打开技术创新课堂教学的新窗:刻画AIoT课堂应用场景

2021-05-07顾小清王超

顾小清 王超

摘要:回望技术在课堂中的应用变迁,尽管研究者与实践者不断尝试在“技术增强教学”方面做出努力,但技术介入始终在教育的边缘徘徊,未能解决课堂教学的本质问题。AIoT作为人工智能与物联网相结合的技术产物,在万物智联时代为改变课堂生态带来新的可能。AIoT支持的智能课堂在实践层面表现为IoT感应设备与智能系统的实时通信,可通过协作、游戏化、创客、实训四种典型课堂场景加以诠释。由于教师的课堂教学表现是精准评估与诊断课堂教学效果、干预课堂教学过程、调整课堂教学模式、提高课堂教学能力的主要依据,因此构建教师的教学表现模型是利用AIoT解决真实课堂问题的方向之一。该模型通过智能设备构建数据驱动的智能体系,实时捕获师生语言、动作等多模态课堂行为数据,围绕教学问题进行特征抽取、数据融合、个性化建模以及动态干预等,为有效监测课堂教学过程、改善教与学的行为模式提供了新的思路。但是,AIoT在教育领域中的应用尚存在诸如过多关注认知维度而忽视其他维度、学习特征有效表征缺乏统一的数据标准、数据安全性等问题,未来仍需在教学实践中不断探索AIoT支持的最佳教学组织和教学策略。

关键词:人工智能;智能课堂;AIoT;物联网技术;多模态数据;学习分析

中图分类号:G434 文献标识码:A 文章编号:1009-5195(2021)02-0003-10 doi10.3969/j.issn.1009-5195.2021.02.001

作者简介:顾小清,博士,教授,博士生导师,华东师范大学教育信息技术学系(上海 200062);王超,博士研究生,华东师范大学教育信息技术学系(上海 200062)。

一、叩问:AIoT是颠覆传统课堂的黑马吗

课堂是教学发生的主场。每当一种颠覆性的技术出现时,人们往往首先考虑的是,这会是那匹彻底颠覆传统课堂的黑马吗(顾小清,2018)?随后才是有针对性地将技术引入课堂。即便这种技术是否以及如何改变课堂尚没有清晰的答案,仍然不妨碍其以实验或试点的方式出现在一些真实的课堂中。智能互联技术AIoT(Artificial Intelligence & Internet of Things,AIoT)就是一种技术上愈加成熟、新近开始进入课堂的新技术。从技术功能的角度来看,AIoT技术能够构建以智能设备为基础的数据驱动智能体系,实时获取学习者全方位的多模态课堂行为数据,为有效监测课堂教学过程、改善教与学的行为模式提供新的思路。但是从课堂的角度来看,AIoT技术又是尚未回答是否以及如何改变课堂的又一鲜活案例。AIoT技术所识别的诸如学生“抬头率”“低头率”等课堂行为表现,或者诸如“高兴”“生气”“惊讶”“悲伤”等情绪状态,是否触碰到了课堂教学的真实问题?基于AIoT技术所建构的多模态数据应用,能够从何种角度对动态的课堂教学进行刻画?这些都是在AIoT进入课堂之前我们必需直面和回答的问题。否则,在缺少明确规范的情况下,贸然使用某些智能设备,不仅不能获得真实可靠的数据,而且也会弱化教师的教育教学能力,甚至可能会侵犯学生隐私、引发社会质疑和公众焦虑(白宇等,2019)。

回看新兴技术的发展历程,每一次技术变革都为课堂教学带来新的可能。第二次工业革命时期,得益于电灯、老式幻灯片为课堂教学提供的设施保障,班级教育初具形态。20世纪90年代初,教育信息化发展步入起步阶段,以多媒体和网络通信为代表的信息技术逐渐走进学校课堂(何克抗,2009),层出不穷的数字学习资源和技术为传统课堂注入了新鲜血液,使得课堂环境由线下扩展到线上线下融合的混合式环境。如今,人工智能(Artificial Intelligence,AI)作为引领未来社會发展的战略性技术,将使课堂朝着智能化方向发展。例如,智能录播系统已用于课堂以采集视音频等数据,机器学习算法等人工智能技术在实现在线自适应学习中已表现出相当的潜力。然而,基于智能设备与智能技术的数据分析尽管在监测和识别学习者面部表情和行为状态方面具有优势,但由于图像背景混乱、画面遮挡、噪音干扰以及同质行为的差异化等问题,导致技术在课堂中的应用并不尽如人意。而AIoT的出现,为数据驱动课堂研究的科学性和精准性提供了保障。AIoT不是人工智能与物联网的简单相加,而是两者融合的产物。物联网(Internet of Things,IoT)作为互联网的延伸,它能通过各种传感设备实时采集各类需求信息,建立物与物、物与人、人与人之间的连接网络(杨现民等,2015)。人工智能技术则致力于探究人类智能活动的机理和规律,构造受人脑启发的人工智能体,让机器或智能系统能够像人一样思考和行动,并进一步提升人的智能(李德毅,2018)。可以说,AIoT技术通过实时捕获师生语言、动作等各类课堂行为,围绕教学问题进行特征抽取、数据融合以及动态建模,并将结果实时反馈给教师和学习者以及时调整教与学的策略,由此打开了技术创新课堂教学的新窗。基于此,本文从AIoT赋能课堂的视角切入,在阐述技术在课堂中的应用变迁基础上,诠释AIoT技术支持的智能课堂及其在典型课堂场景中的应用,并从AI教研实践层面深刻理解AIoT技术如何刻画教师课堂表现的具体做法。

二、回望:技术在课堂中的应用变迁

回顾技术在课堂中的应用变迁,大致可分为技术平移应用、技术融合应用和技术创新应用三个阶段。尽管研究者与实践者不断尝试在“技术增强教学”方面做出努力,但技术介入始终在教育的边缘徘徊,未能解决课堂教学的本质问题。因此,透视技术在课堂中的真实情势,可为新兴技术的教学应用提供指引。

1.课堂转型的趋势

(1)技术平移应用阶段

技术自诞生之日起即给课堂教学带来新的可能性。多媒体技术、电子白板作为代表性技术营造了生动活泼的课堂环境。具体来说,一是多媒体课堂环境为学习者学习新知开启了便捷之窗。声像同步、动静结合的学习情境,以及学习资源的实时获取、开放共享等优势,拓展了学习者自主学习和协同创新的探究空间。同时,采用生动的文本、动画、视频等形式替代枯燥的文字板书,通过感官刺激诱发学习者的积极情绪,最大化地提高了教学效果。二是多媒体课堂环境大大提高了教师的教学效率。已有研究表明,技术融入课堂的实施方式和效果会显著影响教师的信息化教学能力(Melinda et al.,2013)。另有实践表明,教师采用多媒体课件组织教学内容,通过可视化、立体化、趣味性的知识呈现方式能为教学活动的有序和高效实施提供有力保障(Liang et al.,2012)。

(2)技术融合应用阶段

随着计算技术和物联网技术的普及,以物理空间和数字空间相结合形成的智慧教室成为技术与教育融合阶段的典型代表(黄荣怀等,2012)。技术与课堂教学的深度融合,改善了学习空间中人与环境的自然交互方式,利于泛在式、开放式和个性化的协作交流。具体来说,就物理学习环境而言,物联网技术、智能技术等能够自动调节学习空间的温度、湿度和照明度;就交互方面而言,多点触控、泛在计算、情境感知等技术不仅能为学习者提供简单、友好的人机交互,而且也能为学习者的信息交互和协同交流提供便捷的工具支持。已有研究证明,自动化控制和自动识别等技术能够实现个性化的知识检索(Jawa et al.,2010)。从学习支持角度来看,技术支持的学习空间能够实现线上与线下、正式与非正式等不同形态学习的结合与贯通,为优质资源的获取和个性化教学指导奠定了坚实基础。从有效教学方面来看,技术增强的课堂能够通过自动记录、多维交互、实时反馈等过程,营造轻松愉悦的教学氛围,提供丰富多彩的学习内容,为信息化教学创新提供了支撑。

(3)技术创新应用阶段

大数据、云计算、人工智能等技术的迅猛发展,彻底打破了学习场域的刻板印象。在技术创新应用阶段,智能互联技术将学习场域打造为一个汇聚优质教育资源的“淘宝平台”,学习者可以随时享受多元化、情境化、泛在化的学习资源。具体表现在三个方面:一是学习空间呈现出物理空间、社会空间和信息空间三元世界的完美融合,加速走向人机结合的智能样态。开放式、集成化的数字虚拟学习空间,为教师和学习者适时指导、自主建构、交流互动等提供有力支持。正如Francesc等(2019)学者所言,基于技术的创新教育既能适应学习者的学习风格和学习能力,也能为学习者的终身学习和发展提供支持。二是学习内容更具社会性、泛在性和个性化,通过智能系统能大大提高知识的拟真化程度。借助多点触摸、眼动追踪等脑机融合方式挖掘学习者的真实状态,有助于大规模个性化学习的实现。三是学习方式更具智慧性,通过多元化因素和适应性学习方案,有助于学习者全面提升关键能力。同时,借助学习行为模型及其在复杂教学情境中的动态诊断技术,能够实时获取学习者的真实状态,动态规划并调整学习者的学习路径和学习资源,助力构建智能化、个性化、精准化的教育生态。

2.技术在课堂中的应用效果审视

毫无疑问,研究者和教育实践者对技术在课堂中的应用变迁表现出极大的热情与期待。然而,当前技术应用始终停留在教学问题的外围。这是因为,教育是一个动态、复杂的生态系统,无论技术多么智能和创新,依然无法掌控教育问题复杂性表征的本质(马红亮等,2014)。因此,分析技术在课堂中的应用效果,能为解决教学创新的痛点提供科学依据。

在不断求新的技术应用中,技术对教学效果的作用究竟如何?我们看到,从多媒体、虚拟/增强现实技术到今天的人工智能等,几乎每一种前沿技术都能以这样或那样的方式被应用于课堂中。课堂中应用的技术,有的可以营造趣味性的课堂环境,有的擅长于识别学习者的学习状态,还有的能够为学习者推送自适应的学习资源。然而,一项囊括84项技术在课堂中应用的元分析结果表明,技术对学习效果的提升作用非常有限,并且对于多媒体教学面言,其提升效用可以忽略(Cheung et al.,2012)。另有研究表明,技术在教学中始终扮演着可替代的策略应用的角色,其与教学内容或教学组织的融合关系并不明显(Tamim et al.,2011)。

究其原因,本质上,在不断求新的技术应用背后,我们应该以真正解决教学问题为技术应用的内核。技术应用的核心要义在于设计,即在明确技术应用需求的基础上围绕教学问题的解决进行教学设计。已有研究表明,当学习者一味地处于技术环境中而缺失教师的指导时,通常会感到茫然和灰心丧气(Mancillas et al.,2016)。这里的教师指导其实质即是教学设计。另有研究表明,自主能力较差的学习者反而喜欢技术支持的松散式、弱干预式课堂(Mok et al.,2004)。更有研究直接指明盲从技术的五大弊端(Buckingham et al.,2012):(1)并没有真正地促进有意义学习;(2)贬低了教师的作用,但教师永远无法被机器智能所取代;(3)降低了学生的自信心,使得他们更依赖于机器的持续反馈,而不是发展他们自己的元认知和学会学习的技能;(4)贬低了深度学习的重要价值,依靠一些肤浅的指标来满足短期经济方面的需求;(5)在应用、再应用、混合学生数据方面引发了相应的伦理道德问题。显然,技术在课堂中的应用并不意味着为教育变革提供了一个放之四海而皆准的捷径,相反如何定位技术所针对的课堂教学问题,如何通过设计来体现技术在解决教学问题中的应用方式,才是技术有效变革教育的根基。

三、刻画:AIoT在课堂中的应用场景

AIoT在教育中的应用还是相对前沿的话题。尽管以AIoT为主题的研究主要集中于环境、安全、家居、农业等领域,但有关“多模态学习”“多模态数据”等主题的教育研究却日趋增多,而多模态教育数据正是依托物联网智能设备在教育进程中的应用所采集到的。由此看来,AIoT在教育領域中的应用已初见端倪。当前AIoT的教学应用主要体现在诸如创客、实训等课堂活动中。以下将对AIoT智能课堂的构成,以及AIoT支持下的协作、游戏化、创客、实训等四种典型的智能课堂应用进行综述,以期明确AIoT智能课堂能够解决什么教学问题,以及如何进行技术应用的设计。

1.AIoT支持的智能课堂

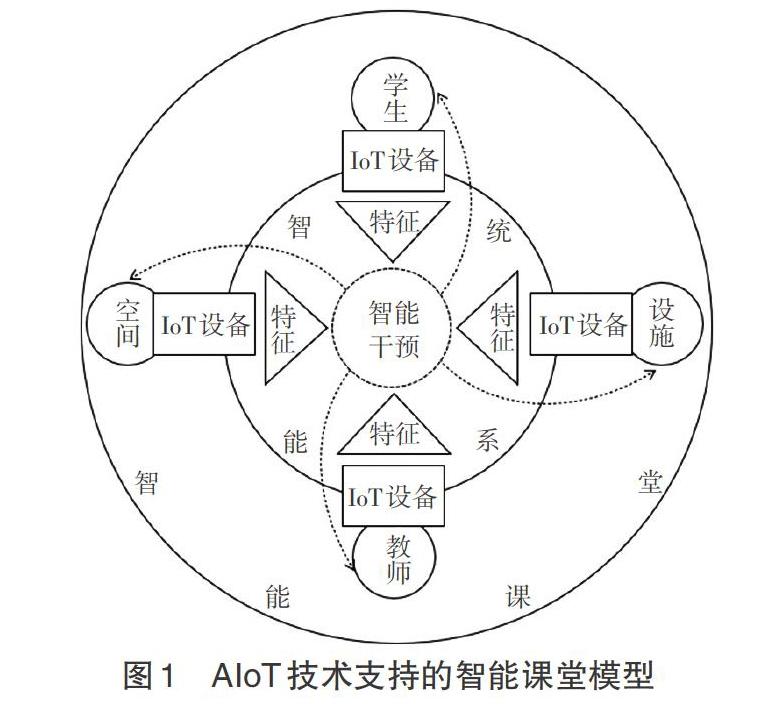

AIoT不是人工智能与物联网的简单相加,而是两者融合的产物。AIoT在课堂教学实践层面表现为IoT感应设备与智能系统的实时通信。具体来说,AIoT支持的智能课堂旨在利用IoT感应设备实时捕获师生语言、动作等各类课堂行为,并用这些行为来表征师生的认知和情感等特征(如图1所示)。智能系统则围绕教学问题进行特征抽取、融合并建模,最后将结果反馈给教师与学习者以便动态调整教与学的策略。

(1)IoT感应设备

课堂行为中蕴含着丰富的教与学信息,但其不易获取性限制了课堂研究的深入。站在以学习者为中心的角度来看,课堂行为数据可分为两个方面:一是学习者本身的学习行为数据,如动作、语言、情绪、血压等。二是与学习者进行交互的学习环境数据,如学习活动、同伴行为和教师行为等。这些行为信息在一定程度上能够反映学习者的认知发展、高阶思维、学习习惯、学习持续力、学业情绪、学习动机、学习投入度等特征。当前,一些相对简单的学习行为数据收集与分析手段已经得到应用,比如利用学习者的测试与作业结果诊断认知能力。在信息系统广泛应用之后,如学习管理系统和移动应用程序的登录(如登录时间点、时长)、浏览(如浏览序列、浏览内容)、测试(如答对一道题尝试的次数、请求反馈的次数)等在线学习行为数据的捕获逐渐变得容易,亦能为评估在线学习习惯、学习持续力等提供证据。相比而言,面对面课堂中的行为捕获更加困难,而IoT感应设备所建构的智能体系为汇聚多模态课堂数据提供了解决方案。

IoT感应设备是能感受到被测量信息并按一定规律转换成可用信号的检测装置,常被置于教室空间、附于教学设备或穿戴于师生身上。课堂安置了IoT感应设备,如同课堂有了视觉、听觉、触觉等感觉器官,可以“看见”师生的动作、“听见”师生的话语、“感受”到师生的情绪等并记录下来,即可以采集所谓多模态数据(Lahat et al.,2015)。常见的IoT设备有:通过语音通道进行采样以获取听觉模态数据,如拾音器、录音笔、佩戴式话筒;通过眼球活动特征以获取眼动轨迹数据,如眼动仪;通过智能录播系统多元追踪语言、动作、面部表情及交互信息,如多功能摄像头;通过皮肤电传感器、脑电波传感器、心电图传感器、肌传感器、加速度传感器等生理信息采集设备,可获取皮肤电导率、大脑内部电位差、心率、肌肉运动、动作振动等数据。近年来,IoT感应设备更是朝着集成化、便携化的趋势发展,如Raca等(2014)在教室前方安置4~6台摄像机以捕捉学生群体动作,在教室后方安置1台摄像机以捕捉教师动作与课件切换;Domínguez等(2015)将学习者的图像、声音、笔记数据采集器集成在一个可置于课桌上的小盒子中。总之,IoT感应设备以轻便简单的外形内嵌于物理空间的形式,便于在课堂中广泛布置和使用,同时也有利于减少教师和学生的认知负担。

(2)智能系统

如果说IoT感应设备是智能课堂的感觉器官,那么智能系统就是智能课堂的大脑。我们可以把智能系统看作是一台拥有人工智能模型与算法的计算机,能够与各IoT感应设备互联互通。理解IoT感应设备捕获到的数据是智能系统的首要任务。以摄像头采集的视频数据为例,Nida等(2019)通过深度卷积神经网络和极限学习机算法,以教学视频中教师的运动轮廓识别了书写板书、使用电脑、使用手机、坐着、走路、指向学生、指向屏幕、互动等8种动作。Ren等(2002)通过隐马尔可夫模型,以脸、胳臂、手、躯干三维运动特征识别了从讲台上拿物体、放回物体、指向学生、指向屏幕、与学生交流、解释、喝水等7种动作。刘清堂等(2019)通过决策树分类器,以人脸数目、轮廓数目、图像最大轮廓面积以及帧间差分图最大轮廓面积等四种特征识别了教师解说、板书、演示、提问和学生发言、思考、笔记、作业等行为。徐振国等(2019)通过卷积神经网络,识别了常态、高兴、愤怒、悲伤、惊恐、专注、厌倦等7种表情。通过训练,智能系统可以识别出基本的肢体行为和面部表情,并能为这些行为和表情赋予符合实际情境的浅层含义,这就构成了智能课堂教学系统的应用基础。

但是,以上仅仅是使用捕捉到的源数据进行动作和表情的识别。课堂行为还需要被赋予更深层次的教学含义,比如用于表征学习者的认知、参与度、情感、注意力等状态,或者评价课堂的情感支持、课堂组织水平、教学支持活动等维度(Pianta et al.,2008)。已有研究探究了学习者的认知能力(Noroozi et al.,2020),为表征认知状态寻得了可信有效的数据和技术支持,如Sharma等(2019)以眼球追踪、脑电、面部表情和腕带唤醒数据作为输入,使用随机森林和支持向量机来预测考试成绩(学习成绩是表征学习者认知能力的公認指标之一),结果表明,眼动、面部表情和腕带数据的结合能更好地预测学习成绩。Chango等(2020)将线下理论课与实践课的课堂视频数据与线上Moodle平台测试、论坛等数据相结合,采用4种不同的数据融合方法和6种分类算法来预测期末成绩,结果表明,理论课上的注意力水平、Moodle测验中的分数以及Moodle论坛中的活跃程度是预测学生最终表现的最佳特征集。总之,不论是线上学习行为还是传统的线下课堂教学行为,均能在一定程度上代表某种教学含义,同时多模态的行为数据比单一模态的行为数据更能客观全面地表征教学意义,而智能系统的应用为实现多模态行为的识别、综合和分析带来了可能。

在行为识别与状态表征的基础上,进行实时课堂干预是智能系统最核心的任务。实时干预是AIoT的最大优势,已有少数研究对此进行了探索。例如,Sharma等(2019)设计了一套学习者参与度实时评估系统,使用眼睛和头部的运动信息以及面部情绪数据计算0%~100%范围内的参与度指数,当评估值低于预先定义的阈值时就向学习者或教师发出警告。Martinez-Maldonado等(2018)开发了一款实时评估舞蹈动作节奏的移动应用程序,嵌入加速度传感器跟踪学生进行舞蹈练习时的动作,以不同颜色的峰波状线条描绘学生律动节拍的正确与否,并能为学生提供错误动作的叙述性反馈。总之,智能系统在课堂教学中的应用目标是改善课堂教学效果、提高课堂教学效率、提升教师教学能力和学生课堂学习能力,以智能技术为支撑的自动化课堂实时干预具有实现这些目标的强大潜力。

2.AIoT在典型课堂场景中的应用

由于教育教学的复杂性,相同的课堂行为在不同的课堂场景中可以解读为不同的教学含义。换言之,同样是面部表情、眼动跟踪、姿势识别、生理数据、语音和文本等多模态数据,不同的课堂场景关注的教学问题不同,因而其选取的数据与特征也不同。笔者将选择协作、游戏化、创客、实训四种典型课堂场景,逐一解析具体课堂场景中关注的问题,通过已有的多模态学习分析研究来看使用何种行为表征何种维度、以何种智能手段解决哪些教学问题,并辅以相应的研究案例进行佐证。

(1)协作课堂场景

无论是传统线下课堂中的小组讨论,抑或是计算机支持的在线协作学习,都是协作课堂场景的外在形式,其本质均为小组成员分享并协商与当前任务相关观点的过程(Roschelle et al.,1995)。相较于合作学习,协作学习更注重小组成员在完成各自任务之外的协商讨论与知识建构。因此,如何解构、分析并干预学习者的协作过程以获得更好的协作学习结果是该场景的核心问题。

已有研究通过AIoT对协作学习结果预测进行了探索,主要是利用IoT感应设备为协作学习结果的预测特征提供新的数据源。概括来讲,协作学习的结果受到协作过程行为(Cukurova et al.,2018)、小组属性(如规模、成员特点、成员认知负荷)(Odo et al.,2019)、物理环境(如桌椅摆放)(Colbert,1997)、协作内容(如任务设计)(Blinne,2013)等多方面因素的影响。以往研究多关注小组人数、在线点击流等容易获取的数据,而IoT设备拓宽了数据来源。例如,Vujovic等(2020)在学习者头部放置了5个标记物(其中4个在头部两侧,1个在头顶),使用8个红外摄像头捕捉标记物的位置移动并转化成坐标,结合视频中学习者的姿势与动作,将协作参与度标定为积极、半积极、不积极三种程度。Riquelme等(2019)使用麦克风采集语音数据,以发言时间和干预时间(指导小组成员的时间)的统计公式来表征协作持久性、持续性和激活三个指标。Olsen等(2020)使用两台250Hz红外眼球追踪摄像机捕获眼动数据,将平均瞳孔直径、瞳孔直径标准差、扫视速度和超过500ms的注视次数作为认知负荷的测量指标(Buettner,2013),同时连同系统日志数据、对话数据等对协作结果进行预测,结果显示,多模态数据比单一模态数据对协作结果的预测精度更高。拓宽数据来源不仅可以使基于证据的研究更具有可信性,而且可以在全面探究协作学习中固有问题的基础上,发掘出新的或者被忽略的问题,从而为协作学习提供新的研究思路与方向。

此外,教师如何在各个协作小组之间分配指导精力也是需要思考的问题。通常情况下,教师会四处走动,以监督和评估小组任务的完成情况。教师面临的一个关键挑战是如何均衡地帮助全体学生,掌握课堂的整体状况,同时能够关注到其中最需要得到帮助的学生。Martinez-Maldonado等(2018)通过在教室中的相应位置部署位置感应器,根据教师在教室中的实际位置描绘出一幅热图,以此构建教师仪表盘。教师可实时查看自己的仪表盘,了解自己对每一个小组的指导时间和干预行为,据此做出实时的行为调整。AIoT在课堂协作学习过程中的应用既省时省力又高效精准,可完全替代人类的观察,为协作学习的研究提供了便捷支撑。

(2)游戏化课堂场景

游戏化学习是指将游戏内容与学习活动相结合以增强特定领域的知识和技能获得,通过有趣的游戏机制激勵学习者参与(Plass et al.,2015)。已有研究表明,游戏化学习可以提高学习者的学习效果与学习兴趣(Qian et al.,2016)。而AIoT的出现,为深层次理解游戏化学习行为和实时捕捉学习兴趣提供了新的测量手段(Plass et al.,2020)。

目前,已有学者使用IoT设备进一步挖掘游戏化学习行为。例如,Tsai等(2016)应用眼动跟踪技术捕捉学习者在游戏化环境下的视觉行为模式,发现不同学习者之间关注点的差异。Taub等(2020)应用面部表情和游戏过程日志数据,发现阅读相关书籍时表现出愉悦情绪,扫描食品得到阳性结果(游戏背景是寻找某神秘疾病的致病源)时表现出困惑情绪等,可以正向预测游戏得分。还有学者开始通过分析学习者的面部表情、眼动轨迹和操作行为来探究游戏化学习的兴趣。例如,Emerson等(2020)利用基于视频的面部表情跟踪系统FACET(iMotions,2016)提取了对应于面部动作编码系统FACS(Ekman et al.,1997)的特征,将面部划分为20个动作单元;同时,基于SMI眼动仪以120Hz的频率追踪眼球运动并记录时间戳,识别出学习者注视(超过250ms)的8个对象以及每秒注视对象的次数,共获得9个特征;然后,根据系统记录的游戏操作轨迹,归纳出8类行为(如移动位置、与游戏中角色对话、完成一项任务等),再加上游戏总时间,共获得9个特征;最后,以这38个特征作为输入,采用逻辑回归预测学习兴趣,结果表明,增加眼动数据和面部数据的预测精度比仅有游戏操作数据时的预测精度更高。这些研究再次证明了利用多模态数据和智能技术剖析学习过程的重要性,同时为构建基于游戏的自适应学习场景提供了基础,也指明了以智能系统为支持的学习分析技术在游戏化学习场景中的研究思路。

(3)创客课堂场景

创客课堂是以跨学科项目式学习为主要形式,旨在培养学习者的高阶思维能力与创新实践能力的课堂形式(申静洁等,2020)。创客课堂中对于学习者的评价,多以学习者的最终作品为主。但是创客课堂的本质是让学生通过“做中学”获得能力的发展(田友谊等,2019),因此捕获学习者的动手操作数据有助于提高创客课堂评价的科学性与合理性。

跨学科合作项目PELARS(Practice-based Experiential Learning Analytics Research and Support),连续三年受到欧盟研究与创新计划的资助,2015年起开始致力于设计基于创客课堂的数据采集环境并开发学习分析系统;2017年的版本从脸、手、操作、时间等方面进行数据采集并实现了可视化呈现(Friesel et al.,2017;PELARS,2017)。具体来说,通过学习者佩戴的腕部位置感应器,获取学习者是否正在操作、操作软硬件对象、操作频率数据,再配以时间序列将操作过程划分为计划、记录、反思三个阶段;同时,使用摄像头获取学生查看电脑屏幕的次数和面部表情,进而为学习者和教师实时呈现整体可视化界面。Healion等(2017)依托该项目探索了桌子的高度与形状对学习的影响,结果发现学习者离开桌子的行为也是一项重要指标,故应跟踪并以不同颜色的线条可视化呈现学习者的运动轨迹。AIoT的应用能够充分挖掘创客课堂的特色行为数据,为创客教学的发展提供适应性证据。

(4)实训课堂场景

实训课堂旨在通过模拟真实的工作场景以检验理论知识、强化专业技能及提高综合素质,对于职前教师、实习医生等具有非常重要的作用。但是,目前的实训课堂中针对学习者表现的反馈滞后,导致实训目标感欠缺(冯咏薇,2019)。而AIoT的出现为实训课堂的实时反馈提供了可能性。

根据搭建环境的不同,实训课堂可分为物理实训课堂和虚拟实训课堂。物理实训课堂是依靠物理设备来模拟真实场景,如Echeverria等(2019)建立了物理的模拟医院病房,配备了5~6个能够展示健康指标的病患模型以及病床等设備,同时部署了位置感应器、腕带感应器、麦克风和拾音器,用于捕获医学院学生在模拟医疗急救场景中的行为信息。以心脏骤停的教学场景为例,扮演护士角色的学生需要及时出现在床边,并对病患模型进行心脏按摩和气流按压。此时学生佩戴的腕带感应器可以测量其压力水平,并感知其皮肤电反应和血容量的变化。基于传感器之间的连接,便可同步计算学生的心率、出汗水平和体温等,这些数据能在一定程度上反映此次急救任务对于该学生的困难程度;病床旁边配置的麦克风和拾音器,可捕捉学生之间以及病患之间的语言交流;位置感应器可追踪学生在各个区域内的停留时间和转移频率。值得一提的是,这个房间内还配置有一间控制室,教师可根据学生的实时表现控制病人的状态和声音,增强了实训的真实性。虚拟实训课堂则是利用虚拟仿真技术来模拟真实场景,其难点在于学习者如何感知虚拟环境。Xiao等(2020)使用Kinect设备和一枚智能戒指进行了尝试。实验过程中,学习者手上会佩戴一枚智能戒指,戒指上置有振动器,当学习者对着屏幕操作虚拟对象时,Kinect设备会捕捉并识别手势(如伸出一根手指表示“点击”,伸出五根手指表示“放下”,五根手指握拳表示“抓取”,二指延伸表示“放大”等)。若学习者的手势与虚拟环境中的手势一致,则表示虚拟操作成功,同时智能戒指会产生振动,以此来连接虚拟学习环境与学习者的知觉。AIoT在实训课堂场景中的应用为学习者对自身技能的认知、教师发现学生技能缺陷并为学生提供指导带来了直接依据。

可以说,AIoT在教育领域的应用潜力巨大,尤其体现在支持实时反馈的智能课堂。智能课堂是基于先进的物联网与人工智能技术而构建的数字化、个性化的智能学习环境,为教师的课堂教学管理与决策和学生的学习提供了重要支撑。相较于考试成绩、线上操作流等单一模态数据,基于IoT感应设备捕获的多模态数据能够更加全面、准确地反映学习者的特征。课堂智能录播系统、可穿戴设备、点阵笔、电子平板、眼动仪、脑电仪等数据采集设备,可高效、便捷、实时地获取多模态教学数据。在人工智能技术的加持之下,多模态教学数据的分析和反馈愈发便捷、精准和高效,尤其是伴随计算机视觉和深度学习技术的不断改进,使得面对面教学过程中的教学语言、声音、笔记、教学行为动作、人体运动轨迹、面部表情、眼动踪迹等大量外显行为数据,以及脉搏、心率等内在生理信号数据的提取与分析实现了自动化和智能化,这将真正促进课堂教学的深刻变革。

四、探寻:智能课堂中的教师课堂表现

上面分析的AIoT应用案例,针对的是非常规性的课堂,其所解决的教学问题也有一定的特殊性。这些应用虽然能够为AIoT智能课堂提供有益的启示,但是要在日常的中小学课堂中发挥AIoT的作用,还需要回到一开始提出的问题,即要解决课堂教学的什么问题?对此,本团队将问题聚焦到教师的课堂教学表现。教师课堂教学表现是精准评估与诊断课堂教学效果、干预课堂教学过程、调整课堂教学模式、提高课堂教学能力的主要依据。智能教学环境下的多模态数据为诊断教师课堂教学特点或缺陷提供了更加全面和客观的证据。同时,课堂教学设计、教学组织和管理等教师教学能力要素的评估方法也以多模态数据为依据、以智能技术为手段,在完成自动化的客观测量基础上,改进课堂教学评价过程,实现高效精准的教学研究与教师技能评估。另外,学生群体的课堂学习行为也能反映教师的教学表现,并为评价教师提供证据支撑。

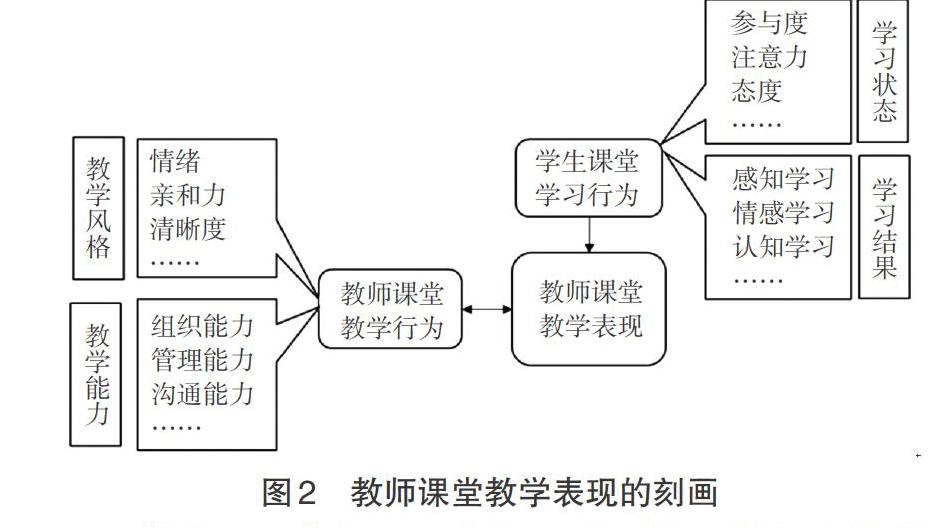

本团队从关注教师课堂教学表现、提升教师课堂教学能力的角度出发,利用教师和学生产生的多模态数据共同刻画教师的课堂教学表现。如图2所示,通过挖掘学生课堂学习行为来表征参与度、注意力、态度等学习状态与学习结果;同时通过挖掘教师课堂教学行为来表征教学风格和教学能力;最后通过智能算法融合来刻画教师课堂教学表现,并依据教师教学表现来指导和干预课堂教学行为。

课堂行为数据的采集需要多种智能设备和仪器的支持。然而,智能化课堂环境既先进又复杂,当前多数涉及到多模态学习分析的教学研究尚处于实验摸索阶段。借助课堂教学实录视频采集行为数据的手段不仅成本低,而且实用性和易用性强,被多数研究者采纳。这就需要用计算机抓取图像,探测教学环境中的师生主体,进而识别主体并提取特征以理解主体的行为和意义表征。该过程离不开人脸检测、面部表情识别、手势识别、人体定位和移动轨迹识别、语音识别等技术支持。本团队在深刻认识智能化课堂环境的基础上,提出了如图3所示的基于多模态行为数据的教师课堂教学表现刻画与评估模型。该模型的涵义是:通过学生全景视频和学生特写视频捕获学生个体/群体的行为,利用行为与状态的表征关系来刻画学生个体/群体的课堂学习状态;通过教师特写视频捕捉教师行为,刻画教师的课堂教学风格与教学能力;通过综合教师和学生的多模态行为数据,最终得到教师课堂教学表现的刻画模型。

五、直面:AIoT面临的现实挑战

面对万物智联时代的到来,采用AIoT赋能课堂教学已是大势所趋。总的来说,AIoT在课堂教学中的应用,实际上就是借助其在数据和算力两个方面的强大功能。基于AIoT的智能课堂通过利用IoT感应设备,采集师生的外显行为数据和内隐生理数据,为总结课堂教学经验、深刻洞悉课堂教学情境、精准发现课堂教学问题、科学研究课堂教学提供了方法指导,同时也为促进学生个性化成长、发展教师专业能力、提升课堂教学效果提供了证据支持。

AIoT技术在课堂应用中仍然面临诸多挑战。第一,目前研究主要关注认知维度,即用多模态数据来预测学习结果,而对学习动机、学习策略、学习态度、学习持续力等维度的表征研究较少。第二,基于IoT感应设备采集的数据各具形态,在这种情境下,选择何种数据来表征何种学习特征仍需大量研究证据支持。第三,课堂多模态数据涉及学习者与教师的隐私数据(如高清人物影像),如何保证数据的安全性也是亟待解决的问题。因此,要克服AIoT在课堂应用中的弊端,仍需在教学实践中不断探索AIoT支持的最佳教学组织和教学策略等。

参考文献:

[1]白宇,岳弘彬(2019). 浙江一小学学生戴“头环”防走神——教育部门已责令学校暂停使用相关产品;专家表示引进技术设备用于课堂教学应有明确规范[N]. 新京报,2019-11-01(A13).

[2]冯咏薇(2019). 智能互联技术+BOPPPS模式下的广告专业教学模式研究——以“广告文案”实训课为例[J]. 传媒,(8):79-82.

[3]顾小清(2018). 破坏性创新:技术如何改善教育生态[J]. 探索与争鸣, (8):34-36.

[4]何克抗(2009). 21世纪以来教育技术理论与实践的新发展[J]. 现代教育技术,19(10):5-14.

[5]黄荣怀,胡永斌,杨俊锋等(2012). 智慧教室的概念及特征[J]. 开放教育研究,18(2):22-27.

[6]李德毅(2018). 人工智能:社会发展加速器[N]. 中国信息化周报,2018-02-05(007).

[7]刘清堂,何皓怡,吴林静等(2019). 基于人工智能的课堂教學行为分析方法及其应用[J]. 中国电化教育,(9):13-21.

[8]马红亮,[英]袁莉,郭唯一等(2014). 反省分析技术在教育领域中的应用[J]. 现代远程教育研究,(4):39-46.

[9]申静洁,赵呈领,李芒(2020). 创客教育:学科视域下提升学生核心素养的路径探析[J]. 中国电化教育,(6):30-36.

[10]田友谊,姬冰澌(2019). 重识中小学创客教育:基于杜威“做中学”思想的审视[J]. 教育科学研究,(12):53-58,66.

[11]徐振国,张冠文,孟祥增等(2019). 基于深度学习的学习者情感识别与应用[J]. 电化教育研究,40(2):87-94.

[12]杨现民,余胜泉(2015). 智慧教育体系架构与关键支撑技术[J]. 中国电化教育,(1):77-84,130.

[13]Blinne, K. C. (2013). Start with the Syllabus: Helping Learners Learn Through Class Content Collaboration[J]. College Teaching, 61(2):41-43.

[14]Buckingham, S. S., & Ferguson, R. (2012). Social Learning Analytics[J]. Educational Technology & Society,15(3):3-26.

[15]Buettner, R. (2013). Cognitive Workload of Humans Using Artificial Intelligence Systems: Towards Objective Measurement Applying Eye-Tracking Technology[C]// Proceedings of the Annual Conference on Artificial Intelligence. Berlin, Heidelberg: Springer:37-48.

[16]Chango, W., Cerezo, R., & Romero, C. (2020). Multi-Source and Multimodal Data Fusion for Predicting Academic Performance in Blended Learning University Courses[J]. Computers & Electrical Engineering, 89:1-13.

[17]Cheung, A. C. K., & Slavin, R. E. (2012). How Features of Educational Technology Applications Affect Student Reading Outcomes: A Meta-Analysis[J]. Educational Research Review, 7(3):198-215.

[18]Colbert, J. (1997). Classroom Design and How It Influences Behavior[J]. Early Childhood News, 9(3):22-29.

[19]Cukurova, M., Luckin, R., & Millán, E. et al. (2018). The NISPI Framework: Analyzing Collaborative Problem-Solving from Students Physical Interactions[J]. Computers & Education, 116:93-109.

[20]Domínguez, F., Chiluiza, K., & Echeverria, V. et al. (2015). Multimodal Selfies: Designing a Multimodal Recording Device for Students in Traditional Classrooms[C]// Proceedings of the 2015 ACM on International Conference on Multimodal Interaction. Seattle, USA:567-574.

[21]Echeverria, V., Martinez-Maldonado, R., & Buckingham, S. S. (2019). Towards Collaboration Translucence: Giving Meaning to Multimodal Group Data[C]// Proceedings of the 2019 CHI Conference on Human Factors in Computing Systems. Glasgow, Scotland, UK:1-16.

[22]Ekman, P., & Rosenberg, E. (1997). What the Face Reveals: Basic and Applied Studies of Spontaneous Expression Using the Facial Action Coding System (FACS)[M]. New York, Oxford University Press.

[23]Emerson, A., Cloude, E. B., & Azevedo, R. et al. (2020). Multimodal Learning Analytics for Game-Based Learning[J]. British Journal of Educational Technology, 51(5):1505-1526.

[24]Francesc, P., Miguel, S., & Axel, R. et al. (2019). Artificial Intelligence in Education: Challenges and Opportunities for Sustainable Development[EB/OL]. [2020-12-20]. https://unesdoc.unesco.org/ark:/48223/pf0000366994.

[25]Friesel, A., Spikol, D., & Cojocaru, D. (2017). Technologies Designed and Developed in PELARS Project-The Way to Enhance STEM Education[C]// Proceedings of the Annual Conference on European Association for Education in Electrical and Information Engineering. Grenoble, France:1-5.

[26]Healion, D., Russell, S., & Cukurova, M. et al. (2017). Tracing Physical Movement During Practice-Based Learning Through Multimodal Learning Analytics[C]// Proceedings of the Seventh International Learning Analytics & Knowledge Conference. Vancouver, Canada:588-589.

[27]iMotions(2016). Attention Tool (Version 6.2)[Z]. Boston, MA: iMotions Inc.

[28]Jawa, A., Datta, S., & Nanda, S. et al. (2010). SMEO: A Platform for Smart Classrooms with Enhanced Information Access and Operations Automation[C]// Proceedings of the Conference on Smart Spaces & Next Generation Wired/Wireless Networking: Springer-Verlag:123-134.

[29]Lahat, D., Adali, T., & Jutten, C. (2015). Multimodal Data Fusion: An Overview of Methods, Challenges, and Prospects[J]. Proceedings of the IEEE, 103(9):1449-1477.

[30]Liang, T. H., Huang, Y. M., & Tsai, C. C. (2012). An Investigation of Teaching and Learning Interaction Factors for the Use of the Interactive Whiteboard Technology[J]. Journal of Educational Technology & Society, 15(4):356-367.

[31]Mancillas, L. K., & Brusoe, P. W. (2016). Born Digital: Integrating Media Technology in the Political Science Classroom [J]. Journal of Political Science Education, 12(4):375-386.

[32]Martinez-Maldonado, R., Echeverria, V., & Santos, O. C. et al. (2018). Physical Learning Analytics: A Multimodal Perspective[C]// Proceedings of the 8th International Conference on Learning Analytics and Knowledge. Sydney, New South Wales, Australia:375-379.

[33]Melinda, D., & Randall, S. (2013). Filling in the Gaps: Linking Theory and Practice Through Telecollaboration in Teacher Education[J]. European Association for Computer Assisted Language Learning, 25(1):4-29.

[34]Mok, M. M. C., & Chen, Y. C. (2004). A Theory of Self-Learning in Human and Technology Environment: Implications for Education Reforms[J]. International Journal of Education Management, 15(4):172-186.

[35]Nida, N., Yousaf, M. H., & Irtaza, A. et al. (2019). Instructor Activity Recognition Through Deep Spatiotemporal Features and Feedforward Extreme Learning Machines[J]. Mathematical Problems in Engineering:1-13.

[36]Noroozi, O., Pijeira-Díaz, H. J., & Sobocinski, M. et al. (2020). Multimodal Data Indicators for Capturing Cognitive, Motivational, and Emotional Learning Processes: A Systematic Literature Review[J]. Education and Information Technologies, 25:5499-5547.

[37]Odo, C., Masthoff, J., & Beacham, N. (2019). Group Formation for Collaborative Learning[C]// Proceedings of the International Conference on Artificial Intelligence in Education. Springer, Cham:206-212.

[38]Olsen, J. K., Sharma, K., & Rummel, N. et al. (2020). Temporal Analysis of Multimodal Data to Predict Collaborative Learning Outcomes[J]. British Journal of Educational Technology, 51(5):1527-1547.

[39]PELARS(2017). Iterative Prototyping Feedback in Interaction Design[EB/OL]. [2020-12-02]. http://www.learningmaking.eu/wp-content/uploads/2017/02/PELARS_D2.6.pdf.

[40]Pianta, R. C., La Paro, K. M., & Hamre, B. K. (2008). Classroom Assessment Scoring SystemTM: Manual K-3[M]. Paul H Brookes Publishing.

[41]Plass, J. L., Homer, B. D., & Kinzer, C. K. (2015). Foundations of Game-Based Learning[J]. Educational Psychologist, 50(4):258-283.

[42]Plass, J. L., Mayer, R. E., & Homer, B. D. (2020). Handbook of Game-Based Learning[M]. Cambridge, MA: MIT Press.

[43]Qian, M., & Clark, K. R. (2016). Game-Based Learning and 21st Century Skills: A Review of Recent Research[J]. Computers in Human Behavior, 63:50-58.

[44]Raca, M., & Dillenbourg, P. (2014). Holistic Analysis of the Classroom[C]// Proceedings of the 2014 ACM Workshop on Multimodal Learning Analytics Workshop and Grand Challenge. Istanbul, Turkey:13-20.

[45]Ren, H., & Xu, G. (2020). Human Action Recognition in Smart Classroom[C]// Proceedings of Fifth IEEE International Conference on Automatic Face Gesture Recognition. Washington, DC, USA:417-422.

[46]Riquelme, F., Munoz, R., & Mac, L. R. et al. (2019). Using Multimodal Learning Analytics to Study Collaboration on Discussion Groups[J]. Universal Access in the Information Society, 18(3):633-643.

[47]Roschelle, J., & Teasley, S. D. (1995). The Construction of Shared Knowledge in Collaborative Problem Solving[M]// OMalley, C. (Eds.). Computer Supported Collaborative Learning. NATO ASI Series (Series F: Computer and Systems Sciences). Springer, Berlin, Heidelberg:69-97.

[48]Sharma, K., Papamitsiou, Z., & Giannakos, M. (2019). Building Pipelines for Educational Data Using AI and Multimodal Analytics: A “Grey-Box” Approach[J]. British Journal of Educational Technology, 50(6):3004-3031.

[49]Tamim, R. M., Bernard, R. M., & Borokhovski, E. (2011). What Forty Years of Research Says about the Impact of Technology on Learning[J]. Review of Educational Research, 81(1):4-28.

[50]Taub, M., Sawyer, R., & Lester, J. et al. (2020). The Impact of Contextualized Emotions on Self-Regulated Learning and Scientific Reasoning During Learning with a Game-Based Learning Environment[J]. International Journal of Artificial Intelligence in Education, 30(1):97-120.

[51]Tsai, M. J., Huang, L. J, & Hou, H. T. et al. (2016). Visual Behavior, Flow and Achievement in Game-Based Learning[J]. Computers & Education, 98:115-129.

[52]Vujovic, M., Hernández-Leo, D., & Tassani, S. et al. (2020). Round or Rectangular Tables for Collaborative Problem Solving? A Multimodal Learning Analytics Study[J]. British Journal of Educational Technology, 51(5):1597-1614.

[53]Xiao, M., Feng, Z., & Yang, X. et al. (2020). Multimodal Interaction Design and Application in Augmented Reality for Chemical Experiment[J]. Virtual Reality & Intelligent Hardware, 2(4):291-304.

收稿日期 2021-02-03 責任编辑 刘选

Abstract: Looking back at the changes in the application of technology in the classroom, although researchers and practitioners keep trying to make efforts in “technology-enhanced teaching”, technology intervention has always been hovering on the edge of education and failed to solve the inherent problem of classroom teaching. AIoT, as a technological product combining Artificial Intelligence (AI) and the Internet of Things (IoT), brings new possibilities to change the classroom ecology. In practice, the classroom supported by AIoT has the affordance of real-time communication between IoT sensing devices and intelligent systems, which can be elaborated with four scenarios. Since teaching performance is the basis for accurately evaluating classroom teaching effect, intervening classroom teaching process, adjusting classroom teaching mode and improving classroom teaching ability, building teaching performance model is one of the approaches to solve real classroom problems by using AIoT. This model constructs a data-driven intelligent system by intelligent devices to capture the real-time classroom behavior data, extract features, integrate data, build personalized models and try dynamic intervention, which provides new ideas for effectively monitoring the classroom teaching and improving the behavioral pattern of teaching and learning. However, there are still some problems such as more focus on cognitive dimension, the lack of unified standard of learning characteristic, data security and so on in the application of AIoT into the education field. Efforts are needed to explore the best teaching organizations and teaching strategies supported by AIoT in teaching practice.

Keywords: Artificial Intelligence; Intelligent Classroom; AIoT; Internet of Things; Multimodal Data; Learning Analytics