基于特征图融合的对抗样本生成方法

2023-08-21张世辉张晓微宋丹丹路佳琪

张世辉,张晓微,宋丹丹,路佳琪

(1.燕山大学 信息科学与工程学院,河北 秦皇岛 066004;2.燕山大学 河北省计算机虚拟技术与系统集成重点实验室,河北 秦皇岛 066004)

0 引言

目前,人工智能领域的安全问题广受关注[1-2]。深度学习作为人工智能的一个重要分支,在图像分类[3]、语音识别[4]、生物科学[5]和目标检测[6]等领域具有广泛应用。在深度学习带来极大便利的同时,研究者发现深度学习模型极易受到对抗样本的攻击[7-8]。攻击方通过对原始样本进行人类视觉系统不易察觉的修改,从而生成可诱导深度学习模型误分类的对抗样本,使得深度学习在高安全性需求场景中的部署和应用面临巨大挑战。因此,关于对抗样本生成问题的研究具有重要的现实意义和学术价值。

现有对抗样本生成方法根据目标网络信息的已知程度,可分为基于白盒的对抗样本生成方法和基于黑盒的对抗样本生成方法。其中,基于白盒的对抗样本生成方法[9-12]已知目标网络的结构和参数,该类方法主要通过求解目标网络的梯度信息生成扰动,并将生成的扰动添加至原始输入样本进而生成对抗样本。本文所提对抗样本生成方法主要面向黑盒模型,因此下面侧重于基于黑盒的对抗样本生成方法的描述。

在实际应用场景中,攻击方除目标网络的输入输出结果外通常无法获得其他信息,故基于黑盒的对抗样本生成方法可代表更一般的应用场景。2018 年,Dong 等人[13]将动量项整合至迭代攻击中, 提出 MI-FGSM (Momentum Iterative Fast Gradient Sign Method)方法,通过在迭代过程中累积损失函数的梯度,以稳定优化过程并避免不良的局部最大值,从而生成具有可迁移性的对抗样本。2019 年,Xie 等人[14]将输入多样性策略整合至迭代攻击中,提出DI2-FGSM(Diverse Inputs Iterative Fast Gradient Sign Method)方法,通过对输入图像进行随机裁剪和随机填充的变换来增加生成对抗样本的可迁移性。MI-FGSM 和DI2-FGSM方法均基于FGSM 方法进行相应改进,从而适应黑盒模型的攻击环境。2019 年,Carlini 等人[15]为了有效评估对抗样本性能,提出一种难度更大的非交互式黑盒(Non-interactive blackBox,NoBox)模型,NoBox 模型作为黑盒模型的延伸,攻击方在对抗样本的生成过程中无法访问目标网络的任何信息,包括输入信息与输出信息,即无法与目标网络进行任何交互访问。在基于NoBox 模型的攻击环境下,攻击方仅可依靠对抗样本的可迁移性来达到攻击目标网络的目的。2020 年,Wu 等人[16]基于类ResNet 网络的跳跃连接操作提出SGM(Skip Gradient Method)对抗样本生成方法,跳跃连接有助于保留更多的浅层特征信息,使得生成的对抗样本可有效迁移至其他分类器。该方法虽然可以在一定程度上提高对抗样本的可迁移性,但迁移后的对抗样本在NoBox 攻击环境下的攻击成功率显著降低。同年, Avishek 等人[17]提出 AEG(Adversarial Example Games)方法,通过生成器与假设分类器之间的对抗性训练生成可迁移性对抗样本。由于对抗性训练需要有效的约束条件使得博弈双方达到理想的纳什均衡状态,因此AEG 方法在NoBox 攻击环境下所构造的对抗样本图像可视化结果较差。2021 年,Philipp 等人[18]提出BNMI-FGSM(Batch Normalization Momentum Iterative Fast Gradient Sign Method)方法,通过利用BN 层使卷积神经网络更倾向于学习非鲁棒特征的特点生成具有可迁移性的对抗样本。虽然该方法生成的对抗样本具有较好的可迁移性,但在NoBox 攻击环境下对抗样本对于不同目标网络的攻击成功率波动幅度较大,稳定性较差。

结合上述关于现有代表性方法的分析,在不与目标网络产生任何交互信息的前提下,本文通过构建基础网络获取原始输入样本的显著特征信息,并基于显著特征信息完成对抗样本生成任务。本文方法主要贡献如下:

1) 提出利用多层次特征图进行对抗扰动构造的思想。依据卷积神经网络分类过程中所提取的不同层次特征图,选取对图像分类结果影响较大的部分特征图进行扰动修改,上采样至相同尺寸后进行融合操作,得到用于对抗样本生成的对抗扰动。

2) 提出一种基于特征图融合的对抗样本生成方法。基于利用多层次特征图进行对抗扰动构造的思想,构建基础网络用于提取原始输入样本的多层次特征图及其权重向量,依据权重向量进行特征图选取,并设计扰动修改方法对所选特征图进行像素级的扰动修改操作,将获取的对抗扰动叠加至原始输入样本生成误导目标网络分类的对抗样本。

3) 与现有代表性方法不同的是,本文方法中的基础网络可由任意卷积神经网络嵌入通道注意力模块实现,显著提高了方法的普适性,且对抗样本生成过程重点关注原始输入样本的特征信息,使得生成的对抗样本具有良好的可迁移性,同时本文方法不需要目标网络的任何信息,即本方法可完全适应NoBox 攻击环境。

1 方法概述

本文所提基于特征图融合的对抗样本生成方法总体思路如下。首先,基于卷积神经网络嵌入注意力模块,构建并训练基础网络;其次,根据基础网络中的卷积层与注意力模块分别获取原始输入样本的不同特征图及相应的权重向量;再次,根据扰动特征图获取方法依次进行特征图选取和扰动修改操作;最后,将多张扰动特征图融合为对抗扰动,并逐像素叠加至原始输入样本以生成对抗样本。所提对抗样本生成方法的总体流程如图1所示。

图1 对抗样本生成方法的总体流程Fig.1 The overall process of the adversarial example generation method

2 基于特征图融合的对抗样本生成方法

2.1 问题定义

设(x,y)是符合自然图像数据分布Pnature的数据集(X,Y)中的一组数据样本,其中x∈X为原始输入样本,y∈Y为对应的数据类别标签。对抗样本x∗通过对原始输入样本x进行像素级的扰动修改,来诱导目标网络ftarget:X→Y误分类。给定原始数据集合(X,Y)~Pnature,在目标网络ftarget的任何信息均未知的情景下(NoBox 攻击环境),采用有效的对抗样本生成方法,使得目标网络误分类对抗样本,即ftarget(x∗)≠ftarget(x)。

2.2 特征图扰动修改思想

随着深度学习的发展,计算机可以快速准确地识别图像中所包含的目标信息。现有基于深度学习的图像分类方法中,主要采用多层卷积操作提取输入图像的特征信息,这些特征信息直接影响目标类别的分类结果,且在此过程中会生成一系列包含不同信息的特征图。其中,浅层卷积操作生成的特征图更多包含纹理与细节特征等信息,而深层卷积操作生成的特征图更多包含轮廓、形状、最强特征等影响人类视觉系统感知的全局信息。

针对图像分类任务,对抗样本通过向原始输入样本中添加精心设计的像素级扰动,达到诱导卷积神经网络误分类的目标。结合上述关于卷积操作生成特征图的特点,本文提出对多层次特征图进行扰动修改,并用于构造对抗扰动的思想。在具有n个卷积层的卷积神经网络中,对多层次特征图进行扰动修改来构造对抗扰动的总体思路如图2 所示。

图2 基于卷积神经网络的多层次特征图扰动修改示意图Fig.2 Sketch map of multi-level feature map perturbation modification based on convolutional neural networks

由于不同卷积神经网络的下采样层大小、数量及位置均不相同,因此图2 中并未考虑下采样层。考虑篇幅限制,图2 对所选取的特征图进行等比例缩放。由图2 可知,为保证生成对抗样本与原始输入样本在人类视觉系统感知上的相似程度,本文选取对图像分类结果影响较大的部分特征图执行扰动修改操作。由于卷积神经网络在提取图像特征信息的过程中,每个卷积层产生的特征图尺寸(通道数×高×宽)并不相同,且浅层特征图的尺寸大于深层特征图,因此需要对选取的部分特征图进行上采样操作,以便后续特征图融合操作的执行。

2.3 基础网络的构建

由上述关于特征图扰动修改思想的阐述可知,在对特征图执行扰动修改和融合操作之前,需要提取输入图像的不同层次特征图,且卷积神经网络可以根据所提取的特征图对输入图像正确分类。由于不同卷积神经网络的卷积层和下采样层的数量并不相同,因此对于输入图像的特征图提取也会因网络结构的不同而存在差异。在图像分类任务中,常用的卷积神经网络包括VGGNet[19]、GoogLeNet[20]、ResNet[21]和 AlexNet[22]等, 其中ResNet 有效解决了网络性能随网络层数增加而退化的问题,使其在图像分类任务中得到广泛应用。为了体现所提对抗样本生成方法的普适性,也为了便于与现有代表性方法进行实验对比,因此本文选取ResNet 用于构建基础网络。

为了实现生成对抗样本的扰动不可感知效果,本文在ResNet 的各个卷积层之后嵌入通道注意力模块,从而构造用于提取多层次特征图及其权重向量的基础网络。其中,通道注意力模块对卷积层生成的多层次特征图进行权重分配操作,而高权重特征图包含更多影响卷积神经网络分类的特征信息,从而仅对高权重特征图进行扰动修改。综上所述,本文所设计的基础网络如图3所示。

图3 基础网络Fig.3 Basic network

由图3 可知,基础网络由ResNet 嵌入通道注意力模块得到。通道注意力模块可以对卷积层所生成的多层特征图执行权重分配操作,且后续卷积层会对加权后的多层特征图执行卷积操作。在实际训练过程中,通道注意力模块可以有效地提升ResNet 对于原始输入样本的分类准确率。同时,通道注意力模块的加入不需要额外的损失函数对其进行指导训练,即基础网络的训练过程为

其中,θ为基础网络f的参数,为参数最优值。

2.4 扰动特征图的获取

对基础网络中各卷积层所提取的特征图依次执行特征图选取操作和特征图扰动修改操作,即可得到用于构造对抗扰动的扰动特征图。

2.4.1 特征图选取

现有对抗样本生成方法多数需要对原始输入样本的所有特征图进行扰动添加操作,造成对抗样本生成时间过长。根据对抗扰动的可视化图像可知,对抗扰动的添加区域集中在图像的显著特征区域,即人类视觉关注的重要局部区域。鉴于通道注意力模块可以突出图像中的显著信息,且对于无用信息能够起到一定的抑制作用,因此所提对抗样本生成方法依据基础网络中所嵌入的通道注意力模块选取对分类结果影响较大的部分特征图,避免对全体特征图进行扰动修改操作。同时通道注意力模块的引入可限制扰动修改区域,有效减少扰动修改量,有利于生成具有良好视觉感知效果的对抗样本。

本文通过基础网络的卷积层和通道注意力模块分别获取原始输入样本的各层特征图及相应的权重向量,具体操作流程如图4 所示。其中,特征图和权重向量用于特征图扰动修改操作,加权特征图则用于基础网络的后续卷积操作。

图4 获取特征图及权重向量的操作流程Fig.4 Operation process of obtaining feature maps and weight vectors

由图4 可知,特征图可以直接通过卷积层获取,而权重向量需要执行两个计算操作得到。首先使用全局平均池化操作得到每张特征图的全局信息,计算公式为

其中,c=1,2,…,C,Zc代表第c张特征图的全局信息,H、W和C分别为通道注意力模块输入特征图的高度、宽度和通道数,Fc(h,w)为第c张特征图中坐标为(h,w)的像素点值。

然后,将式(2)所获取的不同层次的全局信息值整合为全局信息向量Z=[Z1,Z2,…,ZC],并通过相应操作得到输入特征图的权重向量,具体计算公式为

其中,S∈RC×1×1为经过通道注意力模块计算所得输入特征图的权重向量,σ(·) 为Sigmoid 函数,δ(·) 为ReLU 函数,和分别表示两层全连接层的权重系数,t为降维系数。

得到各卷积层生成特征图的权重向量S后,利用排序算法对权重向量中各值进行排序,使用其中权重较高的特征图作为待扰动特征图。选取待扰动特征图的计算公式为

其中,M为待扰动特征图,IS为权重向量S排序后所返回的特征图索引序列,F为卷积层所生成的特征图,TOP 函数依据索引序列IS中前k位的索引值,选取卷积层生成特征图F中相同索引位置的特征图,即权重值最高的k张特征图。

对于基础网络中各卷积层生成的特征图均执行上述选取操作,即可得到不同尺寸的待扰动特征图。

2.4.2 特征图扰动修改

卷积神经网络通过卷积层提取原始输入样本中的特征信息用于类别分类,而具有较高权重的特征图可以代表更为重要的特征信息。因此,对已选特征图进行扰动修改可以有效模糊卷积神经网络分类所需的特征信息,从而诱导卷积神经网络误分类。为生成高质量对抗样本,本文设计了一种特征图扰动修改方法,旨在通过较小的扰动修改改变特征图所包含的重要特征信息。

鉴于特征图高亮区域包含显著特征信息,该区域所对应的像素点值也相应较大,故本文方法通过修改特征图中较大像素点值来模糊特征图中所包含的特征信息。具体地,以单张特征图为例,通过对待扰动特征图中各像素点值进行排序操作,并返回对应的像素点索引序列,依据索引序列对前l个较大像素点值进行扰动修改,达到对单张特征图扰动修改的目的。

单张特征图Mi中像素点索引序列的计算公式为

其中,i=1,2,…,k。

通过像素点索引序列在单张特征图Mi中定位到前l个最大值像素点位置,进一步对其执行扰动修改操作。为有效模糊特征图中所包含的特征信息,本文方法将扰动区域内的像素点值均置为相反数,且对于特征图中非扰动区域内的像素点值均置为0,即原始输入图像中的非感兴趣区域不作扰动修改。所有待扰动特征图执行上述扰动修改操作,即可得到相应的仅保留感兴趣区域信息的扰动特征图。

2.5 对抗样本的生成

由于基础网络中具有不同程度的下采样操作,所提取特征图的尺寸也均不相同,因此需要对扰动特征图进行相应的上采样操作至相同尺寸,并进一步通过融合操作得到最终用于生成对抗样本的对抗扰动r。

为保证对抗样本与原始输入样本之间的视觉感知效果,本文方法引入缩放因子ε∈ [0,1]用于限制对抗扰动添加量。最终,将对抗扰动r逐像素叠加至原始输入样本x中,即可得到高迁移性的对抗样本x∗,用于攻击未知的目标网络ftarget,如式

3 实验结果及分析

3.1 实验基本设置

3.1.1 实验环境及数据集

实验硬件环境为Intel Xeon Gold-5118@2.30 GHz (CPU)、NVIDIA RTX 2080 Ti (GPU);软件环境为Ubuntu 14.04.5 LTS、CUDA 10.0、Python 3.8.0 和PyTorch 1.6.0。

不失一般性,本文使用对抗样本生成领域常用的CIFAR-10[23]和MNIST[24]作为实验数据集。其中,CIFAR-10 为彩色图像数据集,包含飞机、汽车、鸟、猫等10 类生活中常见的60 000 张32×32的彩色图像,其中训练样本50 000 张,测试样本10 000 张。MNIST 为手写数字数据集,包含10 类共70 000 张28×28 的手写数字图像,其中训练样本60 000 张,测试样本100 00 张。

3.1.2 评价指标

为验证所提对抗样本生成方法的有效性,本文采用攻击成功率(Attack Success Rate,ASR)评估对抗样本生成方法对于目标网络的误导能力,采用L2范数评估对抗样本的图像质量。为评估对抗样本生成方法在不同目标网络中攻击成功率的稳定程度,引入方差s2作为评价指标。所述三项评价指标具体定义为

其中,N为待分类的数据样本总量,nadv为成功误导目标网络的对抗样本总量,Z为目标网络数量,ASRi为对抗样本生成方法在第i个目标网络中的攻击成功率,为对抗样本生成方法对不同目标网络的攻击成功率的平均值。

3.2 关于方法参数的选取实验

为了验证方法参数对各性能指标的影响,本节对方法参数的不同取值进行实验及分析,从而获取有效的参数设置。其中方法参数包括特征图选取个数k、像素点修改个数l和缩放因子ε。

对于参数k的实验过程为:随机选取基础网络中的某一卷积层,利用所嵌入的通道注意力模块输出多张特征图的权重向量,并计算权重最大的前k张特征图的权重占比总和。实验结果如图5 所示。

图5 关于特征图选取个数k 的实验结果Fig.5 Experimental results on the number k of selected feature maps

由图5 可知,随着特征图选取个数k的不断增加,所选特征图的权重占比总和也随之增加。当特征图选取为3 张(k=3)时,其权重占比总和即可达到97%以上。然而,当特征图选取大于3张(k≥4)时,权重占比总和趋于平稳,并未出现较大幅度增长。该实验结果说明卷积层所提取的多张特征图中仅3 张权重占比最大的特征图即可代表多数特征信息,故在本文后续的实验过程中,特征图选取个数k设置为3。

对于参数l和ε的实验过程为:基于上述有关参数k的实验过程及结果分析,随机改变所选取的3 张特征图的l个像素点值,将融合后所得对抗扰动乘以缩放因子ε添加至原始输入样本并计算相应的攻击成功率ASR和L2范数。参数l和ε关于攻击成功率的实验结果如图6 所示,其中图6(a)和图6(b)分别为基于CIFAR-10 和MNIST 数据集所得攻击成功率的实验结果。

图6 像素点修改个数l 和缩放因子ε 关于攻击成功率的实验结果Fig.6 Experimental results on ASR by modifying the number of pixel points l and the scaling factor ε

由图6 可知,像素点修改个数l和缩放因子ε的变化均影响对抗样本的攻击成功率。综合分析图6 可知,当像素点修改个数l=4 和缩放因子ε=0.2 时,本文方法在CIFAR-10 和MNIST 数据集上的攻击成功率均取得最优值。鉴于此,本文将像素点修改个数l和缩放因子ε分别初步设定为4和0.2。

为评估参数l和ε的取值对样本可视化效果的影响,本文采用L2范数指标作进一步实验验证。图7 给出参数l和ε关于L2范数的实验结果,该结果亦可说明在不同的l和ε下所生成对抗样本的图像质量。由图7 可知,随着参数l和ε的不断增大,相应的L2范数逐渐升高,即对抗样本图像质量逐渐降低。由于对抗样本的生成过程中需同时兼顾对抗样本的攻击成功率和视觉感知效果,故所选定的像素点修改个数和缩放因子在保证攻击成功率较高的同时应使L2范数相对较小。分析图7 可以发现,在初步选定的l和ε参数下所得到的L2范数较小,即在保证较高攻击成功率下能兼顾对抗样本的视觉感知效果,故在后续实验中,最终将像素点修改个数l设置为4,缩放因子ε设置为0.2。

图7 像素点修改个数l 和缩放因子ε 关于L2 范数的实验结果Fig.7 Experimental results on the L2 norm by modifying the number of pixel points l and the scaling factor ε

基于上述选定的参数,本文方法生成的对抗样本可视化结果如图8 所示。观察图8 可知,对于两种不同的数据集,使用该方法生成的对抗样本均较少地改变了图像显著特征信息,原始样本中具体的语义信息得以保留,目标细节信息清晰,视觉感知良好。

图8 对抗样本可视化结果Fig.8 The visualization results of the adversarial examples

3.3 特征图选取层数对比实验

为进一步验证所提方法采用多层次特征图用于对抗样本生成的优越性,本节分别采用深层特征图和多层次特征图执行对抗样本生成过程,并进行实验结果比较及分析。其中深层特征图为基础网络后六层卷积层所提取的特征图,且两组实验的其余条件均一致。具体实验结果如表1。

分析表1 可知,深层特征图仅包含全局信息,如轮廓、形状、最强特征等,由于缺少细节信息的辅助,使得仅依据深层特征图所构造对抗样本的攻击效果较差,而在信息量较少的简单数据集(MNIST)中,细节信息对于整张对抗样本的影响则更加显著。基于此,本文方法采用多层次特征图用于对抗样本生成,旨在最大程度地减少对抗样本中全局信息和细节信息的丢失,使得对抗样本在近似原始样本的视觉感知效果时,达到较高的攻击成功率。由表1 可知,所示实验结果验证了多层次特征图相比深层特征图用于对抗样本生成的优越性。

3.4 不同对抗样本生成方法的比较实验

为了评估本文方法的有效性和先进性,本节将本文方法与现有代表性的MI-FGSM[13]、DI2-FGSM[14]、SGM[16]、AEG[17]和BN-MI-FGSM[18]方法在NoBox 攻击环境下针对不同目标网络进行实验结果比较及分析。其中,目标网络分别为VGG-16[19]、Wide ResNet(WR)[25]、DenseNet-121(DN-121)[26]和Inception-V3(Inc-V3)[27]。为便于多种方法的实验结果对比,已知网络结构设置为图像分类任务中常用的ResNet-18[20]。对抗样本生成方法可获取ResNet-18 网络信息,而目标网络的任何信息均未知。考虑篇幅限制,本节实验数据集采用相对复杂的CIFAR-10 彩色数据集,实验所得结论在MNIST 数据集中同样适用。具体实验结果如表2 所示,其中加粗字体为最优值,加下划线字体为次优值。

表2 不同对抗样本生成方法针对不同目标网络的攻击成功率比较结果Tab.2 Comparison results on ASR of different adversarial example generation methods against different target networks%

由表2 可知,相比于MI-FGSM、DI2-FGSM 和SGM,本文方法所生成的对抗样本在不同目标网络中均达到了较高的攻击成功率。MI-FGSM 和DI2-FGSM 均属于FGSM 方法的变体形式,分别通过动量整合和随机变换操作来适应黑盒攻击环境,虽然可以提高对抗样本的可迁移性,但面对更加复杂的NoBox 攻击环境,并未取得较好的攻击效果。SGM 方法依据黑盒模型训练替代模型,从而完成关于黑盒模型的对抗样本攻击。但在NoBox 攻击环境下,替代模型的训练过程不允许访问目标网络的任何信息,导致SGM 方法生成的对抗样本对于目标网络的攻击效果较差。与上述方法不同的是,本文方法关注卷积神经网络在图像分类任务中所依据的特征信息,通过对特征信息进行有效修改来生成具有可迁移性的对抗样本,使得对抗样本在任何卷积神经网络中均可达到稳定的攻击成功率。

与AEG 和BN-MI-FGSM 方法相比,本文方法在Inc-V3 网络上达到了最优值,在VGG-16、WR和DN-121 网络上达到了次优值。从方法原理上讲,AEG 方法通过对抗性训练构造生成器模型,并使用有效约束条件生成具有可迁移性的对抗样本,但该方法的稳定性不好,从而导致对于不同目标网络无法实现稳定的攻击效果,且原始输入样本过于复杂时,AEG 方法会陷入鞍点优化问题,使得攻击成功率下降。BN-MI-FGSM 方法生成的对抗样本虽然在WR 网络中的攻击成功率略高于本文方法,但该方法需要对原始输入样本整体区域进行扰动修改,而本文方法仅对显著区域添加扰动,且在其余目标网络中的攻击成功率均高于BNMI-FGSM 方法。总体而言,同已有方法相比,本文方法所生成的对抗样本在保持较高攻击成功率的同时,由于重点关注卷积神经网络分类所依据的显著特征信息,使得扰动修改区域可威胁到任意卷积神经网络,因此对抗样本具有扰动信息量少、扰动不可感知、攻击稳定性及样本迁移性俱佳等显著优点,故在综合考虑方法性能、健壮性及实用性等多种因素的条件下,本文方法不失为一种具有竞争力的方法。

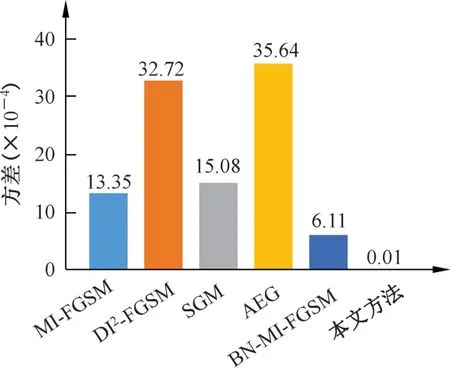

为了进一步展示不同方法的稳定性,图9 将表2 中不同对抗样本生成方法在不同目标网络中的攻击成功率的方差进行了可视化展示。该展示结果反映了不同对抗样本生成方法攻击成功率的波动幅度,亦即反映了不同对抗样本生成方法的稳定性。由图9 可知,与现有代表性方法相比,本文方法所生成的对抗样本在不同卷积神经网络中均可获得稳定的攻击成功率,特别是与近两年攻击性能较好的AEG 和BN-MI-FGSM 方法相比,本文方法的稳定性具有明显的优势,从而进一步验证了本文方法在取得较高攻击成功率的同时具有较好的稳定性和可迁移性。

图9 不同对抗样本生成方法对不同目标网络的攻击成功率的方差结果Fig.9 Results of ASR′s variance on different adversarial example generation methods against different target networks

4 结论

本文提出一种基于特征图融合的对抗样本生成方法。该方法从原始输入样本的特征信息出发,通过引入通道注意力模块并构建基础网络,依次提取、选取和修改包含不同特征信息的特征图,最终融合不同尺寸的特征图生成对抗样本。该方法重点关注用于图像分类的特征信息,不与目标网络产生任何交互信息。基于CIFAR-10 和MNIST 数据集的实验结果表明,本文方法所生成的对抗样本可兼顾攻击成功率与视觉感知效果。与现有代表性对抗样本生成方法相比,本文方法所生成的对抗样本可迁移性高,在不同卷积神经网络中可稳定达到90%以上的攻击成功率。