夜晚图像增强方法综述

2020-07-04姜雪松姚鸿勋

姜雪松 姚鸿勋

摘要:夜晚图像增强作为图像增强领域的一个重要分支,一直受到学者们的关注。夜晚图像增强的目标是提升夜晚图像的整体质量,包括提升亮度和细节可见度、抑制噪声等方面。本文收集了大量真实夜晚图像,并通过人工合成大量低照度图像,使用这些数据对多种夜晚图像增强方法进行分析,比较各种方法在夜晚图像增强任务中的表现,对这些方法的原理、优点和存在的不足加以分析。研究使用主观评价和客观评价两种图像质量评价方法同时评价不同方法的性能,主观评价从视觉感知方向直接评价增强图像的质量,客观评价方法则分为有参考的图像质量评价和无参考的图像质量评价,本文分别使用生成低照度图像和真实夜晚图像测试所有算法性能,为了保证对比实验的公正性,所有算法的参数都按照原论文参数设置。分析和实验结果表明,基于图像处理方法的夜晚图像增强方法能够有效提升图像亮度,但也发现了传统图像处理在夜晚图像增强问题中存在的瓶颈,而基于机器学习的夜晚图像增强方法能够改变夜晚图像的亮度分布情况,更好地提升夜晚图像质量,夜晚图像增强的进一步发展必然使用机器学习方法。

关键词: 夜晚图像增强; 图像处理; Retinex模型; 图像分解; 深度学习

【Abstract】 Nighttime image enhancement, as an important branch of image enhancement, has attracted the attention of researchers. The goal of nighttime image enhancement is to improve the overall quality of night image, including enhancing brightness and detail visibility, suppressing noise and so on. Firstly, this paper collects a large number of real night images and synthesizes a large number of low-light images artificially. Then, the paper uses these data to analyze various nighttime image enhancement methods, compares their performance, and analyzes the principles, advantages and disadvantages of these methods. After that, the paper uses subjective evaluation and objective evaluation to evaluate the performance of different methods at the same time. Subjective evaluation directly evaluates the quality of enhanced images from the direction of visual perception. The objective evaluation methods are divided into reference image quality evaluation and non-reference image quality evaluation.Low-light is used respectively. Degree image and real night image test the performance of all algorithms. In order to ensure the fairness of the contrast experiment, all the parameters of the algorithms are applied to set according to the parameters of the original paper. The analysis and experimental results show that the night image enhancement method based on image processing method can effectively improve the brightness of the image, but it also finds the bottleneck of the traditional image processing in the night image enhancement. The night image enhancement method based on machine learning can change the brightness distribution of the night image and improve the night image quality better. The further development of night image enhancement will inevitably use machine learning method.

【Key words】 nighttime image enhancement; image processing; Retinex model; image decomposition; deep learning

0 引 言

在人們的日常生活、生产过程中,难免会在夜晚采集数字图像,以获得当时的信息;或者在夜间场景下工作,与场景中的物体产生互动。而这些都需要在夜晚环境中采集图像或视频(本文将视频视为图像序列,后文将仅就单幅图像进行分析,事实上,夜间视频因包含更多信息比单幅夜晚图像更容易处理),这就让夜晚图像增强算法的研究有很高的应用价值和科研价值。

在夜晚环境中采集的图像,由于夜间照明的特殊性,光源来源复杂,强弱不一,使得夜间环境或者光线亮度不足(如黯淡月光、星光、烛光等),拍摄的图像亮度值极低,可见度和对比度严重下降,并伴随着大量的随机噪声;或者光照分布不均匀(局部有光源照射,如车灯、路灯、日光灯等),使部分区域照明充足而周边区域亮度极低,影响这些区域的细节可见度和局部对比度,并在较暗区域产生比其他区域更复杂的噪声分布;抑或因为光源来源复杂(如钠灯、霓虹灯等),产生的光照本身并非白色光照,改变场景内物体表面的色彩,使拍摄得到的图像出现色彩偏差。而夜晚增强算法针对的是夜晚环境的特点,提升夜晚图像的质量,包括提升亮度和对比度,增强图像细节的可见度,抑制噪声等级以及校正出现的色彩偏差问题等等。

综上所述,夜晚图像增强面临的问题复杂,几个问题之间相互关联影响,在设计图像增强算法时很难逐一解决上述问题,往往需要借助各种假设和先验简化问题难度,或者将所有问题构建在统一的增强算法框架中。因此,增强夜晚图像相比有目标导向的增强普通图像更难找到合适的方法。针对上述难题,研究者们提出了不同的假设和先验,在一个方法中解决一个或多个问题。

1 夜晚图像增强算法

1.1 基于底层图像处理的夜晚图像增强方法

夜晚图像最显著的特点就是图像亮度和对比度低,细节的辨识程度差,从这个问题分析,提升图像亮度最简单直接的方法就是使用线性函数放大图像亮度,然而这一方法缺点明显,因为方法中采用的是全局提升亮度的处理方式,不考虑图像内亮度的空间分布,使增强后的结果在亮度高的区域出现不可避免的过饱和现象,细节丢失严重。为了避免这一现象出现,非线性单调映射函数更适合提升图像的亮度,如幂律函数(Power-law function)[1]、对数函数(logarithm function)[2]、伽马函数(gamma function)[3]等。这些非线性函数通过调整参数改变图像亮度的增强幅度,利用非线性函数的特点避免亮度较高区域和低亮度区域增强相同幅度引起的失真,保持增强结果的图像质量。其中,伽马函数的应用较为广泛,配合其他图像处理方法能够合理地提升图像亮度,这些方法都属于全局的图像增强算法。直方图均衡化(Histogram equalization,HE)[4]也是全局图像处理方法之一,也能够增强图像亮度。HE能够拉伸图像的直方图的空间分布,提升部分像素的亮度值,增大图像对比度,虽然同样不考虑像素点的空间分布信息,但是由于其算法简单,可用性强,现已广泛地使用到多种图像处理领域。HE的许多扩展算法也被用来增强低照度图像,加入亮度限制[5-7]、对比度限制[8]、图像金字塔[9]都能提升HE的性能。但是全局增强方法并不考虑图像内的亮度分布信息和细节丢失,提升亮度的映射函数兼顾全局的同时无法保证图像所有区域都得到有效的提升,难以保证图像质量。

全局夜晚图像增强算法不考虑图像内亮度和细节的空间分布,使用统一的参数和模式提升图像亮度,总是带来不可避免的副效应。学者们将目光投向了局部图像处理方法。对全局图像增强算法最直接的改进是局部直方图均衡化方法(Local histogram equalization,LHE)[10-12],使用滑动窗口策略调整局部图像块的直方图来增强图像块的对比度,通常可以分为图像分块算法(即滑动窗口无重叠)、滑动窗口重叠算法和滑动窗口部分重叠算法,三者各有优劣,图像分块算法计算速度快,细节增强充分,但是各图像块之间直方图均衡函数差异较大,容易产生块效应;滑动窗口重叠算法便利图像所有像素,能够有效避免块效应,但是算法效率低,计算消耗资源多;滑动窗口部分重叠算法综合上述二者特点,采用更大的移动步长,平均多次均衡的像素灰度值作为最终输出图像的灰度值。此外,还存在大量的基于局部直方图均衡化的变种算法,但大体框架如上,这在里不做一一赘述。

一些研究者将全局图像增强和局部图像增强算法的特点融合,采用多种增强算法叠加的策略增强低照度图像。这些方法通常不采用单一的非线性函数或直方图均衡化方法,而是通过变换色彩空间,分别处理图像的亮度、饱和度和对比度等信息,使用全局色调映射、局部色调映射、全局与局部直方图处理等方法组合在一起,构建复杂的色彩与亮度调整方法 [13-17]。如文献[13]中采用的方式,使用圖像亮度计算非线性映射的参数,通过多次全局色调映射、照明估计、直方图调整、纹理提取和主成分分析(Principal component analysis,PCA)一系列算法,组成了复杂的图像增强策略,实验效果良好,针对低照度图像有明显的亮度提升功效,同时避免了较亮区域的失真,其更适用于HDR图像的增强。但是这一类方法结构复杂,且难以控制实验结果,固定的参数不具有普适性,难以应对夜晚图像增强面临的复杂问题。

1.2 基于底层图像处理的夜晚图像增强方法

基于图像处理的夜晚图像增强方法从提升图像亮度的角度出发,利用线性或非线性函数将低照度图像的亮度向更大的方向拉伸,只是单纯从数学的角度出发,并不考虑夜晚图像成像过程的物理模型,导致部分情况下增强结果无法满足人们的需求。

Retinex理论[18-19]是人类视觉的一种颜色感知模型,反映人类色觉的基础机制,既取决于视网膜感光细胞(Retina)的捕捉,也取决于这些信号在大脑皮层(Cortex)的解释。其基本思想是人感知到某点的颜色和亮度并不仅仅取决于该点进入人眼的绝对光线,还和其周围的颜色和亮度有关。Retinex理论建立在3个假设之上,即:真实世界没有颜色,对颜色的感知是由光与物质的相互作用产生的;每个颜色区域可以由固定波长的红、绿、蓝三原色构成;上述三原色决定每个像素的色彩。

Retinex理论基础是物体颜色由物体对不同波长光线的反射能力决定,而非反射光线的强度,物体的色彩不会被光照的非均匀性影响,具有一致性,即Retinex以颜色恒常性为基础。也就是说,在Retinex模型当中,光照强度和物体颜色是不相关的。一般来说,Retinex可以表示为:

I = S·R,[JY](1)

其中,I表示人眼或摄像设备能接收到的反射光图像;S表示入射光图像,其强度决定了图像像素值能达到的动态范围,反映场景内光照信息,因此也被称为照度分量(或照明图,Illumination map);R表示场景内物体的反射性质图像,这是物体的固有属性,不随光照的变化而改变,也被称为反射图(Reflectance map)。

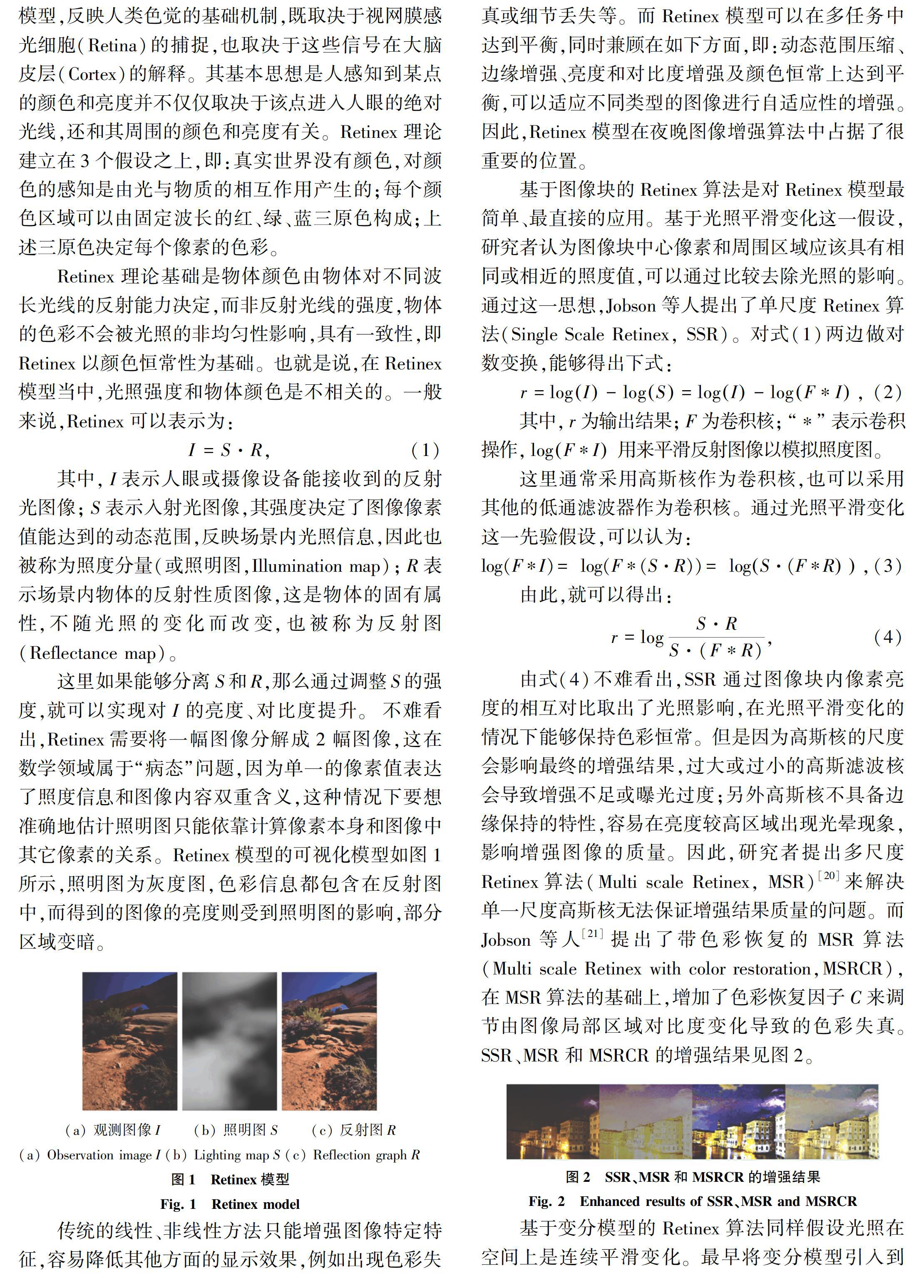

這里如果能够分离S和R,那么通过调整S的强度,就可以实现对I的亮度、对比度提升。不难看出,Retinex需要将一幅图像分解成2幅图像,这在数学领域属于“病态”问题,因为单一的像素值表达了照度信息和图像内容双重含义,这种情况下要想准确地估计照明图只能依靠计算像素本身和图像中其它像素的关系。Retinex模型的可视化模型如图1所示,照明图为灰度图,色彩信息都包含在反射图中,而得到的图像的亮度则受到照明图的影响,部分区域变暗。

针对能够稳定提供多幅同场景不同时间的图像或者同一场景一段时间内的多幅图像的情况,或者可以提供其他种类的场景信息来源的情形,基于图像融合的夜晚图像增强算法能够取得更优异的增强结果。

最容易得到同一场景不同时段的多幅图像就是监控场景[35-38]。在监控视频的应用场景中,因为摄像机固定,所以可以假设其拍摄的图像的背景信息不变。将白天时拍摄的清晰图像与夜晚拍摄的降质图像作为算法输入,提取图像中不变的物体作为图像背景,将白天图像中的背景与夜晚图像中的前景进行融合,得到最终的输出图像。这种算法的增强结果背景亮度值较高,背景保真度也很不错,但是由于没有合适的增强前景目标的方法,使得图像出现很强的不和谐的感觉,图像自然性差。而且前景与背景分离的时候很难把握二者之间的尺度,容易出现失真和二者之间的亮度、色彩过渡地区的失真。部分算法考虑的前景的处理问题,对其进行了亮度和对比度提升,但是由于前景与背景的增强方式区别很大,过渡区域的失真问题仍难以解决。另外存在的问题就是监控设备的稳定性问题,因为现实场景存在震动、风等多种外在干扰,监控设备的位置会受到影响,在一定程度上移动了监控设备对准的位置,即不同时间拍摄的图像难以保证是像素对齐的,这样融合的时候产生的结果质量难以保证。而采用图像匹配方法会增加计算消耗,同时不同照明环境下的同一物体梯度信息和纹理信息相差较大,很难保证像素间对齐的准确率,进而影响增强结果。

目前针对这一问题,一些其他的方法被提出来。首先比较直接的做法便是采集同一场景内一段时间内的低照度视频,对齐进行融合得到提升亮度的图像。这类方法[39-43]等同于在拍照时延长曝光时间,常用于移动摄影设备,如智能手机、智能相机等的夜间拍照模式。不难判断,这一类方法需要场景内不存在运动物体,摄像设备尽量保持稳定以降低融合时像素偏移造成的干扰。除了使用多幅图像融合外,研究者们还使用单幅低照度图像生成多幅关注不同信息的图像来融合成最终的增强结果。受到HDR图像融合方法[44-45]的启发,使用输入的低照度图像的亮度图生成不同虚拟曝光程度的亮度图,然后将亮度图在融合如输入图像的色调、饱和度信息以得到增强结果。文献[46-47]的作者都采用了相同的融合方法,即给定初始的照明图,采用不同的非线性函数提升照明图亮度,而后从中提取拉普拉斯图像金字塔和作为权重的图像高斯金字塔,将多幅不同曝光的照明图融合得到提升亮度的照明图,最后得到增强结果。2个方法的唯一不同之处在于计算初始照明图的方法不同,文献[46]采用HSV色彩空间的明度通道作为初始照明图,而文献[47]采用使用指导滤波器[48]的图像分解方法提取初始照明图。Ma等人[49]通过分析低曝光图像和正常曝光图像之间的区别,统计模拟函数模拟图像的曝光过程,改变参数即可得到不同曝光程度的图像,然后将多幅虚拟曝光图像通过评估结果进行像素融合,得到最终的增强图像,实验结果说明这类方法提升亮度明显,色彩保持更鲜艳,保真度较高。

此外,融合不同种类的图像也能够提升夜晚图像的质量。最常用的就是融合红外图像和可见光图像以提升图像质量[50-54]。可见光摄像设备和红外摄像设备放置在同一位置,去除夹角影响后,可见光摄像设备拍摄场景中物体的颜色信息和照明光变化,红外摄像设备不受照明光变化的影响,反映场景内物体的的温度差或辐射差,能够拍摄出物体的轮廓差异,可以有助于分别背景和目标。可见光图像与红外图像的融合可以从3个层次进行:像素级、特征级和决策级。像素级图像融合是最低层次的融合,作为另外两个层次的图像融合方式的基础,直接对2幅或多幅图像中的对应像素点进行信息综合处理。特征级图像融合使用在2幅或多幅图像中提取的特征向量进行融合,主要提取图像中的边缘、形状、方向等底层特征,确保图像之间的特征的对应性。决策级图像融合是针对图像内信息进行属性提取和描述,而后将不同图像中提取的重要性息融合在一起,最后一种融合得到的属性作为决策依据。针对不同的融合层次,也有不同的融合方法与之相对应。可见光图像和红外图像的融合方法中,常有的方法有基于变换域的融合方法、基于成像模型的融合方法、基于线性加权的融合方法、基于多尺度分解的融合方法、贝叶斯估计法、熵法、模糊聚类法等。

但是融合可见光图像和红外图像的时候,仍然有很多问题。可见光图像和红外图像之间存在巨大差异,二者成像原理有很大差别,分辨率相差较大,图像内灰度、纹理、边缘特征、像素关联都有很大差别,这些差别一方面保证了融合2种图像能够得到更多信息,另一方面却增加了融合两者的难度,参数设置、色彩保持、边缘保持、运动目标与背景的分离等都有很大难度,增强后的图像结果难以保证。另外,额外的红外摄像设备即增加了硬件资源开销,也需要对应的软件开发需求,限制了这种方法的应用空间和应用前景。

1.3 基于机器学习的夜晚图像增强方法

机器学习方法在计算机视觉中有很广泛的应用,在底层图像处理中也能够取得不错的成绩。基于机器学习的夜晚图像增强算法最大的障碍就是数据集的收集,在同一场景采集白天和夜晚的图像,既要场景内没有随时间变化出现物体位移、出现和消失,又要保证数据量充足,能够满足训练过程的需要。为了克服这一问题,研究者们或者借用HDR图像数据集,将低曝光度的图像作为夜晚图像,正常曝光度的图像作为标签图像;又或通过非线性函数或人工处理的方式将正常图像亮度降低,模拟夜晚图像。但是这样产生的样本与夜晚图像有一定差别,而且相同的亮度降低操作也降低了模型学习的难度,无法保证方法在真实夜晚图像的作用。

比较早的基于机器学习的夜晚图像增强方法使用的是稀疏表示来学习模型[55]。稀疏表示是前些年图像处理和计算机视觉领域最常用的机器学习方法,通过为普通稠密表达的样本学习过完备字典(亦成为过完备基),将样本转化为合适的稀疏表达模式,降低模型复杂度,也被称为“稀疏编码”。文献[55]学习低照度图像和正常图像两个字典,给定输入夜晚图像能够在低照度图像字典中使用少量特征向量重构,那么对应的向量在正常圖像字典中就能够重构出增强结果。

深度学习方法已经成为了机器学习领域最热门的方法,在自然语言处理、图像处理和计算机视觉领域都取得了可观的研究成果,在性能上远远超过了此前的一些机器学习方法。Lore等人[55]使用深度自编码器增强低亮度图像,将亮度提升和噪声抑制同时放在一个模型当中学习出来,通过一定量数据的学习,能够得到不错的效果,但是由于自编码器本身对于输入图像的尺寸有要求,而且参数较多,导致了本方法提供的实验数据都是小尺寸的图像,很难确定其在真实夜晚图像的表现情况。

深度卷积神经网络在图像处理领域中比自编码器应用得更广,其共享参数的卷积网络模式能够学习更复杂的像素映射,因此在图像去噪、超分辨率和图像去雾等底层图像处理任务中都表现优异。Wei等人[56]使用深度神经网络模拟Retinex模型(RetinexNet),让低照度图像和正常图像共享网络参数,分解得到相同的反射图,以确保二者照明图的不同,然后基于分解结果训练网络增强照明图,增强结果亮度提升明显。但是在处理真实的夜晚图像时,特别是包含噪声多的夜晚图像,增强结果出现了严重的色彩失真,噪声被明显放大。

HDR-Net[57]同时训练2个并行的网络结构,与RetinexNet不同的是,其目标并不是将图像分解,而是从图像中计算出对应像素值的变换系数,同时兼顾图像的全局特征和局部特征,再使用另一个神经网络计算求得的变换系数对应的像素位置,然后计算得到增强结果。该方法相当于在有指导图像的情况下融合多个线性增强后的图像,能够保证图像不会出现大范围失真。

MSR-Net[58]使用传统的深度卷积神经网络,将输入的夜晚图像进行尺度对数变换,得到亮度被提升不同等级的图像,然后将这些图像输入神经网络得到增强结果。MSR-Net与HDR-Net同样采用融合图像的思想,不同之处在于二者的网络结构,MSR-Net人工设定了几个亮度提升等级,而HDR-Net通过网络学习得到。但是在输入图像的平滑区域如果存在噪声,例如夜晚的天空,卷积神经网络通常会产生类似块效应的模糊效果,会降低图像质量。之所以造成这种现象,除了深度神经网络本身的特性外,数据量不足、损失函数缺少有效约束也有一定的原因。

LSID[17]不针对已经采集得到的图像,转而针对相机端的原始数据(例如RAW,RAF格式等)进行增强处理。相机端采集的数据未经处理和存储,包含的图像信息更多,在进行图像增强时能够给深度神经网络提供更多的信息。在LSID中,作者采用不同的曝光时长模拟不同亮度的图像,其输入的短曝光时长数据可以使用其他的图像处理函数直接提升亮度,和该方法设计的网络提升的亮度基本一致。但是使用图像处理函数得到的增强图像包含很多的噪声,尤其是因曝光时长过短产生的各种噪声明显影响图像质量,而使用Chen等人提出的深度神经网络处理的短曝光图像则很平滑,可见该方法的主要作用在于抑制短曝光图像的噪声等级随着图像亮度提升而提升。

2 对比实验

在本节,使用大量夜晚图像测试提出夜晚图像增强方法,和其他的夜晚图像增强方法进行对比试验,从主观评价和客观评价两个方面评测方法的性能。本文使用之前方法常用的夜晚图像和Exdark[59]数据集测试本文提出的增强方法,并人工生成一定数量夜晚图像,使用有参考的图像质量评价标准测试增强方法性能,这样测试数据集可以大致分为14个类别,分别包含不同数量的夜间图像或生成夜间图像,自然夜间图像每种类别有500~800张图像,生成图像包含由1 100张正常图像合成的5 500张低照度图像。在此基础上又将增强方法应用到实施拍摄的夜晚视频中测试增强效果。

2.1 主观评价

主观评价是评价图像处理算法性能最常用的评价方式,通过提供列举不同类型的图像和对应结果,让使用者直接观察图像,从视觉感官的主观感受出发评价图像质量,能够更直观地感受到不同方法在同一图像处理问题上得到的性能差异。夜晚图像增强结果比较见图3。

由图3可以看出使用物理模型对图像进行建模的方法在保持图像自然性方面更有优势,能够避免增强图像内出现过度增强现象。不同夜晚图像增强方法的结果见图4。

由图4可以看出LIME和NEID能够得到亮度提升最明显的增强结果,但是NEID增加了噪声抑制处理,增强结果看起来更平滑,图像质量有所提升。 Retinex-net和HDR-net增强结果比较见图5。

由图5可以看出Retinex-net在增强夜晚图像时,出现了明显的过度增强现象,严重影响了增强结果质量,而HDR-net能够保持图像原本的光照分布,但是也无法达到夜晚图像白昼化,原因主要在于训练数据的缺乏。LSID得到的增强结果见图6。

由图6可以看出其与使用相机自带的图像处理函数得到的结果差别在于噪声被抑制,与长曝光图像的色彩也有所不同,说明LSID具有一定的图像白平衡作用。但是和使用相机函数增强的结果相比,说明LSID在夜晚图像在噪声抑制方向更有优势,其对于图像亮度的提升效果如图7所示。

2.2 客观评价

夜晚图像增强方法关注图像的整体质量,除了直观的主观视觉感知评价之外,还使用多种客观评价方法测试提出的增强方法的性能。研究不仅使用图像标准差(STD)、平均梯度(MG)和图像信息熵(IE)这三种能够直接反映图像内纹理、梯度等信息的衡量方法,同时也使用基于自然图像统计特性提出的几种图像质量衡量方法,包括NIQE (Natural image quality evaluator)[60],ARIS (Autoregressive-based image sharpness metric)[61], BLIIND (blind image quality assessment by DCT statistics model)[62]和OG-I(Relative gradient statistics and adaBoosting neural network)[63]。这几种无参考图像质量评价方法各有侧重,从不同角度评价图像质量,反映各种夜晚图像增强方法的性能。同时研究合成了不同亮度的夜晚图像用于有参考的图像质量评价,包括MSE、PSNR和SSIM[63]图像质量评价方法。本次研究主要测试了时下各种具有代表性的方法,即:SRIE、FEWI、LIME、JIEP、Dong、FSBI、NPEA、NEID、BIMEF和OpenCE。不同夜晚图像增强方法的无参考图像的图像质量客观评价见表1。

由表1可以看出LIME在使用圖像内部梯度信息计算的评分评价较高,而NEID在其他基于自然图像统计特性的评价取得评分较高,究其原因在于二者都能大幅度提升夜晚图像的亮度,但是LIME不考虑噪声问题,NEID增加了噪声抑制。OpenCE使用相机响应函数提升图像亮度,得到的增强结果亮度也比一般的图像增强方法高。而NPEA并不适用于夜晚突袭中的HDR场景,增强结果的光源总是出现失真,这些方法的增强图像的直接比较结果如图8所示。

进一步,研究给出了有参考的图像质量评价结果见表2。其中,NEID在MSE评价和PSNR两项评分最佳,主要在于该方法在提升亮度时抑制噪声,因此LIME在MSE上取得了次优的成绩,OpenCE基于像素点计算图像亮度提升使用的参数,得到的增强结果对图像结构保持较好,所以在SSIM评价上取得了最优评价。

3 结束语

本文通过大量实验,测试了不同的夜晚图像增强方法的性能,并对这些方法加以分析,说明其偏重的方向、优势、和不足。通过实验分析发现基于底层图像处理在夜晚图像增强中瓶颈,并分析了几种基于机器学习的夜晚图像增强方法的原理和性能,得出了以下结论:底层图像处理能够提升夜晚图像亮度,但无法改变夜晚图像质量降低的本质,基于机器学习的方法具有实现夜晚图像白昼化潜力,但目前因数据收集的困难无法实现。因此,目前夜晚图像增强方法面临的较突出问题就是数据问题,如何收集对应的夜晚图像和正常图像对将是后续重点研究方向。

参考文献

[1] BEGHDADI A, NEGRATE A L. Contrast enhancement technique based on local detection of edges[J]. Computer Vision Graphics and Image Processing, 1989, 46(2):162.

[2]PELI E. Contrast in complex images[J]. Journal of the Optical Society of America A-optics and Image Science & Vision, 1990, 7(10):2032.

[3]GONZALEZ R, WOODS R. Digital image processing[M]. 3rd ed. Upper Saddle River, NJ:Pearson prentice hall, 2008.

[4]JAIN A K. Fundamentals of digital image processing[M]. New Jersey:Prentice-Hall, Inc., 1989.

[5]IBRAHIM H, KONG N S P . Brightness preserving dynamic histogram equalization for image contrast enhancement[J]. IEEE Transactions on Consumer Electronics, 2008, 53(4):1752.

[6]WANG Chao, YE Zhongfu. Brightness preserving histogram equalization with maximum entropy: A variational perspective[J]. IEEE Transactions on Consumer Electronics, 2005, 51(4):1326.

[7]CHEN S D, RAMLI A R. Minimum mean brightness error Bi-histogram equalization in contrast enhancement[J]. IEEE Transactions on Consumer Electronics, 2003, 49(4):1310.

[8]REZA A M. Realization of the contrast limited adaptive histogram equalization (CLAHE) for real-time image enhancement[J]. Journal of VLSI Signal Processing Systems for Signal, Image, and, Video Technology, 2004, 38(1):35.

[9]YUN S H, KIM J H, KIM S . Image enhancement using a fusion framework of histogram equalization and laplacian pyramid[J]. IEEE Transactions on Consumer Electronics, 2010, 56(4):2763.

[10]ABDULLAH-AL-WADUD M, KABIR M H, DEWAN M A A, et al. A dynamic histogram equalization for image contrast enhancement[J]. IEEE Transactions on Consumer Electronics, 2007, 53(2):593.

[11]STARK J A. Adaptive image contrast enhancement using generalizations of histogram equalization[J]. IEEE Transactions on Image Processing:A publication of the IEEE Signal Processing Society, 2000, 9(5):889.

[12]WANG Xuewen, CHEN Lixia. Contrast enhancement using feature-preserving bi-histogram equalization[J]. Signal Image & Video Processing, 2018, 12(4):685.

[13]CHEN S, BEGHDADI A. Natural enhancement of color image[J]. EURASIP Journal on Image and Video Processing, 2010, 2010(1):175203.

[14]FANG Fang, LIN Meirong, LI Yingjie, et al. Color image saturation enhancement[J]. Proceedings of SPIE - The International Society for Optical Engineering, 2000.

[15]NACCARI F, BATTIATO S, BRUNA A R, et al. Natural scenes enhancement by adaptive color correction[C]// International Symposium on Consumer Electronics. Reading, UK:IEEE, 2004: 320.

[16]MOREL J, PETRO A B, SBERT C, et al. Toward a natural local color image enhancement[C]// International Conference on Computer Graphics, Imaging and Visualisation. Washington, DC:IEEE, 2012: 211.

[17]WANG Shuhang, LUO Gang. Naturalness preserved image enhancement using a priori multi-layer lightness statistics [J]. IEEE Transactions on Image Processing, 2018, 27(2): 938.

[18]LAND E H. The Retinex[J]. American Scientist, 1964, 52(2):247.

[19]LAND E H, MCCANN J J. Lightness and Retinex theory[J]. The Journal of the Optical Society of America, 1971, 61(1):1.

[20]JOBSON D J, RAHMAN Z, WOODELL G A. Properties and performance of a center / surround Retinex[J]. IEEE Transactions on Image Processing, 1997, 6(3): 451.

[21]JOBSON D J, RAHMAN Z, WOODELL G A . A multiscale retinex for bridging the gap between color images and the human observation of scenes[J]. IEEE Transactions on Image Processing, 1997, 6(7):965.

[22]KIMMEL R, ELAD M, SHAKED D, et al. A variational framework for Retinex[J]. International Journal of Computer Vision, 2003, 52(1):7.

[23]Ma W, Osher S. A TV Bregman iterative model of Retinex theory[R]. Los Angeles:University of California, 2010.

[24]NG M K, WANG Wei. A total variation model for Retinex[J]. SIAM Journal on Imaging Sciences, 2011, 4(1): 345.

[25]CHEN T, YIN W, ZHOU X S, et al. Total variation models for variable lighting face recognition[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2006, 28(9): 1519.

[26]FU X, ZENG D , HUANG Y , et al. A weighted variational model for simultaneous reflectance and illumination estimation[C]// Proceedings of the 2016 IEEE Computer Vision & Pattern Recognition. Piscataway, NJ:IEEE, 2016:2782.

[27]PARK S, MOON B , KO S. Low-light image restoration using bright channel prior-based variational Retinex model[J]. EURASIP Journal on Image and Video Processing, 2017, 2017(1):44.

[28]PARK S , YU S , MOON B , et al. Low-light image enhancement using variational optimization-based Retinex model[J]. IEEE Transactions on Consumer Electronics, 2017, 63(2):178.

[29]GUO Xiaojie, LI Yu, LING Haibin. LIME: Low-light image enhancement via illumination map estimation[J]. IEEE Transactions on Image Processing, 2017, 26(2):982.

[30]CAI Bolun, XU Xianming, GUO Kailing, et al. A joint intrinsic-extrinsic prior model for Retinex [C]// IEEE International Conference on Computer Vision. Venice, Italy:IEEE, 2017: 4020.

[31]HE K M, SUN J, TANG X O. Single image haze removal using dark channel prior[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2011, 33(12):2341.

[32]DONG Xuan, WANG Guan, PANG Yi, et al. Fast efficient algorithm for enhancement of low lighting video[C]// 2011 IEEE International Conference on Multimedia and Expo. Barcelona:IEEE, 201:1.

[33]YING Zhenqiang, LI Ge, REN Yurui, et al. A new low-light image enhancement algorithm using camera response model[C]//2017 IEEE International Conference on Computer Vision Workshop.Venice, Italy:IEEE , 2017: 3015.

[34]JIANG Xuesong, YAO Hongxun, LIU Dilin. Nighttime image enhancement based on image decomposition[J]. Signal Image and Video Processing, 2019,13(1): 189.

[35]CAI Y, HUANG K, TAN T, et al. Context enhancement of nighttime surveillance by image fusion[C]// International Conference on Pattern Recognition.Hongkong:IEEE, 2006: 980.

[36]KAO W C, HSU C C, KAO C C, et al. Adaptive exposure control and real-time image fusion for surveillance systems[C]// IEEE International Symposium on Circuits & Systems. Island of Kos, Greece:IEEE,2006: 935.

[37]RAO Yunbo, LIN Weiyao, CHEN Leiting. Image-based fusion for video enhancement of night-time surveillance[J]. Optical Engineering, 2010, 49(12): 120501.

[38]BHATNAGAR G, LIU Zheng. A novel image fusion framework for night-vision navigation and surveillance[J]. Signal Image & Video Processing, 2015, 9(S1):165.

[39]BENNETT E P, MCMILLAN L. Video enhancement using per-pixel virtual exposures[J]. ACM Transactions on Graphics, 2005, 24(3):845.

[40]MALM H, OSKARSSON M, WARRANT E, et al. Adaptive enhancement and noise reduction in very low light-level video[C]// IEEE International Conference on Computer Vision. Rio deJaneiro:IEEE, 2007: 1395.

[41]REMPEL A G, TRENTACOSTE M, SEETZEN H, et al. Ldr2Hdr: on-the-fly reverse tone mapping of legacy video and photographs[J]. ACM Transactions on Graphics, 2007, 26(99):39.

[42]BANTERLE F, LEDDA P, DEBATTISTA K, et al. Inverse tone mapping[C]// International Conference on Computer Graphics & Interactive Techniques in Australasia & Southeast Asia.[S.l.]: ACM, 2006: 349.

[43]LI S, KANG X. Fast multi-exposure image fusion with median filter and recursive filter[J]. IEEE Transactions on Consumer Electronics, 2012, 58(2):626.

[44]LI Shutao, KANG Xudong, FANG Leyuan, et al. Pixel-level image fusion: A survey of the state of the art[J]. Information Fusion, 2017, 33: 100.

[45]WANG Qiuhong, FU Xueyang, ZHANG Xiaoping, et al. A fusion-based method for single backlit image enhancement[C]// IEEE International Conference on Image Processing(ICIP). Phoenix, AX, USA: IEEE, 2016: 4077.

[46]FU Xuegang, ZENG Delu, HUANG Yue, et al. A fusion-based enhancing method for weakly illuminated images[J]. Signal Processing, 2016,129: 82.

[47]HE Kaiming, SUN Jian, TANG Xiao'ou. Guided image filtering[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2013, 35(6):1397.

[48]YING Zhenqiang, LI Ge, GAO Wen. A bio-inspired multi-exposure fusion framework for low-light image enhancement[J]. arXiv preprint arXiv:1711.00591, 2017.

[49]MA Jiayi, MA Yong, LI Chang . Infrared and visible image fusion methods and applications: A survey[J]. Information Fusion, 2018,45: 153.

[50]TSAGARIS V, ANASTASSOPOULOS V. Fusion of visible and infrared imagery for night color vision[J]. Displays, 2005, 26(4-5):191.

[51]ZHOU Z, DONG M, XIE X, et al. Fusion of infrared and visible images for night-vision context enhancement[J]. Applied Optics, 2016, 55(23):6480.

[52]WANG Y, SHI X, LI F, et al. An effective color image fusion algorithm of visual and infrared night images[C]// 2014 26th Chinese Control and Decision Conference. Changsha:IEEE, 2014: 2974.

[53]SAVOYE E D, SEIBERT M C, CARRICK J E, et al. Color night vision: Opponent processing in the fusion of visible and IR imagery[J]. Neural Networks:The official Journal of the International Neural Network Society, 1997, 10(1):1.

[54]FOTIADOU K, TSAGKATAKIS G, TSAKALIDES P, et al. Low light image enhancement via sparse representations[M]// CAMPILHO A, KAMEL M.ICIAR 2014, Part I, LINS 8814. Switzerland:Springer, 2014: 84.

[55]LORE K G, AKINTAYO A, SARKAR S. LLNet: A deep autoencoder approach to natural low-light image enhancement[J]. Pattern Recognition, 2015, 61:650.

[56]WEI Chen, WANG Wenjing, YANG Wenhan, et al. Deep Retinex decomposition for low-light enhancement[C]//British Machine Vision Conference 2018(BMVC 2018). Newcasle:Northumbria Unviersity, 2018.

[57]SHEN Liang, YUE Zihan, FENG Fan, et al. MSR-net: Low-light image enhancement using deep convolutional network[J]. arXiv preprint arXiv: 1711.02488, 2017.

[58]CHEN Chen, CHEN Qifeng, XU Jjia, et al. Learning to see in the dark[J]. Computer Vision and Pattern Recognition, 2018: 3291.

[59]LOH Y P, CHAN C S. Getting to know low-light images with the exclusively dark dataset[J]. Computer Vision and Image Understanding, 2019(178): 30.

[60]MITTAL A, SOUNDARARAJAN R, BOVIK A C. Making a 'completely blind' image quality analyzer[J]. IEEE Signal Processing Letters, 2013, 20(3):209.

[61]GU Ke, ZHAI Guangtao, LIN Wei, et al. No-reference image sharpness assessment in autoregressive parameter space[J]. IEEE Transactions on Image Processing:A publication of the IEEE Signal Processing, 2015, 24(10):3218.

[62]SAAD M A, BOVIK A C, CHARRIER C. Blind image quality assessment: A natural scene statistics approach in the DCT domain[J]. IEEE Transactions on Image Processing, 2012, 21(8):3339.

[63]LIU Lixiong, HUA Yi, ZHAO Qingjie, et al. Blind image quality assessment by relative gradient statistics and AdaBoosting neural network[J]. Signal Processing Image Communication, 2015, 40(C):1.

[64]GHARBI M, CHEN Jiawen, BARRON J T , et al. Deep bilateral learning for real-time image enhancement[J]. ACM Transactions on Graphics, 2017, 36(4):118.

[65]WANG Z, BOVIK A C, SHEIKH H R , et al. Image quality assessment: From error visibility to structural similarity[J]. IEEE Transactions on Image Processing, 2004, 13(4): 600.