基于ERNIE的命名实体识别

2020-07-04张晓李业刚王栋史树敏

张晓 李业刚 王栋 史树敏

摘要:针对深度学习方法处理命名实体识别任务时,经典的词向量表示只能将其映射为单一向量,无法在上下文中表示出字的多义性这一问题,提出ERNIE-BiGRU-CRF模型,该模型通过知识增强语义表示ERNIE预训练模型增强字的语义感知表示。引入多元数据知识生成语义向量,然后将字向量输入到GRU层提取特征,最后通过CRF层得到标签序列。实验结果表明,该模型在人民日报语料库中F1值达到了94.46%。

关键词: 命名实体识别; 知识增强语义表示; 门控循环单元网络; 条件随机场

【Abstract】 For the problem of processing the named entity recognition in the deep learning method, traditional word embedding method map words or chars into a single vector, which can't represent the ambiguity of the word in the context. The ERNIE-BiGRU-CRF model is proposed. The model expresses the semantic perceptual representation of the enhanced words of the ERNIE pre-training model through Enhanced Representation from kNowledge IntEgration. The multivariate data knowledge is introduced to generate the semantic vector, the word embedding is input to the GRU layer to extract features, and the label sequence is obtained through the CRF layer. The experimental results show that the F1 value of the model in the People's Daily corpus reaches 94.46%.

【Key words】 Named Entity Recognition; Enhanced Representation from kNowledge IntEgration; Gated Recurrent Unit; Conditional Random Field

0 引 言

命名实体识别[1](Named Entity Recognition,NER)是自然语言处理[2](Natural Language Processing,NLP)中的一项基础性任务,目的是从非结构化数据文本中提取出人名、地名、组织机构名和数字表达等特定类型的实体。NER在问答系统[3]、句法分析[4]、机器翻译[5]等高级NLP任务中有广泛的应用价值。英文命名实体识别和中文命名实体识别相比,起步相对较早,且英文单词间有空格等明显的标识符,实体识别过程中不涉及分词等问题,只需要考虑词本身的特征,识别起来较中文来说难度相对较小。而中文实体结构复杂、形式多样、边界模糊,且中文字在不同的语境下还会存在一词多义、一字多性的情况。同时与分词等其它NLP任务相互影响。这些都增加了中文命名实体识别的难度,使得中文命名实体识别更具有研究和应用价值。

针对中文命名实体识别任务,本文在传统深度学习命名实体识别中引入了融合知识增强语义表示ERNIE预训练语言模型,提出了一种ERNIE-BiGRU-CRF神经网络模型。ERNIE 通过对训练数据中的词法结构、语法结构、语义信息进行统一建模,极大地增强了通用语义表示能力。实验结果表明,ERNIE-BiGRU-CRF模型在人民日报语料库上F1值达到了94.46%。与之前最好的Feng(2018)模型相比,人名实体、地名实体F1值分别提高了3.26个百分点和2.96个百分点。

1 相关工作

在命名实体识别中常用的机器学习算法有条件随机场(Conditional Random Fields,CRF)模型、支持向量机 (Support Vector Machine,SVM) 模型等。这类机器学习方法通常依赖复杂的特定人工特征,需要人工制作特征模板,导致识别方法泛化能力弱,识别方法不通用。

随着深度学习的兴起,端到端的神经网络模型占据了命名实体识别方法的主流。Hammerton[6]首先通过LSTM网络结构进行命名实体识别的研究。Huang等人[7]通過LSTM网络结构和CRF相结合,弥补了LSTM未能考虑样本输出之间关系的缺陷,该模型在NER等序列标记任务中取得了很好的效果。目前许多NER框架都是基于LSTM-CRF模型的。通过在LSTM-CRF模型上融入各种特征,可以进一步提升命名实体识别效果。Ma等人[8]采用了CNN提取字符级别的特征,通过字词结合的方式处理命名实体识别任务获得了不错的效果。李丽双等人[9]在生物领域内利用BiLSTM-CNN-CRF模型取得了当时最高的F1值。李明扬等人[10]通过使用Transformer结构中的多头注意力机制结合BiLSTM-CRF模型在微博文本领域的命名实体识别中取得了很好的效果。Strubell等人[11]通过利用空洞卷积网络进行命名实体识别,有效提取序列信息的同时缩短了训练的时间。

将深度学习算法引用到命名实体识别任务中的一个关键步骤是用词向量表达文本中词语[12]。其中,word2vec[13]的提出吸引了大量科研人员的关注,word2vec可以通过训练神经网络模型将词语表示为固定长度的低维向量,得到分布表示特征。训练好的向量中蕴涵着一些潜在的语义信息。将预训练词向量作为字词特征输入到神经网络模型中,提高了命名实体识别效果。Lample等人提出的BiLSTM-CRF模型,使用了大量无标记的语料在无监督学习中预训练生成word2vec词向量,模型中没有使用附加词典便取得了很好的效果。但word2vec无法表示字的多义性。例如在句子“他每天都重复地做着那些重活”中“重”字表达了不同的意思,类似于word2vec等工作聚焦于上下文无关的词向量建模,不能分别区分其含义,针对这个问题,科研人员提出了各种预训练语言模型来进行词表示,Peters等人[14]提出了一种基于BiLSTM网络结构的词向量表征模型,该模型通过上下文的语境变动而改变,动态地增强词的表示,表征词汇的语法语义层面特征;Devlin等人[15]提出的BERT模型,通过预测屏蔽的词,利用双向Transformer网络来获取预训练语言模型;2019年,Sun等人[16]针对BERT在处理中文时难以学习出更大语义单元的完整表示,提出了基于知识增强的ERNIE模型直接对先验语义知识单元进行建模,增强了模型语义表示能力。

鉴于ERNIE预训练语言模型的强大表义能力,针对中文命名实体识别任务,本文引入了ERNIE预训练语言模型,提出了一种融合知识增强语义表示的ERNIE-BiGRU-CRF深度神经网络模型。结合GRU网络对文本进行深层特征提取,结果表明,ERNIE-BiGRU-CRF模型在人民日报语料库上F1值达到了94.46%。

2 ERNIE-BiGRU-CRF模型

ERNIE-BiGRU-CRF模型的整体架构如图1所示。该模型首先通过知识增强语义表示的ERNIE预训练语言模型获得输入的语义表示,获取的字向量输入到双向GRU层提取句子级别特征,最后经过CRF层进行序列标注,获取全局最优的标签序列。

与之前的主流命名实体识别模型相比,ERNIE-BiGRU-CRF模型最主要的区别是加入了知识增强的语义表示ERNIE预训练语言模型,ERNIE模型通过对词、实体等语义单元的掩码学习得到完整概念的语义表示。表征了字的多义性,增强了模型语义表示能力。

2.1 ERNIE预训练语言模型

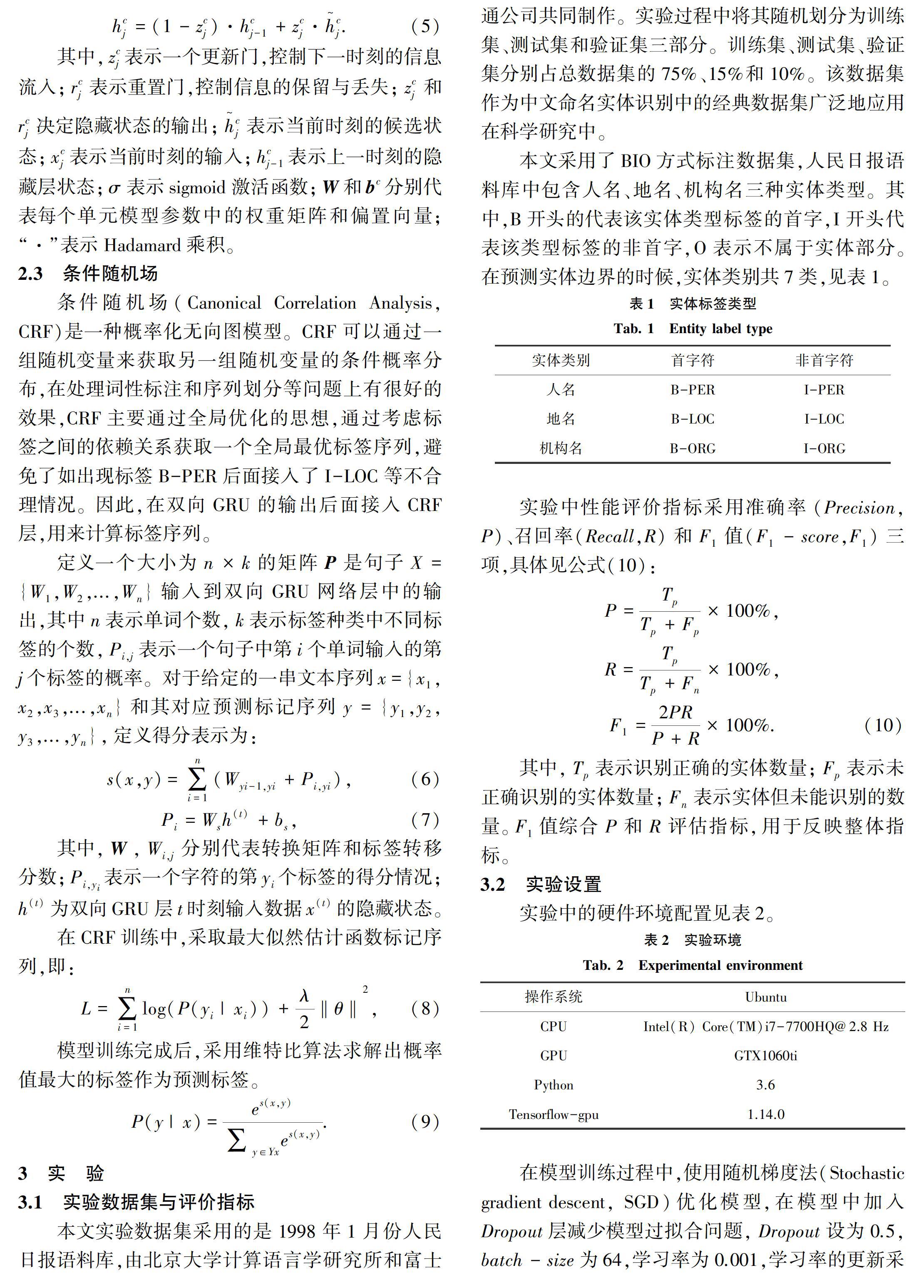

近年来,通过深度神经网络训练无监督文本的预训练语言模型有效地提高了命名实体识别、情感分析和问答系统等各类NLP任务。早期的工作集中于上下文无关词向量的建模,之后的Glove[17]、Elmo等模型构建了语句级的语义表示,2018年Google的Devlin等人[15]提出的BERT模型利用Transformer编码器的self-attention双向建模,取得了更好的性能。但以上的几种模型关注的焦点在于处理原始语言信号上,很少利用语义知识建模,导致模型难以获取更大语义单元的完整语义表示,在中文上表现更为突出。针对这个问题,Sun等人[16]提出了基于知识增强的ERNIE模型。ERNIE模型通过对大规模的语料中的词、实体及实体关系进行建模,学习真实世界的语义关系。

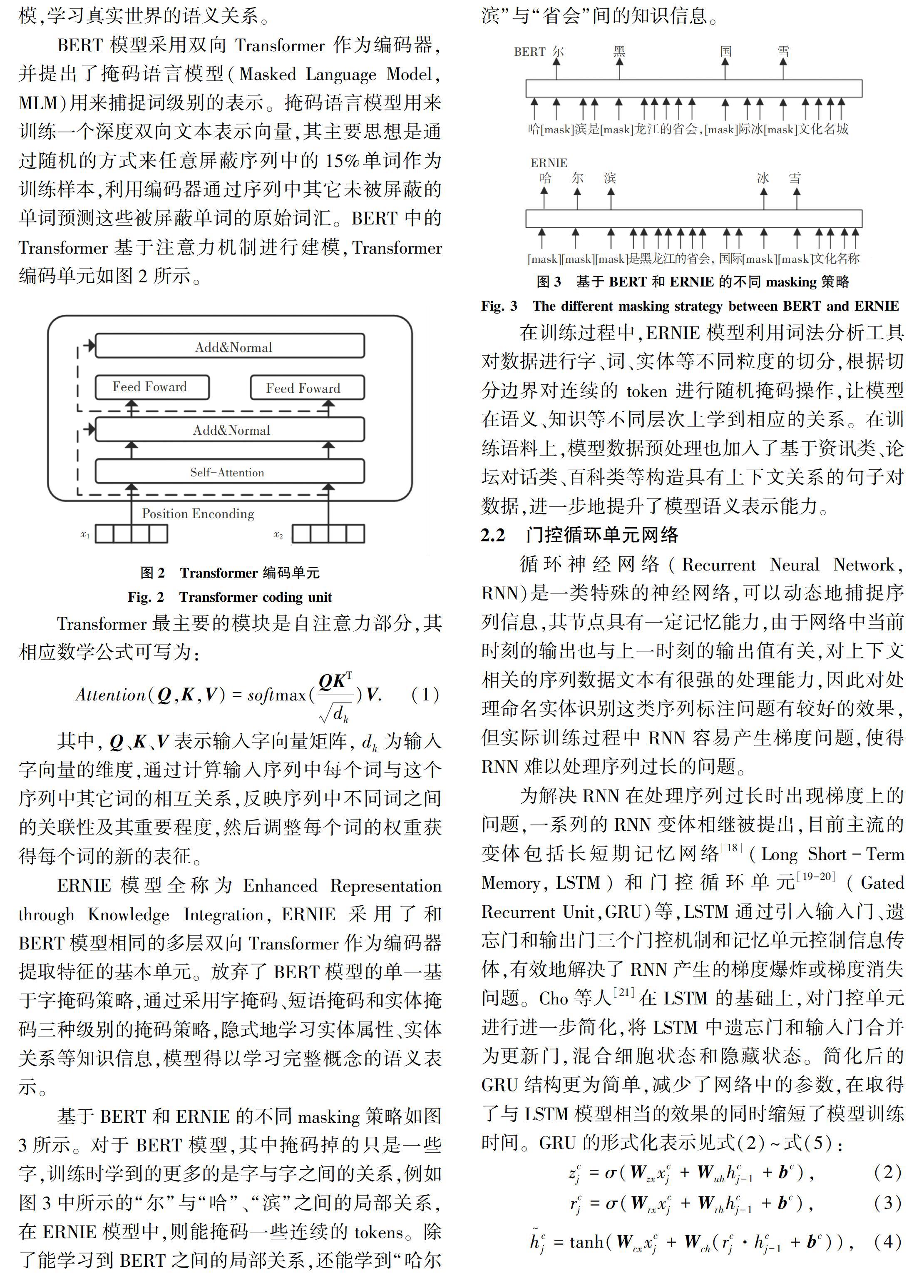

BERT 模型采用双向 Transformer 作为编码器,并提出了掩码语言模型(Masked Language Model,MLM)用来捕捉词级别的表示。掩码语言模型用来训练一个深度双向文本表示向量,其主要思想是通过随机的方式来任意屏蔽序列中的15%单词作为训练样本,利用编码器通过序列中其它未被屏蔽的单词预测这些被屏蔽单词的原始词汇。BERT中的Transformer基于注意力机制进行建模,Transformer编码单元如图2所示。

在模型训练过程中,使用随机梯度法(Stochastic gradient descent, SGD)优化模型,在模型中加入Dropout层减少模型过拟合问题,Dropout设为0.5,batch-size为64,学习率为0.001,学习率的更新采用step decay,衰减率为0.05,L2正则化参数为0.000 1。模型训练过程中利用GTX1060ti加速处理。

3.3 实验结果与分析

为了验证本文提出的基于ERNIE的命名实体识别方法的有效性和泛化性,对比了以下几种主流算法,评估模型的性能。对此可做解析分述如下。

(1)CRF。CRF是机器学习中处理命名实体识别任务效果最好且应用最为广泛的算法。

(2)BLSTM-CRF。该模型是序列标注任务中经典神经网络模型,采用预训练好word2vec向量作为BLSTM网络的输入进行特征提取,最后将其特征矩阵输入到CRF中完成序列标注。

(3)Feng(2018) [18]。该模型是Feng等人在2018年提出的一种命名实体识别模型,在BLSTM-CRF模型的基础上加入了词语的前后缀信息和领域词典,并将其转换为词的分布表示特征。

(4)ERNIE-BiGRU-CRF模型。本文提出的ERNIE-BiGRU-CRF模型,通过引入了ERNIE预训练语言模型,增强模型语义表示能力,通过学习到海量文本中的潜在知识,提高了命名实体识别效果。

在实验中,为验证ERNIE对实体识别效果的影响,对比了采用预训练好的词向量输入到BiGRU-CRF模型中进行训练的效果。

表3~表5中分別展示了地名、人名、组织名三种实体准确率、召回率、F1值的对比情况,与现有的方法相比,本文提出的ERNIE-BiGRU-CRF模型三种实体的F1值分别达到了93.73%、96.92%和91.56%,总体F1值达到了94.46%。其中,组织类实体识别的F1值相对于其它两种相对较低,分析是因为组织类实体容易出现地名嵌套、歧义实体等干扰信息,导致模型预测出现误差。而人名这类实体结构相对简单,一般由姓和名两部分组成,更易获取中文命名实体识别的特征,故F1值高于机构名和地名两类实体。

ERNIE-BiGRU-CRF模型在P、R、F1值三个方面均优于与CRF模型。原因是利用GRU网络在训练的过程中能够捕捉长距离信息,能够更加有效地提取特征信息。同时ERNIE-BiGRU-CRF模型避免了手动构造特征模板等不足,解决了传统识别方法过于依赖人工特征的问题,实现了端到端的命名实体识别。

与BiGRU-CRF模型、BLSTM-CRF模型相比,地名、人名、组织名三类实体的F1值均所提高,其中提高幅度最大的是人名类实体,分别提高了10.04%和9.15%。说明基于知识增强的ERNIE模型能够通过建模海量数据中的实体概念等先验知识,增强字的语义感知表示,更好地表示字的语义信息。例如在句子“罗阳汝信韦典徐达欧阳春汤洪高安启元”中,正确的实体划分应为“罗阳|汝信|韦典|徐达|欧阳春|汤洪高|安启元”,但是在BiGRU-CRF模型中,未能识别出安启元这个名字,研究分析是因为安字作为姓氏出现的场景较少,利用word2vec训练的词向量可能更会偏向于“平安”的意思。而在ERNIE-BiGRU-CRF模型中,由于采用了知识增强语义表示ERNIE预训练模型, ERNIE模型通过对词、实体等语义单元的掩码学习到完整概念的语义表示。表征了字的多义性,根据不同的语义生成不同的语义向量,正确识别出人名。

对比Feng等人(2018)的模型,ERNIE-BiGRU-CRF模型在地名实体、人名实体F1值均有所提高,说明ERNIE的特征抽取能力较强。与Feng(2018)模型相比,还少去了添加字典等构造外部特征的过程,从而使模型具有更好的鲁棒性与更强的泛化能力。

本文提出的ERNIE-BiGRU-CRF模型更具有競争力,明显优于本文对比的其它方法,在人民日报语料库实验对比中取得了最佳的结果。证明了该模型在中文命名实体识别中的有效性。

4 结束语

针对传统词向量不能表征字的多义性问题和模型难以获取更大语义单元的完整语义表示等问题,本文提出了ERNIE-BiGRU-CRF模型。ERNIE预训练模型采用了多层双向Transformer作为编码器提取特征的基本单元,通过采用字掩码、短语掩码和实体掩码三种级别的掩码策略动态生成字的上下文语义表示,比传统的词向量更能增强模型语义表示能力,最终提高了命名实体识别效果。

该模型存在的问题是在一些缺乏大规模标记数据的特定领域中,由于上下文信息不足,且存在缩写、歧义实体等现象时,会出现提取错误的情况,下一步的研究方向可以考虑深度学习结合迁移学习方法来解决。

参考文献

[1] MARRERO M, URBANO J, SNCHEZ-CUADRADO S, et al. Named entity recognition: Fallacies, challenges and opportunities[J]. Computer Standards & Interfaces, 2013, 35(5): 482.

[2]SEKINE S, NOBATA C. Definition, dictionaries and tagger for extended named entity hierarchy[C]//LREC. Lisbon:ELRA, 2004: 1977.

[3]于根,李晓戈,刘睿,等. 基于信息抽取技术的问答系统[J]. 计算机工程与设计,2017,38(4):1051.

[4]杨锦锋,于秋滨,关毅,等. 电子病历命名实体识别和实体关系抽取研究综述[J]. 自动化学报,2014,40(8):1537.

[5]张磊,杨雅婷,米成刚,等. 维吾尔语数词类命名实体的识别与翻译[J]. 计算机应用与软件,2015,32(8):64.

[6]HAMMERTON J. Named entity recognition with long short-term memory[C]//Proceedings of the Seventh Conference on Natural Language Learning at HLT-NAACL 2003. Stroudsburg, PA, USA:ACL , 2003,4: 1.

[7]HUANG Z, XU W L, YU K, et al. Bidirectional LSTM-CRF models for sequence tagging[J]. arXiv preprint arXiv: 1508.01991, 2015.

[8]MA Xuezhe, HOVY E. End-to-end sequence labeling via bi-directional LSTM-CNNs-CRF[J]. arXiv preprint arXiv:1603.01354, 2016.

[9]李丽双, 郭元凯. 基于 CNN-BLSTM-CRF 模型的生物医学命名实体识别[J]. 中文信息学报, 2018,32(1):116.

[10]李明扬, 孔芳. 融入自注意力机制的社交媒体命名实体识别[J]. 清华大学学报(自然科学版), 2019,59(6):461.

[11]STRUBELL E, VERGA P, BELANGER D, et al. Fast and accurate entity recognition with iterated dilated convolutions[J]. arXiv preprint arXiv:1702.02098, 2017.

[12]BENGIO Y,SCHWENK H,SENCCAL J S,et al. A neural probabilistic language model[J]. Journal of Machine Learning Research, 2003,3(6):1137.

[13]MIKOLOV T, CHEN K, CORRADO G S, et al. Efficient estimation of word representations in vector space[C]//Proceedings of International Conference on Learning Representations. Scottsdale, Arizona:ICLR, 2013:1.

[14]PETERS M E, NEUMANN M, IYYER M, et al. Deep contextualized word representations[C]//North American Chapter of the Association for Computational Linguistics. Louisiana, USA:dblp, 2018: 2227.

[15]DEVLIN J, CHANG M, LEE K, et al. BERT: Pre-training of deep bidirectional transformers for language understanding[C]// North American Chapter of the Association for Computational Linguistics. Minneapolis:dblp, 2019: 4171.

[16]SUN Y, WANG S, LI Y, et al. ERNIE: Enhanced representation through knowledge integration[J]. arXiv preprint arXiv:1904.09223, 2019.

[17]PENNINGTON J, SOCHER R,MANNING C D. Glove: Global vectors for word representation[C]//Proceedings of the 2014 Conference on Empirical Methods in Natural Language Processing (EMNLP). Doha, Qatar:ACL, 2014:1532.

[18]冯艳红,于红,孙庚,等. 基于BLSTM的命名实体识别方法[J]. 计算机科学, 2018, 45(2): 261.

[19]石春丹, 秦岭. 基于BGRU-CRF的中文命名实体识别方法[J]. 计算机科学, 2019, 46(9): 237.

[20]李佰蔚. 基于GRU-CRF的中文命名实体识别方法研究[D]. 哈尔滨:哈尔滨理工大学,2019.

[21]CHO K, Van MERRIENBOER B, GULCEHRE C, et al. Learning phrase representations using RNN encoder-decoder for statistical machine translation[C]// Proceedings of the 2014 Conference on Empirical Methods in Natural Language Processing. Doha, Qatar: Association for Computational Linguistics, 2014: 1724.