基于机器视觉的小贯小绿叶蝉智能识别的研究与应用

2022-06-21边磊何旭栋季慧华蔡晓明罗宗秀陈华才陈宗懋

边磊,何旭栋,季慧华,蔡晓明,罗宗秀,陈华才,陈宗懋*

基于机器视觉的小贯小绿叶蝉智能识别的研究与应用

边磊1,何旭栋2,3,季慧华2,蔡晓明1,罗宗秀1,陈华才3*,陈宗懋1*

1. 中国农业科学院茶叶研究所,浙江 杭州 310008;2. 杭州益昊农业科技有限公司,浙江 杭州 310018;3. 中国计量大学,浙江 杭州 310018

深度学习已经在农作物害虫实时监测的智能识别过程中广泛应用。以小贯小绿叶蝉()识别模型为基础,研究深度学习在诱虫板上叶蝉识别中的应用,旨在提高小贯小绿叶蝉田间种群调查的准确性。本研究设计了一种茶园小贯小绿叶蝉的识别、计数方法,首先采用黄色诱虫板诱集小贯小绿叶蝉,利用相机对诱虫板进行图像采集并上传至服务器,然后通过服务器部署的目标检测算法,对图像中叶蝉进行识别与计数。通过算法筛选,确定YOLOv3作为识别算法,用改进后的Soft-NMS代替原来的NMS,用K-means聚类方法计算新的先验框的尺寸,提升YOLOv3对目标识别的速度和准确率。通过田间试验对比诱虫板上叶蝉的真实数量,结果显示优化后识别算法的准确率可达到95.35%以上。本研究验证了诱虫板诱集、目标识别算法和物联网技术相结合,能够为小贯小绿叶蝉田间种群的实时监测提供技术支持,可为其他具有颜色偏爱性昆虫的实时监测和茶园害虫综合治理提供参考。

深度学习;目标检测;小贯小绿叶蝉;种群监测;YOLOv3

茶树是我国重要的经济作物,有害生物综合治理(IPM)是当下茶园害虫防治的要求,害虫种群的实时监测是IPM的基础,是各种防治技术精准施用的依据[1-2]。长期以来,许多茶树害虫的种群监测采用人工统计的方法[3],不仅消耗大量的时间和人力,而且统计结果会因调查人员的变动产生误差。因此,消除人工误差,降低劳力成本,实时高效地监测茶园害虫的种群动态,对于茶园害虫的精准防治至关重要。目前,人工智能相关的自动检测识别技术已在害虫的识别和监测中广泛应用,将深度学习的概念融入关联的设备中,实现在没有人为干预的情况下,高效准确统计稳定区域内目标昆虫的数量[4]。

小贯小绿叶蝉是中国茶园的重大害虫之一,对黄色具有偏爱性[5],所以统计黄色诱虫板上的叶蝉虫口是监测茶园叶蝉种群的一种常见的方法[6]。由于诱虫板上叶蝉的体表特征和其他具有黄色偏爱性的昆虫具有差异性,所以结合人工智能的视觉自动检测识别方法是可行的。计算机视觉是一种常见、有效、并且能快速鉴别昆虫种类的方法,将深度卷积神经网络(CNN)用于昆虫检测和识别的体系在植物害虫监测任务中具备良好的前景[7]。例如对稻田中杀虫灯内稻飞虱(包括白背飞虱和褐飞虱)[8]和蔬菜大棚中诱虫板上蓟马的自动识别和检测,已体现出智能识别技术在昆虫种群动态监测的优势[9]。

本研究采用图像深度学习筛选并优化小贯小绿叶蝉的识别技术,包括图像的预处理、目标检测算法的选择和优化,以及识别模型的田间评估,以期为小贯小绿叶蝉的远程实时监测提供技术支持。

1 材料与方法

1.1 图像采集

1.1.1 图像预处理

采用黄色诱虫板(25 cm×20 cm,杭州益昊农业科技有限公司)诱集茶园中的小贯小绿叶蝉。通过工业相机(1 200万像素,杭州海康威视数字技术股份有限公司,参数见表1)对茶园的诱虫板进行实时拍照,采集图像(图1),对其中成像存在问题的图片进行预处理。

表1 工业相机参数

对于在强光下图片存在过度曝光的问题(图1-c,图2-a),采用直方图变换的方法预处理[10]。先通过灰度值分布求出概率密度函数,再根据公式将原有图像的灰度值做映射处理,最后用新的灰度值代替原位置像素的灰度值,将灰度值范围进行拉伸,起到增强对比度的作用(图2-b)。

1.1.2 小目标检测

小目标检测在深度学习目标检测领域一直属于难题[11]。小贯小绿叶蝉检测属于小目标检测,其主要难点在于两点:(1)大多数的样本不包含小目标;(2)即使在包含小目标的样本中,小目标的出现次数也极其有限。在本研究所有图像中,小贯小绿叶蝉的大小在(20×20)~(70×70)范围内,整幅图像大小为4 000×3 000,所占的面积极少,同时每幅图的样本数量也不足,导致目标检测算法很难学习到小贯小绿叶蝉的相关特征。

注:a、b、c、d分别为采集自雨天、晴天、强光和弱光条件下的图片

注:(a)过度曝光原图,(b)直方图变化处理后

1.1.3 数据增强

鉴于采集图像的数量有限,需通过数据增强的方法来提升深度学习训练效果[12]。训练之前不仅对图像进行了常规的垂直水平翻转和任意角度的旋转,同时为了解决小目标样本不足的问题,采用特殊的Copy-Paste技术。对整张图片进行操作之后分别得到含目标的前景区域和不含目标的背景区域,然后把前景叠加在背景图上,将得到的新图加到训练集中进行训练。

图3 采用Copy-Paste技术进行图像数据增强

本研究为了得到Copy-Paste的最佳效果,尝试了多种不同的方法。第一种尝试是把不同小贯小绿叶蝉目标复制,并融合到一张图中;第二种方式是把同一小贯小绿叶蝉目标复制多次,融合到一张图中,效果如图3所示。结果表明,这两种方法使算法的性能得到了提升。试验中深度学习训练的图片数量为2 000张,其中1 800张用于模型学习,200张用于测试。

1.2 算法选择

1.2.1 Faster R-CNN

Faster R-CNN由Ross Girshick在2015年推出[13],为了提高检测速度与精度,Faster R-CNN将R-CNN和RPN(Region proposal network)进行了结合[14]。Faster R-CNN的核心是提出了RPN,代替了传统产生候选区域的方法,实现了端到端的训练。在结构上,Faster R-CNN已经将特征抽取(Feature extraction)、proposal提取、bounding box regression(Rect refine)、classification整合在了一个网络中,使得综合性能有较大提高,在检测速度方面尤为明显。采用ROI Pooling(Region of interest pooling)使用最大值池化将特征图上ROI(Region of interest pooling)固定为特定大小的特征图,采用NMS(Non-maximum suppression,非极大值抑制)技术,筛选候选框数量。

1.2.2 SSD

SSD(Single shot multibox detector)于2016年提出,是经典的one-stage目标检测模型之一[15]。SSD消除了边界框候选以及特征的上采样过程,精度上和Faster R-CNN目标检测方法相同,在速度上也能满足实时性的要求。SSD提取了不同尺度的特征图进行检测,大尺度特征图(较靠前的特征图)可以用来检测小物体,而小尺度特征图(较靠后的特征图)用来检测大物体;并且采用不同尺度和长宽比的先验框。SSD借鉴了Faster R-CNN中锚的理念,每个单元设置尺度或者长宽比不同的先验框,预测的边界框(Bounding boxes)以先验框为基准,减少了训练难度。但是SSD也存在一些不足,如小目标的检测效果不好,定位不准等。

1.2.3 YOLOv3

YOLOv3是YOLO(You only look once)系列目标检测算法中的第3版,由Redmon等[16]提出,是以Darknet53作为Backbone的一个全卷积神经网络。相比之前YOLO系列的算法,针对小目标的精度有显著提升[16]。主要体现在ResNet的应用和多尺度检测。

为了提高对小目标的检测能力,YOLOv3采用了类似FPN(Feature pyramid networks)的多尺度特征融合算法[16],具体如图4所示,卷积网络在经历几个卷积层之后在79层得到一种尺度的检测结果,相较于输入图像,这里的特征图进行了32倍的下采样。由于采用了较高的下采样倍数,特征图拥有较大的感受野,对尺寸较大的对象具有较好的检测效果。为了实现对小目标的检测,本研究将第79层特征图作上采样并与第61层特征图融合,进行一系列卷积操作得到第91层特征图,在提高网络泛化能力同时提高网络精度以及算法的速度。经过该次上采样,可以得到相对于原图像进行了16倍下采样的特征图,由于其具有中等尺寸的感受野,对中等尺寸目标的检测效果较优。然后进行相似操作,将第91层特征图进行第二次上采样,与第36层特征图融合,得到的特征图相对于输入图像进行了8倍下采样。最后的特征图具有最小的感受野,适合检测小目标对象。

1.3 YOLOv3算法优化

以YOLOv3作为识别算法并进行改进,主要体现在用改进后的Soft-NMS代替原来YOLOv3中的NMS和用K-means聚类方法重新计算先验框的尺寸两个方面。

1.3.1 NMS的改进

对于大多数目标检测算法,NMS是必要的后处理步骤,该处理方法容易造成目标漏检,一旦两个对象的重叠区域太大,则重叠的对象框可能会被过滤掉[17]。NMS根据检测框的概率进行降序排序之后,以概率最大的检测框作为基准,依次计算其他检测框与其IOU(Intersection-over-union,交并比),随后去除掉IOU值大于阈值的检测框,导致目标检测算法漏检。

图4 多尺度特征融合示意图

如图5所示,在YOLOv3检测小贯小绿叶蝉的实际应用中,红框和蓝框分别为不同的目标,但红框的得分低于蓝框,并且两框之间的IOU超过了设定的阈值,根据NMS的处理步骤,红框会被过滤掉,造成漏检。为了避免此类情况的发生,本研究使用改进的Soft-NMS进行目标框的去重处理。

图5 目标漏检

Soft-NMS算法由Bodla等[18]提出用来优化NMS算法,通常用于解决检测框之间IOU较高的问题。其优势是能够把现有的概率递归地进行修改,不会直接过滤掉IOU较高的检测框,在同一类目标之间IOU较高时可以避免对检测框实施误过滤操作。

Soft-NMS的工作原理是重叠度大于阈值的其他检测框不会直接去除,而是采用一个函数来衰减这些检测框的置信度。对于重叠度很高的检测框,置信度会衰减为一个很低的分数;相反,对于重叠度很低的验证框,保留原来的置信度。

Soft-NMS的抑制表达式的形式有两种,一种是线性加权:

一种是高斯加权:

在高斯衰减函数中,N是指IOU的阈值,在Soft-NMS高斯衰减求最优解的试验中,当=0.6时,效果最佳。试验过程中,发现当两个检测框的IOU值较大时,Soft-NMS算法仍然会使检验框的置信度得分低于更新后先前设置的阈值,从而导致漏检。基于Soft-NMS的最佳结果,提出了新的衰减公式来减小原始衰减幅度:

改进之后的Soft-NMS表达式为:

其中,是指可修改并用于控制衰减幅度的参数。在N取0.5,取0.6的Soft-NMS最优条件下,以作为自变量,研究与模型效果的关系,结果如图6所示。在本研究中,当达到0.05时效果最佳。

1.3.2 K-means聚类方法

目前的目标检测算法大多采用锚定机制,即先定义许多先验框作为初始值,再在此基础上进行优化得到最终结果。锚定机制将所有可能的实例框的连续空间离散化为一些预定义尺寸及宽高比的有限数量的框,缩小了网络的参数分布空间,提高了算法定位的准确性[19]。传统获取锚点的方法是基于最后一个特征图,例如,最后一层的特征图大小为13×13,相对尺寸在(0×0,13×13)范围内。经典算法是使用K-means聚类获得不同大小的锚点,这些锚点被分为多尺度特征图。在YOLOv3中,用于训练的数据集为COCO数据集,根据K-means聚类的方法为每种下采样尺度设定3种先验框,总共聚类出9种尺寸的先验框。在COCO数据集这9个先验框分别是(10×13)、(16×30)、(33×23)、(30×61)、(62×45)、(59×119)、(116×90)、(156×198)、(373×326)。在本试验中所使用的数据集与COCO数据集差异较大,使用原始锚设置不合适,需要重新计算小贯小绿叶蝉数据集的锚定尺寸,通过K-means均值聚类获得的结果如表2所示。同样,9个锚分为3个比例。

分配上,在最小的13×13特征图上有较大的感受野,应用较大的先验框(59×36)、(67×43)、(72×47)适合检测较大的对象。中等的26×26特征图上有中等的感受野,应用中等的先验框(44×25)、(49×27)、(51×31)适合检测中等大小的对象。较大的52×52特征图上有较小的感受野,应用较小的先验框(22×11)、(33×18)、(40×22)适合检测较小的对象。

表2 尺寸分类表

图6 Soft-NMS公式k值与模型效果关系图

如图7所示,利用原有的先验框进行目标检测,存在先验框尺寸过大和定位不准的问题(图7-a)。利用K-means均值聚类重新计算先验框尺寸后,先验框更加贴合目标,位置也更加准确(图7-b)。

1.4 模型效果评估

1.4.1 模型运行环境

计算机配置CPU型号为Intel(R)Core(TM)i7-7500HQ,CPU3.2 GHz,内存16 G,GPU型号为NVIDIA GTX 3060Ti,1 T固态硬盘。计算机操作系统为Window10 64位操作系统,配置python3.6,PyCharm2019.6,tensorflow-gpu-1.14.0+cudnn-7.6.4+cuda-10.0+Pytorch-2.2.4深度学习框架用于所有模型的训练和测试。参数设置:Batch size设置为16,img size为416,epochs为100,GPU num为1,learning rate为0.001,并在4 000和4 500迭代中除以10,optimizer为SGD。

1.4.2 田间测试

在模型深度学习的基础上,对其识别准确率开展田间测试评估,地点位于中国农业科学院茶叶研究所种质资源圃。分别于2020年6月和2021年6月,在测试地点架设叶蝉田间图像采集设备(图8),每天中午悬挂诱虫板,24 h后进行更换,图像采集时间为早晨7:00,每次采集1张诱虫板图像,连续采集15 d,以诱虫板上叶蝉的实际诱捕数量作为真实值,通过对比设备的识别数量来评估设备的精确性。目标检测常用的评价标准有查准率(Precision)、查全率(Recall)、平均准确率(Average precision),在本研究中用查准率作为评判不同算法识别准确率的标准。查准率的公式为:

图7 K-means均值聚类效果对比

图8 叶蝉田间图像采集设备及其系统结构示意图

=/(+)

式中,表示当目标被正确识别出来,即正样本被识别成正样本(真实值),表示非目标被识别成目标,即负样本被识别成正样本(错误识别)。

2 结果与分析

2.1 不同模型识别小贯小绿叶蝉的效果

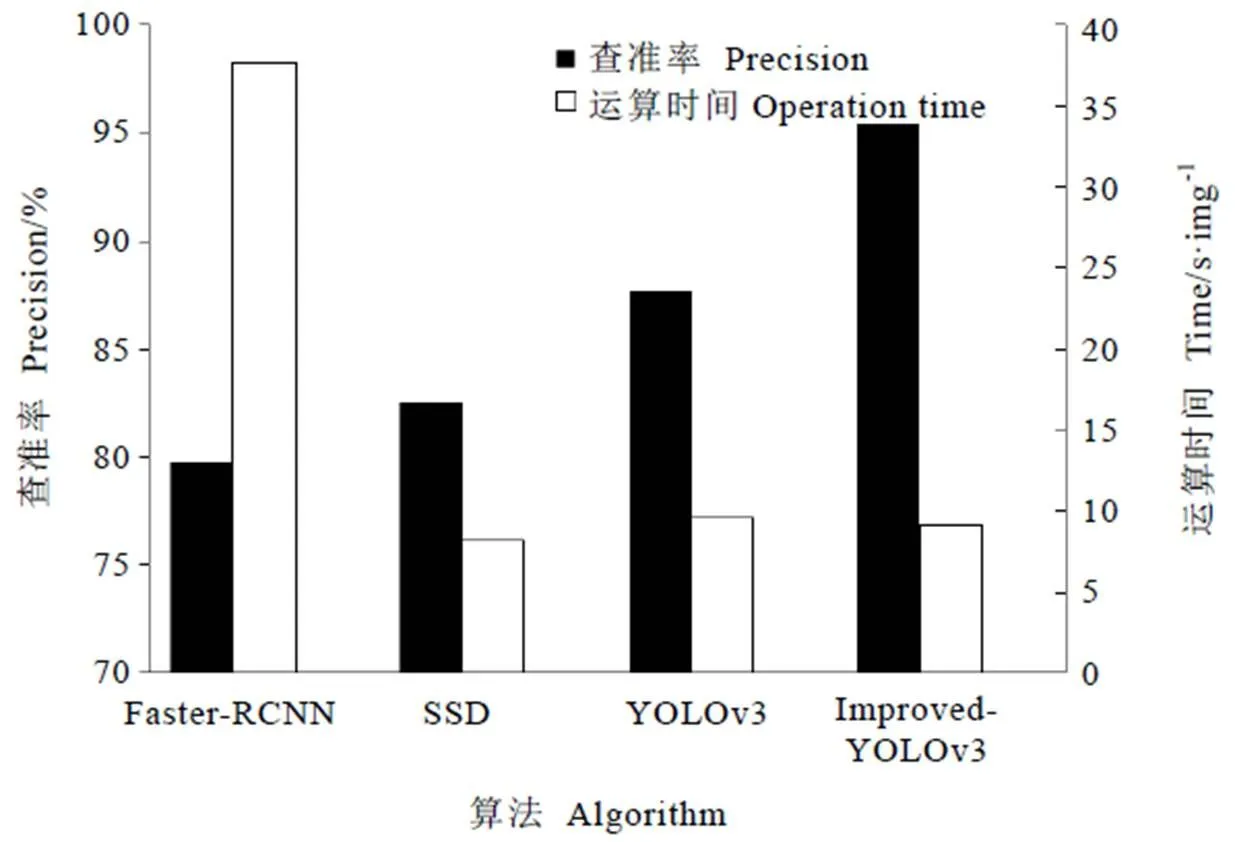

为了验证算法优化后的效果,对比SSD、Faster R-CNN、原始YOLOv3和优化后YOLOv3算法的值。小贯小绿叶蝉的数据被分别输入到4种算法中,以相同的设置进行训练和测试。结果如图9所示,对比SSD、Faster R-CNN和YOLOv3算法,Faster-RCNN算法在准确率值和运算速度方面都不是很理想,SSD算法的速度比YOLOv3算法快,但值较低。改进后的YOLOv3算法相较于改进前准确率提高了7.7%,达到95.3%,同时运算速度也有所提升(0.5%)。

2.2 基于改进YOLOv3的小贯小绿叶蝉识别

以基准线作为对照,对比了不同策略对算法的提升效果。结果显示,不同的策略对YOLOv3算法的值均有提升(图10)。其中采用Copy-Paste策略后,值比原始YOLOv3算法中的正常数据增加3.6%,主要是因为Copy-Paste策略在增加小目标样本数量尺寸的同时,增加了小目标样本数量,保证每个图像中同时有多个小目标。根据小贯小绿叶蝉数据的特征设计锚点,可以使网络更加准确地了解小贯小绿叶蝉的边缘信息,因此K-means聚类策略使值提升了1.8%的。在实际场景中,小贯小绿叶蝉的重叠非常普遍,由于原始NMS无法用于检测重叠的对象,会导致值下降,针对此问题Soft-NMS与改进后的Soft-NMS可以对算法值分别提升0.5%和1.6%。

2.3 模型田间测试

如表4所示,2020年田间测试试验中,15 d中有6次系统识别的叶蝉数量与实际数量一致,整个测试期内,小贯小绿叶蝉总体识别准确率为93.86%。2021年,在持续学习采集样本的基础上,15 d中有7次系统识别的叶蝉数量与实际数量一致,小贯小绿叶蝉总体识别准确率为95.35%。

图9 不同算法的查准率和速度比较

图10 不同的策略对YOLOv3算法平均准确率的影响

表4 模型对叶蝉的识别准确率

3 讨论

采用深度学习和神经网络的目标检测算法识别诱虫板上的小贯小绿叶蝉,在田间试验中结合物联网、图像采集系统初试的识别准确率可达到93.86%以上,说明依托机器视觉的叶蝉智能识别在茶园中用于叶蝉成虫的监测是可行的。本研究虽然在前期图像的采集过程中考虑到了数据的多样性,并且在算法迭代过程中加入了负样本的学习,但是在开放环境下目标害虫体征的实时变化,使得样本的多样性和复杂性远远超出预期。如环境中的光强度会直接影响诱虫板图像的亮度;湿度过高和雨天会造成诱虫板上凝聚水滴,导致系统误判;叶蝉和部分昆虫因诱虫板悬挂时间过长而导致褪色和堆叠等问题,尽管已经将这些情况作为负样本对算法进行优化,但是受限于样本采集的数量有限,在实际应用中仍会产生误判。

在研究中,通过调整图像采集时间、诱虫板悬挂时长可减少光照等环境因素对算法准确率的影响。诱虫板对小贯小绿叶蝉的诱集高峰是每天的清晨和傍晚[20],每天清晨采集诱虫板上叶蝉的诱集量,能避免强光对图像采集的影响,并反映出区域内叶蝉的相对虫口数量[21-23]。在田间试验中通过每天更换诱虫板缩短悬挂时长,可以避免叶蝉和部分昆虫因诱虫板悬挂时间过长而导致的褪色、白化和堆叠等问题,提升系统对叶蝉的识别率,但是该措施需要定期更换诱虫板,会增加叶蝉动态监测的工作量。受环境中湿度和气候的影响,诱虫板上的水滴问题不可避免,需通过采集大量的图像进行持续学习和算法优化来解决。

茶园中具有颜色偏爱性的害虫种类繁多,如蓟马、粉虱、叶甲、蜡蝉和网蝽等[24],结合诱虫板诱集和智能识别技术,可以实现对这些害虫种群的远程监测。植保装备的智能化是我国未来农业的发展方向,作物虫害的准确监测是指导精准用药的前提[25-26]。本监测系统在持续学习的基础上,结合规范的使用方法,可进一步提升对叶蝉的识别率,作为田间环境下叶蝉虫口远程监测的技术储备,能够为其他害虫的智能识别、监测技术研发提供指导。

[1] Kogan M. Integrated pest management: historical perspectives and contemporary developments [J]. Annual Review of Entomology, 1998, 43(1): 243-270.

[2] 吴孔明, 陆宴辉, 王振营. 我国农业害虫综合防治研究现状与展望[J]. 昆虫知识, 2009, 46(6): 831-836.

Wu K M, Lu Y H, Wang Z Y. Advance in integrated pest management of crops in China [J]. Chinese Bulletin of Entomology, 2009, 46(6): 831-836.

[3] 中国茶叶学会标准化工作委员会. 茶树主要害虫绿色防控技术规程: T/CTSS 37—2021 [S/OL]. [2021-12-20]. http://down.foodmate.net/standard/yulan.php?itemid=115353.

Standardization Committee of China Tea Science Society. Green controlling technical regulations for major pests of tea plant: T/CTSS 37—2021 [S/OL]. [2021-12-20]. http://down.foodmate.net/standard/yulan.php?itemid=115353.

[4] Khanna A, Kaur S. Evolution of internet of things (IoT) and its significant impact in the field of precision agriculture [J]. Computers and Electronics in Agriculture, 2019, 157: 218-231.

[5] Bian L, Sun X L, Luo Z X, et al. Design and selection of trap color for capture of the tea leafhopper,, by orthogonal optimization [J]. Entomologia Experimentalis et Applicata, 2014, 151(3): 247-258.

[6] Bian L, Cai X M, Luo Z X, et al. Design of an attractant for(Hemiptera: Cicadellidae) based on the volatile components of fresh tea leaves [J]. Journal of Economic Entomology, 2018, 111(2): 629-636.

[7] 封洪强, 姚青. 农业害虫自动识别与监测技术[J]. 植物保护, 2018, 44(5): 127-133.

Feng H Q, Yao Q. Automatic identification and monitoring technology of agricultural pests [J]. Plant Protection, 2018, 44(5): 127-133.

[8] 姚青, 吴叔珍, 蒯乃阳, 等. 基于改进CornerNet的水稻灯诱飞虱自动检测方法构建与验证[J]. 农业工程学报, 2021, 37(7): 183-189.

Yao Q, Wu S Z, Kuai N Y, et al. Automatic detection of rice planthoppers through light-trap insect images using improved Corner Net [J]. Transactions of the Chinese Society of Agricultural Engineering, 2021, 37(7): 183-189.

[9] 王茂林, 荣二花, 张利军, 等. 基于图像处理的蓟马计数方法研究[J]. 山西农业科学, 2020, 48(5): 812-816.

Wang M L, Rong E H, Zhang L J, et al, Study on countingbased on image processing [J]. Journal of Shanxi Agricultural Sciences, 2020, 48(5): 812-816.

[10] 李正飞. 基于小波变换的图像增强技术研究[J]. 机械工程与自动化, 2009(2): 15-17.

Li Z F. Image enhancement method based on wavelet transform [J]. Mechanical Engineering & Automation, 2009(2): 15-17.

[11] 张江勇. 基于深度学习的动车关键部位故障图像检测[D]. 成都: 电子科技大学, 2019.

Zhang J Y. Fault detection of emus based on deep learning [D]. Chengdu: University of Electronic Science and Technology of China, 2019.

[12] 彭宜. 基于残差网络和随机森林的音频识别方法研究[D]. 武汉: 武汉科技大学, 2019.

Peng Y. Research on audio recognition method based on residual network and random forest [D]. Wuhan: Wuhan University of Science and Technology, 2019.

[13] Girshick R. Fast R-CNN [C]//IEEE. 2015 IEEE International Conference on Computer Vision (ICCV). Santiago: 2015.

[14] Ren S Q, He K M, Girshick R, et al. Faster R-CNN: towards real-time object detection with region proposal networks [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149.

[15] Liu W, Anguelov D, Erhan D, et al. SSD: single shot multibox detector [M]//Leibe B, Matas J, Sebe N, et al. Lecture notes in computer science. Cham: Springer, 2016: 21-37.

[16] Redmon J, Farhadi A. YOLOv3: an incremental improvement [J]. Eprint ArXiv, 2018: 1804.02767. doi: 10.48550/arXiv.1804.02767.

[17] Huang J, Zhang H, Wang L, et al. Improved YOLOv3 Model for miniature camera detection [J]. Optics and Laser Technology, 2021, 142. doi: 10.1016/j.optlastec.2021.107133.

[18] Bodla N, Singh B, Chellappa R, et al. Soft-NMS-improving object detection with one line of code [J]. Eprint ArXiv, 2017: 1704.04503. doi: 10.48550/arXiv.1704.04503.

[19] Redmon J, Farhadi A. YOLO9000: better, faster, stronger [C]//IEEE. 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu: 2017.

[20] 边磊, 孙晓玲, 陈宗懋. 假眼小绿叶蝉的日飞行活动性及成虫飞行能力的研究[J]. 茶叶科学, 2014, 34(3): 248-252.

Bian L, Sun X L, Chen Z M. Studies on daily flight activity and adult flight capacity ofGöthe [J]. Journal of Tea Science, 2014, 34(3): 248-252.

[21] Kim K N, Huang Q Y, Lei C L. Advances in insect phototaxis and application to pest management: a review [J]. Pest Management Science, 2019, 75(12): 3135-3143.

[22] Shimoda M, Honda K. Insect reactions to light and its applications to pest management [J]. Applied Entomology and Zoology, 2013, 48(4): 413-421.

[23] Rodriguez-Saona C R, Byers J A, Schiffhauer D. Effect of trap color and height on captures of blunt-nosed and sharp-nosed leafhoppers (Hemiptera: Cicadellidae) and non-target arthropods in cranberry bogs [J]. Crop Protection, 2012, 40: 132-144.

[24] 杨智辉. 黄色诱虫板对茶果园主要害益虫的诱杀作用调查[J]. 现代农业科技, 2017(15): 91-93.

Yang Z H. Investigation on the trapping and killing effect of yellow insect traps on the main harmful and beneficial insects in tea orchards [J]. Modern Agricultural Science and Technology, 2017(15): 91-93.

[25] 吴孔明. 中国农作物病虫害防控科技的发展方向[J]. 农学学报, 2018, 8(1): 35-38.

Wu K M. Development direction of crop pest control science and technology in China [J]. Journal of Agriculture, 2018, 8(1): 35-38.

[26] 陈宗懋, 蔡晓明, 周利, 等. 中国茶园有害生物防控40年[J]. 中国茶叶, 2020, 42(1): 1-8.

Chen Z M, Cai X M, Zhou L, et al. Developments on tea plant pest control in past 40 years in China [J]. China Tea, 2020, 42(1): 1-8.

Research and Application of Intelligent Identification ofBased on Machine Vision

BIAN Lei1, HE Xudong2,3, JI Huihua2, CAI Xiaoming1, LUO Zongxiu1, CHEN Huacai3*, CHEN Zongmao1*

1. Tea Research Institute, Chinese Academy of Agricultural Sciences, Hangzhou 310008, China;2. Hangzhou Yihao Agricultural Technology Co., Ltd., Hangzhou 310018, China; 3. China Jiliang University, Hangzhou 310018, China

Deep learning has been widely used in intelligent identification in the progress of real-time monitoring of crop pests. Based on the identification model of tea leafhopper,, the application of deep learning in field leafhopper recognition was introduced to improve the precision of field population investigation ofIn this paper, a method of identification and count ofin tea garden was designed. Firstly, yellow sticky card was used to attract tea leafhoppers, and images of cards were collected by camera and uploaded to the web server. Then, target detection algorithm deployed by the server was used to identify and count the leafhoppers in the images. Through algorithm screening, YOLOv3 was determined as the recognition algorithm, and the improved soft-NMS was used to replace the original NMS. K-means clustering method was used to calculate the size of the new prior frame, so as to improve the speed and precision of YOLOv3. The results show that the average precision of the optimized algorithm could reach more than 95.35% comparing with the real number of leafhoppers on the sticky card. Therefore, the combination of the sticky card trapping, target recognition algorithm and internet of things technology could realize the real-time monitoring of population for, which could provide a reference for other insects with color preference and integrated pest management in tea gardens.

deep learning, target detection,, population monitoring, YOLOv3

S435.711;Q126

A

1000-369X(2022)03-376-11

2021-10-09

2021-12-01

浙江重点研发计划(2019C02033)、财政部和农业农村部:国家现代农业产业技术体系(CARS-19)、中国农业科学院创新工程

边磊,男,副研究员,主要从事茶树害虫物理防治技术研究。*通信作者:huacaichen@cjlu.edu.cn;zmchen2006@163.com

(责任编辑:黄晨)