基于深度学习的目标跟踪算法研究现状及发展趋势

2021-11-03张莹杰

DOI:10.19850/j.cnki.2096-4706.2021.08.024

摘 要:近十年来,深度学习由于其优越的性能,已经逐渐应用于各个领域。在目标跟踪领域,基于深度学习的方法也取得了巨大的成功。文章主要介绍基于深度学习的目标跟踪算法研究现状及发展趋势。首先,介绍了视觉目标跟踪传统算法。然后,对基于深度学习的目标跟踪算法进行分类,并进行问题分析。最后,对基于深度学习的目标跟踪算法的发展趋势进行预测。

关键词:目标跟踪;深度学习;孪生网络;相关滤波

中图分类号:TP391.41 文献标识码:A 文章编号:2096-4706(2021)08-0082-04

Research Status and Development Trend of Target Tracking Algorithm Based on Deep Learning

ZHANG Yingjie

(Zhanjiang University of Science and Technology,Zhanjiang 524094,China)

Abstract:In recent ten years,deep learning has been gradually applied in various fields because of its superior performance. In the field of target tracking,the method based on deep learning has also achieved great success. This paper mainly introduces the research status and development trend of target tracking algorithm based on deep learning. Firstly,the traditional algorithms for visual target tracking are introduced. Then,the target tracking algorithms based on deep learning are classified and the problems are analyzed. Finally,the development trend of target tracking algorithm based on deep learning is predicted.

Keywords:target tracking;deep learning;siamese network;correlation filtering

0 引 言

視觉目标跟踪在目标检测算法检测到目标以后,对目标进行持续跟踪。视觉目标跟踪在现实世界中有诸多应用,涉及智能交通系统[1],先进辅助驾驶[2],导弹制导[3],医疗诊断[4],视频监控[5]等领域。

主流的目标跟踪系统结构如图1所示,从整体上分为特征提取、外观模型、目标搜索、模型更新4个部分。特征提取主要利用图像处理技术提取图像的一些特征信息。目标搜索主要根据目标的信息,提供一系列候选目标。外观模型根据特征提取和目标搜索提供的候选来预测目标的状态。模型更新可以让外观模型适应目标和背景变化。

自上世纪开始,很多经典的视觉目标跟踪算法被提出。这些算法大多采用一些人工设计的特征,比如光流法[6]、粒子滤波法[7]、均值漂移滤波方法[8,9]等。如光流法是一种比较经典的目标跟踪算法,它利用两帧之间的差别来对目标进行跟踪,能够很好地利用时间序列的信息,现在很多优秀的目标跟踪算法,都是借鉴光流法的思想。粒子滤波法通过在上一帧预测目标位置周围撒粒子,并计算每个粒子对目标的重要性,综合判断真实目标所在的位置。然而,传统的目标跟踪算法基本上需要专业人员手工去设置特征,这不仅需要专业知识,也限制了算法的适用性。另外,由于目标经常受到光照变化、尺度变化、严重变形、背景杂波和严重遮挡等因素的影响,视觉目标跟踪仍然是一项具有挑战性的任务。

近年来,深度学习由于其优越的性能,已经逐渐应用于各个领域[10,11]。一些研究人员将深度学习引入目标跟踪[12,13]。本文主要介绍基于深度学习的目标跟踪算法研究现状及发展趋势。首先,我们介绍了视觉目标跟踪传统算法。然后,对基于深度学习的目标跟踪算法进行分类,并进行问题分析。最后,我们对基于深度学习的目标跟踪算法未来的发展趋势进行预测。

1 基于深度学习的目标跟踪算法分类

基于深度学习的目标跟踪算法大致可以分为两类。第一类的主要思想是将深度学习作为特征提取器,与传统目标跟踪算法相结合[11-13]。该方法可以大大提高跟踪精度,但实时性较差。第二类是直接构建一个用于目标跟踪的深度学习框架[14,15]。

1.1 深度学习与传统目标跟踪算法结合框架

基于相关滤波器的目标跟踪方法在跟踪精度和时间效率方面表现良好。Bolme等人第一次提出用相关的思想解决目标跟踪的问题[16],利用人工设置的特征对目标进行描述,并在搜索区域上寻找与目标特征最相似目标,以最大响应值作为最终的预测目标位置。并且,在进行相关计算时,利用快速傅里叶变换,解决了相关计算比较慢的问题,具有很强的实际应用价值。Henriques等人引入了循环矩阵来增加正样本的数量[17]。Danelljan等人在CSK的基础上添加颜色信息进行训练[18]。Danelljan等人(DSST)将尺度自适应引入到相关滤波目标跟踪中[19]。Henriques等人中,将单通道特征扩展为多通道方向梯度直方图特征,并利用图像的梯度信息来提高算法的跟踪性能[20]。Zhu等人引入了一种新的特征MC-HOG,并结合相关滤波框架,在一定程度上提高了跟踪器的性能[21]。

Ma等人将深度特征与相关滤波结合,在KCF的基础上,用深度特征替代HOG特征,使用预训练VGG-19网络的conv3-4、conv4-4、conv5-4,分别得到3张响应图,融合响应图得到最后的预测目标位置,这种融合方法不仅能够提高跟踪精度,并且能更好地适应不同的目标大小[11]。Danelljan等人利用深度神经网络的各层特征联合来表示所要跟踪的目标,并在各个层次自适应学习相关滤波,取得了良好的性能[12]。Danelljan等人提出一种新的融合方法,它能够很好地融合不同分辨率的特征图像[13]。

1.2 基于深度学习的目标跟踪框架

目前,基于深度学习的目标跟踪算法基本上是基于孪生网络框架的。基于孪生网络的目标跟踪算法能够在精度和速度之间达到极好的平衡[14,15]。Bertinetto等人首次将孪生网络应用于目标跟踪领域,首先,分别提取模板和搜索区域的特征,然后,将模板和搜索区域在特征空间进行卷积操作,选择最大响应的位置作为预测的目标位置[14]。在Bertinetto等人工作的基础上,研究学者提出了许多改进的跟踪方法。Guo等人提出了动态孪生网络,通过一个快速的变换学习模型,可以有效地在线学习目标外观变化和背景抑制[22]。He等人将语义特征引入到SiamFC框架中,互补的语义特征和外观特征提高了目标跟踪的准确性[23]。

为了提高跟踪精度,受目标检测候选区域生成思想的影响,SiamRPN算法被提出[24],通过对候选区域进行细化,可以得到更精确的边界框。然而,SiamRPN将语义背景视为干扰源,当有语义的物体是背景时,其性能无法得到保证。DaSiamRPN在训练阶段加入困难负样本,提高了跟踪器的分辨力,得到了更为稳健的跟踪结果[25]。SiamRPN++将ResNet网络引入基于孪生网络的视觉跟踪器,取得了更好的性能[26]。

2 基于深度学习的目标跟踪算法所存在的问题

目前,虽然基于深度学习的目标跟踪算法具有良好的跟踪性能。然而,由于深度学习技术特性及目标跟踪的实际应用特点,基于深度学习的目标跟踪算法还存在以下这些问题。

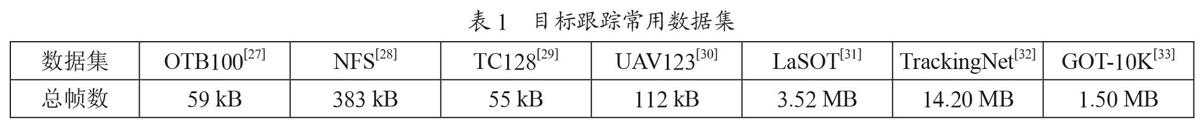

数据标注。当前基于深度学习的目标跟踪算法基本上都是监督式学习,需要大量的已标注数据,这需要花费大量的人力去标注数据,随着数据量的增加,完全标注数据的获取变得越来越困难。常用的目标跟踪数据集如表1所示,这些数据集总帧数最少的有5万多张图片,最多的有1 000多万张图片,这些都需要耗费大量的人力去标注。

目标模型在线更新。在目标跟踪过程中,被跟踪目标将不可避免的发生形状变化、光照条件变化、尺度变化等情况。如果目标模型不在线更新,将很难适应跟踪目标的这些变化,从而导致跟踪失败,如基于孪生网络的目标跟踪算法,由于缺乏模型更新,容易向与目标相似区域漂移,并且当目标外观发生较大变化时,会造成目标候选框和目标模型间出现较大差异,从而导致跟踪失败。因此,如果目标跟踪算法的模型不在线更新,很难适应复杂的场景。而而如果目标模型在线更新,由于观测的不确定性,可能导致模型被污染。如基于相关滤波的目标跟踪算法,这类直接在线更新目标模型的目标跟踪算法,在目标跟踪中是非常冒险的,尤其是对于长时目标跟踪。表2为主流目标跟踪算法在目标跟踪数据集UAV123的跟踪结果。其中,PrDiMP50[34]、DiMP50[35]、ATOM[36]均在线更新目标模型,SiamRPN++[26]、SiamRPN[24]、SiamBAN[37]、SiamCAR[38]均不在线更新目标模型,从表2可以看出,在线更新目标模型算法的AUC远高于不在线更新目标模型算法。

目标丢失判别。基于深度学习的目标跟踪方法通常是利用跟踪器的输出来进行自我判别。如置信度分数、峰值旁瓣比、最大响应值、异常跟踪状态与目标相关性检验等。然而,由于目标跟踪的复杂性,输出并不总是能可靠地反映目标跟踪状态,尤其是当跟踪器经历了长时的不确定和噪声观测时。因此,这些方法都不能严格判断目标是否丢失,同时容易导致较高的误检率。

受限的搜索窗口。当前,主流的目标跟踪算法都是在上一帧的预测位置上,截取图像的部分区域作为搜索区域,并在此搜索区域内寻找目标。当相似目标干扰、严重遮挡等因素导致目标跟踪暂时失败时,受限的搜索窗口很难再次找回目标,从而导致无法恢复的跟踪失败。图2为SiamBAN算法在OTB100數据集Human3上的跟踪结果,从结果可以看到,在第10帧时,算法能够很好地跟踪目标;在第50帧,出现相似目标干扰时,算法漂移到相似目标上,目标跟踪暂时失败;在第80帧,相似目标消失,但是,真正的目标已经不在搜索区域内,因此,导致无法恢复的跟踪失败。

3 结 论

基于深度学习的目标跟踪算法近年来表现出良好的性能,但是由于深度学习需要大量的已标注数据,这大大限制了深度学习在目标跟踪领域的实际应用。另外,基于深度学习的目标跟踪算法并没有完全解决目标跟踪领域存在的一些问题,如严重遮挡和相似目标干扰等问题。随着深度学习和目标跟踪技术的进一步发展,基于深度学习的目标跟踪算法的性能将进一步提升。本文对基于深度学习的目标跟踪算法的未来发展方向及展望,总结为:

(1)无监督或者弱监督深度学习。当前基于深度学习的目标跟踪算法基本上都是监督式学习,需要大量的已标注数据,这需要花费大量的人力去标注数据,随着数据量的增加,完全标注数据的获取变得越来越困难。这就需要将无监督或者弱监督深度学习技术应用于目标跟踪领域,以解决数据标注这一问题。

(2)模型在線更新。当前,基于孪生网络的目标跟踪算法由于缺乏模型更新,容易向与目标相似区域漂移,并且当目标外观发生较大变化时,会造成目标候选框和目标模板间出现较大差异,从而导致跟踪失败。而目标跟踪的场景复杂、且目标发生较大外观变化可能性较大,基于孪生网络的目标跟踪算法很难适应复杂场景。而基于深度特征的相关滤波跟踪算法在每一帧都进行更新,在相似目标干扰、完全遮挡等场景导致目标跟踪暂时失败时,模型可能被污染,从而导致无法恢复的跟踪失败。因此,模型在线更新会变得越来越重要。

(3)目标丢失判断。目标跟踪场景复杂,在目标跟踪过程中,不可避免地会发生目标丢失的情况。这就需要对目标丢失进行判断,以调用重检测器重新找回目标。不准确的目标丢失判断可能导致重检测器错误被启动,因此,准确判断目标丢失就变得非常关键。

(4)搜索窗口。当前,主流的目标跟踪算法都是在上一帧的预测位置上,截取图像的部分区域作为搜索区域,并在此搜索区域内寻找目标。当相似目标干扰、严重遮挡等因素导致目标跟踪暂时失败时,受限的搜索窗口很难再次找回目标,从而导致无法恢复的跟踪失败。因此,如何选择搜索窗口是目标跟踪领域一个重要问题。

参考文献:

[1] 吴大伟.智慧交通中形变自适应的目标跟踪算法研究 [J].山西建筑,2020,46(6):196-198.

[2] 周俊静,段建民,杨光祖.基于改进的确定性目标关联的车辆跟踪方法 [J].模式识别与人工智能,2014,27(1):89-95.

[3] 吕梅柏,赵小锋,刘广哲.空中大机动目标跟踪算法研究 [J].现代防御技术,2018,46(2):45-50+172.

[4] 吕福友.家用智能视频中运动目标的检测与跟踪 [J].通讯世界,2019,26(1):180-181.

[5] 陈汐,韩译锋,闫云凤,等.目标物智能跟踪与分割融合算法及其在变电站视频监控中的应用 [J].中国电机工程学报,2020,40(23):7578-7587.

[6] SUN D Q,ROTH S,BLACK M J. Secrets of optical flow estimation and their principles [C]//2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition.San Francisco:IEEE,2010:2432-2439.

[7] NUMMIARO K,KOLLER-MEIER E,GOOL L V. An adaptive color-based particle filter [J].Image and Vision Computing,2003,21(1):99-110.

[8] COMANICIU D,MEER P. Mean shift:A robust approach toward feature space analysis [J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2002,24(5):603-619.

[9] MA C,HUANG J B,YANG X K,et al. Hierarchical convolutional features for visual tracking [C]//2015 IEEE International Conference on Computer Vision(ICCV).Santiago:IEEE,2015:3074-3082.

[10] HE R,WU X,SUN Z N,et al. Wasserstein CNN:Learning Invariant Features for NIR-VIS Face Recognition [J].IEEE transactions on pattern analysis and machine intelligence,2019,41(7):1761-1773.

[11] FU K,ZHAO Q J,GU I Y H. Refinet:A deep segmentation assisted refinement network for salient object detection [J].IEEE Transactions on Multimedia,2019,21(2):457-469.

[12] DANELLJAN M,H?GER G,KHAN F S,et al. Convolutional features for correlation filter based visual tracking [C]//2015 IEEE International Conference on Computer Vision Workshop(ICCVW).Santiago:IEEE,2015:621-629.

[13] DANELLJAN M,ROBINSON A,KHAN F S,et al. Beyond correlation filters:Learning continuous convolution operators for visual tracking [C]//European Conference on Computer Vision(ECCV).Amsterdam:Springer,2016:472-488.

[14] BERTINETTO L,VALMADRE J,HENRIQUES J F,et al. Fully-Convolutional Siamese networks for object tracking [C]//European Conference on Computer Vision.Amsterdam:Springer,2016:850-865.

[15] TAO R,GAVVES E,SMEULDERS,A W M. Siamese instance search for tracking [C]//2016 IEEE Conference on Computer Vision and Pattern Recognition(CVPR).Las Vegas:IEEE,2016:1420-1429.

[16] BOLME D S,BEVERIDGE J R,DRAPER B A,et al. Visual object tracking using adaptive correlation filters [C]//2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition.San Francisco:IEEE,2010:2544-2550.

[17] HENRIQUES J F,CASEIRO R,MARTINS P,et al. Exploiting the circulant structure of tracking-by-detection with kernels [C]//European Conference on Computer Vision.Florence:Springer,2012:702-715.

[18] DANELLJAN M,KHAN F S,FELSBERG M,et al. Adaptive color attributes for real-time visual tracking [C]//2014 IEEE Conference on Computer Vision and Pattern Recognition.Columbus:IEEE,2014:1090-1097.

[19] DANELLJAN M,H?GER G,KHAN F S,et al. Accurate scale estimation for robust visual tracking [C]//British Machine Vision Conference 2014.Nottingham:BMVA Press,2014:1-11.

[20] HENRIQUES J F,CASEIROR,MARTINS P,et al. High-speed tracking with kernelized correlation filters [J].IEEE transactions on pattern analysis and machine intelligence,2015,37(3):583-596.

[21] ZHU G B,WANG J Q,WU Y,et al. MC HOG correlation tracking with saliency proposal [C]//Thirtieth AAAI Conference on Artificial Intelligence.Phoenix:AAAI Press,2016:3690–3696.

[22] GUO Q,FENG W,ZHOU C,et al. Learning dynamic Siamese network for visual object tracking [C]//2017 IEEE International Conference on Computer Vision(ICCV).Venice:IEEE,2017:1781-1789.

[23] HE A F,LUO C,TIAN X M,et al. A twofold Siamese network for real-time object tracking [C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Salt Lake City:IEEE,2018:4834-4843.

[24] LI B,YAN J J,WU W,et al. High performance visual tracking with Siamese region proposal network [C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Salt Lake City:IEEE,2018:8971-8980.

[25] ZHU Z,WANG Q,LI B,et al. Distractor-aware Siamese networks for visual object tracking [C]//European Conference on Computer Vision.Munich:Springer,2018:103-119.

[26] LI B,WU W,WANG Q,et al. SiamRPN plus plus:Evolution of Siamese visual tracking with very deep networks [C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR).Long Beach:IEEE,2019:4277-4286.

[27] WU Y,LIM J,YANG M H. Object tracking benchmark [J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2015,37(9):1834-1848.

[28] GALOOGAHI H K,FAGG A,HUANG C,et al. Need for speed:A benchmark for higherframe rate object tracking [C]//2017 IEEE International Conference on Computer Vision(ICCV).Venice:IEEE,2017:1134-1143.

[29] LIANG P P,BLASCH E,LING H B. Encoding color information for visual tracking:Algorithms and benchmark [J].IEEE Transactions on Image Processing,2015,24(12):5630-5644.

[30] MUELLER M,SMITH N,GHANEM B. A benchmark and simulator for UAV Tracking [C]//European Conference on Computer Vision.Amsterdam:Springer,2016:445-461.

[31] FAN H,LIN L T,YANG F,et al. LaSOT:A high-quality benchmark for large-scale single object tracking[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR).Long Beach:IEEE,2019:5369-5378.

[32] M?ELLER M,BIBI A,GIANCOLA S,et al. TrackingNet:A large-scale dataset and benchmark for object tracking in the wild [C]//European Conference on Computer Vision.Munich:Springer,2018:310-327.

[33] HUANG L H,ZHAO X,HUANG K Q. GOT-10k:A large high-diversity benchmark for generic object tracking in the wild [J/OL].arXiv:1810.11981 [cs.CV].(2018-10-29).https://arxiv.org/abs/1810.11981v3.

[34] DANELLJAN M,GOOL L V,TIMOFTE R. Probabilistic regression for visual tracking [C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR).Seattle:IEEE,2020:7181-7190.

[35] BHAT G,DANELLJAN M,GOOL L V,et al. Learning discriminative model prediction for tracking [C]//2019 IEEE/CVF International Conference on Computer Vision(ICCV).Seoul:IEEE,2019:6181-6190.

[36] DANELLJAN M,BHAT G,KHAN F S,et al. ATOM:Accurate tracking by overlap maximization [C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR).Long Beach:IEEE,2019:4655-4664.

[37] CHEN Z D,ZHONG B N,LI G R,et al. Siamese box adaptive network for visual tracking [C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR).Seattle:IEEE,2020:6667-6676.

[38] GUO D Y,WANG J,CUI Y,et al. SiamCAR:Siamese fully convolutional classification and regression for visual tracking [C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR).Seattle:IEEE,2020:6268-6276.

作者簡介:张莹杰(1992—),女,汉族,河南商丘人,助教,硕士研究生,研究方向:智能算法。

收稿日期:2021-03-14