深度学习在医学图像分析中的应用

2020-01-08乔琛吴娇陈坚

乔琛 吴娇 陈坚

摘 要 随着深度学习在计算机视觉任务中取得巨大成功,此技术也被应用到医学图像分析领域。本文总结与医学图像分析相关的深度学习模型,并概述了这些模型在医学图像分类、检测、分割和配准方面的应用成果,具体涉及到神经、视网膜、肺、数字病理学、乳腺、肌骨骼等方面的图像分析任务。本文最后还总结了目前与医学图像分析相关的深度学习研究现状,并对未来研究面临的挑战和应努力的方向进行了讨论。

关键词 医学图像 深度学习 临床应用

中图分类号:TP391.5; R445 文献标志码:A 文章编号:1006-1533(2020)23-0014-06

Application of deep learning in medical image analysis*

QIAO Chen1, WU Jiao1, CHEN Jian2**(1. School of Mathematics & Statistics, Xian Jiaotong University, Xian 710049, China; 2. Department of Gastroenterology, Huashan Hospital, Fudan University, Shanghai 200040, China)

ABSTRACT With the great success of deep learning algorithms in computer vision tasks, these algorithms have been also applied to medical image analysis. This article summarizes the deep learning models related to medical image analysis and introduces their application results in medical image classification, detection, segmentation and registration, specifically involving the image analysis tasks in nerve, retina, lung, digital pathology, breast, musculoskeletal and other aspects. Finally, we summarize the current status of research and discuss the challenges and directions for future research.

KEy WORDS medical image; deep learning; clinical application

作为机器学习领域中新的学习范式,深度学习能通过逐层训练的方法学习数据深层次的非线性表达,从而深刻揭示海量数据中所蕴含的复杂抽象信息。与机器学习中常用的浅层模型相比,深层模型具有优异的特征学习能力,可从数据的复杂结构中学习到能对数据进行本质刻画的特征,有利于数据的特征提取、分类与识别、场景描述与理解等任务执行。由于具有上述优异的学习能力,深度学习已被成功应用于计算机视觉、自然语言处理和信号处理等多个领域。

目前,基于深度学习等机器学习算法的人工智能技术已深入融合到医疗领域的各个方面,从新药研制到辅助临床诊断、治疗,医学大数据分析正逐渐成为影响医疗行业发展的重要因素。特别是,将人工智能和医学影像学等技术相结合的人工智能医疗的研究,得到了各级政府相关部门的大力支持。我国人工智能医疗的市场规模2017年为136.5亿元,2018年达到210亿元左右,同比增长54%。预计在2017—2024年间,人工智能应用对医疗行业年复合增长率的贡献率将达40%。截至2019年底,我国人工智能医疗企业有80多家。医学图像的人工智能分析是数字医疗产业的研究热点,涉及企业40多家,包括阿里巴巴、腾讯、百度、科大讯飞等著名公司。人工智能技术已逐渐成为影响医疗行业发展、特别是医学图像分析研究领域的重要因素。

1 医学图像分析研究现状

人工分析医学图像不仅用时长,且受分析者经验的限制。培养一名合格的医学图像分析专业人员需耗费大量的时间和成本。因此,人工智能进入了人们的视野。1963年,美国放射学家洛德威克等提出了X线片的数字化方法。1966年,美国学者莱德利等正式提出了“计算机辅助诊断”的概念,希望通过计算机来减轻医师的工作负担。1972年,CT得到临床应用,开创了数字化医学影像学的先河。此后,磁共振成像仪、计算机X线摄影系统、数字化X线摄影系统和单光子发射型计算机X线断层扫描仪等数字化医疗设备相继问世,推动了医学图像资料的存储和传输系统的发展。1982年,美国放射学会(American College of Rediology, ACR)和美国电气制造商协会(National Electrical Manufacturers Association, NEMA)决定共同成立一个名为ACRNEMA的委员会,致力于制定医学图像设备间的通信交流规范。1985和1988年,ACR-NEMA各发布了一套规范(ACR-NEMA 1.0和ACR-NEMA 2.0)。1993年,ACR-NEMA发布了一套新规范,并命名为DICOM 3.0,详细规定了医学图像及其相关信息的传输标准。

虽然医学图像存储与传输标准有所发展,但人工智能用于医学图像分析仍困难重重,主要原因包括视觉系统成像模糊,人体组织、结构和功能的复杂性,以及传统机器学习算法的局限性等。2006年,深度算法出现,使圖像识别研究获得了突破性的进展。2012年,有研究者使用多层卷积神经网络(convolutional neural networks, CNN)结构,将图像识别的错误率从26.2%降至3%,深度机器学习算法由此进入了工业和医疗领域的应用阶段。

医学图像分析中常用的监督类深度学习模型包括CNN、基于CNN的迁移学习和递归神经网络(recursive neural networks, RNN),而非监督类深度学习模型包括自动编码器、受限玻尔兹曼机(restricted Boltzmann machines, RBM)和对抗神经网络(generative adversarial networks, GAN)[1]。CNN是目前医学图像分析中最常用的机器学习算法,其优点在于可保存图像的空间关系特征,而此特征对医学图像分析非常重要。例如,在组织学检查时,载玻片上癌细胞的DNA和细胞质的比例较正常细胞高。因此,若在CNN的前几层中检测到强烈的DNA特征,CNN就能预测癌细胞的存在。通过迁移学习可将已学到的模型参数通过某种方式分享给新模型,从而加快并优化模型的学习效率,不用像其他大多数网络那样从零开始学习。在医学图像分析中常常利用迁移学习将CNN在接受一个数据集训练期间学习到的权重转移到另一个CNN,然后再运用这些权重接受被标记过的医学数据集的训练。RNN常被用来分析序列数据,在医学图像分析中主要用于图像的分割。RNN与CNN的主要不同在于,RNN的某一层输出不仅会成为下一层的输入,且会反馈到该层,也就是说RNN可学习使用过去的信息。自动编码器主要用于数据的降维或特征提取,其不需带标记的数据集,并能有效地降低数据的维度和模型的复杂度,非常适用于缺乏带标记数据集的医学图像分析。在深度学习中,自动编码器可对输入的数据进行特征转换,先将数据编码为另一种形式,然后在此基础上进行一系列的学习。RBM[2]最初由Ackley等于1985年提出,其是一类具有2层结构、对称连接且无自反馈的随机神经网络模型,层间全连接,层内无连接。GAN[3]是一种生成式神经网络模型,由2种模型生成模型和判别模型组成,其中生成模型不断学习训练集中的真实概率分布,将输入的随机噪声转换为以假乱真的图像;判别模型则判断一幅图像是否是真实的图像,目标是将生成模型产生的图像与训练集中的真实图像区分开。深度学习模型近年来的发展十分迅速,除上述介绍的模型外,基于这些模型也产生了很多变体模型。

2 深度学习在医学图像分析中的应用

深度学习在医学图像分析中主要有4种应用方式,分别是图像的分类、检测、分割和配准。其中,分类是指根据在图像信息中反映出的特征不同,把不同类别的目标区分开来;检测是指在各个物体周围确定出边界框,这些物体可能来自不同的分类;分割是指在目标物体的边缘确定出轮廓,并对其进行语义标记;配准则是指将一幅图像拟合到另一幅图像上。

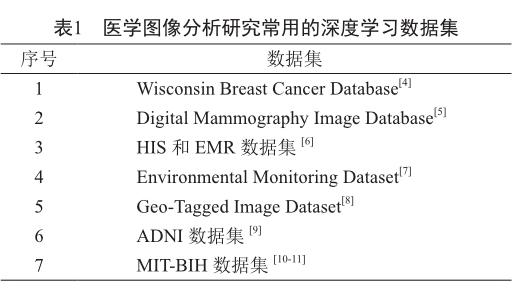

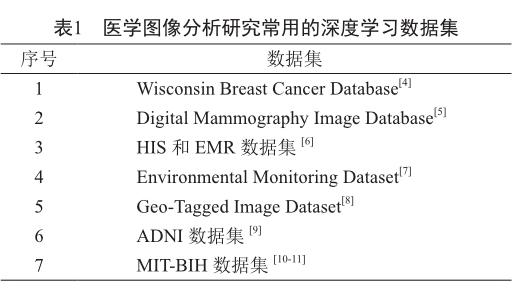

实际上,在临床医疗实践中,准确地区分这些任务并不是十分必要。事实上,在下面介绍的一些研究中,这些任务或多或少都存在着一定的混淆或混合。最理想的机器学习系统是能将上述这些任务统一起来,如先从CT图像中检测肺部肿瘤,然后定位并分割出它,最后预测使用什么治疗方案可获较好疗效。从大数据角度看,训练一个稳健的深度学习模型需使用大量、高质量的医疗数据。医学图像分析研究常用的数据集如表1所示。

2.1 医学图像分类

医学图像分析中的图像分类是深度学习应用的第一种方式。近年来,CNN被广泛应用于分类任务。2015—2017年发表的基于多分类任务的医学图像分析研究论文共有47篇,其中36篇使用CNN模型,6篇使用RBM模型,5篇使用自动编码器模型。这些模型包含很多应用场景,如脑部磁共振成像、视网膜成像、肺部CT检查和数字病理学成像等。总体来看,CNN仍是目前多分类任务所用标准模型。

早在1995年,Lo等[12]就尝试使用CNN模型在X线胸片图像上检测肺结节。他们使用55幅X线胸片图像并建立了一个拥有2个隐藏层的CNN来检测图像区域是否存在肺结节。Rajkomar等[13]以1 850幅X线胸片图像增强数据集,并利用一种预先训练好的CNN——GoogLeNet将图像分为正面图和侧面图,结果显示分类准确率几近100%。虽然该研究的临床应用价值不大,但其证实了扩充数据集和对模型进行预训练有益。Rajpurkar等[14]使用一种改进的DenseNet[15]对来自ChestX-ray数据集[16]的112 000幅X线胸片图像进行了14种疾病(包括肺炎)的分类。这种改进的DenseNet有121层卷积层,被称为CheXNet。研究者将肺炎图像视为正类、其余13种疾病的图像视为负类来进行分类,受试者工作特征曲线下面积(area under curve of receiver operating characteristics, AUC)为0.763。研究者还利用测试集比较了CheXNet和放射科医师诊断结果的受试者工作特征曲线,结果显示CheXNet的AUC为0.788,优于放射科医师的AUC,表明CheXNet在检测肺炎这项任务上已能匹配、甚至超过放射科医师。Shen等[17]使用CNN并结合支持向量机和随机森林对来自LIDC-IDRI数据集的1 010幅带标记的肺部CT图像进行肺结节良、恶性分类。他们使用3个并行运行的CNN,每个CNN有2层卷积层,不同的CNN使用不同尺度的图像块来提取特征,然后将学习到的特征结合起来,构造成一个特征向量,最后利用核函数为径向基函数的支持向量机或随机森林作为分类器进行分类。他们模型的分类准确率达到86%,且该模型显示有很强的鲁棒性。Kallenberg等[18]将作为自动编码器训练的非监督卷积层与监督层相结合,对乳房X线片图像按不同纹理和密度进行分类,进而判断是否存在乳腺癌。他们使用来自荷兰乳腺癌筛查项目的2 700幅乳房X线片图像、荷兰乳腺癌筛查数据集和葡萄牙梅奥乳腺摄影健康研究数据集,发现该卷积堆叠自编码器模型的AUC为0.57。van Tulder等[19]利用卷积RBM对肺组织按正常、肺气肿、纤维化、微结节和毛玻璃组织进行分类,使用的数据集由ILD数据库中128例间质性肺部疾病患者的CT图像组成。卷积RBM通过纯判别、纯生成、混合判別和生成学习目标来产生滤波器,然后使用这些滤波器提取特征,最后利用随机森林进行分类。他们模型的分类准确率为41% ~ 68%,且发现通过混合判别产生的滤波器的效果最好。此外,Khatami等[20]使用深度信念网络将X线片图像按解剖区域和方向分为5类。

Li等[21]提出了一种三维CNN模型来补全多模态数据,使用磁共振成像数据来预测缺失的正电子发射型计算机X线断层扫描数据,但模型过拟合问题未解决。Hosseini-Asl等[22]使用深度三维CNN来学习捕获阿尔茨海默病的通用特征并适应不同的数据集域。三维CNN建立在三维卷积自动编码器的基础上,该编码器经预训练,可捕获结构性脑磁共振成像中的解剖形状变化,然后针对每个特定于任务的阿尔茨海默病分类微调三维CNN的完全连接的上层。Korolev等[23]提出了一种基于VGGNet的残差神经网络架构,这种架构可使层数达100 ~ 1 000层的神经网络模型也得到很好的训练。他们利用ADNI数据库中的数据并分别使用VoxNet和ResNet来对健康者和老年痴呆症患者的脑磁共振成像图像进行分类,结果显示模型的分类准确率分别为79%和80%。虽然这些数值相对较低,但他们的模型建立过程更为简单。

Pratt等[24]训练了一个具有10层卷积层和3个全连接层的CNN来处理90 000幅眼底图像。他们将糖尿病视网膜病变按照严重程度分为5类,模型的分类准确率为75%。除此之外,Plis等[25]对亨廷顿舞蹈病和精神分裂症患者进行功能性磁共振成像检查,并使用深度信念网络从功能性磁共振成像图像中提取特征。

2.2 医学图像检测

对解剖对象病变部位进行检测和定位是医学图像分析中的重要一步。

2017年Kaggle“数据科学碗(Data Science Bowl)”比赛的任务包括检测肺部CT图像中癌变的肺结节,所用数据集共包括2 000幅CT图像。该赛题优胜者使用的三维CNN模型受U-Net[26]架构的启发,先用图像的子图像块进行肺结节检测,然后将这个输出作为第二阶段的输入,而第二阶段由2个全连接层构成,用于输出患癌概率[27]。Shin等[28]使用5种著名的CNN模型来检测CT图像上的胸、腹部淋巴结和肺间质病变,其中淋巴结是可能患癌的标志。他们使用GoogLeNet对纵隔淋巴结进行检测,模型的AUC高达0.95,是一个非常好的结果。此外,他们还总结了迁移学习的益处。Overfeat是2013年ImageNet定位任务比赛的冠军项目[29],同时也在分类和检测任务上获得了不错的结果。Ciompi等[30]将Overfeat与简单的支持向量机和随机森林分类器相结合,使用肺部CT图像的冠状面、轴向面和矢状面的二维切片图进行训练,用于检测肺部间隙及其周围是否存在肺结节。

除肺部病变检测外,也用于其他病变检测,如恶性皮肤细胞检测。Esteva等[31]使用13万幅皮肤病学图像和皮肤镜图像去训练基于Inception V3的GoogLeNet。该模型将图像分为良性、恶性和非肿瘤性病变3类,分类准确率为72%,而2名医师基于专业知识的人工分类准确率分别为65%和66%。除此之外,该模型在预测2种皮肤癌治疗方案的疗效方面也优于21名皮肤科医师,其AUC在0.91 ~ 0.96间。

目前,组织病理学检查图像越来越数字化,相关研究也越来越多。一片组织病理学切片可能包含上百、甚至上千个细胞,在高倍显微镜下也存在丢失异常的肿瘤区域的风险。Ciresan等[32]使用11 ~ 13层卷积层的CNN识别来自MITOS数据集的50幅乳腺组织图像中的有丝分裂图像,获得88%的准确率和70%的召回率。Yang等[33]使用5 ~ 7层卷积层的CNN将肾癌组织病理学检查图像分为肿瘤和非肿瘤2类,准确率达到97%。Sirinukunwattana等[34]使用CNN在100幅结肠腺癌的染色组织病理学检查图像中检测结肠腺癌细胞核。他们的方法中使用了空间受限CNN,使用空间回归和周围空间环境来识别细胞核的中心。Xu等[35]则使用堆叠稀疏自编码器来检测乳腺癌组织切片图像中的乳腺癌细胞核,结果显示模型的准确率为89%,同时也证明了无监督学习可用于这方面的检测。

2.3 医学图像分割

CT和磁共振成像图像分割研究涵盖肝脏、前列腺和膝关节软骨等各种器官和组织,但大量研究集中在脑、包括脑肿瘤图像的分割方面。若在手术中破坏太多脑区会致出现多种神经功能缺陷,故确定脑肿瘤的确切边界对指导切除性手术的实施非常重要。在传统治疗过程中,这种边界是由脑外科医师通过CT或磁共振成像图像逐层绘制的。Akkus等[36]总结了在脑磁共振成像图像分割中曾使用过的各种CNN架构及其性能,并介绍了许多相关数据集。

Moeskops等[37]使用3个并行运行的CNN对22名儿童和35名成人的大脑磁共振成像图像按不同组织进行分类,如白质、灰质和脑脊液等。每个CNN都有大小不同的二维子图像块的输入,每个子图像块分别专注于捕获图像的不同特征,其中最小的子图像块专注于捕获图像的局部纹理特征,较大的子图像块则专注于捕获图像的空间特征。结果显示,该模型的Dice系数在0.82 ~ 0.87间。Tajbakhsh等[38]使用迁移学习分析了4种不同类型的医学图像,包括结肠镜检查图像上的息肉检测、结肠镜检查图像的帧分类、肺血管造影CT图像上的肺栓塞检测和超声扫描颈动脉壁层图像的内中膜界面分割。他们的研究还发现,与从头开始训练的CNN相比,迁移学习能更好地提高CNN的性能。Chen等[39]将CNN和RNN相结合,从显微镜图像中分割出了神经元和真菌结构。

大多数关于医学图像分割的研究都是在二维图像上进行的,但Milletari等[40]卻使用三维CNN对来自PROMISE 2012数据集的前列腺磁共振成像图像进行分割。他们提出的V-Net具有U-Net架构[26],模型的Dice系数为0.869。Pereira等[41]使用3×3矩阵的滤波器,设计了一个具有11层卷积层的CNN模型,并用274幅存在神经胶质瘤的脑磁共振成像图像训练该模型。他们的模型解决了过拟合问题,且在2013年国际医学图像计算和计算机辅助干预协会举办的“多模态脑肿瘤分割”挑战赛中获得了第一名。Havaei等[42]也研究了神经胶质瘤的图像分割问题,他们的CNN模型中使用了一种级联架构,即第一个CNN的输出作为第二个CNN的输入,算法的运行时间从100 min减少到3 min。Chen等[43]提出了一种DeepLab架构,在对PASCAL VOC-2012图像分割上表现优秀。Casamitjana等[44]比较了各种三维CNN架构在图像分割任务中的性能,发现由DeepMedic CNN[45]修改而来的模型对BRATS 2015脑瘤数据集中图像的分割表现最好。他们提倡使用更小的感受野和多尺度架构。Stollenga等[46]则通过长短期记忆网络对神经元的三维电子显微镜图像和脑磁共振成像图像进行分割。医学图像分割方法多种多样,出于细分目的,RNN也很常用。Xie等[47]使用Clockwork RNN模型对由苏木精-伊红染色的组织病理学检查图像中的肌膜进行了分割。

2.4 醫学图像配准

医学图像配准是一种常见的图像分析任务,其通常在一种特定的(非)参数转换类型的迭代框架中进行。目前,图像配准主要有2种策略:第一种是使用深度学习网络来估算2幅图像的相似度,进而驱动迭代优化策略;第二种是使用深度回归方法直接预测转换参数。

El-Gamal等[48]介绍了医学图像配准的概念及其技术发展动态。神经外科或脊柱外科医师使用图像配准来定位肿瘤或脊柱骨“地标”,以便于手术切除肿瘤或植入脊柱螺钉。图像配准涉及2幅图像,即参考图像和感知图像,其中参考图像可是术前脑磁共振成像图像,感知图像则可为首次切除肿瘤后的脑磁共振成像图像。感知图像被用来确定是否有残余肿瘤以及是否需要进行二次切除。

Yang等[49]使用OASIS数据集中的脑磁共振成像图像,以编码-解码的方式堆叠卷积层,以预测输入像素如何变形为其最终配置。他们使用LDDMM配准模型,大大缩短了计算时间。Miao等[50]使用具有5层卷积层的CNN模型,将膝关节植入物、手部植入物和食管探头的三维模型配准到二维X线片图像上,以评估它们的姿态。他们的方法成功配准的用时仅为0.1 s,较传统配准方法有显著的进步。

3 小结和展望

深度学习是人工智能研究领域的热点之一。在机器学习中,一个关键问题是数据问题,高质量的数据能有效提高算法的性能。但事实上,特别是在医学图像方面,高质量的带标记的数据严重匮乏。因此,研究者们都希望能通过更好的模型架构来避免有限数据的限制,而本文所介绍的一些研究结果相对来说是令人满意的。深度学习中的一些生成模型,如GAN和变分自编码器,也可通过合成医疗数据来避免数据匮乏的问题。

本文第2节主要介绍了深度学习在医学图像分析中的一些传统应用方式,即图像分类、检测、分割和配准。但现深度学习也有许多新的应用,如Nie等[51-52]使用GAN从原始图像生成了分辨率更高的CT图像。这种方法亦可用来生成高质量的磁共振成像图像以降低医疗成本。Tsochatzidis等[53]完成了一项基于内容的图像检索和计算机辅助诊断相结合的工作。机器学习在医学图像分析方面的发展极其迅速,应用也会越来越多。

总的来说,尽管目前的人工智能应用于医学图像分析还有可解释性、鲁棒性等极其重要的问题需予解决,但在某些特定的图像识别中,现有的人工智能已超过人类。相信未来人工智能系统一定能在很大程度上辅助、甚至替代医师来读片和诊断,而智能医学图像分析产品也会越来越多地进入临床并得到实际应用。

参考文献

[1] Litjens G, Kooi T, Bejnordi BE, et al. A survey on deep learning in medical image analysis [J]. Med Image Anal, 2017, 42: 60-88.

[2] Smolensky P. Information processing in dynamical systems: foundations of harmony theory [M]//Rumelhart DE, McClelland JL. Parallel distributed processing, Vol. 1. Cambridge, USA: MIT Press, 1986: 194-281.

[3] Goodfellow IJ, Pouget-Abadie J, Mirza M, et al. Generative adversarial nets [EB/OL]. [2020-09-13]. https://arxiv.org/ pdf/1406.2661.pdf.

[4] Abdel-Zaher AM, Eldeib AM. Breast cancer classification using deep belief networks [J]. Expert Syst Appl, 2016, 46: 139-144.

[5] Nie D, Zhang H, Adeli E, et al. 3D deep learning for multimodal imaging-guided survival time prediction of brain tumor patients [J]. Med Image Comput Comput Assist Interv, 2016, 9901: 212-220.

[6] Havaei M, Guizard N, Larochelle H, et al. Deep learning trends for focal brain pathology segmentation in MRI [EB/ OL]. [2020-09-13]. https://arxiv.org/pdf/1607.05258.pdf.

[7] Yan Y, Qin X, Wu Y, et al. A restricted Boltzmann machine based two-lead electrocardiography classification [EB/OL].[2020-09-13]. https://ieeexplore.ieee.org/document/7299399.

[8] Che Z, Purushotham S, Khemani R, et al. Distilling knowledge from deep networks with applications to healthcare domain [EB/OL]. [2020-09-13]. https://arxiv.org/ pdf/1512.03542v1.pdf.

[9] Sun W, Tseng TB, Zhang J, et al. Enhancing deep convolutional neural network scheme for breast cancer diagnosis with unlabeled data [J]. Comput Med Imaging Graph, 2017, 57: 4-9.

[10] Andreu-Perez J, Poon CC, Merrifield RD, et al. Big data for health [J]. IEEE J Biomed Health Inform, 2015, 19(4): 1193-1208.

[11] Futoma J, Morris J, Lucas J. A comparison of models for predicting early hospital readmissions [J]. J Biomed Inform, 2015, 56: 229-238.

[12] Lo SB, Lou SA, Lin JS, et al. Artificial convolution neural network techniques and applications for lung nodule detection[J]. IEEE Trans Med Imaging, 1995, 14(4): 711-718.

[13] Rajkomar A, Lingam S, Taylor AG, et al. High-throughput classification of radiographs using deep convolutional neural networks [J]. Digit Imaging, 2017, 30(1): 95-101.

[14] Rajpurkar P, Irvin J, Zhu K, et al. CheXNet: radiologist-level pneumonia detection on chest X-rays with deep learning [EB/ OL]. [2020-09-13]. https://arxiv.org/pdf/1711.05225.pdf.

[15] Huang G, Liu Z, van der Maaten L, et al. Densely connected convolutional networks [EB/OL]. [2020-09-13]. https://arxiv. org/pdf/1608.06993.pdf.

[16] Wang X, Peng Y, Lu L, et al. ChestX-ray8: hospital-scale chest X-ray database and benchmarks on weakly-supervised classification and localization of common thorax diseases[EB/OL]. [2020-09-13]. https://arxiv.org/pdf/1705.02315.pdf.

[17] Shen W, Zhou M, Yang F, et al. Multi-scale convolutional neural networks for lung nodule classification [J]. Inf Process Med Imaging, 2015, 24: 588-599.

[18] Kallenberg M, Petersen K, Nielsen M, et al. Unsupervised deep learning applied to breast density segmentation and mammographic risk scoring [J]. IEEE Trans Med Imaging, 2016, 35(5): 1322-1331.

[19] van Tulder G, de Bruijne M. Combining generative and discriminative representation learning for lung CT analysis with convolutional restricted Boltzmann machines [J]. IEEE Trans Med Imaging, 2016, 35(5): 1262-1272.

[20] Khatami A, Khosravi A, Nguyen T, et al. Medical image analysis using wavelet transform and deep belief networks[J]. Expert Syst Appl, 2017, 86: 190-198.

[21] Li R, Zhang W, Suk HI, et al. Deep learning based imaging data completion for improved brain disease diagnosis [J]. Med Image Comput Comput Assist Interv, 2014, 17(Pt 3): 305-312.

[22] Hosseini-Asl E, Gimelfarb G, El-Baz A. Alzheimers disease diagnostics by a deeply supervised adaptable 3D convolutional network [EB/OL]. [2020-09-13]. https://arxiv. org/pdf/1607.00556v1.pdf.

[23] Korolev S, Safiullin A, Belyaev M, et al. Residual and plain convolutional neural networks for 3D brain MRI classification[EB/OL]. [2020-09-13]. https://arxiv.org/pdf/1701.06643v1. pdf.

[24] Pratt H, Coenen F, Broadbent DM, et al. Convolutional neural networks for diabetic retinopathy [J]. Procedia Comput Sci, 2016, 90: 200-205.

[25] Plis SM, Hjelm DR, Salakhutdinov R, et al. Deep learning for neuroimaging: a validation study [J/OL]. Front Neurosci, 2014, 8: 229 [2020-09-13]. doi: 10.3389/fnins.2014.00229.

[26] Ronneberger O, Fischer P, Brox T. U-Net: convolutional networks for biomedical image segmentation [EB/OL].[2020-09-13]. https://arxiv.org/pdf/1505.04597.pdf.

[27] Liao F, Liang M, Li Z, et al. Evaluate the malignancy of pulmonary nodules using the 3-D deep leaky noisy-OR network [J]. IEEE Trans Neural Netw Learn Syst, 2019, 30(11): 3484-3495.

[28] Shin HC, Roth HR, Gao M, et al. Deep convolutional neural networks for computer-aided detection: CNN architectures, dataset characteristics and transfer learning [J]. IEEE Trans Med Imaging, 2016, 35(5): 1285-1298.

[29] Sermanet P, Eigen D, Zhang X, et al. Overfeat: integrated recognition, localization and detection using convolutional networks [EB/OL]. [2020-09-13]. https://arxiv.org/ pdf/1312.6229.

[30] Ciompi F, de Hoop B, van Riel SJ, et al. Automatic classification of pulmonary peri-fissural nodules in computed tomography using an ensemble of 2D views and a convolutional neural network out-of-the-box [J]. Med Image Anal, 2015, 26(1): 195-202.

[31] Esteva A, Kuprel B, Novoa RA, et al. Dermatologist-level classification of skin cancer with deep neural networks [J]. Nature, 2017, 542(7639): 115-118.

[32] Cire?an DC, Giusti A, Gambardella LM, et al. Mitosis detection in breast cancer histology images with deep neural networks [J]. Med Image Comput Comput Assist Interv, 2013, 16(Pt 2): 411-418.

[33] Yang X, Yeo SY, Hong JM, et al. A deep learning approach for tumor tissue image classification [EB/ OL]. [2020-09-13]. https://www.researchgate.net/profile/ Xulei_Yang/publication/298929528_A_Deep_Learning_ Approach_for_Tumor_Tissue_Image_Classification/ links/56ed642108ae59dd41c5d00b/A-Deep-LearningApproach-for-Tumor-Tissue-Image-Classification.pdf.

[34] Sirinukunwattana K, Ahmed Raza SE, Tsang YW, et al. Locality sensitive deep learning for detection and classification of nuclei in routine colon cancer histology images [J]. IEEE Trans Med Imaging, 2016, 35(5): 1196-1206.

[35] Xu J, Xiang L, Liu Q, et al. Stacked sparse autoencoder(SSAE) for nuclei detection on breast cancer histopathology images [J]. IEEE Trans Med Imaging, 2016, 35(1): 119-130.

[36] Akkus Z, Galimzianova A, Hoogi A, et al. Deep learning for brain MRI segmentation: state of the art and future directions[J]. J Digit Imaging, 2017, 30(4): 449-459.

[37] Moeskops P, Viergever MA, Mendrik AM, et al. Automatic segmentation of MR brain images with a convolutional neural network [J]. IEEE Trans Med Imaging, 2016, 35(5): 1252-1261.

[38] Tajbakhsh N, Shin JY, Gurudu SR, et al. Convolutional neural networks for medical image analysis: full training or fine tuning? [J]. IEEE Trans Med Imaging, 2016, 35(5): 1299-1312.

[39] Chen J, Yang L, Zhang Y, et al. Combining fully convolutional and recurrent neural networks for 3D biomedical image segmentation [EB/OL]. [2020-09-13]. https://arxiv.org/ pdf/1609.01006.pdf.

[40] Milletari F, Navab N, Ahmadi SA. V-Net: fully convolutional neural networks for volumetric medical image segmentation[EB/OL]. [2020-09-13]. https://arxiv.org/pdf/1606.04797.pdf.

[41] Pereira S, Pinto A, Alves V, et al. Brain tumor segmentation using convolutional neural networks in MRI images [J]. IEEE Trans Med Imaging, 2016, 35(5): 1240-1251.

[42] Havaei M, Davy A, Warde-Farley D, et al. Brain tumor segmentation with deep neural networks [J]. Med Image Anal, 2017, 35: 18-31.

[43] Chen LC, Papandreou G, Kokkinos I, et al. DeepLab: semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected CRFs [J]. IEEE Trans Pattern Anal Mach Intell, 2018, 40(4): 834-848.

[44] Casamitjana A, Puch S, Aduriz A, et al. 3D convolutional networks for brain tumor segmentation [EB/OL]. [2020-09-13]. https://imatge.upc.edu/web/sites/default/files/pub/ cCasamitjana16.pdf.

[45] Kamnitsas K, Ledig C, Newcombe VFJ, et al. Efficient multiscale 3D CNN with fully connected CRF for accurate brain lesion segmentation [J]. Med Image Anal, 2017, 36: 61-78.

[46] Stollenga MF, Byeon W, Liwicki M, et al. Parallel multidimensional LSTM, with application to fast biomedical volumetric image segmentation [EB/OL]. [2020-09-13]. https://arxiv.org/pdf/1506.07452.pdf.

[47] Xie Y, Zhang Z, Sapkota M, et al. Spatial clockwork recurrent neural network for muscle perimysium segmentation [J]. Med Image Comput Comput Assist Interv, 2016, 9901: 185-193.

[48] El-Gamal EZA, Elmogy M, Atwan A. Current trends in medical image registration and fusion [J]. Egypt Inform J, 2016, 17(1): 99-124.

[49] Yang X, Kwitt R, Styner M, et al. Quicksilver: fast predictive image registration – a deep learning approach [J]. Neuroimage, 2017, 158: 378-396.

[50] Miao S, Wang ZJ, Liao R. A CNN regression approach for real-time 2D/3D registration [J]. IEEE Trans Med Imaging, 2016, 35(5): 1352-1363.

[51] Nie D, Trullo R, Lian J, et al. Medical image synthesis with context-aware generative adversarial networks [J]. Med Image Comput Comput Assist Interv, 2017, 10435: 417-425.

[52] Nie D, Cao X, Gao Y, et al. Estimating CT image from MRI data using 3D fully convolutional networks [J]. Deep Learn Data Label Med Appl, 2016, 2016: 170-178.

[53] Tsochatzidis L, Zagoris K, Arikidis N, et al. Computer-aided diagnosis of mammographic masses based on a supervised content-based image retrieval approach [J]. Pattern Recogn, 2017, 71: 106-117.

*基金項目:西安市科技创新计划(高校重大科技创新平台建设)资助项目(2019421315KYPT004JC006)

**通信作者:陈坚,副主任医师。研究方向:消化道肿瘤的基础研究与临床诊治。E-mail: chen5120@126. com