智能车环境视觉感知及其关键技术研究现状

2019-06-11陈政宏李爱娟邱绪云袁文长葛庆英

陈政宏 李爱娟 邱绪云 袁文长 葛庆英

摘要:环境视觉感知技术是智能车获取外界环境信息的主要手段,是智能车进行自主驾驶的前提条件。在综合分析以不同检测对象为目标的检测技术方法的基础上,给出了环境视觉感知研究的主要内容,讨论了研究涉及的关键技术:车道检测技术、车辆检测技术、行人检测技术、交通标志检测技术,并对每种检测技术各子技术的优点和不足之处进行了分析。在总结全文的基础上,提出未来智能驾驶中环境视觉感知技术的主要发展趋势包括:基于多特征融合的环境视觉感知技术的发展;复杂环境下多种环境感知技术的融合应用;三维图像在图像处理方面的应用;改进的卷积神经网络(CNN)方法在图像处理方面的应用。

关键词:车辆工程;视觉感知;车道检测;行人检测;车辆检测;交通标志检测

中图分类号:U273文献标志码:A

CHEN Zhenghong, LI Aijuan, QIU Xuyun, et al.Survey of environment visual perception for intelligent vehicle and its supporting key technologies[J].Journal of Hebei University of Science and Technology,2019,40(1):15-23.Survey of environment visual perception for intelligent

vehicle and its supporting key technologies

CHEN Zhenghong, LI Aijuan, QIU Xuyun, YUAN Wenchang, GE Qingying

(School of Automotive Engineering, Shan Dong Jiaotong University, Jinan, Shandong 250357, China)

Abstract:Environmental visual perception technology is one of the main means for intelligent vehicles to obtain external environmental information and the precondition for autonomous driving of intelligent vehicles. Based on the comprehensive analysis of the detection technology and methods targeted at different detection objects, the main contents of environmental visual perception research are provided, and the key technologies that the study involves including lane detection technology, vehicle detection technology, the pedestrian detection technology, and traffic signs detection technology are discussed. The advantages and disadvantages of each sub-technique of each technology are analyzed. Finally, on the basis of summarization of the paper, the prospect of unmanned environment of visual perception technology in the future development direction is given:the development of the multi-feature fusion based environment visual perception technology; the fusion application of several environment perception technologies under complicated conditions; the application of the three-dimensional image in picture processing; the application of the improved CNN method in picture processing.

Keywords:vehicle engineering; visual perception; lane detection; pedestrian detection; vehicle detection; traffic signs detection

智能車是自主实施任务决策,具备一定自适应和学习能力的智能设备[1]。智能车在自主运动时会涉及到环境感知问题[2],若对环境感知没有正确的认识,使用不准确的感知信息来指导任务决策、轨迹规划、控制系统,智能车则会做出错误的判断,降低驾驶效率。例如,交通标志检测系统因错过一个停车标志,就会发生交通事故。

目前,智能车辆的研究处于不成熟阶段,本身又是非完整系统,复杂的环境使得智能车在自主行驶过程中的环境感知问题变得不再单一。车辆进行环境感知的主要目的是给车辆的自主导航和轨迹规划提供最根本的基础依据,保证车辆能够自主、安全、可靠的行驶[3]。

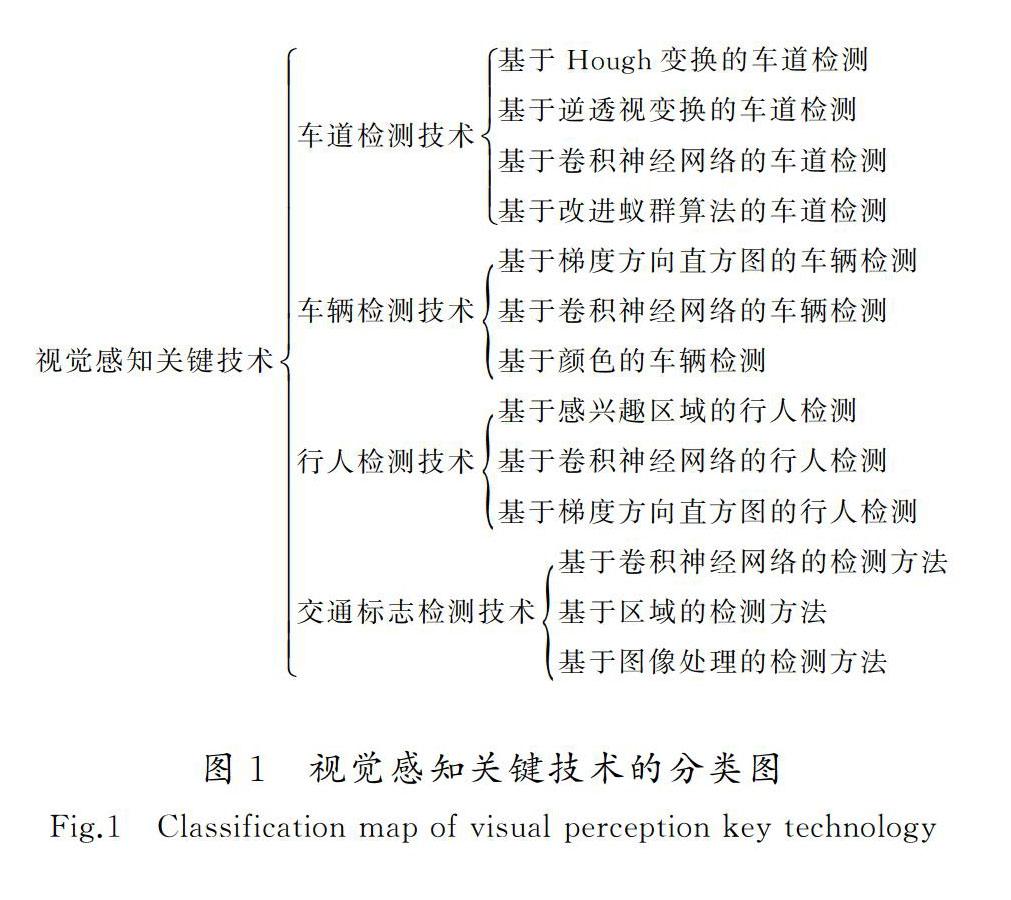

本文主要分析智能车辆环境视觉感知的4种关键技术——车道检测技术、车辆检测技术、行人检测技术、交通标志检测技术的研究现状以及各技术的适用性、优缺点,并对视觉感知技术未来的发展趋势进行展望。

1智能车辆视觉感知概况

随着智能车的发展和普及,环境视觉感知技术受到了极大的关注[4]。视觉感知技术是从相机中获取、解释数据,执行关键任务的,如对车辆、道路、行人检测。自动驾驶系统通常会有其他传感器的参与,但相机是必不可少的,因为它可以模拟人眼,获得真实的环境信息,大多数交通规则是通过假定视觉感知能力来设计的。例如,许多交通标志有着相似的外形,它们的颜色模式只能通过视觉感知系统识别。

河北科技大学学报2019年第1期陈政宏,等:智能车环境视觉感知及其关键技术研究现状视觉感知主要用于检测动态(如车辆、行人)或静态(如车道、交通标志)障碍物,不同的障碍物会使车辆面临着不同的任务决策和驾驶规则。例如,一条道路对边界进行了严格定义,车辆必须在保证不超过边界的情况下安全行驶。近年来,研究者主要集中于车道、车辆、行人、交通标志的检测与研究[5]。

2视觉感知的关键技术

综合了研究者的部分文献,本文的视觉感知技术主要以车道、车辆、行人和交通标志为检测对象进行分类,视觉感知关键技术的分类图如图1所示。

2.1车道检测技术

车道检测[6]是智能车在道路上安全行驶不可或缺的重要技术,若不正确检测车道,会危及车辆自身及道路上其他车辆的安全。现阶段,视觉感知技术中车道大多是由车道标记[7]来定义的,文献[8]中研究了一种车道检测算法,它能够处理弯曲车道、磨损的车道标记、车道变化等,实现鲁棒性、实时性检测。

2.1.1基于Hough变换的车道检测

针对光照和背景杂波问题,文献[9]采用改进的Hough变换(HT)提取车道轮廓小线段,利用带有噪声的基于密度的聚类算法 (density-based spatial clustering of applications with noise,DBSCAN)将小线段进行聚类,通过曲线拟合来识别车道,实验结果表明检测效果优于直线算法(line segment detector,LSD),比传统的Hough变换更精确,对噪声具有很强的鲁棒性。为了适应复杂多变的车道环境,文献[10]中提出了基于多约束条件下的Hough变换检测方法:通过改变原始图像(red green blue, RGB)的分量权重转化为灰度化图像,增加图像约束条件后,利用Hough变换提取车道标记线,概率表决程序估计线段上的消失点,用消失点约束线段[11],进而再对车道线K-means聚类,此方法优于传统Hough变换消失点约束方法,具有很好的鲁棒性和实时性,而文献[12]是在自由条件下先利用传统的Hough变换提取道路标记线,再对原始灰度图像进行操作,并在几个概率最高的候选点附近识别地标特征,然后利用这些特征提取出更高精度的车道边界。

2.1.2基于逆透视变换的车道检测

逆透视变换是根据相机的标定信息对图像进行自上而下的平行投影,得到车道线的俯视图。文献[13]的综述中给出了一种基于逆透视变换的车道检测方法,可滤除图像中的透视效果和车道线不平行的干扰,但不适用于车辆上下坡。文献[14]中根据逆透视变换得到车道线的俯视图后,采用局部二值模式算子(local binary patterns, LBP)对图像纹理进行分析,检测出车道线边缘,用贝赛尔曲线拟合出车道线,但仅适用于平面道路上行驶的车辆。

2.1.3基于卷积神经网络的车道检测

通过剔除噪声和障碍物,卷积神经网络[15](convolutional neural networks, CNN)可以增强车道检测前的输入图像。研究表明,传统的CNN需要大量的计算和数据集,文献[16]则提出了一种利用极端学习机进行CNNs学习的新算法,大大节省了计算和数据收集的时间。由于卷积特征无法清晰地检测到微小物体,文献[17]提出了一种基于改进的快速区域卷积神经网络(fast regions with CNN features, Fast R-CNN)方法,对图像中的小目标进行快速多层次组合、上下文线索和锚点生成方法检测,实验表明,准确率优于R-CNN。为了提高车道检测的准确性和鲁棒性,文献[18]提出了基于CNN和马尔可夫随机场(Markov random fields, MRF)结合的车道检测方法,利用迭代聚类算法将图像分割成大小均匀的超像素图像,同时利用CNN训练模型对道路和非道路区域进行分类,基于超像素邻域之间的关系,利用MRF对CNN的分类结果进行优化,该方法在光照和道路阴影变化时具有很好的鲁棒性。弯道、车道线模糊、光线昏暗等复杂环境下,文献[19]提出了基于全卷积神经网络[20]的检测算法,首先将图像信息输入到全卷积神经网络中,然后利用条件随机场[21](conditional random fields, CRF)对图像信息进行处理,得到的结果与原始图像具有一致性,经过验证,此方法在检测精度、识别率和速度上都有很明显的优越性。

2.1.4基于改进蚁群算法的车道检测

为了准确识别出车道线,并去除图像噪声,文献[22]中先对道路图像滤波,再利用基于改进蚁群算法[23]的二维Otsu算法[24]进行图像分割,从而拟合并识别出车道线。基于改进的蚁群算法可以有效增加车道线的有效特征点。现阶段,车道检测技術已趋于自动化,文献[25]结合各种空间、光谱和纹理对象等描述符,提出了一种利用模糊推理系统[26](fuzzy inference system, FIS)对图像进行分析的基于蚁群算法的改进高分辨率(very high resolution, VHR)遥感卫星图像路网检测方法[27],使用边缘保持引导过滤器[28]平滑卫星道路图像,磁共振探测(magnetic resonance sounding, MRS)方法[29]生成图像对象,该结果的平均完整性、正确性和质量都比较好,但仅适用于城市车道。

综上所述,基于Hough特征变换的车道检测技术可以克服光照、复杂多变的道路环境,但恶劣环境下(如雨天)车道线检测模糊;基于逆透视变换的车道检测技术仅适用于平面行驶的车辆;基于改进蚁群算法的车道检测技术可以解决车辆、广告牌等边缘物体的干扰,增加有效车道线,较趋于自动化,但仅适用于城市车道检测;基于卷积神经网络(CNN)的车道检测技术可得到与现实环境相似的信息,较前幾种方法环境适应性、鲁棒性好。

2.2车辆检测技术

正确的车辆目标检测是安全驾驶的关键。目前采用的方法可分为基于知识的、基于特征的、基于学习的、基于立体的和基于运动的[30]。传统的检测方法主要由两个步骤构成:从原图像中提取可用的特征,利用合适的算法(AdaBoost算法[31])构建高效分类器辨别图像场景。传统的基于边缘的车辆检测方法易受到噪声和背景干扰,文献[32]中利用边缘信息可以帮助突出轮廓及投射物体阴影的原理,提出了一种基于高斯差分的多尺度边缘融合的车辆检测方法。

2.2.1基于梯度方向直方图的车辆检测

梯度方向直方图[33](histogram of gradient, HOG)是进行车辆目标检测应用最广泛的特征。文献[34]中提出HOG和局部自相似(local self-similarity, LSS)特征结合的检测方法,结合Adaboost、支持向量机[35](support vector maching, SVM)分类器进行实验,结果表明,组合特征的描述能力优于单一特征。为了适应复杂的城市环境,文献[36]提出了一种基于Harr特征和HOG特征结合的两步算法,利用Harr特征提取出HOG特征的感兴趣区域(region of interest, ROI),级联结构Adaboost分类器对其特征和目标区域进行分类,从ROI区域中提取出HOG特征,该方法的检测精度很高。

2.2.2基于卷积神经网络的车辆检测

文献[37]中提出了一种快速车辆提议网络(fast vehicle proposal network, FVPN)的浅度完全卷积神经网络,可实时定位车辆对象。为了得到精细的显著目标,文献[38]中提出了一种可实现端到端的基于层次显著性循环卷积神经网络检测方法,它首先是通过视觉几何组(visual geometry group, VGGNet)对图像中的车辆目标进行检测得到粗略显著性图像,然后使用层次循环卷积神经网络对目标逐层细化得到显著性图像,最后采用自适应分割阈值的方法提取目标区域,此方法更好解决了光照条件的影响。

2.2.3基于颜色的车辆检测

为了对环境了解更全面,文献[39]提出了基于三维激光雷达和彩色摄像机数据的车辆检测体系,利用单目彩色相机校准激光雷达RGB图像,以提高车辆检测效率。文献[40]提出了一种基于颜色强度分离的车辆检测方法,利用强度信息滤波ROI的光照变化、阴影和杂乱背景,再对车辆进行检测,该方法依赖于车辆与周围环境之间的颜色强度差,适用于实施应用。文献[41]是将RGB视频帧转换为色域图像(hue saturation lightness, HSV),更准确地区分了车辆的颜色特征,实现对车辆的跟踪,其每一帧的噪声都可以降低或消除。

综上所述,基于梯度方向直方图(HOG特征)的车辆检测技术在复杂环境下需与各分类器或特征结合;基于颜色的车辆检测技术虽可以实现车辆识别和跟踪,但依赖于颜色强度;基于卷积神经网络(CNN)的车辆检测技术可以解决光照条件的影响,较前两种方法具有很好的鲁棒性和运算效率。

2.3行人检测技术

现阶段,行人检测是机器视觉研究的一个重要领域,智能车辆在行驶过程中面临着行人的衣着、光线、姿态多变等因素,这就需要动态感应,发现行人的踪迹,因此,行人检测和规避行人的研究领域极具挑战性。

2.3.1基于感兴趣区域的行人检测

在遮挡、旋转、光照条件的影响下,文献[42]提出基于感兴趣区域和级联分类器的检测方法,识别、定位和提取包含行人的候选区,用分类器对目标信息进行提取。文献[43]提出SVM提取ROI的行人检测方法,而SVM的分类器特征较低,会导致部分行人划分错误,影响检测结果。针对复杂环境的行人检测,文献[44]提出了基于双目视觉感兴趣区域的行人检测,利用相机标定的信息,获取视差图和深度图,在去除干扰获得感兴趣区域后,与CNN训练模型对比判定行人,此方法也适合逆光环境,但会出现错检或漏检。

2.3.2基于卷积神经网络的行人检测

卷积神经网络(CNN)已经被证明具有最先进的行人检测精度,然而,在处理单个图像时常需要数十亿浮点运算的情况下,代价是昂贵的,为了解决这个复杂性问题,文献[45]中提出Fast R-CNN和只需瞄一眼[46](you only look once, YOLO)便可识别出图像中的行人及位置信息,降低了计算成本。基于CNN的框架,文献[47]提出了基于深度卷积神经网络的多光谱行人检测方法,采用不同于文献[48]融合图像的方法,为了更好地进行鲁棒性行人检测,文献[49]给出了一种基于深度卷积神经网络进行无监督多光谱特征学习的行人检测方法,利用自动标注框架与多光谱数据信息进行互补,在可见通道中进行迭代标注行人,此方法与最先进的基于深度神经网络(deep neural networks, DNNs)的行人检测性能相当,但它无法通过注释正确识别一些微不足道的行人样本。

2.3.3基于梯度方向直方图的行人检测

通过利用梯度方向直方图来构成人体特征的方法,能够很好地描述人体的边缘,文献[50]先提取出运动目标区域中的HOG特征作为描述符,再利用数据分析方法(principal component analysis, PCA)在HOG特征维度高处进行降维,因此得到HOG-PCA特征,为了更好地进行行人检测,文献[51]则是将基于PCA算法的特征与基于经典的字典训练算法K-SVD的稀疏表示特征直接结合起来,在静态图像中快速实现行人检测,其中K-SVD是K-means的扩展形式,实验结果表明,该方法是一种有效的行人检测方法。由于单一特征的信息不全面,文献[52]和文献[53]提出了基于HOG与LBP特征结合的检测方法,将分别获得的HOG特征向量和LBP特征向量进行合成,SVM再对新特征向量进行训练和测试,结果表明该方法克服了单一特征的不足。

综上所述,基于感兴趣区域(ROI)的行人检测技术虽可以缩减计算、提高检测效率,但需要与分类器、CNN训练模型结合实验,具有一定的局限性;基于梯度方向直方图(HOG特征)的行人检测技术可以很好地描述人体边缘,但要具体检测行人须与PCA,LBP等特征算法相结合;基于卷积神经网络(CNN)的行人检测技术是最先进的,而多光谱行人检测是计算机视觉应用中的一项重要功能,研究者证明CNN与它相结合会事半功倍,总的来说基于卷积神经网络(CNN)的方法可以得到精确的行人信息。

2.4交通标志检测技术

交通标志为智能交通系统(intelligent transportation systems, ITS)的运行提供了指向能力,文献[54]、文献[55]中实现了基于图像预处理和交通标志定位算法的检测技术,在提高交通标志检测效率的同时,交通运行速率也会提升,降低交通事故率。

2.4.1基于卷积神经网络的检测方法

文献[56]提出了一种训练有素基于全卷积网络(fully convolutional networks, FCN)的方法,可产生多个判别候选对象,有助于检测系统快速、准确地完成作业。文献[57]在Faster-RCNN中引入了一个AN(attention network)进行寻找潜在的感兴趣区域,并根据交通标志的颜色特征将其大致分类,供车辆做出选择,文献[58]发现Faster-RCNN与Inception Resnet V2网络模型结合应用可快速识别出最佳目标区域,提高检测效率。在考虑交通标志牌表面特性和图案属性下,文献[59]则是在图像色彩(hue saturation value,HSV)的灰度图上提取交通标志候选区域,然后通过CNN提取特征选择出合适的交通标志区域,此方法能够准确识别和确定交通标志和非交通标志区域。

2.4.2基于区域的检测方法

文献[60]给出基于区域颜色快速分割的检测方法,基于颜色空间(hue saturation intensity, HSI),结合阈值处理,按颜色进行分层得到图像中含有交通标志的ROI,用形态学识别区域形状,最后进行内容的图像检索[61],实验结果显示,其检测的准确率在90%以上,但对白色交通标志的检测有很大缺陷。文献[62]通过创建矩形框标记标识所处的ROI,用这些区域的数据判断不同类别交通标志的位置,但精度和优化方面都不好,实验结果表明若为感兴趣区域添加更多的过滤会是一个很大的改进。

2.4.3基于图像处理的检测方法

文献[63]中对图像预处理后提取感兴趣区域,进而再对交通标志进行检测和识别,此方法提高了检测效率。文献[64]中经Hough变换利用点与线的对偶性[65],将原始图像中检测曲线的问题转换为寻找空间参数的峰值问题,经过线段检测、形状测量,计算面积比和周长比等数据信息后,与原数据库模板进行比对,以此来实现对交通标志的智能识别,该方法可实现对不同交通标志的准确检测和识别。

综上所述,基于区域的检测方法需要考虑交通标志的颜色,具有一定的局限性;基于图像处理的检测方法是计算ROI中交通标志的数据信息,与原数据库对比直接选择出交通标志,不需要考虑交通标志的颜色问题;基于卷积神经网络(CNN)的检测方法是应用最广泛的,可识别出交通标志和非交通标志区域,提高检测效率,其中Faster R-CNN 的表现最佳。

3结语

本文主要介绍了以检测对象为目标的环境视觉感知关键技术,并对各个关键技术子技术的优点和不足之处进行了归纳总结和分析。总而言之,现阶段智能车环境视觉感知技术的研究已经取得了一定的成果,但智能车在行驶过程中的视觉感知系统需要对技术、算法、硬件等进行持续的完善和升级,且距离实际的应用还有一定的距离。对于智能车的环境视觉感知领域涉及众多先进技术,尚需不断地进行探索与创新。面对新的挑战和领域,环境视觉感知技术的新发展趋势如下。

1)不能仅局限于一种特征的探索,基于多特征融合的环境视觉感知技术会更好地描绘出物体的参数和属性,大大提高精确度,因此新技术的发展应该趋向于融合。目前,这样的新方法已有一些成果,例如:文獻[66]提出了在基于卷积神经网络中引入通道金字塔特征和跨通道信息融合思想,解决了光照、天气等影响,丰富了行人特征,提高了检测效率。

2)复杂环境下应采用多种环境感知技术融合的方法,以弥补误差和提高精度,更真实地反映出环境信息,真正做到像人一样敏感,提高驾驶安全。例如:基于视觉-激光数据融合的检测方法[67],在视觉局限性的情况下,激光雷达弥补了其短板,可以更好地检测出微小物体,为无人驾驶车辆的自主轨迹规划与导航提供了一种精确的道路边界模型。

3)图像处理可以应用三维图像。三维图像层次分明,可模拟人眼反映真实信息,而不是仅局限于静止状态,可以显著提高检测效果。例如:文中提到的基于逆透视变换的车道检测技术,车辆上下坡时其算法需要进一步分析,而立体视觉可以克服这一点;文献[68]提出基于双目视觉感知的无参考三维图像视觉质量评价,即在预测生成三维图像上,利用双通道卷积神经网络模型来模拟人类视觉系统具有一定的效果。

4)由于卷积神经网络(CNN)的泛化能力优于其他方法,可以避免复杂特征提取和数据重建过程[69],因此图像处理时可以采用改进的卷积神经网络(CNN)方法来提高检测效率。例如:文献[70]提出基于卷积神经网络(CNN)的全局车道线检测算法研究,在弯道、车道线模糊、光线昏暗下具有鲁棒性和实时性;文献[71]提出基于Faster R-CNN深度学习框架的交通标志检测方法,解决了光照、遮挡、模糊下的交通标志,检测效率高。

参考文献/References:

[1]阎岩, 唐振民. UGV 协同系统研究进展[J]. 计算机应用究, 2011, 28(10): 3623-3628.

YAN Yan, TANG Zhenmin. Advances in unmanned ground vehicles coordination system[J]. Application Research of Computer, 2011, 28(10): 3623-3628.

[2]王世峰, 戴祥, 徐宁, 等. 无人驾驶汽车环境感知技术综述[J].长春理工大学学报(自然科学版), 2017, 40(1): 1-6.

WANG Shifeng, DAI Xiang, XU Ning, et al. Overview of environmental perception technology for unmanned ground vehicle[J]. Journal of Changchun University of Science and Technology(Natural Science Edition), 2017, 40(1): 1-6.

[3]刘严岩, 王进, 冒蓉. 无人地面车辆的环境感知技术[J].太赫兹科学与电子信息学报, 2015, 13(5): 810-815.

LIU Yanyan,WANG Jin, MAO Rong. Environment perception awareness technology for unmanned ground vehicles[J]. Journal of Terahertz Science and Electronic Information Technology, 2015, 13(5): 810-815.

[4]WANG Yue, SHEN Dinggang, TEOH E K. Lane detection using spline model [J]. Pattern Recognition Letters, 2003, 24(2): 2301-2313.

[5]胡房武. 基于图像采集的智能车系统设计[D].大连: 大连海事大学, 2011.

HU Fangwu. Design of Intelligent Vehicle System based on Image Acquisition[D]. Dalian: Dalian Maritime University, 2011.

[6]王春阳. 车道检测方法综述[J]. 科技视界, 2016(9): 322-324.

WANG Chunyang. Review of lane detection[J]. Science & Technology Vision, 2016(9): 322.

[7]XU H, WANG X, HUANG H, et al. A fast and stable lane detection method based on b-spline curve[C]// IEEE International Conference on Computer-aided Industrial Design & Conceptual Design. Wenzhou: IEEE, 2010: 1036-1040.

[8]KIM Z W . Robust lane detection and tracking in challenging scenarios[J]. IEEE Transactions on Intelligent Transportation Systems, 2008, 9(1):16-26.

[9]NIU Jianwei, LU Jie, XU Mingliang, et al. Robust lane detection using two-stage feature extraction with curve fitting[J]. Pattern Recognition, 2016, 10(59): 225-233.

[10]石林軍, 余粟. 基于多约束条件下的霍夫变换车道线检测方法[J]. 计算机测量与控制, 2018, 26(9): 9-12.

SHI Linjun, YU Su. Hough transform lane detection based on multiple constrains[J]. Computer Measurement and Control, 2018, 26(9): 9-12.

[11]YUAN J, TANG S, PAN X, et al. A robust vanishing point estimation method for lane detection[C]// Control Conference. Nanjing: IEEE, 2014:4887-4893.

[12]SAHAR M, MAJID S. Design and FPGA implementation of dual-stage lane detection, based on Hough transform and localized stripe features[J]. Microprocessors and Microsystems, 2019, 64(2): 12-22.

[13]方睿. 基于视觉的车道线检测技术综述[J]. 内江科技, 2018, 39(7): 41-42.

[14]沈超. 微缩智能车及其视觉感知关键技术研究[D]. 西安: 长安大学, 2016.

SHEN Chao.Research on Microscale Intelligent Vehicle and Its Key Technologies of Visual Perception [D]. Xian: Changan University, 2016.

[15]LU H M, LI Y J, UEMURA T, et al. Filtering deep convolutional network for marine organism classification[J]. Multimedia Tools and Applications, 2017(2): 1-14.

[16]KIM J,KIM J, JANG G, et al. Fast learning method for convolutional neural networks using extreme learning machine and its application to lane detection[J]. Neural Networks, 2017, 3(87): 109-121.

[17] TIAN Y, GELEMTER J, WANG X, et al. Lane marking detection via deep convolutional neural network[J]. Neurocomputing, 2018, 280(3): 46-55.

[18]GENG Lei, SUN Jiangdong, XIAO Zhitao, et al. Combining CNN and MRF for road detection[J]. Computers & Electrical Engineering, 2018, 70(8): 895-903.

[19]洪名佳, 汪慧蘭, 黄娜君, 等. 一种基于FCN的车道线检测算法[J].无线电通信技术, 2018, 44(6): 587-592.

HONG Mingjia, WANG Huilan, HUANG Najun, et al.A lane detection algorithm based on FCN [J]. Radio Communication Technology, 2018, 44(6): 587-592.

[20]施泽浩, 赵启军. 基于全卷积网络的目标检测算法[J]. 计算机技术与发展, 2018, 28(5): 55-58.

SHI Zehao, ZHAO Qijun. Object detection algorithm based on fully convolutional neural network [J]. Computer Technology and Development, 2018, 28(5): 55-58.

[21]LAFFERTYJ D, MCCALLUM A, PEREIRAF C N. Conditional random fields: Probabilistic models for segmenting and labeling sequence data[J]. Proceedings of Icml, 2001, 3(2):282-289.

[22]侯利龙, 李让军. 基于改进蚁群算法的道路图像分割算法研究[J]. 决策探索(中), 2018, 9: 92-93.

[23]柳丹, 郭忠, 张树丽. 基于无人机航路规划问题的蚁群算法综述[J]. 汽车实用技术, 2018, 1: 111-112.

LIU Dan, GUO Zhong, ZHANG Shuli. The review of ant colony algorithm based on UAV route planning [J]. Automobile Applied Technology, 2018, 1:111-112.

[24]郎咸朋, 朱枫, 都颖明,等. 基于积分图像的快速二维 Otsu 算法[J]. 仪器仪表学报, 2009, 30(1): 40-41.

LANG Xianpeng, ZHU Feng, DU Yingming,et al. Fast two-dimensional Otsu algorithm based on integral image [J].Chinese Journal of Scientific Instrument, 2009,30(1):40-41.

[25]MEHDI M, JALAL A, SHIRIN M, et al. Integrating fuzzy object based image analysis and ant colony optimization for road extraction from remotely sensed images[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2018, 138(4): 151-163.

[26]JALAL A. Road Identification from Satellite Images based on a Fuzzy Reasoning Model[D].Tehran:University of Tehran,2002.

[27]GROTE A, HEIPKE C, ROTTENSTEINER F. Road network extraction in suburban areas[J]. Photogram, 2012, 137(27): 8-28.

[28]ZHANGY, ZHANG J, LI T. Road extraction and intersection detection based on tensor voting[J]. IEEE, International Geoscience and Remote Sensing Symposium (IGARSS), 2016: 1587-1590.

[29]HADAVANDA, SAADATSERESHT M, HOMAYOUNI S. Segmentation parameter selection for object-based Land-cover mapping from ultra high resolution spectral and elevation data[J]. Int Remote Sens, 2017, 38 (12): 3586-3607.

[30]YANG Zi, LILIAN S C, CHENG P. Vehicle Detection in transportation systems and its applications under varying environments: A review[J]. Image and Vision Computing, 2018, 69: 143-154.

[31]JEON D, DONG Q, KIM Y, et al. A 23-MW face recognition processor with mostly-read 5 T memory in 40-NM CMOS[J]. IEEE Solid-State Circuits, 2017, 52(6): 1628-1642.

[32]MU Kenan, HUI Fei, ZHAO Xiangmo, et al. Multiscale edge fusion for vehicle detection based on difference of Gaussian[J]. Optik, 2016, 127(11): 4794-4798.

[33]DALAL N, TRIGGS B. Histograms of oriented gradients for human detection[J]. IEEE CVPR, 2005, 1: 886-893.

[34]YAO S, WANG T, SHEN W, et al. A novel combination feature HOG-LSS for pedestrian detection[C]// Emerging Intelligent Computing Technology and Applications. Berlin: Springer, 2013: 177-181.

[35]HU Jiangsheng. Body Detection based on Adaboost and SVM[D]. Wuhan: South-Central University for Nationalities, 2011.

[36]WEI Yun, TIAN Qing, GUO Jianhua, et al. Multi-vehicle detection algorithm through combining Harr and HOG features[J]. Mathematics and Computers in Simulation, 2019, 155(1): 130-145.

[37]ZHOU Y,LIU L,SHAO L,et al. A unified framework for fast vehicle detection and annotation[J]. European Conference on Computer Vision, 2016, 10:278-293.

[38]梁敏健. 智能車行车环境视觉感知关键技术研究[D]. 西安:长安大学, 2017.

LIANG Minjian. Research on Key Technologies of Visual Perception of Driving Environment of Intelligent Vehicles [D]. Xian: Changan University, 2017.

[39]ASVADI A, GARROTE L, PREMEVIDA C, et al. Multimodal vehicle detection: Fusing 3D-LIDAR and color camera data[J]. Pattern Recognition Letters, 2018, 115:20-29.

[40]SRAVANM S,NATARAJIAN S, KRISHNA E S, et al. Fast and accurate on-road vehicle detectionbased on color intensity segregation[J]. Procedia Computer Science,2018,133: 594-603.

[41]ANANDHALLI M, BALIGAR V P. A novel approach in real-time vehicle detection and tracking using raspberry Pi[J]. Alexandria Engineering Journal, 2018, 57(3): 1597-1607.

[42]HALIDOU A, YOU X, HAMIDINE M, et al. Fast pedestrian detection based on region of interest and multi-block local binary pattern descriptors[J]. Computers & Electrical Engineering, 2014, 40(8): 375-389.

[43]靳培飛, 周莉, 刘建,等.基于支持向量机提取感兴趣区域的行人检测[J]. 计算机工程与设计, 2017, 38(4): 1098-1102.

JIN Peifei, ZHOU Li, LIU Jian, et al. Pedestrian detection based on region of interest extracted by support vector machine[J]. Computer Engineering and Design, 2017, 38(4): 1098-1102.

[44]应光林. 基于双目视觉感兴趣区域的行人检测[J]. 信息通信, 2018(3): 48-50.

[45]SHI W J,BLAWIEH M B,LI X. Algorithm and hardware implementation for visual perception system in autonomous vehicle: A survey[J]. Integration Volume, 2017, 59: 148-156.

[46]REDMON J,FARHADI A YOLO9000:Better,faster,stronger[C]//Conference on Computer Vision and Pattern Recognition.Honolulu:IEEE,2017:6517-6525.

[47]HOU Yali, SONG Yaoyao, HAO Xiaoli. Multispectral pedestrian detection based on deep convolutional neural networks[C]//Infrared Physics & Technology.Seoul:IEEE, 2018, 94: 69-77.

[48]CHOIE J, PARK D J. Human detection using image fusion of thermal and visible image with new joint bilateral filter[C]// International Conference on Computer Sciences and Convergence Information Technology.Seoul:IEEE, 2010: 882-885.

[49]CAO Yanpeng, GUAN Dayan, HUANG Weilin, et al. Pedestrian detection with unsupervised multispectral feature learning using deep neural networks[J]. Information Fusion, 2019, 46(3): 206-217.

[50]刘文振. 基于HOG特征的行人检测系统的研究[D]. 南京:南京邮电大学, 2016.

LIU Wenzhen. Research on HOG-based Pedestrian Detection System [D]. Nanjing: Nanjing University of Posts and Telecommunications, 2016.

[51]ZHENG Chunhou, PEI Wenjuan,YAN Qing, et al. Pedestrian Detection based on Gradient and Texture Feature Integration[J]. Neurocomputing, 2017, 228(8): 71-78.

[52]PEI W J, ZHANG Y L, ZHANG Y, et al. Pedestrian detection based on HOG and LBP[M]. [S.l]:Springer International Pablishing, 2014.

[53]闫敬文, 江志东, 刘蕾. 基于HOG -多尺度LBP特征的人脸性别识别[J]. 扬州大学学报(自然科学版), 2016, 19(3): 58-62.

YAN Jingwei,JIANG Zhidong,LIU Lei,et al.Face gencler recognition based on HOG and LBP feature[J].Journal of Yangzhou Univeristy(Natural Science Edition),2016,19(3):58-62.

[54]FURSOV V, BIBKOV S,YAKIMOV P. Localization of objects contours with different scales in images using Hough transform[J]. Computer Optics, 2013, 37(4): 502-508.

[55]YAKIMOV P. Tracking traffic signs in video sequences based on a vehicle velocity[J]. Computer Optics, 2015, 39(5): 795-800.

[56]ZHU Yingying, ZHANG Chengquan, ZHOU Duoyou, et al. Traffic sign detection and recognition using fully convolutional network guided proposals[J]. Neurocomputing, 2016, 214(19): 758-766.

[57]YANG Tingting, LONG Xiang, ARUN K S, et al. Deep detection network for real-life traffic sign in vehicular networks[J]. Computer Networks, 2018, 136(8): 95-104.

[58]ARCOS G , LVAREZ G J A, SORIA M L M. Evaluation of deep neural networks for traffic sign detection systems[J]. Neurocomputing, 2018, 316(17): 332-344.

[59]王方石, 王堅, 李兵, 等. 基于深度属性学习的交通标志检测[J]. 吉林大学学报(工学版), 2018, 48(1): 319-329.

WANG Fangshi, WANG Jian, LI Bing, et al. Deep attribute learning based traffic sign detection [J]. Journal of Jilin University(Engineering and Technology Edition), 2018, 48(1): 319-329.

[60]金旭晖. 基于区域颜色分割的交通标志检测和识别[J]. 电气自动化, 2016, 38(3): 14-16.

JIN Xuhui. Traffic sign detection and recognition by block-based color segmentation [J]. Electrical Automation, 2016, 38(3): 14-16.

[61]张华伟, 孙劲光. 基于颜色与形状图像检索的研究[J]. 计算机仿真, 2009, 26( 11): 207-210.

ZHANG Huawei, SUN Jinguang. A research of image retrieval based on color and shape [J]. Computer Simulation, 2009, 26(11): 207-210.

[62]KRYVINSKA N,PONISIEWSKA M A,GREGUS M. an approach towards service building for road traffic signs detection and recognition[J]. Procedia Computer Science, 2018, 141: 64-71.

[63]孙小霞. 基于视频图像的道路交通标志检测与识别[D]. 武汉:华中科技大学, 2015.

SUN Xiaoxia. Detection and Recognition of Road Traffic Signs based on Video Image [D]. Wuhan: Huazhong University of Science and Technology, 2015.

[64]赵玉伟. 基于图像处理的道路交通标志检测与识别方法[J]. 交通世界, 2018, 3(9): 42-43.

[65]滕今朝, 邱杰. 利用Hough变换实现直线的快速精确检测[J]. 中国图象图形学报, 2008, 13(2): 234-237.

TENG Jinchao, QIU Jie.Fas tand precise detection of straight lines with Hough transform[J]. Journal of Image and Graphics, 2008, 13(2): 234-237.

[66]孙玲. 基于卷积神经网络的行人与车辆检测方法研究[D]. 成都:电子科技大学, 2018.

SUN Ling. Research on Pedestrian and Vehicle Detection Methods based on Convolutional Neural Network [D].Chengdu: University of Electronic Science and Technology, 2018.

[67]LIU Yisha, XU Wenhao. DOBAIA A M, et al. Autonomous road detection and modeling for UGVs using vision-laser data fusion[J]. Neurocomputing, 2017, 275:2752-2761.

[68]鄢杰斌. 基于双目视觉感知的无参考三维图像视觉质量评价[D]. 南昌:江西财经大学,2018.

YAN Binjie. Visual Quality Evaluation of Unreferenced 3d Images Based on Binocular Visual Perception[D]. Nanchang: Jiangxi Univer-sity of Finance and Economics, 2018.

[69]陈兵旗. 机器视觉技术[M]. 北京: 化学工业出版社, 2018.

[70]景辉. 基于卷积神经网络的全局车道线检测算法研究[D]. 北京:北京交通大学, 2018.

JING Hui. Research on Global Lane Line Detection Algorithm based on Convolutional Neural Network[D]. Beijing: Beijing Jiaotong University, 2018.

[71]武林秀, 李厚杰, 贺建军, 等. 基于深度学习的交通标志检测方法研究[J]. 大连民族大学学报, 2018, 20(5): 460-463.

WU Linxiu, LI Wujie, HE Jianjun, et al. Research on traffic sign detection method based on deep learning[J]. Journal of Dalian Minzu University, 2018, 20(5): 460-463.