基于强定位与三点手眼标定的目标移载视觉引导算法*

2017-09-08张善文

杜 刚,张善文

(西京学院 信息工程学院,陕西 长安 710123)

基于强定位与三点手眼标定的目标移载视觉引导算法*

杜 刚,张善文

(西京学院 信息工程学院,陕西 长安 710123)

为了解决当前定位算法受目标背景干扰影响大,且其采用的物理接触标定技术易损伤工件表面的不足,提出了基于强定位与三点手眼标定的视觉引导算法。首先,利用高斯滤波处理Hessian矩阵,采用非极大值抑制法来确定特征点和方向,从而构造了surf特征点描述子,完成目标位置边缘和中心点的强定位,达到去除背景和环境光干扰,精确定位目标中心点与角度。然后提出三点标定法,计算缩放旋转矩阵和平移矩阵参数,完成Robot世界坐标与相机图像坐标的绑定映射。最后,编程实现算法和系统,实验测试结果显示:与当前工件材料移载系统相比,文中系统拥有更高的目标定位与标定移载成功率。

视觉引导;强定位;三点手眼标定;缩放旋转矩阵

0 引言

随着“智能制造”、“中国制造2025”的概念升华与深化发展,在未来人力成本不断升高的大背景下,企业已经认识到利用先进的信息技术,实现工业无人化制造的必然趋势[1-2]。制造流水线中有大量移载工作,以往采用人力,现在随着机器人应用的推广,很多企业开始使用机器人完成移载工作[3-4]。但是随着应用的深入,也出现了问题,比如机器人需要依赖物理定位块完成对产品的抓取和移载,而物理挡块的夹取容易导致材料损伤。因此已经有厂家开始基于视觉完成机器人移载工作,但也出现了两个需要解决的问题:①制造环境目标背景复杂和光照干扰,影响视觉目标定位。②精确计算机器人世界坐标与相机图像坐标的关系映射,即手眼标定。

在视觉定位与标定方面,国内研究人员已经将计算机视觉技术引入到该领域中,对其展开研究,如胡明星[5]提出了基于Canny检测与SIFT特征的旋转工件目标识别算法。首先,对采集工件图像的RGB三通道完成权重分配,获取灰度化图像;并利用Canny边缘检测和霍夫直线检测处理灰度图像,计算出工件旋转角度;并基于几何变换,定义图像校正模型,消除工件旋转角度,对其完成复位处理,并采用模板匹配在图像中定位工件,达到定位标定目的。但是,此技术依靠准确的轮廓抓取,在复杂背景影响边缘捕捉时,往往影响了视觉定位。杜刚[6]提出了基于计算机在机器人单目视觉系统中的广泛应用,主要集中在对摄像机定位,拍摄图像的分割计算,模式的坐标识别,探测目标距离,将视觉系统应用到机器人中的运用与分析,达到了视觉定位标定目的。然而,这种技术依赖大量模式经验,在相机与机器人相对位置不可预知时,往往不能准确绑定机器人与相机坐标系。

综上所述,为了提高智能机器人基于视觉定位与标定完成材料移载能力,本文提出了基于强定位算子与手眼标定的视觉引导系统,并编程实现算法,验证本文系统功能。

1 本文目标移载视觉引导算法

本文提出的视觉引导技术过程见图1。该方法首先对复杂背景和环境光干扰下的目标图像进行强定位处理,继而得到目标中心点与角度,通过三点手眼标定法,绑定机器人坐标与图像坐标,完成手眼标定,把计算得到的图像目标坐标转换为机器人世界坐标。机器人根据计算得到的坐标,抓取目标材料,完成移载工作。

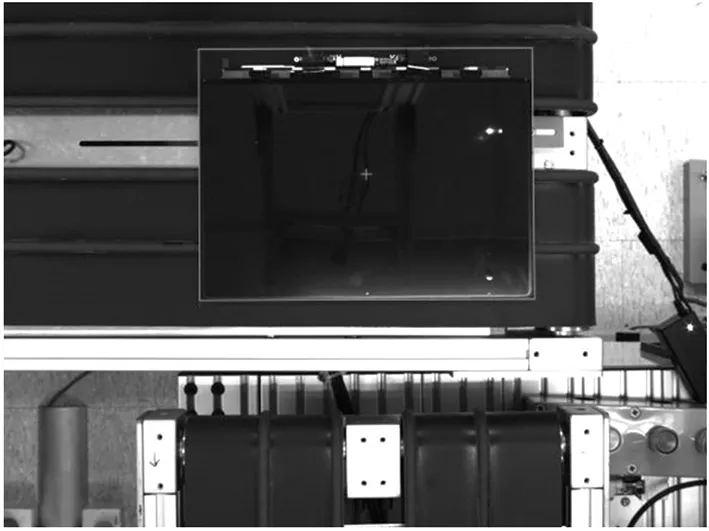

材料目标与背景如图2所示,可见环境光照的反光严重、图像背景复杂,对目标视觉定位与标定的影响较大。

图1 本文目标移载视觉引导机制

图2 待定位图像

1.1 基于Surf的工件强定位

工业制造环境对目标定位的干扰来源两个方面:环境光照射带来的反光干扰、复杂背景带来的目标边缘定位困难。针对此问题,提出基于Surf特征[7-8](Speed Up Robust Feature)的强定位机制,见图3。为了分析每个像素点本身与周边特性,首先建立Surf的基础数据,计算每个像素点的Hessian矩阵[9]行列式:

(1)

式中,(x,y)代表图像中任一像素点,f(x,y)为图像坐标(x,y)的灰度值,Hessian矩阵H由函数、偏导数组成,求H矩阵判别式为:

(2)

其中,det的值是H矩阵的特征值,可以利用判定结果的符号将所有点分类,根据判别式取值正负,来判别该点是或不是极值点。

二阶标准高斯函数作为滤波器,卷积计算二阶偏导数,计算H矩阵的三元素Lxx,Lxy,Lyy来估算H矩阵:

(3)

为了达到特征点与尺度无关的目的,对hessian矩阵进行高斯滤波:

L(x,t)=G(t)·f(x,t)

(4)

其中,L(x,t)表示不同解析度下的图像表示,可以利用高斯核G(t)与图像函数f(x) 在点x的卷积来实现[10],其中高斯核G(t):

(5)

其中,g(x)为高斯函数,t为高斯方差。

通过上述过程,可以为图像中每个像素计算出其H行列式的特征值。得到hessian矩阵值后,开始定位特征点:

(1)利用非极大值抑制[11-12]初步确定特征点。得到hessian矩阵处理过的每个像素点与其3维领域的26个点进行大小比较,如果它是这26个点中的最大值或者最小值,则保留下来,当作特征点。

(2)选取特征点的主方向。统计特征点领域内的水平haar小波特征和垂直haar小波特征的总和,作为该特征点的主方向。

(3)构造surf特征点描述算子。在特征点周围取一个带方向的正方形框。

(4)从特征点中选取目标最小外接矩形的四个顶角,计算得到目标中心点与倾斜角度。

图3 强定位过程

普通定位算法的边缘定位性能易受到复杂背景干扰和环境光反射干扰,而本文的强定位算法,基于高斯hessian矩阵和surf特征点寻找,克服了以上干扰,完成精确定位。如图4a所示,特征点如图标注;如图4b所示,可见本文强定位机制能够准确定位目标材料的轮廓;如图4c所示,可见本文强定位算法准确的定位旋转目标材料的轮廓。

(a)特征点

(b)定位成功

(c)旋转目标定位成功图4 基于surf特征的强定位结果

1.2 三点手眼标定过程

得到目标中心点与角度后,需要把相机图像坐标转换为Robot世界坐标,这个过程即手眼标定[13],以便Robot准确抓取目标,补偿旋转角度,完成移载作业,其过程见图5。手眼标定的目的是绑定相机图像坐标与Robot世界坐标,找出映射关系,核心是计算缩放旋转矩阵、平移矩阵,如下式所示:

(6)

式中,R为缩放旋转矩阵,a、b、a′、b′为缩放旋转矩阵参数元素。接着介绍平移矩阵:

(7)

式中,M为平移矩阵,c、c′为平移矩阵参数元素。联立缩放旋转矩阵、平移矩阵、图像坐标和Robot坐标:

(8)

(x,y)表示图像坐标,(x′,y′)代表机器人坐标,该式分解如下:

(9)

式中,a、b、c、a′、b′、c′为所求参数,接着进行行列式化:

(10)

根据式(10)中的a、b、c、a′、b′、c′构成旋转缩放平移矩阵。操作机器人在不同直线上走3个点,并记录对应Robot坐标和图像坐标,然后代入式(10),可得:

(11)

(12)

然后对式(11)、式(12)进行行列式化:

(13)

(14)

根据式(13)、式(14)进行行列式计算,得到a、b、c、a′、b′、c′,从而构成旋转缩放平移矩阵。

图5 标定算法流程

2 实验与讨论

为了体现本文算法的优势,将当前标定性能较好的技术—文献[3]、文献[4]设为对照组,本文系统基于VS2010平台开发实现,算法实验参数如:缩放旋转矩阵为[321,435,-463,-431]、平移矩阵为[435,-463]。

本文开发的工件标定系统界面如图6,具有视觉定位、坐标计算功能。采用强定位和三点标定技术处理图6中左上角的原图,首先利用深化hessian矩阵寻找特征点,在此基础上,用强定位技术得到图像坐标中心点和角度。然后采用机器人走三点完成手眼标定,最终实现对材料的自动准确移载。如图7所示,本文开发的系统准确定位移载目标材料,同时用绿色标注出材料轮廓。而利用文献[3]技术处理图6左上角的原图时,由于此技术依靠准确的轮廓抓取,在背景复杂和环境光干扰严重时,往往影响视觉定位标定功能,如图8所示, 以绿色标注,可见,该技术存在明显的定位偏差,影响移载工作的完成。同时,利用文献[4]技术处理图6左上角的原图时,由于依赖大量固定样本,在机器人与相机相对关系未知且多变时,往往不能精确完成标定,同时缺乏定位精细度,如图9所示, 绿色标注,可见,这种算法存在明显的定位偏差,降低了工作的移载精度。原因是本文算法充分利用了hessian矩阵与高斯滤波的尺度旋转无关性,精确定位工件的特征角点,并引入最大值抑制技术,去除伪特征点,得到工件的surf特征点,有效提高了特征点的鲁棒性,根据提纯之后的特征点,可准确计算出工件中心坐标,实现复杂背景下工件的强定位。而且,本文算法的过机器人在相机视野中走三个点(不在同一条直线上),记录图像与机器人坐标,以计算出缩放、旋转参数,达到图像坐标与世界坐标的转换绑定,使得算法对工件位置变化具有良好的鲁棒性,从而实现工件准确抓取。而文献[3]是依靠普通的边缘检测算子来获取目标轮廓,对低对比度与噪声干扰的复杂背景干扰较为敏感,致使其可用的边缘信息不完整,并且该算法是主要是依靠工件、相机和机器人的相对位置关系来实现,导致其定位不准确,最终使其对工件的移载精度较低。文献[4]通过利用中值滤波算子与直方图特性,联合大量的固定样本进行工件定位与抓取,虽然该技术可以消除噪声干扰,但是在光照条件不佳时,采集到的工件图像直方图信息存在丢失,且其是利用多模式坐标转换来实现工件标定,在实际工件移载过程中,工件、相机以及机器人的位置是动态变化的,从而导致其移载存在偏差。

图6 工件移载视觉引导系统的界面

图7 本文视觉引导技术的工件定位结果

图8 文献[3]定位标定结果

图9 文献[4]定位标定结果

3 结论

为了解决前目标定位算法受复杂背景和环境光干扰严重、标定困难的问题,本文提出了基于强定位与手眼标定的视觉引导系统。实现对图像hessian矩阵深化建立、特征点计算、目标图像中心点计算。然后分析三点标定法,计算缩放旋转平移矩阵,完成图像坐标与机器人坐标的映射。实验结果表明:在背景光照干扰严重的情况下,相较普通技术,本文算法具有更强的鲁棒性,能够提取更加精确的鲁棒特征,以及更好地实现图像坐标与世界坐标的转换绑定来完成工件准确定位与移载,更能够适应光照条件不佳等复杂环境,表现出更低的定位误差与更强的抗干扰性。

[1] Adriana Giret, Emilia Garcia, Vicente Botti. An Engineering Framework for Service-Oriented Intelligent Manufacturing Systems[J]. Computers in Industry, 2016, 81(9): 116-127.

[2] 许杰. 基于改进加权质心和UKF的移动目标定位算法[J]. 吉林大学学报(工学版),2016, 46(4):1354-1359.

[3] 王林波. 基于手眼视觉的合作目标特征点精确定位算法研究[D]. 北京:中国科学院大学,2014.

[4] Wu Qian,Guan Haobing, Gu Jinan. Research on Image Preprocessing of Workpiece Recognition and Positioning System[J]. Journal of Convergence Information Technology, 2013, 8 (8): 187-193.

[5] 胡明星. 模板匹配优化耦合图像校正的旋转工件目标定位算法[J]. 组合机床与自动化加工技术,2016(6):35-38.

[6] 杜刚. 机器人双目视觉系统的标定与定位算法分析[J]. 信息系统工程,2016(2):39.

[7] WeiLong Zhang, LeiBo Liu, ShouYi Yin. An efficient VLSI architecture of speeded-up robust feature extraction for high resolution and high frame rate video[J]. Science China Information Sciences, 2013, 56 (7): 1-14.

[8] Hu Zhang Fang, Yang Lin, Luo Luan. The Research and Application of SURF Algorithm Based on Feature Point Selection Algorithm[J]. Sensors & Transducers, 2014, 169 (4): 67-72.

[9] Ying Wei, Rui Li, Jin-zhu Yang. An algorithm for segmentation of lung ROI by mean-shift clustering combined with multi-scale HESSIAN matrix dot filtering[J]. Journal of Central South University, 2012, 19 (12): 3500-3509.

[10] Zeping Wu, Donghui Wang, Patrick Okolo N. Unified estimate of Gaussian kernel width for surrogate models[J]. Neurocomputing, 2016, 203(26): 41-51.

[11] 陈金辉, 叶西宁. 行人检测中非极大值抑制算法的改进 [J]. 华东理工大学学报(自然科学版),2015, 41(3): 371-378.

[12] 王文涛, 朱顺安, 唐菀. 一种自适应非极大值抑制边缘检测算法及FPGA设计实现[J]. 小型微型计算机系统,2014, 35(8): 1926-1930.

[13] 胡小平, 左富勇, 谢珂. 微装配机器人手眼标定方法研究学标定[J]. 仪器仪表学报,2012, 33(7): 1521-1526.

(编辑 李秀敏)

Objects Vision Guiding System Based on Strong Positioning and Hand-eye Calibration

DU Gang,ZHANG Shan-wen

(College of Information Engineering, Xijing University, Chang′an Shaanxi 710123, China)

In order to solve the current localization algorithm big background interference affects calibration methods exist damage, physical contact with the workpiece material on the surface of the problem, hand-eye calibration was proposed based on strong orientation and three visual guidance systems. First, deepen the Hessian matrix, using Gaussian filter, using the maximum inhibition precisely determine the feature points and direction, in order to construct surf feature points description, finish strong positioning operator based on surf, to remove the background and the ambient light interference, the purpose of accurate positioning center of the target with Angle. And then put forward three points calibration method, calculation scale rotation matrix and translation matrix parameters, complete the Robot world coordinates and binding mapping camera image coordinates. Finally, program implementation algorithm and system, the experiment results showed that compared with the current workpiece material transfer system, this system has higher goal orientation and calibration transfer success rate.

visual guidance; location; three point calibration of hand eye; zoom rotation matrix

1001-2265(2017)08-0021-04

10.13462/j.cnki.mmtamt.2017.08.005

2017-02-10;

2017-03-14

国家自然科学基金(61473237);陕西省自然科学基础研究计划(2014JM2-6096)

杜刚(1980—),男,陕西武功人,西京学院讲师,硕士,研究方向为图像处理、计算机应用、信息安全与软件,(E-mail)Dugang1980elexj@163.com。

TH166;TG659

A