面向病理图像分割的边缘感知网络

2024-01-29黄鸿杨沂川王龙郑福建吴剑

黄鸿,杨沂川,王龙,郑福建,吴剑

(1 重庆大学 光电技术与系统教育部重点实验室,重庆 400044)

(2 重庆大学附属肿瘤医院 头颈肿瘤中心,重庆 400030)

0 引言

在临床诊断中,对病理图像中的病灶区域进行精确分割和定量评估能够为后续的病理分析提供有价值的信息,在理解、诊断和治疗疾病方面发挥了关键作用[1]。然而,传统的手动分割方法耗时耗力,并且严重依赖病理学家的经验[2]。因此,高效的病理图像自动分割方法就显得尤其重要。

传统的图像分割方法主要基于手工特征,包括阈值分割法、图割法和分水岭法等[3]。典型的阈值分割法有大津法[4],其主要原理是通过最大化类间方差来计算分割阈值,因其效率高而被广泛应用。分水岭算法[5]检测速度快且分割结果具有空间连续性,但该算法对噪声敏感且不适用于大区域分割。典型的图割法有Graphcut 法[6],其原理为利用图像纹理信息和边界信息先构建一张加权图,通过边权值的大小来筛选边,使划分的子图彼此尽量相互分离,从而实现分割的目的。该方法具有较好的泛化性,但对于相似目标分割能力差。上述传统图像分割方法主要适用于早期计算机辅助病理图像分割的研究中,过度依赖于手工特征的先验知识,而深层鉴别特征表达能力不足,导致其分割性能受限。

近年来,深度学习在自然图像处理任务中表现出了卓越的性能,并应用于生物医学图像分割。基于编码器-解码器结构的卷积神经网络(Convolutional Neural Network,CNN)因其可实现端到端的自动分割,在准确性以及效率方面相较于传统分割方法体现出明显优势[7]。U-Net[8]作为医学图像分割中广泛使用的编码器-解码器网络结构,其编码器捕获低级和高级特征,解码器利用上采样层恢复空间分辨率并通过跳跃连接实现特征融合来构建最终结果。该网络能够在病理图像数据缺乏的情况下完成图像分割任务,但由于跳跃连接导致了编码器与解码器之间的语义差距,限制了其分割性能。

为了克服上述限制,UNet++[9]在跳跃连接的过程中添加了一系列嵌套、密集的连接路径,以形成密集的编码-解码网络,并带有深监督实现对目标的分割。IBTEHAZ N 等[10]提出一种MultiResUNet,观察到编码器特征和解码器特征之间可能存在语义差距,通过引入具有残差结构的Res-Path 来改进跳跃连接,从而提升分割精度。OKTAY O 等[11]提出Attention U-Net对编码-解码块使用注意力门来突出特定局部区域的显著特征,同时抑制不相干区域。WANG J S 等[12]提出了一种基于乳腺癌组织微阵列样本高光谱图像的癌巢分割方法,该方法结合了U-Net神经网络和无监督主成分分析的优点,在减少模型计算量的同时,提高了目标分割精度。黄鸿等[13]将不同深度解码特征重新进行组合并实现深度特征融合,提升了深层特征在预测中的作用,改善了分割性能。ZHAO B C 等[14]提出具有渐进密集特征聚集的感知分割网络,通过提取病理图像的RGB 信息、染色信息以及分割位置信息,使网络学习到更多有用的特征,提高病理图像分割精度。但是上述网络仅改变网络结构以增强特征间的交互,忽略了大部分病理图像病灶区域聚集、细胞形态差异过小的特点。

为了解决上述问题,ZAMORA W 等[15]基于U-Net 网络框架,通过图像前景、背景和细胞核边缘的距离信息来提取分割目标的形态特征,将形态学特征与全卷积网络模型结合,实现细胞核实例分割,且细胞核分割精度明显优于U-Net。FANG Y 等[16]提出了一种具有面积和边界约束的选择性特征聚合网络用于息肉分割,考虑了区域和边界之间的相关性,并通过附加的边缘监督获得了良好的结果。FAN D P 等[17]提出具有前景背景区分注意力模块作为补充特征的PraNet,在分割结果的边缘细化上取得了较大的突破。CHEN S等[18]提出了一种多边形上下文感知网络,通过对目标像素点集进行采样获取每个点集的质心与区域边界构成的多边形特征,利用置信度加权模块融合输出特征,并引入了形状感知损失,在一定程度上解决了细胞核分布拥挤和边界模糊的问题,提高了预测分割精度。ACSNet[19]利用编码器分支的局部和全局上下文特征为每个解码步骤提供具有空间注意力的引导信息,使网络在医学图像分割结果上取得了进一步的提升。由于CNN 结构存在固有的归纳偏差,缺乏对图像远程依赖关系的学习理解,最近基于Transformer 结构的网络也逐渐应用于医学图像分割。TransUNet[20]同时具有Transformer 和U-Net 的优点,一方面将CNN 与Transformer 的自编码器结合作为医学图像分割任务的强编码器提取全局上下文信息,另一方面解码器将编码特征上采样并与高分辨率的CNN 特征图组合以提高定位精度,从而增强网络的分割性能。VALANARASU J 等[21]提出了一种门控轴线注意力模型来扩展现有的Transformer 模型,并提出LoGo 训练策略,能够更好的训练医学图像,提高了分割精度。WANG H 等[22]利用基于Transformer 的通道变换器替代U-Net 简单的跳跃连接,有效地将编码器多尺度信息交叉融合到解码器部分,分割精度明显优于U-Net。但上述深度学习方法仍存在以下两个问题:大多数网络更关注易于分割的区域,而忽略了分割困难的边缘像素点,限制了分割精度的提高;某些网络虽然提取了边缘信息作为补充,但并没有解决不同特征间语义层次不一致的问题,而利用通道注意力机制来弥补特征间语义差距的现有方法模型复杂度过高,在医学图像稀少的情况下网络模型拟合较慢。

针对上述问题,本文提出了基于边缘感知融合的病理图像分割网络(Boundary Perception Network,BPNet)。该网络基于经典的编码-解码结构,并构建了边缘感知模块(Boundary Perception Module,BPM)以及自适应通道注意力模块(Adaptive Shuffle Channel Attention Module,ASCAM)来提升网络性能。BPM使边界位置信息深度参与到网络训练的优化过程中,大幅提升了网络分割结果的精细程度。ASCAM 在增加极少参数量的情况下,自适应的捕捉了编码、边缘、解码三部分特征信息的交互关系,以弥补不同层次特征间的语义差距,捕获更复杂的通道相关性。此外,设计了边缘与结构的联合损失函数,以优化网络的目标定位和细节处理能力。与其他图像分割方法相比,本文方法在两个公共病理图像数据集上的实验结果都表现出更好的分割性能。

1 边缘感知网络

1.1 整体网络结构

针对病理图像病灶目标实例多、分布广以及边缘模糊的特性,本文提出了一种面向病理图像分割的边缘感知网络(BPNet),该模型基于编码器-解码器结构,网络结构如图1所示。其中,编码过程采用基于EfficientNet-B4 网络[23]的特征编码器。EfficientNet-B4 属于EfficientNet 系列的一部分,是一种高效的深度神经网络架构,它采用了复合缩放方法,即在网络的深度、宽度和分辨率三个维度上进行缩放,以实现高效的模型设计。本文通过EfficientNet-B4 网络的特征编码器进行卷积下采样,提取图像的特征信息,在保持网络性能的同时,显著减少了计算复杂性和参数量。解码器包括解码块、边缘感知模块以及自适应通道注意力模块。解码块进行反卷积操作完成特征信息的解码过程。边缘感知模块(BPM)对每层解码器的输出进行边缘提取,再将边缘信息叠加到编码特征上输出边缘感知增强特征。自适应通道注意力模块(ASCAM)在增加极少参数量的情况下,自适应的捕捉编码、边缘、解码三部分特征信息的交互关系,弥补不同层次特征间的语义差距,捕获更复杂的通道相关性,以更好地恢复目标对象的细粒度细节。在此基础上,通过采用联合损失函数对网络进行深监督约束,首先将不同深度的解码特征进行激活输出,分别计算各层的层级监督损失Ldsi,从解码器不同尺度优化隐藏层特征以获得更精确的分割结果;随后通过分割损失L1约束目标区域从而优化网络参数;同时,为了更大程度地提升边缘分割效果,训练过程中增加边缘损失约束Ledge。

图1 BPNet 整体网络结构Fig.1 The overall structure of the BPNet algorithm

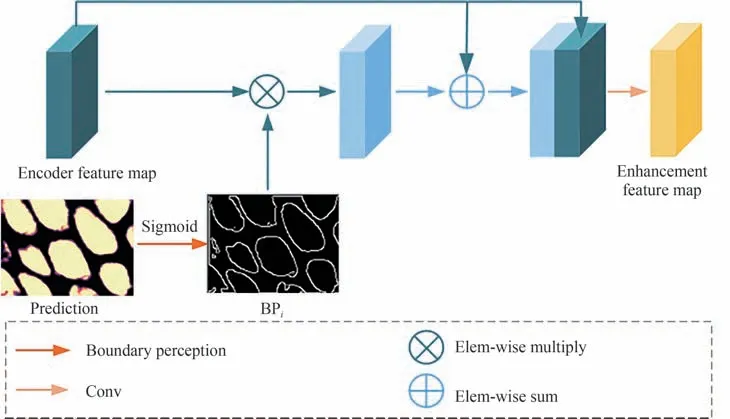

1.2 边缘感知模块

本文设计的边缘感知模块(BPMi)具体结构如图2所示。该模块是一种新型边缘注意力方式,通过关注不确定性更高和更复杂的边缘区域,以实现特征互补和预测结果精细化。

图2 边缘感知模块结构Fig.2 The structure of attention boundary perception module

1.3 自适应通道注意力

为了更好地融合编码器、解码器和边缘感知模块间语义不一致的特征,本文使用改进的自适应通道注意力模块(ASCAM),通过有效学习特征间的通道交互信息从而提高特征表达能力,该模块具体结构如图3所示。

图3 自适应通道注意力模块结构Fig.3 The structure of adaptive shuffle channel attention module

图4 GlaS 病理图像数据集Fig.4 The GlaS pathological image datasets

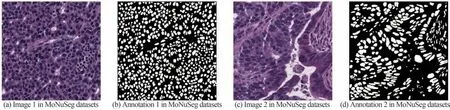

图5 MoNuSeg 细胞核数据集Fig.5 The MoNuSeg nuclei datasets

自适应通道注意力模块输入为第k层网络的编码器、解码器和边缘感知模块特征拼接得到的融合特征Xk∈RH×W×C。首先对融合特征进行通道重排,按顺序各取三个特征块的一个通道特征图依次排列组成新的特征块,其目的是使后续卷积操作在不使用大卷积核的情况下能有效捕获不同特征块之间的信息交互。通道重排后的特征RH×W×C作为通道注意力处理的输入。之后空间压缩由一个全局平均池化(Global Average Pooling,GAP)进行,产生特征向量G(x)∈R1×1×C

式中对输入特征Xk∈RH×W×C的C个通道的特征值分别求平均值,H,W分别为每个特征图的高度与宽度。

执行以上步骤后,通常采用一个多层感知器模块(Multiple Layer Perception,MLP)[24]计算通道权重系数。MLP 主要由两个全连接层(Fully Connected Layer,FC)构成,其中首个FC 的节点数通常利用降维操作降低模块的参数量,第二个FC 再将特征映射回特征空间。但这样的降维操作破坏了通道与权重参数之间一一对应的关系,进而影响最终的模型学习效果[25]。因此,本文提出的自适应通道注意力利用一维卷积捕获局部通道交互信息,显著降低通道注意力模块复杂度的同时兼顾了模块有效性。同时,为了最大程度地保证信息交互的通用性,需要确定相互作用的覆盖范围,即一维卷积核的尺寸。而网络不同层级的特征块中具有不同的通道数,需要通过人工调整优化卷积核大小。然而,通过手动调整核参数耗费大量计算资源,部分采用组卷积的改进模型证实,卷积操作的卷积核尺寸k与通道数量C之间存在正相关映射关系φ[26],且网络中通道数量通常为2 的指数,因此,将映射关系设置为如下所示的非线性映射关系

因此,给定通道数C,一维卷积核大小k可以自适应确定为

式中,|t|odd表示取t的绝对值相邻最近的奇数。本文中,γ的值设置为1,b设置为0。显然,通过非线性映射关系,高维通道的相互作用距离较长,而低维通道的相互作用距离较短,经计算自上往下的四个ASCAM 模块自适应卷积核数量分别为1、3、5、7。在此基础上,利用Sigmoid 函数进行激活得到通道注意力权值系数β∈[0,1]1×1×C。随后,将获得的通道注意力系数β与原始的输入映射Xk∈RH×W×C逐通道相乘,得到经过权值优化的层注意力融合特征。该模块可以有效地学习特征间的通道交互信息提高特征表达能力,与其他现有通道注意力相比,该方法以较低的模型复杂度获得了较好的性能。

1.4 联合损失函数

本文提出边缘与结构联合损失函数,以优化网络的目标定位和细节处理能力。该联合损失函数包括三部分:分割损失L1,层级监督损失Lds和边缘惩罚损失Ledge。其中,分割损失L1计算网络最终的分割预测结果与对应标签Mask 之间的损失,在保证网络鲁棒性的同时有效提升训练速度,提高目标分割精度;层级监督损失Lds计算不同深度的解码特征进行激活输出后的预测值与对应标签Mask 之间的损失,从解码器的不同尺度优化隐藏层特征以获得更精确的分割结果;边缘惩罚损失Ledge计算网络最终的分割预测结果边缘与对应标签Mask 边缘之间的损失(预测图像与标签的边缘均有Sobel 算子提取),进而有效利用目标的边缘信息,约束网络预测的边缘精度,提升对边缘的分割效果。该联合损失函数Lall表示为

式中,α,β,γ分别为损失的权重系数,α设置为2,β与γ均设置为1。

L1是二元交叉熵损失(Binary Cross Entropy,BCE)与Dice 损失的加权结果:L1=LBCE+LDice。

LBCE鲁棒性较好,但易受到医学图像类别不均衡的影响,定义为

LDice更关注目标区域,可以有效提升训练速度,提高目标分割效果,但稳定性较差,其表达式为

式中,y表示真实标注,̂表示预测结果。

Lds从解码器不同尺度优化隐藏层特征以获得更精确的分割结果,属于深监督损失,每一层的Lds与L1计算方式相同,均为二元交叉熵损失与Dice 损失的加权,定义为

式中,ydowni和Oi分别表示第i层下采样标签矩阵与第i层网络预测矩阵。

除了约束目标区域的L1与Lds损失外,本文引入了增强边缘精度的Ledge损失,在网络训练过程中实时优化分割边缘,该损失定义为预测结果边缘与标签边缘的二元交叉熵计算结果,具体可表示为

2 实验结果及分析

在整个实验中,实验硬件环境是基于PANYAO 7048GR 服务器,CPU 为正式版E5-2096 2.3G-3.6G 45M Cache22NM,内存为256G,六张NVIDIA GeForce TITAN RTX 显卡。软件环境是基于Ubuntu 系统的Tensorflow2.0 深度学习框架,CUDA 和CUDNN 的版本分别为10.1.243 和7.6.5,编程语言为Python3.8。

2.1 实验数据集

1)MICCAI 2015 腺体分割挑战赛数据集(GlaS)[27]。

GlaS 数据集病理图像采用苏木精和伊红(Hematoxylin Eosin,H&E)染色,并使用蔡司MIRAX MIDI 扫描仪对结直肠癌组织进行20 倍放大成像,原始图像大小不一,大多数为775×522 大小的RGB 图像。共包含85 张训练数据以及80 张测试数据。

2)MoNuSeg 细胞核数据集[28-29]。

MoNuSeg 数据集由40 倍放大下捕获的H&E 染色组织图像形成。该数据集包含患者和多个器官的图像,原始尺寸均为1 000×1 000。训练数据包含30 张图像,约22 000 个细胞核核边界注释。测试数据包含14 张图像,其中核边界标注超过7 000 个。

2.2 实验设置

两个实验数据集将训练数据按照训练集与测试集4∶1 划分。同时为了弥补训练数据不足造成过拟合,实验中对训练集数据进行了水平翻转、垂直翻转两种在线数据增强方式。为尽量保留训练图像细节和减少模型计算量,训练BPNet 网络时两个数据集中图像均缩放为512×512 尺寸作为输入。模型训练采用随机梯度下降(Stochastic Gradient Descent,SGD)作为模型优化器。训练初始学习率为0.01,训练epoch 总数设置为200,当验证精度超过15 个epoch 不增加时,则将学习率更改为当前学习率的0.5,最小学习率为0.000 5,当经过连续30 个epoch 验证精度没有提高时结束训练,批次大小统一设置为6。实验采用1.4 节描述的边缘与结构联合损失函数,为保证实验可靠性,实验最终结果取5 次重复实验平均值。

对于两个实验数据集,均采取Dice 系数、交并比系数(Intersection over Union,IoU)、准确率(Accuracy,ACC)和精确率(Precision,PRE)四个评价指标。

式中,y表示标签,ŷ表示预测结果,TP、FP、TN、FN 分别表示为真阳性、假阳性、真阴性、假阴性的对应像素预测结果,其中最终的预测结果为模型预测结果以0.5 为阈值进行二值化后得出。

2.3 GlaS 数据集实验结果

2.3.1 BPNet 算法和经典算法对比

为验证BPNet 网络整体分割性能,将其与其他先进的方法进行对比。对比方法包括两种类型,四种基于CNN 的方法:U-Net[8]、UNet++[9]、MultiResUNet[10]和AttentionUNet[11],三种基于Transformer 的方法:TransUNet[20]、MedT[21]和UCTransNet[22]。其中,MedT 与UCTransNet 模型输入大小按照原始公布代码设置为224×224,其余网络模型输入设置为512×512。为了更加公平的比较,上述所有方法的其余设置均采用2.2 节所提的实验设置,不同算法在GlaS 数据集上的分割结果见表1,最佳分割结果采用加粗显示。

表1 不同算法在GlaS 数据集上的实验结果(平均值±标准差)Table 1 The experimental results with different methods on GlaS datasets(Mean ± Std)

由表1 可知,BPNet 方法与现有方法相比在四个指标上具有明显优势。其中,U-Net 作为经典的医学图像分割网络,提出使用跳跃连接融合细节特征,但其较弱的特征提取能力以及简单的特征融合方式导致分割性能不足。UNet++和MultiResUNet 分别在UNet 的基础上改进跳跃连接方式、增强特征融合使得分割效果有提升。而基于Tansformer 结构的TransUNet、UCTransNet 网络通过利用自注意力机制编码远程依赖关系,在精度上相较于基于U-Net 的模型精度有较大提升,但其参数量巨大,且网络训练拟合速度慢,在多个指标上仍略低于BPNet。MedT 则由于其复杂的特征提取过程和训练策略,在数据量偏少的数据集上难以取得优势。BPNet 因其加强了对于病理图像复杂区域的特征提取,取得最好的图像分割性能。

为了直观对比不同方法的预测结果,将模型分割结果进行可视化,如图6所示。可以看出,U-Net 及其改进网络特征信息提取不够完全,导致存在欠分割的情况。基于Transformer 系列网络的分割结果相较于U-Net 系列网络有明显改善,但对于一部分相邻的病灶区域,其分割结果依旧存在粘连情况,说明上述基于Transformer 的分割网络并没有针对边缘特征进行单独的网络改进。而BPNet 拥有最佳的分割效果,尤其是在分割边缘保留了更多的细节信息,证明所提的边缘感知模块优化了网络对于边缘的分割效果。

图6 不同算法在GlaS 数据集上的分割结果Fig.6 The segmentation results of different algorithms on GlaS datasets

2.3.2 算法消融实验

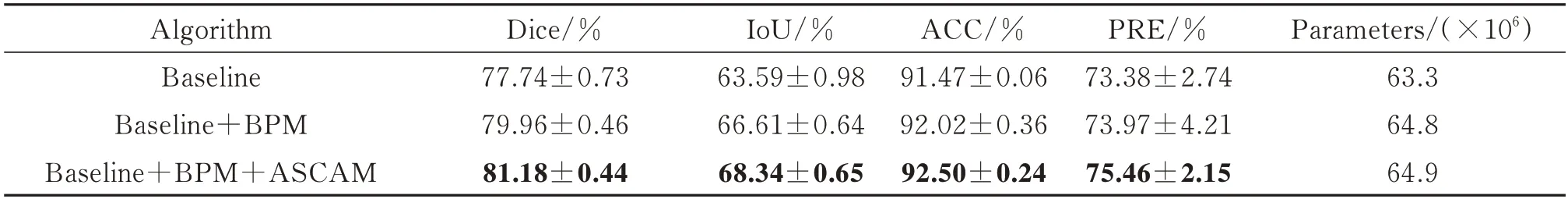

在此基础上,进行了消融实验,具体设置为:1)Baseline 是以EfficientNet-B4 网络作为编码器的UNet,并使用ImageNet 数据集预训练模型,训练过程中采用联合损失函数。2)在Baseline 的基础上加入边缘感知模块,命名为Baseline+BPM。3)在Baesline+BPM 的基础上增加自适应通道注意力模块,注意力模块的使用位置在各解码层对应的特征融合位置,实验中命名为Baseline+BPM+ASCAM,即BPNet。消融实验中所有模型训练设置与BPNet 算法相同,取五次重复实验结果均值作为各模型得分,实验结果如表2所示。

表2 GlaS 数据集上的消融实验结果(平均值±标准差)Table 2 The ablation experimental results on GlaS datasets(Mean ± Std)

由表2 可知,Baseline 在原始U-Net 基础上更换有效编码器及使用联合损失函数使得网络的性能有一定的提升。同时,添加边缘感知模块后模型的预测分割精度提升明显,说明边缘感知模块有效地增强了网络对于边缘细节的预测。而自适应感知通道模块仅增加极少的参数量使得网络的分割结果进一步提升。

为体现各模块对分割结果的作用,图7 展示了相应的消融实验实际分割效果。可以看出,在基础模型添加BPM 后,相邻分割目标的粘连现象有明显改善,说明该模块加强了模型对于边缘的区分能力,但还存在定位不准确,分割目标缺失的问题。在上述模型添加ASCAM 后,分割结果进一步完善,在保留精细边缘的同时准确定位目标。

图7 GlaS 数据集上的消融实验结果Fig.7 The segmentation results of ablation experiments on GlaS datasets

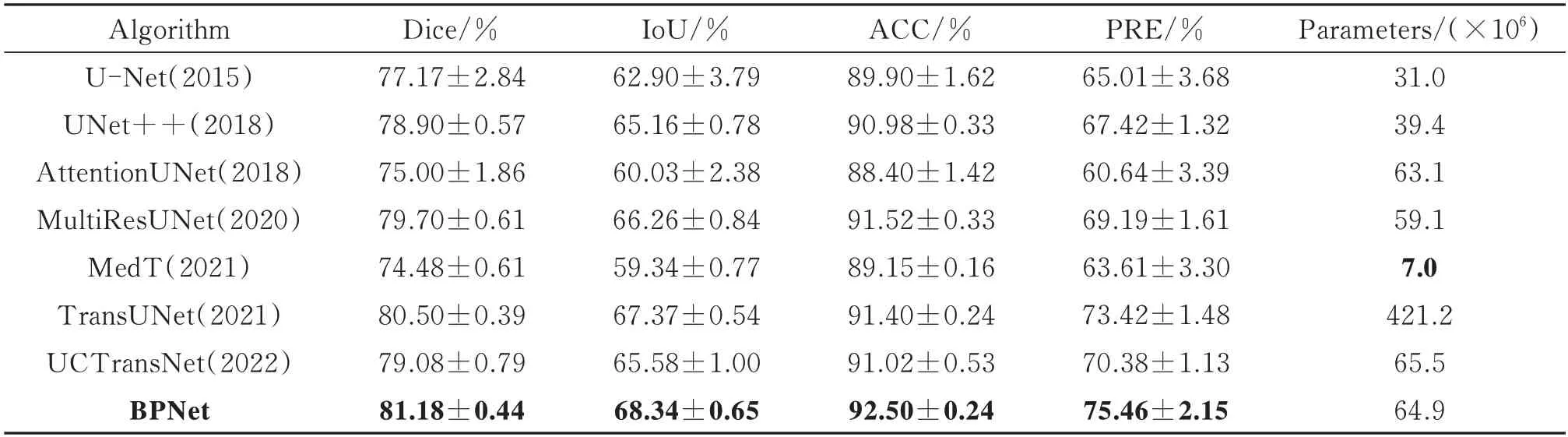

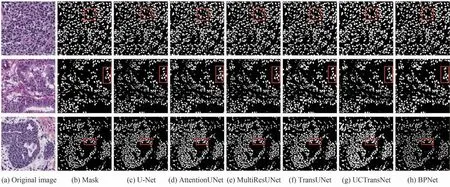

2.4 MoNuSeg 数据集实验结果

2.4.1 BPNet 算法和经典算法对比

为了测试BPNet 模型在不同数据集上的泛化性,在MoNuSeg 数据集上进行了对比实验,实验设置同2.3.1 节,实验结果见表3。

表3 不同算法在MoNuSeg 数据集上的实验结果(平均值±标准差)Table 3 The experimental results with different methods on MoNuSeg datasets(Mean ± Std)

在表3 中,UNet++和MultiResUNet 相较于U-Net 分别提升了约1.6%和2.5%的Dice 系数,提升幅度小于GlaS 数据集,这是由于MoNuSeg 数据集的分割目标更加聚集复杂。而AttentionUNet 的注意力模块并没有使网络在复杂的数据下获得更佳的融合特征,反而使得网络参数量增加导致过拟合,测试集得分相较于U-Net 有所下降。基于Transformer 的TransUNet 和UCTransNet 在得分上相较于基于U-Net 的网络有明显提升,这是由于细胞核在整幅图像有重复性以及相似性,Transformer 能够有效提取不同区域相似目标之间的关联特征,使分割效果提升,但MedT 由于网络仅采用自注意力机制进行特征提取,在数据量偏少的情况下网络不能有效拟合,导致得分明显偏低。本文提出的BPNet 在四个指标上均取得了最高得分,说明网络有效提取了复杂病理图像的细节信息。

各算法在测试集上的预测结果如图8所示。在图8 中,各算法均出现了不同程度的过分割,主要体现在相邻细胞核的边界存在粘连,这种情况会极大地影响临床中后续的细胞计数。相较于对比算法,BPNet 优化了边界的特征提取以及在训练过程中加入对边界效果的评价,使其取得了最好的分割效果。

图8 不同算法在MoNuSeg 数据集上的分割结果Fig.8 The segmentation results of different algorithms on MoNuSeg datasets

2.4.2 算法消融实验

在MoNuSeg 数据集上的消融实验设置与2.3.2 节一致,实验结果见表4。

表4 MoNuSeg 数据集上的消融实验结果(平均值±标准差)Table 4 The ablation experimental results on MoNuSeg datasets(Mean ± Std)

从表4 可以看出,Baseline 逐渐添加BPM 以及ASCAM 后各指标有了明显提升,说明采用边缘感知融合以及自适应通道注意力都能提高网络的病灶分割性能。结合表3 的实验结果,可以发现添加BPM 模块能够使目标的边界位置信息深度参与到网络训练的优化过程中,对于模型的分割性能提升尤为明显,这体现了边缘特征对于提高密集目标分割性能的重要性;而ASCAM 模块在保证不增加网络模型复杂度的前提下,自适应的捕捉了编码、边缘、解码三部分特征信息的交互关系,弥补了不同层次特征间的语义差距,有效捕获了更复杂的通道相关性,进一步提升了分割精度。

3 结论

本文提出了一种改进的病理图像语义分割算法BPNet。该算法首先利用解码特征图生成边缘增强特征,加强了网络对于实例多且分布广的病理图像的分割性能,并采用自适应通道注意力模块筛选重要特征,最后在输出层利用联合损失函数实现网络对于不同层级特征的信息捕获,使网络性能达到最优。在GlaS 和MoNuSeg 病理图像数据集上的实验结果表明,本文所提方法优于其他方法,获得了最好的分割效果,其Dice分割精度分别可达92.21%和81.18%,尤其在边缘预测处理上具有明显的优势。此外,基于Transformer 的网络能够有效提取图像不同区域相似目标之间的长距离依赖关系,提升分割性能。因此下一步将联合Transformer 模型,在细化分割边缘的同时进一步加强网络的特征提取能力。