融合高分辨率网络的雾天目标检测算法

2023-11-17陈紫强孙宗威赖镜安

张 骞,陈紫强,孙宗威,赖镜安

(桂林电子科技大学信息与通信学院,广西 桂林 541004)

1 引言

随着计算机技术以及新能源技术的快速发展,汽车行业逐渐朝着智能化的趋势发展。目前,自动驾驶领域中许多关键技术都是基于视觉的智能感知和识别算法实现的。该类算法可以感知出道路、车辆及行人等信息,并基于感知结果获取相应的距离和状态等信息,为车辆辅助控制系统提供决策依据。通过视觉传感器获取的道路图像虽然能够获取丰富的目标信息,但是容易受到不利视觉条件如雾霾、雨雪等天气的影响,这些来自外界环境的干扰会对相机中搭载的深度学习算法造成严重的影响。因此,如何提高检测算法在雾天天气下的检测精度,是当前目标检测领域的关键问题之一。

随着人工智能研究的不断深入,基于深度学习的目标检测算法凭借其优异的检测性能,被广泛应用于实际交通场景中。根据算法流程的不同,常见的目标检测算法主要可以分为以下2类。第1类可以看作单阶段的检测算法,包含YOLO[1-4]系列、SSD(Single Shot multibox Detector)[5]、RetinaNet[6]等,将图像输入到卷积网络提取特征,根据提取到的特征信息直接预测目标的类别和位置信息。文献[7]将DehazeNet去雾网络与SSD算法相结合,实现雾天场景下车辆和行人的检测。文献[8]提出了一种用于恶劣天气条件下的目标检测模型DSNet(Dual-Subnet Network),将采集的图像输入恢复子网络中进行图像增强,再引入RetinaNet检测子网络对增强后的图像进行目标检测。第2类可以看作双阶段的目标检测算法,如Faster RCNN[9],Cascade RCNN[10]等,先采用候选区域生成网络RPN(Region Proposal Network)、选择性搜索等算法对提取的特征信息进行筛选,再对筛选出来的候选区域进行分类和回归,最终得到检测结果。该类算法牺牲了一定的推理速度,检测效果更优。文献[11]提出了一种基于知识引导的目标检测框架,通过统计先验设计检测网络中的锚框面比,从而对网络的特征学习进行指导。文献[12]提出了一种嵌入雾浓度判别模块的Faster RCNN目标检测算法,先根据不同雾的浓度选择对应的目标检测模型,再引入SENet(Squeeze-and-Excitation Networks)注意力模块和可变性卷积对Faster RCNN进行改进,以半监督的方式进行训练,提高目标识别的精度。上述算法未考虑到串联的网络结构在下采样的过程中存在一定信息损失,同时雾天图像中的浅层特征受噪声的干扰严重,使得网络难以学习到目标轮廓、位置等有效的细粒度信息。

鉴于此,本文提出一种融合高分辨率网络的目标检测算法HR-Cascade RCNN(High Resolution Cascade RCNN)。采用双阶段检测算法Cascade RCNN作为基准检测算法,将高分辨率网络HRNet(High Resolution Network)[13]作为主干特征提取网络,提取不同分辨率的特征信息进行聚合,以提升最终的检测准确率;引入CIoU(Complete Intersection over Union)[14]损失函数替换原来的SmoothL1损失函数,提升训练过程中边界框的回归效果,加快网络的收敛速度,有助于提高网络检测性能;最后,采用SoftNMS(Soft Non-Maximum Suppression)[15]对候选框后处理,优化候选框选择机制,降低目标遮挡情况下的漏检率。实验结果表明,HR-Cascade RCNN能够充分利用有益于目标检测的高分辨率特征信息,同时减少下采样过程中的信息损失,以提高雾天场景中车辆和行人的检测精度,降低小目标及遮挡目标的漏检率。

2 Cascade RCNN网络模型

Cascade RCNN是基于Faster RCNN的多阶段改进结构,将级联回归作为重采样机制,通过递增的交并比IoU(Intersection over Union)分阶段训练检测器,解决因训练候选框过多而导致的过拟合问题。Cascade RCNN的结构由主干网络ResNet[16]、特征增强网络FPN(Feature Pyramid Networks)[17]和级联检测器组成,如图1所示。图像输入到ResNet中提取图像特征;接着,把提取的图像特征输入FPN进行特征增强,再经过区域生成网络RPN对增强后的特征信息生成候选区域;然后,通过设定不同的IoU阈值,训练多个级联的检测器进行检测,其中每个检测器包含ROI Align[18]、目标分类置信度C和边界框置信度B;最终输出分类和回归结果。

课程的知识目标主要体现在学习本课程要让学生知道效果图的运用范围,了解效果图的特点,掌握室内效果图的表现流程;掌握3DSMAX9菜单栏、工具栏、视图区、命令面板和视图控制区5部分的界面布局;了解住宅室内装饰构造特点;理解住宅室内空间设计的基本原理;掌握室内常用设计风格,现代简约、欧式和中式风格;掌握二维线的创建和修改方法;掌握标准和扩展三维模型的创建及修改方法。

Figure 1 Network structure of Cascade RCNN图1 Cascade RCNN网络结构

4.3.1 损失函数对比

f(I,b)=fT∘fT-1∘…∘f1(I,b)

(1)

其中,I表示输入图像,b表示边界框,T表示检测器的总数。Cascade RCNN的损失函数L包含边界框的回归损失Lloc和分类损失Lcls,回归损失函数沿用了Fast RCNN[19]中的SmoothL1损失,分类损失函数采用交叉熵损失,其计算公式[10]如式(2)~式(5)所示:

L(xt,g)=Lcls(ht(xt),yt)+

λ[yt≥1]Lloc(ft(xt,bt),g)

(2)

Lcls(ht(xt),yt)=-log(hyt(xt))

(3)

Lloc(ft(xt,bt),g)=

(4)

(5)

其中,t表示级联的阶段,xt表示第t个阶段的输入,g表示目标的真实边界框,yt表示预测的类别,λ表示用于平衡损失的权重系数,bt表示预测得到的边界框,Cx和Cy表示边界框中心点的横纵坐标,w和h分别表示边界框的宽和高。

HRNet40经过高分辨率与低分辨率卷积之间的信息交互,将不同分支的特征信息进行拼接,共输出4种不同尺度的特征图,可视化结果如图9所示。其中,图9a表示第1个分支输出的高分辨率特征信息,共有40个通道;第2个阶段和第3个阶段输出的特征信息分别如图9b和图9c所示,分别共有80和160个通道;第4个阶段的特征共有320个通道,拼接后的特征图如图9d所示。

一是建立党员干部结对联系群众机制。实现党员一对一直接联系群众全覆盖,通过党组织共建、部门与教研室、班级共建、党员与教师、学生结对党员帮扶困难师生等形式,建立起党员干部与结对群众之间的稳定联系,有效畅通和拓宽民情民意沟通反映渠道,有效提升为群众解决实际问题的及时性、针对性和有效性。

Figure 2 Network structure of HR-Cascade RCNN图2 HR-Cascade RCNN网络结构

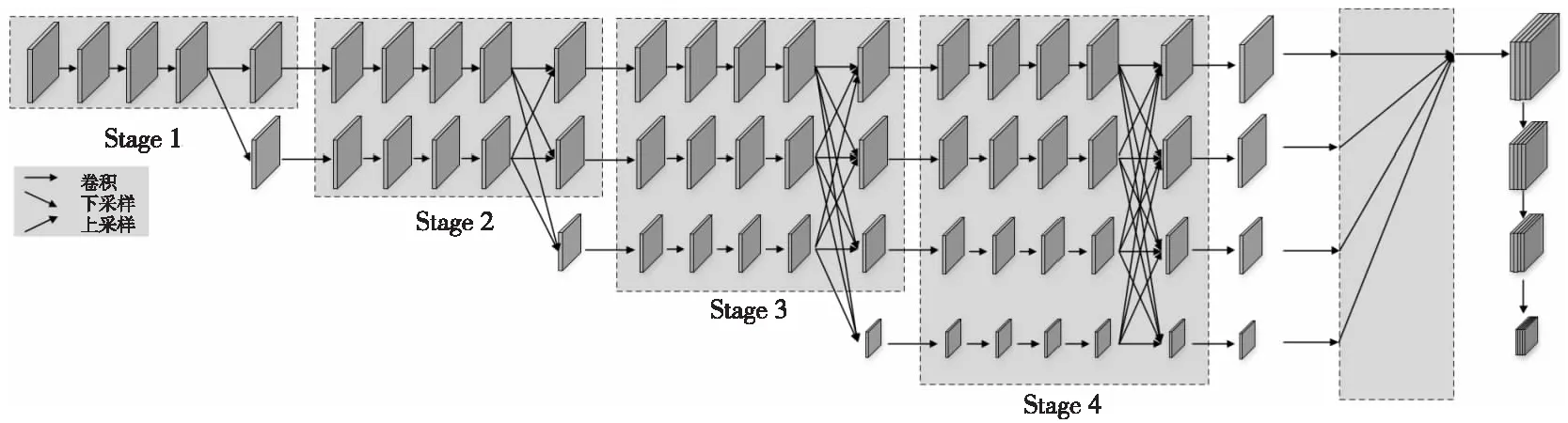

Figure 3 Network structure of HRNet图3 HRNet网络结构

3 HR-Cascade RCNN网络模型

HR-Cascade RCNN的结构如图2所示,在Cascade RCNN的基础上引入HRNet高分辨率主干网络,并对模型的损失函数和锚框选择机制进行改进。输入图像经过HRNet主干网络提取不同分辨率的特征信息,接着对提取的信息进行拼接操作,输出到RPN生成候选区域,最后将特征信息与候选区域输入到3个级联的检测器中得到分类和回归结果。

根据雷达回波监测及廊桥附近的监控视频综合分析(图6),廊桥桥顶垮塌时间与合村气象站所测得极大风速时间基本一致,在19:34—19:35左右。0.5°仰角的雷达径向速度为27~30 m/s。同时根据现场调查,廊桥周边部分树木存在折断、倒伏现象,玉米地、大棚被破坏的情况,对照蒲氏风级表对陆地地面征象表述的“九级风为烟囱及平房顶受到损坏,小屋遭受破坏;十级风为陆上少见,见时可使树木拔起,或将建筑物吹毁”。据此判断,廊桥桥顶垮塌时可能有10级大风。

3.1 HRNet结构

HRNet网络的结构如图3所示,整个网络结构由高分辨率网络与低分辨率网络并行连接,使网络能够在卷积的过程中保持高分辨率的图像特征。此外,HRNet包含大量跨高分辨率和低分辨率的信息交互,可以改善采样过程中的信息丢失问题[20]。其中,通过步长为2的3×3卷积实现高分辨率特征的下采样;采用双线性插值的方式进行上采样,实现低分辨率向高分辨率的转换。整体流程可分为4个阶段,每个阶段包含不同分辨率的卷积层。第1个阶段由1个子网络构成,第2个阶段由2个并行连接的子网络构成,第3个阶段由3个并行子网络构成,第4个阶段由4个并行子网络构成。每个阶段之间将不同分辨率的特征信息进行融合,输出4种尺度的特征图。最终,将所有分辨率的特征图进行拼接,并通过下采样得到多种尺度的特征信息。

4.3.4 RTTS数据集对比实验结果

3.2 CIoU损失函数

Cascade RCNN中设置了3个不同阈值的检测器对筛选出来的候选框进行分类和回归。其中,回归损失函数采用SmoothL1损失进行计算。SmoothL1损失将检测框的坐标以相对独立的方式进行计算,忽略了检测框坐标之间的关联性。在实际的计算过程中可能会出现不同的检测框具有相同的SmoothL1损失[21]。因此,SmoothL1损失在衡量预测框与真实框之间的关系时存在一定的局限性。为加快网络的收敛速度,提升边界框回归过程中的收敛效果,采用CIoU作为回归损失函数,CIoU在DIoU[14]损失函数的基础上引入了新的惩罚项,用来度量检测框与真实框的长宽比之间的相关性。相比于SmoothL1损失函数仅仅计算检测框坐标之间的关联,CIoU损失函数不仅计算2个检测框之间的距离和IoU交并比,而且还引入了新的惩罚项,用来衡量检测框相对比例的一致性,更关注检测框之间的关联性,符合实际的检测场景。如图4所示,d是2个重叠框中心点之间的距离,c是覆盖2个重叠框最小包围框的对角线长度。

Figure 4 Example of CIoU图4 CIoU示例

CIoU损失函数的计算公式如式(6)~式(8)所示:

从图8和图9可以看出,ResNet50提取出来的特征信息受雾天环境的影响较大,如图8a图像受噪声的干扰比较严重,提取到的特征信息存在一定的局限性,目标与背景的差异较小,无法学习到有效特征。从图9b可以看出,HRNet输出的高分辨率特征图受雾天的干扰比较小,提取了如车辆、行人等关键特征,细节信息丰富,目标的轮廓更清晰,更有利于网络模型的学习更新。对比图8a和图8b可以看出,ResNet提取的目标特征与背景特征差异并不明显;而HRNet提取到的行人和车辆特征更为突出,且背景的关注度更低,使得网络对目标的定位更加准确。从图8d可以看到,ResNet提取的特征图背景依旧存在部分噪声;而图9d中HRNet提取的低分辨率特征干扰信息更少,更具代表性,有利于网络学习。

(6)

(7)

(8)

其中,IoU代表真实框与预测框之间的交并比;p表示模型检测出来的边界框;gt表示人工标注的真实边界框;b表示边界框的中心点坐标;ρ2(·)表示欧氏距离;α和v是引入的惩罚项,用来对重叠框的宽高比进行约束;w表示边界框的宽度;h表示边界框的高度。相比于SmoothL1损失函数,CIoU考虑了检测框与真实框的重叠面积、中心点距离以及宽高比,有助于提升检测框的定位精度。

2010年4月,布朗造访社区为选举造势。其间,一位66岁的女性工党成员对布朗表示,她和家人一直支持工党,并就东欧移民、福利金领取、国债等议题频频向布朗发问。

3.3 SoftNMS

非极大值抑制NMS(Non-Maximum Suppression)对筛选出来的候选框按照得分从高到低进行排序,选中分数最高的候选框,然后抑制与选中框有明显重叠的候选框。但是,NMS算法存在一定的局限性:一方面如果阈值的选取过高,将会删除更多的候选区域,导致漏检的情况发生;另一方面,如果输入图像中出现2个重合度较高的目标,分数较低的候选框会因为重叠的面积较大而被删除。如图5所示,放大的图像中存在2辆汽车,实线边界框和虚线边界框分别对应不同车辆的检测框,虚线检测框中的汽车因遮挡导致置信度较低。传统的NMS算法会选择置信度较高的实线检测框而删除虚线候选框,导致出现漏检的现象。

Figure 5 Example of NMS deletion by mistake图5 NMS误删示例图

本文实验所用到的数据集包括BDD100k[22]、Foggy CityScapes[23]和RTTS(Real-world Task-driven Testing Set)[24]。其中,BDD100k共包含10万幅图像,分别拍摄于不同时间、不同天气条件下的驾驶场景,目标标签共包含汽车、交通标志和行人等10个类别;Foggy CityScapes是在CityScapes[25]数据集基础上,使用大气散射模型合成的雾天数据集,共有2 975幅训练图像,包含汽车、自行车和摩托车等9类标签;RTTS是真实场景下获取的雾天数据集,共有4 322幅图像,其中包含汽车、公交车和行人等5个类别。为了规范数据集的类别,后续的实验统一采用RTTS数据集中的标签类别。训练时从BDD100k数据集中随机抽选12 000幅图像,并按照9∶1的比例划分训练集和验证集,将微调后的模型分别在RTTS和Foggy Cityscapes上进行测试。

(9)

其中,Nt是设定的阈值,M是得分最高候选框的坐标,bi表示第i个待处理的候选框坐标,IoU(·)表示交并比,Si是第i个候选框的得分。因此,与M距离较远的候选框不受影响,与M距离较近的候选框的得分会有一定的衰减。

4 实验与结果分析

4.1 实验数据

雾天环境中车速较缓,常出现交通堵塞等现象,且车辆之间易出现遮挡的情况,导致目标检测算法无法对车辆进行有效的检测,模型的检测精度偏低。为改善因多个目标检测框相近被误删,使得遮挡目标出现漏检的问题,采用SoftNMS算法对候选框进行筛选,计算公式如(9)所示[15]:

参加捐款的干部职工纷纷表示,灾区群众不会孤独,水利系统的干部职工永远与灾区人民心连心,继续为受灾地区群众提供更多的支持和帮助。

迁安海绵城市建设思路与创新模式研究 ……………………………………………………………………………… 孙迎春(4/49)

4.2 实验环境及参数设置

本文的实验环境及参数设置如下:操作系统为Windows10,CUDA版本为11.1.1,CUDNN版本为8.1.1,GPU型号为GetForce RTX 3060,显存为12 GB,实验均在MMDetection[26]目标检测框架上进行。在训练阶段,采用预训练权重在训练集上微调训练12个epoch,学习率初始值为1.25×10-3,学习率的衰减策略为阶段衰减,衰减系数为1×10-4,动量为0.9,优化算法为随机梯度下降。当迭代次数达到8和11的时候,学习率根据衰减策略调整为1.3×10-4和1×10-5。实验中采用单个类别的平均精度AP(Average Precision)和所有类别的平均精度均值mAP(mean Average Precision)对模型的性能进行评估,采用的IoU阈值为0.5。

在对照组综合方案治疗的基础上,再予温针灸治疗:取会阴穴,嘱患者取仰卧位,常规会阴穴及局部消毒后,用一次性针灸针直刺2寸,待得气后行提插捻转,2 min后在针柄处插入长为2 cm的艾柱并点燃,每日治疗1次,每次30 min。共治疗1个月。

4.3 实验结果分析

Cascade RCNN包含多个具有不同IoU阈值的级联检测器,每个检测器都包含一个分类器hi和一个回归器fi。将前一检测器的回归结果作为后一检测器的输入,通过级联检测的方式,可以获取定位更精准的候选框,有助于提升最终的检测精度。单个回归器fi的计算公式如式(1)所示:

为验证CIoU损失函数对于边界框回归训练的有效性,分别采用CIoU损失函数和Smooth L1损失函数对HR-Cascade RCNN进行对比实验,回归损失的对比曲线如图6所示。

Figure 6 Comparison of regression error curves图6 回归误差曲线对比

图6显示了采用不同损失函数时,候选框回归损失的下降情况。可以看出,2条曲线在第35 000次迭代的附近,误差值均出现了一次明显的下降。这是因为学习率在训练第8个epoch时进行了阶跃性的衰减,衰减后的学习率使得损失可以达到更优的局部最小值。此外,CIoU的误差值要明显低于Smooth L1的误差值,证明CIoU损失更有利于网络整体的训练。相比于Smooth L1损失,CIoU损失函数不仅考虑了重叠区域和中心点之间的距离,并且还考虑了预测框与真实框宽高比的一致性,因此能够使网络达到更好的收敛效果,有助于提高网络的检测性能。

4.3.2 特征图可视化对比

本节以Cascade RCNN为基准,分别采用ResNet50和HRNet40作为主干网络,输入如图7所示的测试图像,对提取到的特征图进行可视化对比,旨在分析不同主干网络在不同阶段提取到的特征信息,以验证HRNet提取高分辨率信息的能力。

Figure 7 Test image of feature visualization图7 特征可视化测试图像

ResNet50共有50层运算,共分为5个阶段,其中第1个阶段结构相对简单,可以视为对输入图像的预处理;后4个阶段都是由BottleNeck组成,结构较为类似。在对网络进行测试的时候,分别提取后4个阶段输出的特征图进行可视化分析,结果如图8所示,图8a表示ResNet50第2个阶段输出的特征图,图8b、图8c和图8d分别表示第2,3和4阶段输出的特征图。

Figure 8 ResNet50 feature map visualization图8 ResNet50特征图可视化

(2)运输。运料车每次使用之前必须保持车厢内清洁干净,不得有余料集存在车厢内。另外,在车厢底板和侧板涂抹一薄层隔离剂或防黏剂。由于母体沥青混合料空隙较大,热量容易散失,在运输过程中混合料应有篷布覆盖,做好保温、防雨和避免污染环境工作。

Figure 9 HRNet40 feature map visualization图9 HRNet40特征图可视化

何良诸恍然明白,赵集、小勺把他弄到井下,让他避开风头。要不,他跟闹事的矿工们混在一起,就说不清道不明了。何良诸问:“赵集被抓走了?”

日照时长与水体蒸发的强度呈现出正相关的关系.流域内1995年日照时长为1 874.1 h,均高于其他年份,由此推测,椒江水体1995年蒸发强度为五年内最大,地表径流因蒸发作用而损失的水量最多.同时,流域于1995年降雨最少,地表径流的补充相对减少,其与日照综合作用,推测椒江地表径流年内水量最少,进一步减弱了水体对悬浮泥沙的“稀释”作用,导致椒江水体悬浮泥沙浓度高于其他年份.

4.3.3 消融实验

为了验证HR-Cascade RCNN改进算法的有效性,本节将在RTTS数据集上进行消融实验。首先,以Cascade RCNN为基准,分别采用不同通道的HRNet主干网络与原ResNet50网络进行实验对比,验证高分辨率网络融合多分辨率特征信息的有效性,实验结果如表1所示。

Table 1 Experimental results comparison of different backbone networks of Cascade RCNN on RTTS dataset表1 Cascade RCNN不同主干网络在RTTS数据集上的实验结果对比 %

从表1可以看出,随着HRNet网络通道维度的增加,单个类别的AP和整个数据集的mAP均有一定的提升,如HRNet18的mAP相比ResNet50的提高了0.7%,HRNet32的mAP相比HRNet18的提高了1.3%,HRNet40的mAP相比HRNet32的提高了1.5%。对比实验结果表明,相比于直接采用ResNet串联结构,HRNet可以更加有效地提取多分辨率的特征信息,提高网络的检测精度。因此,后续实验中的HR-Cascade RCNN模型均采用HRNet40作为主干特征提取网络。

为验证CIoU损失函数和SoftNMS改进的有效性,HR-Cascade RCNN在RTTS数据集上的消融实验结果如表2所示。消融实验结果表明,HR-Cascade RCNN在RTTS数据集上相比于Cascade RCNN网络,改进主干网络使检测均值平均精度mAP提升了3.9%,表明采用HRNet提取不同分辨率的特征信息,增强了特征图深浅层特征信息融合,从而提升了检测效果;对损失函数优化后,mAP在改进主干网络的基础上提升了1.2%,说明CIoU损失相比于SmoothL1损失,更注重真实框与候选框之间的相关性,有效提升了网络的泛化性能;优化锚框选择机制使mAP提升了0.8%,说明SoftNMS可以有效地降低目标的漏检率。与Cascade RCNN的mAP相比,HR-Cascade RCNN的平均检测精度由52.1%提升至58%,大幅度提升了检测精度。

Table 2 Comparison of HR-Cascade RCNN ablation experiments on RTTS dataset表2 HR-Cascade RCNN在RTTS数据集上的消融实验对比 %

本文研究选择我院在2015年5月~2017年9月诊治的颈动脉病变患者35例作为检查对象,患者均确诊为颈动脉狭窄疾病,其中脑梗死24例,短暂性脑缺血11例,患者均经过颅脑CT和MIR检查确诊,无肝肾疾病、其他心脑血管疾病和碘过敏史等。患者同意参与本次检测分析,可以配合。患者中男20例,女15例,年龄为(45.3±0.6)岁,患者的年龄、疾病类型等数据可比。

先验P(θ)决定质点的初始化状态。好的先验包含有地理信息,例如附近断层线相对于第一个被触发台站的位置,以及在断层线上产生的地震最常见震级。这些信息都可以根据每个台站的历史地震目录得到,并在对质点滤波进行初始化时实时使用。如果先验信息缺失,则可以使用平坦先验来进行替代。先验分布的选择会影响估计的质量和收敛速度。大覆盖的先验分布可能会使初始估计不稳定,这是因为几乎没有证据存在。小覆盖的先验分布则可能导致收敛速度慢或收敛错误(即在错误值上收敛)。这就需要根据经验来进行权衡。在本文中,我们使用统一的平坦先验,即位置为±100km,深度为±10km,震级为±1级,事件发震时刻为±10s。

本节将在RTTS数据集上对HR-Cascade RCNN和其他的目标检测算法进行对比实验,通过结合不同的图像去雾算法如DCP和AOD-Net,验证本文算法的有效性。表3展示了在RTTS数据集上的对比实验结果。从表3可以看出,结合去雾算法前,本文算法HR-Cascade RCNN的平均检测精度mAP为58.0%,单个类别的AP及mAP均高于其他对比算法的;Faster RCNN和Cascade RCNN的平均检测精度次之,分别为52.7%和52.1%。其次是单阶段的目标检测方法,如YOLOX的mAP为50.5%,YOLOv3的mAP为34.0%,RetinaNet的mAP为33.1%。在结合去雾算法之后,检测结果有所下降。如Faster RCNN对DCP去雾后的图像进行检测,检测类别中行人和摩托车的平均精度得到一定程度的提升,但是其他类别检测精度均出现了不同程度的下降,整体的平均检测精度mAP下降了1.1%;结合AOD-Net去雾算法之后,单个类别的检测精度均出现不同程度的提升或下降,整体的平均检测精度mAP保持在52.7%不变。同样地,从表3可以看到,RetinaNet和YOLOX算法对去雾后的图像进检测得到的检测精度都降低了约1%。此外,YOLOv3、Cascade RCNN和HR-Cascade RCNN在结合不同的去雾算法之后均有0.8%~1%的提升。如YOLOv3结合DCP去雾算法之后检测精度提升了0.9%,结合AOD-Net去雾后的检测精度提升了1%;Cascade RCNN结合DCP去雾算法之后检测精度下降了0.3%,结合AOD-Net去雾算法后的检测精度提升了0.6%;本文算法HR-Cascade RCNN在结合DCP去雾算法之后的检测精度并未得到有效的提升,结合AOD-Net去雾算法之后的检测精度提升了0.8%。结合去雾算法之后的检测精度一方面取决于去雾算法自身的去雾能力,当出现细节丢失或颜色失真等情况时,会影响检测器后续的检测任务,出现检测精度下降的情况;另一方面,检测网络本身的特征提取能力和训练数据集的限制也会对检测精度出现不同程度的影响,如主干网络提取能力强的检测模型受到的影响较小,且训练集的大小和图像种类也会影响模型的鲁棒性和泛化能力。

图10~图15分别展示了HR-Cascade RCNN和对比算法在真实雾天数据集RTTS上的部分检测效果,雾天图像代表的是未使用去雾算法,直接对原始雾天图像进行检测的结果;DCP代表在检测前使用DCP去雾算法对图像进行去雾后,各检测算法的检测效果;AOD-Net表示使用AOD-Net去雾算法对图像进行去雾后,使用检测算法对去雾后的图像进行检测的效果。从图10可以看出,在车辆目标较小、难以辨认的情况下,Faster RCNN未能准确地检测出图中的小目标,如对于图10a测试图像,Faster RCNN仅能检测到图像右侧的车辆和行人,左侧的行人和车辆等目标均未检测到;在图10b和图10c测试图像中,使用不同的图像去雾算法之后,图像变得更清晰,漏检现象得到了改善,图像左侧的部分目标被检测到,但仍有一定的提升空间。因存在车辆目标密集的情况,各算法均存在一定的漏检情况,相对于其他的检测算法,本文算法的漏检率更低,可以检测出更多的车辆。图11为YOLOv3算法的检测图。从图11a可以看到,YOLOv3算法在雾天图像中检测到的目标较少,检测效果较差;经过图像去雾之后,YOLOv3的检测效果获得不同程度的提升,如图11b和图11c所示,更多的车辆和行人目标被检测到,但相比于其他算法仍有一定的差距。图12为RetinaNet算法的检测结果。从图12可以看到,RetinaNet出现了漏检的现象,仅检测到少量的行人和车辆目标;使用DCP和AOD-Net去雾之后,更多的行人被检测到,但是相比于其他的检测算法仍有一定的差距。图13为YOLOX的检测对比图。从图13a可以看到,YOLOX在去雾前能够检测到较多的车辆和行人等目标,优于YOLOv3和RetinaNet算法,但是仍有部分车辆和行人未被检测到;使用去雾算法之后的检测效果未得到明显的提升,如图13b和图13c,图像中的部分车辆仍未被检测到。图14是Cascade RCNN的检测对比图。图14a为去雾前的检测图,图像左侧的车辆和行人未被检测到;图14b和图14c为去雾后的检测效果图,漏检现象得到改善,但是被遮挡的出租车未被检测到。图15为本文算法HR-Cascade RCNN的检测效果图,在去雾前也存在一定的漏检现象,如图15a所示;使用图像去雾算法之后,图像左侧的行人和车辆均被检测到,且被遮挡的出租车也被检测到了。由此可以看出,在真实雾天场景中,HR-Cascade RCNN在结合一些去雾算法之后的检测效果更好,检测精度更高。

Table 3 Detection results comparison of different detection algorithms on RTTS dataset表3 不同检测算法在RTTS数据集上的检测结果对比 %

Figure 10 Detection results comparison of Faster R-CNN on RTTS dataset图10 Faster R-CNN在RTTS数据集上的检测结果对比

Figure 11 Detection results comparison of YOLOv3 on RTTS dataset图11 YOLOv3在RTTS数据集上的检测结果对比

Figure 12 Detection results comparison of RetinaNet on RTTS dataset图12 RetinaNet在RTTS数据集上的检测结果对比

Figure 13 Detection results comparison of YOLOX on RTTS dataset图13 YOLOX在RTTS数据集上的检测结果对比

Figure 14 Detection results comparison of Cascade RCNN on RTTS dataset图14 Cascade RCNN在RTTS数据集上的检测结果对比

Figure 15 Detection results comparison of HR-Cascade RCNN on RTTS dataset图15 HR-Cascade RCNN在RTTS数据集上的检测结果对比

4.3.5 Foggy Cityscapes数据集实验结果

本节在合成的雾天数据集Foggy Cityscapes上进行对比实验,通过结合不同的去雾算法,验证HR-Cascade RCNN在合成雾图中的准确率,实验结果如表4所示。从表4可以看出,在结合去雾算法之前,与其他的算法相比,HR-Cascade RCNN的检测性能在各个类别的平均检测精度AP都有一定的提升,平均检测精度mAP为43.8%,相比于Faster RCNN、YOLOv3、YOLOX-s、RetinaNet和Cascade RCNN的分别提高了2.1%,15.5%,10.2%,13.5%和3%,性能得到了明显的提高。使用去雾算法之后,一些检测算法的检测性能有所下降,如Faster RCNN在结合DCP算法之后的mAP降低了0.3%;YOLOX结合DCP算法之后的mAP降低了0.6%。更多的检测算法在结合图像去雾算法之后的检测性能均提升1%~2%,如Faster RCNN结合AOD-Net去雾算法之后的mAP提升了1.2%,RetinaNet结合AOD-Net去雾算法之后的mAP提升了1.1%,本文算法结合AOD-Net之后mAP提升了1.3%。实验结果表明,HR-Cascade RCNN在合成数据集上的检测性能存在一定的优势。

为了测试HR-Cascade RCNN和对比算法在Foggy CityScapes上的检测效果,从测试集中选取了部分检测图进行对比,结合去雾算法前后的检测效果如图16~图21所示。从图16a可以看出,使用Faster RCNN直接对雾天的图像进行检测时可以正确检测到车辆和行人等目标;图16b是结合DCP去雾算法之后的检测图像,因为颜色失真和细节丢失的原因,出现了漏检的现象,没有正确地检测出遮挡汽车。结合AOD-Net去雾算法后,依然可以精确地检测到目标。图17a为YOLOv3的检测结果图,去雾前的检测图中存在漏检的汽车;在使用去雾算法之后,如图17b和图17c漏检现象得到改善,但仍有远处的汽车没有检测到。图18为RetinaNet算法的检测图,图中依然存在未检测到的汽车和行人,使用DCP和AOD-Net去雾算法之后,检测效果有所提升,如图18c右侧的行人被检测到,但对于远处的汽车未能全部检测到。图19为YOLOX算法的检测对比图,相比于YOLOv3,YOLOX的检测效果具备一定的优势,如图19a右侧的自行车可以被准确地检测到;结合不同的去雾算法之后,YOLOX的检测效果得到不同程度的提升,如从图19b可以看到,YOLOX能够检测到图像中远处的汽车。图20和图21分别为Cascade RCNN和HR-Cacasde RCNN的检测结果对比图,去雾前Cacade RCNN和HR-Cascade RCNN难以检测到全部目标,如图20a和图21a所示;在使用去雾算法之后,漏检现象均得到了一定程度的改善,如图20c中Cascade RCNN可以检测到图像中远处的汽车,但仍有一辆汽车未被检测到。从图21c可以看到,HR-Cascade RCNN在结合AOD-Net去雾算法后,可以准确地检测到图像中远处的汽车,且图像左侧的遮挡车辆也能够被正确地检测到。在合成数据集中,对于雾天场景中模糊、难以辨认等未检测出来的目标,改进后的模型能够准确地检测出来,证明了本文算法的有效性。因此,对于真实雾天场景和合成雾天场景下的目标检测,HR-Cascade RCNN的检测性能相比于Cascade RCNN有显著的提高。

参照文献[7], 它的耗散另行在ξh=π处设置r=10加以限定. 改进B最终的系数为al= {-0.032 803, 0.225 61, -0.885 98, 0.110 61, 0.720 07, -0.159 24, 0.021 742}, 如图1所示, 该改进关于色散获得相当大的改善并在整个波数范围满足r≤10. 通过以上改进, 可在较短的距离内从主波面中消除原始的7点6阶中心格式的伪波, 见图2.

Table 4 Detection results comparison of different detection algorithms on Foggy CityScapes dataset表4 不同检测算法在Foggy CityScapes数据集上的检测结果对比 %

Figure 16 Detection results comparison of Faster R-CNN on Foggy Cityscapes dataset图16 Faster R-CNN在Foggy Cityscapes数据集上的检测结果对比

Figure 17 Detection results comparison of YOLOv3 on Foggy Cityscapes dataset图17 YOLOv3在Foggy Cityscapes数据集上的检测结果对比

Figure 18 Detection results comparison of RetinaNet on Foggy Cityscapes dataset图18 RetinaNet在Foggy Cityscapes数据集上的检测结果对比

Figure 19 Detection results comparison of YOLOX on Foggy Cityscapes dataset图19 YOLOX在Foggy Cityscapes数据集上的检测结果对比

Figure 20 Detection results comparison of Cascade RCNN on Foggy Cityscapes dataset图20 Cascade RCNN在Foggy Cityscapes数据集上的检测结果对比

Figure 21 Detection results comparison of HR-Cascade RCNN on Foggy Cityscapes dataset图21 HR-Cascade RCNN在Foggy Cityscapes数据集上的检测结果对比

5 结束语

为了提高雾天场景中车辆和行人等目标检测的精度,本文提出一种融合高分辨率的目标检测网络HR-Cascade RCNN。在网络结构上采用HRNet作为主干网络,通过高分辨率和低分辨率的信息交互,改善下采样过程中的信息损失问题,提高网络特征提取能力;引入CIoU损失函数替换原有的SmoothL1损失,提升训练时的收敛效果,提高模型的检测精度;最后使用SoftNMS优化锚框选择机制,有效地降低了目标遮挡情况下的漏检率,提高网络的鲁棒性和泛化能力。在真实雾天数据集RTTS和合成雾天数据集Foggy Cityscapes上的实验结果表明,HR-Cascade RCNN准确率均优于其他的检测算法,平均检测精度相比于原算法分别提高了5.9%和3%,有效地提升了网络的检测精度。后续将研究更轻量化的网络模型,在不降低检测精度的前提下,进一步提升检测速度。