无人机自主航迹规划智能算法综述

2023-07-20郭启敏张鹏王应洋王石

郭启敏 张鹏 王应洋 王石

摘 要:自主能力是无人机跨代升级的根本能力和直接推手。 随着人工智能技术的颠覆变革, 基于智能算法的自主航迹规划技术成为提高无人机自主能力的关键技术, 具有重要研究价值。 本文首先总结国内外相关研究, 提出对无人系统自主性的理解, 对智能算法应用于无人机自主航迹规划的优势进行分析, 然后从算法改进方式入手, 对进化算法、 群智能算法、 神经网络、 强化学习算法和深度强化学习等航迹规划智能算法进行分类梳理和总结, 最后结合当前无人机自主航迹规划面临的挑战, 对未来的研究方向进行展望。

关键词:无人机; 航迹规划; 自主性; 智能优化算法; 机器学习算法; 算法改进

中图分类号: TJ760; V279文献标识码:A文章编号: 1673-5048(2023)03-0029-12

DOI: 10.12132/ISSN.1673-5048.2022.0220

0 引言

无人机在空战中地位作用日益突出, 如何提高在高对抗、 强拒止战场环境中的自主作战能力, 成为各国重点研究方向, 美军将自主性列为加速无人系统作战应用的四大驱动力之一[1]。 无人机自主能力涵盖自主感知、 自主判断、 自主决策、 自主行动等多个方面。 其中, 无人机航迹规划是无人机遂行任务的核心环节, 航迹规划的优劣关系到无人机的生存和任务能力。 因此, 無人机自主航迹规划技术成为影响无人机自主能力的关键因素。

近年来, 以机器学习为代表的人工智能技术飞速发展, 实现与多种应用场景的深度融合[2]。 在军事领域, 人工智能技术成为推动军事革命的核心力量, 世界军事大国纷纷抢先布局人工智能, 塑造未来新型战场优势, 掌握智能化战争主动权。 将基于人工智能技术的智能算法应用于无人机自主航迹规划, 能够避免传统航迹规划算法的不足, 实现复杂、 动态、 高度不确定性战场环境下的自主航迹规划。

1 无人系统自主性及其内涵

自主性(Autonomy)是行为主体按自己意愿行事的动机、 能力或特性。 提高无人系统自主性, 对压缩“OODA”回路的循环周期[3]、 占据战场主动权具有重要意义。

1.1 无人系统自主性定义

20世纪70年代, 研究人员将自主性概念引入无人系统领域后, 自主性就成为衡量无人系统智能化程度的重要指标, 但至今未形成被广泛认同的定义。 美军对无人系统自主性的研究有3项。

(1) 围绕能力需求

美国空军研究实验室(AFRL)于2000年提出自主作战概念, 认为无人作战系统应具备态势感知、 信息处理、 控制重构和自适应能力, 能够在没有人类干预情况下, 制定最优策略完成给定任务。 美国无人系统自主性等级工作组(ALFUS)将无人系统自主性定义为系统具有传感、 感知、 分析、 通信、 规划、 决策和执行能力, 完成由人类指定的任务或由其他无人系统分配的任务[4]。

(2) 提炼行为特征

美国空军实验室专家Bruce Clough认为, 自主系统能够不受外界影响进行合理决策, 具备在没有指挥员指令时完成任务和为实现目标开发任务的能力, 即自主系统有自由意志[5]。 美国国防部在《无人系统综合路线图(2011-2036)》[6]中指出, 自主系统能够在不确定情况下以目标导向方式优化自身行为。 报告认为无人系统应具备与人类操作员和其他无人系统的交互协作能力, 以及适应环境、 任务变化并从中学习的能力。

(3) 自主行为的核心

美国空军在2019年版《自主地平线》[7]中未明确定义无人系统自主性, 而是针对系统行为提出了“WHAT, WHAT-NOT, WHY, NOT-HOW”模型, 即通过在任务环境中告诉无人系统“做什么、 不做什么、 为什么做和不做的后果”来描述自主行为, 认为熟练性、 可信赖性和灵活性三组属性是自主行为的核心。

国内对无人系统自主性研究中, 高劲松等[8]将无人机自主性定义为无人机在没有外界指导下根据作战目标产生自己意图的能力。 胡晓峰等[9]认为自主性是将决策权赋予智能系统, 使其能够在特定范围内自由采取行动。 刘畅等[10]对无人机可变自主展开研究, 认为无人机系统自主等级应根据战场态势变化、 任务需求和操作员意图共同决定。 郑剑[11]对无人作战系统自主性的描述较为全面, 即无人作战系统根据自身能力, 精确获取战场环境信息, 通过系统内部间交流协作, 在操作人员监督下进行独立判断、 决策并完成作战任务的能力。

从国内外无人系统自主性定义研究中, 得出结论: (1)自主性的重要性体现在复杂、 动态、 高度不确定性的战场环境中; (2)自主性是更高级别的自动化, 自主系统通过目标导向方式优化自身行为; (3)自主性体现在无人系统领受任务后, 在没有人类干预情况下独立完成任务的能力; (4)自主性包括自主感知、 判断、 决策和行动, 自主决策是自主性的核心。

综上所述, 对无人系统自主性可理解为: 无人系统自主性的最终目标不是让系统脱离人的控制, 而是实现人机合作的高度自主。 自主性代表无人系统的独立性水平, 无人系统应具备在复杂、 动态、 高度不确定性战场环境中理解、 学习、 协作和自适应的能力, 在没有人类干预情况下通过目标导向独立完成任务。 无人系统的自主级别应根据战场环境和操作员意图动态调整, 并使无人系统始终处于操作人员的监控下。

1.2 无人系统自主性内涵

(1) 自主感知认知

自主感知认知是指无人系统利用自身携带的多样化传感设备, 对战场态势要素进行综合感知, 使用信息融合技术对感知信息进行融合处理, 实现对动态战场环境的准确理解和敌方作战意图的准确判断, 从而使无人系统达到人类指挥员的认知水平。 自主感知认知能力是无人系统从战场边缘进入战场中心的基础保证。

(2) 自主规划决策

自主规划决策是无人系统在自主感知认知能力基础上, 综合分析战场环境变化和敌我双方作战要素变化, 不依赖指挥员指令进行作战规划, 最终实现任务目标约束下的快速辅助规划决策。 2020年, 在DARPA人工智能近距空战格斗比赛中, 苍鹭公司的自主空战算法以5∶0的总比分击败了经验丰富的美军F-16飞行教官。 自主规划决策能力是提高无人系统作战效能的必然要求。

(3) 自主协同交互

自主协同交互是指利用协同交互技术, 解决多无人系统、 无人/有人系统间的协同问题和人机之间的交互问题, 使无人系统能够跨系统相互通信、 共享信息并与人类协同完成作战任务。 美国“忠诚僚机”项目通过有人机与自主作战无人机高效集成, 实现有人-无人编队协同作战, 对空中、 地面目标实施打击。 自主协同交互能力是无人系统融入联合作战体系的关键要素。

(4) 自主学习

随着现代战争从物理域、 信息域向认知域拓展, 通过学习数据中的模式模型, 开发出具备自主学习和决策能力的无人系统, 使系统具有类人智能[1]。 因此, 未来无人系统不是一成不变的, 而是根据战场态势信息不断学习进化, 这种学习能力将使无人系统实现高度自主。 自主学习能力是推进自主感知认知、 自主规划决策、 自主协同交互向更深层次发展的力量倍增器。

2 航迹规划智能算法优势

2.1 航迹规划问题

无人机自主航迹规划是在满足性能约束和保证飞行安全的前提下, 生成一条连接起点和终点的最优任务航线[12], 其实质是一类多约束条件下的最优化问题。

无人机航迹规划按任务需求可分为预先航迹规划和实时航迹规划。 预先航迹规划是基于环境先验信息的全局优化, 因此在合理时间内得到全局近似最优解更具现实意义; 实时航迹规划是应对突发威胁的航线局部优化, 需要尽量缩短规划时间以达到实时性要求。

求解航跡规划问题的主要方法是将航迹规划问题转换为状态空间的航线优化问题, 利用优化算法获得最优解。 当前, 针对小范围、 已知环境下的航迹规划研究已经较为成熟, 未来重点研究方向是大范围复杂场景和动态不确定环境下的航迹规划研究[13]。 因此, 航迹规划算法的改进、 创新和应用也是未来研究的重点和难点。

2.2 智能算法优势分析

航迹规划算法分为传统优化算法和智能算法两大类。 其中传统优化算法又分为图搜索算法、 空间采样算法、 势场法等。 A*算法[14]作为一种被广泛应用的图搜索算法, 实现较为简单, 但是在大范围高维空间中搜索效率低, 难以解决多约束的航迹规划问题; 快速扩展随机树法[15]是一种典型空间采样算法, 无需离散化飞行环境, 搜索速度快, 但是难以获得最优航线; 人工势场法[16]规划速度快、 实时性好, 但在大范围高维空间中存在局部震荡、 局部极小值等情况导致航线不可用。 因此, 传统优化算法能够在简单环境下具有较好的航迹规划效果, 但是难以高效解决复杂、 动态、 高度不确定性战场环境下的无人机自主航迹规划问题。

近年来, 智能算法因具有高并行性、 强鲁棒性、 自组织自学习等特点, 被广泛应用于复杂环境下的无人机自主航迹规划问题[17]。 与传统优化算法相比, 智能算法在复杂环境下有以下优势:

(1) 鲁棒性。 复杂环境体现在规划空间的复杂。 自主航迹规划问题是NP-hard问题, 传统优化算法在小规模空间中具有明显优势, 随着空间规模增大, 计算复杂度呈指数增加, 易产生“组合爆炸”; 智能算法构建启发式目标(奖励)函数, 采用并行计算和自组织、 自学习方式, 在简单和复杂环境中均表现出良好适用性。

(2) 实时性。 复杂环境也体现在约束条件的复杂, 需全面考虑无人机自身性能约束和动态变化的各类威胁、 障碍, 因此, 自主航迹规划问题是一类多极值优化问题。 与传统优化算法相比, 智能算法在求解多极值优化问题时, 牺牲得到最优航迹的可能却获得更快的收敛速度, 更符合航迹规划实时性需求。

综上, 相比传统优化算法, 智能算法在解决多约束条件下的优化问题上具有明显优势, 更加适用于复杂、 动态、 高度不确定性战场环境下的无人机自主航迹规划。

3 无人机自主航迹规划智能算法

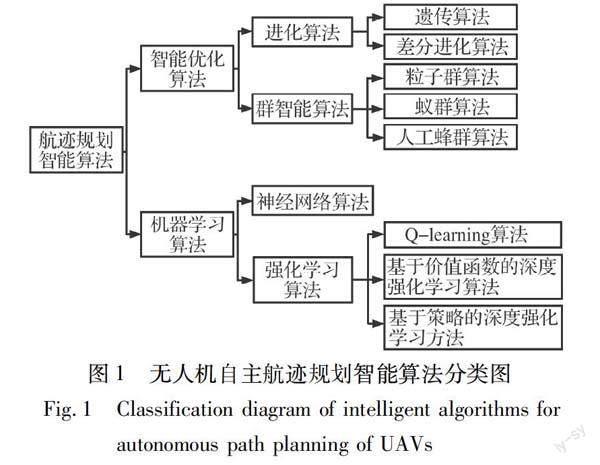

无人机自主航迹规划智能算法分为两类: 智能优化算法和机器学习算法。 图1为无人机自主航迹规划智能算法分类图。

3.1 智能优化算法

智能优化算法通过模拟大自然的某种现象或生物群体的自组织行为解决无人机自主航迹规划等组合优化问题, 具有易实现、 启发性、 并行处理等特点。

3.1.1 进化算法

进化算法来源于大自然的生物进化现象。 在无人机自主航迹规划中常用的进化算法有遗传算法和差分进化算法。

(1) 遗传算法

遗传算法(Genetic Algorithm, GA)是一类基于生物进化论和遗传学机理的随机搜索优化算法[18]。 在航迹规划中, 对初始航线进行基因编码, 依据各类约束建立适应度函数, 通过选择、 交叉、 变异等遗传算子逐代演化出最优航迹。

遗传算法具有鲁棒性、 隐含并行性[19] 特点, 有较强的全局搜索能力, 适用于求解复杂环境的无人机航迹规划问题。 但是遗传算法在算法后期的局部搜索能力差, 同时存在早熟性收敛、 规划时间长的缺点。 针对上述缺点, 研究人员主要从种群初始化、 遗传算子、 种群结构和适应度函数等方面进行改进。

① 种群初始化策略改进。 文献[20]通过Logistic混沌映射生成初始航线, 通过反向搜索降低初始航线交叉概率, 该算法能够提高初始航线质量, 缩短航迹规划时间。 文献[21]针对Logistic映射不能均匀遍历解空间的缺点, 采用Tent映射方法初始化航线, 同时引入自适应遗传算子, 使交叉、 变异概率随适应度值变化自动调整。

② 遗传算子改进。 文献[22]通过改进轮盘赌选择算子和引入插入算子、 删除算子, 保证路径连续且最短, 采用精英保留策略避免了进化过程丢失最优路径。 文献[23]提出基于模糊自适应遗传算法的路径规划方法, 通过模糊逻辑控制器动态调整交叉、 变异概率, 在增强多样性的同时提高路径搜索效率。

③ 种群结构改进。 随着迭代次数增加, 高适应度航线会重复出现(即同质化现象), 导致早熟性收敛。 文献[24]提出一种基于多种群迁移遗传算法的路径规划方法, 将种群划分为多个小种群并赋予不同功能, 利用种群间迁移机制代替选择机制, 有效解决了同质化现象。

④ 适应度函数改进。 文献[25]将转弯次数和航线角度等约束引入适应度函数, 提高航线平滑度, 但是多约束条件下通过线性加权法建立适应度函数, 存在权重选择难题。 针对此问题, 文献[26]提出基于改进NSGA-Ⅱ算法的多目标无人机航迹规划方法, 同时对航线长度、 航线威胁、 最大转弯角等多个目标函数进行优化, 得到一组分布多样化的最优路径。

(2) 差分进化算法

差分进化算法(Differential Evolution, DE)是一类基于群体差异的随机搜索优化算法。 与遗传算法类似, 在航迹规划中, 对初始航线编码建立各类约束的适应度函数, 通过变异、 交叉、 选择等操作, 迭代得到最优航迹。

差分进化算法结构简单、 鲁棒性强, 独特的记忆功能使其具有较强的全局搜索能力, 适用于求解无人机航迹规划等组合优化问题。 针对标准差分进化算法早熟收敛和收缩停滞[27]等缺点, 主要从控制参数、 进化策略和种群结构等方面改进, 也可以与其他优化算法结合使用。

① 控制参数、 进化策略改进。 文献[28]引入基于正弦余弦算法的变异策略、 融合扰动的交叉策略和自适应缩放因子, 改进差分进化算法, 应用于无人机三维航迹规划, 得到能够有效避开各类障碍的更短航线。 文献[29]将改进差分进化算法用于无人机低空突防三维航迹规划, 采用冯·诺依曼拓扑结构和改进变异算子优化进化策略, 使用相对极坐标方式初始化航线缩小解空间, 航迹规划效果优于标准差分进化算法。

② 种群结构改进。 文献[30]提出一种多策略融合的差分进化算法, 通过划分多个子种群并采取不同变异策略, 使算法兼顾全局和局部搜索能力, 同时引入基于教学的参数自适应策略动态调整缩放因子和交叉概率, 有效解决了多目标约束的无人机航迹规划问题。

③ 与其他优化算法结合。 文献[31]提出一种基于APSODE-MS算法的无人机三维航迹规划方法, 在自适应粒子群算法基础上, 引入含动态缩放因子的差分进化算法, 增加航线多样性, 改善粒子群算法收敛速度慢等问题, 具有比传统PSO和DE算法更好的航迹规划效果。

表1为基于进化算法的无人机自主航迹规划方法的改进和对比。

3.1.2 群智能算法

群智能算法主要模拟生物群體与环境交互而表现出的集体自组织行为。 无人机自主航迹规划中常用的群智能算法有粒子群算法、 蚁群算法、 人工蜂群算法等。

(1) 粒子群算法

粒子群算法(Particle Swarm Optimization, PSO)是一类模拟鸟群觅食行为的群智能搜索优化算法。 在航迹规划中, 每个粒子代表一条航线, 建立适应度函数评价粒子的航线质量, 根据粒子间信息共享指导粒子运动由无序向有序演变, 最终得到最优航线。

粒子群算法具有参数设置少、 搜索速度快等优点, 被广泛用于无人机自主航迹规划, 但是易陷入局部最优、 收敛速度慢等缺点影响了算法的应用效果。 研究人员主要从控制参数、 更新策略、 拓扑结构和与其他优化算法结合等方面改进算法。

① 控制参数改进。 文献[32]设计一种随种群进化过程自适应线性变化的加速系数和最大速度, 提高航迹规划的最优性和快速性。 文献[33]采用“阶梯式”惯性权重调整方法, 相比于线性型、 指数型自适应参数调整方法, 提高了航迹规划效率。

② 更新策略改进。 文献[34]提出自适应学习粒子群算法, 在优化阶段从4种粒子更新策略中自适应选择更新策略, 有效提高航线质量。 文献[35]通过在更新规则中引入自适应柯西变异算子, 有效改进航线质量、 减少规划时间。

③ 拓扑结构改进。 文献[36]将全局与局部粒子群算法结合, 提出混合粒子群算法, 与全局或局部粒子群算法相比, 有效缩短多目标航迹规划时间。

④ 与其他优化算法结合。 文献[37]将粒子群算法与可见性图结合求解无人车路径规划问题, 采用基于搜索空间缩减技术的改进Dijkstra算法初始化种群, 有效避免 陷入局部最优。 文献[38]在粒子更新阶段引入正弦余弦算法, 提高船舶避撞路径规划的速度和准确性。

此外, 通过改变搜索空间和粒子编码方式, 研究人员提出多种航迹规划改进算法, 如相位角编码粒子群算法[39](θ-PSO)、 量子粒子群算法[40](QPSO), 这两种改进算法的性能均优于标准粒子群算法, 但是在复杂环境中仍难以找到最优航线。 文献[41]提出一种基于球面矢量的粒子群算法, 将搜索空间从传统笛卡尔空间转移到配置空间, 通过球面矢量的幅值、 仰角和方位角分量与无人机运动分量之间的相互关系实现复杂环境中的无人机航迹规划。

(2) 蚁群算法

蚁群算法(Ant Colony Optimization, ACO)是一类模拟蚂蚁觅食行为的群智能搜索优化算法, 主要包括初始化、 构建问题解和信息素更新三部分。 在航迹规划中, 将空间离散化并赋予初始信息素, 蚂蚁的搜索路径代表可行航迹, 通过信息素迭代更新, 蚁群在正反馈作用下集中到最优航线。

蚁群算法具有正反馈特点, 鲁棒性强、 实现简单, 被广泛用于无人机自主航迹规划, 但是存在易陷入局部最优、 收敛速度慢等问题。 研究人员从信息素初始化、 状态转移规则、 信息素更新策略、 搜索策略、 种群结构等方面改进算法来满足自主航迹规划要求。

① 信息素初始化策略改进。 传统蚁群算法采用均匀分布的信息素初始策略, 导致盲目搜索、 计算量大等问题。 文献[42]综合考虑节点到起点连线距离和节点到终点距离, 提出航线初始信息素非均匀分布策略, 用更少迭代次数得到最优航线。 文献[43]引入人工鱼群算法进行预搜索, 优化信息素初始分布, 将拥挤度因子引入状态转移规则, 实现水下无人航行器三维路徑规划。

② 状态转移规则、 信息素更新策略改进。 状态转移和信息素更新是蚁群算法的核心。 文献[44]将转弯角引导因子和障碍物排除因子引入状态转移规则, 并提出基于路径质量和自适应信息素挥发因子的信息素更新策略, 提高路径规划速度和避障能力。 文献[45]提出动态调整影响因子的参数自适应状态转移策略和差异化-动态分级信息素更新策略, 解决蚁群算法在复杂环境中规划效率低的问题。

③ 搜索策略改进。 文献[46]引入一种三维空间局部搜索策略, 根据无人机机动性能约束, 缩小蚂蚁可选节点范围, 降低空间复杂度。 文献[47]提出一种基于概率的随机游走搜索策略, 通过交替使用布朗运动和柯西运动构造新路径, 平衡算法搜索和收敛能力。

④ 种群结构改进。 文献[48]提出一种双向并行搜索策略, 将蚁群等分为两组, 从起点和终点相向搜索, 改进算法以较快速度找到最优路径。 文献[49]提出一种多种群博弈蚁群算法, 将博弈论相关思想应用于蚁群间信息交流, 提高搜索效率和路径规划质量。

(3) 人工蜂群算法

人工蜂群算法(Artificial Bee Colony, ABC)是一类模拟蜜蜂采蜜行为的群智能搜索优化算法, 由蜜源、 引领蜂、 跟随蜂、 侦察蜂四部分组成。 蜜源代表航迹规划问题的可行解, 引领蜂、 跟随蜂进行航线的局部搜索和信息共享, 侦察蜂在搜索停滞时寻找新航线, 经多次迭代得到的最优蜜源即为最优航线。

人工蜂群算法鲁棒性强, 具有控制参数少、 实现简单等优点, 适用于求解无人机自主航迹规划问题。 但存在局部搜索能力较弱、 收敛速度较慢等缺点。

① 搜索策略和选择策略是人工蜂群算法的核心, 主要从这两方面同时进行改进。 文献[50]提出一种多改进策略融合的无人直升机航迹规划方法, 用搜索策略规则库代替随机搜索策略, 在规则库中融合基于自我知识、 其他个体知识[51]、 最优个体知识、 种群平均知识的4种搜索策略, 根据不同飞行环境选择合适搜索策略, 采用集成反馈机制代替轮盘赌选择策略, 改进算法提高了复杂环境下的航迹规划质量。 针对传统人工蜂群算法随机搜索策略是一维搜索的局限性, 文献[52]提出一种基于强化学习的人工蜂群算法, 首先为引领蜂和跟随蜂设计不同的搜索策略, 引入基于重尾分布的尺度因子, 提高搜索随机性, 其次在引领蜂阶段, 通过强化学习算法动态调整搜索方程中的更新维度, 获得良好的航迹规划效果。 其他改进方法有邻域结构搜索策略[53-54]、 Boltzmann选择策略[55]、 排序选择策略[56]、 随机分组机制选择策略[57]等。

② 从蜜源初始化、 种群结构等方面对算法进行改进。 文献[58]将混沌思想和反向学习方法引入蜜源初始化阶段, 使蜜蜂能够充分搜索解空间, 增加种群多样性。 文献[59]根据种群进化状态自适应调整种群规模, 平衡算法搜索和收敛能力。 文献[60]提出一种自适应多种群人工蜂群算法, 能够根据进化状态调整子种群数量, 具有更好的搜索效果。

(4) 其他算法

除常用算法外, 近些年研究人员将多种新型群智能算法用于求解无人机自主航迹规划问题, 如布谷鸟搜索算法[61](Cuckoo Search, CS)、 蝙蝠算法[62](Bat Algorithm, BA)、 鲸鱼优化算法[63](Whale Optimization Algorithm, WOA)、 樽海鞘群算法[64](Salp Swarm Algorithm, SSA)、 郊狼优化算法[65](Coyote Optimization Algorithm, COA)等, 这些算法均被证明具有良好的航迹规划效果。

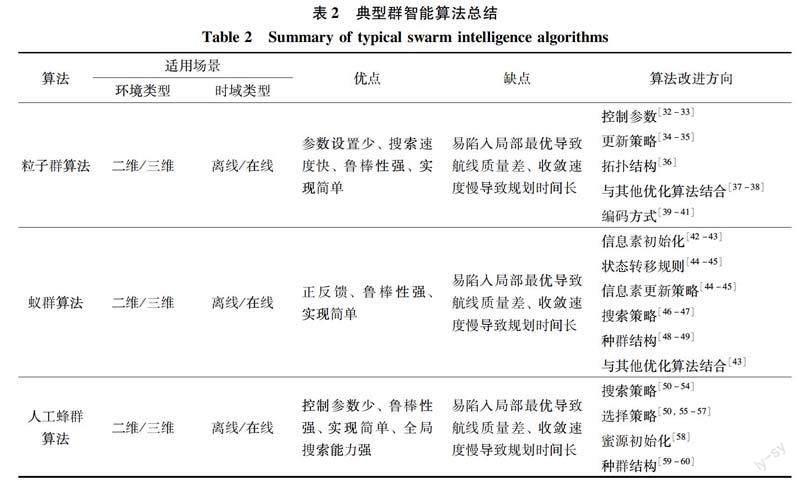

表2为基于群智能算法的无人机自主航迹规划方法的改进和对比。

3.2 机器学习算法

机器学习算法通过模拟人类的学习行为, 实现在航线样本或飞行环境中的自主学习, 解决复杂环境下的无人机自主航迹规划等组合优化问题, 具有自主性强、 实时性好等优势。

3.2.1 神经网络

神经网络(Artificial Neural Networks, ANN)是一类模拟生物神经网络行为的智能计算模型, 由大量简单同质的神经元相互连接而成, 其信息处理方式是一种基于神经元的结构化传递[66]。 神经网络能够拟合复杂非线性函数, 因此具有较好的泛化能力、 非线性映射能力和学习能力, 是无人机自主航迹规划的重要研究方向。

基于神经网络的无人机自主航迹规划方法分为两类。 一是使用神经网络直接生成飞行航线, 再利用其他方法优化航线。 文献[67]将无人机威胁信息、 搜索信息、 位置信息作为神经网络输入, 引擎推力作为网络输出, 使用神经网络直接控制无人机运动, 再通过构建适应度函数, 利用遗传算法选择最优飞行航线, 更新网络参数, 有效解决飞行样本有限、 环境信息未知等问题, 但此类方法存在局限性, 不能确保所得航迹为近似最优解。 二是使用神经网络计算目标函数, 再使用其他方法生成飞行航线。 文献[68]首先使用动态步长策略初始化航迹, 使用神经网络建立威胁能量函数, 网络输入为航点与威胁边缘距离, 输出为航点的威胁能量函数值, 再利用梯度下降法构建关于函数的运动方程, 使航线快速远离威胁。 此类方法利用神经网络并行计算特点, 同时检测航线是否与所有威胁发生碰撞, 缩短目标函数计算时间, 多与智能优化算法结合使用[69-70]。

模糊逻辑是运用模糊集理论求解不确定性问题的人工智能方法, 将模糊逻辑和神经网络相结合, 发挥模糊逻辑推理的结构性知识表达能力和神经网络的自学习能力, 可以实现优势互补。 文献[71]将自适应神经模糊推理系统应用于机器人路径规划中, 通过基于模糊推理的神经网络实现动态障碍下的路径规划。 文献[72]提出一种混合神经模糊控制器, 先将障碍物距离输入神经网络得到目标角, 再将目标角和障碍物距离输入模糊系统得到最佳目标角度值, 控制机器人获得最优路径。

深度神经网络是包含多个隐含层的神经网络, 通过学习飞行样本的内在规律进行航迹规划。 文献[73]提出一种基于残差卷积神经网络的无人机实时航迹规划方法, 从包含环境信息的训练集中提取的无人机位置、 目标位置和局部环境信息作为网络输入, 网络输出为环境状态和无人机航向, 经过离线训练后的网络模型具有较好的实时航迹规划能力。 文献[74]提出一种端到端的神经网络结构, 将三维航迹规划问题转换为神经网络分类问题, 引入动作分解和合成概念, 通过2D卷积神经网络实现值迭代过程, 解决三维航迹规划问题。

3.2.2 强化学习

强化学习(Reinforcement Learning, RL)是指智能体通过与环境交互获得最优行动策略的一类机器学习方法[66]。 智能体依据策略π执行动作at后, 状态st转移至新状态st+1, 同时环境反馈给智能体一个奖励r, 智能体根据奖励r更新行动策略π*并执行新的动作at+1, 智能体通过与环境交互进行“试错”学习, 最终获得最优行动策略。 图2所示为强化学习模型。

无人机航迹规划问题可以转换为从起始状态到目标状态的基于马尔科夫决策过程的强化学习问题, 学习得到的最优行动策略可为无人机在复杂飞行环境下进行自主决策提供依据。 不同于监督学习和无监督学习, 强化学习不依赖样本数据, 因此适用于飞行样本较少的无人机自主航迹规划问题。

文献[75]提出基于接收信号强度的导向强化Q-learning算法, 以接收信号强度作为奖励, 以导向强化原则更新Q函数优化动作选择, 通过在强化学习中引入启发式思想提高无人机在未知环境下的学习效率。 文献[76]提出一种双层Q-learning算法, 低层算法处理静态障碍信息, 用于全局航迹规划, 高层算法处理动态障碍信息, 用于局部航迹规划, 通过在强化学习中引入分层思想协同规划无人机无碰撞路径。

3.2.3 深度强化学习

在航迹规划中, 复杂飞行环境意味着存在高维原始数据输入, 将这些数据直接作为强化学习的状态输入很难被计算机处理和理解, 最终导致维数灾难[77]。 借助深度神经网络的特征学习能力逐层提取环境状态信息, 提高系统处理和泛化能力, 这是深度强化学习(Deep Reinforcement Learning, DRL)的思想。

基于深度强化学习的无人机航迹规划方法按照策略更新方式分为基于价值函数和基于策略的两类方法。

(1) 基于价值函数的深度强化学习方法

基于价值函数的DRL方法是一类间接方法, 通过最大化价值函数间接优化策略。 DeepMind团队提出深度Q网络[78](Deep Q-Network, DQN), 将卷积神经网络与Q-learning算法结合, 使用深度神经网络端到端的拟合Q表, 一定程度解决了维数灾难问题。

文献[79]提出一种ANOA算法用于无人车实时路径规划, ANOA算法采用竞争Q网络(Dueling DQN)结构, 将状态动作值分为状态值函数和动作优势函数两部分, 使网络能够学到在没有动作影响下的环境状态价值, 算法效率优于DQN算法。 文献[80]将基于Rainbow模型的深度强化学习算法应用于海战场路径规划, Rainbow模型融合了Double DQN网络、 优先经验回放、 Dueling网络、 噪声网络、 分布式学习、 多步学习等6种DQN算法改进机制, 实验证明该算法有更優的路径规划效果。 文献[81]将Deep-Sarsa算法用于无人机航迹规划, Deep-Sarsa在Sarsa算法基础上, 同样使用深度神经网络端到端的拟合Q表, 采用同策略(on-policy)学习方法, 学习速度更快, 在实时航迹规划方面有更好表现。

基于价值函数的DRL方法适用于离散动作空间的航迹规划, 但无法处理连续动作空间, 且无法解决随机策略问题[82]。

(2) 基于策略的深度强化学习方法

基于策略的DRL方法是一类直接方法, 通过优化策略搜索方式直接优化策略。 其基本思想是在策略π中引入参数θ构建概率函数πθ(s, a), 通过学习参数θ逐渐逼近最优策略。 参数化的函数形式使算法复杂度不受状态动作数的影响, 且函数输入可以是连续的, 因此适用于高维连续动作空间。

在航迹规划研究中, 基于Actor-Critic的深度强化学习方法是近些年的研究热点。 Actor-Critic算法[83]引入价值函数评估策略函数, 使策略学习方法可以单步更新, 提高学习效率。 其中Actor网络由策略梯度法衍生而来, 通过学习策略函数生成策略, 指导动作选择; Critic网络由价值函数法衍生而来, 通过学习价值函数, 对策略进行估值并反馈给Actor网络进行策略优化。 图3所示为Actor-Critic算法框架。

通过对相关研究的分析总结, 将基于Actor-Critic的DRL方法分为随机策略DRL方法和确定性策略DRL方法。

① 随机策略DRL方法是指在Actor中利用随机策略梯度定理学习策略参数θ进行策略优化, 在Critic中使用深度神经网络拟合价值函数Q。 由于随机策略在相同状态下每次选择的动作不同, 因此算法具有良好的探索性。

信赖域策略优化算法[84](Trust Region Policy Optimization, TRPO)引入信赖域算法进行策略优化, 以KL散度作为步长约束条件, 解决了传统策略梯度算法步长选择不合理的问题, 但是计算过程复杂, 未能解决实际航迹规划问题。

近端策略优化算法[85](Proximal Policy Optimization, PPO)是TRPO算法的简化版本。 算法将新旧策略的KL散度作为惩罚项, 大幅简化计算步骤, 学习效率更高。 文献[86]提出一种基于Safe-PPO算法的路径规划方法, 在PPO算法中引入协方差自适应进化策略, 解决传统PPO算法的方差适应性问题。 文献[87]提出一种基于异步多线程 PPO算法的航迹规划方法, 引入异步机制统一全局和局部规划过程, 提高学习效率。

针对PPO算法大量采样导致学习效率较低的问题, 文献[88]提出了SAC(Soft Actor-Critic)算法, SAC算法是一类基于最大熵框架的异策略(off-policy)随机策略梯度算法, 最大熵强化学习框架平均动作选择概率, 提高空间探索能力, off-policy方法减少了样本采样次数, 提高学习效率。 在航迹规划应用中, 文献[89]将多层并行注意力机制网络模型引入SAC算法, 通过多代理系统与注意力机制相结合提高算法性能, 实现未知动态环境下的高效路径规划。 文献[90]提出一种改进SAC算法, 通过建立综合奖励函数将问题描述为最大化奖励的策略问题, 引入优先经验回放机制改变样本权重, 解决随机抽样样本利用率低的问题, 实现机器人自主避障规划。

② 确定性策略DRL方法是指在Actor中利用确定性策略梯度定理最大化价值函数Q进行策略优化, 在Critic中使用深度神经网络拟合价值函数Q。 由于确定性策略在相同状态下每次选择的动作是确定的, 采样数据更少、 效率更高, 因此算法更适合高维连续动作空间。

文献[91]提出深度确定性策略梯度算法(Deep Deterministic Policy Gradient, DDPG)。 该算法基于上述思想构造4个网络学习策略函数和价值函数, 通过独立目标网络和经验回放机制打破数据相关性。 在航迹规划应用中, 文献[92]提出一种相关经验学习DDPG算法以解决无人机自主运动规划问题, 引入双重筛选抽样方法, 利用优先经验回放机制和经验相关性函数找到最适合当前无人机状态的旧经验进行学习, 同时调整学习和动作选择顺序, 增加学习过程对当前状态动作选择的影响, 获得比DDPG算法更好的航迹规划效果。 双延迟深度确定性策略梯度算法[93](Twin Delayed DDPG, TD3)是DDPG算法的改进版本, 通过加入目标策略平滑、 裁剪双Q网络、 策略延迟更新三种改进方法, 解决DDPG算法过高估计问题, 提高了算法效率。 文献[94]提出一种具有双流网络结构的改进TD3算法, 该算法从环境变化信息中提取环境特征, 感知动态障碍物运动趋势, 使无人机能够在动态环境中安全快速地到达终点。

3.3 算法应用比较

智能优化算法和机器学习算法均适用于无人机自主航迹规划问题, 其中智能优化算法长于搜索而不擅长学习, 机器学习算法长于学习而不擅长搜索。 通过梳理智能算法研究现状, 对比智能优化算法和机器学习算法应用情况, 得到相关结论。

(1) 智能优化算法结构简单、 易于实现, 对计算机配置要求不高, 更适合在地面控制站使用。 其多为启发式算法, 可拓展性强, 通过融合多重改进策略, 适用于多样化场景的预先航迹规划。

但是, 在解空间变大时, 该算法普遍存在易陷入局部最优、 收敛速度慢的缺点, 难以把握搜索和收敛的平衡, 导致航线规划质量没有保证、 规划时间较长等问题, 因此在复杂环境下的实时航迹规划效果不理想。

(2) 机器学习算法具有非线性映射能力, 通过学习航线数据的内在规律得到一个航迹规划策略, 当环境发生变化需要航线重规划时, 无需像智能优化算法那样需要重新进行搜索, 适用于实时航迹规划。

数据驱动是机器学习的特点, 但無人机航线数据较少, 制约了机器学习在航迹规划中的应用; 深度强化学习存在不稳定性, 如算法初期盲目搜索会影响规划效率, 数据训练不充分、 超参数设置不合理均会影响航线质量; 此外, 机器学习是黑箱模型, 在实际作战使用中存在着信任问题。

4 展望

无人机自主航迹规划智能算法仍存在很多问题有待深入研究, 可从5个方面进行梳理。

(1) 贴近真实战场的环境模型

近些年, 无人机实时三维航迹规划成为研究热点, 但是在成果和论文数量方面仍少于二维预先航迹规划[17]。 随着各类无人机在战场上的广泛运用, 二维预先航迹规划无法保证无人机安全性和任务能力, 迫切需要无人机具备实时航迹规划能力, 以应对复杂、 动态、 高度不确定的战场环境。 传统优化方法依赖先验环境信息, 处理复杂问题时易出现维数爆炸, 难以解决不确定性信息。 因此, 未來研究应围绕构建贴近真实战场的实时三维环境模型展开, 同时, 如何提高智能算法在该类模型下的实时性和规划效率, 也是未来研究重点。

(2) 考虑多类约束的目标函数

智能算法通过设计目标(奖励)函数求解最优航迹, 现有算法中目标函数考虑要素较少, 难以保证所得航迹的最优性、 可靠性。 因此, 设计目标函数时, 应考虑在满足任务需求和各类约束条件下的最小化飞行成本(包括飞行时间或航迹长度等)。 其中, 约束通常分为两类, 性能约束即无人机动力学约束, 如最小转弯角、 最大俯仰角、 升限等, 环境约束指环境中各类障碍和威胁, 如地形、 建筑、 敌方侦察打击装备等。 此外, 构造目标函数时, 大部分文献通过线性加权法将多目标优化问题转换为单目标优化问题求解, 实现简单但难以保证航迹最优。 梯度下降法直接优化[95]和神经网络非线性逼近[68]被认为是解决此类问题的有效方法。 因此, 设计合理的目标函数是未来研究中亟待解决的问题。

(3) 智能优化算法的设计改进

智能优化算法是一类结果型算法, 即算法优化过程是通过直接对随机生成的解集进行选择、 优化等操作得到最优解。 此类算法便于理解、 易于实现, 但是存在一些问题: 复杂环境下运算量大、 易陷入局部最优、 难以把握搜索和收敛的平衡。 因此, 未来在基于智能优化算法的无人机自主航迹规划方法研究中, 一是要将研究重心放在提高算法搜索效率和搜索精度上, 同时注重使用新的智能算法[96-97], 因为这些算法与经典智能优化算法相比, 融合并优化了更多改进策略, 易于实现且效率更高; 二是在搜索解空间时要注重客观性、 有效性, 把握不同规划阶段对搜索和收敛能力的需求, 提高算法的自组织、 自学习能力。

(4) 机器学习算法的设计改进

机器学习算法是一类过程型算法, 即算法优化过程是通过学习数据中的规律求最优解。 机器学习算法理论上更适合复杂动态的战场环境, 但是存在依赖大量飞行数据、 模型训练时间较长等问题, 限制了其在无人机自主航迹规划中的应用。 因此, 未来在基于机器学习算法的无人机自主航迹规划方法研究中, 一是要将基于模型和无模型的机器学习算法相结合, 先从数据中学习环境模型, 再基于模型进行策略优化并反向更新模型, 实现两种方法的优势互补; 二是要实现机器学习算法中多源域的特征迁移、 任务迁移, 通过提高迁移能力提高航迹规划算法通用性; 三是要将机器学习与逻辑推理结合, 开展机器学习可解释性研究, 解决信任危机。

(5) 基于算法融合的设计改进

利用算法互补性, 将多种优化算法融合用于无人机自主航迹规划, 弥补单一智能算法的缺陷, 是另一种算法改进方法。 常用融合方法有: 在不同规划阶段针对性选择不同算法或者利用一种算法的优点弥补另一算法的不足。 此外, 文献[73]提供了另一种改进思路, 将A*算法在不同训练场景中得到的最优路径作为样本用于训练深度神经网络, 再将经过训练后的神经网络用于无人机实时航迹规划。 但是当前关于融合算法的研究较少, 同时融合算法会增加算法复杂度和计算成本。 因此, 如何设计算法融合策略, 使融合算法充分发挥各自优势, 将是未来重要的研究方向。

5 结语

由于智能算法在复杂、 动态、 高度不确定性战场环境下的良好适应性, 其被广泛应用于求解无人机自主航迹规划问题。 研究表明, 智能优化算法适用于地图规模较小或实时性要求不高的预先航迹规划任务, 机器学习算法适用于实时性要求高的实时航迹规划任务。

无人机自主航迹规划智能算法仍需持续深入地探索和发展, 未来的研究重点是改进各类智能算法的自身缺陷, 同时结合航迹规划的特性, 提高算法搜索效率和搜索精度。

参考文献:

[1] Fahey H K M, Miller M J.Unmanned Systems Integrated Roadmap FY2017-2042[R]. Washington D C: Department of Defense, 2018.

[2] Suguna S K, Dhivya M, Paiva S. Artificial Intelligence(AI): Recent Trends and Applications[M]. Boca Raton: CRC Press, 2021.

[3] United States Air Force Unmanned Aircraft Systems Flight Plan 2009-2047[R]. Washington D C: USAF, 2009.

[4] Sebbane Y B. Intelligent Autonomy of UAVs: Advanced Missions and Future Use[M]. Boca Raton: CRC Press, 2018: 11-15.

[5] Clough B. Metrics, Schmetrics! How Do You Track a UAVs Autonomy? [C]∥1st UAV Conference, AIAA, 2002: 3499.

[6] Unmanned Systems Integrated Roadmap FY2011-2036[R]. Washington D C: Department of Defense, 2011.

[7] Zacharias G L. Autonomous Horizons: The Way Forward[M]. Alabama: Air University Press, 2019: 12-33.

[8] 高劲松, 邹庆元, 陈哨东. 无人机自主性概念研究[J]. 电光与控制, 2007(5): 58-61.

Gao Jinsong, Zou Qingyuan, Chen Shaodong. Study on the Concept of Autonomy for UAV[J]. Electronics Optics & Control, 2007(5): 58-61.(in Chinese)

[9] 胡晓峰, 荣明. 智能化作战研究值得关注的几个问题[J]. 指挥与控制学报, 2018(3): 195-200.

Hu Xiaofeng, Rong Ming. Several Important Questions of Intelligent Warfare Research[J]. Journal of Command and Control, 2018(3): 195-200.(in Chinese)

[10] 刘畅, 谢文俊, 张鹏, 等. 复杂威胁环境下无人机实时航线规划逻辑架构[J]. 北京航空航天大学学报, 2020(10): 1948-1957.

Liu Chang, Xie Wenjun, Zhang Peng, et al. UAV Real-Time Route Planning Logical Architecture in Complex Threat Environment[J]. Journal of Beijing University of Aeronautics and Astronautics, 2020(10): 1948-1957.(in Chinese)

[11] 郑剑. 面向任务的无人作战系统自主性等级评估与分配技术研究[D]. 长沙: 国防科技大学, 2019: 12-15.

Zheng Jian. Research on Autonomy Levels Evaluation and Assignment Technology of Mission-Oriented Unmanned Combat System[D]. Changsha: National University of Defense Technology, 2019: 12-15.(in Chinese)

[12] Aggarwal S, Kumar N. Path Planning Techniques for Unmanned Aerial Vehicles: A Review, Solutions, and Challenges[J]. Computer Communications, 2020, 149: 270-299.

[13] Shahid N, Abrar M, Ajmal U, et al. Path Planning in Unmanned Aerial Vehicles: An Optimistic Overview[J]. International Journal of Communication Systems, 2022, 35(6): e5090.

[14] 张一豆, 赵剡, 魏彤. 基于改进A*算法的导盲避障路径规划策略研究[J]. 航空兵器, 2017(3): 86-92.

Zhang Yidou, Zhao Yan, Wei Tong. Improved A* Algorithm for Obstacle Avoidance Path Planning Strategy of the Blind[J]. Aero Weaponry, 2017(3): 86-92.(in Chinese)

[15] 高升, 艾劍良, 王之豪. 混合种群RRT无人机航迹规划方法[J]. 系统工程与电子技术, 2020(1): 101-107.

Gao Sheng, Ai Jianliang, Wang Zhihao. Mixed Population RRT Algorithm for UAV Path Planning[J]. Systems Engineering and Electronics, 2020(1): 101-107.(in Chinese)

[16] 韩尧, 李少华. 基于改进人工势场法的无人机航迹规划[J]. 系统工程与电子技术, 2021(11): 3305-3311.

Han Yao, Li Shaohua. UAV Path Planning Based on Improved Artificial Potential Field[J]. Systems Engineering and Electro-nics, 2021(11): 3305-3311.(in Chinese)

[17] Zhao Y J, Zheng Z, Liu Y. Survey on Computational-Intelligence-Based UAV Path Planning[J]. Knowledge-Based Systems, 2018, 158: 54-64.

[18] 段玉倩, 贺家李. 遗传算法及其改进[J]. 电力系统及其自动化学报, 1998(1): 39-52.

Duan Yuqian, He Jiali. Genetic Algorithm and Its Modification[J]. Proceedings of the CSU-EPSA, 1998(1): 39-52.(in Chinese)

[19] Holland J H. Adaptation in Natural and Artificial Systems: An Introductory Analysis with Applications to Biology, Control, and Artificial Intelligence[M]. Ann Arbor: University of Michigan Press, 1992.

[20] Gao M S, Liu Y X, Wei P F. Opposite and Chaos Searching Genetic Algorithm Based for UAV Path Planning[C]∥ IEEE 6th International Conference on Computer and Communications, 2020.

[21] 文超, 董文瀚, 解武杰, 等. 基于CEA-GA的多无人机三维协同曲线航迹规划方法[J/OL]. 北京航空航天大学学报. [2022-09-13]. https:∥doi.org/10.13700/j.bh.1001-5965.2021.0787.

Wen Chao, Dong Wenhan, Xie Wujie, et al. Multi-UAVs 3D Cooperative Curve Path Planning Method Based on CEA-GA [J/OL]. Journal of Beijing University of Aeronautics and Astronautics.[2022-09-13]. https:∥doi.org/10. 13700/ j.bh.1001-5965.2021.0787.(in Chinese)

[22] 魏彤, 龙琛. 基于改进遗传算法的移動机器人路径规划[J]. 北京航空航天大学学报, 2020(4): 703-711.

Wei Tong, Long Chen. Path Planning for Mobile Robot Based on Improved Genetic Algorithm[J]. Journal of Beijing University of Aeronautics and Astronautics, 2020(4): 703-711.(in Chinese)

[23] 王吉岱, 王新栋, 田群宏, 等. 基于改进模糊自适应遗传算法的移动机器人路径规划[J]. 机床与液压, 2021(23): 18-23.

Wang Jidai, Wang Xindong, Tian Qunhong, et al. Mobile Robot Path Planning Based on Improved Fuzzy Adaptive Genetic Algorithm[J]. Machine Tool & Hydraulics, 2021(23): 18-23.(in Chinese)

[24] Hao K, Zhao J, Yu K, et al. Path Planning of Mobile Robots Based on a Multi-Population Migration Genetic Algorithm[J]. Sensors, 2020, 20(20): E5873.

[25] 牛秦玉, 李博. 基于模拟退火遗传算法的全向AGV路径规划[J/OL]. 计算机集成制造系统. [2022-09-13]. https:∥kns.cnki.net/ kcms/detail/11.5946.TP.20220517.1105. 014. html.

Niu Qinyu, Li Bo. Omnidirectional AGV Path Planning Based on Simulated Annealing Genetic Algorithm[J/OL]. Computer Integrated Manufacturing Systems. [2022-09-13]. https:∥kns.cnki. net/kcms/detail/11.5946.TP.20220517.1105.014. html. (in Chinese)

[26] 樊娇, 雷涛, 董南江, 等. 基于改进NSGA-Ⅱ算法的多目标无人机路径规划[J]. 火力与指挥控制, 2022(2): 43-48.

Fan Jiao, Lei Tao, Dong Nanjiang, et al. Multi-Objective UAV Path Planning Based on an Improved NSGA-ⅡAlgorithm[J]. Fire Control & Command Control, 2022(2): 43-48.(in Chinese)

[27] 丁青锋, 尹晓宇. 差分进化算法综述[J]. 智能系统学报, 2017(4): 431-442.

Ding Qingfeng, Yin Xiaoyu. Research Survey of Differential Evolution Algorithms[J]. CAAI Transactions on Intelligent Systems, 2017(4): 431-442.(in Chinese)

[28] 张宗豪, 徐斌, 胡铮. 应用改进差分进化算法的三维路径规划[J]. 电光与控制, 2022(6): 6-10.

Zhang Zonghao, Xu Bin, Hu Zheng. Application of Modified Differential Evolution Algorithm in 3D Path Planning[J]. Electronics Optics & Control, 2022(6): 6-10.(in Chinese)

[29] 彭志红, 孙琳, 陈杰. 基于改进差分进化算法的无人机在线低空突防航迹规划[J]. 北京科技大学学报, 2012(1): 96-101.

Peng Zhihong, Sun Lin, Chen Jie. Online Path Planning for UAV Low-Altitude Penetration Based on an Improved Differential Evolution Algorithm[J]. Journal of University of Science and Technology Beijing, 2012(1): 96-101.(in Chinese)

[30] Chai X Z, Zheng Z S, Xiao J M, et al. Multi-Strategy Fusion Differential Evolution Algorithm for UAV Path Planning in Complex Environment[J]. Aerospace Science and Technology, 2022, 121: 107287.

[31] 鲁亮亮, 代冀阳, 应进, 等. 基于APSODE-MS算法的无人机航迹规划[J]. 控制与决策, 2022(7): 1695-1704.

Lu Liangliang, Dai Jiyang, Ying Jin, et al. UAV Trajectory Planning Based on APSODE-MS Algorithm[J]. Control and Decision, 2022(7): 1695-1704.(in Chinese)

[32] Shao S, Peng Y, He C, et al. Efficient Path Planning for UAV Formation via Comprehensively Improved Particle Swarm Optimization[J]. ISA Transactions, 2020, 97: 415-430.

[33] 方群, 徐青. 基于改进粒子群算法的无人机三维航迹规划[J]. 西北工业大学学报, 2017(1): 66-73.

Fang Qun, Xu Qing. 3D Route Planning for UAV Based on Improved PSO Algorithm[J]. Journal of Northwestern Polytechnical University, 2017(1): 66-73.(in Chinese)

[34] Li G S, Chou W S. Path Planning for Mobile Robot Using Self-Adaptive Learning Particle Swarm Optimization[J]. Science China Information Sciences, 2017, 61(5): 1-18.

[35] 巫茜, 羅金彪, 顾晓群, 等. 基于改进PSO的无人机三维航迹规划优化算法[J]. 兵器装备工程学报, 2021(8): 233-238.

Wu Qian, Luo Jinbiao, Gu Xiaoqun, et al. Optimization Algorithm for UAV 3D Track Planning Based on Improved PSO Method[J]. Journal of Ordnance Equipment Engineering, 2021(8): 233-238.(in Chinese)

[36] 冯辉, 刘梦佳, 徐海祥. 基于AHPSO算法的无人艇多目标路径规划[J]. 华中科技大学学报:自然科学版, 2018,46(6): 59-64.

Feng Hui, Liu Mengjia, Xu Haixiang. Multi-Target Path Planning for Unmanned Surface Vessel Based on AHPSO[J]. Journal of Huazhong University of Science and Technology: Natural Science Edition, 2018, 46(6): 59-64.(in Chinese)

[37] Krell E, King S A, Garcia Carrillo L R. Autonomous Surface Vehicle Energy-Efficient and Reward-Based Path Planning Using Particle Swarm Optimization and Visibility Graphs[J]. Applied Ocean Research, 2022, 122: 103125.

[38] Xue H. A Quasi-Reflection Based SC-PSO for Ship Path Planning with Grounding Avoidance[J]. Ocean Engineering, 2022, 247: 110772.

[39] Hoang V T, Phung M D, Dinh T H, et al. Angle-Encoded Swarm Optimization for UAV Formation Path Planning[C]∥ IEEE/RSJ International Conference on Intelligent Robots and Systems, 2018.

[40] 金建海, 孙俊, 张安通, 等. 基于量子粒子群优化算法的无人艇航线规划[J]. 船舶力学, 2020, 24(3): 352-361.

Jin Jianhai, Sun Jun, Zhang Antong, et al. USV Path Planning Based on Quantum-Behaved Particle Swarm Optimization[J]. Journal of Ship Mechanics, 2020, 24(3): 352-361.(in Chinese)

[41] Phung M D, Ha Q P. Safety-Enhanced UAV Path Planning with Spherical Vector-Based Particle Swarm Optimization[J]. Applied Soft Computing, 2021, 107(2): 107376.

[42] 刘双双, 黄宜庆. 多策略蚁群算法在机器人路径规划中的应用[J]. 计算机工程与应用, 2022, 58(6): 278-286.

Liu Shuangshuang, Huang Yiqing. Application of Multi-Strategy Ant Colony Algorithm in Robot Path Planning[J]. Computer Engineering and Applications, 2022, 58(6): 278-286.(in Chinese)

[43] 胡致远, 王征, 杨洋, 等. 基于人工鱼群-蚁群算法的UUV三维全局路径规划[J]. 兵工学报, 2022, 43(7): 1676-1684.

Hu Zhiyuan, Wang Zheng, Yang Yang, et al. Three-Dimensional Global Path Planning for UUV Based on Artificial Fish Swarm and Ant Colony Algorithm[J]. Acta Armamentarii, 2022, 43(7): 1676-1684.(in Chinese)

[44] Miao C W, Chen G Z, Yan C L, et al. Path Planning Optimization of Indoor Mobile Robot Based on Adaptive Ant Colony Algorithm[J]. Computers & Industrial Engineering, 2021, 156: 107230.

[45] 肖金壯, 余雪乐, 周刚, 等. 一种面向室内AGV路径规划的改进蚁群算法[J]. 仪器仪表学报, 2022, 43(3): 277-285.

Xiao Jinzhuang, Yu Xuele, Zhou Gang, et al. An Improved Ant Colony Algorithm for Indoor AGV Path Planning[J]. Chinese Journal of Scientific Instrument, 2022, 43(3): 277-285.(in Chinese)

[46] 魏江, 王建军, 王健, 等. 基于改进蚁群算法的三维航迹规划[J]. 计算机工程与应用, 2020, 56(17): 217-223.

Wei Jiang, Wang Jianjun, Wang Jian, et al. 3D Path Planning Based on Improved Ant Colony Algorithm[J]. Computer Engineering and Applications, 2020, 56(17): 217-223.(in Chinese)

[47] Liu J, Anavatti S, Garratt M, et al. Modified Continuous Ant Co-lony Optimisation for Multiple Unmanned Ground Vehicle Path Planning[J]. Expert Systems with Applications, 2022, 196: 116605.

[48] 赵娟平, 高宪文, 符秀辉. 改进蚁群优化算法求解移动机器人路径规划问题[J]. 南京理工大学学报, 2011(5): 637-641.

Zhao Juanping, Gao Xianwen, Fu Xiuhui. Improved Ant Colony Optimization Algorithm for Solving Path Planning Problem of Mobile Robot[J]. Journal of Nanjing University of Science and Technology, 2011(5): 637-641.(in Chinese)

[49] 陈银燕, 高安邦. 机器人导航路径的多种群博弈蚁群规划策略[J]. 机械设计与制造, 2021(1): 272-276.

Chen Yinyan, Gao Anbang. Robot Navigation Path Planning Strate-gy Based on Multi-Population Game Ant Colony Algorithm[J]. Machinery Design & Manufacture, 2021(1): 272-276.(in Chinese)

[50] Han Z L, Chen M, Shao S Y, et al. Improved Artificial Bee Colony Algorithm-Based Path Planning of Unmanned Autonomous Helicopter Using Multi-Strategy Evolutionary Learning[J]. Aerospace Science and Technology, 2022, 122: 107374.

[51] Chen X, Tianfield H, Li K J. Self-Adaptive Differential Artificial Bee Colony Algorithm for Global Optimization Problems[J]. Swarm and Evolutionary Computation, 2019, 45: 70-91.

[52] Cui Y B, Hu W, Rahmani A. A Reinforcement Learning Based Artificial Bee Colony Algorithm with Application in Robot Path Planning[J]. Expert Systems with Applications, 2022, 203: 117389.

[53] Xiao S Y, Wang H, Wang W J, et al. Artificial Bee Colony Algorithm Based on Adaptive Neighborhood Search and Gaussian Perturbation[J]. Applied Soft Computing, 2021, 100: 106955.

[54] Ye T Y, Wang W J, Wang H, et al. Artificial Bee Colony Algorithm with Efficient Search Strategy Based on Random Neighborhood Structure[J]. Knowledge-Based Systems, 2022, 241: 108306.

[55] Chen M R, Chen J H, Zeng G Q, et al. An Improved Artificial Bee Colony Algorithm Combined with Extremal Optimization and Boltzmann Selection Probability[J]. Swarm and Evolutionary Computation, 2019, 49: 158-177.

[56] 孔德鵬, 常天庆, 戴文君, 等. 基于排序选择和精英引导的改进人工蜂群算法[J]. 控制与决策, 2019, 34(4): 781-786.

Kong Depeng, Chang Tianqing, Dai Wenjun, et al. An Improved Artificial Bee Colony Algorithm Based on the Ranking Selection and the Elite Guidance[J]. Control and Decision, 2019, 34(4): 781-786.(in Chinese)

[57] Zeng T, Wang W J, Wang H, et al. Artificial Bee Colony Based on Adaptive Search Strategy and Random Grouping Mechanism[J]. Expert Systems with Applications, 2022, 192: 116332.

[58] 魏锋涛, 岳明娟, 郑建明. 基于改进邻域搜索策略的人工蜂群算法[J]. 控制与决策, 2019, 34(5): 965-972.

Wei Fengtao, Yue Mingjuan, Zheng Jianming. Artificial Bee Colo-ny Algorithm Based on Improved Neighborhood Search Strategy[J]. Control and Decision, 2019, 34(5): 965-972. (in Chinese)

[59] Cui L Z, Li G H, Zhu Z X, et al. A Novel Artificial Bee Colony Algorithm with an Adaptive Population Size for Numerical Function Optimization[J]. Information Sciences, 2017, 414: 53-67.

[60] Nseef S K, Abdullah S, Turky A, et al. An Adaptive Multi-Population Artificial Bee Colony Algorithm for Dynamic Optimisation Problems[J]. Knowledge-Based Systems, 2016, 104: 14-23.

[61] Xie C, Zheng H Q. Application of Improved Cuckoo Search Algorithm to Path Planning Unmanned Aerial Vehicle[C] ∥12th International Conference on Intelligent Computing (ICIC), 2016.

[62] Wang G G, Chu H E, Mirjalili S. Three-Dimensional Path Planning for UCAV Using an Improved Bat Algorithm[J]. Aerospace Science and Technology, 2016, 49: 231-238.

[63] Yan Z P, Zhang J Z, Zeng J, et al. Three-Dimensional Path Planning for Autonomous Underwater Vehicles Based on a Whale Optimization Algorithm[J]. Ocean Engineering, 2022, 250: 111070.

[64] 王秋萍, 王彦军, 戴芳. 多策略集成的樽海鞘群算法的机器人路径规划[J]. 电子学报, 2020, 48(11): 2101-2113.

Wang Qiuping, Wang Yanjun, Dai Fang. Multi-Strategy Ensemble Salp Swarm Algorithm for Robot Path Planning[J]. Acta Electronica Sinica, 2020, 48(11): 2101-2113.(in Chinese)

[65] 陈都, 孟秀云. 基于自适应郊狼算法的无人机离线航迹规划[J]. 系统工程与电子技术, 2022, 44(2): 603-611.

Chen Dou, Meng Xiuyun. UAV Offline Path Planning Based on Self-Adaptive Coyote Optimization Algorithm[J]. Systems Engineering and Electronics, 2022, 44(2): 603-611.(in Chinese)

[66] 王东. 机器学习导论[M]. 北京: 清华大学出版社, 2021.

Wang Dong. Introduction to Machine Learning[M]. Beijing: Tsin-ghua University Press, 2021.(in Chinese)

[67] 李波, 杨志鹏, 贾卓然, 等. 一种无监督学习型神经网络的无人机全区域侦察路径规划[J]. 西北工业大学学报, 2021, 39(1): 77-84.

Li Bo, Yang Zhipeng, Jia Zhuoran, et al. An Unsupervised Learning Neural Network for Planning UAV Full-Area Reconnaissance Path[J]. Journal of Northwestern Polytechnical University, 2021, 39(1): 77-84.(in Chinese)

[68] 陈侠, 艾宇迪. 应用改进神经网络的无人机三维航迹规划[J]. 电光与控制, 2018, 25(9): 7-11.

Chen Xia, Ai Yudi. Application of Improved Neural Network in 3D Path Planning of UAVs[J]. Electronics Optics & Control, 2018, 25(9): 7-11.(in Chinese)

[69] 陳秋莲, 郑以君, 蒋环宇, 等. 基于神经网络改进粒子群算法的动态路径规划[J]. 华中科技大学学报:自然科学版, 2021, 49(2): 51-55.

Chen Qiulian, Zheng Yijun, Jiang Huanyu, et al. Improved Particle Swarm Optimization Algorithm Based on Neural Network for Dynamic Path Planning[J]. Journal of Huazhong University of Science and Technology: Natural Science Edition, 2021,49(2): 51-55.(in Chinese)

[70] Duan H B, Huang L Z. Imperialist Competitive Algorithm Optimized Artificial Neural Networks for UCAV Global Path Planning[J]. Neurocomputing, 2014, 125: 166-171.

[71] Pothal J K, Parhi D R. Navigation of Multiple Mobile Robots in a Highly Clutter Terrains Using Adaptive Neuro-Fuzzy Inference System[J]. Robotics and Autonomous Systems, 2015, 72: 48-58.

[72] Muni M K, Parhi D R, Kumar P B, et al. Towards Motion Planning of Humanoids Using a Fuzzy Embedded Neural Network Approach[J]. Applied Soft Computing, 2022, 119: 108588.

[73] Liu Y, Zheng Z, Qin F Y, et al. A Residual Convolutional Neural Network Based Approach for Real-Time Path Planning[J]. Knowledge-Based Systems, 2022, 242: 108400.

[74] Wu K Y, Abolfazli Esfahani M, Yuan S H, et al. TDPP-Net: Achieving Three-Dimensional Path Planning via a Deep Neural Network Architecture[J]. Neurocomputing, 2019, 357: 151-162.

[75] 周彬, 郭艷, 李宁, 等. 基于导向强化Q学习的无人机路径规划[J]. 航空学报, 2021,42(9): 498-505.

Zhou Bin, Guo Yan, Li Ning, et al. Path Planning of UAV Using Guided Enhancement Q-Learning Algorithm[J]. Acta Aeronautica et Astronautica Sinica, 2021,42(9): 498-505.(in Chinese)

[76] Cui Z Y, Wang Y. UAV Path Planning Based on Multi-Layer Rein-forcement Learning Technique[J]. IEEE Access, 2021, 9: 59486-59497.

[77] 闫其粹. 解决强化学习中维数灾问题的方法研究[D]. 苏州: 苏州大学, 2010: 1-4.

Yan Qicui. Researches on the Curse of Dimensionality in Reinforcement Learning[D]. Suzhou: Soochow University, 2010: 1-4.(in Chinese)

[78] Mnih V, Kavukcuoglu K, Silver D, et al. Human-Level Control through Deep Reinforcement Learning[J]. Nature, 2015, 518(7540): 529-533.

[79] Wu X, Chen H L, Chen C G, et al. The Autonomous Navigation and Obstacle Avoidance for USVs with ANOA Deep Reinforcement Learning Method[J]. Knowledge-Based Systems, 2020, 196: 105201.

[80] 杨清清, 高盈盈, 郭玙, 等. 基于深度强化学习的海战场目标搜寻路径规划[J/OL]. 系统工程与电子技术. [2022-10-17]. https:∥kns.cnki.net/kns8/defaultresult/index.

Yang Qingqing, Gao Yingying, Guo Yu, et al. Target Search Path Planning for Naval Battle Field Based on Deep Reinforcement Learning[J/OL]. Systems Engineering and Electronics. [2022-10-17]. https:∥kns.cnki.net/kns8/defaultresult/index. (in Chinese)

[81] Luo W, Tang Q R, Fu C H, et al. Deep-Sarsa Based Multi-UAV Path Planning and Obstacle Avoidance in a Dynamic Environment[C]∥ International Conference on Swarm Intelligence, 2018.

[82] 闫皎洁, 张锲石, 胡希平. 基于强化学习的路径规划技术综述[J]. 计算机工程, 2021, 47(10): 16-25.

Yan Jiaojie, Zhang Qieshi, Hu Xiping. Review of Path Planning Techniques Based on Reinforcement Learning[J]. Computer Engineering, 2021, 47(10): 16-25.(in Chinese)

[83] Grondman I, Busoniu L, Lopes G A D, et al. A Survey of Actor-Critic Reinforcement Learning: Standard and Natural Policy Gra-dients[J]. IEEE Transactions on Systems, Man, and Cybernetics, Part C (Applications and Reviews), 2012, 42(6): 1291-1307.

[84] Schulman J, Levine S, Moritz P, et al. Trust Region Policy Optimization[C]∥32nd International Conference on Machine Learning, 2015: 1889-1897.

[85] Schulman J, Wolski F, Dhariwal P, et al. Proximal Policy Optimization Algorithms[EB/OL].(2017-08-28)[2022-10-17]. https: ∥arxiv.org/pdf/1707.06347.pdf.

[86] 別桐, 朱晓庆, 付煜, 等. 基于Safe-PPO算法的安全优先路径规划方法[J/OL]. 北京航空航天大学学报.[2022-10-17]. https:∥ doi.org/10.13700/j.bh.1001- 5965.2021.0580.

Bie Tong, Zhu Xiaoqing, Fu Yu, et al. Safety Priority Path Planning Method Based on Safe-PPO Algorithm[J/OL]. Journal of Beijing University of Aeronautics and Astronautics.[2022-10-17].https:∥doi.org/10.13700/j.bh.1001-5965.2021.0580.(in Chinese)

[87] He Z C, Dong L, Sun C Y, et al. Asynchronous Multithreading Reinforcement-Learning-Based Path Planning and Tracking for Unmanned Underwater Vehicle[J]. IEEE Transactions on Systems Man Cybernetics-Systems, 2022, 52(5): 2757-2769.

[88] Haarnoja T, Zhou A, Abbeel P, et al. Soft Actor-Critic: Off-Policy Maximum Entropy Deep Reinforcement Learning with a Stochastic Actor[C]∥35th International Conference on Machine Learning, 2018: 1861-1870.

[89] 韩金亮, 任海菁, 吴淞玮, 等. 基于多层注意力机制—柔性AC算法的机器人路径规划[J]. 计算机应用研究, 2020,37(12): 3650-3655.

Han Jinliang, Ren Haijing, Wu Songwei, et al. Robot Path Planning Based on Soft AC Algorithm for Multilayer Attention Mechanism[J]. Application Research of Computers, 2020, 37(12): 3650-3655.(in Chinese)

[90] Chen P Z, Pei J A, Lu W Q, et al. A Deep Reinforcement Learning Based Method for Real-Time Path Planning and Dynamic Obstacle Avoidance[J]. Neurocomputing, 2022, 497: 64-75.

[91] Lillicrap T P, Hunt J J, Pritzel A, et al. Continuous Control with Deep Reinforcement Learning[EB/OL]. (2019-07-05)[2022-10-17]. https:∥arxiv.org/pdf/1509.02971.pdf.

[92] Hu Z J, Gao X G, Wan K F, et al. Relevant Experience Learning: A Deep Reinforcement Learning Method for UAV Autonomous Motion Planning in Complex Unknown Environments[J]. Chinese Journal of Aeronautics, 2021, 34(12): 187-204.

[93] Fujimoto S, van Hoof H, Meger D. Addressing Function Approximation Error in Actor-Critic Methods[EB/OL]. (2018-10-22)[2022-10-17].https:∥arxiv.org/pdf/1802.09477.pdf.

[94] Zhang S T, Li Y B, Dong Q H. Autonomous Navigation of UAV in Multi-Obstacle Environments Based on a Deep Reinforcement Learning Approach[J]. Applied Soft Computing, 2022, 115: 108194.

[95] Gebken B, Peitz S, Dellnitz M. A Descent Method for Equality and Inequality Constrained Multiobjective Optimization Problems[EB/OL]. (2017-12-11)[2022-10-17]. https:∥arxiv.org/pdf/1712.03005.pdf

[96] Hashim F A, Hussien A G. Snake Optimizer: A Novel Meta-Heuristic Optimization Algorithm[J]. Knowledge-Based Systems, 2022, 242: 108320.

[97] Ntakolia C, Iakovidis D K. A Swarm Intelligence Graph-Based Pathfinding Algorithm(SIGPA) for Multi-Objective Route Planning[J]. Computers & Operations Research, 2021, 133: 105358.

Review of Intelligent Algorithms for Autonomous Path Planning of UAVs

Guo Qimin1,2, Zhang Peng1, Wang Yingyang1, Wang Shi3

(1. Equipment Management and UAV Engineering College, Air Force Engineering University, Xian 710051, China;

2. Graduate College, Air Force Engineering University, Xian 710051, China; 3. Unit 93057 of PLA , Siping 136400, China)

Abstract: Autonomous capability is the fundamental ability and direct driving force of UAVs cross-generation upgrade. With the disruptive revolution of artificial intelligence technology, the autonomous path planning technology of UAV based on intelligent algorithm has become a key link to improve the autonomous capability of UAV, which has important research value. This paper firstly summarizes relevant studies of path planning technology at home and abroad, puts forward an understanding of the autonomy of unmanned systems, and analyzes the advantages of intelligent algorithms applied to the autonomous path planning of UAVs. Secondly, starting with algorithm improvement methods, the intelligent algorithms of autonomous path planning of UAVs, such as evolutionary algorithm, swarm intelligence algorithm, neural network, reinforcement learning algorithm and deep reinforcement learning, are classified and summarized. Finally, the future research directions for autonomous path planning technology are prospected based on the current challenges of UAV autonomous path planning.

Key words: UAV; path planning; autonomy; intelligent evolutionary algorithm; machine learning algorithm; algorithm improvement

收稿日期: 2022-10-18

基金項目: 国家自然科学基金项目(62103439); 陕西省自然科学基础研究计划项目(2021JQ-364)

作者简介: 郭启敏(1994-), 男, 山东青岛人, 硕士研究生。

*通信作者: 张鹏(1979-), 男, 山西五台人, 博士, 副教授。