面向性别识别的基于GAN的域自适应模型

2022-07-06吕乔健

吕乔健, 陈 宁

( 华东理工大学信息科学与工程学院,上海 200237)

基于语音的性别识别的目的是检测语音是由男性还是女性发出的[1]。在实际应用中,常将其作为辅助工具嵌入语音识别[2]或说话人识别系统[3]中,以此来提高系统的整体性能。近年来,对多媒体内容的自动分析已成为研究热点,例如通过对电影中每个角色的个人信息(如性别、年龄和种族)进行统计,来评价电影中不同角色的表现。然而,由于电影中的语音信号通常会被音乐、环境噪声或者背景对话等掩盖,使得性别识别任务极具挑战性[4],因此如何让在干净数据集上训练的模型适应于多媒体音频的性别识别成为一个亟需解决的问题。

目前,基于语音的性别识别任务已经得到了很好的研究[5],其中高斯混合模型在性别识别系统中的应用最为广泛,这类方法通常基于MFCC系数进行分类,它们使用有限的数据进行训练可以获得较好的性能[6]。基于i-vector的方法从属于不同说话人的语音片段中提取表示每个人身份的身份认证向量,然后通过LDA或者PLDA进行打分[7]。在性别识别任务中,文献[8]证明了基于i-vector的方法比高斯混合模型具有更好的性能。文献[9]在进行分割语音流中男女说话片段任务中,实现了一种深层的卷积神经网络模型,该网络能够同时结合特征提取、特征降维以及分类功能[10]。在REPAIR语料库上,文献[9]提出的模型比高斯混合模型和i-vector模型实现了更好的性能。但是这些算法在识别多媒体音频时,会出现识别准确率下降的问题。因为这些算法所用的训练集大多是在相对安静或者声学条件单一的情况下采集的(例如希尔贝壳中文普通话语音数据库AISHELL-2[11]是在安静室内环境中录制的),尽管这些算法可以在训练集上达到95%以上的识别准确率,但是在识别多媒体音频时,识别准确率会严重下降,并且由于实际场景数据的缺乏不可能对模型进有监督的训练。

近期,为了提高电影音频场景下基于语音的性别识别准确率,文献[4]和文献[12]分别提出了新的方法。文献[4]通过融合电影音频中不同语言通道(英语、西班牙语和法语)和不同声道的信息来提高系统识别性能。然而并不是所有多媒体音频都像电影音频一样包含多个声道或者多种语言的通道信息,大部分音频也不会被不同国家的配音演员重新配音。在这种情况下,文献[4]的方法就无效了,并且文献[4]的方法除了要识别电影原声语言通道以外,还要识别其他语言的通道,增加了算法的时间复杂度。文献[12]是用预训练后的VGGish模型作为特征提取模块。由于VGGish模型是在Audioset[13]数据集上进行预训练的,所以它对声学条件复杂多变的音频具有较好的特征表现力。文献[12]还通过迁移学习的方式让原本用于音频事件检测任务的模型适应于性别识别任务中。然而这种方法的局限性在于:如果目标域音频与Audioset数据集有较大的差异,那么模型即使在迁移学习后对目标域音频识别效果也不好,甚至可能更差。

为了解决以上问题,本文提出了一个面向性别识别的基于生成对抗网络 (Generative Adversarial Network, GAN)的域自适应模型。首先,结合深度卷积神经网络和GhostVLAD层[14]构建了性别识别模型,利用卷积神经网络对音频的特征进行提取和降维;然后,利用GhostVLAD层减少音频中的噪声以及无关信息的影响;最后,采用基于GAN的域自适应算法,通过无标签的多媒体音频对性别识别模型进行域自适应训练,以进一步提高模型在多媒体音频上的识别准确率。在对抗训练过程中,通过引入辅助损失来保持网络对性别特征的表征能力。实验结果表明,与基于卷积神经网络的性别识别模型[9]相比,本文算法的识别准确率有了大幅度的提高。

1 模型描述

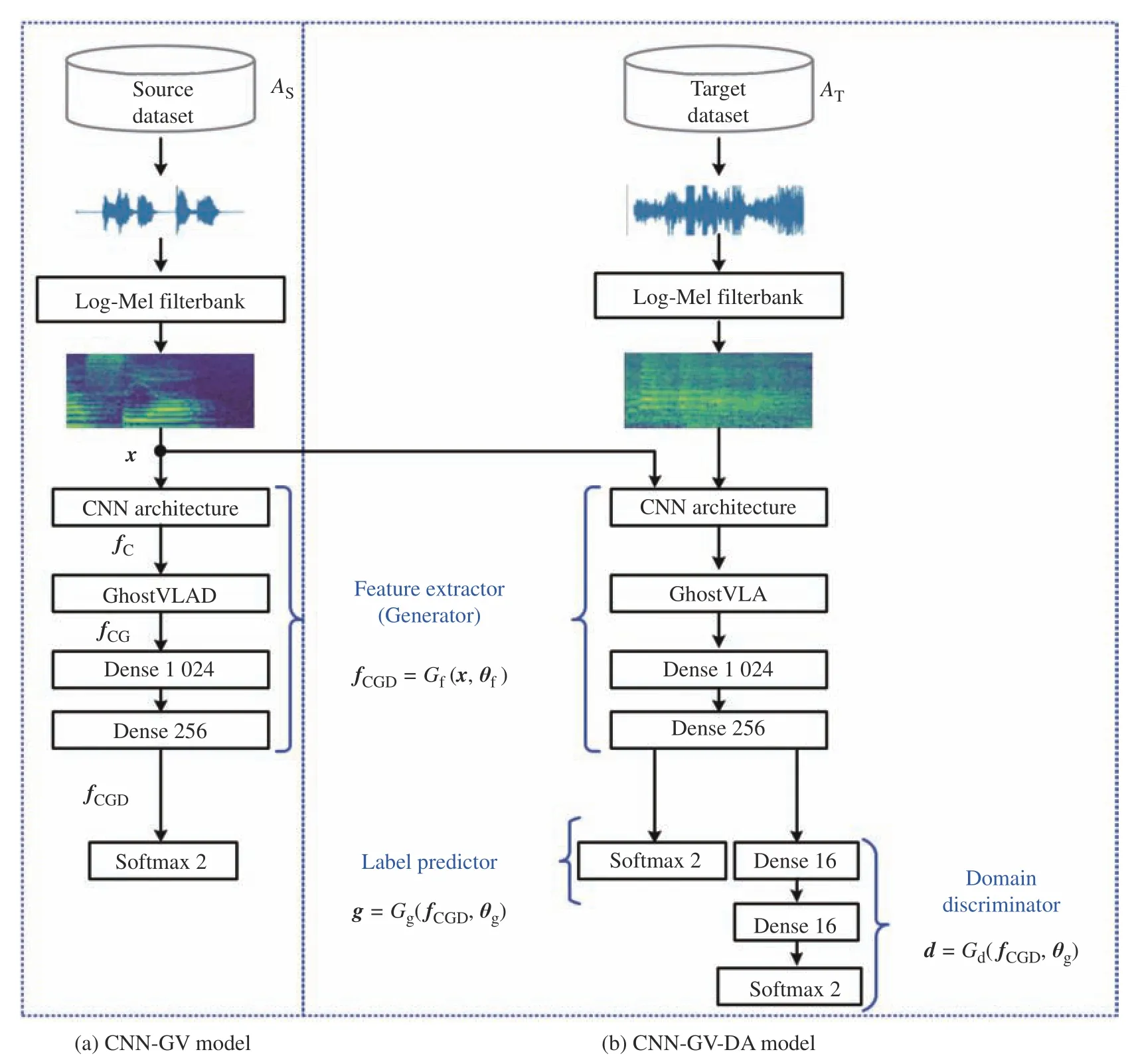

本文提出的性别识别模型框图如图1所示,由两个阶段组成。在第一阶段中(图1(a)),基于深度卷积网络和GhostVLAD层搭建了性别识别模型,称为CNN-GV模型。在第二阶段中(图1(b)),对CNN-GV模型进行基于GAN的域自适应训练,提高其在多媒体音频上的识别准确率,称为CNN-GV-DA模型。其中值得注意的是在第二阶段训练过程中使用无标签的多媒体音频进行非监督训练。

图1 性别识别模型框图Fig. 1 Block diagram of gender identification model

1.1 声学特征

将输入音频的采样率转换为16 kHz,并随机截取0.96 s的语音片段进行预加重、分帧、加窗等预处理,其中分帧时帧长为25 ms,帧移为10 ms;然后对预处理后的信号进行傅里叶变换得到幅度谱,并采用梅尔滤波器组对其滤波以实现梅尔尺度的转换;最后对所有滤波器输出进行对数运算得到Fbank特征。实验采用64个滤波器组成的梅尔滤波器组,归一化后的Fbank特征将作为模型的输入。

1.2 CNN-GV模型

如图1(a)所示,CNN-GV模型由卷积层、GhostVLAD层和全连接层组成,其详细结构如表1所示。与文献[9]相比,CNN-GV模型在卷积层之后引入了GhostVLAD层。局部聚合描述子向量 (Vector of Locally Aggregated Descriptors, VLAD)是一种图像特征提取方法,它可用来捕捉从图像上聚合出的局部描述子的统计信息,并且记录每个局部描述子与其最近的聚类中心的残差总和。NetVLAD[15]层的提出解决了VLAD算法不可微的问题,并且把传统的VLAD结构嵌入到CNN网络结构。在NetVLAD层的基础上,为了筛选出高质量的图像局部描述子,Zhong等[14]提出了GhostVLAD层,它是由NetVLAD层和ghost聚类中心点组成。

表1 CNN-GV模型的结构Table 1 Structure of the CNN-GV model

设输入的归一化Fbank特征为x,卷积层将x(96×64×1)映射成为大6×小2×为512的特征,它可被看成12个维度为512的局部描述子,记为fC={(j),n=1,···,N,j=1,···,D},N=1,2D=,512表示第n个局部描述子。GhostVLAD层设置K个聚类中心点,记为ck。GhostVLAD层将卷积层提取的局部描述子通过式(1)所示的软分配方式分配到不同的聚类中心ck={ck(j),j=1,···,D} ,D=512[16]。

1.3 域自适应算法

域自适应算法的基本思想是寻找一个可以最小化目标域与源域间差异的表示函数,这样在源域上训练的模型就可以用于识别目标域的数据[17]。

1.3.1 基于GAN的域自适应算法 GAN的训练过程是生成器和鉴别器之间的极大极小博弈过程,其中鉴别器将最小化鉴别真假数据过程中的误差,而生成器会最大化鉴别器判断出错的概率[18]。GAN的这一特性使其成为无监督域自适应的理想选择。通过与域鉴别器的对抗,生成器将源域和目标域数据在数据空间或者特征空间对齐[19-20]。

在训练生成器时,为了使生成器最大化域鉴别器判错概率,使用与训练域鉴别器时相反的标签来训练生成器,GAN的目标函数被分成生成器目标函数和域鉴别器目标函数,生成器目标函数如式(3)所示:

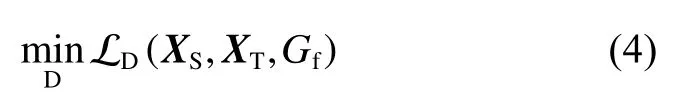

式中: LG表示生成器的损失;XS表示源域数据;XT表示目标域数据;Gd表示域鉴别器。域鉴别器目标函数如式(4)所示:

式中: LD表示域鉴别器损失;Gf表示生成器。

1.3.2 CNN-GV-DA模型CN N-GV-DA模型由生成器Gf(x,θf) 、标签预测器Gg(fCGD,θg) 以及域鉴别器Gd(fCGD,θd) 组成。其中Qf、Qg、Qd表示训练参数。生成器由图1(a)模型中的CNN结构到Softmax层之前的网络组成;标签预测器由一个Softmax层组成;域鉴别器由两个全连接层以及一个Softmax层组成。CNN-GV-DA模型的作用是在缺少目标域性别标签预测器Gg(fCND,θg) 去识别目标域的数据,使得标签的情况下,训练特征提取器Gf(x,θf)以及性别的在第一阶段训练得到的CNN-GV模型可以去识别声学条件复杂多变的多媒体音频数据。

在训练中生成器和域鉴别器被交替训练。首先用源域数据和目标域数据通过二分类交叉熵(Binary CrossEntropy, BCE) 损失 LD(XS,XT,Gf) 训练域鉴别器Gd:

采用式(6)所示的生成器损失函数 LG(XS,XT,Gd)和相反标签来训练生成器Gf:

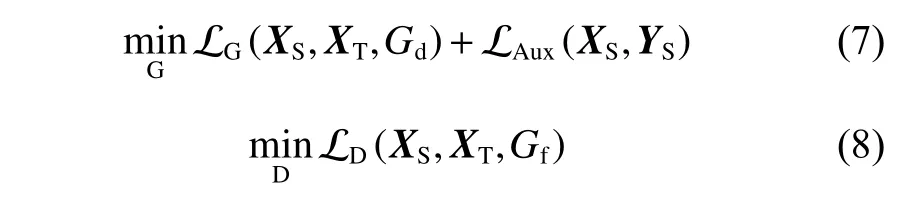

为了在域自适应过程中保持生成器对性别特征的表征能力,本文引入并修改了Auxiliary Classifier GAN (AuxGAN)[21],这样在域自适应阶段,生成器和域鉴别器的目标函数分别如式(7)和(8)所示:

2 实验结果

实验中采用的硬件设备为NVIDIA TITAN Xp显卡(12 GB 显存)以及Intel Xeon CPU E5-2650 v4处理器。训练CNN-GV模型以及CNN-GV-DA的生成器、域鉴别器、以及标签预测器时采用了相同参数的Adam优化器。Adam的参数具体如下:一阶矩估计的指数衰减率为0.9,二阶矩估计的指数衰减率为0.999,学习率为0.001。Batch-size为128,迭代次数为20 000次。

2.1 数据集

采用Voxceleb1[22]数据集作为源域数据,Audioset和 Movie数据集分别作为目标域数据集。

2.1.1 Voxceleb1 Voxceleb1数据集是由来自1 251位被试的超过100 000条的英语语音样本构成。由于样本是从明星红地毯、名人讲台演讲、真人节目访谈、大型体育场解说等视频场景下采集的,因此数据带有一定的真实噪声,如背景人声、笑声、回声、室内噪声、录音设备噪声等,但是背景噪声相对单一,声学条件相对简单。实验中将Voxceleb1按8∶2的比例划分为源域训练集和源域测试集。

2.1.2 Audioset Audioset数据集是Google开源数据集Audioset的一个子集。通过在Audioset中下载标签为“male speech, a man speaking”和“female speech,a woman speaking”的视频文件,再利用FFmpeg工具从视频中提出音频而得到。该数据集包含18 239个时长为10 s的样本,其中男性和女性的样本数分别为5 879和12 360。

由于Audioset中的音频来自YouTube网站,其样本所包含的噪声的种类和强度比Voxceleb1数据集中的样本更加复杂多变。实验中按照17∶3的比例将Audioset划分为目标域训练集和目标域测试集。

2.1.3 Movie 该数据集中的音频来自“Kill Bill 1(2003)、Saving Private Ryan (1998)、I Am Legend (2007)、The Bourne Identity (2002)”等4部好莱坞影片,其性别标签由文献[12]提供,我们进行了校对。实验中所有的音频被切分为2 s的样本,从而构成了1 891个男性样本和388个女性样本。该数据集只作为目标域测试集。

2.2 评估指标

通过计算单个性别上模型的预测正确率,然后计算它们的平均值 (UnWeighted Average, UWA) 作为评价指标,UWA比精度或召回率更适合评估数据分布不平衡的分类问题。

2.3 实验结果

2.3.1 与基准模型的性能比较 实验中复现了文献[9]提出的模型,并将其作为基准模型。本文模型的训练分为两个阶段:第一阶段在源域训练集上对CNNGV进行训练,第二阶段在Audioset目标域训练集上对CNN-GV进行域自适应训练获得CNN-GV-DA。性能对比结果如表2所示,其中CNN-GV-DA(Without GhostVLAD)模型是将GhostVLAD层移除后重新分为两个阶段训练得到的。

表2 模型性能对比Table 2 Performance comparison of models

实验结果表明:(1)无论是在源域还是在目标域上,CNN-GV-DA均取得了比基准模型更高的UWA,其中在Audioset目标域测试集上提高了5.13%,在Movie数据集上提高了7.72%;(2)对于基准模型,与源域的结果相比,Audioset目标域测试集和Movie数据集上的UWA分别下降了14.82%和18.13%;而对于CNN-GV-DA模型,下降的幅度分别为11.56%和12.28%,可以看出,本文提出的域自适应算法可有效缓解由于数据集之间分布差异所造成的性能下降。

2.3.2 GhostVLAD层与域自适应的贡献 表2的实验结果表明:(1)无论是在源域还是在目标域上,CNN-GV-DA的性能均优于CNN-GV-DA (Without GhostVLAD),这说明GhostVLAD层对模型性能提高有贡献;(2)在3个数据集上CNN-GV-DA的性能均优于CNN-GV,说明域自适应处理可有效提高模型性能;(3)域自适应对模型性能提高的贡献大于GhostVLAD的贡献。

3 结束语

本文提出了一种面向性别识别的域自适应模型。在特征提取阶段通过引入GhostVLAD层降低无关信息的干扰;在域自适应阶段采用基于GAN的域自适应策略。在3个公开的数据集上的实验结果表明,本文提出的域自适应模型可有效缓解由于实际数据与训练集之间的差异性所导致的模型性能下降的问题,并且GhostVLAD层和基于GAN的域自适应策略均能提高模型性能。