目标上下文卷积神经网络高分遥感影像语义分割

2021-03-03刘艳飞丁乐乐孟凡效

刘艳飞,丁乐乐,孟凡效

(天津市勘察设计院集团有限公司,天津 300000)

0 引言

随着高分辨率遥感卫星的成功发射,高分辨率遥感影像已经成为对地精细观测的重要数据来源,为地理国情普查、数字城市建设、精细农业等科学和生产领域提供了数据支撑。然而,高分辨率遥感影像所具有的可用光谱波段少、影像信息高度细节化、“异物同谱,同物异谱”等特点为高分辨率遥感影像的分类识别带来了困难和挑战。针对高分辨率遥感影像语义分割任务,国内外学者展开了系列研究,并形成了基于空间结构特征的分割方法[1-3]、面向对象的分割方法[4-6]、基于空间上下文的分割方法[7]和基于深度学习的分割方法[8-12]。

基于空间结构特征的方法挖掘像元和邻域像元的空间模式,提取各种形式的空间结构特征。如何挖掘影像的空间信息,获取描述地物目标的特征是该方法的关键,常用的空间结构特征主要有纹理特征和几何特征。如Zhao等[13]利用高斯马尔可夫随机场提取纹理特征用于高分影像语义分割,Huang等[14]基于加权均值、长宽比和标准差等统计几何信息构建空间结构特征用于像素表达。面向对象的分类方法将无监督分割和语义分割结合,不再将单一像元作为特征提取和分割的研究单元,通过无监督分割获得同质性区域,然后从同质性区域中提取特征并用于同质性区域的语义分割。如许高程等[15]通过多尺度分割在SPOT 5卫星影像上获取不同空间尺度结构下海域使用的地物斑块,并从分割对象中提取光谱、形状和语义特征,建立分类规则集,实现池塘养殖用海域的信息提取。曹凯等[16]采用面向对象的方法对南京市区部分主城区进行水体提取,基于空间上下文的分割方法假设相邻像元更可能属于同一地物类别。首先通过面向像素的分割方法获得类别概率图,然后基于局部滤波或者扩展随机游走算法对类别概率图进行精化,从而得到最终考虑空间信息的分类结果。Zhao等[17]在成对条件随机场模型的基础上,集成光谱信息、局部空间上下文信息以及空间位置信息构建高阶势能函数挖掘影像的大尺度空间上下文信息,从不同视角提供地物判别的互补信息,提高分类制图效果。Zhang等[18]提出用超像素代替单个像素用于条件随机场构图,提出超像素-条件随机场模型考虑空间上下文用于高分影像语义分割。

以上三类方法都需要手工设计特征以及专家先验知识,而且分类过程和特征提取过程分离,分类器无法为特征提取过程提供指导监督信息。深度学习作为一种数据驱动的模型方法,可以从数据中自动学习特征,且在深度学习模型中,分类器也被设计为网络的一层,完成了形式的统一,实现特征提取和分类器学习过程的一体化。由于深度学习强大的特征学习能力,已经被成功应用于高分遥感影像语义分割,并获得广泛关注。如Tao等[19]为解决高分影像语义分割中网络深度增加导致的梯度弥散问题,提出稠密连接网络实现网络深度和表达能力的平衡。

在高分影像语义分割中,由于 “异物同谱,同物异谱”问题,单纯依靠光谱信息无法对地物目标进行精细分类,还需依赖像素空间上下文进行特征提取和分类。卷积神经网络通过堆叠卷积层、池化层进行层次化特征提取,隐式地将空间上下文信息融合到特征提取过程中。然而这种方式仅仅融合了像素自身局部范围的上下文信息,忽略了全局影像中同类目标像素之间的关系。针对这一问题,本文显式地对全局空间目标上下文建模,将目标上下文卷积神经网络(object-context representation CNN,OCRNet)[20]用于高分遥感影像语义分割。OCRNet包含双分支网络,分别为粗分割分支和精分割分支。首先,利用粗分割分支获得每一个像素的类别概率分布;然后,基于粗分割分支得到的类别概率分布和精分割的特征图计算每个类别的特征中心,根据类别特征中心对每个像素进行编码得到编码特征;最后,将像素的编码特征和精分割特征叠加作为最终的表达特征用于精分割分支的语义分割任务。

1 目标上下文卷积神经网络高分遥感影像语义分割

本文采用的方法主要包含四个部分,即骨干网络特征提取、粗语义分割、全局类别中心计算和精细语义分割。总体流程图如图1所示。

图1 目标上下文卷积神经网络高分遥感影像语义分割流程图

设输入影像为I∈RH×W×C及其对应的标注影像为Y∈RH×W,其中H、W、C分别表示影像的行、列和通道数,在本文中通道数为3,即C=3。对于输入影像I,本文利用HRNet作为骨干网络进行基本特征提取,得到基础特征fb,如式(1)所示。

fb=backbone(I)

(1)

式中:backbone表示骨干网络;fb表示提取得到的基础特征图。对于得到的基础特征图fb,对其进行上采样至H×W,并进行卷积操作,得到像素特征图fp=RH×W×S,其中每一个位置处的向量表示像素的特征向量。

在粗语义分割阶段,本文将特征图fb作为粗语义分割网络分支输入进行初步语义分割,得到粗语义分割图fcorse∈RH×W×Cla,其中Cla表示类别数,如式(2)所示。

fcorse=branch-corse(fb)

(2)

式中:branch-corse为粗语义分割模块。在训练阶段,得到fcorse后,计算粗语义分割损失函数,如式(3)所示。

Lcorse=CrossEntropy(fcorse,Y)

(3)

式中:CrossEntropy表示交叉熵损失函数。在粗语义分割模块branch-corse的Cla个通道输出中,每一个通道代表像素对某一类别的响应。因此,在某一类别对应的通道上,属于该类别的像素在该通道上响应值大,不属于该类别的像素在该通道响应值小。在全局类别中心计算阶段,本文利用这一特性从全局中考虑空间上下文,获得每一类像元在特征空间的类别中心。本文将fcorse的每一通道分别进行归一化,并将之作为权值获得该类别对应的类别中心,如式(4)所示。

(4)

式中:mk∈RH×W为fcorse归一化后的第k通道,fcorse,k∈RH×W为fcorse的第k通道,fcorse,k,i∈R表示第i个像素在通道k上的响应值。得到权重mk后,计算每一类对应的特征中心,如式(5)所示。

(5)

式中:fp,i∈RS为像素特征图fp的第i个特征向量;mk,i表示第权重图mk的第i个元素;fcentor,k为第k类的类别中心。

在精细语义分割阶段,本文利用得到的类别中心作为码本对像素特征fp进行编码,得到新的编码特征fc∈RH×W×T,实现全局信息融合,如式(6)所示。

κ(a,b)=φ(a)Tψ(b)

(6)

(7)

(8)

式中:κ(·)为距离函数;φ(·)、ψ(·)、σ(·)和ρ(·)为转换网络,其网络结构为1×1卷积层-BN归一化层-ReLU响应层;wi,k为像素-中心关系矩阵w中的元素,表示第i个像素与第k个类别中心的编码权重;fc,i为全局编码特征图fc的第i个元素,表示第i个像素的编码特征。通过这种编码方式,编码特征fc融合了全部范围内的空间上下文信息。在本文中,得到编码特征fc后,将编码特征与像素特征进行叠加和转化,得到最终的深度融合特征ffus用于遥感影像语义分割,表达如式(9)至式(10)所示。

fcon=[fp,fc]

(9)

ffus=g(fcon)

(10)

式中:[·]表示将两个特征图首尾相连进行叠加;g(·)为转换网络,网络结构同样为1×1卷积层-BN归一化层-ReLU响应层。利用ffus进行精细化分类,表达如式(11)至式(12)所示。

ffine=conv1×1(ffus)

(11)

Lfine=CrossEntropy(ffine,Y)

(12)

式中:conv1×1(·)表示1×1卷积。本文的最终目标函数L如式(13)所示。

L=Lfine+λLcorse

(13)

式中:λ为粗语义分割分支损失函数权重。

在本文采用的方法中,粗语义分割分支提供了基本的类别信息用于对精细分割分支像素特征进行全空间区域的“软聚类”,获得精细分割分支像素特征空间的语义类别中心,并以此为码本对精细分支像素特征进行编码,建立单个与全局内其他同类像素的空间联系,融合全局内同类像素的信息,提高表达能力。相比于传统仅通过逐层卷积来考虑局部区域像素之间空间关系的高分语义分割方法,本文采用的方法为像素之间建立了更为广阔的空间联系。

2 实验与分析

2.1 实验设置

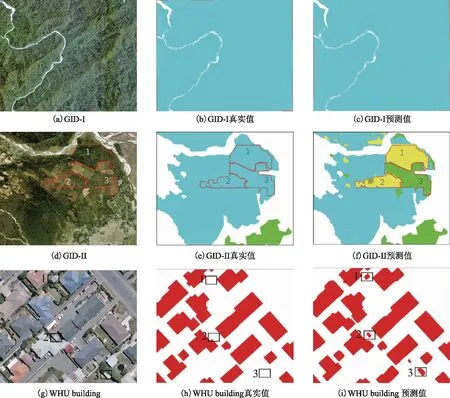

数据集上选用GID[21]和WHU building 数据集[22-23]两个数据集进行实验。GID数据集包含150张高分2号卫星影像,每张影像大小为6 800像素×7 200像素,包含建筑物、农田、森林、草地和水域五个类别。在实验中随机抽取120张影像用于训练,剩余30张用于测试。WHU building数据集是建筑物提取数据集,包含四个子数据集,本文使用WHU building 数据集中的aerial imagery dataset和building change detection dataset两个子数据集进行实验,其中选用“the cropped image tiles and raster labels”和“a_training_aera_before_change”两个数据作为训练集进行模型训练,选用“after_change”和“before_change”作为测试集(测试集为同一区域不同时期的两幅影像)。在实验中,为避免显存溢出问题,本文将每张影像切割成512×512大小作为输入用于模型训练。图2为实验数据代表样本。为使网络获得一个较好的初始化,本文选用在cityscapes数据集[24]上进行过预训练的HRNet对骨干网络参数进行初始赋值。实验在配置有10块Nvidia 2080Ti显卡服务器上进行,迭代次数为3 000,初始学习率为0.003,学习率变化策略为多项式衰减,衰减参数power为0.9,最小学习率设置为0.001,优化方法选用随机梯度下降。本文选用FCN、DeepLabV3Plus[25]、PSPNet[26]、PointRend[27]等方法进行对比实验,采用Kappa系数、总体精度OA、平均交并比MIoU、每类分类精度作为评价指标,对于WHU building dataset,另增加一个交并比IoU作为评价指标。

图2 实验数据示例样本

2.2 实验结果与分析

1)GID数据实验。表1给出了本文的方法OCRNet与对比方法在GID数据集上的语义分割结果。从表1可以看出,本文采用的方法OCRNet在GID数据集上的Kappa、平均交并比MIoU以及总体精度OA分别为97.14、95.08和97.99,获得了最优的分割结果,相比于次优的PointRend,在Kappa、MIoU、OA三个指标上分别提升0.9、1.87、0.6,有效证明了OCRNet有效性。在单类分割结果上,本文的方法OCRNet在建筑物,草地以及水域三个类别获得最高的分割精度,在农田和森林上低于DeepLabV3Plus的结果,在这两个类别获得次优的分割精度。图3给出了本文的方法OCRNet和对比方法在GID数据集上的可视化对比情况,其中GT表示真实标注影像。从Image的区域1和区域2中,对比方法分别将水域错分为农田、农田错分为水域,而本文的方法OCRNet对每一个像素在全局范围内提取上下文信息精细融合,有效地减少了水域和农田的错分。然而在边界处,如Image中的区域2处,OCRNet仍然无法完全消除类别之间的错分现象,这主要是因为卷积神经网络在卷积的过程中不可避免地会造成图像的空间平滑,使得在类别边缘处造成错分。

表1 GID数据集语义分割结果评价表 %

图3 OCRNet及其他方法在GID数据集上的分类结果可视化对比

2)WHU building数据实验。为进一步验证OCRNet的有效性,本文在WHU building数据集进行实验。表2给出了在WHU building数据集上的对比实验情况。从表2可以看出,OCRNet在Kappa系数、平均交并比MIoU、总体精度OA、每类分类精度以及交并比IoU等五个指标上均高于对比方法,取得最优的分割精度,其中在IoU指标上,相对于次优方法FCN,在IoU指标上有2.17个点的提升,证明了算法在提高语义分割精度方面的有效性。图4给出了所有方法在WHU building数据集上的可视化分割结果。对于区域2、3、4,对比方法FCN、DeepLabV3Plus、PSPNet和PointRend得到的分割结果较为破碎,而采用的OCRNet对每一个待分像素在全局范围内进行空间信息融合,可以有效地获得影像中同类像素的信息用于最终的表达,所以相比于对比方法,可以获得完整的分割结果。在区域1上,OCRNet仍然获得相对较为完整的建筑物提取结果,然而在局部区域存在提取不完整的现象。图5给出了OCRNet在其中一张测试数据上的建筑物提取结果。

表2 WHU Building数据集语义分割结果评价表 %

图4 OCRNet及其他方法在WHU building数据集上的分类结果可视化对比

图5 OCRNet在WHU building数据集上的建筑物提取结果

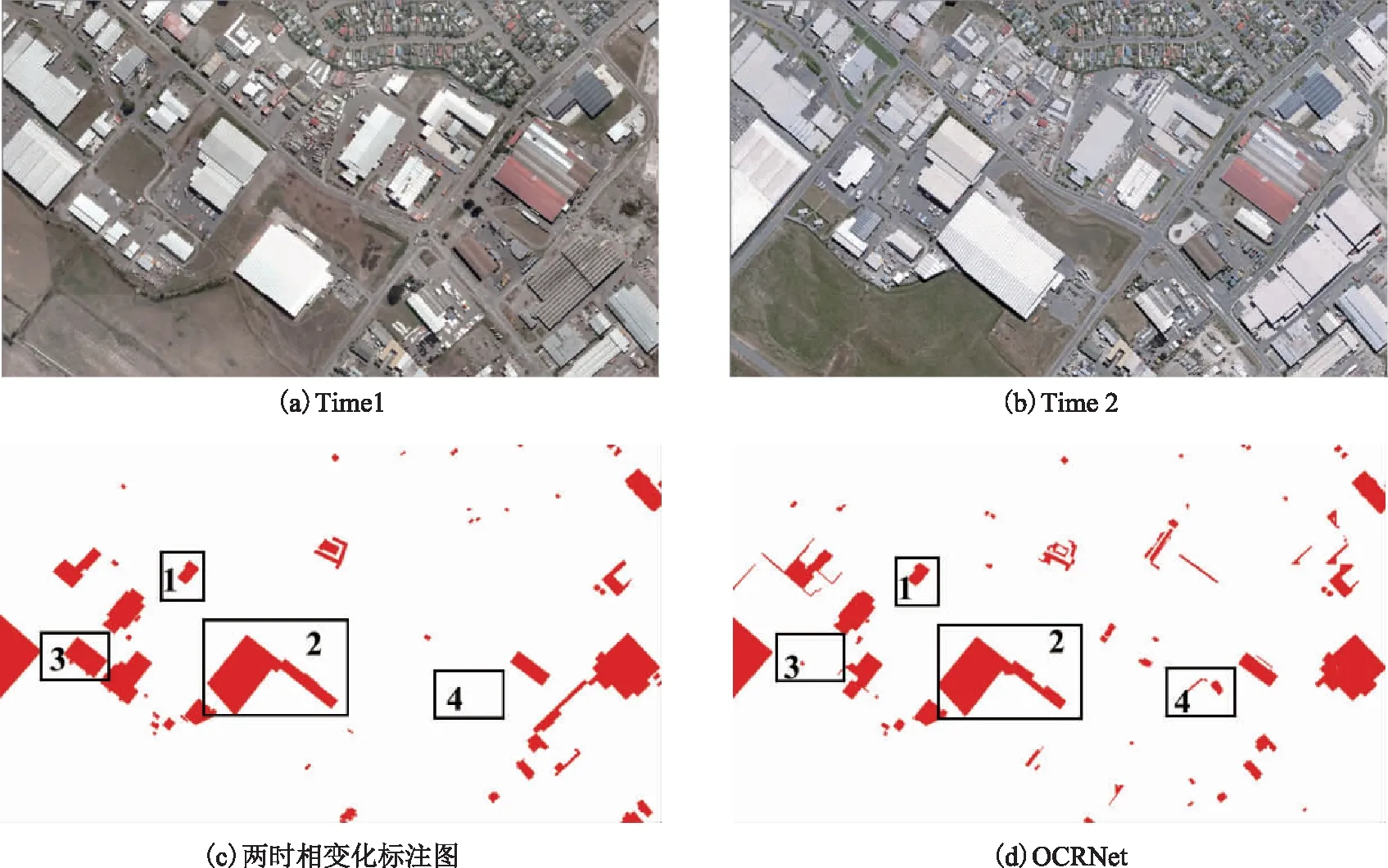

本文采用的WHU building测试数据集为同一地区的不同时相数据,因此本文对两时相的分割结果做对比,获得建筑物的变化情况。表3给出了对比方法与OCRNet在该数据集上的变化检测精度。从表3可以看出,在召回率Recall这个指标上,OCRNet与FCN、PointRend相比没有提升,略有下降。然而在Precession和F1分数指标上,OCRNet均有明显提升,在Precessions上与PSPNet相比提升7.13(从85.43提升至91.73),证明OCRNet在该数据集上具有更低的虚警率。图6展示了OCRNet在WHU building数据集上的建筑物变化检测结果,区域1和区域2为OCRNet提取出完整的变化图斑,区域3为漏检图斑,区域4为虚警。

表3 WHU Building建筑物变化检测结果评价表 %

图6 OCRNet在WHU building数据集上的变化检测结果

2.3 参数分析

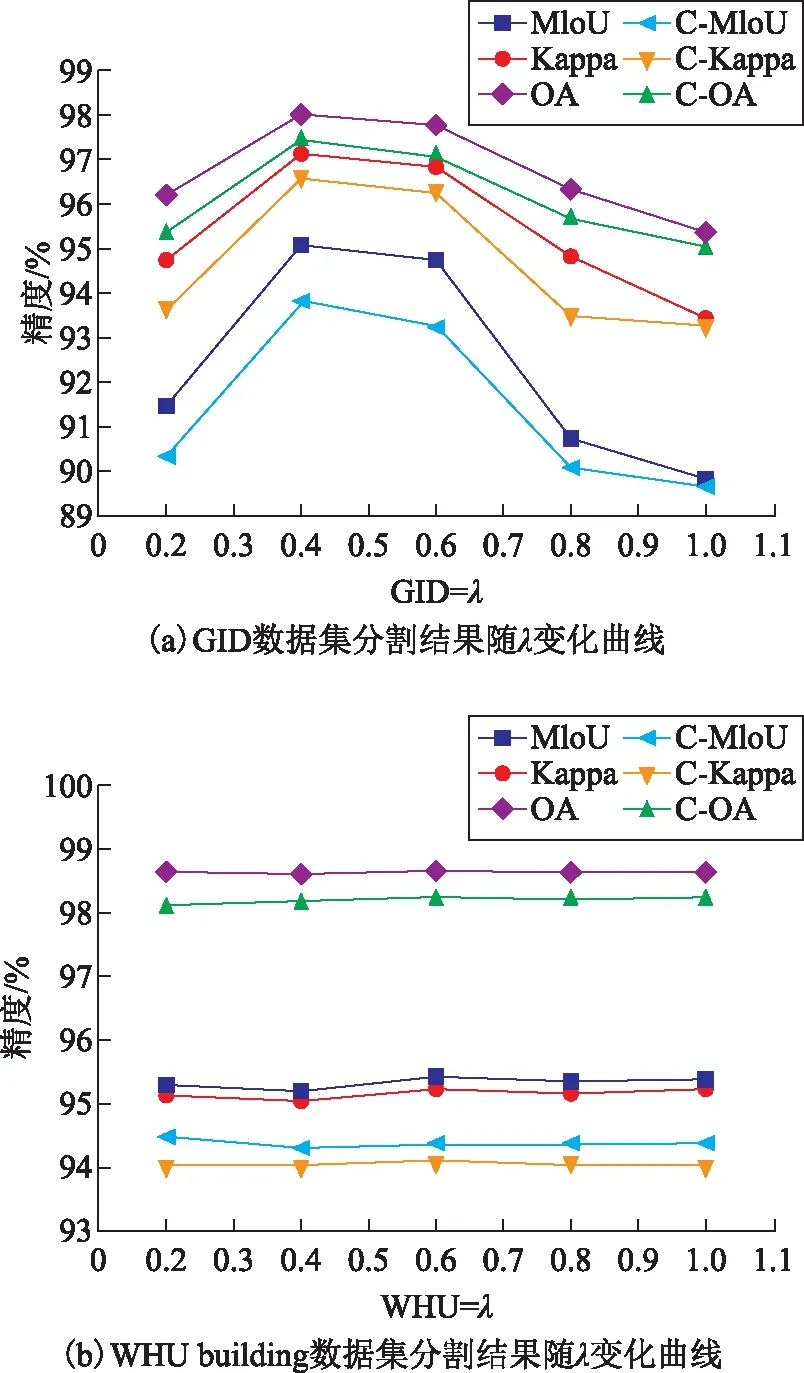

在本文使用的方法中,同时训练粗语义分割分支和精细语义分割分支,并将两个分支的损失函数进行加权叠加,加权系数为λ。为研究加权系数λ对语义分割结果的影响,本文分别令λ={0.2,0.4,0.6,0.8,1.0}进行实验。实验结果如图7所示,其中MIoU、Kappa和OA为本文中网络最终预测时的分割结果,C-MIoU、C-Kappa和C-OA为粗语义分割分支的分割精度指标。

图7 λ不同取值下,OCRNet在GID和WHU building数据集上的分割结果变化

从图7可以看出,对于GID数据集,当λ从0.2增加至0.4的过程中,分割精度指标MIoU、Kappa和OA不断提升,在λ=0.4时取得最优值,随后随着λ的继续增加,分割精度不断下降。对于WHUbuilding数据集,建筑物提取结果基本不受系数λ影响,随着λ改变,分割精度基本不变。在OCRNet中,粗语义分割分支的输出将用于类别中心的特征编码,进而影响待分割像素在特征空间的最终表达,因此粗语义分割分支的分割精度会影响最终的分割精度。从图7也可以看出,最终的分割精度与粗语义分割精度具有相似的变化曲线,基本随着粗语义分割分支的分割精度变化而变化。对于GID数据集,由于其数据在空间上分布跨度较大(从中国60多个城市获取得到的),类内异质性较大,粗语义分割分支精度随其加权系数λ变化,并在λ=0.4时取得最优结果,因此使得OCRNet在λ=0.4获得最优精度。然而对于WHU building数据集,由于该数据覆盖区域多为相邻区域,数据同质性较强,相比于GID数据,较为容易分割,粗语义分割分支对λ较为鲁棒,因此最终的分割结果对于λ也表现出较为鲁棒的特点,基本不随λ波动。

图8给出了OCRNet在GID和WHU building数据集上的预测结果与真实值对比情况。对于第一行数据GID-Ⅰ,其为典型的森林,区域内部较为同质,OCRNet在该区域完全分类正确。然而对来自其他区域的第二行数据GID-Ⅱ中,森林内部如1、2、3地区表现出较大差异,同质性较差,地区1和地区2被错分为草地,地区3被错分为农田。尤其是地区3,与第一行中的森林差异大,视觉上与农田这一类别较为相似。第3行给出了在WHU building数据集上的对比结果,相比于GID,WHU building建筑物和非建筑物之间具有更明显的差异,相对更加容易分类。在第四行中,区域1、2、3是真实标签图中被遗漏标注却被我们的模型给正确识别的。虽然区域1、2、3相对于其他房屋尺寸较小,然而其仍然表现出典型的建筑物的特征,而且与周围背景差异较大,所以可以被正确识别。因此相较于WHU building,GID具有较高的类别复杂度,在OCRNet中粗语义分割分支精度对其对应的权重λ较为敏感,最终表现出分割精度曲线随粗语义分割分支权重λ起伏较大的现象。而在WHU building上,粗语义分割分支较为容易获得不错的分割结果,基本受λ影响不大,进而分割精度曲线变化较小。

图8 OCRNet和WHU building数据集上的预测结果与真实值对比情况

3 结束语

深度卷积神经网络已经在高分遥感影像语义分割获得成功应用,并成为当前高分语义分割的研究热点。然而传统基于卷积神经网络的高分影像语义分割方法,通过堆叠卷积层、池化层进行层次化特征提取,隐式地将空间上下文信息融合到特征提取过程中。这种方式仅仅融合了像素自身局部范围的上下文信息,忽略了全局影像中同类像素之间的关系。本文显式地对全局空间目标上下文建模,将目标上下文卷积神经网络用于高分遥感影像语义分割。在采用的方法中,包含了粗语义分割分支和精细语义分割分支的双分支语义分割网络。利用粗语义分割分支获得每一个像素的类别概率分布,并结合精细语义分割分支获得像素特征获得全局空间的类别中心特征。随后,将类别中心特征作为码本对像素特征进行变化,获得融合了全局上下文信息的变换特征,并将变换特征与像素特征融合用于最终的像素表达,进行语义分割。为验证算法的有效性,本文在GID和WHU building语义分割数据集上进行实验,实验结果证明所用算法可以有效利用全局空间上下文进行特征融合,提高高分影像语义分割精度。