无人机自主作战能力试验评价技术综述

2021-01-06杜梓冰陈银娣

杜梓冰 陈银娣

摘 要:为有效开展智能无人机自主作战能力的试验与评估, 本文对自主能力进行试验及评价的紧迫性和所属技术范畴进行了研究, 探讨美国在政策、 计划、 技术等方面的做法, 同时深入剖析当前典型自主等级评价模型在飞行试验中的适用性, 并分析了重塑试验评估模式、 建设高智能对抗试验环境、 建立试验评估技术体系、 形成自主性等级标准、 建设通用模型和工具、 试验评估中应用人工智能等主要方向的研究内容, 提出了顶层重视规划试验评估、 加大人工智能技术应用、 加大通用模型构建和发展虚实一体试验等建议, 以期提升自主性技术落地应用速度, 扩大智能无人机作战使用范围。

关键词: 军事智能; 人工智能; 无人机; 自主作战能力; 试验与评价; 自主等级; 虚实一体试验

中图分类号: TJ760; V217; V279 文献标识码: A 文章编号: 1673-5048(2021)06-0058-08

0 引 言

随着人工智能技术在军事领域的快速发展和应用, 军事领域将迎来一场变革, 从机械化、 信息化走向智能化, 未来战争将是智能化的战争, 而无人化是其基本形态, 人工智能与相关技术的融合发展将逐步把这种形态推向高级阶段, 航空装备领域的无人机系统自主水平将大大提高[1-9], 甚至是五代机的一种可能形式[2]。 美军认为, 人工智能与无人系统融合为无人自主系统, 是改变战场规则的颠覆性技术, 基于此, 美军近年来提出了“忠诚僚机”“分布式作战”“全域作战”“蜂群”“马赛克战”等颠覆性作战概念, 将自主性无人机作为其关键部分, 进行了大量演示验证试飞, 验证了其技术的先进和战略优势的维持[8]。 自主性是人工智能技术在军事领域深度应用的结晶, 可解释性、 自主性能力、 信任度、 鲁棒性、 人机权限、 人机编组效能、 集群效能等是影响无人机系统投入使用的主要问题。 科学、 全面、 先进的试验、 评估、 验证和确认(TEVV)技术是解决这些问题的关键[10-11], 但自主感知、 自主规划、 自主学习、 自主协同、 自主决策、 自主攻击等行为的试验评估超出了现有试验技术的范畴和模式, 其多学科交叉性、 不可理解性、 不可预测性等特征对现有试验与评估方法带来了巨大的挑战, 亟需开展新的试验与评估方法研究[11-12]。

美国自21世纪初开始出台大量政策文件支持自主能力的试验项目[11-17], 形成了多种自主能力评价模型[1,2,18-28], 国内杨伟[1]、 卢新来等[6]、 刘树光等[26]、 Wang等[27]也对相关理论进行了研究, 但未形成统一的标准, 而且也不完全适用于外场试验评估。

为确保军事智能技术落地应用, 扩大自主性无人机的应用场景, 需要超前研究相关的试验评估技术体系, 为此, 研究美国在自主能力试验方面的做法和相关评价模型在试验中的适用性, 分析自主作战能力对试验与评估的挑战, 并给出自主作战试验与评估发展建议, 以期促进国内相关技术的发展。

1 无人机系统自主作战能力试验评价的基本问题

1.1 无人机自主性的内涵

关于自主性的定义有多种, 对于无人机而言, 美国空军2015年发布的《自主地平线》[3]的定义比较恰当: 自主性是融合智能系统功能, 使用更多的传感器和复杂软件, 在广泛的作战挑战下、 复杂环境因素和多样的任务中, 能够响应设计中未编程或未预期的情况(即基于决策的响应), 具有一定程度的自治和自我指导的行为。 自主性被认为是自动化的重要扩展, 可在未完全预期的情况下成功执行非常高级的任务指令。 其特征在于, 能够在极其不确定的情况下, 独立实现任务目标, 且在很长时间内表现良好, 还能在通信受限或无通信情况下弥补系统故障带来的影响[3]。

1.2 无人机自主性能力发展的需求

美国国防科学委员会2012年发布的《自主性在国防部无人系统中的地位》指出, 自主能力是美国无人系统的核心能力。 美国《无人系统综合路线图(2017-2042)》提出,“互操作性、 自主性、 网络安全以及人机协同”是未来无人系统发展的四个关键技术和驱动。 作战需求是技术发展的牵引力, 在自主性方面, 通过提高操作速度、 降低认知负荷以及提高逆境中性能的方式提高自主性能力。

“人在环路”受制于人的固有限制, 需要提高机器的自主性以解放人力。 由于軍事、 政治和伦理的限制, 当前“捕食者”等无人机仍然是“人在环路”, 在目标侦察确认、 武器打击等环节仍然需要人的介入, 而操控员固有的生理限制影响作战效果, 人员处理容量和速度有限, 影响作战效能, 有限空间多人协同操作高压下易出错, 合格人员成长速度落后于装备发展速度, 通过自主性的提升, 减少人员干预环节、 减少人员操作负荷, 可以一定程度上避免人的因素影响作战效能。

战场的博弈对抗需要提升无人平台的自主性。 随着人工智能技术在军事领域的快速应用, 未来战场的复杂性、 博弈动态性和不确定性都给有人和无人系统执行OODA作战环路带来了极大的挑战, 必须提高无人系统的自主性, 以扩大系统的处理能力。 集群作战必须提高无人系统的自主性。 “蜂群”“狼群”“鱼群”等集群模式下, 作战的无人系统数量众多, 但是受制于人的因素, 一个人能操作控制的无人机有限, 链路资源和地面站资源难以支撑, 势必要求提高无人系统自主性。

1.3 无人机自主作战的特征与影响

智能化作战不再是能量的逐步释放和作战效果的线性叠加, 而是非线性、 涌现性、 自生长等多种效应的急剧放大和结果的快速收敛, 逐步具备自适应、 自学习、 自对抗、 自修复、 自演进、 博弈对抗等特征。 基于人工智能技术的新一代无人机自主作战系统, 无人机平台、 探测、 识别、 决策、 跟踪、 打击等环节自主作战, 能够模拟人的思维和行为, 促进制胜机理从“制信息权”变为“制智权”。

1.4 试验与评估的必要性和迫切性

正如美国海军分析中心2017年在《人工智能、 机器人和蜂群》所言[13], 自主性武器带来了一系列伦理与道德问题, 如“能否区分军事目标与平民?”“如何将主观道德变为代码”。 牛津大学等机构研究认为, 人工智能的使用将加剧实体及数字安全系统面临的威胁, 并产生全新的威胁[14], 因此, 国际上一直呼吁禁止开发具有攻击性的自主武器。 如美国2005年的电影《绝密飞行》中, 智能无人机能拒绝人工指令、 自行选择别国目标进行攻击等, 这在现实中将带来巨大的政治风险, 其他诸多科幻小说、 电影中也展示出无人机自主化将带来一系列的伦理、 道德、 文化、 人权和军事风险, 因此世界各国都对自主无人机的作战使用持怀疑态度。 这也带来一个矛盾, 一方面没有人会拒绝人工智能技术在军用无人机领域的应用, 但同时又带来各方面巨大的风险, 科学、 充分、 有效的试验与评估是缓解这个问题的有效途径, 智能无人机系统比以往任何航空装备都更需要充足的试验与评估。

1.5 智能无人机自主作战能力试验与评估范畴

智能无人系统的自主性试验与评估属于军事智能试验评估的范畴, 《美军军事智能试验评估技术发展态势研究》中将军事智能试验技术分为智能化试验对象技术和试验手段智能化技术, 如图1所示[11]。

《智能装备试验与评价的挑战与对策思考》认为, “智能装备的试验与评估是确保智能装备可靠、 可信和可用的重要基础, 是检验智能装备能否在实际环境中应用的基本前提, 也是加快智能装备研制进度的重要保障”[10]。 在智能无人机自主能力试验与评估过程中, 需要构建相匹配的智能化试验技术。

2 美国无人机自主作战能力试验与评估方面的做法

2.1 各方政策重视智能化带来的自主性试验挑战, 强调试验与设计同步发展

美国很早就认识到缺少与自主化、 智能化装备匹配的试验评估方法, 迫切需要新的试验评估技术应对该挑战, 因此, 在《维持美国在人工智能领域的领导地位》《人工智能倡议法》《2019年国家人工智能研究发展计划》《人工智能原则支持文件》等政策文件中[12, 17], 都提出要对军事领域的人工智能技术进行持续的试验与评估, 必要时改变现有试验、 评估、 验证和确认程序, 创建新的试验评估基础架构, 旨在从政策、 标准、 技术手段等方面提升军事智能的试验与评估能力, 促进人工智能的技术优势向作战优势转变, 寻求与设计技术同步开展研究, 确保试验能力不滞后于装备的发展, 避免因试验能力的不足延迟装备研发进程, 从而延缓先进战斗力的生成速度。

2.2 美国多部门关注, 并持续投资自主领域的试验与评估项目

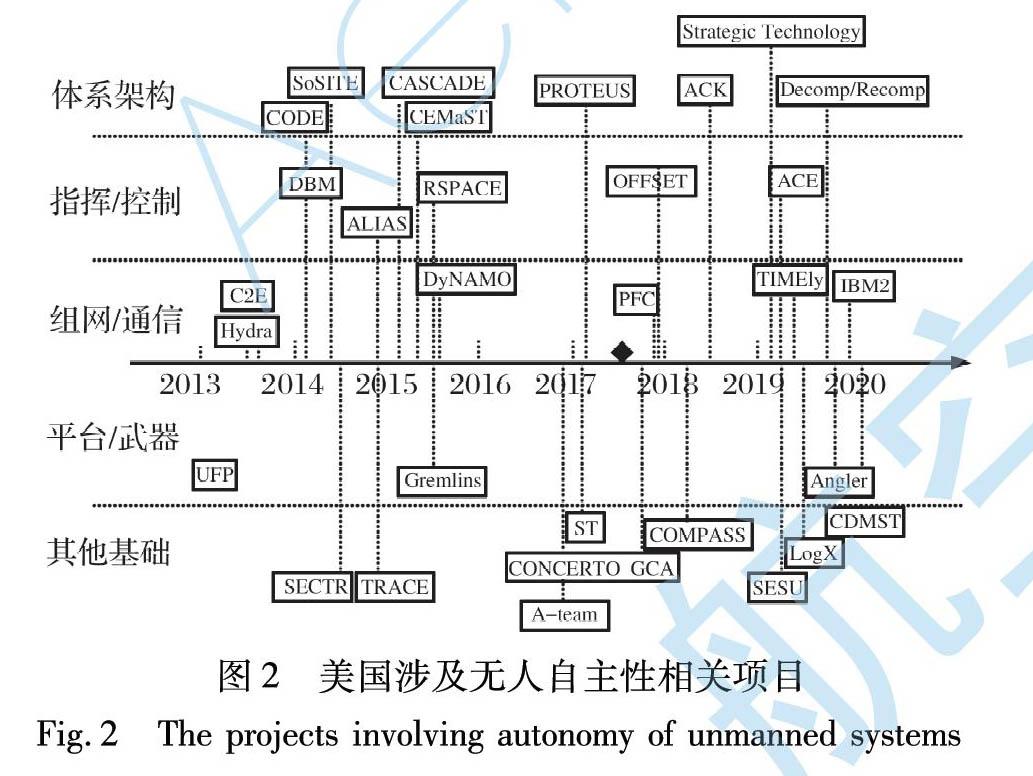

美国国防部自2006年开始就紧盯自主性试验与评估面临的特殊挑战, 一直将无人自主系统的试验与评估作为重点投资领域。 在《国防部试验评估资源战略规划》中, 将“自主与人工智能”列为试验与评估科技计划的投资方向之一 [12,16], “无人与自主系统试验”于2007年首次成为该计划的7个领域之一[16]。 自2020财年开始, 无人与自主系统试验更名为自主性与人工智能试验[11-12,16], 是重点投资的8个试验技术领域之一, 具体的重点项目包括增强自主试验与评估的安全性、 自主性部件的试验与评估、 自主系统可靠性的测试等[16], 相应的试验技术已转化应用, 如图2所示。 2011年备忘录中, 美国国防部将自主性和人机界面交互系统作为7项科技投入中的2个优先事项, 并成立自主性兴趣小组[13]。 在2014年公开的《依托21工作准则》中, “自主”是其17个技术领域之一[16]。 鉴于测试、 评估、 验证和确认(TEVV)是自主性系统保障的关键要素, 美国建立了利益共同体(COI)小组来解决该问题, 早在2015年便发布了一份技术投资战略, 其目标包括协助需求开发和分析的方法和工具、 基于证据的设计和实现、 通过研究开发累积、 执行行为预测和恢复、 自主系统的保证论据。 《自主性试验、 评估、 检验和确认技术投资策略2015-2018》中, 明确了自主能力试验和评估的研究范围和能力发展方向[12]。 美国国防高级研究计划局(DARPA)也在不断增加无人自主系统及其试验评估的项目投资, 如进攻性集群使能战术项目的重要目标就是发展无人自主集群集成试验环境, 其他涉及无人机系統自主能力的项目也统筹考虑了试验评估的发展。

2.3 建立顶层技术体系框架, 指引自主性发展方向

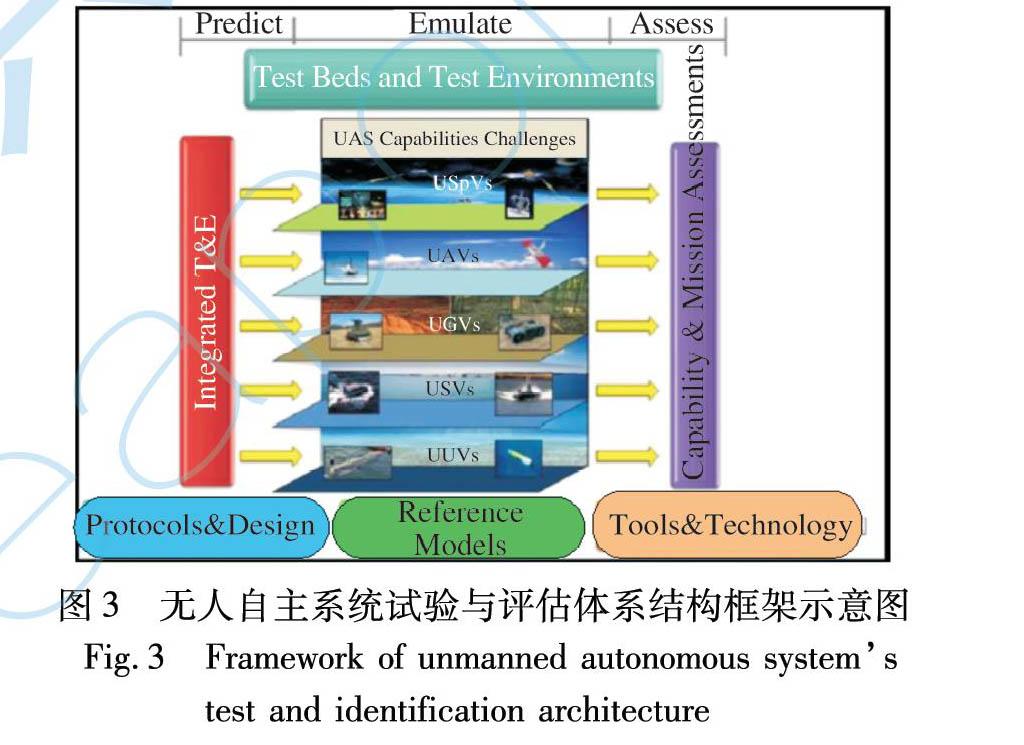

近年来, 美国出台了覆盖无人机、 地面无人系统、 机器人等一系列无人系统技术发展规划, 包括《美国陆军无人机系统路线图》《无人系统自主技术路线图》《无人系统综合路线图》《美国地面无人系统路线图》《美国机器人技术路线图》以及《自主地平线》等[3]。 尤其是美国国防部牵头制定的8版《无人系统综合路线图》, 持续指导军用无人系统的全面发展, 虽然各版侧重点有所不同, 但在各版路线图中均对无人机自主作战等级划分进行了说明。 另外, 试验资源管理中心在2011年就制定了图3所示的无人自主系统试验评估体系结构框架[12]。 其中包括面向五类作战空间的自主系统、 七类自主性支撑技术、 四层自主系统试验类型、 五类自主系统评价指标以及基于“观察、 调整、 决策、 行动”(OODA)环的“真实、 虚拟、 构造”(LVC)试验环境, 从而实现相关技术成体系发展[12]。 该技术体系框架不仅对自主性试验有指导意义, 对构建整个智能试验技术体系也有重要参考价值。

2.4 大力开展演示验证试飞, 提高技术成熟度

近年来, 美国针对“忠诚僚机”“分布式作战”“马赛克战”“蜂群”作战等项目陆续进行了多阶段试飞, 对无人系统作战能力进行充分的验证, 比作战理念和装备研发更重视演示验证试飞, 以加速技术成熟[8]。

2.5 出台自主性试验评估规则, 研究新的采办策略

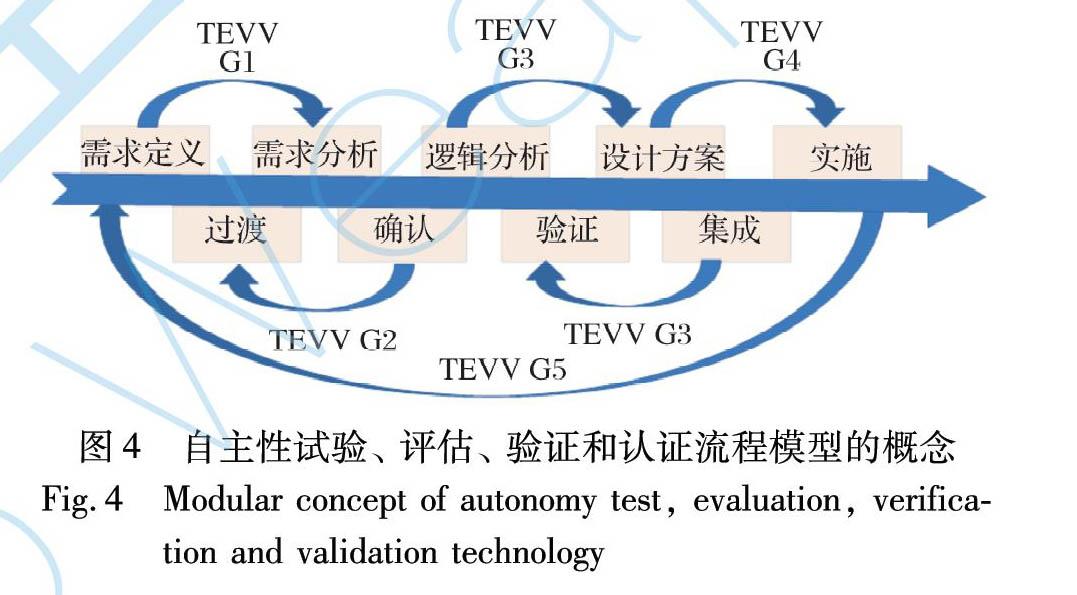

美国国防部指令3000.09要求, 自主性武器必须经过严格的硬件验证和认证[15], 以及现实系统开发和操作的试验与评估, 包括分析复杂操作环境导致的自主或半自主系统的意外应急行为, 并扩大了验证与认证以及试验评估的范围, 要求在现实条件下评估系统性能、 能力、 可靠性、 效率和适用性, 但同时认为现有做法无法满足自主能力的试验与评估, 正在研究新的采办流程, 试图将经典“V”模型替换为图4所示的扁平模型[13]。

3 无人机自主能力评价模型在试飞评价中的适用性分析

无人机的自主作战能力最终以自主等级来表征。 美国在持续开展自主作战相关设计技术研究的同时, 对无人机自主能力评价技术进行了大量研究, 形成了多种评价方法, 主要有宽泛分类和精确分类两大类[18-29]。

3.1 宽泛分类法

考虑到无人机需要人员的介入, 实战过程中需要明确人-机权限分配问题, 形成了多种比较宽泛的分类方法, 主要有国防部的人机权限4级模型[6,19]、 “美国国家航空航天局”(NASA)的6级飞行器自主等级[6,19]、 美国海军5级自主等级模型[2]。 美国国防部在2011、 2013版无人系统路线图中采用了人机权限4级评价模型, 分为人操作、 人委派、 人监督、 完全自主4个等级, 人的权限越低, 机器权限越高, 自主性越强[19]。 NASA将高空长航程科学任务分为6个自主等级, 分别是遥控、 简单的自动操作、 远程操作、 高度自动化(半自主)、 完全自主、 协同操作, 通过掌控的时间多少来量化分析自主等级[19]。 美国海军2021年3月在《无人作战框架》中将自主性依赖由低到高分为人操作、 远程操作、 人类监督、 人类编组、 接近独立5个层级[2]。 这类模型太过宽泛、 主观性过强, 对于定量的试验与评估而言仅具有参考意义。

3.2 精确分类法

(1) Sheridan 的自动装置等级(LOA)评价法

LOA评价法最早产生于1991年, 其将系统的自主性等级分成10级, 范围从计算机不提供任何帮助、 完全由人进行操作到计算机自己选择并执行任务、 完全不依赖于人[19]。 该方法注重通用性, 但考虑的因素较为简单, 难以转换为详细的评估指标体系, 对于基于试验的评价而言, 实际使用不便。

(2) 自主控制水平等级(ACL)

美国空军实验室定义了无人机的10个自主性等级[13], 如图5所示。 美国国防部前3版无人机路线图采取了这种定义方法, 同时对在研的无人机均做出了自主性等级评定。 该方法在提出时具有很强的前瞻性, 时至今日, 对当前国际上大部分无人机自主性评价均有一定的借鉴意义, 因此具有较强的实际意义。 但是其指标分类不统一, 颗粒度不均衡, 前后关联性不强, 且都是定性评价, 对于要投入实战的无人机而言, 评价指标太过宽泛, 无法完全依据该评价方法确定无人机自主等级, 试验过程中需要进行细化。

(3) 无人系统自主性框架(ALFUS)

美国于2004年提出了一种ALFUS框架, 试图从任务复杂度、 环境复杂性、 人机交互程度等三个方面来建立评价框架, 期望成为一种无人系统自主能力的通用量化评估框架[13,18], 如图6所示。 該框架不是一个特定的测试或一组指标, 而是代表一组表征自主性水平的多维指标模型。 通过在每个轴向上分别建立度量方法, 最终定义了人机交互从高到低, 环境从简单到复杂, 任务从简单到复杂, 低、 中、 高3个自主层级[13,18]。 该框架模型考虑环境、 任务和人机交互方面的实际因素较多, 不限定于特定领域, 不仅关注物理空间, 还利用“任务空间”作为衡量自主性的背景, 可以反映无人机执行任务的能力, 对试验与评估而言具有较高的借鉴意义, 已推广到一些地面无人车辆的试验与评估中。

但是, ALFUS框架不提供任何以标准方式分解任务的工具, 没有提供一种客观的方法描述系统的自主性能力映射到整体自主性水平, 而且建立的系统比较开放[19], 导致同一无人机、 不同方案的评价结果差异较大, 可能提供很多的间隔尺寸。 具体实施过程中, 每个坐标轴如何选取指标、 如何量化定义比较困难, 需要根据系统特点慎重制定。

(4) 基于OODA的自主等级评价模型

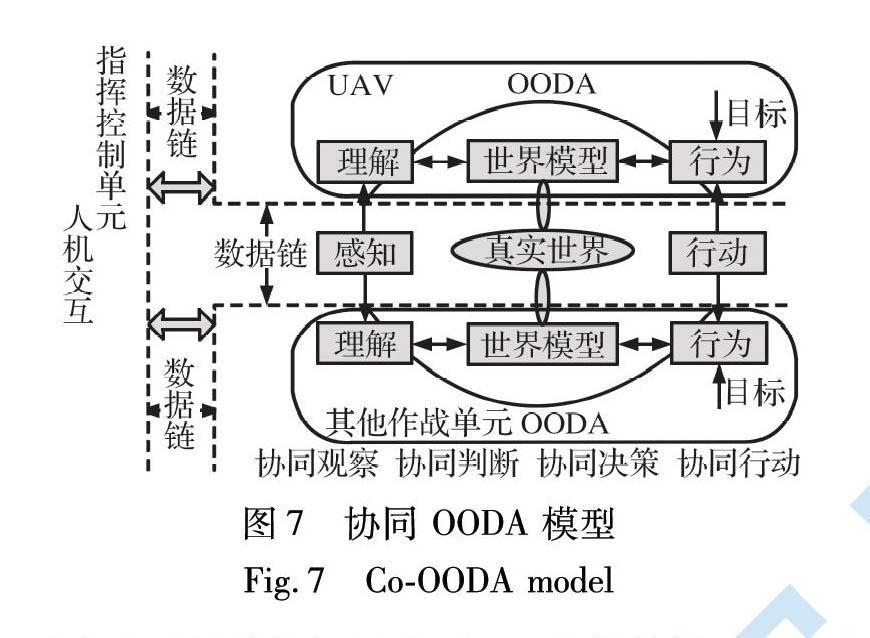

2002年, 美国空军实验室自动化领域的知名专家布鲁斯结合“观察、 调整、 决策、 行动”(OODA)环的原理, 对ACL进行了较大修改, 分成遥控驾驶(0级)、 执行预先规划任务、 可变任务、 实时故障/事件的鲁棒响应、 故障/事件自适应、 实时多平台协同、 战场认识、 战场认知、 战场集群认知和完全自主(10级)共11个等级, 分别针对OODA中的每个环节进行基于ACL模型的自主等级划分[6,21]。 NASA的普劳德在其报告中基于OODA环将自主性分为8个等级, 也是分别对OODA环中的每个环节都进行了自主等级划分, 同时还给出详细的评价实例[6,22]。 为了评价无人机与其他系统协同作战的能力, 国防科技大学还提出协同OODA模型[29], 增加了OODA模型对协同和交互性能的描述, 从感知、 分析、 规划、 协同、 执行五个维度评价UAV系统自主性等级, 如图7所示。

这些方法虽然等级标准不一, 但都是通过对OODA的每个环节进行自主等级划分和评价, 分别以不同的行为模式定义自主等级, 对整个作战过程考虑比较全面, 比较适合智能无人机系统, 可分别牵引各部分技术发展[1], 但是对于每个部分的定级比较困难, 不同无人机的需求不同, 在实际试验应用中应详细制定针对性的标准。

3.3 其他领域自主等级分类

无人机领域经过20多年的研究, 仍无权威、 具有实际使用意义的自主等级标准, 而汽车自动驾驶领域发展较快, 在这方面有更实质的进步。 美国机动车工程师协会在2016年提出了0~5级的汽车自动化驾驶划分指导, 国内工信部也在2020年3月提出了《汽车驾驶自动化分级(报批稿)》国家标准, 将自动化驾驶分为0~5级, 这都是权威机构或部门的标准, 意味着汽车在自主能力评价方面比无人机更为成熟。

由于人工智能技术在航空装备领域应用还不成熟, 且自主能力的试验组织难度大、 周期长、 消耗大, 使得相关理论、 技术的验证进度比较缓慢, 目前仍处于对智能无人机自主性试验与评估的探索中, 各个方法都有其优缺点, 尚未形成满足实用并普遍认同的等级划分, 很难有一个模型对不同类型无人机都适用。 在实际试验过程中(尤其攻击型无人机), 对基于OODA的模型、 ALFUS框架和ACL这三种模型进行综合考虑, 可能在实际试飞中比较有价值和可操作性。

4 无人机自主作战能力试验评估技术的重点发展领域

无人机自主作战能力试验评估的主要任务是解决系统能否在无人干预情况下实施自主作战的问题。 由于无人机具有了自主行为, 使得作战任务和作战能力相比传统机械化、 信息化装备大幅扩展, 必然导致试验和评估需求有所增加, 当前的试验评估技术体系无法完成对其进行试验和评估的任务, 必须从一些方面重点开展研究, 建立与自主无人机系统相匹配的试验评估技术体系。 美国国防部在2015年提出, 试验需求、 试验工具、 试验方法等8个关键领域是无人机自主系统的重要方面, 贯穿整个采购[30]。 美国防御分析研究所2018年也指出, 对抗试验等技术是无人机自主性试验中的关键[31]。 针对未来战争形态和装备研发模式, 无人机自主作战能力试验评估技术的重要发展领域主要包括以下方面。

4.1 重塑试验评估模式

试验模式是装备试验评估的基本框架和路线, 只有确定了试验模式, 才能开展后续的试验。 当前, 机械化、 信息化装备的试验评估模型、 体系、 技术已经比较健全, 其中一些关键点的进步是其发展的重点方向。 而智能化装备的试验评估尚处于起步阶段, 由于被试对象的智能化特性, 当前试验评估模式不再适用, 需要建立新的试验评估模式。

首先是要研究虚实跨域融合的试验评估模式。 对无人机自主性的评价需要对其内部算法进行大量的验证。 由于算法规模庞大, 且持续学习进步, 无法完全依靠真实飞行试验的方式试验和评估, 必须大量采信仿真的结果, 这方面需要数字孪生、 平行仿真等技术的应用, 实现虚实互动、 共同试验。

其次是要研究多阶段融合的一体化试验模式。 虽然美国当前的试验评估强调“左移”“一体化”, 但其性能试验、 作战试验等部分仍然是分立为主, 各个阶段有机融合, 但各个阶段的独立性仍然存在, 而智能化无人机, 由于存在“会学习”“能进步”这一“智力”增长的最突出特点, 导致试验评估需要各个阶段实现真正的融合与一体化, 避免性能试验评价对象智力为“小学生级”, 作战试验评价对象智力为“博士级”, 各个阶段的自主等级评价完全不同, 结果互不适用。 另外, 对于自主性无人机, 更强调对于算法的持续验证及模型的持续优化, 需要实验室和外场之间保持持续的联系和互动, 甚至实现平行试验。 由于这些特点, 需要建立真正意义上一体化的试验评估模式, 将研制方、 试验方从一开始融合在同一试验评估团队, 加强模型和数据的共用, 这对当前的研发和试验体系是巨大的挑战。

最后, 要研究单样本持续增长的试验评估模式。 传统装备的试验评估遵循“建立模型→仿真预测→飞行试验→模型修正”循环迭代的方式[12], 然而, 对于自主作战的无人机而言, 其庞大的算法空间规模、 不确定的黑箱推理模型、 不确定的作战行为, 导致无法重复状态, 且行为持续学习、 进化, 致使预测-试验-比较的模式行不通, 出现一个状态一个样本, 但是样本持续增长的情况, 需要着重研究这种单样本持续增长的试验评估模式。

4.2 高智能对抗型试验环境构建

试验环境是进行无人机自主系统研究、 学习、 测试、 验证和演练必不可少的条件。 由于无人机自主性试验和评估涉及信息、 控制、 社会学等, 传统的靶场、 试验设施已无法支撑, 这是因为自主型无人机具备学习能力, 有什么样的环境就会训练出什么样的智能算法和装备, 经历高智能、 高对抗性、 高复杂度环境的磨练, 才能使装备更聪明, 自主能力更强、 更可靠, 因此对于无人机自主能力的评价, 要建设能够与无人机持续交战的背景环境、 干扰环境和目标环境, 能够根据无人机的行为持续改变环境特征, 这样才能真正激励无人机的自主作战行为, 挖掘其潜力, 培养其能力。

4.3 建立试验评估技术体系

一次完整的试验评估包含试验设计、 试验设施、 数据采集、 结果分析与评价等关键步骤。 由于“自主”的特殊性, 对这些关键步骤也需要研究全新的技术。

在试验设计方面, 针对智能算法规模的急剧增加、 样本空间没有边界、 多学科交叉等问题, 需要研究与传统正交试验设计、 均匀试验设计等不同的试验设计方法。

在数据采集和处理方面, 若对无人机全系统数据均进行采集、 记录, 会导致数据采集记录系统庞大, 对于载重小的无人机而言, 可能无法装载足够多的测试设备, 若按当前的模式, 事先制定部分采集方案, 又可能对无人机作战中意料之外的“自主”行为特征数据漏采, 影响事后的分析评判, 因此需要研究自主的数据采集技术, 能够根据任务、 行为“自主”改变部分数据的采集、 记录内容、 方式。

在结果评估方面, 为了实现自主能力的评估, 需要针对智能力、 信任度、 鲁棒性、 效能、 人机交互等方面建立新的評估模型, 这些方面评估的重要性已经超过了当前无人机“高度、 速度、 打击距离…”等指标的评估。 同时, 为了实现对这些新指标的评估, 需要构建有别于当前基于经典统计、 Bayes统计方法的数据处理模型, 因为由于自主性的存在, 不同行为样本的分布特性难以确定, 甚至是完全不同的。

4.4 建立自主性等級标准

制定自主性等级评价标准、 给出无人机的自主性等级, 是自主无人机试验评估的显著特点, 与当前装备的评价明显不同。

明确的自主能力分级是研发、 试验、 使用的基础。 当前, 由于无人机类型众多、 作战任务模式多样, 对自主性的认识还不统一, 尚无权威统一的自主性评价标准体系和方法, 造成在论证、 设计、 制造、 试验过程中, 各方对于自主性的认识不统一, 交流“频道”不一, 影响技术的开发及装备的研发和作战使用。 为确保合理的研发使用, 必须建立自主性等级评价。 自主能力分级是衡量自主能力的可靠工具, 使得自主能力有可比性, 为发展方向提供明确指示。

准确的自主能力分级是合理任务分配的前提。 人机协同的主要作战模式有: 有人机支配无人机, 有人机协助无人机, 有人机、 无人机互补等。 无人机自主系统逐渐演变为与人并肩作战的全功能队友, 不同复杂度、 不同环境任务对于装备能力的需求不同, 用等级太高的无人机执行低等级任务, 是“杀鸡用牛刀”, 用低等级无人机执行高等级任务, 则难以完成任务, 合理的无人机等级划分, 可以使得任务分配更合理。

4.5 通用型模型、 工具的建设

装备的试验和评估过程中, 需要一些特定模型和工具的支撑。 对于机械化、 信息化的装备而言, 存在种类少的特点, 如美国目前主流歼击机主要有F-22, F-35, 且一代装备研制需要数十年, 模型、 工具开发尚能应付装备的试验, 但是其无人机装备类型多、 数量多, 发展速度快, 未来的自主性无人机发展速度会更快, 导致无法针对每种自主性无人机去研发配套相应的模型、 工具, 必须研究通用、 互操作的模型、 工具等试验资源, 以应对多种多样的智能无人系统。 为实现通用模型、 工具的研发, 还需要相应的标准、 架构的开发。

4.6 试验评估中应用人工智能技术

随着技术的发展, 人工智能不再是一种神秘的力量, 而是一种普适性的使能技术, 是促进社会各个方面进步的通用工具, 如同蒸汽、 电力一样, 只有加快应用步伐, 才能提高试验和评估技术的整体进步, 而且有的领域不应用人工智能技术已经无法解决, 如海量算法空间的试验设计、 大量非结构化数据的处理和分析、 智能对抗环境的构建等等。 试验与评估是装备的量尺, 其智能化水平必须比装备更高, 才有可能量测出装备的具体性能。

5 发展建议

针对无人机自主性试验与评估的重要发展领域, 对标美国的做法, 为国内相关的研究提出以下建议。

加大顶层规划力度, 加快技术研究速度。 人工智能技术是有可能颠覆现有大国格局的关键技术。 美国在军事智能技术大量应用之前, 已经认识到现有试验评估技术无法应对自主性的要求, 因此, 早早规划了试验技术的发展。 智能技术的发展速度远远超过机械化、 信息化技术的发展速度, 导致无人机自主性能力快速提升, 而自主型无人机比以往任何领域都更需要充分的试验和评价。 为避免试验技术发展速度与设计技术不匹配、 无法合理评估装备情况的出现, 国内也必须体系化考虑自主型无人机的发展问题, 与先进自主型理论、 技术的发展一道同步规划试验技术的研究和资源建设, 加大对试验模型、 试验技术体系的研究速度, 尽早完成准备。

加大人工智能技术在试验评估中的应用, 革新试验技术体系。 人工智能技术在装备中的应用, 将带来革命性的变化。 试验与评估技术作为“尺子”, 必须构建更智能的环境、 更智能的对手、 更智能的试验手段, 才能度量智能技术水平, 才能应对无人机自主性的试验和评估任务。

加大对民用通用型模型、 工具、 标准、 框架的研究和应用, 提升军用无人机自主性试验与评估的整体进步速度。 国内对于无人机自主能力的评估还处于起步阶段, 但国内外民用领域针对机器学习、 语音识别、 深度学习等基础技术领域, 以及无人车、 机器人等典型应用场景构建了部分专用测试工具、 模型, 开展了大量的公路测试、 试用, 已经比较成熟, 且出台或正在制定一系列标准[32], 但是在无人机领域推广不够, 对于人工智能这种通用化较强的技术, 且民用研究远远大于军用研究的情况下, 必须加大对民用通用测试工具、 标准、 框架的研究和推广, 强力推进在军用无人机领域的应用, 加快研发进度、 降低技术风险。

6 结 论

(1) 由于人工智能技术的应用, 无人机自主作战发展是不可逆的高速发展过程, 将颠覆传统的作战模式和制胜机理, 必须正视并积极应用, 但面临战争伦理、 信任度等问题, 充分的试验与评估是确保其投入使用的关键。

(2) 美国早早认识到自主性试验与评估的挑战和困难, 出台了大量政策, 支持大量的项目研究。

(3) 自主等级是无人机自主作战能力的最终体现, 国内外学者研究了多种模型, 但各有利弊, 适用范围不同, 在试验评估中需要综合分析运用。

(4) 为了实现无人机自主作战能力的试验和评估, 需要在试验模式、 试验技术体系、 环境构建、 人工智能技术的应用、 通用模型工具等方面进行重点研究。

(5) 为了匹配设计技术的发展, 建议加大试验评估技术的顶层规划, 实现试验技术与设计技术同步发展, 通过运用人工智能技术, 增加通用模型、 工具等的开发, 快速提升无人机自主性试验与评估的发展。

参考文献:

[1] 杨伟. 关于未来战斗机发展的若干讨论[J]. 航空学报, 2020, 41(6): 524377.

Yang Wei. Development of Future Fighters[J]. Acta Aeronautica et Astronautica Sinica, 2020, 41(6): 524377.(in Chinese)

[2] Department of the Navy Unmanned Campaign Framework[EB/OL].(2021-03-17)[2021-05-24]. https:∥www.subsim.com/department-of-the-navy-unmanned-campaign-framework/.

[3] Landreth L. Autonomous Horizons: The Way Forward [J]. Air & Space Power Journal, 2020, 34.

[4] 于成龙, 侯俊杰, 蒲洪波, 等. 新一代人工智能在国防科技领域发展探讨[J]. 国防科技, 2020, 41(4): 13-18.

Yu Chenglong, Hou Junjie, Pu Hongbo, et al. Development of the New Generation Artificial Intelligence in National Defense Science and Technology[J]. National Defense Technology, 2020, 41(4): 13-18.(in Chinese)

[5] 刘永才. 新形势下武器装备发展思考[J]. 战术导弹技术, 2020(4): 1-12.

Liu Yongcai. Thoughts on the Development of Weapons and Equipment under the New Situation[J]. Tactical Missile Technology, 2020(4): 1-12.(in Chinese)

[6] 卢新来, 杜子亮, 许赟. 航空人工智能概念與应用发展综述[J]. 航空学报, 2021, 42(4): 251-264.

Lu Xinlai, Du Ziliang, Xu Yun. Review on Basic Concept and Applications for Artificial Intelligence in Aviation[J]. Acta Aeronautica et Astronautica Sinica, 2021, 42(4): 251-264.(in Chinese)

[7] 雷宏杰, 姚呈康. 面向军事应用的航空人工智能技术架构研究[J]. 导航定位与授时, 2020, 7(1): 1-11.

Lei Hongjie, Yao Chengkang. Technical Architecture of Aviation Artificial Intelligence for Military Application[J]. Navigation Positioning and Timing, 2020, 7(1): 1-11.(in Chinese)

[8] 杜梓冰, 张立丰, 陈敬志, 等. 有人/无人机协同作战演示验证试飞关键技术[J]. 航空兵器, 2019, 26(4): 75-81.

Du Zibing, Zhang Lifeng, Chen Jingzhi, et al. Critical Technologies of Demonstration Flight Test of Cooperative Operation for Manned/Unmanned Aerial Vehicles[J]. Aero Weaponry, 2019, 26(4): 75-81.(in Chinese)

[9] Endsley M R. Autonomous Horizons: System Autonomy in the Air Force—A Path to the Future. Volume I: Human-AutonomyTeaming[R]. Washington D C: United States Air Force Office of the Chief Scientist, 2015.

[10] 韦正现. 智能装备试验与测试的挑战与对策思考[J]. 测控技术, 2021, 40(2): 1-5.

Wei Zhengxian. Challenge and Countermeasure of Intelligent Equipment Experiment and Test[J]. Measurement & Control Technology, 2021, 40(2): 1-5.(in Chinese)

[11] 权晓伟, 张灏龙, 龚茂华, 等. 美军军事智能试验鉴定技术发展态势研究[J]. 中国航天, 2021(2): 62-64.

Quan Xiaowei, Zhang Haolong, Gong Maohua, et al. Research on the Technological Developments of Military Artificial Intelligent Test and Evaluation in US[J]. Aerospace China, 2021(2): 62-64.(in Chinese)

[12] 周宇,杨俊岭.美军无人自主系统试验鉴定挑战、 做法及启示[EB/OL]. (2017-03-27) [2021-05-24]. https:∥news.qq.com/a/20170327/019952.htm.

Zhou Yu,Yang Junling. Challenges, Practices and Implications of the Test and Appraisal of Unmanned Autonomous Systems in the US Military[EB/OL]. (2017-03-27) [2021-05-24]. https:∥news.qq./a/ 20170327/019952.htm. (in Chinese)

[13] Ilachinski A. AI, Robots, and Swarms: Issues, Questions, and Recommended Studies[R]. Center for Naval Analyses (CNA), 2017.

[14] Brundage M, Avin S, Clark J, et al. The Malicious Use of Artificial Intelligence: Forecasting, Prevention, and Mitigation[EB/OL]. (2018-02-01)[2021-05-24]. https:∥www.researchgate.net/publication/ 323302750_The_Malicious_Use_of_Artificial_Intelligence_Forecasting_Prevention_and_Mitigation.

[15] Carter A B. Autonomy in Weapon Systems: DOD Directive 3000.09[S]. Washington D C: Department of Defense, 2012.

[16] 張宝珍, 尤晨宇, 吴建龙, 等. 从美国国防部试验鉴定科技计划看美军试验与测试技术发展重点[J]. 测控技术, 2020, 39(10): 1-8.

Zhang Baozhen, You Chenyu, Wu Jianlong, et al. Focus Areas of US Military Test Technology Development in the Light of US Department of Defense Test & Evaluation/Science & Technology Program[J]. Measurement & Control Technology, 2020, 39(10): 1-8.(in Chinese)

[17] 杨俊岭,周宇.2019年美军试验鉴定热点综述[EB/OL]. (2020-01-21) [2021-05-24]. https:∥ www. sohu.com /a/368196290_635792.

Yang Junling, Zhou Yu. A Review of the Hot Spots of Test Identification in the US Military in 2019[EB/OL]. (2020-01-21) [2021-05-24]. https:∥ www. sohu.com /a/368196290_635792. (in Chinese)

[18] Proud R W, Hart J J, Mrozinski R B. Methods for Determining the Level of Autonomy to Design into a Human Spaceflight Vehicle: A Function Specific Approach[EB/OL]. (2003-09-01)[2021-05-24].http:∥handle.dtic.mil/100.2/ADA515467.

[19] Vincent P, Roske, Jr. Autonomous System Challenges to Test and Evaluation[R]. National Defense Industrial Association Test & Evaluation, 2012.

[20] Fahey H K M, Miller M J. Unmanned Systems Integrated Roadmap:FY2017-2042[R]. Washington DC: Office of the under Secretary of Defense, 2017: 4-5.

[21] Durst P J, Gray W. Levels of Autonomy and Autonomous System Performance Assessment for Intelligent Unmanned Systems[R]. Defense Technical Information Center, 2014.

[22] Zhang J M, Harman M, Ma L, et al. Machine Learning Testing: Survey, Landscapes and Horizons[J]. IEEE Transactions on Software Engineering, 2019.

[23] Thompson M. Testing the Intelligence of Unmanned Autonomous Systems[J]. Security, 2008, 29: 380-387.

[24] Helle P, Schamai W, Strobel C. Testing of Autonomous Systems-Challenges and Current State-of-the-Art[J]. INCOSE International Symposium, 2016, 26(1): 571-584.

[25] Huang H M. Autonomy Levels for Unmanned Systems (ALFUS) Framework, Volume I: Terminology[R]. National Institute of Standards and Technology, 2008.

[26] 劉树光, 茹乐, 王柯. 无人机自主性评价方法新进展[J]. 飞航导弹, 2019(2): 43-49.

Liu Shuguang, Ru Le, Wang Ke. New Development of Evaluation Methods for UAV Autonomous Level [J]. Aerodynamic Missile Journal, 2019(2): 43-49.(in Chinese)

[27] Wang Y C, Liu J G. Evaluation Methods for the Autonomy of Unmanned Systems[J]. Chinese Science Bulletin, 2012, 57(26): 3409-3418.

[28] Clough B. Metrics, Schmetrics! How do You Track a UAV’s Autonomy? [C]∥1st UAV Conference, 2002.

[29] Wu L Z, Niu Y F, Zhu H Y, et al. Modeling and Characterizing of Unmanned Aerial Vehicles Autonomy[C]∥ 8th World Congress on Intelligent Control and Automation, 2010: 2284-2288.

[30] Maj Thoma T, Darryl K A. Workshop Report: Test and Evaluation of Autonomous System[C]∥STAT T&E Center of Excellence, 2016.

[31] Brian H, David S, David T. The Status of Test, Evaluation, Verification, and Validation of Autonomous System[R].2018.

[32] 中国电子技术标准化研究院.人工智能标准化白皮书[EB/OL]. (2020-01-21)[2021-05-24].http:∥www.cesi.cn/ 202107/7796.html.

China Electronics Standardization Institute. Artificial Intelligence Standardization White Paper[EB/OL]. (2020-01-21)[2021-05-24]. http:∥www.cesi.cn /202107/7796.html.(in Chinese)

Review on Testing and Evaluation of UAV’s

Autonomous Operational Ability

Du Zibing1 , Chen Yindi2*

(1.Chinese Flight Test Establishment, Xi’an 710089, China;

2.Military Science Information Research Center, Military Academy of Sciences, Beijing 100142, China)

Abstract: In order to carry out the testing and evaluation of the autonomous operational ability of the intelligent UAV , this paper studies the urgency and category of testing and evaluation for UAV autonomous ability, then discusses the main policy, plan, technology of the United States, and examines the applicability of the current typical autonomic rating evaluation model in flight test deeply. It analyzes study contents of remodeling of the test and evaluation model, building of a high-intelligent confrontation test environment, establishment of the test and evaluation technology system, forming of the autonomy level standard, construction of the general model and tools, and artificial intelligence applying in various fields of test and evaluation. Suggestions on concern the plan of test and evaluation from the top level, strengthening the application of artificial intelligence technology, increasing the construction of general model and developing the virtual reality integration test are proposed to improve the autonomous technology’s application speed and expand the operational scope of intelligent UAV.

Key words: military intelligence; artificial intelligence; UAV; autonomous operational ability; test and evaluation; autonomic rate; virtual reality integration test