一种应用于目视化瞄准的头动注视点定位算法

2020-04-02张振华贺瑾瑜田元元

李 瑞,张振华,姜 满,贺瑾瑜,田元元

(北方自动控制技术研究所,太原 030006)

0 引言

传统的火炮直瞄射击过程中,需要靠观瞄人员手动测距、瞄准、装定射角、调炮,对操作人员的熟练程度要求很高,存在着目标识别过程效率低下,目标打击准确性低的问题[1]。视线追踪技术是指通过摄像机捕捉人眼角膜闪点和瞳孔反射点位置信息获取实时的观察点位置,从而对人眼的视线进行跟踪使观察者通过眼动这种自然便捷的方式进行人机交互[2]。采用基于视线追踪的目视化瞄准技术应用于火炮的直瞄射击过程,能够通过自然的人眼识别决策,快速聚焦威胁目标,驱动火炮瞄准射击,大大改善目标识别的效率和准确性。

近年来,视线跟踪技术作为一种新型便捷的人机交互技术得到了飞速的发展和应用。在民用方面,视线跟踪技术在广告及网页设计、模拟驾驶、心理学研究、商场超市布局、人机交互、虚拟现实等领域都有广泛的应用。在军事领域[3],以色列Elbit 公司提出了将眼动设备嵌入未来头盔系统中,使得飞行员通过双眼注视即可控制红外光线跟踪敌机。英国皇家空军也在飞机空中打击军事作战应用眼动控制,配合声控装置发现目标后锁定目标并发出摧毁指令。美国海军陆战队配备的单兵头盔也植入了眼动设备帮助实现瞄准和射击。在国内的军事领域,视线跟踪技术还未得到成熟的应用,但其应用前景极为广泛,是多个预研课题的研究热点。

在视线追踪技术中,如何保证头部的运动不影响观察点的定位是研究的难点与热点[4]。传统的桌面式眼动仪使用过程中,需要保证观察者头部的静止来定位眼睛的观察点位置,无法满足现代战争对火炮观瞄系统的灵活性和便捷性要求。同时,火炮内部环境复杂恶劣,观瞄人员可能需要同时进行其他操作,因此,应用于火炮内目视化瞄准设备,需要尽可能降低对工作环境的要求和人员操作的复杂程度。

1 头部运动注视点定位算法原理

为了解决视线检测过程中的头动问题,文献[5]采用了惯性测量装置测量头部运动,并利用红外视频技术采集眼动数据同步检测,文献[6]引进了虹膜面积信息对虹膜反射点进行修正,以消除头部运动影响,文献[7]利用神经网络技术对人眼特征和屏幕坐标间的映射进行聚类,可粗略地解决小范围内头动问题。但是这些方法有的对实验环境的光学条件要求过高,有的对观察人员提出的限制过多,难以运用到火炮目视化瞄准场景中。

本文采用了一台高性能摄像机与桌面遥测式眼动仪配合,分别用于观察人体头部的空间姿态和人眼的运动状态。通过摄像机捕捉人脸图像进行识别,判断人体头部的运动信息,建立人体的空间姿态坐标系,将其与眼动信息检测的坐标系进行合成和转换,从而搭建头眼动结合的注视目标跟踪系统。通过头动检测进行视线跟踪可以确定出测试者大致的观察方向,应用于视线的粗略跟踪,结合对眼球运动的跟踪,完成对目标点的检测。从而实现视线跟踪的过程中人体头部可以自由转动,观察者空间位置不会影响观察准确性,同时在自然光条件下即可正常运行,大大提高了其通用性,使其可应用于复杂的战场环境,方便操作人员应用到目视化瞄准系统中。

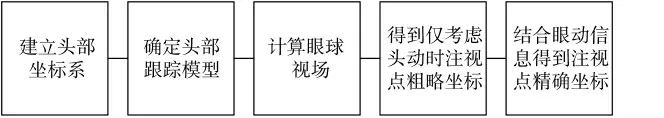

图1 头动注视点定位算法流程图

2 头动模型的建立

2.1 头动坐标系的确定

头部的运动可分类为旋转向量和平移向量。旋转向量包括绕X 轴旋转,绕Y 轴旋转,绕Z 轴旋转。平移向量则为沿着X、Y、Z 轴方向的位移。

在3D 旋转模型中,常用四元数和欧拉角来表示旋转[9]。与用矩阵表示旋转模型相比,用欧拉角来建立旋转模型可以节约存储空间且方便插值。本文对常见的笛卡尔坐标系进行变形,使之适用于头部姿态捕捉摄像机。文中以摄像机为原点搭建坐标系,坐标轴的Z 轴箭头方向为观察者方向,此时观察者的头部旋转和位置移动都可用相对坐标原点的坐标表示。

图2 以摄像机为原点的笛卡尔坐标系

四元数是一种高阶复数,用于表示一种四维的空间。指由1 个实数单位和3 个虚数单位组成的具有下列形式实元的数:

其中,e1、e2、e3是直角坐标系的3 个基元。四元数p的张量(绝对值)|p|为

当|p|=1 时,该四元数为单位四元数。一个单位四元数可以用q=[w x y z]T来表示。其中,q 为一个四元数,w 为一个实数,x、y、z 表示四元数的基元。

通过头部旋转角和绕旋转轴旋转的角度可以构造一个单位四元数:

其中,α 是绕旋转轴旋转的角度,cos(βx)、cos(βy)、cos(βz)为旋转轴在x、y、z 方向的分量。

此时该四元数可以表示为

将其转换为欧拉角[10]:

在人眼检测过程中,通过摄像头捕捉得到人体头部姿态旋转的四元数,由四元数转换为欧拉角的公式可得到头部绕x、y、z 轴旋转的旋转角度。

2.2 跟踪模型的建立

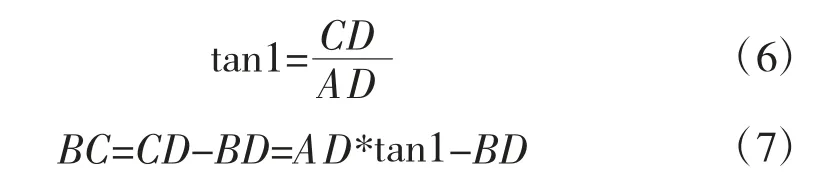

在人眼相对于头部不转动的情况下,建立人眼的头动模型。由文献[11]可知,X 轴和Y 轴方向的旋转分量可以定位一个精确的头动。因此,本文采用X 轴和Y 轴方向的旋转分量,来对人体头部的运动方向进行建模。在图2 中A 为观察者头部位置,B为头动捕捉摄像机所在位置,C 为观测点,AD 之间的距离d 为观察者到摄像机所在平面的距离,BD为观察者在X 轴方向上的偏移,该图中角1 为绕Y轴的旋转角度。通过上面的参数可求得注视点C 的位置:

图3 Y 轴方向旋转视线示意图

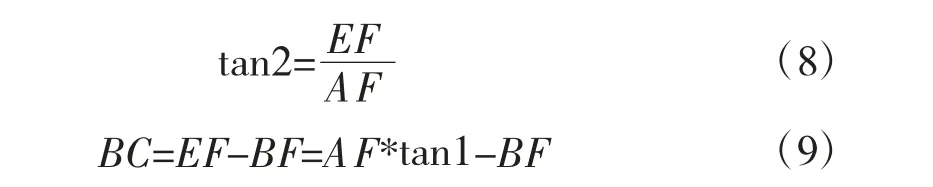

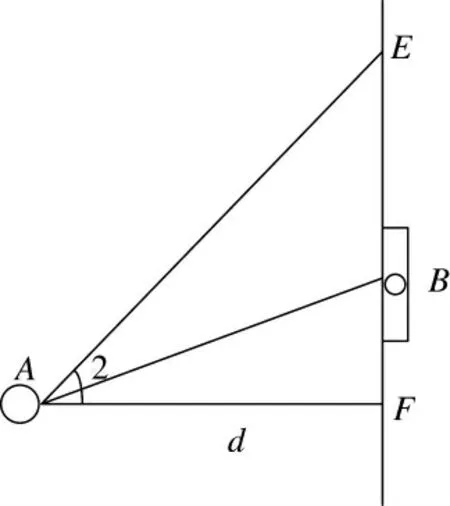

图3 中的模型为头部绕X 轴转动的情况,B 为摄像机的所在位置,c 为观测点,AF 间的距离d 为观察者到眼动仪所在平面的距离,BF 为观察者在X轴方向上的偏移,图4 中的角2 为绕X 轴的旋转角度。通过上面的参数可求得注视点E 的位置:

图4 X 轴方向旋转视线示意图

2.3 眼球视场的确定

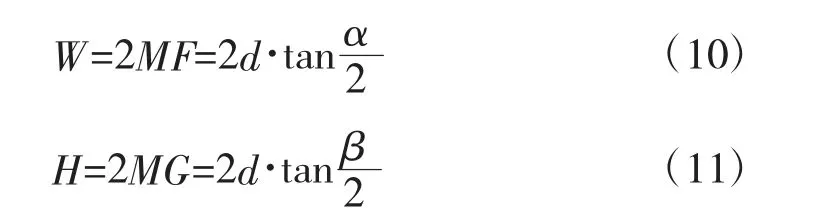

视场一词的本意是指通过望远镜观察时的观察范围。本文中的视场则指的是人眼对世界的观察范围。在头动视线跟踪过程中,注视点为视线向量和眼动仪所在平面的交点,人眼感兴趣的区域可以由人眼的视线范围确定。距离观察者距离为d 的目标场感兴趣区域有3 个参数,分别为人到目标场的距离d,视线范围的水平角α 和竖直角β。

下页图5 中标示出了人眼目标场中的感兴趣区域。图中点O 为两眼的中心点,M 点为眼球中心点在目标场的映射,四边形ABCD 为目标场的范围,将其分别按序连接组成目标场的上下左右界,点E、F、G、I 分别为边AB、DC、AD、BC 的中点。观察者目标场的最大长H 和宽W 可通过计算得到:

2.4 世界坐标与屏幕坐标的转换

在实时监测视线跟踪的结果过程中,需要确定世界坐标和屏幕坐标的对应关系,目标场以摄像机的所在位置为原点对应屏幕的中点,此时可以得到真实的世界坐标和屏幕坐标的对应关系:

图5 视线场景示意图

其中,x、y 分别为注视点所对应屏幕坐标的横纵坐标,w、h 分别为屏幕的宽和高,W、H 分别为目标场的宽和高,X、Y 为注视点在世界坐标系下的横纵坐标。此时即可计算出在只有头动情况下的注视点位置。

3 系统测试与验证

把头动摄像机放在水平面上,以视线向量与水平面的交点为中心确定目标场的范围。因为在人脸识别时需要通过头部关节点坐标确定头部区域和方向,因此,需要保证人体的头部完全呈现在摄像机的角度范围内。同时需要保证观察者的头部处于眼动仪的视线范围内,此时将头动检测技术与视线跟踪技术结合,实现人眼视线方向的感知。

在未使用本文头动检测算法时,必须保持人的头部严格放置在头部支架上,才能实现视线跟踪,一旦人体头部发生转动或平移,眼动仪检测的观察点将会脱离实际注视点甚至根本无法检测。

在使用本文算法与视线跟踪方法结合之后,实验者可以以自然的状态观察目标,在参考文献[12-13]中得出,当人眼处于自然状态观察时,头动对视线的影响与眼动对视线的影响权重比例约为0.7∶0.3。本次实验中以该比例对头动与眼动的偏移量进行结合,进行测试与验证环节。

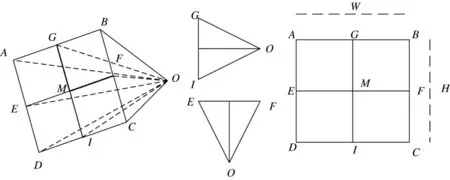

实验过程中设置5 个标定点P1、P2、P3、P4、P5,其中,P5 为目标场的中点,P1~P4 与P5 点的横坐标与纵坐标的距离均为30 cm,观察者在一段时间内分别注视这5 个点,观察过程中保持头部在不同方向和位置平移和转动,确定观测者的观察点位置。对比检测到的观察点和标定点的位置,记录其距离偏差值和角度偏差值。分析记录下来的注视点个数和偏差值如表1 所示。

图6 标定点示意图

表1 一段时间内跟踪误差统计

4 结论

通过分析火炮中目视化瞄准的实际需求,提出了将头动跟踪运用于目视化瞄准技术,以使其适用于战场环境的方案,并建立了人体头部运动时对注视点定位的算法。通过建立以头动检测摄像机为原点的直角坐标系,得到人体头部旋转的四元数和旋转角。将实际观测者的观察点映射到屏幕坐标,建立世界坐标系与屏幕坐标系的对应方程,对视线跟踪结果进行分析,证明通过本文建立的头动模型可实现对观察者在不同位置上的视线跟踪。

本文建立的头动注视点定位算法,解决了传统桌面式眼动仪应用过程中人体无法转动的问题,同时该实验系统在自然光条件下即可正常运行,实验环境较为简单。将其应用于火炮直瞄射击应用场景,可以改善观瞄人员操作难度,提高观瞄人员操作效率。