基于航拍图像与改进U-Net的建筑外墙裂缝检测方法

2024-01-03刘少华任宜春郑智雄牛孜飏

刘少华 任宜春 郑智雄 牛孜飏

摘要:针对建筑外墙裂缝人工检测方法检测效率低、检测效果和安全性差的问题,提出基于航拍图像与计算机视觉的裂缝检测方法。使用无人机绕建筑物航拍采集裂缝图像,并构建裂缝数据集;优化U-Net模型以解决细长裂缝分割不连续、复杂背景下裂缝漏检及背景误检的问题。将模型编码网络替换为预训练的ResNet50以提升模型特征表达能力;添加改进的多孔空间金字塔池化(Atrous Spatial Pyramid Pooling,ASPP)模块,获取多尺度上下文信息;采用改进的损失函数处理裂缝图像正负样本分布极度不均的问题。结果表明:改进的U-Net模型解决了原模型存在的问题,IoU指标和F1_score分别提升了3.53%、4.18%;与经典分割模型相比,改进模型的裂缝分割性能最优。与人工检测方法相比,所提方法可以安全、高效且准确地进行建筑外墙裂缝检测。

关键词:建筑外墙裂缝;无人机;计算机视觉;语义分割;U-Net

中图分类号:TU17 文献标志码:A 文章编号:2096-6717(2024)01-0223-09

Building exterior wall crack detection based on aerial images and improved U-Net

LIU Shaohua1, REN Yichun1, ZHENG Zhixiong2, NIU Ziyang2

(1. School of Civil Engineering, Changsha University of Science and Technology, Changsha 410114, P. R. China;

2. China Construction Fifth Engineering Bureau Co., Ltd, Changsha 410007, P. R. China)

Abstract: Aiming at the problems of low efficiency, unsatisfactory detection effect and poor safety of manual detection methods for building exterior wall cracks, a crack detection method based on aerial images and computer vision was proposed. Firstly, the Unmanned Aerial Vehicle (UAV) was used to collect the crack images through aerial photography around the buildings, and a crack dataset was constructed. Secondly, the U-Net was optimized to solve the problems of discontinuous segmentation of slender cracks as well as the missed and false detection under complex backgrounds. The encoder was replaced with pre-trained ResNet50 to improve the feature expression ability of the model. An improved Atrous Spatial Pyramid Pooling (ASPP) module was added to obtain multi-scale context information. The improved loss function was used to deal with the problem of extremely uneven distribution of positive and negative samples in crack images. Experiments show that the improved U-Net model solved the problems existing in the original model; the IoU and F1_score were increased by 3.53% and 4.18%, respectively. Compared with the classical segmentation model, the improved model has the best crack segmentation performance. Compared with manual detection methods, it can efficiently, accurately, and safely detect building exterior wall cracks.

Keywords: building exterior wall cracks; UAV; computer vision; semantic segmentation; U-Net

建筑外墻裂缝会使带腐蚀性的雨水渗入墙体,导致墙体涂料与防水材料等发霉、剥落,不仅影响建筑美观,甚至锈蚀墙内钢筋等材料,破坏墙体结构,带来安全隐患。准确检测出裂缝位置,可以为制定有效的维护方案提供依据。目前,建筑外墙裂缝主要采用人工检测,这是一种高空作业,不仅危险,而且检测效率和精度都很低。如何安全、高效地检测建筑外墙裂缝成为亟须解决的问题。

计算机视觉为裂缝检测提供了一种非接触式的检测技术[1],包括图像处理和深度学习两类方法。基于图像处理的裂缝检测方法根据裂缝的纹理和边缘等特征,人为设计裂缝检测的依据,实现裂缝检测[2]。这种方法够在特定的数据集上取得良好的检测效果,但是裂缝的检测精度不高,且需要针对特定的图像设计专门的裂缝检测算法。近年来,基于深度学习的方法在裂缝检测领域取得了显著的成果,根据裂缝检测方式的不同可将其分为3类:图像分类、目标检测与语义分割。基于图像分类[3]与目标检测[4]的裂缝检测方式,只能识别并定位裂缝,不能在像素级别上标记裂缝,从而无法获得裂缝形状信息;基于语义分割的裂缝检测方法是对图像中的每个像素点进行分类,能将裂缝像素准确标记出来,既可以检测有无裂缝,又能得到裂缝的位置、形状等信息[5]。经典语义分割模型U-Net[6]、DeepLabv3+[7]、PSPNet[8]及其改进模型在桥梁、路面及隧道等领域的裂缝检测中得到广泛应用。李良福等[9]提出了改进的PSPNet模型,解决了桥梁裂缝分割细节信息丢失的问题;Li等[10]提出了一种可训练的上下文编码网络,实现了复杂条件下桥梁裂缝的检测;曹锦纲等[11]提出了一种基于注意力机制的网络,实现了自动准确地路面裂缝检测;Nguyen等[12]提出了一种两级卷积神经网络来处理含噪声和低质量的道路图像;孟庆成等[13]用改进的MobileNet_v2替换U-Net编码器,实现了对混凝土裂缝的实时检测;Dang等[14]提出了改进的U-Net模型,在满足裂缝分割性能要求的基础上支持裂缝自动测量。上述模型在裂缝检测中的成功应用,表明深度学习方法在裂缝检测领域具有广阔的应用前景。

建筑外墙裂缝与桥梁、路面等混凝土裂缝拥有共同特征,然而建筑外墙因其材料多样性,且墙体包含复杂建筑构件,导致建筑外墙裂缝图像背景更加复杂,存在更多的背景噪声。因此,有必要为建筑外墙裂缝检测针对性地设计一个深度学习模型。基于深度学习的裂缝检测方法在训练和预测阶段都依赖原始图像数据,人工采集大型建筑的外墙图像需高空作业,存在安全隐患大、效率低等问题。近年来,无人机技术取得快速发展,无人机搭载传感器为高空采集图像提供了一种安全且高效的方式,在抗震救灾、农业植保等领域得到广泛应用[15]。笔者使用无人机航拍采集建筑外墙图像,并根据裂缝图像特征设计了改进的U-Net模型用于裂缝检测。

1 裂缝数据集构建

1.1 图像采集与处理

图像采集包括裂缝数据集构建和裂缝检测两个阶段。在构建数据集时,为了保证训练后模型的鲁棒性,需要广泛采集各类型建筑外墙图像,包括不同光照条件、不同拍摄角度及不同航拍间距等。在裂缝检测阶段,需要根据裂缝检测精度要求来设计图像采集方案,规划采集路线、航拍间距等以确定裂缝位置及图像像素比例尺,从而指导裂缝修复与建筑维护。

广泛采集原始建筑外墙图像以构建建筑外墙裂缝数据集。共得到建筑外墙裂缝图像566张,分辨率大小为8 000×6 000。由于采集的图像分辨率过大,不利于模型训练,且裁剪后的裂缝图像细节信息更加丰富,于是对图像进行裁剪。利用滑动窗口方法将原图裁剪为512×512大小的子图,第1步:从图像左上角开始,沿着自左向右、自上而下的顺序依次裁剪,得到子图165张,保证子图覆盖原图,避免信息丢失;第2步:在图像左下角7 488×5 488范围内随机选择35个点作为子图左下角进行裁剪,得到子图35张,用于信息补充。在完成所有图像裁剪后,剔除非建筑外墙图像及不含裂缝的背景图像后共得到裂缝图像3 862张。

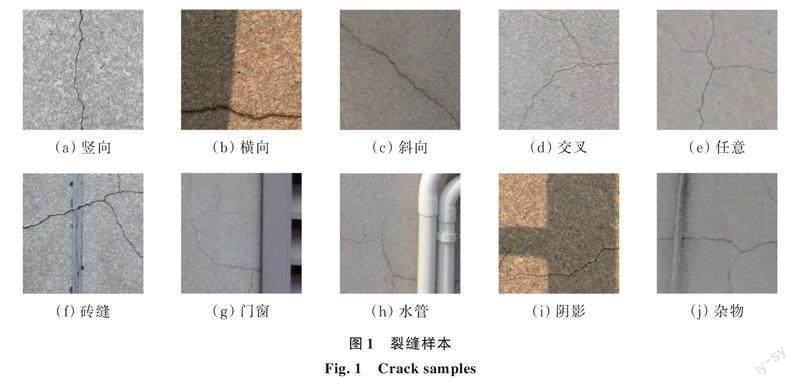

为了确保模型的泛化性能和复杂背景下裂缝分割的鲁棒性,必须保证裂缝图像数据中裂缝样本及图像背景的多样性和复杂度。无人机航拍包括不同天气状况、一天的不同时间段,因光照条件不同,得到明暗程度不同的裂缝图像;裂缝图像包含的裂缝类型全面,包括纵向、横向、斜向、交叉及任意分布的裂缝图像,且图像背景丰富,包括不同材料建筑外墙下砖缝、门窗、排水管、阴影及杂物等背景,部分裂缝图像如图1所示。

1.2 图像标注

为了保证数据集的可靠性,使用开源的分割任务标注软件labelme对裂缝进行人工标注。首先,沿着裂缝边缘逐点勾勒出裂缝的轮廓,生成一个包含裂缝位置坐标的json文件,然后用python代码将其转化为可供计算机学习的二值图像,标记结果如图2所示。

在完成裂缝数据集构建后,按照8∶1∶1的比例将数据集划分为训练集、验证集和测试集,其中训练集3 102张,验证集与测试集各380张。

2 研究方法

2.1 U-Net模型

U-Net是在全卷积神经网络的基础上提出用于医学图像分割的网络模型。该模型是一个对称编解码结构,包括编码器、解码器两个部分。其独特之处在于将编码器中低分辨率特征图通过跳跃连接直接拼接到对应解码器上采样生成的特征图,从而有效融合浅层纹理特征和深层语义特征,有利于图像分割。

编码器是由两个无填充的3×3卷积重复应用组成,每一个卷积后面有一个ReLU激活函数,两次卷积之后有一个2×2最大池化,用于下采样。编码器一共包含4个下采样,每一个下采样中,将特征通道的数量增加一倍,特征图大小减为一半。编码器主要负责提取输入图像的特征信息,并將多个尺度的特征图传入解码器。

解码器是模型的加强特征提取网络,利用转置卷积对主干网络获取的5个初步有效特征层进行上采用,并进行特征融合,最终得到一个融合了所有特征的有效特征层。

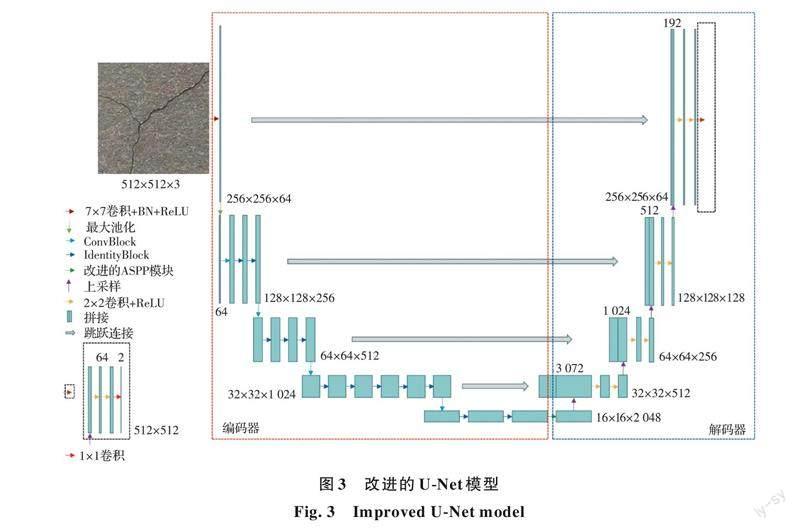

2.2 改进的U-Net模型

研究表明:U-Net模型存在细长裂缝分割不连续、复杂背景下裂缝漏检及背景误检的问题。分析其可能原因为:1)裂缝图像正负样本分布不均对模型性能造成影响;2)模型特征提取能力不足导致裂缝漏检及误检;3)缺少获取多尺度信息的能力导致裂缝分割不连续及背景误检。在分析原因基础上提出了基于U-Net的改进模型,相对于原模型做出了3点具有针对性的改进:1)使用改进的损失函数处理裂缝图像正负样本分布极度不均衡的问题;2)使用预训练的ResNet50网络替换原模型的编码网络,以提升模型特征表达能力;3)添加改进的ASPP模块,获取多尺度上下文信息。网络结构如图3所示。

2.2.1 残差神经网络

理論上,神经网络的层数越多即深度学习模型越深,网络的特征表达能力越强。但神经网络达到一定深度时,继续加深会因为反向传播过程梯度消失导致模型性能变得更差。为了解决这个问题,He等[16]提出了用跳跃连接解决网络加深造成梯度消失的残差神经网络(ResNet),包括Conv Block和Identity Block两个基本模块,Conv Block改变网络的维度,用来调整特征图大小和层数;Identity Block不改变网络维度,用来加深网络,结构如图4所示。

基于深度学习的方法对建筑外墙裂缝图像分割,然而裂缝的标注难度较大,自制大型数据集成本太高且不实际,为了克服深度学习方法依赖大量训练样本的问题,引入迁移学习方法。基于特征提取的迁移,用ImageNet数据集上预训练好的深度残差网络(删除最后的平均池化层、全连接层和softmax层),替换U-Net网络原来由两层卷积加一层池化组成的编码网络。

2.2.2 ASPP模块

受空间金字塔池化(Spatial Pyramid Pooling, SPP)模块[8]启发,Chen等[7]提出了ASPP模块,结构如图5所示。

采用并行的多个具有不同扩张率的扩张卷积,每个分支使用不同扩张率单独进行图像特征提取,并将各分支提取特征进行融合,从而提取得到多尺度的图像信息。该模块可以有效避免局部信息丢失,增加远距离信息的相关性。

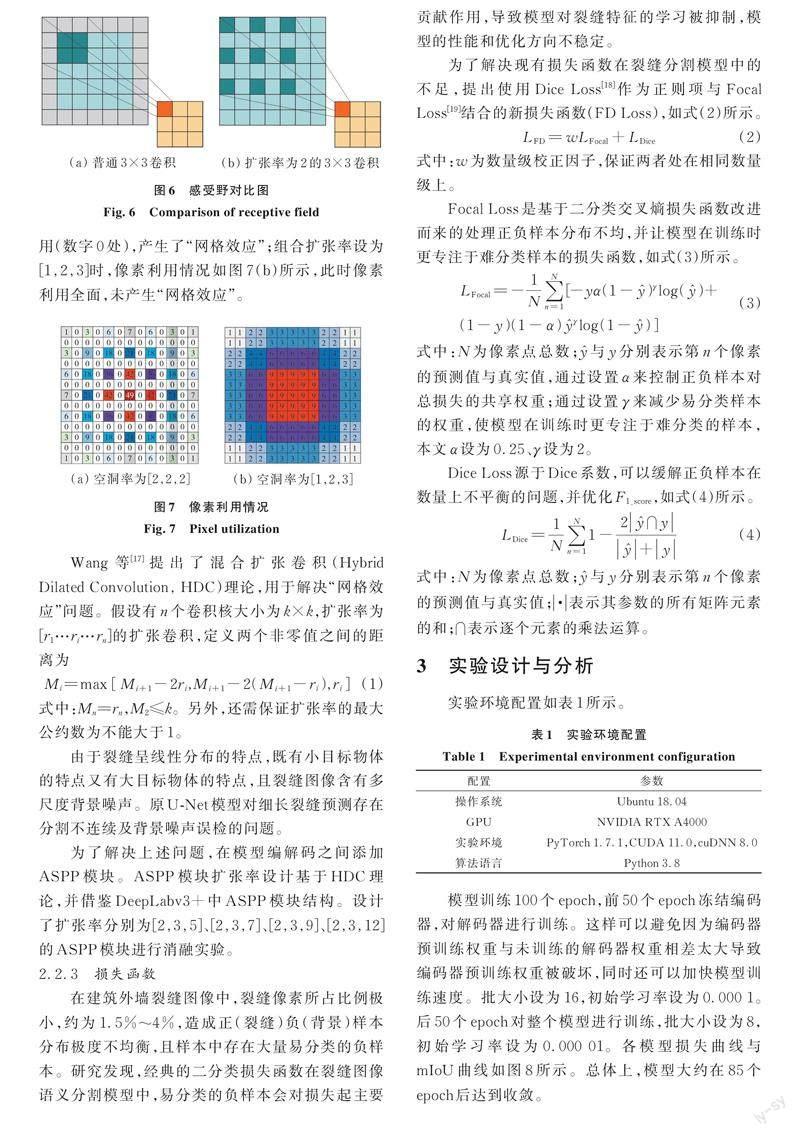

扩张卷积是在普通卷积中增加“空洞”来扩大感受野的卷积,相对于普通卷积增加了“扩张率”这个超参数。通过设置扩张率的大小,可以实现相同参数量和计算量下更大的感受野。如图6所示,扩张率为2的3×3卷积核与普通3×3卷积核相比,感受野由3×3扩大为5×5。

值得注意的是,组合扩张卷积的扩张率设置不当会产生“网格效应”。当卷积核大小为3×3,组合扩张率设为[2,2,2]时,像素利用情况如图7(a)所示(数字表示像素利用次数),此时,大量像素未被利用(数字0处),产生了“网格效应”;组合扩张率设为[1,2,3]时,像素利用情况如图7(b)所示,此时像素利用全面,未产生“网格效应”。

Wang等[17]提出了混合扩张卷积(Hybrid Dilated Convolution, HDC)理论,用于解决“网格效应”问题。假设有n个卷积核大小为k×k,扩张率为[r1…ri…rn]的扩张卷积,定义两个非零值之间的距离为

式中:Mn=rn,M2≤k。另外,还需保证扩张率的最大公约数为不能大于1。

由于裂缝呈线性分布的特点,既有小目标物体的特点又有大目标物体的特点,且裂缝图像含有多尺度背景噪声。原U-Net模型对细长裂缝预测存在分割不连续及背景噪声误检的问题。

为了解决上述问题,在模型编解码之间添加ASPP模块。ASPP模块扩张率设计基于HDC理论,并借鉴DeepLabv3+中ASPP模块结构。设计了扩张率分别为[2,3,5]、[2,3,7]、[2,3,9]、[2,3,12]的ASPP模块进行消融实验。

2.2.3 损失函数

在建筑外墙裂缝图像中,裂缝像素所占比例极小,约为1.5%~4%,造成正(裂缝)负(背景)样本分布极度不均衡,且样本中存在大量易分类的负样本。研究发现,经典的二分类损失函数在裂缝图像语义分割模型中,易分类的负样本会对损失起主要贡献作用,导致模型对裂缝特征的学习被抑制,模型的性能和优化方向不稳定。

3 实验设计与分析

实验环境配置如表1所示。

模型训练100个epoch,前50个epoch冻结编码器,对解码器进行训练。这样可以避免因为编码器预训练权重与未训练的解码器权重相差太大导致编码器预训练权重被破坏,同时还可以加快模型训练速度。批大小设为16,初始学习率设为0.000 1。后50个epoch对整个模型进行训练,批大小设为8,初始学习率设为0.000 01。各模型损失曲线与mIoU曲线如图8所示。总体上,模型大约在85个epoch后达到收敛。

3.1 评价指标

对于二分类问题,在进行结果评价时,可将样例根据其真实类别与预测类别的组合划分为真正例(TP)、假正例(FP)、真反例(TN)、假反例(FN)4种情形。

使用交并比(IoU)、精准率(Precision)、召回率(Recall)和F1_score这4个指标,对网络模型的分割性能进行定量评估。

IoU突出预测结果与标签的重合度,是常见的图像分割评价指标;Precision突出预测结果中误检像素的比例;Recall突出漏检的比例;F1_score综合考虑了Precision与Recall,F1_score值越大代表模型性能越好。

3.2 实验分析

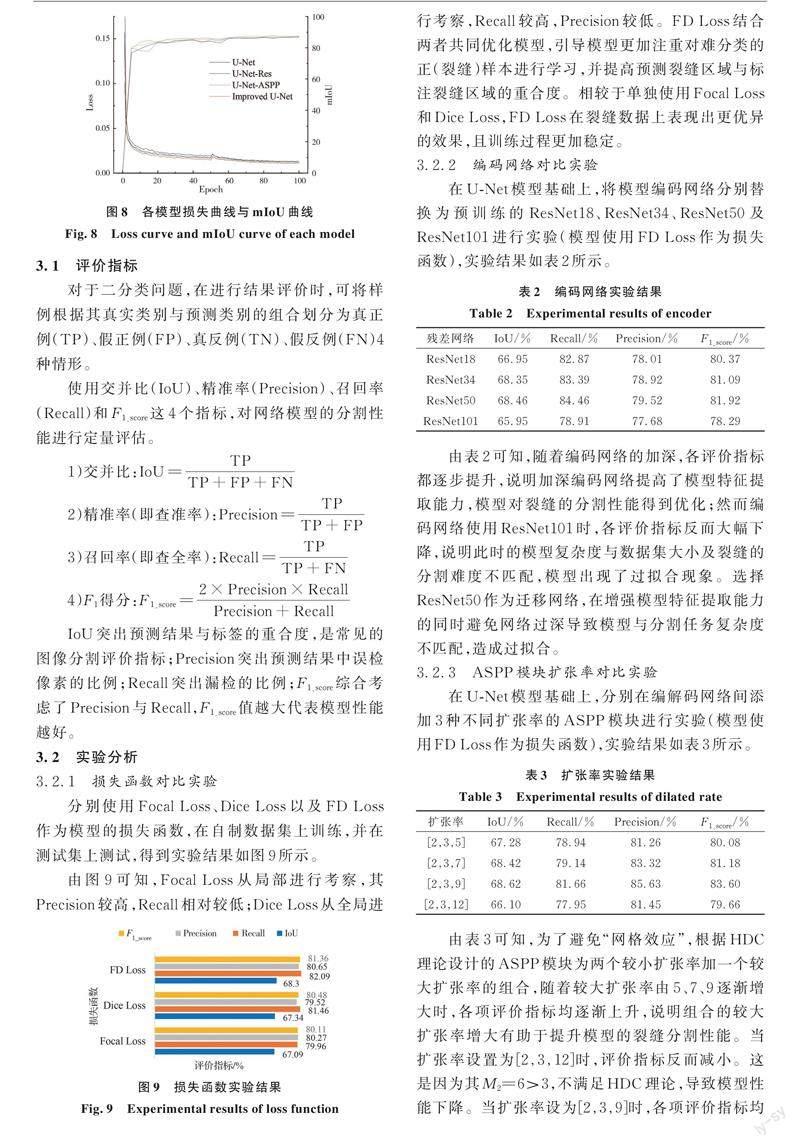

3.2.1 损失函数对比实验

分别使用Focal Loss、Dice Loss以及FD Loss作为模型的损失函数,在自制数据集上训练,并在测试集上测试,得到实验结果如图9所示。

由图9可知,Focal Loss从局部进行考察,其Precision较高,Recall相对较低;Dice Loss从全局进行考察,Recall较高,Precision较低。FD Loss结合两者共同优化模型,引导模型更加注重对难分类的正(裂缝)样本进行学习,并提高预测裂缝区域与标注裂缝区域的重合度。相较于单独使用Focal Loss和Dice Loss,FD Loss在裂缝数据上表现出更优异的效果,且训练过程更加稳定。

3.2.2 编码网络对比实验

在U-Net模型基础上,将模型编码网络分别替换为预训练的ResNet18、ResNet34、ResNet50及ResNet101进行实验(模型使用FD Loss作为损失函数),实验结果如表2所示。由表2可知,随着编码网络的加深,各评价指标都逐步提升,说明加深编码网络提高了模型特征提取能力,模型对裂缝的分割性能得到优化;然而编码网络使用ResNet101时,各评价指标反而大幅下降,说明此时的模型复杂度与数据集大小及裂缝的分割难度不匹配,模型出现了过拟合现象。选择ResNet50作为迁移网络,在增强模型特征提取能力的同时避免网络过深导致模型与分割任务复杂度不匹配,造成过拟合。

3.2.3 ASPP模块扩张率对比实验

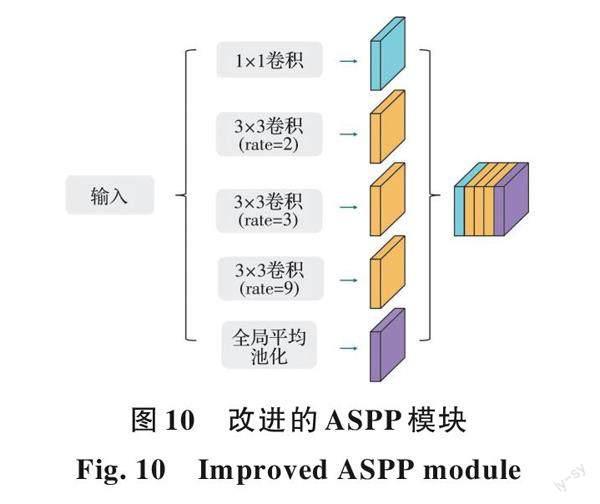

在U-Net模型基礎上,分别在编解码网络间添加3种不同扩张率的ASPP模块进行实验(模型使用FD Loss作为损失函数),实验结果如表3所示。由表3可知,为了避免“网格效应”,根据HDC理论设计的ASPP模块为两个较小扩张率加一个较大扩张率的组合,随着较大扩张率由5、7、9逐渐增大时,各项评价指标均逐渐上升,说明组合的较大扩张率增大有助于提升模型的裂缝分割性能。当扩张率设置为[2,3,12]时,评价指标反而减小。这是因为其M2=6>3,不满足HDC理论,导致模型性能下降。当扩张率设为[2,3,9]时,各项评价指标均达到最高,模型分割性能最优。基于此,改进的ASPP模块选择扩张率为[2,3,9]的一组扩张卷积,结构如图10所示。

改进的ASPP模块首先使用一个1×1的普通卷积作为第1层,保留原特征图以补充空间信息;然后使用扩张率为[2,3,9]的扩张卷积作为2到4层,提取多尺度物体的特征;最后使用全局平均池化作为第5层,获取全局特征。

3.2.4 消融实验

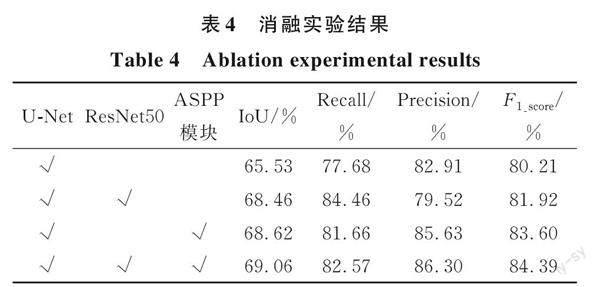

为了验证改进策略对提高模型分割性能的有效性,在自制数据集上进行消融实验。分别验证进行迁移学习、添加改进的ASPP模块以及二者组合对模型分割效果的影响(模型都使用FD Loss作为损失函数),实验结果如表4所示。

比较实验结果可知,在改进损失函数的基础上用ResNet50替换编码网络,Recall提升了6.78%,同时IoU、Precision和F1_score都有相应的提升,说明引入迁移学习的U-Net模型可以提取更丰富的裂缝特征,减少了部分裂缝不能被准确分割的状况;在改进损失函数的基础上添加改进的ASPP模块,Precision提升了2.72%,同时IoU、Recall和F1_score都有相应的提升,说明改进的ASPP模块获取多尺度上下文信息的能力在U-Net模型中得到利用,降低了将背景误检为裂缝的状况,保证了裂缝分割的连续性;改进的U-Net模型是在改进损失函数的基础上引入迁移学习方法并加入改进的ASPP模块,与单个改进策略相比,以上评价指标都有一定的提升,说明用ResNet50替代编码网络与添加改进的ASPP模块可以共同优化模型,并提升模型性能。与原模型相比,IoU指标和F1_score分别提升了3.53%、4.18%,说明所提改进策略有效提升了模型的裂缝分割性能。

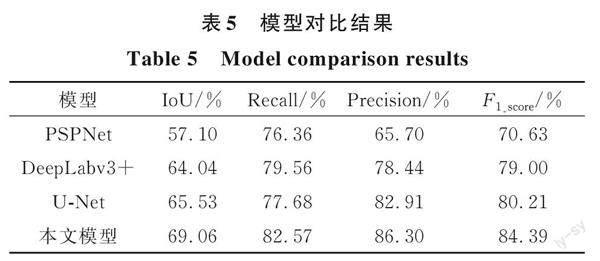

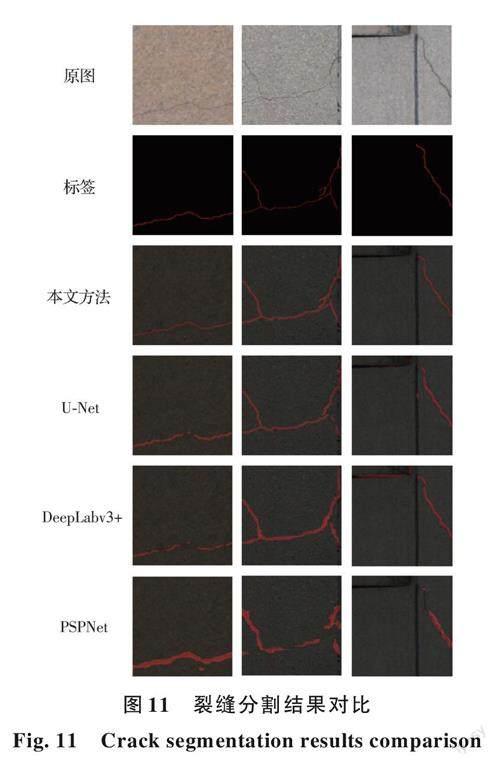

3.2.5 经典语义分割模型对比

为了验证改进模型的先进性和鲁棒性,在自制建筑外墙裂缝数据集上复现了经典语义分割模型U-Net、DeepLabv3+及PSPNet,并与模型进行对比。为了确保实验有效性,各模型在相同实验参数下进行训练。通过评价指标与分割结果进行定性与定量地对比模型性能。不同模型在建筑外墙裂缝数据集上实验结果如表5所示。

由表5可知,改进的U-Net模型各项评价指标分别为69.06%、82.57%、86.3%、84.39%,均高于其他语义分割模型,说明模型对建筑外墙裂缝分割具有最优的性能。

为了更直观地对比经典模型与本文模型对建筑外墙裂缝图像的分割效果,选取3张分别包含细长裂缝、任意分布裂缝及复杂背景噪声的裂缝图像进行预测,得到各模型的分割结果如图11所示。

由图11可知,经典语义分割模型在裂缝数据集上训练后均能进行裂缝分割,但由于原模型并非针对裂缝特征进行设计,故裂缝分割效果较差,存在大量漏检和误检的情况。对比经典模型分割效果可知,U-Net模型对裂缝的分割效果较理想,存在少量误检和漏检的情况;Deeplabv3+模型对裂缝的分割效果较U-Net要差,漏检和误检情况更加明显;PSPNet模型对裂缝的分割效果较差,不仅分割粗糙,且存在大量漏检和误检。与经典模型相比,针对裂缝特征改进的U-Net模型对裂缝分割不仅准确,而且分割精细,与标签图像基本一致;与U-Net模型相比,改进模型解决了原模型细长裂缝分割不连续、复杂背景下裂缝漏检及背景误检的问题。

4 结论

针对建筑外墙裂缝人工检测方法效率低、检测效果和安全性差的问题,提出基于无人机航拍与计算机视觉的裂缝检测方法。针对U-Net模型存在的问题进行改进,并进行对比实验,得出以下结论:

1)无人机灵活性强,可以绕建筑飞行并快速获取高清的外墙图像。在构建裂缝数据集和建筑外墙裂缝定期检测阶段,可以使用无人机绕建筑航拍实现安全、高效地采集建筑外墙图像。

2)提出了组合Focal Loss与Dice Loss的FD Loss,用于模型优化。新损失函数具有更强的处理正负样本分布不均的能力,保证了模型训练过程的稳定性,并提高了模型对裂缝的分割性能。

3)所提改进的U-Net模型增强了模型编码网络的特征提取能力,以及模型获取多尺度上下文信息的能力,解决了原模型细长裂缝分割不连续、复杂背景下裂缝漏检及背景误检的问题,IoU指标和F1_score分别提升了3.53%、4.18%。实验表明,改进的U-Net模型可以对复杂背景下的裂缝进行准确识别,具有较强的鲁棒性。

4)所提基于无人机航拍与计算机视觉的建筑外墙裂缝检测方法,使用无人机获取裂缝图像,并利用改进的U-Net模型对裂缝进行检测。该方法解决了传统建筑外墙裂缝检测方法需要人工高空作业带来的安全问题,并提高了裂缝检测的效率和精度。

参考文献

[1] 周颖, 刘彤. 基于计算机视觉的混凝土裂缝识别[J]. 同济大学学报(自然科学版), 2019, 47(9): 1277-1285.

ZHOU Y, LIU T. Computer vision-based crack detection and measurement on concrete structure [J]. Journal of Tongji University (Natural Science), 2019, 47(9): 1277-1285. (in Chinese)

[2] MUNAWAR H S, HAMMAD A W A, HADDAD A, et al. Image-based crack detection methods: A review [J]. Infrastructures, 2021, 6(8): 115.

[3] DAIS D, BAL I E, SMYROU E, et al. Automatic crack classification and segmentation on masonry surfaces using convolutional neural networks and transfer learning [J]. Automation in Construction, 2021, 125: 103606.

[4] 宋立博, 费燕琼. 两类YOLOv4-tiny简化网络及其裂缝检测性能比较[J]. 同济大学学报(自然科学版), 2022, 50(1): 129-137.

SONG L B, FEI Y Q. Comparison of two types YOLOv4-tiny simplified networks and their crack detection performance [J]. Journal of Tongji University (Natural Science), 2022, 50(1): 129-137. (in Chinese)

[5] JU H Y, MA T, LI W, et al. Pixelwise asphalt concrete pavement crack detection via deep learning-based semantic segmentation method [J]. Structural Control and Health Monitoring, 2022, 29(8): e2974.

[6] RONNEBERGER O, FISCHER P, BROX T. U-Net: Convolutional networks for biomedical image segmentation [C]//Proceedings of the 18th International Conference on Medical Image Computing and Computer-Assisted Intervention. Munich, Germany. 2015: 234-241.

[7] CHEN L C, ZHU Y K, PAPANDREOU G, et al. Encoder-decoder with atrous separable convolution for semantic image segmentation [C]//Proceedings of the 15th European Conference on Computer Vision. Munich, Germany. 2018: 833-851.

[8] ZHAO H S, SHI J P, QI X J, et al. Pyramid scene parsing network [C]//2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, HI, USA. IEEE, 2017: 6230-6239.

[9] 李良福, 王楠, 武彪, 等. 基于改进PSPNet的桥梁裂缝图像分割算法[J]. 激光与光电子学进展, 2021, 58(22): 101-109.

LI L F, WANG N, WU B, et al. Segmentation algorithm of bridge crack image based on modified PSPNet [J]. Laser & Optoelectronics Progress, 2021, 58(22): 101-109. (in Chinese)

[10] LI G, LI X, ZHOU J, et al. Pixel-level bridge crack detection using a deep fusion about recurrent residual convolution and context encoder network [J]. Measurement, 2021, 176: 109171.

[11] 曹錦纲, 杨国田, 杨锡运. 基于注意力机制的深度学习路面裂缝检测[J]. 计算机辅助设计与图形学学报, 2020, 32(8): 1324-1333.

CAO J G, YANG G T, YANG X Y. Pavement crack detection with deep learning based on attention mechanism [J]. Journal of Computer-Aided Design & Computer Graphics, 2020, 32(8): 1324-1333. (in Chinese)

[12] NGUYEN N H T, PERRY S, BONE D, et al. Two-stage convolutional neural network for road crack detection and segmentation [J]. Expert Systems with Applications, 2021, 186: 115718.

[13] 孟庆成,李明健,万达,等.基于M-Unet的混凝土裂缝实时分割算法[J].土木与环境工程学报(中英文), 2024, 46(1): 215-222.

MENG Q C, LI M J, WAN D, et al. Real-time concrete crack segmentation algorithm based on M-Unet [J]. Journal of Civil and Environmental Engineering, 2024, 46(1): 215-222. (in Chinese)

[14] DANG L M, WANG H, LI Y, et al. Automatic tunnel lining crack evaluation and measurement using deep learning [J]. Tunnelling and Underground Space Technology, 2022, 124: 104472.

[15] LI Y, ZHANG J H, GUAN Z G, et al. Experimental study on the correlation between crack width and crack depth of RC beams [J]. Materials, 2021, 14(20): 5950.

[16] HE K M, ZHANG X Y, REN S Q, et al. Deep residual learning for image recognition [C]//2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, NV, USA. IEEE, 2016: 770-778.

[17] WANG P Q, CHEN P F, YUAN Y, et al. Understanding convolution for semantic segmentation [C]//2018 IEEE Winter Conference on Applications of Computer Vision. Lake Tahoe, NV, USA. IEEE, 2018: 1451-1460.

[18] MILLETARI F, NAVAB N, AHMADI S A. V-net: Fully convolutional neural networks for volumetric medical image segmentation [C]//2016 Fourth International Conference on 3D Vision (3DV). Stanford, CA, USA. IEEE, 2016: 565-571.

[19] LIN T Y, GOYAL P, GIRSHICK R, et al. Focal loss for dense object detection [C]//2017 IEEE International Conference on Computer Vision. Venice, Italy. IEEE, 2017: 2999-3007.

(編辑 胡玲)

DOI: 10.11835/j.issn.2096-6717.2022.145

收稿日期:2022⁃09⁃27

基金项目:湖南省自然科学基金(2021JJ30716);湖南省高新技术产业科技创新引领计划(2020KG2026);长沙理工大学土木工程优势特色重点学科创新性项目(16ZDXK05)

作者简介:刘少华(1999- ),男,主要从事计算机视觉与健康监测研究,E-mail:liushaohua2020@163.com。

Received: 2022⁃09⁃27

Foundation items: Natural Science Foundation of Hunan Province (No. 2021JJ30716); High-Tech Industry Science and Technology Innovation Leading Plan Project of Hunan Province (No. 2020KG2026); Civil Engineering Advantage Characteristic Key Discipline Innovation Project of Changsha University of Science and Technology (No. 16ZDXK05)

Author brief: LIU Shaohua (1999- ), main research interests: computer vision and health monitoring, E-mail: liushaohua2020@163.com.