一种高效运动想象脑电信号浅层卷积解码网络

2023-10-29李文平徐光华张凯张四聪赵丽娇李辉

李文平,徐光华,2,张凯,张四聪,赵丽娇,李辉

(1. 西安交通大学机械工程学院,710049,西安; 2. 西安交通大学机械制造系统工程国家重点实验室,710054,西安; 3. 西安交通大学经济与金融学院,710061,西安)

脑-机接口(brain-computer interface, BCI)是一种允许使用者使用大脑神经信号来控制如假肢、外骨骼、轮椅等外部设备的系统[1-3]。基于运动想象(motor imagery, MI)范式的脑-机接口系统,其典型过程为采集大脑在动作想象时的电信号,经过数据预处理与特征提取,再对想象任务进行识别与分类,最后形成相对应的控制指令[4]。目前用于运动想象脑-机接口系统的脑电信号有植入脑电、皮层脑电和头皮脑电[5]等。头皮脑电采用电极帽或将电极平贴于头皮上记录数据,是一种非侵入式的信号,与其他脑电信号相比,具有安全性高、易用、低成本、便携等方面的优点,但同时也牺牲了信噪比与空间分辨率[6-7]。由于基于运动想象的脑-机接口系统的性能主要取决于信号解码算法的性能,因此提高解码算法的信息传输率对提升脑-机接口系统性能有着至关重要的作用。

共空间模式(common spatial pattern,CSP)特征提取方法,结合支持向量机(SVM)等机器学习分类算法,在二分类任务的运动想象脑电解码方面取得了较好的效果[8-9]。之后,许多学者对初始的CSP方法进行了诸多改进研究,Ang 等[10]针对CSP方法中频带选择问题,提出了滤波器组共空间模式(FBCSP)算法,使用等频宽的滤波器组对信号进行分解,在每个频段信号提取CSP特征,再使用互信息的特征选择方法进行特征选择。鉴别滤波器组CSP (DFBCSP) 算法[11]、共时空频CSP(CTFSP)算法[12]、双谱熵(BECSP)算法[13]等一系列优化算法被相继提出,以期能提取更加显著的运动想象脑电信号特征。然而,上述运动想象解码算法均需要手动对信号进行特征提取,因此解码的性能十分依赖于专业的相关知识与经验。

基于人工神经网络(ANN)的深度学习方法很大程度上缓解了人工参与特征提取的需求,例如,在计算机视觉(CV)[14]与语音识别(audio recognition)[15]领域已经实现了远超于人工提取特征的识别效果,并获得了最先进的性能。近年来,许多研究已经关注到深度学习算法在脑电信号处理上的应用[16]。Schirrmeister等[17]提出了一种适用于脑电信号分类的深度卷积网络(DeepConvNet)。Lawhern等[18]提出了可以跨范式、跨被试且效果较好的脑电信号解码网络(EEGNet),模型具有很强的泛化能力。Liu等[19]提出时间和通道注意卷积网络(TCACNet),实现了对脑电信号的分类。上述基于深度学习的算法,通过自适应训练的深度网络实现了对原始脑电信号的模式识别,在大量数据的支持下能够取得很好的识别效果。

但是,深度学习在脑电信号识别领域仍存在以下问题。首先,运动想象作为一种内源性的脑-机接口范式,神经电信号来源于特定区域、特定时间以及个体差异性的节律,特征呈现出较强的时间-空间-频率耦合特性[12, 20-21],加之头皮脑电对神经信号质量的折损,如何自适应地提取到这些强耦合的特征是需要研究的重点[22];其次,深度网络的训练参数随网络深度与广度的增加而增加,随之带来的是更多的训练数据样本需求[23],为算法的实际应用造成阻碍;最后,在脑-机接口的实际应用场景中,要想普及更多的设备使用场景,就要追求比较高的信号解码准确率,还需要更快的神经网络训练速度与更低的计算资源占用[24]。

针对上述问题,本文在EEGNet网络模型的基础上,提出了一种改进的运动想象脑电信号浅层卷积解码网络(Faster-EEGNet)。通过新的神经网络结构,增强了对运动想象时间-空间-频率耦合特征的提取能力。该网络可训练参数只有104量级,对训练样本数要求较低;最后通过结构优化,明显提升了网络卷积运算速度,使得实验中的训练用时减少了44.8%。

1 基于深度学习的运动想象解码算法

1.1 EEGNet网络结构

EEGNet是Lawhern等[18]受到FBCSP算法启发构建的一个紧凑式的、可以用于运动想象脑电信号识别的可训练神经网络,其网络结构如图1所示。

图1 EEGNet网络结构Fig.1 Structure of EEGNet network

网络输入层输入的脑电信号数据为通道数×采样数;紧接着为中间层,其第1层是二维卷积层,卷积核尺寸与脑电数据采样率有关,设L=0.5fs(fs为脑电数据采样频率),则卷积核尺寸为L×1。该卷积层的卷积操作是对脑电信号开展逐行卷积运算,其作用为逐通道滤波,再经过激励函数实现特征图的输出,其过程的数学表达式如下

yj=f((X*wj)+bj)

(1)

式中:yj表示第j个特征图;X表示该层的输入信号;wj表示第j个卷积核的权重矩阵;bj表示第j个卷积的偏差值;f表示激活函数。

中间层的第2层是深度卷积层,卷积核尺寸为通道数×1。该深度卷积层与第1层的区别在于:在深度为1时,进行卷积操作时1个特征图输入对应1个卷积核[25],而普通卷积层的每个卷积核会与每个输入的特征图进行卷积操作。深度卷积的计算公式为

(2)

式中:h表示深度卷积的深度;yj,h表示第j个卷积核对应的深度为h的输出;Xj表示第j个输入的特征图;wj,h表示第j个深度为h的卷积核;bj,h表示第j个深度为h的偏差值。

深度卷积的意义为对输入的每个特征图进行单独操作,实现了特征图的独立特征提取[25]。同时相比于普通卷积,深度卷积的运算量、可训练参数量也会大大减少。深度卷积层的卷积计算类似于CSP算法中的空间滤波计算,是对各通道信号的加权滤波,因此该层的输出变为一维信号。

中间层的最后一层为深度分离卷积[25],此卷积过程是深度卷积与点卷积的组合,因此有两层的卷积过程。点卷积的卷积核大小为1×1,因此卷积不会改变特征图的大小,但也能将特征降维以及增加模型的非线性表达能力。

由深度分离卷积层输出的特征图,首先经过深度卷积过程进一步提取时域特征,再经历如下所示的点卷积过程

(3)

式中:yj表示第j个特征图输出;Xi表示第i个特征图输入;wj表示第j个点卷积核;bj表示卷积偏置。

可以看出,点卷积核会与每一个输入的特征图进行卷积,求和之后得到特征图输出。因此,深度分离卷积过程增加了网络对脑电信号时空耦合特征提取的学习能力。

最后在输出层进行全连接与分类结果输出,实现脑电信号解码。

1.2 Faster-EEGNet网络结构

本文的研究工作主要是基于EEGNet网络模型开展优化,提出如图2所示的适用于运动想象脑电信号解码的Faster-EEGNet紧凑式深度学习网络。网络的输入数据导联数为C,数据长度为T,F1与D表示网络的一组可调整超参数,网络的最终结构可由F1与D确定。

本文提出的网络模型,重点是对EEGNet网络中间层的第1层与第2层结构进行改造,在网络构建过程中选用一维卷积核加快卷积速度,对于单通道信号的不同频段、不同通道信号以及信号时域信息,有着更强的耦合特征学习能力,能够实现更快的网络训练速度以及具有更强的特征提取能力。

表1详细列出了Faster-EEGNet网络的结构与参数。可以看到,输入层对于采集到的原始脑电信号,需要进行适当的预处理,如通道选择、去线性趋势、带通滤波等,输入数据为采样点数×通道数(T×C)。中间层的第1层是大小为32的F1个一

图2 Faster-EEGNet的网络结构Fig.2 Structure of Faster-EEGNet

表1 Faster-EEGNet的网络结构与参数

维卷积滤波器,能够对多通道的脑电信号进行时域特征提取,计算公式如下

(4)

与EEGNet网络中间层的第1层相比,Faster-EEGNet网络的第1层卷积对所有通道采用不同的卷积权重,在滤波之后进行叠加,虽然大大增加了该层的可训练参数,但也增强了对时空耦合特征的学习能力。在卷积核大小的选择上,采用了更小的32,以增加时间分辨率。不仅如此,由于采用的卷积在运算过程中是对所有通道同时进行,因此相比于EEGNet网络,计算速度提升较大,达到了在参数增多的情况下仍能加快计算速度的目的。之后的批次标准化计算起到了正则化的作用,能够减小数据的分布变化。第2层是大小为16的深度卷积层,深度卷积的特点就是卷积核不与上一层所有的特征图连接,其作用一方面是减少该层的参数量,另一方面是单独对上一层输出的时空特征图进行时域特征学习。在激活函数的选择上,没有依照EEGNet网络使用指数线性单元(elu), 而是选择了整流线性单元(Relu)函数,其数学表达式为

(5)

式中:y表示激活函数的输出;x表示激活函数的输入。

由于Relu会将输入为负的激励输出为0,因此起到了特征选择的作用。同时,将部分神经元输出置零,也加快了网络计算的速度。

深度卷积之后使用大小为4的平均池化,将250 Hz的信号采样频率降到64 Hz,可大大降低特征图的大小,因而减少了计算量。紧随的神经元丢弃(dropout)操作使部分神经元失活,起到了防止过拟合的作用,失活率可以根据训练过程中的过拟合情况选择0.25或者0.5。中间层的最后一层是深度分离卷积,与EEGNet网络一样借鉴了CSP算法的思想,进一步提取时间-空间域上的特征,输出的特征图经历批次标准化、 Relu激活、平均池化、神经元丢弃等一系列操作后,生成该层输出。尺寸为8的平均池化进一步降低了特征图大小,减少了后续计算量。最后经过全连接展平,将所有的特征与输出层连接。

Faster-EEGNet网络将第1层二维平面串行卷积变为所有通道同时进行的串行卷积,完成了各通道信号的时域滤波、空间滤波,中间深度卷积层对空间模式提取信号进行时域卷积特征提取,最后由深度分离卷积再次提取信号时间-空间耦合特征。整个过程中,虽然可训练参数量有所增加,但是计算速度与特征学习能力得到了增强。

2 实验材料与设计

2.1 数据集介绍

本文使用2022年世界机器人锦标赛-BCI脑控机器人大赛公开的运动想象RankB赛题数据作为验证数据集,采用博瑞康64导脑电采集设备采集实验数据,含一个事件信息(trigger)通道,信号采样频率为250 Hz。一次实验内容包括2 s任务提示、4 s运动想象和2 s休息,每组共计30次。任务类型包括左手运动、右手运动、双脚运动的想象,每种任务随机出现10次。数据集采集了5名被试者的运动想象数据,每名被试者参与3组实验共计90个试次。为了模拟真实的在线识别场景,本文脑电解码实验使用的训练集与测试集数据均来自不同的实验组,以减少训练集与测试集的相似性。

2.2 模型训练与验证实验设计

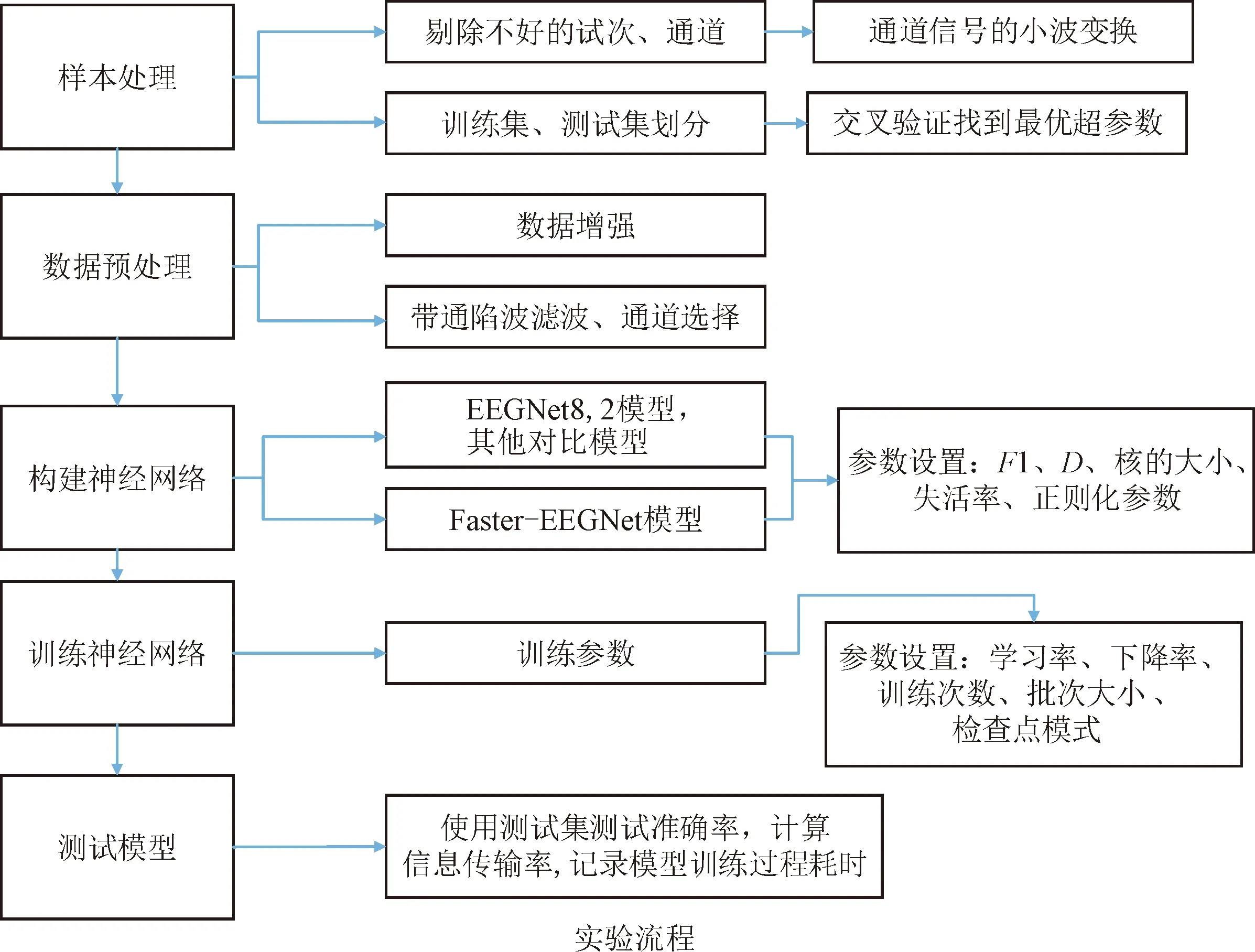

为验证本文所提出的Faster-EEGNet网络性能,在所选公开数据集上设计了与EEGNet网络运动想象解码性能的对比实验。模型训练的过程如图3 所示。

图3 模型训练与实验过程Fig.3 Model training and experiment process

实验采用python语言平台,计算机配置为12核intel Core i7-8700,编程环境为Windows10 + python3.10。不使用GPU的原因是由于在前期实验过程中发现,在数据量与神经网络都很小的情况下,GPU训练的速度很大程度上取决于CPU处理与载入数据的速度,所以导致训练耗时差异很小,因此使用CPU进行训练可以更好地对比神经网络训练速度的差异。

样本的处理步骤为:实验中,对每名被试者所有通道每个试次的数据进行小波变换,绘制试次信号的时频图,然后根据经验去掉噪声比较大的脑电信号通道与试次样本。本实验的通道号选择如表2所示。

表2 不同被试者脑电通道号的选取

被试训练集与测试集的划分过程为:为消除训练数据与测试数据相似度对测试结果的影响,先使用第1个实验组的数据作为测试集,第2、3组的数据作为训练集得到测试集准确率,然后再依次使用第2组、第3组数据作为测试集,即采用三折交叉验证的方法,选取3组测试集准确率的平均值作为模型的分类识别准确率。

数据预处理步骤为:由于数据集中每名被试者的数据样本只有90个试次,训练集样本只有60个试次,因此本文采用移动剪裁的方法进行数据增强,即使用长度为120的窗,移动间隔为30的裁剪方法对4 s的运动想象数据进行裁剪,可以将数据样本扩大30倍,之后对增强后的样本再进行去线性趋势以及8~30 Hz滤波。

按照Lawhern[18]所述的网络参数构建EEGNet8,2网络,按照表1的参数对Faster-EEGNet网络进行设置,其中F1设置为16,D设置为2,F2设置为32,第1个神经元的丢弃概率设置为0.5,第2个神经元的丢弃概率设置为0.25。

模型训练的批次大小设置为32,EEGNet8,2网络的学习率设置为0.01,Faster-EEGNet网络的学习率设置为0.000 1,学习率设置按梯度衰减,以防止训练前期收敛太慢与训练后期过拟合。为了发挥2种网络的最佳性能,学习率与批次大小的设置选取训练调参过程中的一个较优参数。

2.3 性能评价方法

2.3.1 模型准确率

为验证本文所提出模型的先进性,使用2.2节中的模型训练方法,分别训练EEGNet8,2与Faster-EEGNet网络。EEGNet8,2网络的训练次数设置为200,并使用Lawhern[19]中所述的检查点模式方法,选择验证集上损失函数最小的模型作为输出模型。本文提出的Faster-EEGNet网络不使用检查点模式方法,而是在训练200次后以最后一次训练得到的模型作为输出模型。采用三折交叉验证方法计算模型的识别准确率,每个被试者均重复20次,记录下每次实验的交叉验证准确率。

2.3.2 信息传输率

信息传输率是反映数据传输系统性能的重要参数,是描述脑-机接口性能的指标之一,其计算公式为

(6)

式中:RIT表示信息传输率;N表示目标数;P表示识别准确率;L表示平均试次时长。

实验中使用的脑电数据长度为0.48 s,但考虑到实际使用场景,加上了模拟的0.5 s休息时长,因此计算过程中L取0.98 s。

2.3.3 模型训练速度

使用S04被试者的数据,从训练10个轮次开始,每次增加10个轮次,一直增加到100个轮次。将此实验过程重复20次,记录下每次训练耗时数据。

2.3.4 模型推理速度

模型的推理速度受测试数据的长度以及脑电数据通道数的影响。为评价测试数据的长度对模型推理速度的影响程度,首先使用S04被试者的数据,选择第1组与第2组共60个试次的59通道脑电数据,按照2.2节中所述方法对样本进行预处理,测试长度分别为0.5、1.0、1.5、2.0、2.5和3 s,采用Faster-EEGNet网络与EEGNet8,2网络进行训练,次数设置为200。对于EEGNet8,2网络,采用检查点模式方法选择输出模型,测试集按照2.2节中所述方法增强到360个样本,每个长度样本对应的实验重复3次,记录2种模型对测试集所有样本进行推理所消耗的时间。

2.3.5 结果的假设检验

将上述性能评价指标实验结果,视作同一组数据的不同处理或测量结果的均值差异,可采用双样本t检验(pairedt-test)方法来比较均值大小,其表达式可写为

(7)

采用式(7)的t检验统计量对2组样本的均值进行检验,其自由度的数目由 Satterthwaite 逼近给出。若均值相等则检验通过,表明结果无明显差异,否则需进行单侧检验比较均值大小。

3 实验结果与讨论

3.1 网络可训练参数

表3给出了Faster-EEGNet、EEGNet8,2、DeepConvNet以及ShallowConvNet 4种网络可训练参数量的对比结果。

表3 4种运动想象解码网络的可训练参数量对比

由表3可知,DeepConvNet网络的可训练参数量最大,达到了105数量级,ShallowConvNet与Faster-EEGNet网络的数量级都在104,EEGNet8,2网络的可训练参数最少。总体而言,Faster-EEGNet网络的可训练参数量相对较少,因此在小样本训练场景也能获得较好的模型拟合效果。对于EEGNet8,2网络,虽然第1层的卷积层为每个通道都分配了单独的卷积核,导致参数量增加,但同时换来了更强的耦合特征提取学习能力。

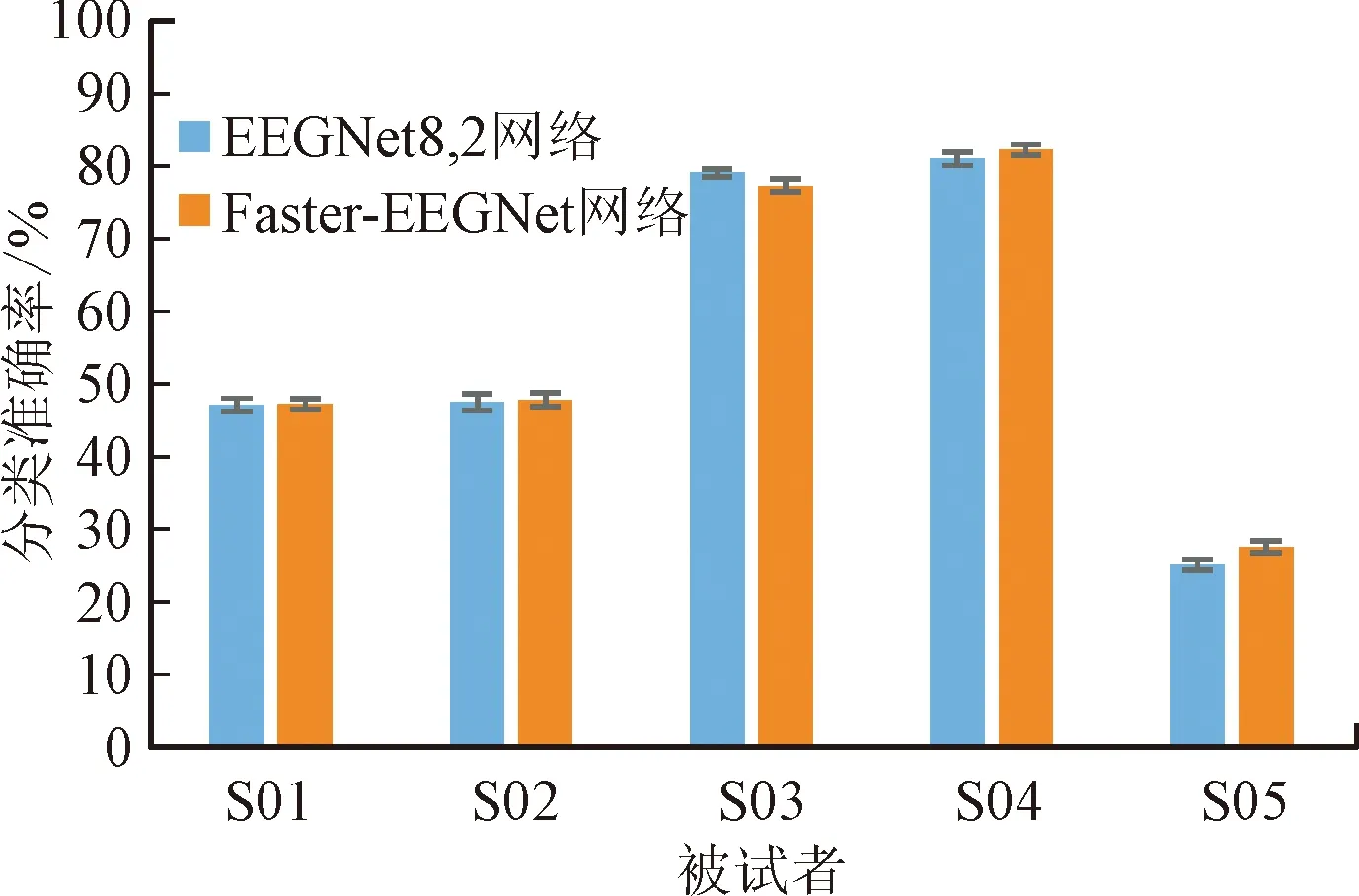

3.2 运动想象脑电信号解码准确率与信息传输率

图4展示了EEGNet8,2与Faster-EEGNet网络在世界机器人锦标赛上运动想象B榜三分类数据集上的识别准确率结果,所有的数据样本长度均为0.48 s。由图可见,在S04与S05被试者的表现上,Faster-EEGNet与EEGNet8,2网络的识别准确率分别为82.12%与27.57%,前者明显优于后者(在p<0.001的显著水平上)。对于S03被试者,则是EEGNet8,2网络取得了更好的识别准确率。2种算法在S01与S02被试者上无显著差异,Faster-EEGNet比EEGNet8,2网络的平均准确率提升了0.46%。识别结果表明,不同被试者间运动想象信号的质量差异较大。

图4 2种网络模型的分类准确率对比Fig.4 Comparison of classification accuracy of EEGNet8,2 and Faster-EEGNet models

表4给出了EEGNet8,2与Faster-EEGNet网络在实验中运动想象解码信息传输率RIT的结果。由于被试者S05的三分类准确率低于1/3,因此信息传输率都为0。Faster-EEGNet网络在S04被试者上的信息传输率结果更优(在p<0.001的显著水平上),而对于S01与S02被试者,两种算法并无明显差异。

表4 2种网络模型的信息传输率

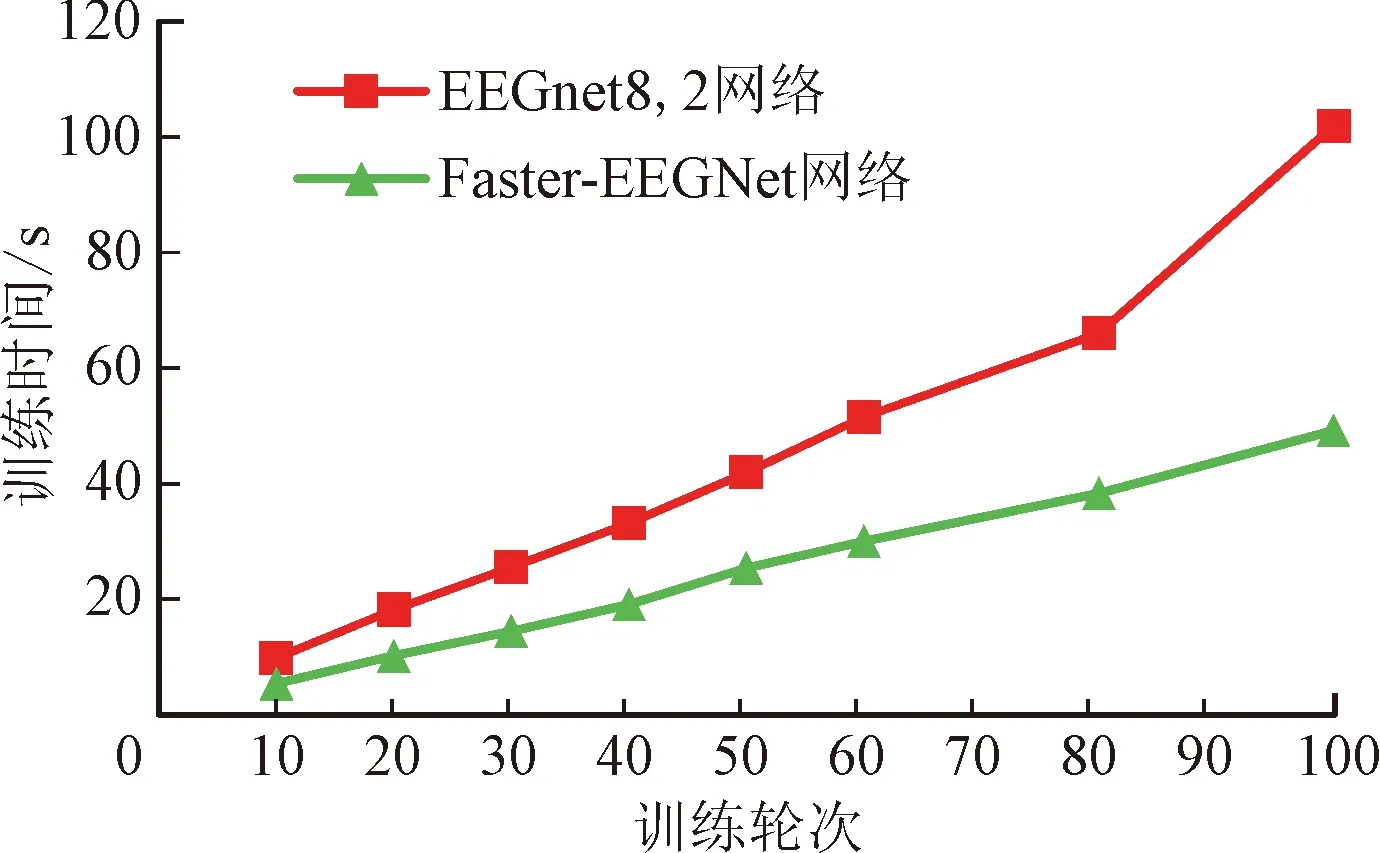

3.3 神经网络训练速度对比结果

图5给出了两种神经网络在S04被试者上的训练耗时。由图可见,在训练数为10~100的所有实验中,本文提出的Faster-EEGNet网络模型的训练耗时均明显低于EEGNet8,2(在p<0.001的显著水平上),能够减少44.8%的训练耗时,训练速度得到明显提升。模型训练速度加快的原因在于:Faster-EEGNet网络将第1层二维平面串行卷积变为所有通道同时进行的串行卷积,使用较小的卷积核完成了各通道信号的时域滤波、空间滤波;而EEGNet网络的第1层为所有通道分配一个卷积滤波器,在卷积计算时使用比较大的卷积核逐次串行对所有通道进行卷积,因而第1层只完成了时域滤波过程,输出特征图也比较大,提升了后续计算的复杂度。

图5 2种网络模型的训练耗时对比(S04被试者)Fig.5 Comparisons of time spent on two net models(S04 training model)

3.4 模型推理速度对比结果

图6展示了大小为360的测试样本上,Faster-EEGNet与EEGNet8,2网络模型的预测推理消耗时间对比结果。由图可见,两种算法的推理时间都随着样本长度的增加而呈近似线性增加,但Faster-EEGNet网络模型的推理时间在所有测试样本长度时均小于EEGNet8,2网络模型(在p<0.001的显著性水平上),如样本长度为0.5 s时推理时间减少了43.6%,样本长度为3 s时推理时间减少了73.0%;从单样本推理时间来看,样本长度为3 s时最长,Faster-EEGNet8,2网络模型推理需耗时0.73 ms,而EEGNet网络模型推理耗时则需要2.66 ms,结果表明相较于EEGNet8,2网络模型,Faster-EEGNet网络模型的推理速度有了较大的提升。

4 结 论

本文针对现有深度学习方法在运动想象脑电信号识别领域面临的挑战展开研究,旨在解决基于运动想象的脑-机接口在实际应用中对于快速模型训练、想象任务准确识别、小样本训练的需求问题,在EEGNet网络结构的基础上,提出了紧凑型的Faster-EEGNet网络,并给出了其结构参数设置以及训练方法。与其他学者提出的神经网络相比,Faster-EEGNet网络参数量较少,对于小样本的训练场景也能够获得较好的模型拟合效果。所选三分类运动想象数据集上的分类结果表明,Faster-EEGNet神经网络平均识别准确率与信息传输率均高于EEGNet网络,部分被试者结果显著高于EEGNet网络,显示出较好的解码性能。在模型训练速度方面,Faster-EEGNet网络有着较为显著的优势,实验中所有试次的平均训练速度提升了44.8%。在基于运动想象的脑机接口系统中,Faster-EEGNet网络能够在保证较好解码性能的前提下显著减少解码模型的训练耗时,提升了运动想象脑机接口系统的便利性。此外,与EEGNet网络模型相比,Faster-EEGNet网络模型推理速度的提升量超过43.6%,大大提高了脑机接口系统的快速响应能力。