一种遥操作场景下的混合现实视觉增强交互系统

2023-10-29施乐洋李晓玲王龙陈漳沂郑帅

施乐洋,李晓玲,王龙,陈漳沂,郑帅

(1. 西安交通大学机械工程学院,710049,西安; 2. 西安交通大学电子与信息学部,710049,西安)

随着自动化控制、自然人机交互、信息通信等技术的快速发展,面向遥操作环境的高度智能化与自主化的机器人系统在高风险任务中发挥着越来越重要的作用[1]。同时,遥操作技术也被广泛应用于排雷排爆[2]、搜索救援[3]、高空作业[4]、水下探索[5]和太空探索[6-7]等极端复杂环境中。在这些应用领域里,机器人往往要代替人们进入危险环境,因此需要重点研究的是该如何赋予机器人以近似人类的感官系统和认知能力,从而能够直观地在操作员端再现远端场景[8]。

研究表明,在人类的5种感官系统中,视觉的神经元数量以及信息传输率要远高于其他感觉模式[9]。从某些程度上来讲,人类大脑的一半以上直接或间接地用于处理视觉影像,视觉信息的处理又支配着来自其他模态信息的处理,由此可见视觉信息的正确反馈对于人类的重要性[10]。然而,目前大多数遥操作系统都是通过2D显示器提供视觉模态的反馈,在这种方式的遥操作过程中,存在着大量的用户操作失误以及设备自身的人机交互问题[11]。

混合现实技术是一种将视觉作为最重要的输入通道之一的交互技术,多年以来,混合现实中的人机交互研究一直在探索更加自然和高效的交互方式[12-13],旨在通过其立体、多维的场景输入[14]改善传统系统中的人机矛盾。目前,混合现实技术已经开始应用于远程医疗手术[15]、太空舱外作业[16]以及排雷排爆等较为特殊的使用场景。在这些应用场景中,用户均可以借助空间信息和直观的交互技术(如手势),来实现交互数据可视化或多模式遥操作,并可以实时获取真实操作状态信息,帮助自身保持高度的情景意识。因此,混合现实技术在提升操作系统的人机交互与协作效率方面具有巨大潜力。针对遥操作机器人这一场景,Su等提出了一种基于混合现实视觉和触觉反馈方法的焊接方案[17],并用于遥控机器人焊接。该方案由机器人工作区域进行混合现实视觉反馈,同时通过混合触觉约束,引导操作员的手部沿混合现实标注导向移动,并将焊接操作限制在无碰撞区域内。这种允许用户进行沉浸式交互的设计方案,具有以用户为中心、将观察视角和态势感知相结合的特点,可以使操作系统快速理解人类指令,丰富了人机协作的应用场景及范围[18-19]。除此以外,华南理工大学的研究团队利用Leap Motion体感控制器对操作者的手部动作进行检测[20],并将其转化为机器人的控制指令,通过混合现实技术对机器人的作业场景进行实时的视觉反馈,以确保操作的安全性和效率,提高了人机交互体验[21]。Livatino等基于混合现实技术设计了一种组织信息呈现方法和一套视觉辅助工具,通过在用户界面中使用混合现实和视觉辅助工具,向用户呈现传感器数据,以促进远程操作控制面板中数据的视觉通信,不仅提高了操作员态势感知能力,还加快了决策速度[22]。

上述研究现状表明,混合现实技术在遥操作交互领域具有很大的应用价值,但现有研究往往单独着眼于改进系统的某一个方向,如视觉反馈、交互反馈等;在进行系统整体设计时,仍没有脱离传统系统的设计思路;在进行交互任务时,由于各部分的混合现实程度不一,使用效率并没有得到较大的提升;而且,混合现实场景下的临场感往往比较低,交互性能不高。因此,本文基于以上研究内容与技术背景,面向遥操作应用场景,利用混合现实技术在人体视觉认知以及人机协作方面的优势,设计了一种视觉增强交互系统架构,以满足遥操作过程中操作员的交互需求;然后,采用摄像机到HoloLens(一种混合现实显示设备)的端到端视频传输方法,实现了远程视景的实时呈现;通过研究混合现实场景下遥操作主端的交互流程与技术实现,建立了基于循环坐标下降逆运动学法的机械臂虚拟交互模型,通过虚实融合技术为遥操作机器人提供了一种可视化效果较好的交互控制方案,解决了目前主从式遥操作系统缺乏临场感、交互性能差的问题,对系统的安全性、稳定性起到了很大的促进作用。

1 混合现实视觉增强交互系统设计

1.1 混合现实遥操作交互需求分析

当前的遥操作系统,尤其是排雷机器人系统(本文主要探讨这一背景),操作员通常是通过显示屏或传统屏幕(如移动设备、平板电脑或笔记本电脑等)观看机器人端摄像头返回的实时视频流。在这种情况下,操作员只能看到二维的图像信息,明显缺乏临场感知[23]。另外,传统的排雷系统中使用的摇杆、手柄、键鼠等遥控设备限制了交互的空间,通常情况下,远端机器人的控制操作与视觉反馈两个模块呈现相互独立的态势。在实际作业与交互过程中,操作员不仅要实时关注机器人端摄像头画面,还需要实时获取机器人的运动姿态并进行远程操作,即操作员必须在视觉反馈区域和控制区域之间不断进行切换,这样不仅会导致注意力分散,而且是不自然和低效的[24-25]。基于上述问题,本文重点研究了如何利用混合现实技术提供一种新型的沉浸式视觉反馈与交互系统,以解决现有系统视点跳跃、交互区域不统一的问题。

从遥操作作业存在的问题和实际需求出发,可以总结出本系统的功能需求如下。

(1)远程视景实时呈现:用户的首要需求是通过实时视频流信息来感知远端环境,因此该系统的主要功能就是采集与传输实时画面,且实时地呈现在用户面前。

(2)人机自然交互:在人机交互过程中,远程机械臂的交互控制需要纳入混合现实交互场景中,以实现视线交互区域与遥控操作交互区域相统一。

(3)虚实融合:在遥工作场景中,将混合现实全息对象和真实的环境元素结合在一起,从而增强交互场景的视觉体验。

非功能需求主要针对软、硬件环境与应用场景,具体包括如下内容。

(1)系统开发平台:Windows平台,不需要大量的存储空间,系统尽量小巧。

(2)用户需求:用户需具备基本的计算机作业经验与能力,且在不熟悉计算机操作和混合现实系统的条件下,能做到快速学习并很好地适应。

(3)环境条件:应当尽量避免强光,以适用于设备采集到合适亮度的视频为准。混合现实显示设备也同样不适用于强光环境。

总体来说,通过混合现实技术改变传统的第三人称视角观察的多视频流传输,有助于理解操作的上下文。此外,交互系统能为用户提供直观、立体的混合现实机械臂交互控制方式,使其更加身临其境并得到自然的交互体验。

1.2 视觉增强交互系统总体架构

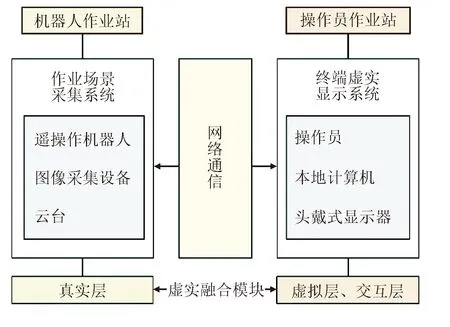

综合以上需求分析,本文提出了一种新的视觉增强交互系统框架,采用“视频视角”的混合现实显示方案,将机器人端返回的视频信息视为真实世界,将混合现实场景中的全息对象用于远程机器人控制,并在数字化视频流上完成混合现实的工作。该方法将视觉反馈区域与控制区域集成一体,最终呈现出一套完整的基于混合现实的闭环遥操作交互系统。此系统从三维显示和自然交互的角度出发,在为操作员提供实时、准确、有效的作业场景信息的同时,实现了立体直观的交互控制指令反馈。所设计的系统结构框架如图1所示,主要分为主动端的操作员站和从动端的机器人作业站,二者通过无线自组网设备实现远程通信。

图1 遥操作视觉增强交互系统框架Fig.1 Teleoperation vision enhancement system frame

主动端为操作员、头戴式显示器、本地计算机等组成的操作员站。在本地计算机上建立一个混合现实场景,该场景包括立体视觉显示和人机交互界面,可以直接给操作员提供立体可视化的远端场景和交互界面,操作员通过头戴式显示器,在安全环境中实时、准确地观察机器人姿态并完成交互控制任务。从动端为遥操作机器人、图像采集设备、云台等组成的机器人作业站。主动端和从动端通过自组网设备进行通信,自组网设备内嵌有视频流传输协议,能够把摄像头采集到的图像发送回主动端,在作业任务时提供辅助参考给操作员。交互系统按功能可分为真实层、虚拟层和交互层,其中也包括了作业场景采集系统、终端虚实显示系统、跟踪注册模块、虚实融合模块等,其工作步骤如下。

步骤1真实层的作业场景采集系统首先读取摄像机采集到的实时流协议(RTSP)视频流,再对其进行编解码,从而获得实时图像信息。

步骤2通过计算机终端的虚实显示系统,完成虚拟图像渲染与栅格化,生成虚拟层的虚拟信息。

步骤3跟踪注册模块完成对摄像机视野和视角的跟踪,生成相关的位置、坐标等信息,同时将虚拟层的数字信息与真实环境相匹配,实现虚拟层与真实层的融合。

步骤4将整合后的信息输出至头戴式显示器,为操作人员提供视觉反馈和机器人控制界面,然后操作员与虚拟模型进行交互,完成遥操作任务并发出控制指令。

2 关键交互技术研究

2.1 远程视景实时呈现

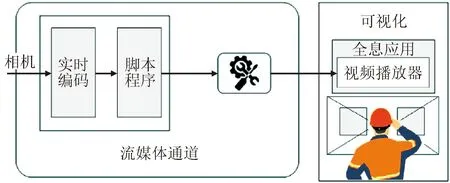

混合现实交互系统首先需要实现的一个功能就是通过摄像机捕捉或记录近端任务环境,与此同时,远程用户在混合现实头盔(HMD)上获得近乎实时的视频流。摄像机-HoloLens端到端视频传输实现方法如图2所示,首先设置流媒体通道,用于发布视频输出、编码视频和发布视频流,然后在全息应用程序中将这个视频流通道部署至HoloLens。

图2 摄像机-HoloLens端到端视频传输实现方法Fig.2 End-to-end video delivery implementation methods

图像传输的流程如图3所示,可通过自定义服务器端和远程客户端传输与接收的数据类型,提高网络通信过程中的稳定性。

图3 图像传输流程Fig.3 Image transfer flowchart

采用2个网络协议(IP)摄像头采集远端场景,分别获取远端整体抓取场景的全景图像以及手部抓取的特写图像。在图像数据的无线传输过程中,图像帧率为30 Hz,分辨率为1 920×1 080像素。另外,为了减小数据传输量,在获取实时图像后将数据压缩为JPEG格式,并根据自定义的传输类型进行打包发送。服务器端程序流程如图4所示,远程客户端负责接收图像数据,并将其解包、解码后在混合现实场景中实时显示。

图4 服务器端程序设计流程Fig.4 Server-side programming

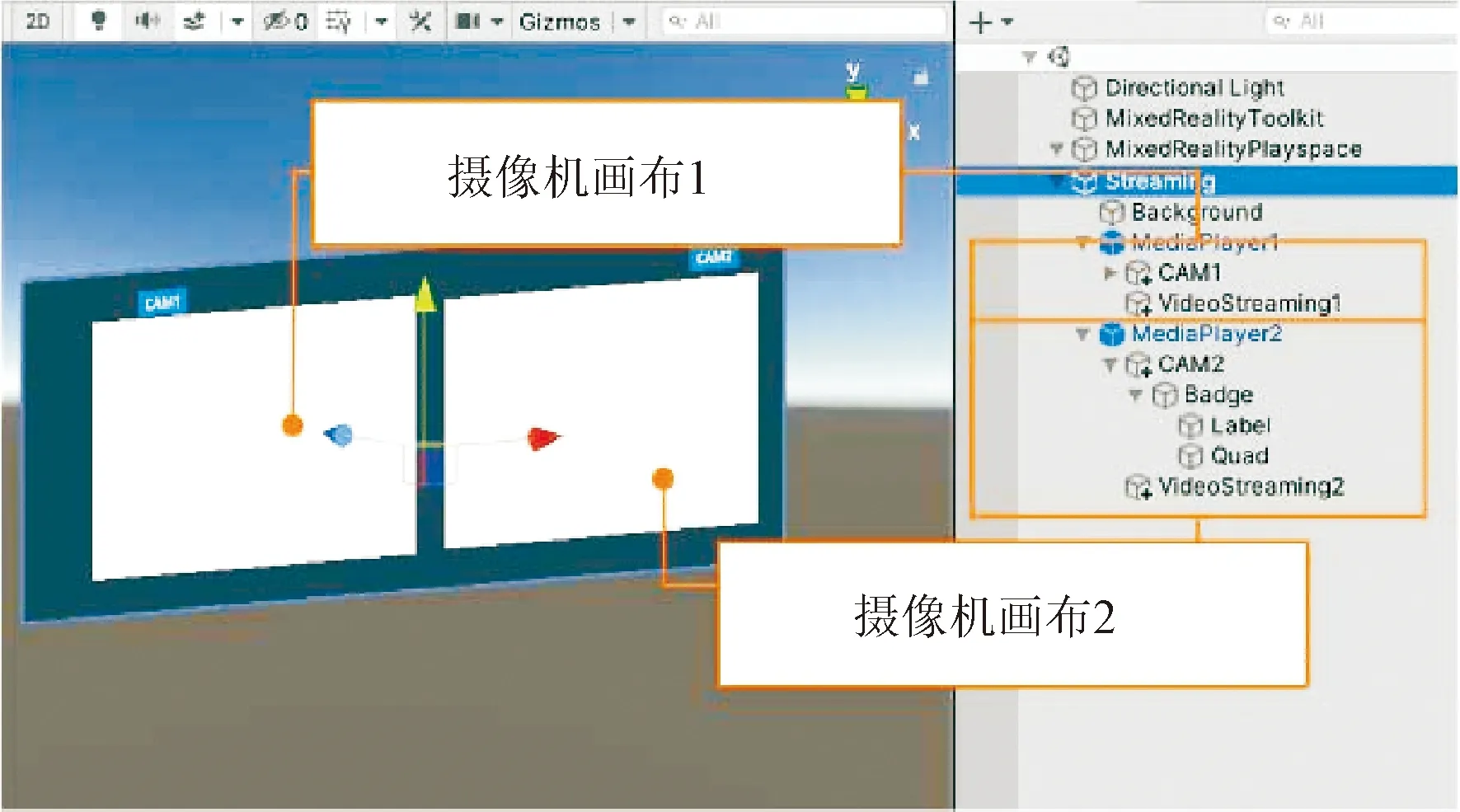

本文基于Unity3D软件实现实时视频播放功能,但由于其原生视频播放器仅支持本地视频文件的播放,因此为了将外部世界的IP摄像头输入到开发环境中,使用Universal Media Player 插件搭建了一个可以播放RTSP实时视频流的场景,用脚本控制RTSP视频流的播放,设计并开发了相应的程序接口与软件界面,如图5所示。

图5 Unity3D软件中的场景架构Fig.5 Scene architecture in Unity3D

该场景包括2个并列排布的2D画布(canvas),分别用于渲染显示主视角相机(CAM1)和手部视角相机(CAM2)的实时视频流,并通过背景面板有效地避免强光环境中的光线干扰。随后设置画布的层次结构,挂载相应的脚本文件,直接调用RTSP视频流,将画面渲染到对应的画布上,实现实时视频流的接收与播放。运行该场景程序时,会在本地计算机打开一个提供网络摄像头画面的新窗口,以输出视频编码器正在接收图像数据的状态信息。在混合现实显示器中,为了生成高质量且稳定的混合现实场景,通过无线串流在Unity3D软件中实现HoloLens与PC电脑在同一局域网内的无线连接,从而在HoloLens中同步Unity中的输出结果,如图6所示。针对此类二维信息的注册,只需确定其相对于真实空间的坐标信息,就能较好地实现信息叠加。在这个过程中,PC计算机作为后台服务器进行数据处理,HoloLens作为客户端向用户提供操作环境。

图6 Unity3D软件中的视频流显示Fig.6 Video stream display in Unity3D

2.2 Unity场景下的机械臂自适应控制

本文所提出的混合现实交互系统面向遥操作作业环境,需要根据真实环境的物理数据创建遥操作平台虚拟交互模型,从而实现对遥操作机器人作业场景中各要素的构建与实际控制。以遥操作机械臂为例,由于需要通过对机械臂模型各关节角度的实时接收发控制远端的真实机械臂,因此首先构建机械臂模型,具体流程如图7所示。首先利用SolidWorks软件对机械臂进行几何重建,确定各零部件之间的装配关系与旋转中心,然后考虑到形状、材质、纹理等因素的影响,利用计算机图形学及相关渲染算法进行模型着色,以提高混合现实三维立体显示的质量。

图7 机械臂虚拟模型构建流程Fig.7 Robotic arm virtual model building process

由于Unity3D软件所支持的模型文件为FBX格式,所以必须先将SolidWorks软件生成的模型导入3DsMAX软件进行转化,再将转化后的文件导入Unity3D软件,建立对应模型的材质球以刻画模型的细节特征,从而提高混合现实视觉质量。此外,通过降低虚拟模型的真实性,保证了系统的实时性需求,即在进行建模与实时渲染时,对模型的精确度和绘制速度进行了权衡,既能使画质得到保证又不会给用户带来任何视觉观感上的不适。模型生成后需要贴上纹理,使其更具有真实感。三维模型贴图的核心是建立纹理贴图与模型表面的映射关系,其实现过程如图8所示。首先计算纹理在三维模型空间坐标系中的空间位置,确定纹理空间点(u,v)与模型空间坐标的映射关系,然后依据该映射关系,实现三维模型的着色。

图8 纹理映射过程示意图Fig.8 Texture mapping process

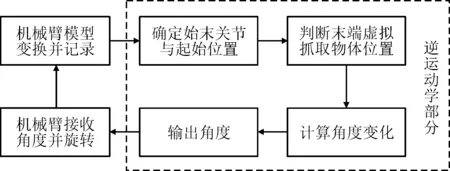

在场景实现过程中,模型建立后需要对机械臂模型进行控制与交互方法的设计。由于采用机械臂仿真Unity铰链关节后进行角度输出的传统方案存在无法精确控制角度的问题,以及当项目套用混合现实工具包(MRTK)组件在混合现实场景下运行时,本文所使用的机械臂需要进行6轴的关节计算,给系统运行造成了较大的负载,常常会出现系统崩溃、模型显示逻辑混乱的情况,因此,本文提出采用循环坐标下降逆运动学(cyclic coordinate descent inverse kinematics,CCDIK)方法实现混合现实场景下机械臂的交互。实现机械臂交互控制的框架如图9 所示。

图9 基于末端抓取物的机械臂交互控制框架 Fig.9 Robotic arm interactive control frame based on end-grabbing objects

本文基于Unity2020.3.41f1c1版本,利用CCDIK算法在混合现实场景中实现Unity机械臂的自适应交互。CCDIK算法是一种较为快速的逆运动学求解算法,在实时性要求较高的环境中运用比较广泛,且由于这种算法的计算量比较小,对系统的负载影响也较小,因此适合在混合现实设备算力较弱的情况下使用。该算法的具体过程为:首先在Unity中创建一个机械臂模型,包括机械臂的各个关节和连接器,并设置好每个关节的转动范围和初始角度;然后,搭建CCDIK脚本来构建机械臂的逆运动学模型,该脚本可以根据机械臂的目标位置和姿态,计算出每个关节需要旋转的角度,从而实现机械臂末端的精确定位;最后,将CCDIK脚本挂载到机械臂模型上,设置目标位置和姿态,并进行运动控制。本文通过编写脚本来控制机械臂的运动,使用手部位姿来操作目标抓取物体,通过在更新进程中进行不间断的坐标判断,向脚本不断输出目标位置,实现连续、实时的机械臂姿态变换。随后,进一步对机械臂模型进行优化和改进,添加了碰撞检测以提高模型的精度和稳定性。

2.3 三维注册与融合流程

混合现实系统的重要部分是将虚拟的全息对象与真实环境融合起来。本文所设计的混合现实场景中的全息对象包括两大类,如图10所示,一类是2D对象如字体、图片、UI等,用于向用户展示当前环境的动态信息及相关属性;另一类是3D对象,主要是指三维全息对象如机械臂、抓取物、小车等虚拟模型,用于远程机器人系统的交互控制,以增强用户的沉浸感体验。

图10 混合现实场景中的虚拟信息Fig.10 Virtual information in a mixed reality scenario

采用基于自然特征点的无标识三维注册方法,对这些全息对象进行空间三维注册,利用Vuforia SDK工具包和Unity3D软件开发对应的Unity脚本,实现对全息对象空间位置和姿态的实时定义。该三维注册系统由4个部分组成,分别是三维目标预设、图像实时处理、三维注册以及图像输出。实现的基本流程如图11所示。

图11 三维注册与融合流程Fig.11 3D registration and fusion flowchart

通过选取多张标记图像建立目标样本数据库,并将数据库导入到Unity项目中,可实现增强现实标记的调用。通过绑定模型与目标物图像,根据Unity3D软件中空间参考坐标系与真实空间坐标系的关系,设定目标物与虚拟模型的相对位置关系,可实现虚实融合与显示。采用HoloLens设备进行虚实融合的过程如图12所示。由图可见,该三维注册方法能将全息对象和现实所观察到的遥操作场景相融合,使全息影像在相机识别到目标对象时,可以按照预先设置的相对关系在混合现实场景中显示,增强了全息图像的真实感,极大地改善了物理环境与虚拟环境的虚实融合效果。基于此方法,系统提供了可以进行机器人操作的全向感知平台,允许操作员在作业过程中与虚拟机器人系统进行交互,并能从各个方向观察虚拟机器人与虚拟抓取场景,有助于操作员直接感受远端环境并进行遥操作控制,以获得更好的真实感和沉浸感。

3 交互系统构建

3.1 交互界面可视化

在Unity3D软件中进行系统交互界面的构建,作为遥操作视觉增强交互系统的重要组成部分,主要包括利用远程摄像机在混合现实场景中获取传输的实时视频流,以及拖动三维可视化后的虚拟机械臂进行控制两部分内容,因此可将虚拟交互空间进行划分,并根据相应的交互功能进行布局。如图13所示,左、右两侧展示了遥操作实时视频流画面,分别用于显示遥操作端的手部实景和遥操作端的全局实景。AR识别平台位于视野正前方,用于实时追踪并定位虚拟机械臂控制的交互平台。用户通过观察立体传输的视频流信息,变换机械臂的虚拟模型位姿以进行远端机械臂的同步控制。交互模式选择模块集合了性能分析器、手势交互方式选择、AR平台关闭与显示、场景切换等功能按键,分别响应于对应的特征。该界面用户最终通过HoloLens设备进行显示,辅助遥操作系统实现了自然人机交互与沉浸式作业。

图13 混合现实系统界面Fig.13 Hybrid reality system interface

交互系统中使用的界面标定方式为环境锁定,但为了适应不同应用场景以及用户的个性化需求,在实际应用过程中也提供了基于头部追随技术的界面标定方式供操作员选择,此方式能有效地避免由于用户移动造成的画面消失或频繁的手动定位。

3.2 系统通信实现

本系统网络通信由两套独立的子系统实现,分别为相机端-主机端视频流的通信实现以及主动端-从动端交互指令的通信实现。通过不同的数据传输协议,从而实现主从端各子系统之间的信息、控制数据流转。

本系统通过传输控制协议(transmission control protocol,TCP)通信实现主从端点云数据流的传输,其方法为在从端的Linux主机上搭建服务端,在主端的Unity程序中搭建客户端并编写对应的脚本文件。TCP是一种面向连接的、可靠的、基于字节流的传输层通信协议,其通过建立稳定连接、按顺序传输数据包以及提供错误检测和重传机制,确保了数据的完整性和可靠性。该协议在本系统的具体应用如图14所示 。

图14 场景传输TCP通信流程Fig.14 Scenario transmission TCP communication process

基于Unity的自适应机械臂实现交互控制后,需要进一步搭建局域网传输机械臂的远程控制指令,具体的通信流程设计如图15所示。由于模型机械臂与真实机械臂的初始位姿不一定同步,因此在系统开启之前需要先进行初始化同步以保证两者的位姿相同,再通过用户数据报协议(UDP)通信使Unity工程与远端机器人进行远程数据交换并发送位置指令。

图15 混合现实机械臂控制通信流程Fig.15 Mixed reality robotic arm control communication process

为了控制机械臂的运动,需要获取机械臂关节角度的变化信息。这些信息可以从Unity工程中提取,在进行位姿同步后,机械臂模型接收末端位姿的坐标并进行实时的姿态变换计算,随后将变换后的角度信息通过UDP通信传输给远端机器人。

在该Unity通信进程中,每一帧即1/12 s都会产生一次角度数据,因此在短时间内产生了大量的、重复的角度数据,并被机械臂服务器端全部接收,这对机械臂的角度处理造成了较大的干扰,频繁出现单次姿态变换中移动卡顿的问题。基于此问题,本文通过物体抓取操作的监听进行数据传输优化,由于系统构建中采用MRTK的交互脚本实现了对虚拟抓取物的交互操作,因此使用 MRTK 的可交互组件进行物体抓取操作时,可以通过监听手势交互终止事件(manipulation ended)来实现每次抓取结束后输出一次角度信息的功能。实现的最终效果为在每次抓取操作结束后,才将旋转信息发送到服务器,并输出角度信息,极大地优化了机械臂的交互控制效果。

4 系统验证

4.1 遥操作场景下传输延时实验

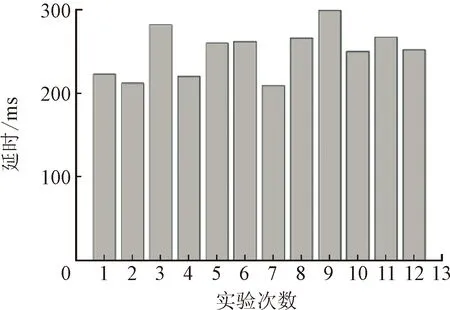

在混合现实视觉增强交互系统的实际应用中,遥操作主从端的传输延时是衡量系统整体性能的一个关键指标。一般情况下,系统延迟响应约为70~110 ms,一旦超过300 ms,就会直接影响到操作者的作业效率。设Δt1是相机从新的位置采集图像并返回显示器所造成的延迟,主要受由网络传输性能的影响,并随着传输图像尺寸的增大而增大,Δt2是在HMD上渲染获取的图像所造成的延迟,因此系统总延迟Δt为Δt1与Δt2之和。实验设定视频以1 920×1 080 像素高清分辨率进行传输,使用MJPG编码,帧率为30 Hz,传输图像尺寸为640×480像素,服务器和客户端在同一局域网中。设置主从端距离为15 m,在摄像机前执行固定动作直到该动作在交互系统中复现后,计算执行动作与复现动作之间的时间差即系统延时。

实验得到的结果如图16所示,统计结果表明,图像传输过程中的延时保持在210 ms到300 ms之间,平均值为260 ms,方差为29 ms,能够满足实时性要求。

图16 主从端距离为15 m时图像传输延时实验结果Fig.16 Experimental results of image transmission delay when the master-slave distance is 15 m

4.2 人机交互功能测试

对本文所设计的遥操作交互系统进行人机交互功能测试,测试结果主要用于评估系统的手势识别与交互性能。实验随机招募14名被试者(10名男性,4名女性),年龄范围为21~26岁(平均为23.79岁,标准差为1.42),均无VR、AR使用经验。被试者进行基础学习与训练后,执行手势30次/命令。手势由5个命令组成,分别为选择虚拟对象、调整对象位置、调整对象尺寸、机械臂姿态变换和多通道选择交互,要求被试者完成混合现实环境下的关于系统相关模块的基本交互任务。实验记录下检测到的手势数,并将统计结果列于表1。

表1 人机交互功能测试任务及结果统计

由表1可见,该系统对手势命令的检测准确率较高,交互时间随着交互任务的复杂度增加。实验过程中帧率总体波动范围为55~75 Hz,最大差值保持在10 Hz以内。

综上所述,所设计的混合现实视觉增强交互系统,能够满足基本的人机交互功能需求,并且具有良好的运行性能与流畅性。同时,通过与实验搭建的利用二维显示器进行场景传输的传统遥操作系统相比,在进行完整的遥操作抓取任务中,同样完成选择对象、机械臂变换以及抓取对象这3组动作,传统二维系统完成任务所需的平均时间为11.73 s,准确度为0.87,而本文所设计的遥操作交互系统在任务平均完成时间上减少了17.3%,准确度提高了7%。

5 结 论

本文针对遥操作机器人系统在高风险任务中近端交互临场感差、操作者难以获得真实体验感的问题,提出了一种适用于遥操作场景的混合现实视觉增强交互系统,并对该交互系统的交互性能进行分析和实验验证,探讨了混合现实交互技术的应用对于遥操作机器人系统人机交互性能的影响,得到以下主要结论。

(1)以人机交互通道为研究对象,从多通道信息的整合入手,研究了Unity3D平台下视频流的采集与流式无线传输方法,完成了在硬件平台上的搭载并进行了传输测试,有效地完成了远程场景还原的系统需求。

(2)基于机械臂的逆运动学构建了混合现实场景下的机械臂控制脚本,设计了一种立体可视化的遥操作控制流程,最大程度地保障了用户以自然的方式与控制对象交互,降低了学习成本。

(3)基于视觉感知以及可视化交互理论构建系统交互界面,提出了二维信息与三维模型相结合的混合式系统信息构建方法。该方法将视觉反馈区域与控制区域集成一体,改善了遥操作机器人系统的复杂度和稳定性。

本文所提出的混合现实视觉增强方法遥操作交互系统,有效地解决了远端作业场景的同步再现问题,提高了操作员的作业效率和准确率,对于军事领域中的排雷排爆等遥操作作业具有一定的应用价值。