基于深度学习的无人机多光谱图像柑橘树冠分割

2023-06-10宋昊昕尤号田刘遥唐旭陈建军

宋昊昕 尤号田 刘遥 唐旭 陈建军

摘 要:树冠信息的准确获取是研究柑橘树生长及产量预测的重要指标,但复杂的树木结构给树冠的准确提取带来一定影响,深度学习的快速发展为柑橘树冠信息准确获取提供了可能。采用一种新的基于深度学习的柑橘树冠自动提取方法,即将消费级无人机采集的多光谱图像与一种新的深度学习模型U2-Net结合,通过对获取的图像进行几何变换以构建柑橘树冠图像数据集。将U2-Net模型和当前3种主流深度学习模型(即PSPNet、U-Net和DeepLabv3+)分别在3个典型试验分区进行试验以提取柑橘树冠信息,并对提取结果进行对比分析。结果表明,在3个试验分区,U2-Net模型的柑橘树冠提取精度最高,其中交并比(IoU)、总体精度(OA)和F1分数(F1-score)分别为91.93%、92.34%和93.92%。与其他3种深度学習模型相比,U2-Net模型的IoU、OA和F1-socre分别提高了3.63%~8.31%、1.17%~5.25%和1.97%~4.91%。此外,U2-Net模型柑橘树冠提取面积和测量面积之间具有较高的一致性,3个试验分区决定系数(R2)均高于0.93,且与其他3种深度学习模型相比,U2-Net模型的错误率也较低,均方根误差(RMSE)为1.35 m2,均方误差(MRE)为8.15%。此研究将无人机多光谱图像与U2-Net模型相结合的方法能够实现柑橘树冠的精确提取,且提取树冠轮廓完整性较好,可为柑橘动态生长变化监测和产量预测提供基础数据与技术支撑。

关键词:柑橘;深度学习;U2-Net;树冠分割;无人机影像

中图分类号:S252.3;P237 文献标识码:A 文章编号:1006-8023(2023)03-0140-10

Abstract:Accurate acquisition of canopy information was an important indicator to study the growth and yield prediction of citrus trees, but the complex tree structure had a certain impact on the accurate extraction of canopy. The rapid development of deep learning provided the possibility for accurate acquisition of citrus canopy information. Based on this, an automatic extraction method of citrus canopy based on deep learning was adopted, which combined the multispectral images collected by consumer drones with a new deep learning model U2-Net, and constructed a dataset of citrus tree canopy by performing geometric transformation on the acquired images. The U2-Net model and the current three mainstream deep learning models (i.e. PSPNet, U-Net and DeepLabv3+) were tested in three typical sample regions to extract the citrus canopy, and the extracted results were compared. Results showed that: in the three sample regions, the U2-Net model had the highest extraction accuracy of citrus canopy, with the intersection over union (IoU), overall accuracy (OA) and F1-score of 91.93%, 92.34% and 93.92%, respectively. Compared with the other three deep learning models, the IoU, OA and F1-socre of the U2-Net model were improved by 3.63%-8.31%, 1.17%-5.25% and 1.97%-4.91%, respectively. In addition, the U2-Net model had high consistency between the extraction area and the measured area of the citrus canopy, and the coefficient of determination (R2) of the three sample regions was higher than 0.93, and the error rate of the U2-Net model was lower than that of the other three deep learning models, with a root mean square error (RMSE) of 1.35 m2 and a mean relative error (MRE) of 8.15%. The results showed that the method of combining the U2-Net model with the multi-spectral image of the drones can realize the accurate extraction of citrus canopy, and the extracted canopy contour had a good integrity, which can provide basic data and technical support for the monitoring of citrus dynamic growth changes and yield prediction.

Keywords:Citrus; deep learning; U2-Net; canopy segmentation; drone imagery

基金项目:国家自然科学基金(41901370, 42261063);广西自然科学基金(2020GXNSFBA297096);广西科技基地和人才专项(桂科AD19110064);桂林理工大学科研启动基金(GLUTQD2017094);广西八桂学者专项项目(何宏昌)

第一作者简介:宋昊昕,硕士研究生。研究方向为摄影测量与遥感。E-mail: 2120201703@glut.edu.cn

*通信作者:尤号田,博士,副教授。研究方向为摄影测量与遥感。E-mail: youht@glut.edu.cn

0 引言

柑橘作为我国南方广泛种植的果树,在增加农民收入等方面发挥着重要作用。柑橘树冠、产量等基础数据的准确获取是实施精准农业的前提[1]。然而,目前获取这些数据的标准方法仍主要依靠人工劳动,费时费力。由于成本限制,大范围调查通常只选择几棵进行,抽样偏差和测量的稀疏性可能导致数据不准确[2]。因此,需要开发一种快速、可靠的技术,精确提取柑橘单木信息。

柑橘因树冠相对较小,一般仅为2.5~5 m,因而导致绝大多数基于遥感数据的研究多局限于区域尺度,难以精细到单木尺度。无人机(Unmanned Aerial Vehicles, UAV)凭借飞行高度低、操作灵活且成本较低等优点,可获得高达厘米级的影像数据,为柑橘单木提取研究提供了可靠的数据源。束美艳等[3]基于UAV影像,利用分水岭算法进行柑橘单木树冠分割,从而提取柑橘株数、树高和冠幅投影面积等结构参数信息。Koc-San等[4]基于UAV獲取多光谱影像生产数字表面模型,采用顺序阈值、Canny 边缘检测和圆形霍夫变换算法提取柑橘树冠边界,结果最高精度可达80%。

除影像空间分辨率外,单木分割算法也是影响柑橘单木信息精确提取的另一关键因素。传统分割算法虽已发展较为成熟,但在单木分割领域研究结果却不令人满意。陈周娟等[5]采用种子区域增长算法和标记控制分水岭算法分别进行单木冠幅提取,结果正确率分别为73.14%和63.43%。万祖毅[6]利用面向对象分割方法进行单木分割进而提取柑橘株数,结果精度仅为84.45%。深度学习(Deep Learning, DL)作为一种新兴的数据挖掘技术,现已广泛应用于图像目标检测与分割研究[7]。如:Osco等[8]提出一种新的卷积神经网络,基于无人机多光谱图像估计柑橘单木数量,结果准确度高达95%,但该算法树冠识别结果为圆形,无法精确分割树冠的细节。韩蕊等[9]基于UAV多光谱影像,在VGG16模型的基础上通过筛选对柑橘分类较为准确的波段,之后基于筛选波段利用U-Net进行柑橘单木树冠分割,结果准确率达91.99%,但该研究所选样地郁闭度不高,随着郁闭度的增加分割准确率有所下降。王辉等[10]构建了基于Mask R-CNN单株树冠的识别与分割模型,虽能精准快速识别并分割复杂环境下的单株柑橘树冠,准确率达到97%,但该模型测试图像中仅有一棵柑橘树,没有进行多棵柑橘树的识别。综上所述可知,先前研究所用主流深度学习模型虽能实现单木树冠分割,但仍存在一定不足,主要是因为这些模型用于提取原始图像全局语义细节的主干是VGG[11]、ResNet[12]和DensNet[13]等结构。这些网络结构主要是为图像分类任务而设计的,很容易忽略丰富的低级和中级语义特征,导致地物提取的完整性降低。而且这些应用于遥感地物提取的深度学习模型通常需要使用大量的遥感数据集进行预训练。如果目标对象的特征与这些数据集有很大差异,则总体提取效果相对较差。U2-Net模型是Qin等[14]2020年提出的一种新的深度学习模型,具有2个嵌套层的U形深度网络,无须对大量数据进行预训练,即可获得较高的精度,现已成功用于人像图像处理和生物医学图像分割,但在复杂树木单木分割方面研究则较少,将其与无人机多光谱影像协同应用进行柑橘单木分割潜能仍需进一步探索与验证。

本研究利用UAV进行柑橘多光谱影像数据采集,并对UAV图像进行处理以构建柑橘树冠检测和分割数据集,利用U2-Net模型与PSPNet, U-Net和DeepLabv3+深度学习模型分别进行单木树冠提取并对不同模型提取结果进行对比研究,以探究U-2-Net模型进行单木树冠分割的潜能,从而获得精度较高的单木分割方法,为柑橘动态生长变化监测和产量预测提供基础数据与技术支撑。

1 材料与方法

1.1 研究区概况

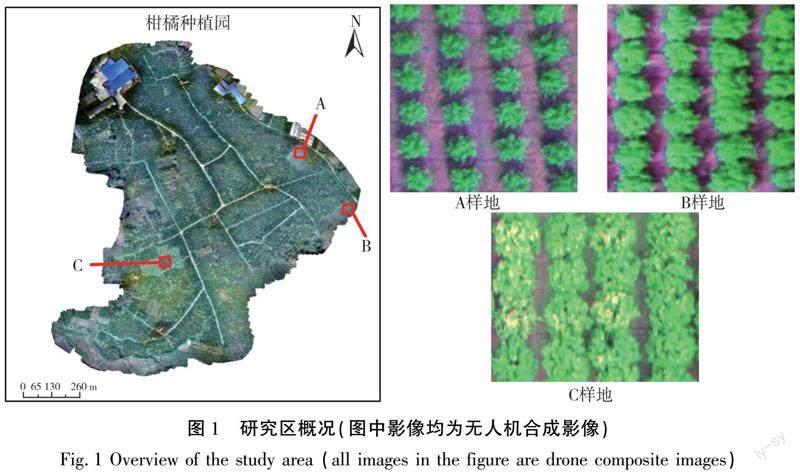

本研究所用研究区位于广西壮族自治区桂林市雁山镇柑橘种植基地(110°17′57.624″ E,25°2′6.072″ N),该区域地势相对平坦,高程变化较小,研究区内柑橘种植年份不同,因而冠形结构差异较大。为进一步验证深度学习模型对不同冠形结构柑橘单木分割的适用性,在研究区内选择了3块不同冠形结构的柑橘,具体如图1所示,其中区域A的柑橘树种植年份相对较短,树冠较小,间距大,树冠间没有明显重叠;区域B柑橘树树冠间存在少部分重叠和粘附;区域C柑橘树树冠相对较大,且树冠间有明显的重叠或粘附。

1.2 无人机图像采集

2021年11月在晴朗无风的天气利用DJI Phantom 4多光谱无人机对柑橘树进行数据采集,该多光谱传感器配备6个CMOS(1/2.9英寸),可同时获得6张影像,其中包括1张RGB真彩色图片以及5张不同波段的灰度图片,即蓝光(Blue,B)、绿光(Green,G)、红光(Red,R)、红边(Red Edge,RE)和近红外(Near Infrared,NIR)。飞行高度设置为135 m,航向和旁向重叠度分别设置为75%,整个研究区域共采集了RGB以及5个波段11 800张照片,使用Pix4D软件对采集的图像进行拼接,以生成空间分辨率为7.14 cm的数字正射影像图。通过对比发现,RNB( RNB为R波段,NIR波段和B波段组合的图像)波段组合的图像与RGB图像相比,更能清晰地显示柑橘树冠轮廓,如图2所示,因此本研究采用RNB图像。

1.3 数据集构建与数据扩充

首先将研究区域的正射影像分为410个子图像,从中选择395个子图像,其中包含柑橘树。为了让U2-Net深度学习模型更有效地学习图像中柑橘树冠的光谱特征,使用LabelMe 3.1.6图像注释软件在每个子图像中手动标记柑橘树冠得到真实标签。为获得最佳精度,深度学习模型通常需要许多图像作为训练数据集。然而,在研究区域采样的图像数量通常是有限的,这将导致模型训练期间的过度拟合[15]。因此,本研究使用数据增强方法对图像执行一系列变换,扩大数据集中的样本数量,增强模型的泛化能力,研究区域的原始UAV图像通过旋转、翻转和缩放进行几何变换,如图3所示。扩充后最终获得2 370幅图像,按照9∶1的比例划分训练集和测试集,几何变换后的数据使模型能够更好地获取不同角度、大小和形状的柑橘树冠特征,并提高了在各种条件下的适应性。

1.4 U2-Net深度学习模型

该模型的总体设计框架为2层嵌套的U形网络结构,如图4所示。每级都遵循一个编码器-解码器(encoder-decoder)结构,类似于U-Net模型中的结构。U2-Net模型的最外层是由编码器和解码器块组成的11个独立的大型U形结构,每个U形结构填充小的残差U形块(ReSidual U-blocks,RSU)。在前4个编码阶段(En_1~4),通过增加卷积层数来扩展感受野,获得更多的局部和全局特征。其中,顶层编码器En_5和En_6中的特征映射的分辨率相对较低,进一步降低这些特征映射的下采样(downsampling)导致有用特征信息的丢失。因此,在En_5和En_6阶段中,用扩展卷积代替了池和上采样(Upsample)操作,这使En_5和En_6的特征映射与其输入特征映射具有相同的高分辨率。解码阶段与编码阶段类似,采用逐步上采样、合并和卷积对高分辨率特征图进行编码,减少了直接上采樣造成的细节损失。模型还增加了一个不同尺度的特征图融合模块来生成显著性概率图。原理如下:以分辨率为288×288的图像为例,U2-Net首先通过一个3×3卷积层和一个sigmoid函数,从En_6、De_5、De_4、De_3、De_2和De_1生成6侧输出显著性概率图(six side output saliency probability maps):S(6)side(1×9×9)、S(5)side(1×18×18)、S(4)side(1×36×36)、S(3)side (1×72×72)、S(2)side(1×144×144)和S(1)side(1×288×288)。然后,分别以32、16、8、4、2和1的采样率对不同大小的特征概率图进行上采样,以获得6个1×288×288特征图,这些特征图使用1×1卷积层和Sigmoid函数进行融合。最后,以最小的误差生成树冠预测图(288×288)。新的设计使网络能够提取多尺度特征,并且不降低特征映射分辨率或显著增加内存和计算成本的情况下增加整个模型架构的深度。

1.4.1 RSU结构

通过借鉴经典的U-Net网络,该模型设计了一种新的残差U-block(RSU),用于在帧内捕捉多尺度特征。RSU(Cin、M和Cout)的结构如图5所示,其中Cin和Cout分别表示特征映射输入和输出通道的数量,而M表示RSU内部层中的通道数量,L表示编码器中包含的层数量。RSU由3个主要部分组成: 1)位于最外层的卷积层首先将输入特征映射x(H(图像高度)、W(图像宽度)和Cin)转换为输出通道为Cout的中间映射F1(x)。卷积层的作用是提取图像的局部特征; 2)转换后的中间映射F1(x)被输入到层数为L的U形结构对称编码器-解码器中。用U(F1(x))来展示这种结构,其可以提取多尺度信息,并减少上采样造成的上下文信息损失。L越大,RSU的层数越深,执行的池化操作越多,感受野范围越大,获得的局部和全局上下文特征越丰富;3)局部特征和多尺度特征通过剩余连接融合。

1.4.2 损失

在训练过程中,模型输出不仅包含最终的树冠预测图,还包含前6个不同尺度的特征图(S(1)side—S(6)side)。因此,在训练模型的过程中,不仅要监督网络的最终输出结果图,还要监督中间不同尺度的特征图。因此,本研究采用了一种类似于整体嵌套边缘检测的深度监控方法的深度监督方法,如式(1)所示,每次迭代输出7个损失(在公式中用Loss表示)。这些损失用于调整模型参数,以最小误差描绘重叠树冠。

式中:m为侧数;l(m)side(M=6,如图4中Sup1—Sup6所示) 是特征图在上采样过程中通过sigmoid激活函数之后得到对应的预测概率图S(m)side与真实标签计算得到的损失;lfuse是最终融合输出显著图预测结果Sfuse和真实标签计算得到的损失;W(m)side和Wfuse是每个损失的权重。

对于每一项,使用标准二值交叉熵来计算损失(l),如式(2)所示。

式中:(i,j)分别是像素坐标; H、W是图像的高度和宽度;PG(i,j)和Ps(i,j)分别表示地面真值和预测显著性概率图的像素值。训练过程试图将总损失Loss降至最低。在测试过程中,选择融合输出lfuse作为最终的显著性图。

1.5 评价指标

交并比(intersection over union, IoU,公式中用IoU表示)经常被用作语义分割任务的精度度量。在参考(reference, R)和预测(prediction, P)掩码中,IoU由2个掩码中的像素数与像素总数的比率来指示。通过比较样本的真实类别与模型的预测结果,可以将其分为以下4种情况:真阳性(true positive, TP,公式中用TP表示),其中柑橘冠的预测值与真实值一致;假阳性(false positive,FP,公式中用FP表示),实际情况是背景,但被错误地预测为树冠;假阴性(false negative, FN,公式中用FN表示),真实场景中的树冠未正确识别;真阴性(true negative, TN,公式中用TN表示),背景与真实值一致。此外,精确度(Precision,公式中用Precision表示)和召回率(Recall,公式中用Recall表示)、总体准确度(overall accuracy, OA,公式中用OA表示)和F1分数(F1-Score,公式中用F1-Score表示)被用作评估模型的评估指标。精确度、召回率、OA和F1分数越高,预测值越接近真实值。公式如下:

选择决定系数(R2)、平均相对误差(mean relative error, MRE,公式中用MRE表示)和均方根误差(root mean square error, RMSE,公式中用RMRE表示)测试U2-Net模型的可靠性,其中R2接近1,表明预测值和测量值相关性更高,MRE和RMRE越小,表明预测值越接近实测值。公式如下

2 结果与分析

本研究的硬件和软件参数见表1。U2-Net模型的一个主要优点是不需要基于大数据集的预训练模型。因此,本研究使用Xavier方法[16]初始化模型中的所有卷积层,并使用Adam优化算法[17]调整模型训练过程。模型批量大小(batch size)设置为14,迭代次数(epoch)设置为300,损失权重设置为1,其余超参数设置为默认值(初始学习率=0.003,betas=(0.9,0.999),eps=1×10-8,权值衰减=0)。根据给定的参数配置模型,并输入数据集进行迭代训练,总共需要18 h的训练时间。

2.1 基于U2-Net模型的树冠分割结果

3个分区中使用U2-Net模型提取柑橘树冠的结果如图6所示。由图6可知,所有试验分区均显示出良好的提取结果。A、B试验分区柑橘树冠密度较低,因此,树木之间有很好的区别,树冠的整体轮廓清晰,形状与实际一致。B区柑橘树的密度高于A区。尽管如此,该地区大多数树冠之间仍存在一定差距,因此U2-Net模型也可以很好地区分单株树冠,只有少数树冠相互附着。相反,C区柑橘密度较高,导致树冠重叠较多;因此,该分区的判别结果不如其他分区。根据不同分区的预测结果可以看出,郁闭度和树木间距对U2-Net模型的影响最大。严重的树冠遮荫和较近的树间距都使模型无法很好地区分每棵树。

U2-Net模型在不同分区提取的冠数的定量评估结果见表2。3个分区获得了较高的准确率,F1分数高于92.96%,OA超过91.23%。通过对各分区柑橘树预测精度的分析,发现U2-Net在A、B分区表现优异,其中柑橘树密度较低,树冠边缘附着和重叠低,OA分别为96.15%和95.09%,F1分数分别为97.94%和96.52%。随着柑橘树密度的增加,树冠边缘的粘连和重叠更加严重,导致U2-Net模型在C分区的性能略有下降,Precision为92.09%,OA为91.23%,F1分数为92.96%。可以看出,U2-Net模型在低树冠密度地区具有良好的适用性。3个分区的统计结果表明,IoU、OA和F1分数的平均值分别为90.74%、94.15%和95.81%,表明该方法用于柑橘树冠提取是可行的。

2.2 基于不同深度学习模型的树冠分割结果

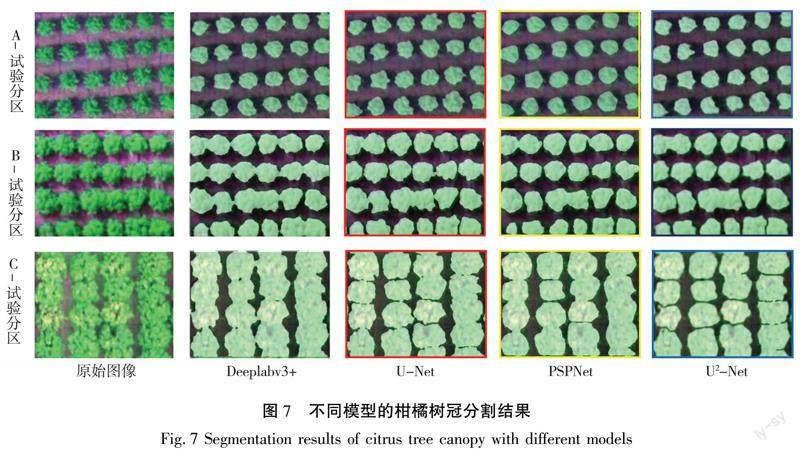

为了研究U2-Net模型的适用性,本研究将其图像分割和提取结果与其他3种主流深度学习模型(即PSPNet、U-Net和DeepLabv3+)进行了比较。DeepLabv3+,U-Net和PSPNet均使用VOC12+SBD预训练权重,所有4个模型使用相同的数据集进行训练。测试可视化提取结果如图7所示。由图7可以看出,4种深度学习模型在同一试验区域的提取效果没有明显的误分类现象,表明这些模型能够很好地区分目标特征和背景特征。然而,在观察细节时,可以看到DeepLabV3+和U-Net的在B试验分区和C试验分区对相连树冠识别的较差。与前2种模型相比,PSPNet模型具有更好的整体效果。但是该模型检测出的柑橘树冠一些部分有欠缺,与U2-Net模型相比存在遗漏现象。本研究使用的U2-Net模型显著减少了误分类和遗漏。虽然还存在一些缺陷,有几个树冠相互粘连,但树冠边缘分割的效果良好。

4个模型提取精度的定量分析结果见表3—表5。在A样地中,4个模型的评价结果几乎相同,每个模型的精度都较好,PSPNet模型的Recall与F1分数最高,达到98.65%和97.95%,仅仅比U2-Net模型高0.54%和0.01%。U2-Net模型的IoU,Precision,OA结果更好。在B样地中,柑橘树比较密集,4个模型的精度都有所降低,PSPNet模型的降幅较大,IoU与Recall分别降低了10.19%和11.23%,U2-Net模型降幅最小,表现稳定,整体结果依然比其他3个模型更好。在C样地中,柑橘树非常密集,4个模型结果差异更加明显,虽然U-Net的Precision最高,为92.87%,但IoU指标的表现不如其他3个模型。使用ResNet-101作为骨干网络的DeepLabv3+,在总体准确性方面优于U-Net。虽然以RSU为骨干网络的U2-Net模型的精度略低于U-Net模型,但在Recall、IoU、OA和F1分数方面更具有优势。U2-Net模型与其他3种模型相比,IoU、OA和F1分数分别提高了14.50%~17.33%、0.21%~9.24%和1.80%~9.06%,综上所述,U2-Net模型可以在样本数据较少的情况下实现更高的准确度,能够满足实际应用场景的准确度要求。

2.3 柑橘树冠面积提取结果

真实冠幅面积根据像素点测算,在labelme软件中通过目视解译手动勾勒测试图像的柑橘冠幅,生成只有冠幅和背景的标签文件,导入ArcMap查看每个冠幅对应的像素数,再乘以每个像素点的面积得到冠幅的真实面积。不同试验区使用U2-Net模型对冠面积提取进行定量评估的结果见表6。A试验分区柑橘树分布均匀,低树冠密度,背景复杂度低,其RMSE和MRE分别为0.34 m2和2.27%,达到了最高的精度。B区的树冠密度较高,但单株树之间存在一定的差距,因此,附近树木的阴影受影响较小,预测值接近测量值。RMSE和MRE分别为1.01 m2和7.72%。准确度最差的是C区,由于树冠密度很高,受阴影影响很大,RMSE和MRE在所有分区中最低,分别只有2.7 m2和14.67%。

比較3个试验分区中预测和测量的树冠面积之间的关系,如图8所示,2个试验分区A和B的R2大于0.95。大多数点分布在1∶1的直线周围,表明U2-Net模型在这些区域提取的面积与测量值高度一致。然而,分区C的决定系数(R2)相对较低,只有0.93。由于该地区柑橘树的严重重叠和粘附,大多数提取面积小于RMSE和MRE所示的测量值。

另一方面,不同試验分区的提取面积值通常与实测值接近。因此,U2-Net模型在提取柑橘树冠面积方面具有较高的精度,能够满足林业调查中提高树冠面积精度的要求,柑橘冠提取任务中4个模型的误差如图9所示。由此可以看出,U2-Net模型在RMSE和MRE中的错误率最低,平均达到1.35和8.15%,表明其提取的面积值最接近测量值。U-Net模型的表现类似于U2-Net,RMSE值为1.71,MRE值为10.42%,而DeepLab V3+和PSPNet的表现更差,RMSE分别为4.24和6.19,MRE分别为16.63%和18.74%。因此,U2-Net的表现优于其他3个模型。

3 结论与讨论

研究利用UAV进行柑橘多光谱影像数据采集,并对UAV图像进行处理以构建柑橘树冠检测和分割数据集,利用U2-Net模型与PSPNet, U-Net和DeepLabv3+深度学习模型分别进行单木树冠提取,并对不同模型提取结果进行对比研究,所得结论主要如下。

1)U2-Net模型在不同的试验分区中均取得了较好的柑橘单木检测和分割结果,其中在试验分区A中,识别准确率最高,准确率和召回率分别为97.78%和98.11%。与3种主流的深度学习模型(PSPNet、U-Net和DeepLabv3+)相比,U2-Net模型在冠数提取方面具有更高的IoU,OA和F1分数,平均值分别提高了6.20%~8.68%、0.93%~4.83%和2.03%~5.25%。

2)U2-Net模型在树冠面积提取方面也表现良好,模型的预测面积更接近实测面积,3个样地的R2均高于0.93。与3种主流的深度学习模型(PSPNet、U-Net和DeepLabv3+)相比,U2-Net模型的平均相对误差和均方根误差最低,分别为1.35和8.15%。

研究结果表明利用UAV多光谱图像和U2-Net深度学习模型相结合的方法可以有效地提取柑橘单木树冠,可为更高层次的应用提供准确的数据支持,但该方法仍有一些局限性,有待改进。

1)通过分析不同试验分区的提取结果,发现,即使在中午进行航空摄影,UAV图像仍然无法完全避免光引起的阴影问题。由于阴影的存在,模型很难提取被阴影遮挡的柑橘树冠,导致预测值低于测量值。

2)复杂的植被类型、密集重叠的树冠和较小的树木间距会阻碍树冠的提取[18]。因此,在未来的研究中应选择更优秀的模型在复杂的环境条件进行柑橘单木树冠提取研究,以克服阴影及复杂地形的影响,进而提高柑橘单木树冠的分割精度。

【参 考 文 献】

[1]NARVAEZ F Y, REINA G, TORRES-TORRITI M, et al. A survey of ranging and imaging techniques for precision agriculture phenotyping[J]. IEEE/ASME Transactions on Mechatronics, 2017, 22(6): 2428-2439.

[2]BARGOTI S, UNDERWOOD J P. Image segmentation for fruit detection and yield estimation in apple orchards[J]. Journal of Field Robotics, 2017, 34(6): 1039-1060.

[3]束美艳,李世林,魏家玺,等.基于无人机平台的柑橘树冠信息提取[J].农业工程学报,2021,37(1):68-76.

SHU M Y, LI S L, WEI J X, et al. Extraction of Citrus crown parameters using UAV platform[J]. Transactions of the Chinese Society of Agricultural Engineering, 2021, 37(1): 68-76.

[4]KOC-SAN D, SELIM S, ASLAN N, et al. Automatic citrus tree extraction from UAV images and digital surface models using circular Hough transform[J]. Computers and Electronics in Agriculture, 2018, 150: 289-301.

[5]陈周娟,程光,卜元坤,等.基于无人机倾斜影像的阔叶林单木参数提取[J].林业资源管理,2022(1):132-141.

CHEN Z J, CHENG G, BU Y K, et al. Single tree parameters extraction of broad-leaved forest based on UAV tilting photography[J]. Forest Resources Management, 2022(1): 132-141.

[6]万祖毅.基于无人机遥感的柑橘果树信息提取及应用研究[D].重庆:西南大学,2020.

WAN Z Y. Research on information extraction and application of Citrus fruit trees based on UAV remote sensing[D]. Chongqing: Southwest University, 2020.

[7]WU J, YANG G, YANG H, et al. Extracting apple tree crown information from remote imagery using deep learning[J]. Computers and Electronics in Agriculture, 2020, 174: 105504.

[8]OSCO L P, ARRUDA M, JUNIOR J M, et al. A convolutional neural network approach for counting and geolocating citrus-trees in UAV multispectral imagery[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2020, 160: 97-106.

[9]韓蕊,慕涛阳,赵伟,等.基于无人机多光谱影像的柑橘树冠分割方法研究[J].林业工程学报,2021,6(5):147-153.

HAN R, MU T Y, ZHAO W, et al. Research on citrus crown segmentation method based on multi-spectral images of UAV[J]. Journal of Forestry Engineering, 2021, 6(5): 147-153.

[10]王辉,韩娜娜,吕程序,等.基于MaskR-CNN的单株柑橘树冠识别与分割[J].农业机械学报,2021,52(5):169-174.

WANG H, HAN N N, LYU C X, et al. Recognition and segmentation of individual Citrus tree crown based on Mask R-CNN[J].Transactions of the Chinese Society for Agricultural Machinery, 2021, 52(5):169-174.

[11]SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition[EB/OL]. 2014, arXiv:1409.1556[cs.CV].

[12]HE K M, ZHANG X Y, REN S Q, et al. Deep residual learning for image recognition[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). June 27-30, 2016, Las Vegas, NV, USA. IEEE, 2016: 770-778.

[13]HUANG G, LIU Z, VAN DER MAATEN L, et al. Densely connected convolutional networks[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). July 21-26, 2017, Honolulu, HI, USA. IEEE, 2017: 2261-2269.

[14]QIN X, ZHANG Z, HUANG C, et al. U2-Net: going deeper with nested U-structure for salient object detection[J]. Pattern Recognition, 2020, 106: 107404

[15]SU D, KONG H, QIAO Y, et al. Data augmentation for deep learning based semantic segmentation and crop-weed classification in agricultural robotics[J]. Computers and Electronics in Agriculture, 2021, 190: 106418.

[16]GLOROT X, BENGIO Y. Understanding the difficulty of training deep feedforward neural networks[J]. Journal of Machine Learning Research - Proceedings Track, 2010.

[17]KINGMA D P, BA J. Adam: a method for stochastic optimization[EB/OL]. 2014, arXiv: 1412.6980[cs.LG].

[18]CASAPIA X T, FALEN L, BARTHOLOMEUS H, et al. Identifying and quantifying the abundance of economically important palms in tropical moist forest using UAV imagery[J]. Remote Sensing, 2019, 12(1): 9.