基于图像和特征联合优化的跨模态行人重识别研究

2023-06-03张辉刘世洪钟武

张辉 刘世洪 钟武

摘要:跨模态行人重识别(VI-ReID)旨在匹配可见光和红外摄像头下捕获的行人图像,十分具有挑战性。为减小可见光图像和红外图像之间的模态差异,本文提出了异质图像增广方法和跨模态特征对齐方法来优化跨模态行人重识别网络,利用轻量级异质图像卷积生成器对可见光图像进行增广,采用色彩抖动方式对红外图像进行增广,并使用正样本优化轻量级异构图像卷积生成器来约束损失。在此基础上,使用两个模态分类器和跨模态特征对齐损失作为指导,不断学习获得模态共享的特征。在两个数据集上的大量实验表明,我们的方法具有优异的性能,在SYSU-MM01和RegDB数据集上分别达到了rank1/mAP 57.82%/54.35%和80.39%/75.05%的精度。

关键词:跨模态行人重识别;模态差异;异质图像增广;跨模态特征对齐

中图分类号:TP391.41 文献标志码:A 文章编号:1008-4657(2023)02-0009-09

0 引言

可见光-红外的跨模态行人重识别(Cross-Modality Person Re-identification)是安防监控领域中非常重要的一项技术,具有重要的研究意义和广泛的应用场景。Ye等[ 1-2 ]设计了由特征提取和距离度量组合成的端到端学习框架,采用双流卷积神经网络,同時处理跨模态和模态内差异。Dai等[ 3 ]引入了生成对抗学习框架,通过改进三元组损失函数和交叉熵损失函数共同约束身份类别和模态类别。Wang等[ 4-5 ]讨论了在跨模态行人重识别中,基于双流卷积神经网络的共享参数问题,并借鉴中心损失[ 6 ](Center Loss)思想提出基于异质中心的三元组损失(Hetero-Center based Triplet Loss)。以上方法都是在特征层面上试图对两种模态的特征进行约束,提升网络匹配跨模态图像的性能,然而不同光谱图像之间是像素级的剧烈不平衡,因此效果仍然无法令人满意。

图像层面上,一些工作利用生成对抗网络来减小模态差异的影响,Wang等人[ 7 ]先将当前模态图像生成对应另一模态的图像,通过生成图像和原图像在通道上叠加后组合成多光谱图像,统一图像的模态后,再将多光谱图像作为特征提取网络的输入。一种对齐生成对抗网络[ 8 ](Alignment Generative Adversarial Network,AlignGAN)将跨模态行人重识别任务分为像素对齐、特征对齐和联合鉴别器三个模块,减小了跨模态和模态内行人图像变化所带来的影响。但是,生成对抗网络需要依赖大量的训练数据,收敛速度慢,计算成本比较高,而且生成图像不同于原始图像的结构,生成图像的分辨率更低,并引入了许多噪声。

虽然目前在跨模态行人重识别领域中已经出现了很多方法,但是仍然面临着两个主要挑战,第一是处理由光照不同、行人姿态变化、跨摄像头视角变化带来的行人样本间的外观差异[ 9 ],第二是处理由于可见光、红外两种模态下摄像头捕获的行人图像高度异构而产生的模态差异。本文在传统单模态行人重识别方法的基础上,构建了应用于跨模态场景的双流网络[ 10 ],利用批次样本三元组损失[ 11 ]度量高维特征空间内行人特征的距离,并使用基于交叉熵计算的身份分类损失对行人类别进行约束,在网络训练过程中不断减小同一行人多个样本间外观差异带来的影响。

针对不同模态下行人样本间的模态差异,在图像层面上,提出了一种基于双流网络的异质图像增广(Heterogeneous Image Augmentation,HIA)方法,原始可见光图像经过轻量级异质图像卷积生成器转变为异质图像,红外图像经过色彩抖动处理后转变为亮度、对比度和饱和度不断变化的新红外图像。异质图像和新红外图像都是在原始图像上的增广图像,它们与原始图像共同作为双流网络的输入,可以减小图像层面上的模态差异,使网络更容易学到模态间的共享特征。在特征层面上,提出了一种基于模态分类的跨模态特征对齐方法(Cross-modality Feature Alignment,CFA),对可见光和红外模态设置预定义标签,双流网络提取出两种模态的特征后,模态分类器对两种模态特征按照预定义标签来分类,并更新模态分类器部分权重参数,然后通过设计跨模态特征对齐损失,在优化特征提取网络中使模态分类器将两种模态特征分类为相反标签。在不断迭代的过程中,模态分类器和特征提取网络交替更新各自模型参数,引导网络学习模态共享特征,减小了特征层面上的模态差异。

1 图像和特征联合优化方法

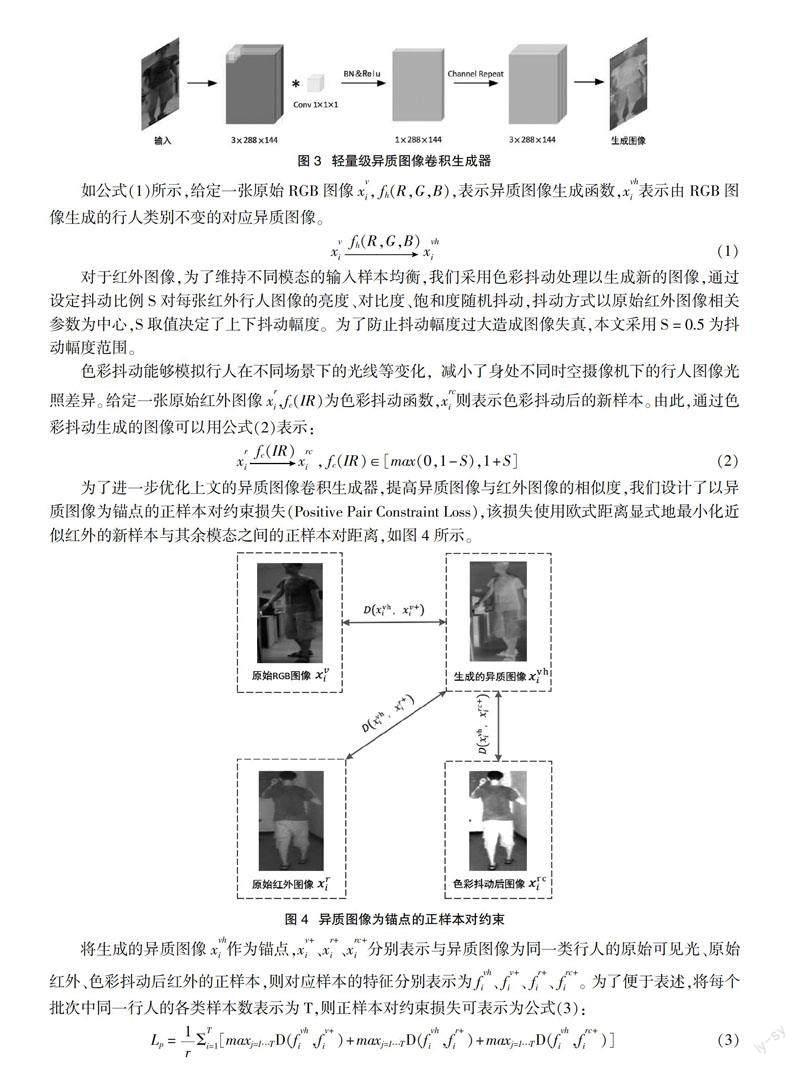

本文提出的方法是在图像和特征两个层面上来减小跨模态行人重识别中的模态差异,进而优化跨模态行人重识别网络的性能,该方法主要包含两个部分。(1)异质图像增广(HIA):设计轻量级异质图像卷积生成器用于可见光图像的增广,采用色彩抖动处理方式进行红外图像的增广,设计正样本对约束损失Lp用于优化异质图像卷积生成器。(2)跨模态特征对齐(CFA):在两个模态的图像特征共同嵌入时,设计模态特征对齐模块Lcfa,用于在统一特征空间内拉近两个模态的特征。

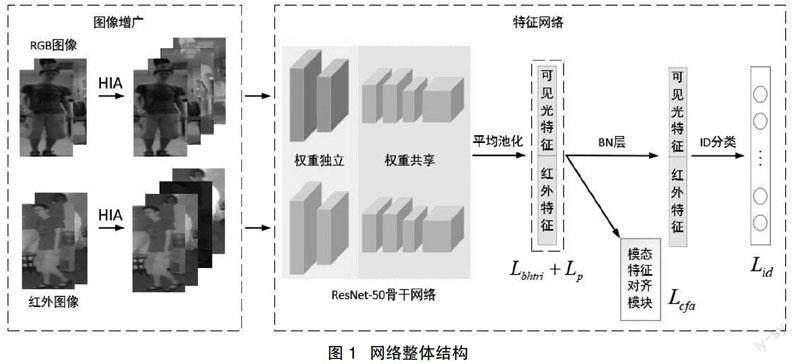

将本文方法应用到跨模态行人重识别的整体网络结构后(图1),其工作步骤是:

(1)两种模态的图像进行增广后,通过权重独立的浅层网络提取各自模态的特征,再通过权重共享的网络将两种模态的特征映射到统一的特征空间内,经过全局平均池化(Global Average Pool,GAP)后得到可见光和红外模态2048维度的高维特征。在网络训练反向传播的过程中,利用正样本对约束损失Lp,优化可见光图像经过异质图像卷积生成器后生成的异质图像。

(2)在高维特征空间中,采用批次难样本三元组损失函数Lbhtri进行特征距离度量,使用设计的模态特征对齐模块Lcfa减小模态差异带来的影响。然后,高维特征经过批量归一化层(Batch Normalization,BN)以保证网络稳定收敛,并使用参数共享的全连接层(Fully Connected Layers,FC)对模态共享信息进行建模,最后计算基于交叉熵的身份分类损失对行人身份进行分类。

其中图2(a)为灰度-零填充:由于红外图像中不含颜色信息,因此文献[ 3 ]提出了一个深度零填充的特征学习网络框架,将所有行人图像灰度化后零填充,形成两通道图像,输入到权重共享的单流网络中学习。然而这样的处理方式未利用到所有信息,它忽略了可见光图像中重要的颜色信息。

图2(b)为RGB-灰度:文献[ 1 ]采用双流网络,直接使用RGB三通道的可见光图像和由单通道重复扩展为三通道的红外图像作为输入,然后将特征嵌入到统一空间中学习跨模态特征表示,网络性能的提升证明了颜色信息对跨模态行人重识别任务是有益的。此后,为了适配网络的输入,将红外图像的单通道重复扩展为三通道灰度图像。

图2(c)为GAN生成:生成对抗网络[ 11 ](GAN)可以生成当前模态对应的另一域的行人图像,在图像层面上达成“模态统一”,其思想就是应用图像风格迁移的方式,将跨模态转换成单模态下的行人重识别。但是GAN生成图像与原始图像相比,噪声增加,清晰度和分辨率下降,部分有益信息会丢失。另外,如果利用GAN將红外图像生成可见光图像,由于没有颜色信息的监督,生成图像将更加不可靠。

现有的图像生成方法大多是利用GAN达到“模态统一”,但此方法没有充分利用可见光图像的颜色信息,颜色信息对于每个模态下的行人聚类是有益的。所以,为了解决RGB图像与红外图像之间高度异构的问题,本文提出了一个新的异质图像增广方法,即图2(d)。

图2(d)为本文方法:采用双流网络作为基础网络,通过异质图像卷积生成器生成的异质图像减小模态差异,使用色彩抖动对红外图像进行处理,模拟光照变化。生成图像作为原始图像的增广样本,在减少模态差异的同时,还利用了原始行人图像中颜色、纹理等有益信息。

对于可见光图像,如图3所示,轻量级异质图像卷积生成器采用的卷积核,将尺寸为(通道数/高度/宽度)的RGB三通道图像在通道上降维压缩成单通道图像,随后采用修正线性单元(Rectiflied Linear Unit,ReLU)和批量归一化(Batch Normalization,BN),以改善模型的非线性表达能力,输出的单通道图像扩展为与红外一致的三通道图像。通过异质图像卷积生成器生成的新样本与红外图像一起输入到双流网络中统一进行训练,随着损失函数的逐渐收敛和网络反向传播优化,训练过后的异质图像卷积生成器能够生成近似红外的新图像。

实验结果表明,异质图像增广方法(HIA)在两种搜索模式下均达到了很好的效果,在常用的全搜索模式下,将本文构建的基础双流网络(Baseline)与应用HIA方法的双流网络(Baseline+HIA)进行对比,后者在rank-1和mAP上的绝对百分比提高了6.21%和4.31%。将Baseline与应用HIA和CFA方法的双流网络(Baseline+HIA+CFA)进行对比,后者在在rank-1和mAP上的绝对百分比提高了9.30%和6.20%。

如表4所示,分别在RegDB数据集的两种测试模式(可见光检索红外和红外检索可见光)下进行测试实验。实验结果表明,在可见光检索红外模式下,与Baseline相比,HIA方法使rank-1和mAP值绝对百分比分别提升了5.62%和5.11%,HIA和CFA联合优化方法使rank-1和mAP值绝对百分比分别提升了8.38%和7.30%。

3 结论

为了减少可见光图像和红外图像之间的模态差异,在图像层面上,我们提出了基于双流网络的异质图像增广方法,利用轻量级异质图像卷积生成器从原始可见光图像生成异质图像,采用色彩抖动方式从原始红外图像生成新红外图像,在此基础上,我们还设计了基于异质图像的正样本对约束损失,用于优化轻量级异质图像卷积生成器。在特征层面上,我们提出了基于模态分类的跨模态特征对齐方法,通过两个模态分类器和跨模态特征对齐损失不断引导网络学习模态共享特征。在两个公开数据集SYSU-MM01和RegDB上的实验结果表明了本文方法的优越性。

参考文献:

[1] Ye Mang,Wang Zheng, Lan Xiangyuan, et al. Visible thermal person re-identification via dual-constrained top-ranking[C]//Proceedings of the 27th International Joint Conference on Artificial Intelligence. San Francisco:Margan Kaufmann,2018: 1092-1099.

[2] Ye Mang,Wang Zheng,Li Jiawei,et al. Hierarchical discriminative learning for visible thermal person re-identification[C]//Proceedings of the Thirty-Second AAAI Conference on Artificial Intelligence and Thirtieth Innovative Applications of Artificial Intelligence Conference and Eighth AAAI Symposium on Educational Advances in Artificial Intelligence. 2018:7501-7508.

[3] Dai Pingyang,Ji Rongrong,Wang Haibin,et al. Cross-modality person re-identification with generative adversarial training[C]//Proceedings of the 27th International Joint Conference on Artificial Intelligence. San Francisco:Margan Kaufmann,2018:677-683.

[4] Wang Zhixiang,Zheng wang,Zheng Yinqiang,et al. Learning to reduce dual-level discrepancy for infrared-visible person re-identification[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR). NJ:IEEE,2019:618-626.

[5] Ye Mang, Lan Xiangyuan, Wang Zheng, et al. Bi-directional center-constrained top-ranking for visible thermal person re-identification[J]. IEEE Transactions on Information Forensics and Security,2019,15:407-419.

[6] Wen Yandong,Zhang Kaipeng,Li Zhifeng,et al. A discriminative feature learning approach for deep face recognition[C]//Computer Vision–ECCV 2016:14th European Conference. Cham:Springer,2016:499-515.

[7] Wang Guanan,Zhang Tianzhu,Cheng Jian,et al. RGB-infrared cross-modality person re-identification via joint pixel and feature alignment[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision. NJ:IEEE,2019:3623-3632.

[8] Wu Ancong, Zheng Weishi, Yu Hongxing, et al. RGB-infrared cross-modality person re-identification[C]//Proceed-ings of the IEEE international conference on computer vision. NJ:IEEE,2017:5380-5389.

[9] Hao Yi,Wang Nannan,Li Jie,et al. HSME: hypersphere manifold embedding for visible thermal person re-identification[C]//Proceedings of the AAAI conference on artificial intelligence. Menlo Park:AAAI,2019,33(01):8385-8392.

[10] Zhu Junyan,Park Taesung,Isola Phillip,et al. Unpaired image-to-image translation using cycle-consistent adversarial networks[C]//Proceedings of the IEEE international conference on computer vision. NJ:IEEE,2017:2223-2232.

[11] Ian Goodfellow,Jean Pouget-Abadie,Mehdi Mirza,et al. Generative adversarial networks[J]. Communications of the ACM, 2020,63(11):139-144.

[12] Hermans A,Beyer L,Bastian L. In defense of the triplet loss for person re-identification[J/OL].[2022-12-23].http://arxiv.org/abs/1703.07737.preprint arXiv:1703.07737,2017.

[13] Nguyen Dat Tien,Hong Hyun Gil,Kim Wan Ki,et al. Person recognition system based on a combination of body images from visible light and thermal cameras[J]. Sensors,2017,17(3):605-633.

[14] Luo Hao,Gu Youzhi,Liao Xingyu,et al. Bag of tricks and a strong baseline for deep person re-identification[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops. NJ:IEEE,2019:4321-4329.

[责任编辑:王妍]

Cross-modality Visible-infrared Person Re-identification

Based on Joint optimization of Image and Feature

ZHANG Hui1, LIU Shihong2, ZHONG Wu1

(1. Wuhan Melit Communication Co., Ltd., Wuhan 430075, Hubei;

2. Chongqing Jinmei Communication Co., Ltd., Chongqing 400030)

Abstract:Cross-modality Visible-infrared Person Re-identification (VI-ReID) aims to match the person images captured under visible and infrared cameras, which is very challenging. In order to reduce the modality difference between visible and infrared images, this paper proposes a heterogeneous image augmentation method and a cross-modality feature alignment method to optimize the VI-ReID network, uses lightweight heterogeneous image convolution generator to augment visible images, uses color jitter to augment infrared images, and optimizes lightweight heterogeneous image convolution generator by using positive samples to constrain loss. On this basis, two modality classifiers and cross-modality feature alignment loss continuously guide the network to learn modal shared features. Extensive experiments show that our method has excellent performance, achieving the accuracy of 57.82%/54.35% for rank1/mAP and 80.39%/75.05% on SYSU-MM01 and RegDB datasets respectively.

Key words:VI-reID;modality differences;heterogeneous image enhancement;cross-modality feature alignment

收稿日期:2023-01-02

作者簡介:张辉(1969-),男,湖北武汉人,武汉迈力特通信有限公司高级工程师,主要研究方向:有线无线通信系统传输接入交换技术;

刘世洪(1971-),男,重庆人,重庆金美通信有限责任公司高级工程师,主要研究方向:数字信号处理及光通信;

钟武(1982-),男,湖北黄冈人,武汉迈力特通信有限公司工程师,主要研究方向:通信技术、图像识别。