无人机基于视觉引导的移动平台追踪与降落

2023-02-23王梓屹张志安

万 铧,王梓屹,李 胜,张志安

无人机基于视觉引导的移动平台追踪与降落

万 铧1,王梓屹1,李 胜1,张志安2

(1.南京理工大学 自动化学院,南京 210094;2.南京理工大学 机械工程学院,南京 210094)

针对当前可远距离实现纯视觉引导无人机降落的方案中合作目标尺寸过大的问题,提出一种三维与二维标志组合的合作目标设计思路:通过深度学习加手工特征检测三维标志以进行远距离定位与追踪,接近后切换检测二维标志以进行降落;引入三维合作目标后,在不降低定位精度的前提下,1.5 m高度的可检测距离增加了2.54倍,且可大角度倾斜检测,合作目标尺寸也大幅减小。实验结果表明,远距离阶段平均定位误差为0.05 m,近距离阶段在移动平台上的降落点平均误差为0.03 m,说明该小尺寸合作目标的视觉定位精度与降落精度很高,可以追踪并降落在移动中的超小尺寸降落平台上。

无人机(UAV);合作目标;视觉;追踪;降落

0 引言

电动多旋翼无人机在工业、农业、商业等领域有着广泛的应用,但续航限制了发展,作业中须频繁降落补充能源。文献[1]指出无人机人工降落阶段事故多发,操作人员工作负担和风险大,须寻找一种鲁棒性较高的无人机自主降落方案,降低无人机作业中操作人员的在环程度。

文献[1]介绍了现有无人机自主降落方案,总结为有源和无源2类,有源指须与外部定位源(卫星、基站等)进行通信,获取自身位置,无源指仅依靠自身硬件实现自主降落,有捷联惯导与视觉定位等方式。文献[2]指出,基于视觉检测合作目标的定位与导航完全由机载设备完成决策与控制,无须与外部定位源通信,实时性强,定位精度高且不受时间、空间影响,适用场景广。当前一些商品级无人机机场(例如大疆机场),也用视觉识别的方式在末端进行辅助定位。这些机场常用小尺寸二维合作目标以减小机场尺寸,但这使得无人机只能在停机坪上方获得完整合作目标后开启视觉引导,稍远之外则依赖载波相位差分(real time kinematic,RTK)技术提供高精度的定位信息,在室内或复杂电磁环境等条件下无法使用;RTK也使得机场只能在静止状态下回收无人机,使用场景受限。对此更多研究倾向于纯视觉定位合作目标,减少对RTK的依赖,且更倾向于动态回收,以提高实用性,拓展应用场景。

文献[3]设计了一种富含光流特征的平板,面积达10829 cm2,精度易受误差累积影响,定位结果的均方根误差(root mean squared error,RMSE)为0.25 m。文献[4]为此加入回字形定位图案,通过细分层级实现了由远至近不断精细化的定位,RMSE降低至0.06 m,但合作目标仍然很大,且同样只能俯视检测。视觉定位领域的文献[5]设计了四月标签(AprilTag),已发展为视觉基准库,用于获取相机的高精度位姿。文献[6]提出了类似的方案,取名科尔多瓦大学增强现实(augmented reality university of Cordoba,ArUco),也可获得相机的位姿,已集成至开源计算机视觉库(open computer vision,OpenCV)。AprilTag与ArUco都是二维码类标识,检测角点后解点透视(perspectivepoints,PP)问题获得二维码位姿,检测速度快,定位精度高,一经提出就有很多研究者将其作为合作目标应用于视觉降落。文献[7]在A3纸上用AprilTag实现平均绝对误差(mean absolute error,MAE)0.08 m的定位,兼顾了合作目标尺寸与定位精度,但只进行了俯视检测。文献[8]设计了一种有6组不同半径比同心圆的合作目标,2.5 m高度俯视定位MAE<0.035 m,但尺寸过大。文献[9]提出一种基于编码圆的分布式编码,远距离更易于解读,可用于降低面积。

上述研究均在全画幅上用手工特征方式提取合作目标特征,易受背景、光照等因素干扰。随着深度学习技术的发展,一些研究使用深度学习检测合作目标[10]。文献[11]用更快的区域卷积神经网络(faster region convolutional neural networks,Faster R-CNN),其在图像变形时也有极高的成功率,但检测速率慢,平均帧率(frame per second,FPS)仅12.5。文献[12]使用第五代目标检测算法(you only look once,YOLO)检测目标特征区域,在英伟达显卡电脑上FPS可达140。文献[13]用生成对抗网络去模糊技术[14]来改善无人机飞行抖动造成的运动模糊问题,经过特定的轻量化操作后可在机载平台上达到实时的推理速度,为后续目标检测提供去模糊的图像输入,提高特定目标的检测成功率与定位精度。相较手工特征,深度学习可以从更高维度上提取合作目标特征,在增加一些推理时间的代价下可更好地减少环境干扰,提高检测成功率。

可以发现,当前纯视觉降落研究均使用二维平面合作目标,尚无法兼顾减小合作目标尺寸、提高定位精度与增加检测距离。对此,本文基于文献[4]分阶段思想,在纯视觉自动降落领域引入三维合作目标,设计一种分布式三维标志(球体)与二维标志(AprilTag)组合的合作目标。

1 合作目标设计

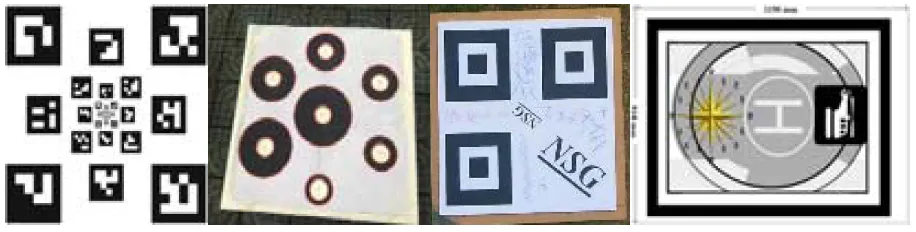

当前部分代表性研究中的平面合作目标如图1所示,相关指标如表1所示。

图1 部分研究中的合作目标

表1 部分研究中的合作目标及相关指标

以在合作目标尺寸与定位误差方面取得较好平衡的AprilTag为例,测试其水平检测距离极限,如图2所示。当74°垂直视场角的相机在150 cm高度、45°斜向下时,边长20 cm的AprilTag(选用36 h 11族系降低误检率,该族系的二维码均含6×6个像素块,最小汉明距离值为11)在250 cm外检测成功率开始降低,至275 cm外已无法检测得到。

图2 二维码水平检测距离极限测试

无法检测的原因在于水平距离增加,相机与合作目标平面夹角减小,相对倾斜程度增加,二维码投影的宽度维度逐渐丢失,编码信息难以被解读,且变形后短边像素点减少,拟合精度降低,特征点精度降低,定位精度也将降低[15-16]。此外,位姿解算只需4个角点,编码图案占用大量面积,且上述小夹角情况下无法发挥作用。

为兼顾尺寸、精度与范围指标,本文提出的合作目标中的三维标志参考文献[9]的思路,使用球体(投影为圆形,等周长时面积最大),无论相机与合作目标平面夹角如何变化,投影始终为圆形,不会向一维退化,并用颜色排列设置编码信息(因解PP问题需至少4对点,以颜色排列顺序作为编码约束进一步降低环境中可能的干扰),用尽量少且鲜明的特征替代二维码,如图3所示,在保证远距离、大倾斜情况下特征点提取精度的同时减少面积占用。

图3 降落平台

如图4所示,检测到同数量边缘像素点时(4= 8π),标志球投影总面积4π2=4π(4/8π)2=2π,二维码面积2,故检测到相同理论精度特征点时,标志球投影总面积小于二维码。

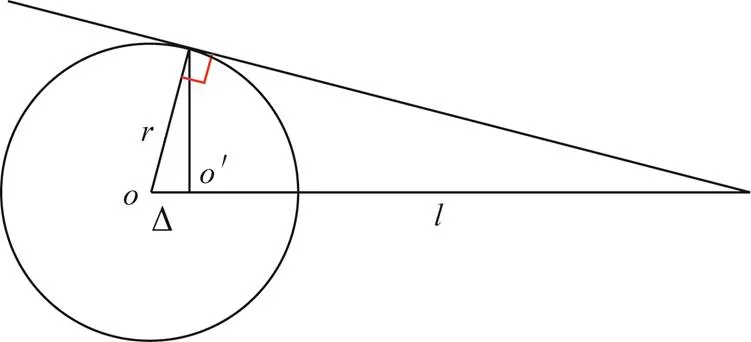

球的投影特性也无须如文献[8]中为解决变形问题而递归求解圆心,可减少计算时间,但标志球投影圆由视锥与该球的切线包围形成,圆心′对应的空间点不是球心,如图5所示。

图5 像素平面圆心与实际球心位置误差

认为圆心′对应的空间点即是球心的最小无差检测距离,计算公式为

式中:为球半径,取7.5 cm;Δ为′与的空间位置误差率,取小于0.1%。

以该最小无差检测距离为界,距离外进行一阶段远距离三维球体检测与定位,越过分界后进入近距离的二阶段,二阶段选取已有研究中在尺寸与定位误差方面取得较好平衡的AprilTag,为近距离的无人机提供超实时的精确定位信息。为避免误检导致的错误定位,选用编码信息丰富的36h11族系;为保证相机在至接近落地时始终捕获到完整标签,使用同心嵌套的方式,如图6所示。外层标签优先级高于内层小面积的二维码,外层标签边长20 cm,内层为3 cm,一张A4纸即可容纳。如图2所示的实验已证明这个距离内可成功检测这个尺寸的二维码合作目标。

图6 二维码示意

2 合作目标检测算法及位姿解算

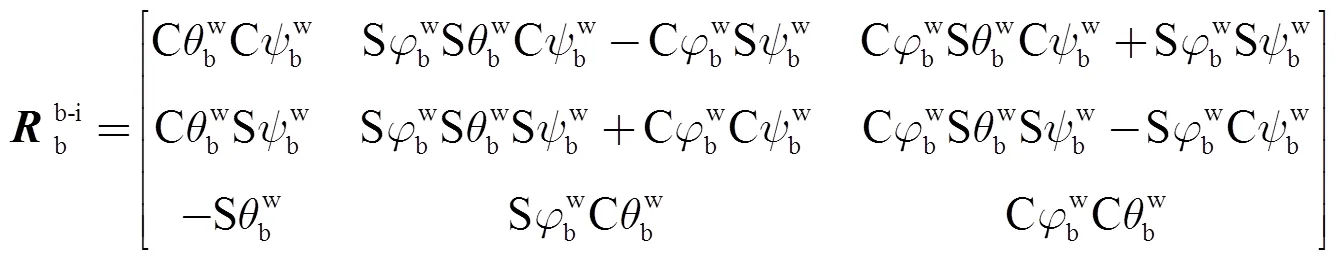

本文坐标系定义如表2所示,三维坐标系均是右手系,三轴姿态角满足右手定则。

表2 坐标系定义

2.1 目标检测算法

2.1.1 一阶段目标检测算法

由于在全画幅上采用手工特征方式提取合作目标特征,容易受背景、光照等环境因素干扰,本文使用深度学习目标检测算法在一阶段检测用于远距离追踪的三维合作目标。

依据文献[12,17],YOLO家族的YOLOv5在检测速度与精度上做到了很好的平衡,适用于工程项目。本文选用YOLOv5-6.0,其网络由主干网络、颈部和检测头3部分组成,结构如图7所示,图中CBS是卷积层(convolutional layer,Conv)、批量归一化层(batch normalization,BN)、S形加权线性激活函数(sigmoid linear unit,SiLU)的首字母缩写组合。主干网络进行了一系列卷积操作以提取各个层次的特征,并在主干网络和颈部间使用快速空间金字塔池化(spatial pyramid pooling-fast,SPPF)以降低运算量、提高速度;颈部使用特征金字塔网络(feature pyramid network,FPN)加像素聚合网络(pixel aggregation network,PAN)的特征融合结构,其中FPN自顶向下传递强语义信息,PAN自底向上传递强定位信息,并用跨阶段局部结构(cross stage partial,CSP)加强特征融合能力;最后检测头在颈部3个不同尺度的输出上利用自适应锚框进行目标检测,并通过边界框损失与非极大值抑制找到最佳边界框。

以路况数据集[18](road traversing knowledge dataset,RTKD)为基础,将不同距离与角度下的降落平台沿轮廓手工分割出来,叠加到RTKD不同路况图片的随机位置上,生成新的数据集,如图8所示。

为了在机载硬件上取得较快的检测速度,选小尺度s架构模型,对上述新数据集进行训练,结果如图9所示,300轮训练后各损失函数均趋向稳定,精确率(真正例与真正例加假正例的和的比值)均趋于1,召回率(真正例与真正例加假负例的和的比值)也趋于1,训练结果好。

图7 YOLOv5-6.0网络结构

图9 训练结果

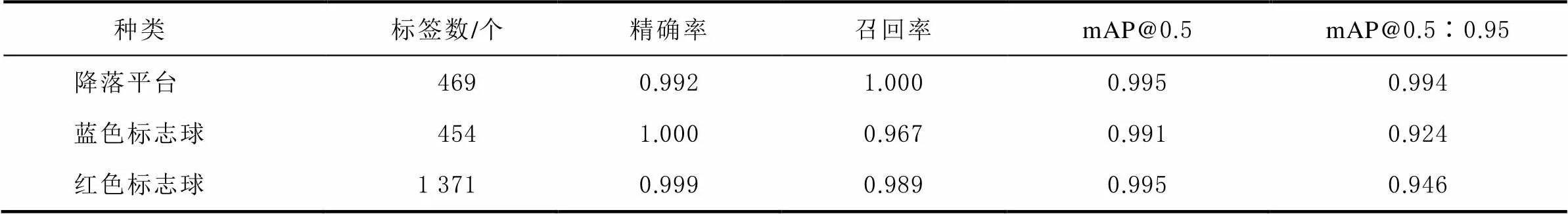

训练结果在469张图的测试集上测试,结果如表3所示,各类别精确率与召回率高,平均精度均值(mean average precision,mAP)高,测试集上表现好。

表3 测试集中模型的表现

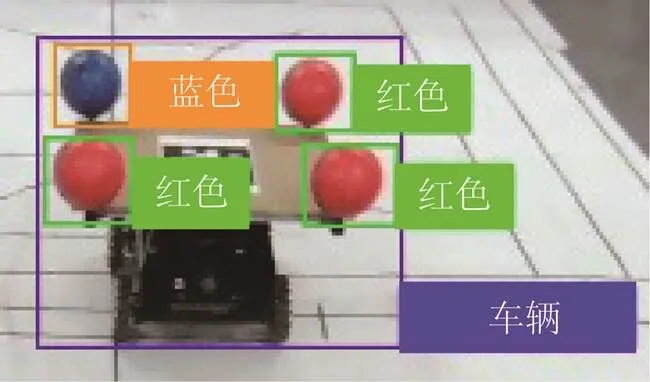

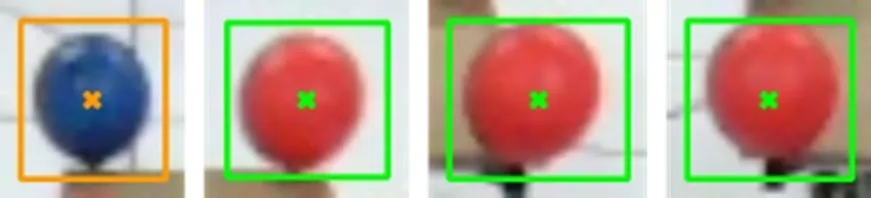

目标检测可得标志球边界框,如图10所示。受背景、光照及检测头中边界框损失及非极大值抑制算法影响,边界框中心常与标志球投影圆圆心存在偏差,如图11所示。由于PP算法对点和位置敏感,为提高PP算法解得的最优平移向量精度,本文增加精确圆心检测来提高圆心检测精度。

图10 单帧检测结果

图11 边界框中心

先将边界框作为兴趣域截出,其中大部分颜色为标志球颜色,对兴趣域进行均值偏移滤波,中和分布相近的颜色,将主体颜色与背景分开,如图12所示。

图12 均值偏移滤波结果

再通过阈值法提取相应颜色区域,并利用坎尼(Canny)算法获得此时边缘信息,如图13所示。

图13 标志球色域及其边缘信息

最后由霍夫梯度法拟合圆心,如图14所示。与边界框中心相比,白点为拟合圆心,×为边界框中心,此时的圆心更接近实际圆心,可提高PP解算精度。至此得到一阶段合作目标各球特征点球心在pix中的对应二维坐标。

图14 精确圆心与边界框中心对比

2.1.2 二阶段目标检测算法

本阶段检测的合作目标为AprilTag,由于已发展为视觉基准库,近距离检测精度优秀,故不再赘述文献[5]中的检测方法,其在检测出指定编号二维码的同时,也能获得4个角点投影在pix的二维坐标。

2.2 位姿解算方法

本节利用2.1节得到的特征点在pix中的二维坐标解算合作目标中心在b-i的三维坐标。

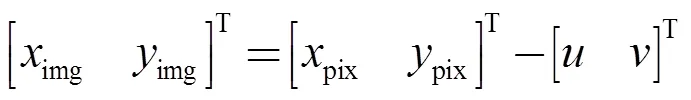

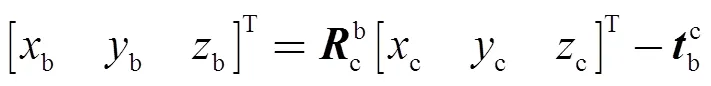

本文使用的一款微畸变镜头的单目相机,其成像可用小孔成像模型表示,pix到img的转换关系为

式中:(pixpix)为空间特征点在pix中的投影坐标;(imgimg)为点在img中的坐标;()为img在pix中的坐标。

由小孔成像的相似关系得img到c转换关系为

式中:为相机焦距;dd分别为像素点的物理宽与高;(c,c,c)为点在c中的坐标;为内参矩阵,反映相机物理结构。

相应有表征pad到c变换的外参矩阵,为

式中:为pad到c的旋转矩阵;为平移向量。

点在c中坐标为

式中pad为点在pad的坐标。

将合作目标中心固连至pad,pad在c中的坐标即为,求取即可得。

点在pad中的位置可通过测量得出,若检测出若干个特征点在pix中的投影点坐标,则的求取可转换为一个PP问题。文献[12]用高效PP(efficient perspective ofpoints,EPP)法[19]解算固定翼飞机的相对姿态,该算法复杂度为O(),速度很快,但实际使用中大倾角时重投影误差大,如图15所示,只用EPP解算效果不佳,通常须以此结果为初值进行迭代优化。本文使用最小化重投影法。

图15 EPnP法重投影误差

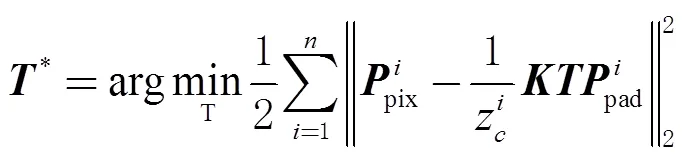

将式(3)改写为

式中:pix为(pixpix,1);pad为齐次向量(padpadpad1);pad取前三维以维持维度相等;上标为个特征点对各自的编号,本文中为4,即2.1节中每个阶段的4个特征点。

由于外参存在误差,定义各特征点的重投影为

式中为重投影误差。

为构建最小二乘为

式中*为外参矩阵的最优解。

根据旋转矩阵性质,属于特殊正交群SO(3),进而外参矩阵属于特殊欧式群SE(3),引入李代数将式(8)转化为无约束优化问题为

式中为李代数。李群可由的指数映射得到。

式(9)可由列文伯格-马夸尔特法(Levenberg-Marquardt,L-M)[20]解出最优外参矩阵,步骤如下。

为简化表述,以下以()代指原非线性优化函数。以EPP[17]的解作为初值0,构造第次迭代时x处的拉格朗日函数为

式中:(x)为()在x处的一阶导数;Δx为增量;为拉格朗日乘子;为信赖域半径;为系数矩阵,可令为单位阵。

对式(10)求导,并令导数为0,有

式中(x)为()在x处的二阶导数。

解式(11)的增量方程,定义信赖域指标

当ρ>0.75,μ增大一倍,ρ<0.25,μ缩小一倍;ρ为正则将Δxk加至xk,ρ为负则不叠加增量。然后进行k+1次迭代,直到Δxk小于阈值后结束迭代,认为此时的xk即为最优解。由此得到最优外参矩阵T*,进而有合作目标中心在Cc中最优平移向量t*,即Opad在Cc中的最优坐标。此时重投影误差如图16所示,对比图15,误差大幅减小。

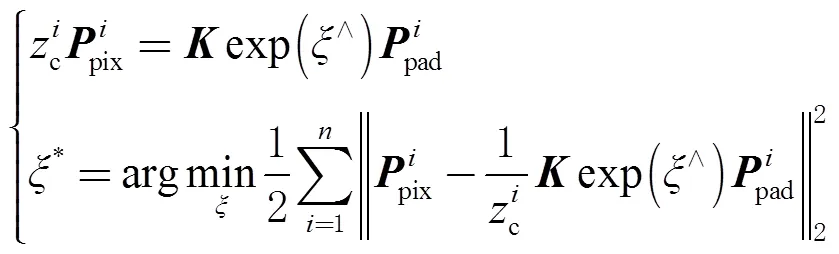

c到b的旋转矩阵cb为

式中:(bbb)为c在b中的姿态角(云台舵机角度);S表示sin,C表示cos。

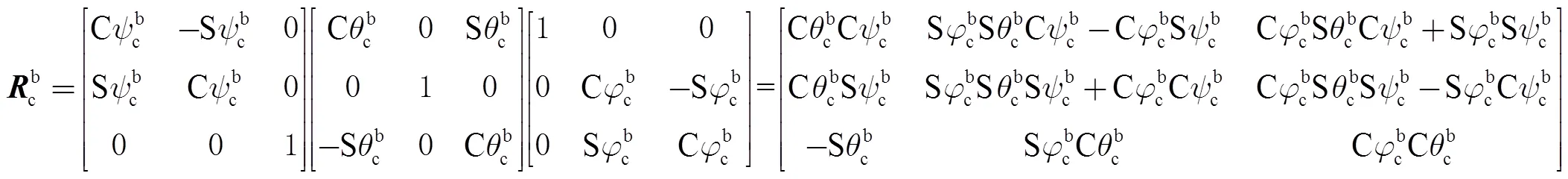

c到b转换关系为

式中:(bbb)为点在b中的位置;bc为c在b中的位置,若保证c处于相机云台的转动轴轴线上,则bc可通过测量得到。

b到b-i的旋转矩阵bb-i为

b和b-i为同一空间点,b到b-i的转换关系为

式中b-i(b-ib-ib-i)为pad(合作目标中心)在b-i中的位置。

w仅作参考坐标系,为b-i提供坐标轴参考方向,以及实验中记录全局位置数据,为适应全局定位系统拒止的场景,实际仅解算无人机在pad的位置(是b-i的逆向反映),不涉及w与其他坐标系转换。

3 无人机追踪与降落控制律

如图17所示,引入pad中平面内的位置环比例微分积分(proportion integration differentiation,PID)控制,目标位置为pad,控制无人机轴速度,引导其追踪接近降落平台。

图17 控制律

当平面无人机到合作目标的相对距离小于0.2 m时开始匀速降落,直至pad中无人机相对高度小于0.01 m,即认为完成降落,电机停转上锁。

4 实验与结果分析

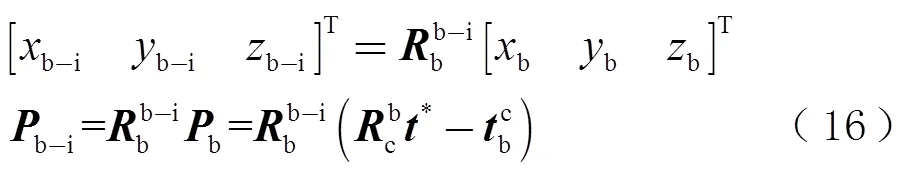

本文所用得硬件平台构成如表4所示,实物如图18所示。

表4 硬件平台构成

图18 硬件平台

4.1 一阶段三维合作目标

4.1.1 目标检测耗时与成功率

在机载电脑上对图2的测试视频(采集于模型训练完成后)进行实验,共1000帧,如图19所示,图19(a)中纵坐标o表示目标检测的用时。预处理加后处理平均帧率达39。

图19 目标检测实验

有若干次红球漏检,是因为此时降落平台到达相机视场边界,前方标志球部分超出视野,故在该模型对视野范围内每帧的动态目标均能成功检测。

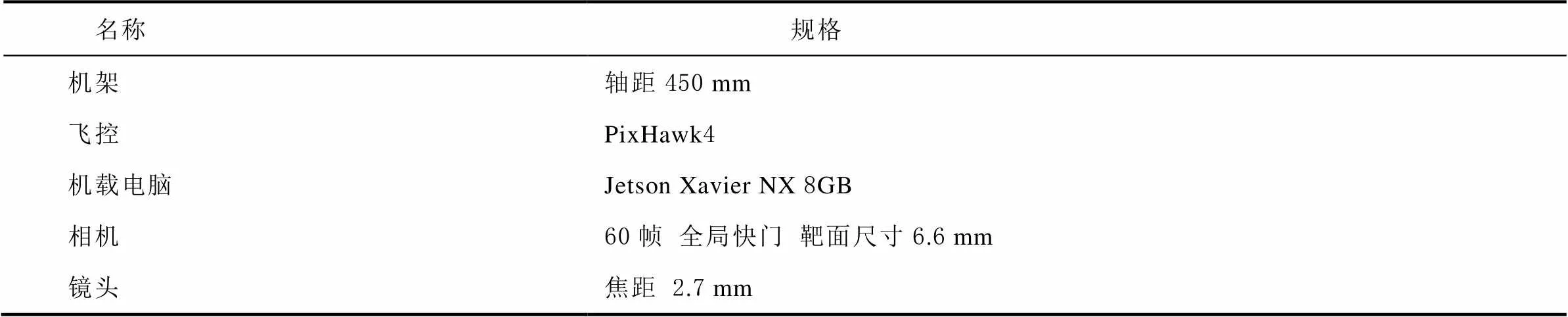

4.1.2 边界框中心与精确圆心定位效果对比

沿用图2(a)的测试条件,令降落平台在3 m外循椭圆轨迹线运动,采集测试视频,分别进行边界框中心法定位与增加精确圆心检测后的定位,如图20所示。用边界框中心进行定位时,端点附近(取|| > 225 cm)定位MAE为3.62 cm;检测精确圆心后定位误差降低,MAE为1.41 cm,降低了256%。增加精确圆心检测后可有效提高远距离定位精度。

图20 边界框中心法与增加精确圆心法的定位效果

4.1.3 一阶段三维球定位拉距实验与精度实验

沿用图2的测试条件与视频,做2.37~7 m的拉距与精度实验,以0.5 m为分度,在每个分度处录制视频进行检测与定位,结果如图21所示。对比图2(c),三维球定位法在二维码检测定位失效的距离上仍可检测合作目标并进行有效定位,1.5 m高度定位距离是二维码法的2.54倍。

图21 一阶段定位拉距实验

图21中,各分度处MAE如表5所示。可见,本文一阶段定位法的定位误差在适用距离内随距离增加而增大,但平均误差为0.05 m,足以满足精确定位并追踪的需求。

表5 各距离定位误差 cm

4.2 二阶段二维码

4.2.1 二阶段检测耗时

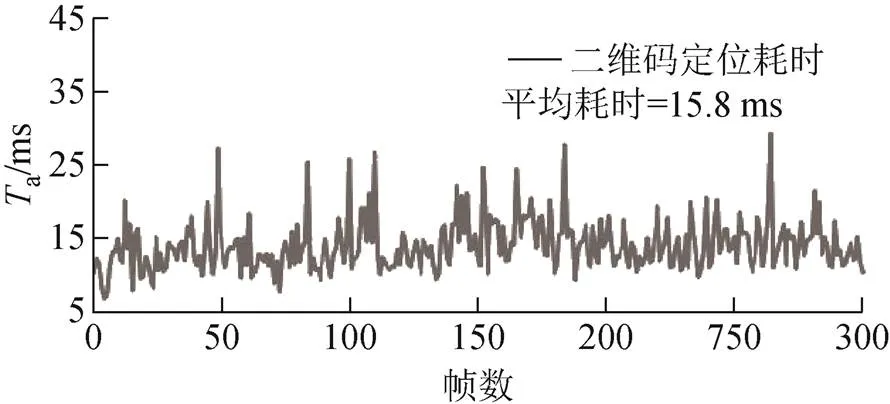

沿用图2对应的测试视频,取前300帧进行检测,如图22所示,图中纵坐标a表示二维码检测及定位的用时。在机载电脑上检测二维码并解算位姿得到定位信息的平均帧率达63,可为末端降落提供超实时的位姿,满足动态降落的需求。

图22 二维码定位耗时

4.2.2 二阶段落点精度实验

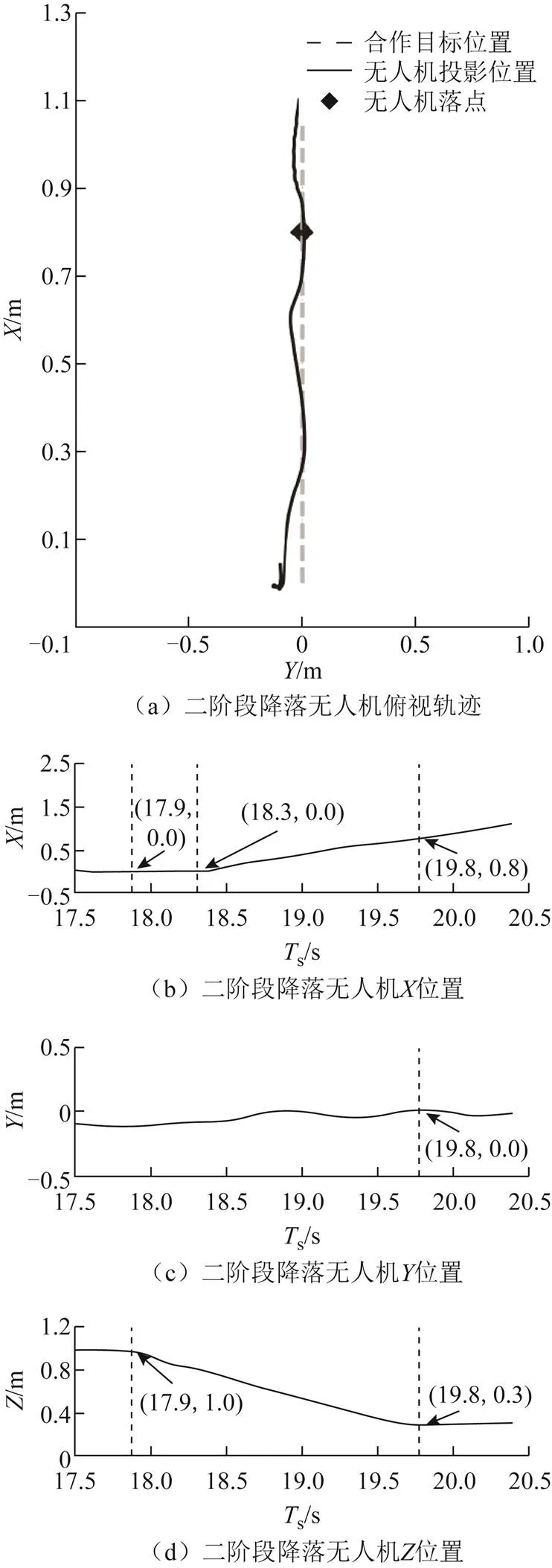

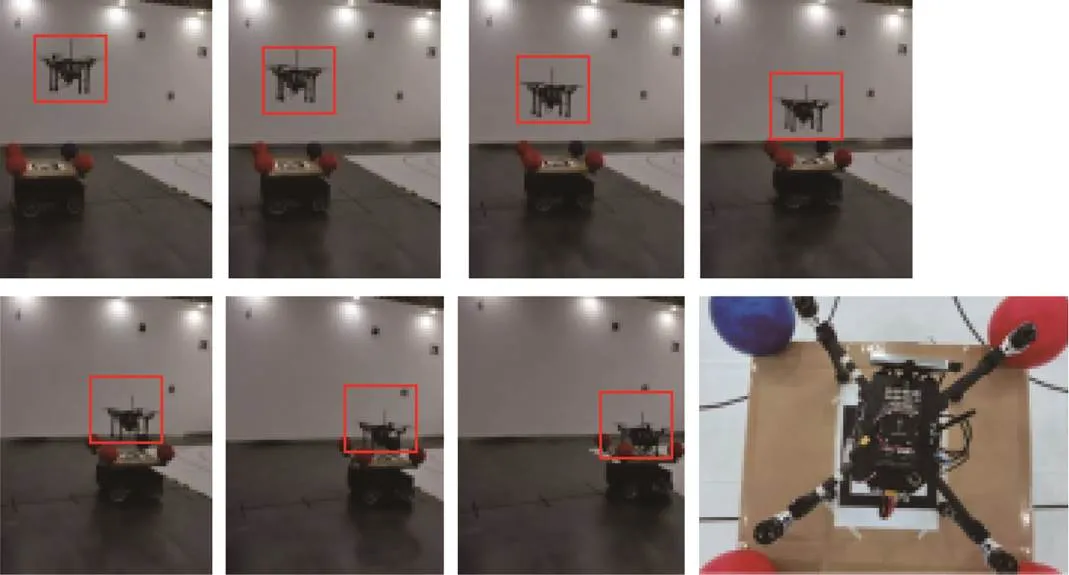

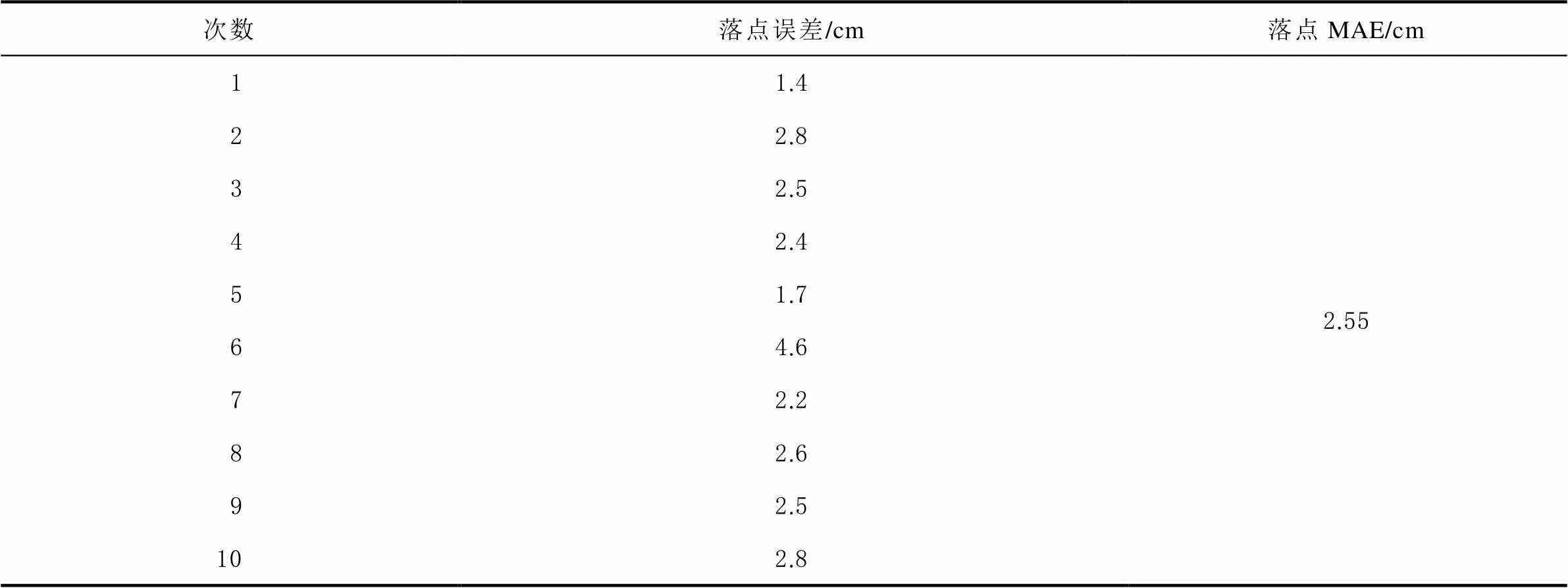

无人机1 m高度悬停,接到降落指令后按第3节的控制算法进行降落,机载T265视觉定位模块记录Cw中无人机位置如图23所示,图中s表示过程时间。过程如图24所示。据图23中与的位置,17.9 s时从1 m高处降落,18.3 s时降落平台前进,19.8 s起高度不再降低而增加,即降落至平台上由平台搭载前进,故无人机在1.9 s内降落到直线速度0.53 m/s的移动平台上,记录此时机体中心在降落平台的投影点为落点位置。在此基础上进行10次重复实验落点误差如表6所示,平均误差为2.55 cm,落点精度很高。

图23 二阶段降落实验数据

图24 二阶段降落实验过程

表6 降落位置误差表

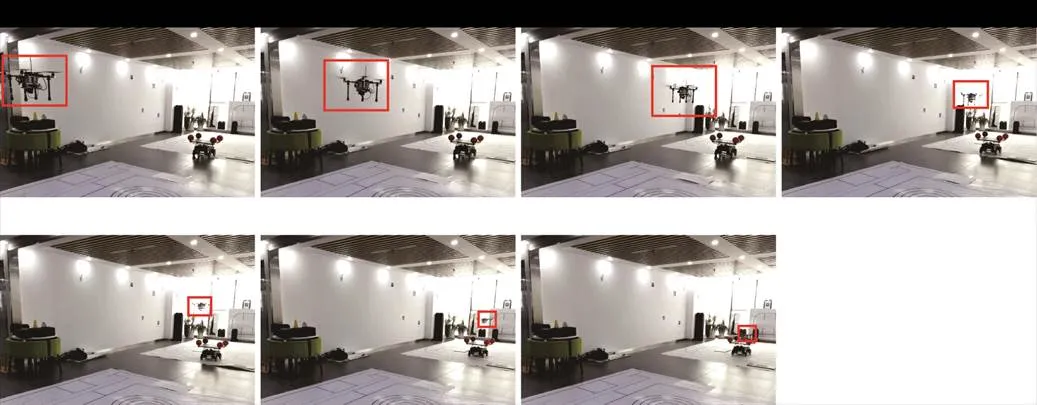

4.3 2个阶段联合实验

最后引入一阶段远距离追踪进行联合实验:将降落平台超前无人机7 m,引入一阶段远距离追踪;无人机起飞至1.5 m高度时开始追踪,然后控制降落平台前进,最终无人机在动平台上降落。无人机在Cw中的位置数据如图25所示,过程如图26所示。据图25的数据,17.1 s时无人机开始追踪降落平台,以1.4 m/s快速逼近,至22.6 s时到平台上方,减速并随平台前进,同时开始降落,26.1 s时完成降落(受T265远距离定位精度影响,在较远距离处高度与真实值有偏差)。

图26 2个阶段联合实验过程

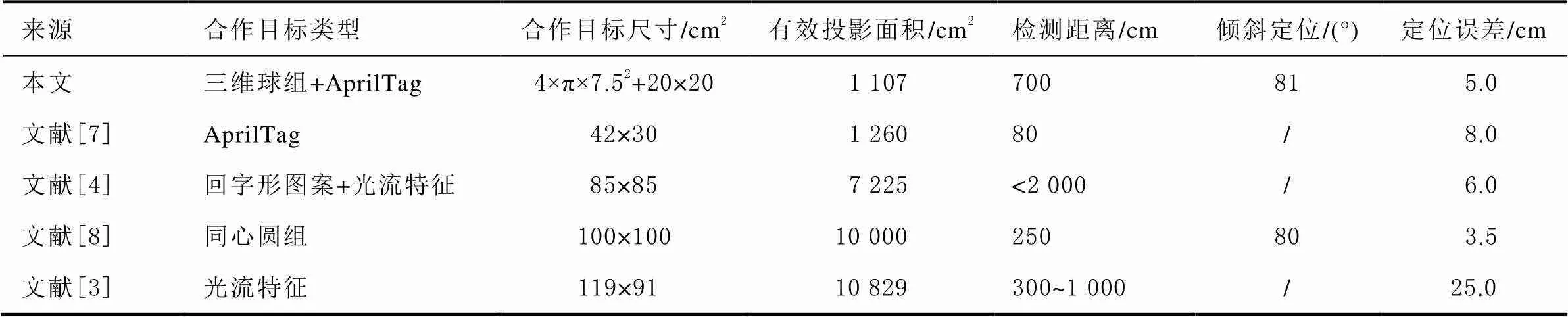

4.4 性能比较

在合作目标相关指标上与现有研究进行比较,结果如表7所示。

表7 合作目标指标对比

本文合作目标尺寸最小,精度第二,检测距离居中,在可倾斜定位的方案中检测距离最远,在相应指标上取得了很好的均衡;且本文速度控制律下无人机落点误差仅0.03 m。该方案可部署至小型化机场,为无人机提供远/近距离超实时、高精度的定位信息以自主降落,作为伴随电站提高其自持性。

5 结束语

针对现有研究合作目标尺寸过大的问题,本文设计了一种新型合作目标,在普遍使用二维合作目标的无人机自动降落领域引入三维合作目标,利用三维物体在二维平面的投影可保留更多特征信息的原理,使用小尺寸合作目标即可获得大尺寸合作目标的定位精度,且引入三维合作目标也解决了水平距离增加、合作目标与相机相对倾斜加剧后无法检测合作目标的问题,并用深度学习+手工特征的方式提高了复杂环境中的球体目标检测成功率与特征点精度,用非线性优化提升了位姿解算精度;在保证定位精度的同时降低了投影面积,并极大地提升相同高度下的水平检测范围,在合作目标主要指标上取得了较好的均衡。有望与当前商品级无人机机场结合,拓展应用场景。后续可进一步在本文提出的合作目标三维化的思路上优化设计,选用更优的三维结构,提高远距离大倾斜状况的定位精度,并进一步降低合作目标的尺寸。

[1] 沈林成, 孔维玮, 牛轶峰. 无人机自主降落地基/舰基引导方法综述[J]. 北京航空航天大学学报, 2021, 47(2): 187-196.

[2] YANG Tao, REN Qiang, ZHANG Fangbing, et al. Hybrid camera array-based uav auto-landing on moving ugv in gps-denied environment[J]. Remote Sensing, 2018, 10(11): 1829.

[3] MONDRAGÓN I F, CAMPOY P, C MARTÍNEZ, et al. 3D pose estimation based on planar object tracking for UAVs control[C]// The Institute of Electrical and Electronic Engineers (IEEE). International Conference on Robotics and Automation (ICRA). Anchorage, Alaska, USA: IEEE, 2010: 35-41[2023-03-30].

[4] YUAN Haiwen, XIAO Changshi, XIU Supu, et al. A hierarchical vision-based UAV localization for an open landing[J]. Electronics, 2018, 7(5): 68.

[5] OLSON E. AprilTag: A robust and flexible visual fiducial system[C]// The Institute of Electrical and Electronic Engineers (IEEE). International Conference on Robotics and Automation (ICRA). Shanghai, China: IEEE, 2011: 3400-3407[2023-03-30].

[6] GARRIDO-JURADO S, MUÑOZ-SALINAS R, MADRID-CUEVAS F J, et al. Automatic generation and detection of highly reliable fiducial markers under occlusion[J]. Pattern Recognition, 2014, 47(6): 2280-2292.

[7] ARAAR O, AOUF N, VITANOV I. Vision based autonomous landing of multirotor UAV on moving platform[J]. Journal of Intelligent & Robotic Systems, 2017, 85(2): 369-384.

[8] 陶孟卫, 姚宇威, 元海文, 等. 无人机自主降落视觉标识设计及位姿测量方法[J]. 仪器仪表学报, 2022, 43(5): 155-164.

[9] 汲振, 李建胜, 王安成, 等. 一种无人机辅助降落合作标志与匹配算法[J]. 导航定位学报, 2022, 10(5): 68-73.

[10] 王辉, 贾自凯, 金忍, 等. 无人机视觉引导对接过程中的协同目标检测[J]. 航空学报, 2022, 43(1): 488-502.

[11] CHEN Junjie, MIAO Xiren, JIANG Hao, et al. Identification of autonomous landing sign for unmanned aerial vehicle based on faster regions with convolutional neural network[C]// Chinese Automation Congress (CAC). Jinan, China: IEEE, 2017: 2109-2114[2023-03-30].

[12] 齐乐, 袁宝玺, 郭凤娟, 等. 固定翼无人机着陆姿态角测量算法研究[J]. 导航定位学报, 2022, 10(4): 56-64.

[13] TRUONG N Q, LEE Y W, OWAIS M, et al. SlimDeblurGAN-Based motion deblurring and marker detection for autonomous drone landing[J]. Sensors, 2020, 20(14): 3918.

[14] KUPYN O, MARTYNIUK T, WU J, et al. Deblurgan-v2: Deblurring (orders-of-magnitude) faster and better[C]// International Conference on Computer Vision (ICCV). Seoul, Korea: IEEE/CVF, 2019: 8878-8887[2023-03-30].

[15] 刘冠楠, 于洋, 张江涛, 等. 针对无人机降落过程的复合地标设计方法[J]. 信息技术与信息化, 2022(10): 64-67.

[16] 杨智贵, 张彦, 田朋云. 一种基于视觉的无人机自主着陆位姿估计方法研究[J]. 现代计算机, 2019(14): 19-22.

[17] 刘彦清. 基于YOLO系列的目标检测改进算法[D]. 吉林: 吉林大学, 2021.

[18] RATEKE T, JUSTEN K A, VON WANGENHEIM A. Road surface classification with images captured from low-cost camera-road traversing knowledge (rtk) dataset[J]. Revista de Informática Teórica e Aplicada, 2019, 26(3): 50-64.

[19] LEPETIT V, MORENO-NOGUER F, FUA P. EPnP: An accurate O(n) solution to the PnP problem[J]. International Journal of Computer Vision, 2009, 81(2): 155-166.

[20] LOURAKIS M I A. A brief description of the Levenberg-Marquardt algorithm implemented by levmar[J]. Foundation of Research and Technology, 2005, 4(1): 1-6.

Tracking and landing of vision-based unmanned aerial vehicles on moving vehicle

WAN Hua1, WANG Ziyi1, LI Sheng1, ZHANG Zhi’an2

(1. School of Automation, Nanjing University of Science and Technology, Nanjing 210094, China;2. School of Mechanical Engineering, Nanjing University of Science and Technology, Nanjing 210094, China)

Aiming at the problem that the size of the cooperative target is often too large in the current schemes of the long-range purely visual-guided drone landing of unmanned aerial vehicles (UAV), the paper proposed a design thought of cooperative targets composed of three-dimensional (3D) and two-dimensional (2D) logos: 3D signs were detected through deep learning and manual features for long-distance positioning and tracking, and it was switched to detect 2D signs for landing on the target autonomously after approaching; by introducing the 3D cooperative targets, the detection distance at 1.5 m height was increased by 2.54 times, detecting tilt targets at a large angle was carried out, and the target size was significantly reduced, without decreasing the positioning accuracy. Experimental result showed that the average long-range positioning error would be 0.05 m, and the average landing error on a moving platform in the short range would be 0.03 m, indicating that the small-size cooperative target could have high visual positioning accuracy and landing accuracy, thus making it possible to track and land on the moving ultra small-sized platforms accurately.

unmanned aerial vehicle (UAV); cooperative target; visual; tracking; landing

万铧, 王梓屹, 李胜, 等. 无人机基于视觉引导的移动平台追踪与降落[J]. 导航定位学报, 2023, 11(6): 129-141.(WAN Hua, WANG Ziyi, LI Sheng, et al. Tracking and landing of vision-based unmanned aerial vehicles on moving vehicle[J]. Journal of Navigation and Positioning, 2023, 11(6): 129-141.)DOI:10.16547/j.cnki.10-1096.20230616.

P228

A

2095-4999(2023)06-0129-13

2023-03-14

万铧(1997—),男,江苏常州人,硕士研究生,研究方向为视觉导航、无人机控制。

李胜(1976—),男,江苏徐州人,硕士生导师,副教授,研究方向为非线性系统控制、机器人控制等。