基于无人机的火灾检测系统设计与实现

2022-05-24董力文

李 宁,刘 青,熊 俊,董力文

(国网北京市电力公司电缆分公司,北京,100010)

0 引言

森林、草原、野坡是大自然最好的“调剂师”,因其可促进自然界的碳、水循环,具有维护生态系统平衡和改善生态环境的功能,越来越受到人们的重视。我国虽然土地辽阔,但是存储的森林、草原、野坡资源占比却很小,如人均森林面积不足世界平均水平的四分之一[1,2]。火灾的破坏力极强,不但会烧毁大片的树木,造成物种的灭亡,还会引起水土流失,威胁人民的生命财产安全[3]。因此关于火灾的巡检技术受到了越来越多的学者和相关部门的关注。尽早发现火情,并精准掌握火灾环境态势,指挥中心便可以采取有效的扑救措施进行火灾控制与扑灭。

目前人工巡检与观测塔的方式是国内最常见的火灾监测手段,该方法存在周期长、效率低、工作量大的缺点。此外通过卫星监测的方式,虽然可以大范围监测火灾,但其存在实时性差、分辨率低等缺点。随着航空技术的发展,有人驾驶飞机巡检监测和无人机巡检监测成为较为有效的火灾监测手段,具有效率高、成本低、实时性强的优势[4-6]。

本文通过无人机系统与基于视频图像的计算机视觉技术结合,设计了一套智能森林火灾巡检系统,实现了在无人参与的情况下,无人机可自动起飞并按预设轨迹飞行。当检测到火灾后,无人机可自动抵近侦察并沿火线边缘飞行,进一步采集森林火灾现场更多的信息。针对常用的基于图像的检测算法难以同时满足超大目标和小目标同步检测的问题,本文提出了一种improved-YOLOv3的火灾检测算法,实时处理无人机平台采集的图像,有效地提高了火灾检测的实时性和准确性。

1 系统方案

1.1 系统组成

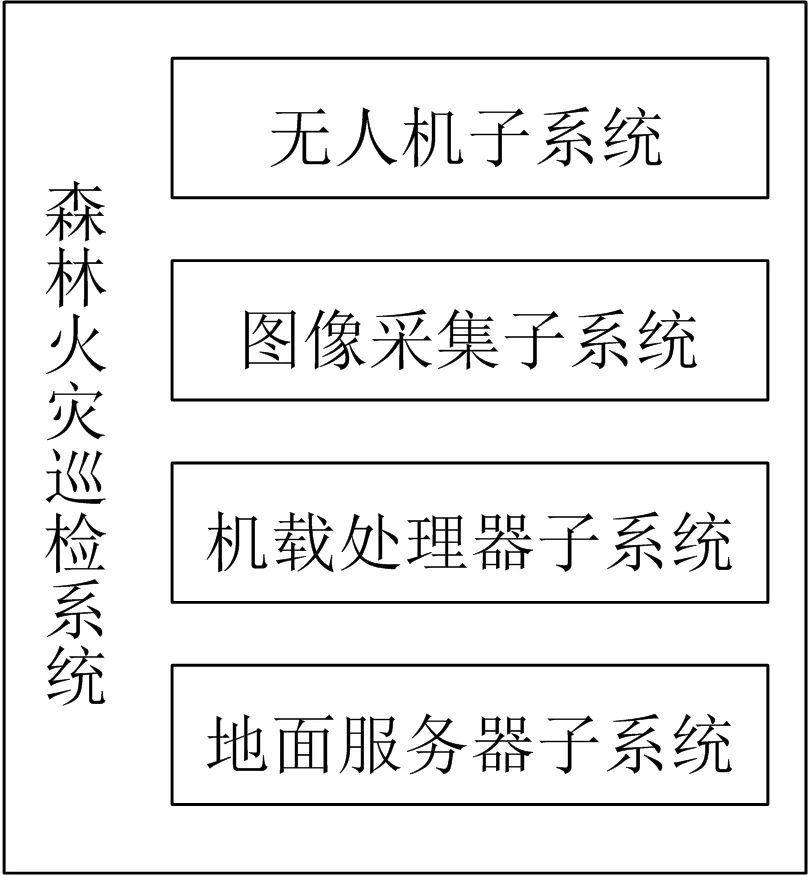

本文针对当前存在的问题,设计了一套基于无人机的火灾巡检系统。通过无人机搭载图像采集设备,将巡检图像实时传回地面服务器,通过基于深度学习算法的智能识别,判断是否有火灾发生。当检测到火灾发生时,无人机可根据机载端火线提取算法,自动沿火线边缘飞行。本系统实现了森林火灾的智能识别、区域定位和态势感知功能,可有效、实时、全天候自动监测火灾并具有作业效率高、运营成本低等优势。本森林火灾巡检系统分为:无人机子系统、图像采集子系统、机载处理器子系统、地面服务器子系统,系统组成如图1所示。

图1 森林火灾巡检系统组成Fig. 1 Composition of forest fire inspection system

无人机子系统为飞行平台的载体,通过其自身装载的传感器如GPS、IMU和气压计等,利用多传感器融合技术,解算出无人机的位置及姿态信息,为其自身控制及火灾位置提取提供多维度的信息源。无人机通过串级PID控制算法,进行姿态、速度、位置自动控制。根据本文载重、航时、抗风等性能要求,采用六轴多旋翼无人机为飞行载体,载重量3 kg,航时为45 min。

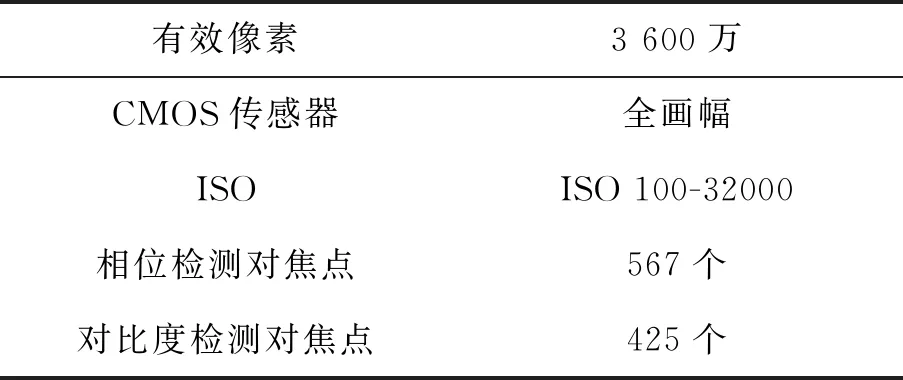

图像采集系统主要由云台、图传、可见光相机三个设备构成。云台起到了消除无人机高频抖动、使画面稳定的功能。在无人机飞行时会出现一定的角度倾斜,云台也能起到抵消角度倾斜的作用。图传为图像无线传输设备,将机载端采集的图像传输到地面服务器。本文采用瑞沃UT1900-S型号的图数一体化设备,通过其中数传模块可将地面服务器的命令指令发送至无人机端。可见光相机采用索尼A7R,其主要性能参数如表1所示。

表1 索尼A7R主要参数表

地面服务器系统通过地面端图传模块接收相机的图像信号,通过深度学习算法对视频信号进行森林火灾的智能检测,当检测到发生火灾情况时,发出报警信号,并向无人机发送抵近侦查指令。

机载处理器主要完成抵近侦察功能的无人机控制指令计算。机载处理器同样接收相机视频信号,当需要抵近侦察时,通过图像火灾像素位置、无人机位置、云台姿态,进行火灾位置的初步计算。无人机将按照此位置进行火灾搜索,实现抵近侦察森林火灾情况功能。

1.2 系统原理

针对规划的待巡检森林区域,无人机设备规划好固定的巡检航线,以其自身的自动航线飞行功能,无人机搭载云台、相机及其他设备,即可开展巡检工作。固定巡检航线以蛇形航线为主,吊舱以正射模式工作。自动飞行过程中,相机可将图像信号通过图传传输至地面服务器,进行本帧图像内森林是否发生火灾的智能判断。

当地面服务器发现有火灾发生后,发出报警信号,并向无人机发送抵近侦察指令。无人机接收到此指令后,启动配备智能识别算法的机载处理器,执行自动抵近侦察工作。相机的视频信号一路接至机载处理器中,识别发生火灾的像素位置,如果火灾边缘全在当前画幅中,则控制无人机自动飞行到火灾中心点上方,随后根据火灾区域占画幅比,控制无人机高度降低,至画幅比满足要求。其中自动飞行原理如下,根据火灾中心点的像素位置,将该像素位置与图像中心点像素位置偏差输入PID控制器,转化为无人机地理坐标系下的控制量,控制无人机移动,从而改变火灾中心点位置,形成闭环负反馈。其控制框图如图2所示。

图2 控制策略框图Fig. 2 Control strategy block diagram

如果检测到火灾发生时,火灾边缘不全在画幅中,即着火面积比较大,此时需调整无人机航向,至火灾边缘某点与图像上边缘中心点像素重合,再控制无人机向前飞行,至图像中心点出现火灾边缘点。通过机载处理器实时检测火灾边缘,实现沿大面积着火区域的边缘飞行,实现大面积火场的态势感知。

2 improved-YOLOv3模型

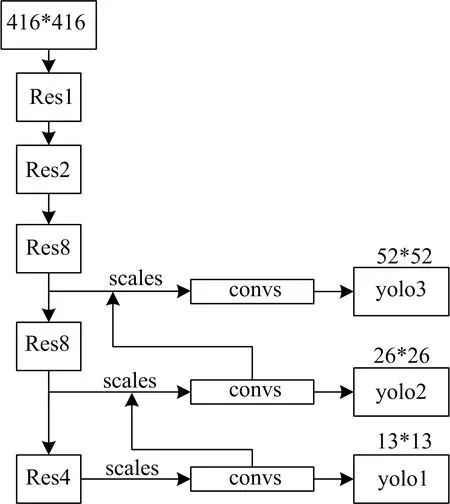

2.1 YOLOv3原生态网络

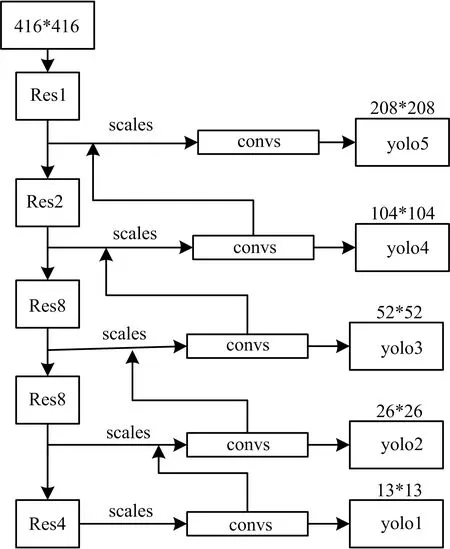

YOLOv3网络可以分为两部分,如图3所示。一是特征提取网络,该部分提取输入图像的特征,其基础网络是darknet-53,使用了53个卷积层,作为YOLOv3特征提取的主要网络结构,该结构使用一系列的3*3和1*1大小的卷积层,与残差层res相结合,具有较好的特征提取能力。图中resn中n代表数字,表示此res_block含有n个res_unit。res_unit为两个DBL模块串联后与输入相加组成的残差结构。二是目标定位与预测网络,即yolo层部分,YOLOv3的特征交互层分为了三个尺度,在每个尺度内通过卷积核的方式实现局部的特征交互[7-9]。三个yolo层的分析如下:

第一个yolo层:输入为13*13的特征图,一共有1024个通道,经过一系列的卷积操作后,输出75个通道的13*13的特征图,用于分类和位置回归。

第二个yolo层:输入为512通道的13*13的特征图,输出256个通道13*13的特征图,然后上采样生成256通道的26*26大小的特征图,同时与61层的26*26的中尺度特征图进行融合,再经过一系列的卷积操作,生成75通道的26*26大小的特征图,用于分类和位置回归。

第三个yolo层:将256个通道的26*26大小的特征图进行卷积操作,生成128通道的26*26的特征图,然后上采样生成128通道的52*52大小的特征图,同时与36层的52*52的特征图进行融合,再进行一系列的卷积操作,得到75个通道的52*52大小的特征图,用于分类和位置回归。

在特征交互阶段,以416*416大小的图像为例,用于分类和位置回归的特征图尺寸分别为13、26、52,感受野偏小,影响大目标的检测能力。本文的研究对象初期火焰较小,占比小,属于小目标检测范畴;随着烟雾弥漫整个图像画面,属于超大目标检测范畴。因此需要针对yolo层进行改进,使其能同时兼顾小目标与超大目标的检测。

图3 原YOLOv3网络结构图Fig. 3 Original YOLOv3 network structure diagram

2.2 improved-YOLOv3 网络结构

通过以上网络结构的解析及实际测试,YOLOv3对过大的目标存在检测能力不足的情况。如本项目中的烟雾,在原生态网络中烟雾的漏检率达到43%,因此需要从网络结构上进行改进,提高模型的检测能力。

在特征交互阶段,416*416大小的图像用于分类和位置回归的特征图尺寸分别为13、26、52、104、208,增加了与第4层和第11层的大尺度特征融合,感受野范围增大。另外原YOLOv3使用k-means生成9种anchor,改进后的网络(因改进后网络有5个yolo层,故下文中称为:YOLOv3-5)使用15种anchor,每三种对应一个yolo层,提高了目标的检测能力。改进的网络片段如图4所示,具体改进描述如下:

第一个yolo层:输入为13*13的特征图,一共有1024个通道,经过一系列的卷积操作,输出75个通道的13*13特征图,用于分类和位置回归。

第二个yolo层:输入为79层的512通道的13*13的特征图,输出256个通道的13*13特征图,然后上采样生成256通道的26*26大小的特征图,同时与61层的26*26的中尺度特征图进行融合,再经过一系列的卷积操作,生成75通道的26*26大小的特征图,用于分类和位置回归。

第三个yolo层:将91层的256个通道的26*26大小的特征图进行卷积操作,生成128通道的26*26的特征图,然后上采样生成128通道的52*52大小的特征图,同时与36层的52*52的特征图进行融合,再进行一系列的卷积操作,得到75个通道的52*52大小的特征图,用于分类和位置回归。

第四个yolo层:将103层的128个通道的52*52大小的特征图进行卷积操作,生成128通道的52*52的特征图,然后上采样生成128通道的104*104大小的特征图,同时与11层的104*104的特征图进行融合,再进行一系列的卷积操作,得到75个通道的104*104大小的特征图,用于分类和位置回归。

第五个yolo层:将115层的64个通道的104*104大小的特征图进行卷积操作,生成128通道的104*104的特征图,然后上采样生成128通道的208*208大小的特征图,同时与4层的208*208的大尺度特征图进行融合,再进行一系列的卷积操作,得到75个通道的208*208大小的特征图,用于分类和位置回归。

图4 improved-YOLOv3网络结构图Fig. 4 Improved YOLOv3 network structure diagram

3 实验及模型性能评价

3.1 数据集

(1)数据集基本情况

本数据集来自UAV采集的3 800张火场图像,主要包含以下场景:森林火场、草原火场、山火、道路车辆起火、郊区建筑物起火等。火灾状态囊括了大火、小火、零星火、薄烟、浓烟等。

(2)数据集标注

由于火焰本身形状不规则,边缘细节不够明显,通过航拍得到的火焰图像较难进行图像分割标注。因此,采用labelimage软件标注成voc格式的目标识别数据集,记录火焰的位置坐标等信息。即:将数据集分为JPEGImages和Annotations两部分,其中JPEGImages文件夹中存放图像数据,Annotations文件夹中存放每个图像对应的xml格式的label信息。标注时将烟雾和火焰分开标注,分为:fire和smoke两类。

(3)数据集增广

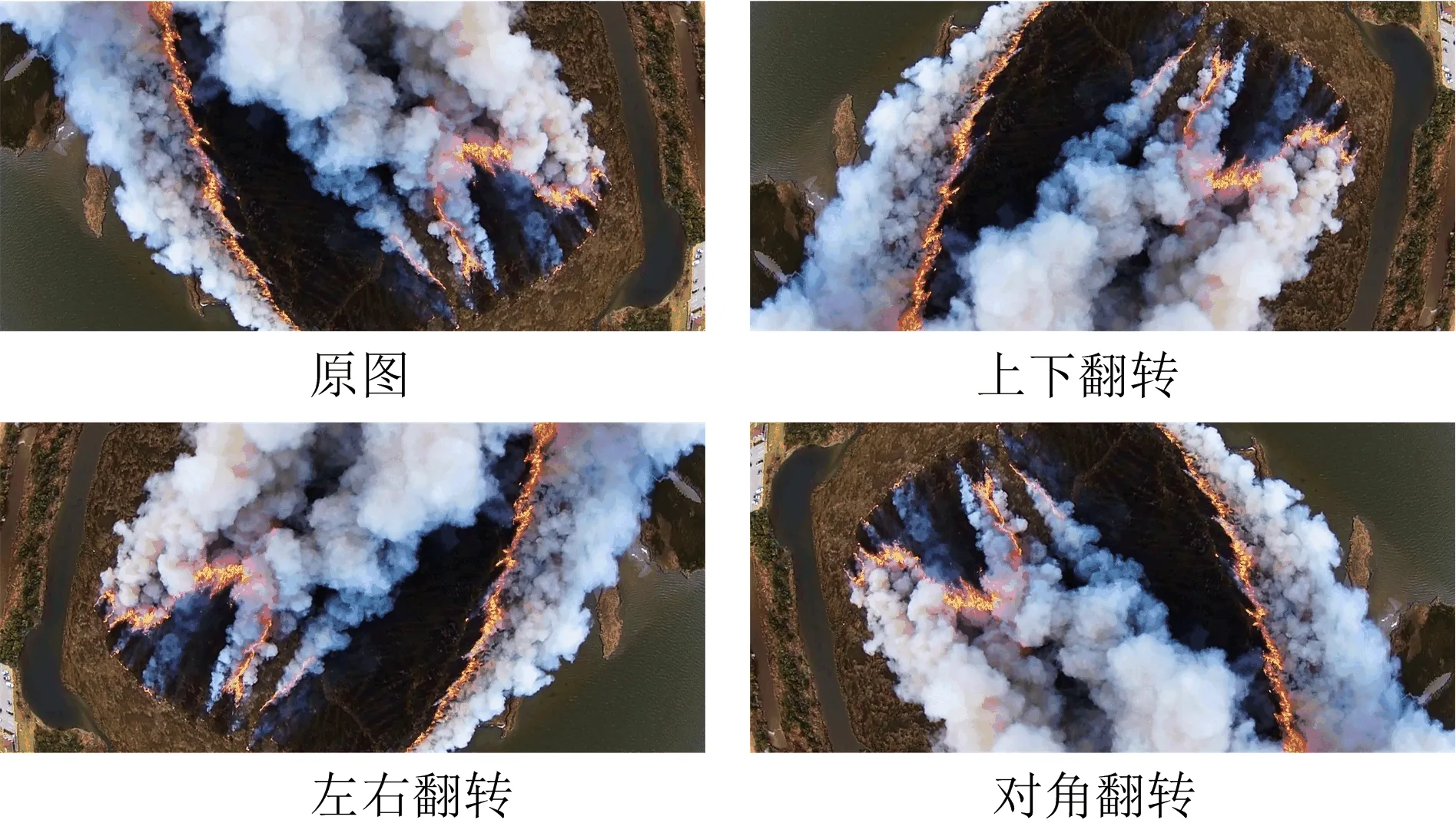

①翻转增广

由于本项目中采用俯视的方式进行图像采集,可以通过图像翻转模拟得到无人机从不同的方向飞行采集的图像,在此选择图像翻转来得到无人机从不同方向飞来时的图像,从而达到数据增广的目的。

图5 翻转效果示例Fig. 5 Flip effect example

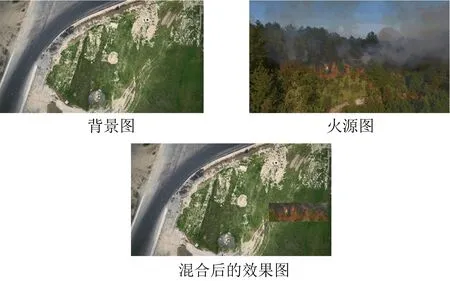

② 混合增广

由于采集的图像场景有限,为了丰富场景,采用混合背景的方法对图像进行增广,即随机选择一张图像做背景,在有火焰的图像上将火焰抠出,然后通过图像融合技术将火焰与背景图像进行融合,得到新场景的火灾图像。

图6 混合增广示例Fig. 6 Hybrid augmentation example

3.2 网络训练与推理加速

(1)重新聚类anchor

改进后的网络需要15种anchors ,比原生态网络多了6种anchors,因此通过K-means方法在本文数据集上聚类出15种anchors,分别为(22,32)、(39,63)、(93,74)、(58,121)、(134,127)、(101,224)、(252,129)、(192,222)、(135,405)、(250,325)、(431,202)、(381,361)、(285,551)、(269,375)、(492,554)。

(2)学习率调整

在网络训练过程中采用了不同阶段适配不同的学习率机制,网络一共训练了40 000次,分别在20 000、30 000、35 000次时进行学习率调整,共调整三次。初始学习率为10-3,前两次每次调整为当前学习率的十分之一,最后一次调整为当前学习率的五分之一。

(3)前向推理阶段,合并BN层到卷积层

为了提升模型前向推理的速度,将BN(Batch Normalization)层的参数合并到了卷积层中。BN层的加入,加速了网络的收敛并且能够有效地控制过拟合,在训练过程中起到了积极作用。但是其增加了运算量,占用了更多的内存或显存空间,因此将其与卷积层合并,达到提升前向推断速度的效果。

3.3 性能测试及评价

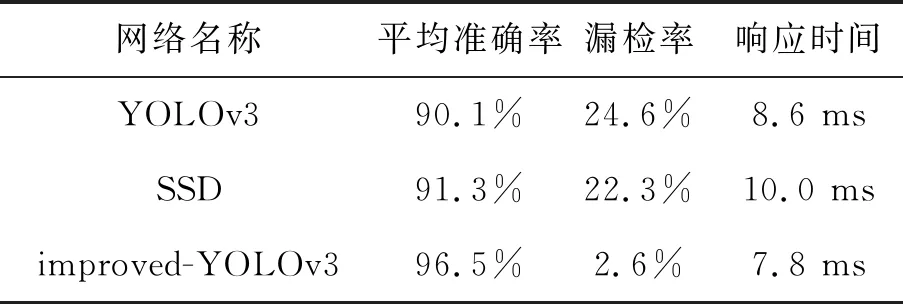

为测试本文提出的improved-YOLOv3网络的性能,采用对比测试的方式进行评估。对比的网络有:原生态YOLOv3、SSD原生态网络。分别对烟雾、火焰的识别准确率和推理速度进行了测试。实验过程中:数据集、迭代次数、数据预处理方式严格保持一致,输入网络的图像大小统一为608*608,分别训练得到最优模型。最后将相同的测试集分别输入到不同的模型中进行推理测试,对推理结果进行统计比较,比较结果如表4所示。经压缩优化处理后的模型大小为9.9 K。

由表4可以看出,本文所提出的improved-YOLOv3网络模型的平均准确率达到了96.5%,均高于原生态的YOLOv3和SSD网络模型,漏检率较于其他两种算法也有明显降低,达到了2.6%。在响应时间上由于添加了网络层的合并操作,时间消耗并没有因为增加了yolo层而增加,反而略有下降,响应时间为7.8 ms。

表2 测试结果统计表

3.4 实际应用测试

为了验证提出的improved-YOLOv3算法的实际性能,在模拟场地的模拟火场中开展无人机火情图像采集,然后利用本文算法进行实时识别,图7给出了部分检测结果。

图7 火灾现场检测效果图Fig. 7 Effect drawing of fire site detection

从现场检测效果图中可以看出,本文所提出的算法既能检测出大面积的烟雾,也能同步对零星的小火焰进行识别,兼顾了超大目标与小目标的同步检测,为森林火灾的检测提供了有力保障。本文从可见光图像的角度有效地提取了烟雾和火焰,实现了精准的火灾检测。今后的研究重点是如何结合红外图像满足夜间及光线较暗的环境下的火灾检测。

4 结论

本文设计并开发了一种基于无人机系统的智能火灾检测系统。系统通过无人机搭载图像采集设备实时采集图像,并将图像实时传输至地面服务器,地面服务器通过智能检测算法实现了火灾的实时检测。通过对比测试和现场试验,系统的检测准确性、漏检率和检测效率均达到了实际应用的水平,从而证明了系统的可行性和实用价值。