基于卷积神经网络的半身裙款式特征分类识别

2021-11-26邓莹洁罗戎蕾

邓莹洁 罗戎蕾

摘 要:针对服装特征分类识别不够全面、较多分类特征导致效果较差的问题,提出一种带有Inception v2模组的快速区域卷积神经网络模型的女装半身裙多特征分类识别方法。建立一个包含8类款式、11种颜色、5种图案、4种长度,共计28种类别标签的女装半身裙样本库;以快速区域卷积神经网络(Faster r-cnn)结构为基础,引入一个Inception v2模组,对半身裙的款式及多种特征进行学习训练,通过全连接层将来自Faster r-cnn主干网络和Inception v2的分类信息进行特征融合并共享损失,以提高算法的准确率;将目标检测框与分类结果一起输出,在对半身裙图像精准定位的基础上实现了半身裙款式及常见特征的分类识别。结果表明:该方法的平均分类准确率为92.8%,可以有效地对女装半身裙款式、特征进行分类识别,并且可用于实际场景的服装图片中。

关键词:卷积神经网络;Inception v2模组;快速区域卷积神经网络;女装半身裙

中图分类号: TS941.26

文献标志码:A

文章編号:1009-265X(2021)06-0098-08

收稿日期:2020-08-06 网络首发日期:2021-01-21

基金项目:浙江理工大学研究生培养基金项目

作者简介:邓莹洁(1995-),女,福建邵武人,硕士研究生,主要从事服装数字化方面的研究。

通信作者:罗戎蕾,E-mail:luoronglei@163.com。

Classification and Recognition of Bust Skirt Style and CommonFeatures Based on Convolutional Neural Network

DENG yingjie, LUO Ronglei

(a.School of Fashion Design & Engineering;b.Zhejiang Province Engineering Laboratory ofClothing Digital Technology, Zhejiang Sci-Tech University, Hangzhou 310018, China)

Abstract: To solve the problem that the classification and recognition of garment features are not all-round enough and many classification features lead to poor effect, a multi-feature classification and recognition method for women〖JX+0.8mm〗〖XZ(322#〗〖HT15.〗'〖XZ)〗s bust skirt based on fast regional convolutional neural network model with Inception v2 module is proposed. A sample library of 28 kinds of women's bust skirts is established, which includes 8 styles, 11 colors, 5 patterns and 4 lengths. Based on the structure of fast regional convolutional neural network (Faster R-CNN), an Inception v2 module is introduced to train the learning of the styles and multiple features of bust skirt. Through the fully connected layer, classification information from the faster R-CNN backbone network and Inception v2 has feature fusion and shares loss, to promote the accuracy of the algorithm. The target detection framework is output together with the classification results, which achieves the classification and recognition of bust skirt style and common features on the basis of accurate positioning of bust skirt images. The results show that the average classification accuracy of this method is 92.8%, which can effectively classify and recognize the styles and features of women's bust skirts, and can be used for garment pictures in real scenarios.

Key words: convolution neural network; Inception v2 module; faster R-CNN; women's bust skirt

互联网与移动设备的普及,加速了服装行业的发展,基于内容的在线推荐系统已成为满足消费者对服装需求的常见方式,服装图像高效、准确的分类识别并建立相应的视觉标签对于在线推荐系统起着重要作用,可为消费者提供一种更为方便的方式来检索他们喜欢的服装商品。

传统的图像处理方法主要采用人工设计算法进行特征的提取,例如边缘检测、颜色直方图、局部二值模式分别提取轮廓、颜色、纹理特征,再利用决策树、支持向量机等进行模式的分类识别[1-3]。向忠等[4]采用canny边缘检测、HSV颜色空间对织物印花轮廓及颜色特征进行提取;Manfredi等[5]运用二值蒙版投影对人体着装图像进行粗糙形状描述,进而获取服装的3D积分颜色直方图及HOG特征最后通过决策树实现服装的颜色分类。李东等[6]根据服装轮廓的几何特点将服装轮廓曲线的曲率极值点集作为表达服装款式的特征向量,结合支持向量机对服装款式进行分类。以上传统算法都取得了不错的进展,但其具有两项明显的缺点:一是传统的特征提取过程是针对具体的底层或局部特征进行提取,经过专门的人为设定,使得该类方法的泛化能力及模型可迁移性都较弱;二是依赖高质量的输入图像,由于服装的高度可变性、属性特征多样化、拍摄场景复杂都会导致分类器的准确率下降。近年来,卷积神经网络的兴起为特征提取和分类识别技术提供了新的研究方向,基于更深层次卷积神经网络结构的服装图像检索系统在精确程度及检索效率上都有大幅度的提升[7]。卷积神经网络(CNNs)是一种多层次模型,通过逐层递增的模式及端到端的结构可以学习特定的图像表示并且广泛运用于服装领域:Dong等[8]在微调的VGG-Net中引入了“空间金字塔”池化策略,解决了不同大小及比例的图像输入引起的识别精度降低的问题同时对服装风格进行分类;Li等[9]提出一种基于极限学习机(ELM)神经网络的识别框架,采用ELM对CNN特征、颜色直方图特征进行深度融合实现服装款式分类;吴欢等[10]运用卷积神经网络CaffeNet模型对女裤廓形进行分类。观察服装时,首先是整体,其次是细节,故对于服装进行细致的描述至关重要,上述方法都只针对服装(风格、廓形、颜色等其中之一)单一属性进行分类识别,不能较好地描述服装的特点。因此,以女装半身裙为研究对象,通过对卷积神经网络模型结构的修改以及参数微调实现目标服装的精准定位,在此基础上对半身裙的款式及颜色、图案、长短多种特征进行分类识别,其结果可用于基于内容的推荐。

1 样本准备

1.1 样本采集

由于目前没有此类的服装图像样本库,根据女装半身裙形态差异及特点综合电子商务平台对半身裙款式的划分,本文选取了8种款式的半身裙:直筒裙、包臀裙、A字裙、波浪裙、百褶裙、鱼尾裙、不规则裙以及蛋糕裙。直筒裙是所有半身裙的原型,呈H型也称为H裙;包臀裙因其紧身贴臀而得名,裙体从腰口沿臀部展开至臀围线最大然后至下摆逐渐收紧,短称包臀裙长称铅笔裙(这里统称为包臀裙);A字裙的侧缝从腰口至下摆逐渐扩大,形成A字廓形;波浪裙(喇叭裙、伞裙)将下摆展开到一定范围,面料自然下垂形成波浪;百褶裙是指裙身由许多细密、垂直的等距褶裥构成的裙装,其褶裥数量在几十至上百不等;鱼尾裙的裙摆为波浪结构,基础裙型为直筒裙或包臀裙;不规则裙呈不规则、不对称的形状;蛋糕裙(节裙、塔裙)由多层次的横向抽褶裁片拼接而成,使裙体形成像蛋糕一样的层叠结构。从各大电商平台收集每种款式半身裙各200张,总计1600张,创建女装半身裙样本库。为了还原真实场景的特征提取与目标识别工作,选取的半身裙图像均为人体以各种姿态穿着(包含正、反面及侧面图片)且背景不一。图1以截取过的8类半身裙款式正面样本进行展示。

1.2 样本描述及标注

根据收集的半身裙款式及对裙类最常见的描述[11],对半身裙的颜色、图案、长度做进一步的划分,包括颜色11种、图案5种、长度4类,其中裙类长度按照裙摆至人体腿部的位置可分为:短裙至大腿中部、中裙至膝盖附近、中长裙至小腿中部以及长裙至脚踝附近。半身裙的款式及特征见表1。

针对以上半身裙的款式特征属性(共计28种),采用Labelimg软件进行标注,故每张图片具有款式、颜色、图案和长度4类标签。半身裙属性特征如图2,图3,图4所示。

2 卷积神经网络模型构建

通常,典型的卷积神经网络(CNN)由一个输入层、一个输出层和多个隐藏层组成,隐藏层中包括卷积层、池化层及全连接层,这些层次结构通过激活函数,例如Relu、Sigmoid、Tanh等实现输入图像的转化,最终通过Softmax回归完成分类。近年来,服装领域主要以图像分类及目标检测为热点研究内容,其中图像分类是通过对图像的整体分析,预测图像的类别。而目标检测主要的目的是从图片中检测并定位特定的多个目标[12]。卷积神经网络针对不同的视觉问题各有侧重点,需要根据实际问题进行权衡选择。

2.1 Inception v2模组

Inception v2[13]网络是一个旨在降低卷积网络复杂程度的模块。例如将较大尺寸的5×5卷积替换为较小的3×3卷积即可在保留计算效率的同时获得较高的精确性。Inception各个模块主要用于提取图像特征,随着每个模块设计的卷积分支的数量、结构和卷积核的大小不同,其特征提取能力随之改变。Inception A模块由3条卷积分支组成,分支内部选用较小的1×1和3×3的卷积核,用于提取较低级的底层特征;Inception B模块有2条分支结构,为了减少参数,其中一条分支将一个较大的7×7卷积核拆分为两个不对称的7×1和1×7卷积核,由于卷积核较大,适用于网络中间层;Inception C模块同样采用2条分支,与B模块的区别是其卷积核为1×3和3×1,可对图像局部特征进行有效的提取。Inception v2模组结构如图5所示。

2.2 快速区域卷积神经网络

快速区域卷积神经网络(Faster r-cnn)是基于Fast r-cnn[14]的改进算法,通过替换Fast r-cnn内部的目标选择算法Selective Search[15]为区域提议网络RPN(Region proposal net),使Faster r-cnn网络直接生成目标候选区域的同时加快了模型的识别速度。Faster r-cnn网络由4个部分组成:特征提取网络、RPN区域提議网络、ROI池化层以及最终分类和回归网络组成。其网络结构由图6所示。

将图像输入至网络模型,经过卷积与池化交替变换的特征图像馈入RPN网络得到一组矩形目标提案;ROI Pooling层将特征图像与RPN形成的候选区域进行相同尺寸裁剪;最后通过两个同级全连接网络框回归层(reg)与框分类层(cls)输出检测结果。

2.3 带有Inception v2模组的快速区域卷积神经网络

基于本文半身裙的识别特征较多(包含款式、颜色、图案、长度下的28个类别标签),将具有强大特征提取能力的Inception v2模组引入Faster r-cnn网络。改进后的Faster r-cnn网络结构如图7所示。

半身裙图像通过Labelimg标注,得到识别区域的准确二维坐标,将带有坐标的图像输入至带有Inception v2模组的快速区域卷积神经网络,此过程如图8所示。

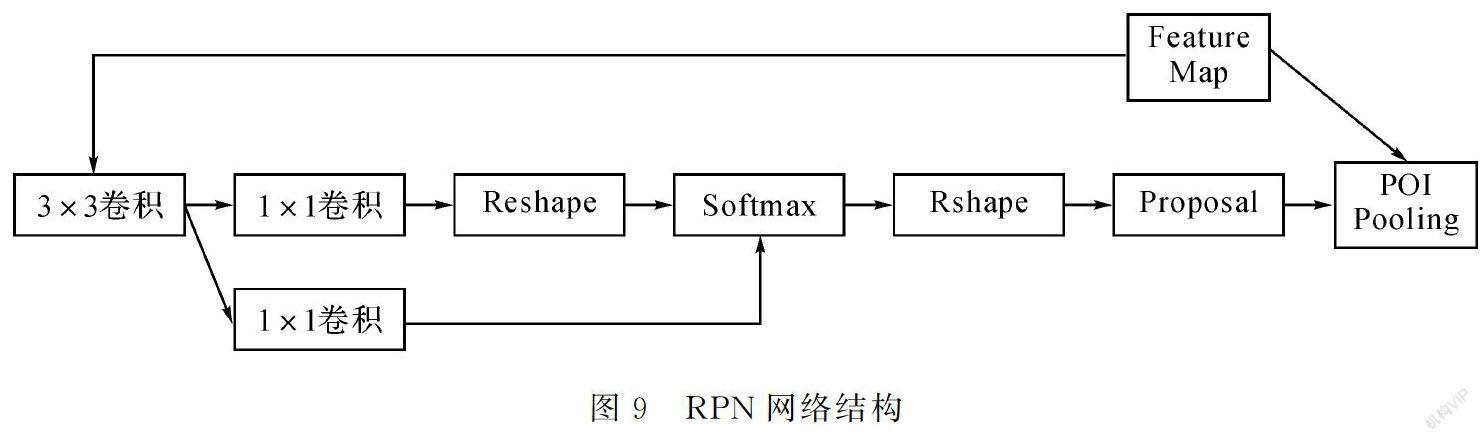

在Faster r-cnn主干网络中,图像通过CNN层的卷积、池化交替操作得到特征图像,经过一个滑动窗口形成不同的锚框(Anchor box),这里根据大部分半身裙图像的比例及位置信息,将候选区域的box修改为100,同时修改Anchor的比例为[0.51.04.06.0],采用此方式可以减少训练时长并降低损失不收敛的风险,得到Anchor box信息的RPN网络将每个样本映射为一个概率值(表示锚框有物体的概率)和四组坐标值(定义物体位置),即通过RPN网络预测候选区域。主要流程如图9所示。

首先,特征图像经过一个3×3的卷积操作,增强特征图像的鲁棒性;其次采用1×1卷积获得一个具有维度18的张量进行Reshape(Reshape尺寸为(15,15,18)),在维度18的张量中具有9个比例hw∈{11,12,21}的Anchor,且每个Anchor都会生成一个包含前景和背景的目标框;最后通过一个二分类的Softmax实现前、后背景分离。

由以上过程生成的Anchor边界较模糊,故对其进行边界框回归,本文选取前景Anchor(由Softmax判别)回归,一个box由四维向量(x,y,w,h)构成,其中x、y、w、h,表示候选框的位置及长宽。

设目标box为G=(Gx,Gy,Gw,Gh),源box为S=(Sx,Sy,Sw,Sh),取映射关系F,使F(S)=G。

平移box得:

缩放box得:

再求S对G的平移和缩放量(vx,vy)、(vw,vh):

前景box对box的平移和缩放量(v*x,v*y)、(v*w,v*h):

式中:x為前景box,xs为源box,x为目标box。

对dx(S)、dy(S)、dw(S)、dh(S)进行线性回归,则目标函数F为:

式中:φ(S)为区域提议的特征向量;W*为需要学习的参数;d*(S)为预测结果。

采用损失函数Smooth L1计算损失,其表达式为:

式中:N为类别数量;v*为真实框与预测框的平移和缩放量。

在Inception v2模组中,图像经过Inception各模块的特征提取和训练已经可以理解较高的特征表示,此过程的其损失值为:

式中:y为真实标签;p(y)为真实标签的概率;ε为模型参数;n为某个类别;p(n)为预测标签的概率。

然后将特征提取的结果输入至Softmax分类器中,进而将分类信息送出。

将Inception v2与Faster-r-cnn网络的两部分的损失进行结合,得到新的损失函数为:

在模型训练过程中手动调整了参数a和b的值,最终发现当a=0.6,b=0.5时,神经网络收敛情况较好,L最终收敛在0.05。

由Faster r-cnn主干网络与Inception v2模组的训练结果经过1×1卷机后进行多分类并输出最终结果。

为进一步提高模型对半身裙的分类性能,对模型的参数进行修改,将网络的初始学习率设置为0.0002,当迭代次数达90000次后,调整学习率为0.00002,防止学习率过高无法求出最优解导致最终结果发散;网络的最大迭代次数设置为100000。

3 结果与分析

3.1 训练过程及结果

采用Python3.6.5作为编程语言,训练环境搭建在Ubuntu18.04系统下进行(Intel Xeon E3 2603V2*2型号;CPU 128GB DDR3 ECC内存;16GB NVIDIA TESLA V100*2型号显卡)。

基于半身裙样本库,在实验数据集中将随机选取80%作为训练集,20%作为测试集用于模型性能的评估。训练过程将统一像素后的半身裙图像输入模型,图像同时经过Faster r-cnn主干网络与带有Softmax分类器的Inception v2模组进行特征提取与目标框的选择,然后利用全卷积层进行特征融合与损失值的共享进而降低损失值,以提高模型分类性能,最终将分类结果与检测框一起输出。本文模型的分类准确率如表2所示。

由表2可知,图案的准确率为89.9%,较其他类别准确率较低,原因可能为同种图案存在大小和比例上的差异,可增加训练数量提高此类的准确率。此外,其余的准确率都在90%以上且平均准确率为92.8%,可见本文提出的带有Inception v2模组的快速区域卷积神经网络能有效的对女装半身裙的款式类型及颜色、图案、长度特征进行分类识别。

3.2 模型验证

抽取阿里巴巴Fashion AI数据集中的半身裙图像对模型进行验证,Fashion AI数据集拥有服装图像10万以上,包含女装上衣、外套、半身裙等品类的详细标签信息。根据建立的半身裙数据集中训练集的数量有1280张,按照11的比例随机抽取Fashion AI中1280张半身裙图片作为测试集,输入至Faster r-cnn Inception v2模型中。分类准确率如表3所示。

由表3可知,模型对于在Fashion AI中抽取的测试集的平均分类准确率为86.3%,较先前测试的准确率低了6.5%,但平均准确率在仍能达到85%以上且未出现模型过拟合的问题,说明研究提出的模型分类性能及鲁棒性都较好。

3.3 实例分析

为更直观的看出改进Faster r-cnn Inception v2模型的分类识别性能,选取4幅包含多个类别标签的半身裙图像输入模型。测试结果如图10所示。

从图10测试结果可以看出,第一幅图像为短裙的概率为95%、为红色的概率为70%、为不规则裙及格子图案的概率都为100%,其在颜色属性中分类概率较低的原因是格子图案具有明显的黑色方框,使半身裙在颜色上同时具有红色及黑色,影响了模型的判别能力;第二幅图像为中长裙的概率为89%、其他属性概率都为100%,模型能够较好的对其各个分类特征进行判别。以此类推模型对图10中的(c)和(d)图也能进行良好的判别。

4 结 论

根据半身裙形态差异结合电子商务平台对半身裙款式的划分,将女装半身裙分为8个类别:直筒裙、包臀裙、A字裙、波浪裙、百褶裙、鱼尾裙、不规则裙以及蛋糕裙,在此基础上对其主要的颜色、图案、长度特征进行分类,建立带有28种类别标签的女装半身裙样本库;提出一种带有Inception v2模组的快速区域卷积神经网络,通过修改其box数量及Anchor比例,对输入的半身裙图像进行精准定位,最后通过微调模型参数,实现了女装半身裙款式及常见特征的分类识别;该方法可应用于实际场景的网络图片,模型通过RPN网络可对图像进行精确定位以及锚框的选择,无须对图像的背景进行处理,节省分类时间。本研究提出的方法平均准确率在92%以上,可对女装半身裙图像的多种特征进行判别。

参考文献:

[1]ZHANG W, ANTúNEZ E, GKTRK S, et al. Apparel silhouette attributes recognition[C].Workshop on the Applications of Computer Vision BrecRenridge, CO, USA. IEE, 2012:489-496.

[2]DI W, WAH C, BHARDWAJ A, et al.Style finder: Fine-grained clothing style detection and retrieval[C].Conference on Computer Vision.and Pattern Recognition work shops. Portland, OR, USA. IEEE, 2012:8-13.

[3]DHAKA V P, SHARMA M K. Classification of image using a genetic general neural decision tree[J]. International Journal of Applied Pattern Recognition, 2015, 2(1):76-95.

[4]向忠,何旋,钱淼,等.基于边缘和颜色特征的织物印花花型检索[J].纺织学报,2018,39(5):137-143.

[5]MANFREDI M, GRANA C, CALDERARA S, et al. A complete system for garment segmentation and color classification[J]. Machine Vision and Applications, 2014, 25(4):955-969.

[6]李东,万贤福,汪军,等.基于轮廓曲率特征点的服装款式识别方法[J].东华大学学报(自然科学版),2018,44(1):87-92.

[7]LUO Y, WANG Z, HUANG Z, et al. Snap and find: Deep discrete cross-domain garment image retrieval[J]. IEEE Transactions on Image Procession,2019,60(12):1-10.

[8]DONG C Y, SHI Y Q,TAO R. Convolutional neural networks for clothing image style recognition[C]// Proceedings of 2018 International Conference on Computational, Modeling, Simulation and Mathematical Statistics Xi'an: Advanced Science and Industry Research Center,2018.

[9]LI R, LU W, LIANG H, et al. Multiple features with extreme learning machines for clothing image recognition[J]. IEEE Access, 2018, 6:36283-36294.

[10]吳欢,丁笑君,李秦曼,等.采用卷积神经网络CaffeNet模型的女裤廓形分类[J].纺织学报,2019,40(4):117-121.

[11]吴苗苗,刘骊,付晓东,等.款式特征描述符的服装图像细粒度分类方法[J].计算机辅助设计与图形学学报,2019,31(5):780-791.

[12]周俊宇,赵艳明.卷积神经网络在图像分类和目标检测应用综述[J].计算机工程与应用,2017,53(13):34-41.

[13]SZEGEDY C, IOFFE S, VANHOUCKE V, et al. Inception-v4, inception-resnet and the impact of residual connections on learning[C]// Proceedings of the 31st AAAI Conference on Artificial Intelligence,2017:4278-4284.

[14]GIRSHICK R. Fast R-CNN[C]// International Conference on Computer Vision.Santiago, chile.IEEE,2015:1440-1448.

[15]UIJLINGS J R R, DE VAN SANDE K E A,GEVERS T,et al. Selective search for object recognition[J]. International Journal of Computer Vision, 2013,104(2):154-171.