基于深度学习的乳腺钼靶图像分类方法研究进展*

2020-07-20包昌宇彭俊川胡楚婷简文静王先明刘维湘

包昌宇,彭俊川,胡楚婷,简文静,王先明△,刘维湘△

(1.深圳大学医学部生物医学工程学院,深圳 518055;2.广东省医学信息检测与超声成像重点实验室,深圳 518060;3.医学超声关键技术国家地方联合工程实验室,深圳 518060;4.深圳市第二人民医院,深圳大学医学部第一附属医院甲乳外科,深圳 518035)

1 引 言

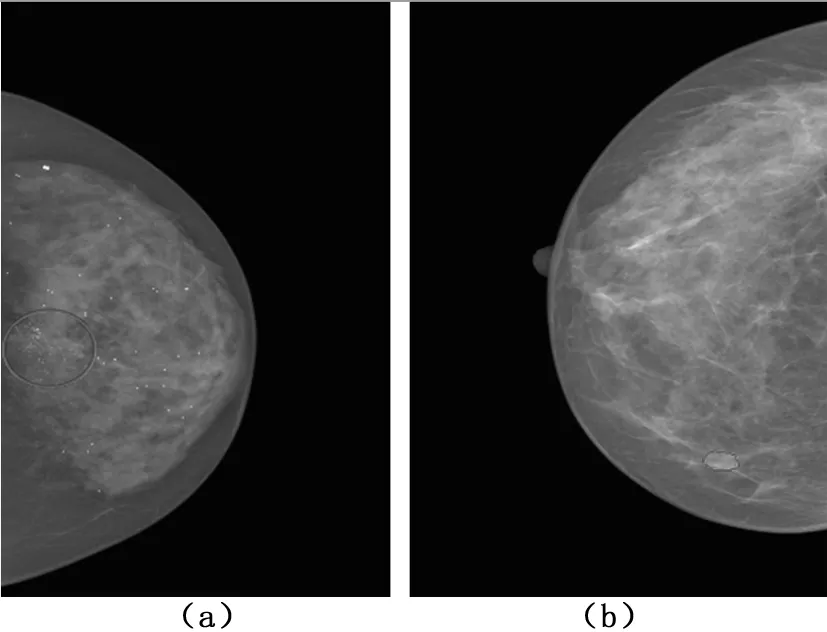

乳腺肿瘤的症状包括疼痛、皮肤增厚、乳头溢液和乳房大小形状的改变等,而乳腺肿瘤征象主要包括钙化、肿块、结构扭曲和对称性征象等。其中,钙化和肿块是两种最为典型的征象,见图1。对乳腺肿瘤的治疗,早期诊断和筛查尤为重要。在乳腺肿瘤筛查中,乳腺X光钼靶检查使用最广泛,可以发现多种疾病症状,而且射线剂量低,不会危害女性健康。钼靶检查的常规投照体位为内外侧斜位及头尾位,正确的摆位是获得高质量乳腺钼靶图像的基础[5]。对于不同的女性,乳房中脂肪组织与结缔组织的比例也不同。当乳房中的结缔组织比例较高时,称之为“致密性乳腺”。欧美国家大约有40%的女性属于偏致密型,而在中国,这一比例高达70%[6]。

图1 两种典型的X线征象(a).钙化征象;(b).肿块征象Fig.1 Two typical X-ray signs

为提高诊断效率和减小误诊风险,针对乳腺钼靶图像开发基于人工智能的计算机辅助诊断系统(CAD)显得尤为重要。在以前的研究中,已经证实CAD系统可以提高医生对乳腺肿瘤诊断的准确性[7]。为了测量诊断系统的性能,广泛使用准确率、灵敏度和特异度指数。另外,受试者工作特征曲线也是一种应用广泛的评估方法,曲线下的面积定义为area under curve(AUC),可以清晰地说明分类器的效果,AUC的值在0.5和1之间,越接近1意味着性能越好。

近年来深度学习技术[8]发展迅速,作为一种多层神经网络学习算法,能够模拟人类神经网络,通过组合多个非线性处理层从数据集中捕捉到潜在的深层特征,极大减少了人工提取特征的工作量[9]。因此,深度学习成为目前进行图像特征提取和分类的主流方法。

基于深度学习的乳腺钼靶图像分类方法中,一种思路是将感兴趣区域(region of interest,ROI)提取出来后再进行分类。但由于ROI标注需要医生具备丰富的临床经验,并且该过程耗时耗力,所以当数据量特别大时,这项工作面临巨大的挑战。因此,针对钼靶图像全图的分类是另一种有效的思路,能够为该挑战找到一个突破口。

2 基于深度学习的乳腺钼靶图像分类方法

2.1 针对ROI的分类方法

针对ROI的分类方法,即先从乳腺钼靶图像中将ROI提取出来(包括自动检测提取和手动检测提取),然后再进行分类。

Sahiner等[10]最早于1996年将卷积神经网络(conveolutional nural networks,CNNS)运用到乳腺钼靶图像的肿块和正常组织的分类中。他们设计了一个具有三个输入的三层卷积神经网络,将纹理特征提取方法应用于ROI的子区域,然后将子区域上计算的特征排列形成纹理图像,最后和ROI平均子采样图像一起输入到卷积神经网络进行训练。在分类来自密歇根大学放射科168张肿块图像和504张正常组织图像时的AUC达到0.87,灵敏度达到0.9,特异度达到0.69。表明通过训练卷积神经网络可以在乳腺钼靶图像上有效地进行肿块和正常乳房组织的分类。

3.2.2 评价方法(1)期末操作考试按健康评估实训教学大纲要求,实行评分标准一样、操作项目一样、考试时间一样,两组按学号抽签考试,操作满分为100分,60分为及格,90分以上为优秀。实验组和对照组平均成绩以Mean表示,采用t检验;优良率采用χ2检验进行统计学分析。

Arevalo等[11-12]提出了一个基于深度学习的乳腺肿块分类框架。他们针对ROI设计神经网络进行监督训练,最后提取网络的倒数第二层作为表征,使用支持向量机进行训练。在分类来自乳腺肿瘤数字数据库(breast cancer digital repository,BCDR)子集BCDR-F03数据集的426张良性肿块图像和310张恶性肿块图像时的AUC达到0.826。

Dhungel等[13]将手工标注的肿瘤ROI和分割掩模输入到卷积神经网络中,通过回归训练使最后全连接层的输出近似于手工特征,然后在顶层添加softmax层进行微调训练,最后将模型的全连接层输出作为特征训练随机森林分类器。在分类来自INbreast数据集的116张肿块图像时,AUC达到0.91,准确率达到95%。表明该方法与使用手工特征的机器学习模型和未经预训练的深度学习模型相比,能够产生更好的分类结果。

Sun等[14]开发了一种半监督学习方案解决肿块良恶性分类问题,该方法只需对训练集中的小部分数据进行标记,通过标记数据训练得到的分类器用于未标记的数据,将共同置信度的数据附加到标记的数据集,然后用这部分数据去构建深度神经网络。在来自全视野数字乳腺X线摄影(full-field eigital mammography)数据库的1 724张良性肿块图像和1 434张恶性肿块图像上的AUC达到0.8818,准确率达到82.43%,表明了通过半监督算法使用未标记数据可以显著提高系统的性能。

Kooi等[15]在区分良性肿囊和恶性肿块的问题上同样使用了深度卷积神经网络。他们训练一个类似VGG结构的卷积神经网络作为特征提取器,用非线性分类器对提取的特征进行分类训练。在来自荷兰一个筛查项目的1 108张良性肿囊图像和696张恶性肿块图像上的AUC能达到0.8,表明了在分类良性肿囊和恶性肿块上卷积神经网络同样具有巨大潜力。

Chougrad等[16]在提取ROI后使用VGG16、ResNet50和Inceptionv3三种预训练好的模型进行微调,从而分类良性肿块和恶性肿块。在由DDSM、BCDR-F03和INbreast三个数据集组合的6 116张图像上进行训练,然后在MIAS数据集的113张图像上的准确率达到98.23%,AUC达到0.99,表明了迁移学习的重要性。

Yu等[17]同样通过深度网络进行迁移学习,对比了GoogLeNet、AlexNet和CNN3三种模型对肿块良恶性分类的性能。在来自BCDR-F03数据集的230张良性肿块图像和176张恶性肿块图像上进行实验,发现三种模型之中GoogLeNet表现最佳,AUC达到0.88,准确率达到81%,同样表明了迁移学习可以改善乳腺肿瘤的诊断。

Morrell等[18]提出了一个神经网络架构,采用基于区域的完全卷积网络(region-based fully convolutional networks,R-FCN)和可变形卷积网络。该框架选择R-FCN获取图像丰富的边界框信息,提取出候选ROI后使用可变形位置敏感得分来生成每类的概率,在包含130 000个隐藏图像的DREAMS挑战中实现了0.879的AUC。

以上针对ROI的分类方法,大多涉及到病灶检测提取阶段,一种是手动病灶提取,另一种是自动病灶提取。手动病灶提取的分类效果要优于自动病灶提取,但该过程耗时耗力,需要工作人员具备丰富的临床知识。

2.2 针对全图的分类方法

针对全图的分类方法,即根据整张图像的整体特征信息进行性质分类。Zhu等[19]提出了基于全图的端对端深度多示例网络用于肿块良恶性分类,并探索了三种不同的多示例学习方案,证明了稀疏多示例学习更加灵活。在INbreast数据集上的AUC达到了0.8586,准确率达到了90%,证明了多示例方法即使在训练中没有检测和分割标注也能发挥出强大的性能。

Shen等[20]也开发了一种端到端的全图乳腺肿瘤诊断算法,该算法使用了全卷积设计。他们先是训练5分类(包括背景、良性钙化、恶性钙化、良性肿块和恶性肿块)图像块分类器,然后通过在图像块分类器的顶层添加卷积层以及修改输入的大小将图像块分类器转化成全图分类器,并且该全图分类器可以在仅使用少量训练数据而不需要病变注释的情况下迁移到其他数据集,从而实现了钼靶图像良恶性二分类。在CBIS-DDSM数据集上的AUC达到了0.88,而通过迁移学习在INbreast数据集上的AUC达到了0.96,表明了通过不依赖ROI标注的端到端方式训练的深度学习模型可以实现准确的全图乳腺肿瘤诊断。

Lotter等[21]介绍了一个多尺度卷积神经网络的训练策略。他们先是使用ResNet在钙化和肿块两个不同尺度的图像上单独训练图像块分类器,然后将训练好的图像块分类器作为特征提取器,以滑动窗口的方式,提取每张图像的最后一层特征,并在全局平均池化后进行连接,最后针对良恶性进行端到端的图像级训练,在DDSM数据集上的AUC达到了0.92,表明了多尺度框架选择对于分类性能发挥着重要作用。

张娟等[22]提出了将卷积受限玻尔兹曼机模型用于解决钼靶图像正常、良性和恶性三分类问题的方法,并且采用改进的快速持续对比散度算法对模型进行训练,在MIAS数据集上能达到88.63%的准确率和0.8912的精度。

Zhang等[23-24]将数据扩增、迁移学习和CNN模型相结合,从而训练出针对钼靶全图的分类模型,并且发现对2D图像的分类效果要优于3D图像。

Geras等[25]则建议使用多视图深度卷积神经网络来处理高分辨率的钼靶图像。他们构建了一个多尺度深度卷积神经网络,在第一阶段将许多卷积层和池化层分别应用于每个视图,然后把这些视图的表征连接成一个向量,在第二阶段将这些向量输入到全连接层,最后添加一个softmax层进行分类。在来自纽约大学医学院数据集的886 437张图像上,AUC达到0.733,证明了多视图神经网络可以输入一组图像,分类性能随着样本量的增加而提高,只有使用原始分辨率才能实现最佳性能。

Carneiro等[26-27]在研究中也发现多视图相比单视图,分类性能可以得到明显改进。他们先使用卷积神经网络给一侧乳腺的两个视图以及对应的钙化和肿块掩模分别训练,得到六个模型,然后提取六个模型的最后一个全连接层特征来训练最终的CNN分类模型。在来自INberast数据集的410张图像和DDSM数据集的680张图像上实验,对于手动病灶标注,良恶性二分类的AUC均超过0.9。后期他们改进了网络设计,在多视图网络输入上对比了2D和3D两种输入形式, 2D模型输入为六张图像,包括两个视图以及对应视图的钙化和肿块掩模图像;3D模型输入为两张分别由CC位或是MLO位以及对应视图的钙化和肿块掩模叠加构成的图像。对于手动病灶检测,在INbreast数据集和DDSM数据集上的AUC均超过0.9。此外,在INbreast数据集上的特异度达到0.92,灵敏度达到0.69,而在DDSM数据集上的特异度达到0.97,灵敏度达到0.94。

Dhungel等[28]提出了一种多视图深度残差神经网络(multi-view deep residual neural network,mResNet))。该方法由一组深度残差网络组成,输入同样为六张图像,即一侧乳腺两个视图以及对应视图的钙化和肿块掩模图像,然后通过连接每个ResNet的输出以及在最后添加全连接层,形成mResNet,以端到端的形式进行训练。在INbreast数据集上AUC达到0.8。同样表明了将两种视图与病灶分割掩模结合起来,可以合理准确地分类乳腺钼靶图像。

除了乳腺钼靶图像的良恶性分类研究,在乳腺组织密度分类问题上,Fonseca等[29]提出了一种基于卷积神经网络的自动分类方法。该方法使用HT-L3卷积网络提取图像的高维特征,然后使用SVM进行分类训练。在从秘鲁立马两个医疗中心1 157名受试者采集的数据上实验,准确率达到73.05%,kappa值达到0.5813,表明在乳腺组织密度分类上,卷积神经网络方法也能够展示出十分有意义的结果。

相比针对ROI的分类方法,针对全图的分类方法有着较为明显的优势。该方法通过对全局图像提取特征来完成分类工作,能够实现对乳腺钼靶图像的全局表征,无需再考虑各类病灶的结构信息,从而有效地避免了复杂的特征提取工作。但是该方法也同样存在缺点,一方面其在临床解释性上表现较弱,无法准确指出病灶具体所在区域,另一方面由于其特征提取方法的单一性,易造成对多种病灶的描述性不足。

3 乳腺钼靶图像数据集介绍

随着乳腺肿瘤的辅助诊断越来越受到关注,对数据的需求也越来越大,研究人员在乳腺钼靶图像上进行分类实验,一种是基于自有的数据,另一种则是基于现有的公共数据集。自有数据一般比较杂乱,可能还缺乏专家的标记或注释,病灶表述上也存在描述不确切的问题。而公共数据集由于成像设备不一致,成像质量及数据量存在很大差异,同一方法在不同数据集上可能会得到不同的效果。我们介绍了目前常用的乳腺钼靶图像公共数据集。

3.1 DDSM数据集

DDSM数据集[30]是来自美国放射学会(American college of radiology,ACR)的一个数据集。该数据集包含2 620例患者的10 480张图像,包括了大量正常数据和癌症患者数据,每例患者包含四个视图的钼靶图像,图像格式为LJPEG格式,并且图像具有多种分辨率。此外,该数据还提供了患者筛查的相关信息,以及由专业放射科医生给定的ACR乳房密度、病灶的乳腺影像报告和数据系统(breast imaging reportingand data system,BI-RADS)分级和异常区域的分割金标准。CBIS-DDSM数据集[31]则是转换为DICOM格式的DDSM数据集子集,由1 249例患者的2 584张图像组成,其中753例包含钙化,分别包括414例良性钙化和339例恶性钙化;891例包含肿块,分别包括472例良性肿块和419例恶性肿块。

3.2 INbreast数据集

INbreast数据集[32]是来自葡萄牙的一个数据集。该数据集由115例患者的410张图像组成,其中90例包含四个视图的图像,25例乳房切除手术患者包含一侧乳房两个视图的图像,图像格式为DICOM格式,图像分辨率有3 328×4 084像素和2 560×3 328像素两种。该数据集给出了精确的病灶注释(包括病灶分割金标准和BI-RADS分级),同时提供了患者筛查的相关信息和ACR乳房密度标注,以及专家对结果的准确评估。该数据集具有广泛的病例变异性,包括了肿块、钙化、不对称和紊乱几种类型的病变。

3.3 MIAS数据集

MIAS数据集[33]是来自英国的一个数据集。该数据集包含161例患者的322张乳腺钼靶图像,其中正常图像为54张,良性图像为66张,恶性图像为54张,图像格式为PGM格式,图像分辨率为1 024×1 024像素,且所有图像均为MLO位视图。此外,该数据集还给出了异常位置的中心点及半径值。

3.4 BCDR数据集

BCDR数据集[34]是由葡萄牙波尔图大学圣若昂医学院提供的一个DICOM格式数据集。该数据集包含1 010个病例的相关临床资料和3 703张图像,图像分辨率为720×1 168,同时还提供了分割金标准,以及分割病灶的BI-RADS分级。BCDR-F03是由良性和恶性肿块图像构成的二分类BCDR子集,包含344例患者的736张肿块图像,其中426张为良性肿块,310张为恶性肿块,该数据集在针对ROI的肿块分类实验上使用比较广泛。

4 总结与展望

近几年,研究人员一直致力于开发基于人工智能的CAD系统,从而辅助医生提高诊断水平。随着深度学习的崛起,基于神经网络的图像分析也受到到越来越多的关注,把深度神经网络应用到乳腺钼靶图像的分类上,能够取得非常不错的效果。无论是针对ROI的方法还是针对全图的方法,基于卷积神经网络的深度学习方法已经成为了分类的热门技术。研究证明,在乳腺钼靶图像的大数据集上训练CNN形式的深度学习模型,已经超越了计算机辅助检测最先进的系统[35]。尽管如此,该技术仍然面临着不少挑战。

使用深度学习的方法,意味着大量的计算,一方面网络内部本身参数众多,另一方面钼靶图像具有高分辨率,这对设备内存和时间的要求非常高。因此,可以考虑使用轻量级网络解决该问题。同时,大量的数据需求也是该方法面临的一个巨大难题。针对小数据集,深度迁移学习和小样本学习是不错的选择。此外,现有的公共数据集几乎均来自欧美国家,而中国女性的乳房密度和欧美女性有较大差异,建立国人的公共数据集势在必行。在未来的研究中,研究人员需要找到更可靠有效的方法去实现深度学习与CAD系统的完美结合,从而进一步提高系统的辅助诊断水平。