改进的深度置信网络分类算法研究*

2019-05-07李蓓蓓

徐 毅,李蓓蓓,宋 威

江南大学 物联网工程学院,江苏 无锡 214122

1 引言

近年来,神经网络[1]被广泛地应用于人工智能领域,并基于此提出了许多非线性处理层的深层模型和体系结构。深度学习[2-3]是对人工神经网络的发展,它试图建立结构更加复杂,层次更加丰富的神经网络,通过逐层学习把前一层学习到的知识传递到下一层,将底层特征组合成更加抽象的高层表示[4]。最经典的深度学习方法是深度置信网络(deep belief network,DBN)[5-6],由多层受限的玻尔兹曼机(restricted Boltzmann machine,RBM)组成,通过使用堆叠的RBM可以创建分层处理的DBN。因此,DBN的大部分改进是源于RBM的改进。DBN是一种概率生成模型,通过建立输入数据和数据标签之间的联合概率分布,在每轮训练过程中更新神经元间的权重参数,使整个神经网络按照最大概率来重构输入数据。目前,学者们已经提出很多DBN模型,例如Hinton等人在文献[6]中提出从下到上学习单层概率图模型的算法;Kaiser等人[7]提出了一种新颖的卷积DBN模型;特别地,由Hinton等人提出的模型是训练深层神经网络的突破口。如今,DBN已经成功应用于各种现实世界的任务,比如手写字体识别[6,8]、语音识别[9]、场景分类[10]、自然语言处理[11]以及各种视觉数据分析任务[12-13]。

尽管DBN模型已经取得了令人鼓舞的成就,但是在训练过程中存在特征同质化现象,即存在大量的共有特征,导致隐藏层单元的后验概率偏高,不能很好地学习到数据有用的特征表示,解决该问题的方法主要是在RBM训练中引入稀疏正则项来调节隐藏单元的稀疏性。目前学者们已经提出多种稀疏RBM模型,Hinton[14]利用交叉熵的概念提出了交叉熵稀疏惩罚因子,使得隐单元具备整体稀疏性;文献[15]通过引入对比散度[16]的稀疏约束,使得模型具有较小的重构误差,并使用折衷系数很好地解决了饱和问题;Lee等人[17]提出基于误差平方和的稀疏RBM(sparse restricted Boltzmann machine,SRBM),惩罚平均激活偏离给定(低)固定水平p的隐单元;文献[18]提出基于率失真理论的稀疏RBM(sparse response restricted Boltzmann machine,SR-RBM),将原始输入分布与RBM学习到的均衡分布之间的KL散度作为损失函数,但目前尚无得到SR-RBM失真度量的正确方法,有待于进一步研究;Chen等人[19]通过引入基于流行的局部性来保留对RBM隐藏层的约束,最终学习到稀疏和区分性表示。

总之对于DBN而言,利用RBM的变体就可以通过指定“稀疏目标”来达到二进制隐藏单元的稀疏行为。但是现有方法需要事先设定“稀疏目标”,隐藏单元在某种状态下都具有相同的稀疏程度,而隐藏单元的稀疏度与给定的数据相关,每个隐藏单元的激活概率可能相同也可能不同。因此,针对上述问题,本文提出了一个改进的稀疏深度置信网络。首先,它根据隐藏层节点的激活概率与稀疏系数之间的差距而具有不同的行为,并且具有可以控制稀疏力度的位置参数;其次,本文算法在样本较少时仍可以获得数据的主要特征,并一定程度上抑制了训练数据较少的情况下出现的过拟合现象,根据实验验证与分析,该方法在不同数据集中都实现了最佳的分类精度,且具有更优的特征提取能力。

2 相关工作

2.1 受限玻尔兹曼机

受限玻尔兹曼机(RBM)[4,14]由一个可视层v和一个隐藏层h组成,可视层包括n个单元v={v1,v2,…,vn},隐藏层包括m个单元h={h1,h2,…,hm}。RBM是基于能量的模型,可视层和隐含层的能量函数公式为:

式中,θ={Wij,ai,bj}是RBM的参数,Wij表示可视层和隐藏层之间的连接权重,ai表示可视层的偏置,bj表示隐藏层的偏置。

该模型v和h的联合概率分布为:

其中,Z(θ)是配分函数(partition function)。

网络分配给可视单元的概率通过对所有可能的隐藏单元求和给出:

根据贝叶斯公式的原理,可推导出隐藏单元和可视单元的激活状态分别为:

其中,σ(x)为非线性的sigmoid激活函数。

利用极大似然法求解对数似然函数P(v):

其中,m是训练样本的数量。

选用对比散度(contrastive divergence,CD)算法[16]训练RBM网络,仅需有限步吉布斯采样就可以得出满足条件的近似采样值。然后通过对权重的概率对数求偏导数实现对参数的更新。

2.2 深度置信网络模型

深度信念网络(DBN)是一种概率生成模型,可以看作由多个RBM堆叠起来的深度神经网络,训练过程通常包括预训练和微调两个阶段:

预训练阶段:采用贪婪无监督学习算法自底向上地逐层训练各层RBM,将底层RBM的输出作为高层RBM的输入,以此类推。每一层RBM经过多次迭代训练,得到无监督的DBN网络。

微调阶段:在DBN的最后一个RBM后设置一层BP神经网络,将最后一个RBM的输出值作为BP的输入值,计算出前向传播的输出结果和标签数据的误差,通过自顶向下的有监督学习微调网络。

3 改进的稀疏深度置信网络模型

3.1 模型求解

根据研究[20],稀疏表示中具有可以用来解释学习特征的属性,即具备对应于输入有意义的方面以及捕获数据变化的因素。因此为了实现深层结构中的稀疏特征,在RBM的最大似然函数中添加稀疏正则项,可以学习有用的低级特征表示。

假设给定一个训练集{v(1),v(2),…,v(m)},使用稀疏正则化的无监督预训练优化模型定义如下:

其中,Funsup表示RBM的似然函数,即式(7)所示的;λ为正则化参数,反映数据分布相对于正则化项的相对重要性;Fsparse表示任意稀疏正则化函数。

增加稀疏正则化项后模型的目标函数为:

通过定义稀疏正则项来减少训练数据的平均激活概率,确保模型神经元的“激活率”保持在相当低的水平,使得神经元的激活是稀疏的。受压缩感知理论以及文献[17-18]的启发,本文提出一种基于Laplace函数的稀疏正则化受限玻尔兹曼机(Laplace sparse RBM,LS-RBM),通过使用拉普拉斯函数惩罚来诱导隐含层单元的稀疏状态,该函数具有重尾特征,根据隐含层单元激活概率与p的差距具有不同稀疏程度。另外,将该函数中的位置参数用来控制稀疏力度,可以针对不同的样本特征实现不同的稀疏性。

其中,拉普拉斯稀疏惩罚项定义如下:

式中,L(qj,p,u)为拉普拉斯概率密度函数,qj表示所给数据第j个隐藏单元的条件期望的平均值,p是一个常数,控制n个隐藏单元hj的稀疏度,u表示位置参数,通过改变它的值可以用来控制稀疏力的程度。qj表示如下:

式中,Ε(∙)是给定数据的第j个隐藏单元的条件期望,m是训练数据的数量,是给出可见层v时,隐藏层单元hj的激活概率,g是sigmoid函数。

因此训练LS-RBM的目标函数如下所示:

式中,第一项是对数似然函数项,第二项为稀疏正则项,其中λ为该项的参数,用来表示该项在目标函数中与数据分布之间的相对重要性。因此在最大化对数似然函数的同时也要最大化稀疏正则项求解。

若LS-RBM整个目标函数的求解直接使用梯度下降法,那么因配分函数Z的存在会使得计算对数似然函数项梯度的代价是昂贵的,尤其当训练样本的特征维数较高时,会大大增加网络训练的时间复杂度。因此参照文献[17]的方法,通过CD算法对似然函数项进行一次参数更新,在此基础上使用正则化项的梯度进行一步梯度下降。CD算法仅需一步抽样就可以很好地近似对数似然的梯度,缩短了训练时间,免去了繁琐的求导过程;稀疏函数的求解符合无约束优化问题,求导简单,因此使用梯度下降法对该函数进行逐步迭代求解。通过这种方法可以高效地训练网络模型,得到参数的最优解。

LS-RBM模型中各参数的梯度计算如下:

对于过于稀疏的数据集,若没有隐藏层偏置项b,LS-RBM的W对于数据的影响就会变小,很难激活一些隐藏层单元,因此隐藏层的偏置项直接控制隐藏单元的激活程度,使得隐藏层具备稀疏性;而a为输入空间的偏置项,仅控制一个单变量,其梯度根据输入数据的特征而波动,不对其进行正则化也不会导致太大方差。基于此,为了方便计算,稀疏正则项的梯度只对W和b进行了更新。其中第一项的求导结果如式(8)和式(10)所示,第二项展开如下:

对隐藏层偏置求偏导可得:

将进行求导后的参数值带入到参数更新式中,得到新的参数值:

LS-RBM模型算法如算法1所示,更新参数值以后,新的参数值继续训练网络,通过不断优化目标函数,使隐含层节点的激活概率逐渐接近给定的固定值p,学习到一组权重参数以及相应的偏置,通过这些合适的参数可以寻找到稀疏特征向量,控制冗余特征,用主要的特征来组合学习权重以重构输入数据,提高了算法对噪声的鲁棒性。

算法1LS-RBM学习算法

输入:学习率α,小批量batches,训练样本以及对应的标签{X,Y}={(x(1),y(1)),(x(2),y(2)),…,(x(n),y(n))},预训练最大迭代次数T,稀疏正则项参数λ,稀疏水平参数p,位置参数u。

预训练阶段:

初始化网络参数:第一个RBM可见层节点的输出值v1=X,W初始化为正态分布(0,0.01)的数值,偏置a和b初始化为0;

3.2 模型分析

在本文提出的LS-RBM方法中,拉普拉斯分布是一种连续的分布,与正态分布相比较而言,具有更平坦的尾部。当固定期望概率p时,也就是说希望所有隐单元为相同的平均激活概率,这时改变位置参数u的大小,函数分布会随着u的变化有不同的分布曲线,从而使得同层中的不同隐藏单元根据数据特征的不同而得到不同的激活概率;而λ的值反映稀疏正则项和数据分布之间的相对重要性,值越大对应的惩罚也越大。

3.3 LS-DBN模型

DBN模型[6]是由多层RBM组成的生成模型,每一层包含一组二进制或者实值单位,通过贪婪逐层训练方法来学习更加抽象和有意义的特征,同时基于该模型结构,将稀疏正则化项也引入到DBN中,本文提出了一种基于Laplace函数的稀疏DBN(Laplace sparse DBN,LS-DBN),它由几个LS-RBM层叠而成,使用上述方法层层训练网络,最底层的LS-RBM训练好的参数和输出作为训练模型中下一个更高层“数据”,也就是下一个LS-RBM,多次循环迭代之后,可以学习到一个深层次的稀疏DBN模型。LS-DBN的算法流程如下所示:

步骤1使用算法1训练第一个LS-RBM;

步骤2通过第一层的特征训练好W(1)和b(1),以及使用P(h(1)|v(1),W(1),b(1))得到第二个LS-RBM的输入特征,使用算法1训练第二个LS-RBM;

步骤3使用第二层的特征训练好W(2)和b(2),按照步骤2使用P(h(2)|h(1),W(2),b(2))得到下一个LS-RBM的输入特征;

步骤4递归地按照以上步骤直到训练到L-1层;

步骤5通过对L层的W(L)和b(L)进行初始化,最终使用{W(1),W(2),…,W(L)}和{b(1),b(2),…,b(L)}组成一个具有L层的深度神经网络,输出层为有标签数据,使用Softmax分类器作为输出层;

步骤6使用{W(1),W(2),…,W(L)}和{b(1),b(2),…,b(L)}作为整个网络的初始参数,使用梯度下降算法微调整个LS-DBN网络。

3.4 算法流程

根据前面所描述的算法,为了更加系统阐述LSDBN模型的训练过程,给出算法流程图如图1所示。

Fig.1 LS-DBN training process图1 LS-DBN训练过程

4 实验结果与分析

4.1 实验环境与参数设置

实验在Linux操作系统上运行,系统的具体配置为:CPU为E5-2620V4*2,GPU为GTX 1080 Ti*4,固态硬盘为480 GB,运行内存为32 GB*8,使用Matlab R2014b开发环境。

本文在MNIST和Pendigits上进行实验分析,以评估和比较本文算法与人工神经网络(artificial neural network,ANN)、自动编码器(auto-encoder,AE)、RBM以及学者所改进的SRBM[17]、SR-RBM[18]算法。为验证深层次模型的有效性,与DBN、基于误差平方和的稀疏DBN(SDBN)、基于率失真理论的稀疏DBN(SR-DBN)算法进行了实验分析。在所有实验中,通过均匀分布的方法初始化权重和偏置。为加快学习过程,将每个数据集分成等份小批量,在每个小批量之后更新权重。以便图像相关特征的提取,对所有图像归一化处理,将特征值映射到0到1区间。

4.2 MNIST数据集

MNIST手写体数据集包括60 000个训练样本和10 000个测试样本,每个图片大小为28×28像素,对应0~9范围的手写数字图像,虽然手写数字受环境因素影响具有较大的形态变化,但是结构特征中的主曲线受字体变形影响较小。本文对每个像素进行了归一化处理,以灰度图像的形式进行存储。传统RBM的提取的该库特征以像素级为主,较为模糊,个别具有一些轮廓特征。本文LS-RBM方法提取到大量的局部特征,比如某个数字的凸曲线和凹曲线,大部分字体的轮廓更清晰地呈现出来,而这些轮廓特征是字体识别中具有辨别力的主要特征,因而LSRBM能提取到更多利于分类的相关信息。

本文从60 000个训练数据抽取每个类别的不同数量的图像进行训练,并使用BP(back propagation)算法进行微调。其中,模型包括784个可视单元和500个隐藏单元,学习率设为1,批量数据大小为100,最大迭代次数为100,并使用步长为1的CD算法训练模型。

为了更准确地衡量RBM、SRBM、SR-RBM以及LS-RBM的稀疏度,采用Hoyer[21]所提出的稀疏性度量方法计算模型学习到的特征表示的稀疏度,稀疏性度量方法如下所示:

其中,x为输入特征,n为x的维数。稀疏度的取值范围为[0,1],越接近于1,表示x越稀疏。本文先计算分批数据的隐藏单元激活概率的稀疏度,然后计算所有数据隐藏单元激活概率的稀疏度平均值。

从表1可知,与SRBM和SR-RBM相比,LSRBM的稀疏度值更高,可以学习到更稀疏的表示,改进的效果更为显著。

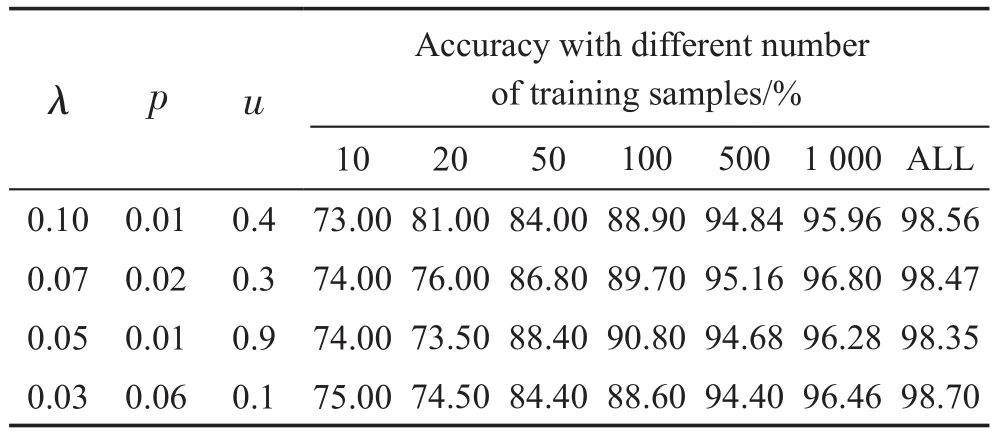

为了证明本文算法在学习稀疏特征方面的优势,训练由可视层和隐藏层组成的深度结构模型,将提出的LS-RBM算法与SRBM、SR-RBM进行比较。为了测试稀疏惩罚因子影响特征提取的能力,本文在每类不同样本个数以及所有样本个数的情况下,惩罚因子取不同值时的分类准确率分别如表2~表4所示。其中表2为SR-RBM在正则化参数λ取值为[0.01,0.10]之间的分类准确率;表3为SRBM在λ取值为[0.01,0.10]和惩罚因子p取值为[0.01,0.10]的分类准确率;表4为LS-RBM在λ取值范围为[0.01,0.10],p取值范围为[0.01,0.10]和尺度参数u取值范围为[0.1,1.0]的分类准确率。

Table 1 Sparsity of hidden units activation probability on MNIST data set表1 MNIST数据集上隐藏单元激活概率的稀疏度

从表2~表4可以看出,LS-RBM在不同样本数的分类效果基本上都要优于SR-RBM和SRBM,显然这只是列出了部分参数,在这些参数组合下可以获得更好的准确率。同时,在样本较少时分类错误率在12%~25%左右,主要原因是由于MNIST数据集的维度较高,样本较少,而深度学习模型需要大量的样本训练,否则会导致模型的性能减弱,从表中对比来看,本文方法的分类错误率有所降低,在一定程度上改善了这个问题。

Table 2 Classification accuracy of MNIST data set under SR-RBM algorithm表2 MNIST数据集在SR-RBM算法下分类准确率

Table 3 Classification accuracy of MNIST data set under SRBM algorithm表3 MNIST数据集在SRBM算法下分类准确率

Table 4 Classification accuracy of MNIST data set under LS-RBM algorithm表4 MNIST数据集在LS-RBM算法下分类准确率

为了验证本文算法的识别能力,与算法ANN、AE、RBM、SRBM、SR-RBM进行分类准确率的比较。如表5所示,给出了SRBM,SR-RBM和LS-RBM在最优参数组合下的结果。

Table 5 Classification accuracy of MNIST data set under 6 algorithms表5 MNIST数据集在6种算法下的分类准确率

从表5可以看出,与传统特征提取算法相比,引入稀疏正则项的算法分类准确度都比较高,在样本较少时,RBM的算法不如AE算法分类性能好,但随着样本数量的增加,RBM的分类性能超过AE,说明RBM需要大量的样本来训练模型才能更好地拟合输入数据,但LS-RBM算法解决了该问题,始终处于最好的识别精度。虽在每类样本数量较多时提升效果不是很明显,但比其他稀疏模型具有更好的分类性能,尤其在每类1 000个样本的情况下达到了96.8%的识别率,比SR-RBM算法要高出3个百分点,也说明具有更好特征提取能力。

为了表达更加直观清晰,通过图的形式展现对比实验结果,并加以分析,如图2所示。观察可知,在每类样本数比较少的情况下LS-RBM分类准确率有了很大的提升,与RBM相比在每类10个样本时有了10%的提高,比SRBM和SR-RBM分别提高了4%和5%左右的分类准确率,表明LS-RBM的表示比SRBM和SR-RBM具有更优的辨别力,改善了RBM算法的稀疏化特征学习性能。

Fig.2 Classification accuracy of MNIST data setunder 6 algorithms图2 MNIST数据集在6种算法下的分类准确率

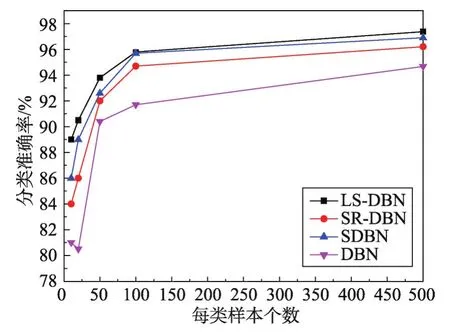

鉴于DBN可以学习更高层的抽象表示,比较DBN、SR-DBN、SDBN和LS-DBN的判别能力,构造了两个隐藏单元都为500的隐藏层,并使用Softmax分类器进行训练得到最终分类结果,如表6所示。可以看出在不同数量的样本下,LS-DBN算法都达到了最佳的识别精度,相比于传统DBN算法,都提高了0.2%~5.0%的分类精度,尤其在每类样本少的情况下,效果提升更为明显。

Table 6 Classification accuracy of MNIST data set under 4 algorithms表6 MNIST在4种算法下的分类准确率

对于更深层次的稀疏模型,每增加一层就会提取到更抽象的特征,同样的也会有一些冗余特征的存在影响最终的分类效果。从图3很明显地可以看出,LS-DBN可以学习到具有易辨别力的特征,比次高的SDBN最多提高3个百分点,说明LS-DBN对于冗余特征的干扰具有更好的鲁棒性。

Fig.3 Classification accuracy of MNIST data setunder 4 algorithms图3 MNIST数据集在4种算法下的分类准确率

4.3 Pendigits数据集

Pen-based recognition of handwritten digits(Pendigits)数据集包括10 992个数据样本,分为10个类,其中训练数据7 494个,测试数据3 298个,每个样本16个特征向量,同样对每个类不同数量的图像进行分析。设置可见层节点16个,隐含层节点10个,学习率设为1,分批块数大小为100,最大迭代次数为1 000。

对于Pendigits数据集,仍将RBM、SRBM、SRRBM、LS-RBM设置为相同的参数值,隐藏单元数量设置为10,对于稀疏正则化系数{λ,p,u},本文根据模型训练的性能选择最佳的值,并与ANN、AE算法进行对比。对于稀疏模型来说,稀疏度越高,算法稳定性越高,鲁棒性也越强。为了验证算法的鲁棒性,同样地对几种算法进行了稀疏度测量,如表7所示。

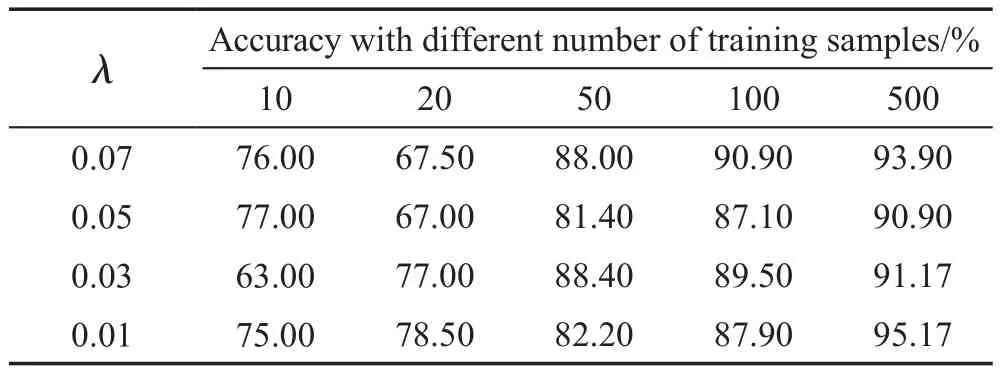

表7显示了不同算法在Pendigits数据集的稀疏度,很明显地可以看出本文LS-RBM算法的稀疏度最高,比传统RBM算法有了很大的提升,具有很好的稀疏表示能力。同样地,为了验证LS-RBM算法与SRBM、SR-RBM的最优参数组合,选取惩罚因子在不同的变化值区间分类准确率分别如表8、表9和表10所示。

Table 7 Sparsity of hidden units activation probability on Pendigits data set表7 Pendigits数据集上隐藏单元激活概率的稀疏度

Table 8 Classification accuracy of Pendigits data set under SR-RBM algorithm表8 Pendigits数据集在SR-RBM算法下的分类准确率

Table 9 Classification accuracy of Pendigits data set under SRBM algorithm表9 Pendigits数据集在SRBM算法下的分类准确率

Table 10 Classification accuracy of Pendigits data set under LS-RBM algorithm表10 Pendigits数据集在LS-RBM算法下的分类准确率

表8显示的是SR-RBM在正则化参数λ取值范围为[0.01,0.10]的分类准确率;表9为SRBM在λ取值范围为[0.01,0.10]和惩罚因子p取值范围为[0.01,0.10]的分类准确率;表10为LS-RBM在λ取值范围为[0.1,1.0]、p取值范围为[0.01,0.10]和位置参数u取值范围为[0.1,1.0]的分类准确率。观察可知,LS-RBM在不同样本数中都取得了最好的分类准确率,同时在大部分参数组合下效果都要好于SRBM和SRRBM算法,且随着样本增加,由于特征分布的问题,其他两种算法会出现分类准确率下降的问题,而LSRBM仍具有良好的效果。

为了验证本文算法的特征稀疏能力和判别能力,接下来对每类分别为10、20、50、100、500个样本进行训练,得到的结果如表11和图4所示。

Table 11 Classification accuracy of Pendigits data set under 6 algorithms表11 Pendigits数据集在6种算法下的分类准确率

Fig.4 Classification accuracy of Pendigits data set under 6 algorithms图4 Pendigits数据集在6种算法下的分类准确率

从表11和图4中可知,大多数算法在每类样本个数越多时,分类准确率也越来越高。与其他两种稀疏模型相比,LS-RBM算法每类只有几十个数据样本,仍然达到最佳的分类准确率,主要是因为在本文改进的稀疏正则项中具有来控制稀疏强度的位置参数u,当隐藏层单元接近1时,说明该单元可能为主要特征;若隐藏层单元没有获得主要的特征,在经过迭代之后激活概率就会逐渐偏离1,使得单元不会激活而达到稀疏的目的,这就可以通过u的值来调节稀疏的力度。同时该稀疏项通过约束参数的范数使其较小,在一定程度上防止了出现的过拟合现象,因此在样本较少的情况下,本文算法仍然可以取得较好的分类结果,也可以表明LS-RBM学习到的表示比SRBM和SR-RBM具有更好的辨别力。

为了学习到深层次的特征,在RBM、SRBM、SRRBM和LS-RBM实验的基础上使用RBM隐藏单元的激活概率训练第二个RBM即DBN、SDBN、SRDBN、LS-DBN,隐藏单元仍设为10,迭代次数各为1 000。使用Pendigits数据集测试集测试每个模型的分类准确率,结果如表12和图5所示。

Table 12 Classification accuracy of Pendigits data set under 4 algorithms表12 Pendigits数据集在4种算法下的分类准确率

Fig.5 Classification accuracy of Pendigits data set under 4 algorithms图5 Pendigits数据集在4种算法下的分类准确率

观察表12和图5可知,经过微调后的LS-DBN、SR-DBN以及SDBN的分类准确率都是优于传统DBN模型的,说明通过LS-RBM、SR-RBM以及SRBM层叠起来的深度神经网络模型同样可以实现对数据的高精度识别,尤其对于Pendigits来说,本身数据集维度较低,而本文算法在样本较少的时候通过稀疏性约束仍然可以获取到其主要特征,比DBN模型分类精度提升2.7%~6.0%,进一步地证明了本文算法在低维度数据集的适用性。

4.4 训练时间对比分析

表13给出了不同算法在MNIST和Pendigits数据集的预训练和微调时间对比,其中,在MNIST上选取60 000个训练样本和10 000个测试样本,在Pendigits上选取7 000个训练样本和3 000个测试样本。从表中看出在MNIST上AE预训练和微调时间最长;SRBM、SR-RBM和LS-RBM由于在似然函数中加入了稀疏正则项,求导过程影响了训练时间,因此在两个数据集上预训练时间多于RBM模型;对于更深层次的结构,因为复杂的计算过程导致时间慢于DBN模型,但分类效果有一定的提高,本文算法和SDBN、SR-DBN的预训练时间相差仅有5 s,说明本文算法在保持稀疏模型时间性能的基础上提高了分类准确率,具有更优的分类性能。

Table 13 Comparison of training time of different algorithms表13 不同算法的训练时间对比 s

5 结束语

本文介绍了深度置信网络和基于改进的深度置信网络的原理与算法流程,首先介绍了深度置信网络模型的结构和训练过程;然后利用在似然函数中引入稀疏正则项,并提出一种改进的稀疏约束项来调节隐藏单元的稀疏性,介绍了改进的稀疏DBN的优化求解以及算法流程;最后在MNIST和Pendigits手写体数据库上进行了实验,并与两种典型的稀疏DBN模型以及自动编码器、ANN算法进行对比分析,说明本文所研究的方法具有更好的稀疏性能以及特征提取能力。但由于算法中参数值的选取是经过大量实验得到的最佳值,时间复杂度较大,因此下一步会通过优化算法比如网格搜索算法进行搜索得到最佳参数组合值。