基于密集卷积网络的X线气胸检测与定位

2019-01-06罗国婷刘志勤周莹王庆凤郑介志刘启榆

罗国婷 刘志勤 周莹 王庆凤 郑介志 刘启榆

摘 要:現有X线气胸检测存在两个主要问题:一是由于气胸通常与肋骨、锁骨等组织重叠,在临床上存在较大的漏诊,而现有算法的检测性能仍有待提高;二是现有基于卷积神经网络的算法无法给出可疑的气胸区域,缺乏可解释性。针对上述问题,提出了一种结合密集卷积网络(DenseNet)与梯度加权类激活映射的方法用于X线气胸的检测与定位。首先,构建了一个较大规模的胸部X线数据集PX-ray用于模型的训练和测试。其次,修改DenseNet的输出节点并在全连接层后添加一个sigmoid函数对胸片进行二分类(气胸/非气胸)。在训练过程中通过设置交叉熵损失函数的权重来缓解数据不平衡问题,提高模型准确率。最后,提取网络最后一个卷积层的参数以及对应的梯度,通过梯度加权类激活映射算法获得气胸类别的粗略定位图。在PX-ray测试集上的实验结果表明,所提方法的检测准确率为95.45%,并且在曲线下面积(AUC)、敏感度、特异性等指标上均高于0.9,优于VGG19、GoogLeNet以及ResNet算法,同时实现了对气胸区域的可视化。

关键词:气胸;胸部X线;密集卷积网络;类别不平衡;类激活映射

中图分类号: TP391.4文献标志码:A

Pneumothorax detection and localization in X-ray images based on

dense convolutional network

LUO Guoting1, LIU Zhiqin1*, ZHOU Ying2, WANG Qingfeng1, CHENG Jiezhi3, LIU Qiyu2

(1. College of Computer Science and Technology, Southwest University of Science and Technology, Mianyang Sichuan 621000, China;

2. Radiology Department, Mianyang Central Hospital, Mianyang Sichuan 621000, China;

3. Shanghai United Imaging Intelligence Limited Company, Shanghai 200232, China)

Abstract: There are two main problems about pneumothorax detection in X-ray images. The pneumothorax usually overlaps with tissues such as ribs and clavicles in X-ray images, easily causing missed diagnosis and the performance of the existing pneumothorax detection methods remain to be improved. The suspicious pneumothorax area detection cannot be exploited by the convolutional neural network-based algorithms, lacking the interpretability. Aiming at the problems, a novel method combining Dense convolutional Network (DenseNet) and gradient-weighted class activation mapping was proposed. Firstly, a large-scale chest X-ray dataset named PX-ray was constructed for model training and testing. Secondly, the output node of the DenseNet was modified and a sigmoid function was added after the fully connected layer to classify the chest X-ray images. In the training process, the weight of cross entropy loss function was set to alleviate the problem of data imbalance and improve the accuracy of the model. Finally, the parameters of the last convolutional layer of the network and the corresponding gradients were extracted, and the areas of the pneumothorax type were roughly located by gradient-weighted class activation mapping. The experimental results show that, the proposed method has the detection accuracy of 95.45%, and has the indicators such as Area Under Curve (AUC), sensitivity, specificity all higher than 0.9, performs the classic algorithms of VGG19, GoogLeNet and ResNet, and realizes the visualization of pneumothorax area.

Key words: pneumothorax; chest X-ray; Dense convolutional Network (DenseNet); class-imbalance; class activation mapping

0 引言

气胸(PneumoThoraX, PTX)属于胸外科和呼吸内科急症[1-2],是指在肺和胸壁之间的胸膜腔内有气体异常积聚的病症。在欧美国家,每年大约有13万~21万例气胸[3],且复发率高达35%[4]。如果发现不及时,可能导致肺完全萎缩或其他并发症,严重者将引起心肺功能衰竭,危及生命[5]。因此,气胸的早期发现及治疗尤为重要。

基于胸部X线的影像学检查是气胸最常用的一种检查方法。相较于其他影像学检查,胸部X线(胸片)具有经济高效、能清晰地显示气胸的病变特征及范围等优势。气胸在站立位胸片上呈无肺纹理暗区(图1(a)中A-1),以肺胸膜线为界,如图1(a)白色箭头所示;仰卧位胸片(图1(b))上可通过萎缩性肋膈沟(深沟征)提示气胸的存在[6-7]。但基于人工的方法检测气胸耗时、费力,且诊断结果易受医生经验等主观影响,文献[3]报道美国每年将近7.4万气胸患者因误诊或延迟诊断而耽误治疗,同时在我们国家对于少量或微量的气胸,也存在较大的漏诊[8]。 借助于计算机辅助诊断(Computer-Aided Diagnosis, CAD)系统,实现X线气胸的自动检测,可以提高诊断效率和准确率,减少漏诊。

然而,胸部X线气胸的自动检测是一项极具挑战性的工作。受气胸大小、拍摄摆位、图像质量以及放射参数等因素影响,气胸的特征变得模糊。此外,气胸容易与皮肤褶皱、锁骨、肩胛骨以及胸腔引流放置重叠,也在一定程度上影响气胸特征的提取。而气胸特征提取的准确性决定了检测结果的精度。传统的气胸检测方法需要手动设计不同的特征提取算法,如:基于特定规则提取后肋骨线和胸膜线[9]、局部和全局纹理特征分析[10]、局部二值模式和支持向量机[11]等。这些特征提取的过程较为复杂,且提取的特征可能存在信息涵盖不全等现象,从而导致气胸的检测性能不高。

随着深度學习的发展,以卷积神经网络(Convolutional Neural Network, CNN)为代表的神经网络在计算机视觉领域的成功应用[12],为CNN在医学图像病变检测方面的应用奠定了基础。CNN一般由输入层、卷积层、池化层、激活层以及全连接层组成,自动学习从原始输入到期望输出间的特征映射,相较于传统算法复杂的特征提取过程,CNN在高级抽象特征提取上的能力更显著,尤其是对细粒度图像的识别具有极大的优势和潜力[13]。文献[14]首次提出用残差网络(Residual Network, ResNet)来检测胸部疾病,并公开了一个超大规模的胸部数据集:ChestX-ray14,该算法在气胸检测上取得了较好的结果,曲线下面积 (Area Under Curve, AUC)为0.79。文献[15]采用多尺度CNN,将胸片下采样到三种不同尺寸进行训练,将AUC提高到0.911;该方法的主要问题在于未考虑其他胸部疾病对结果的影响,使得训练的模型很容易将其他疾病也归类为气胸。文献[16]通过组合不同的超参数和CNN架构训练了多个模型,最后获得了两个最佳模型:一个是基于VGG19[17]的高敏感度(0.79)模型;另一个是基于GoogLeNet[18]的高特异性(0.97)模型。由于它们的主要目标是检测气胸危急情况,因此在训练数据中只纳入了中等和大量气胸,而忽略了少量气胸。

综上,虽然现有基于深度学习的气胸检测方法能有效提升检测性能,但仍存在三个局限:一是大部分研究使用的数据集是ChestX-ray14,该数据集来自欧美患者,成像参数及体格均与国内有明显差异,此外标签的获取是通过文本挖掘技术,据报道,气胸标签和放射科医生标注的一致性仅为60%[16],数据标签的错误也会导致检测性能的下降;此外,目前还缺乏适用于国内的大规模数据集。二是现有算法并没有提到少量气胸的检测,尤其是文献[16]将少量气胸完全排除在外,且气胸的检测性能有待提高。三是由于CNN和其他深度网络没有直观和易于解释的组件,就像一个“黑匣子”,使得现有基于深度学习的气胸检测方法缺乏可解释性;而要让人们建立起对CAD气胸检测系统的信任,就必须使模型透明和易于解释。

目前对CNN的可视化已有较多的研究成果,如:文献[19-21]通过突出“重要”像素点,即改变那些对预测值有很大影响的像素点强度而使CNN预测可视化,但这些方法不具类别判别能力。文献[22]通过修改CNN架构,用卷积层和全局平均池化层(Global Average Pooling, GAP)代替全连接层,并用特定类别的类激活映射(Class Activation Mapping, CAM)图表示CNN识别该类别而关注的图像区域;但CAM的缺点是需要修改网络架构,且修改后的网络会损失一定的精度。文献[23]在CAM基础上提出了梯度加权CAM(Gradient-weighted CAM, Grad-CAM)算法,该算法不需要修改网络架构或重新训练网络,可以从任何基于CNN的网络生成不同类别对应的视觉解释。

针对上述数据集的局限性,本文的首要工作是构建一个国内X线气胸的较大规模数据集,同时考虑到目前在临床上对少量气胸的检测存在较大的漏诊,因此在构建数据集时通过增加少量气胸的比重和采用数据增强来提升模型对少量气胸的拟合能力。其次,本文提出基于密集卷积网络(Densely Convolutional Networks, DenseNet)[24]的改进算法检测气胸,结合DenseNet具备网络较深、能够融合浅层与深层特征进行分类的优势,修改密集卷积网络的输出节点并在全连接层后添加一个sigmoid函数检测气胸。此外,为了减少数据不平衡带来的影响,提出一种加权的交叉熵损失函数训练策略,以期提高准确率。最后,本文将DenseNet与Grad-CAM算法结合,生成气胸的定位热力图,从而增加卷积网络的可解释性。

1 数据集及其预处理

1.1 数据集创建

由于国内目前还没有公开可用的胸部X线气胸数据集,因此本文构建了一个国内的较大规模数据集:PX-ray,用于模型的训练及测试。PX-ray来源于绵阳市中心医院,首先通过检索图像存档与通信系统(Picture Archiving and Communication System, PACS)中2010年1月到2018年6月气胸的临床报告数据库,确定候选范围。然后,再使用关键词“气胸”筛选出阳性组的候选图像;阴性组的纳入图像通过搜索阴性短语(如心肺无异常)和纳入不符合阳性纳入标准的同期胸片来确定。阴性组的选取采用以上两种纳入方法可确保阴性组里不仅有正常的胸片,同时包含除气胸外的其他胸部疾病的胸片。最后,用定制的自动化图像下载工具从PACS里提取候选图像及诊断报告。为了保证医院及病人隐私安全,对所有数据进行匿名化处理,包括删除病人姓名及机构名等敏感信息。最终成功获取12050例后前位胸片。

1.2 数据集标注

数据标注过程分为粗标注和细标注两步。粗标注由文本报告生成,将文本中包含“心肺无异常”或不包含“气胸”的影像标记为0,表示无气胸;将文本中包含“气胸”的影像标记为1,表示有气胸。经过粗标注后,可以确保标记为0的影像都不包含气胸,但标记为1的影像需要再次排查。细标注时,再次从标记为1的影像对应文本中提取关键字“可疑” “考虑” “气胸基本吸收” “气胸好转”等不确定性词组,将该部分病例提取出来,交给有经验的放射科医生再次核实。之所以不丢弃这些疑问数据,主要是这部分数据正是比较难诊断的少量气胸,对模型的训练非常重要。提取文本中每例气胸的大小,结果如图2所示。由图2可以看出,少量及微量气胸(20%以内)占了气胸例数的一半(3055/5650),使得模型更有利于学习到少量气胸的特征。

1.3 数据预处理

由于原始胸部X线的像素由12位组成,其像素强度在0到4095之间,这使得像素间信息非常丰富,但也会导致高光噪声[11]。基于这一原因,将原始像素转换為8位,即像素强度变为0到255之间,并对图像作归一化处理,如式(1):

其中:X代表原始图像像素矩阵;Xmin和Xmax分别是原始图像的最小和最大值;Xnorm是进行归一化和强度变换后的像素矩阵。

将PX-ray所有数据打乱重组,按照60%/20%/20%的比例分成训练集、验证集和测试集,以便所有训练和评估实验都使用相同的数据集。为保证模型对未知数据的泛化能力,三个数据集的图像互不交叉。此外,本文在训练时通过随机水平翻转以及随机裁剪方法实现数据增强。数据增强不仅可以扩大训练数据,还可以进一步提升模型的泛化能力。

2 气胸检测网络

2.1 基于DenseNet的网络架构设计

DenseNet的主要结构为密集块(Dense Block, DB)和过渡块(Transition Block, TB)。Dense Block用前馈的方式将每一层(Layer)的特征图(feature maps)直接传递给后面所有层,使用级联方式,使得每一层都接受来自前面层的特征映射。假设Xl表示第l层的feature maps,它接收所有以前层,包括X0,X1,…,Xl-1层的feature maps,如图3(a)所示,则有:

Xl=Hl([X0,X1,…,Xl-1])(2)

其中,Hl为复合函数,由批量归一化(Batch Normalization, Batch Norm)、整流线性单元(Rectified Linear unit, ReLu)及卷积(Convolution, Conv)等组成。

考虑到特征融合后输入的特征图数量仍然很多,为了减少其数量及降低维度而加入了瓶颈层(Bottleneck Layer),即在Dense Block的每个Layer中加入1×1的卷积,其后添加3×3、生长率(Growth Rate)为32的卷积用于提取特征。每次卷积前都先进行Batch Normalization以及ReLu激活,从而提高网络的泛化性和避免梯度消失问题。此外,本文在卷积后加入随机失活正则项(Dropout)层,概率设为0.25来避免网络过拟合。Layer细节如图3(b)所示。

为了进一步压缩参数和降低维度,在Dense Block 之间加入了Transition Block。假设Dense Block输出m个feature maps,则通过Transition Block中的1×1卷积生成θm个feature maps,其中θ属于(0,1),以此来减少feature maps的数量。与Dense Block一样,卷积前先进行Batch Norm 以及ReLu。再通过2×2的平均池化(Average pooling, Avg pool)降低feature maps的大小, 如图4所示。在本文中,每经过一个Transition Block,feature maps的数量及大小均减半。

气胸的检测属于二分类任务,即存在或不存在气胸。因此,本文基于DenseNet的两种主要结构,构建了一个121层的特征提取网络,如图5所示。首先将图像输入7×7的卷积层获取特征。然后,再经过3×3的最大池化简化网络计算复杂度,之后经过4个Dense Block来提取更抽象的特征,Dense Block layers的数量分别为6、12、24和16,并在最后一个Dense Block后添加一个Batch Norm层,对最后一个卷积层的输出进行归一化。最后,将DenseNet的输出节点修改为2,并在其后添加一个sigmoid层获取气胸的检测概率。

本文基于改进的DenseNet提取气胸特征的优势主要体现在以下3方面:

1)省参数。网络中的每一层都直接与其前面层相连,实现feature maps的重复利用;同时可以把网络的每一层都设计得特别窄,即只学习非常少的feature maps,减少了冗余特征。此外,通过添加瓶颈层和过渡层,又再一次降低了参数量。这对于工业界而言,小模型可以显著地节省带宽,降低存储开销。

2)省计算。由于网络的每一个卷积层都比较窄,通道数均为32,而一般卷积网络更深层的卷积通道数都有上千个。因此DenseNet的卷积计算量非常低。

3)抗过拟合。由于DenseNet 可以综合利用浅层复杂度低的特征,因而更容易得到一个光滑的具有更好泛化性能的决策函数;同时加入了Dropout正则化项,因此具有非常好的抗过拟合性能[25]。

2.2 加权交叉熵损失函数

传统的交叉熵损失函数(Cross Entropy Loss function, CELoss)因不同类别的训练样本数目不平衡,从而导致网络训练时侧重样本数目较多的类别,而“轻视”样本数目较少的类别,这样网络泛化能力就会受到影响。

本文通过在CELoss中设置权重系数w,让小样本乘以较大的权重,大样本乘以较小的权重,来缓解因数据不平衡造成的影响。加权CELoss(Weighted CELoss, WCELoss)可表示为:

L(X,y)=-ω+y lg ρ(Y=1|X)-

ω-(1-y)lg ρ(Y=0|X)(3)

其中:ρ(Y=i|X)代表网络预测为i类的概率;ω+=(|P|+|N|)/|P|,ω-=(|P|+|N|)/|N|,|P|、|N|分别为训练集每一批次中气胸的阳性病例数和阴性病例数。就本文的研究而言,气胸的病例较少于非气胸病例。采用这种方法,使得网络在每一批次训练时,气胸类样本的损失就会加大,从而减轻数据不平衡带来的影响。

3 基于Grad-CAM的气胸区域定位

已有研究证明CNN中的更深层次主要捕获更高层次的语义信息[25-26],此外,卷积层保留了在全连接层中丢失的空间信息,因此可以大膽猜测网络最后的一个卷积层在高级语义和空间信息之间达到最好折中,这些层中的特征图能在图像中寻找语义类特定的信息(比如对象部分)。Grad-CAM就是利用流进CNN最后一个卷积层的梯度信息,然后将该信息反向传播到卷积层,以此来了解该卷积中的每个特征图对特定类做决策的重要性。将卷积层的特征图与其对应的重要性权重相乘就得到了特定类的定位图,实现对气胸的弱监督定位。Grad-CAM算法的流程如图6所示,具体算法步骤如下:

1)假设LcGrad-CAM∈Rμ×ν为类别c的类别定位图,其中μ和ν分别是类别c的宽度和高度。

2)计算类别c的得分梯度yc,yc是sigmoid层之前,即本文算法中的Linear层(图5)的输出结果,维度为2。

3)提取网络最后一个卷积层参数,在本文中,最后一个卷积层的大小为7×7,通道数(卷积核)为1024,将yc分别对1024个特征图(记Ak,表示第k个特征图)求偏导,就得到了第k个特征图的梯度。

4)分别对k个特征图的梯度求像素平均,获得该特征图的重要性权重αck:

αck=1Z∑i∑jycAk(4)

其中:权重αck表示第k个特征图对类别c决策的重要性; Z为Ak的像素数,Aki, j为Ak中(i, j)处的像素值。

5)将k个特征图与其对应的权重αck相乘再求和就得到了LcGrad-CAM。由于对类别c有正影响的那些特征值应该被关注,而有负影响的特征值应被舍弃,所以在上述基础上添加一个ReLu函数。ReLu函数将负值的特征变为0,从而减少负值对结果的干扰。LcGrad-CAM的计算式如式(5):

LcGrad-CAM=ReLu(∑kack·Ak)(5)

6)由上述得到的类别c定位图尺寸与最后一个卷积层尺寸相同,均为7×7。因此,为了更好的可视化结果,本文将Grad-CAM上采样到输入图像大小,并与输入进行叠加形成最终的定位热力图(Localization heat map)。

Grad-CAM算法为模型提供可靠的可视化解释,它直观地阐释了模型是看图像哪个区域而做的决策。这种方法的优势在于:首先不需要对图像进行细致的气胸区域标注,减少了标注的成本;其次可以结合任意基于CNN的网络,而不需要修改或重新训练网络,扩展性较好。

4 实验与结果分析

4.1 评价指标

为全面衡量本文所提模型对气胸的检测性能,采用曲线下面积(AUC)、错误率(Error Rate, Error)、敏感度(Sensitivity, Se)、特异度(Specificity, Sp)、阳性预测值(Positive Predictive Value, PPV)和阴性预测值(Negative Predictive Value, NPV)作为评价指标,计算式分别如下:

Se=TPTP+FN(6)

Sp=TNTN+FP(7)

PPV=TPTP+FP(8)

NPV=TNTN+FN(9)

其中:TP为真阳性样本数;TN为真阴性样本数;FP为假阳性样本数;FN为假阴性样本数。

此外,模型的时间复杂度和空间复杂度也是衡量模型好坏的重要指标[27]。时间复杂度决定了模型训练或预测需要运算的次数,空间复杂度决定了需要学习的参数数量。时间复杂度通常以浮点运算次数(FLoating-point OPerations, FLOPs)来衡量,空间复杂度则以模型参数数量(Parameters)来衡量。对于卷积神经网络,时间复杂度和空间复杂度的计算分为卷积层和全连接层。对于每个卷积层,其时间复杂度和空间复杂度分别为:

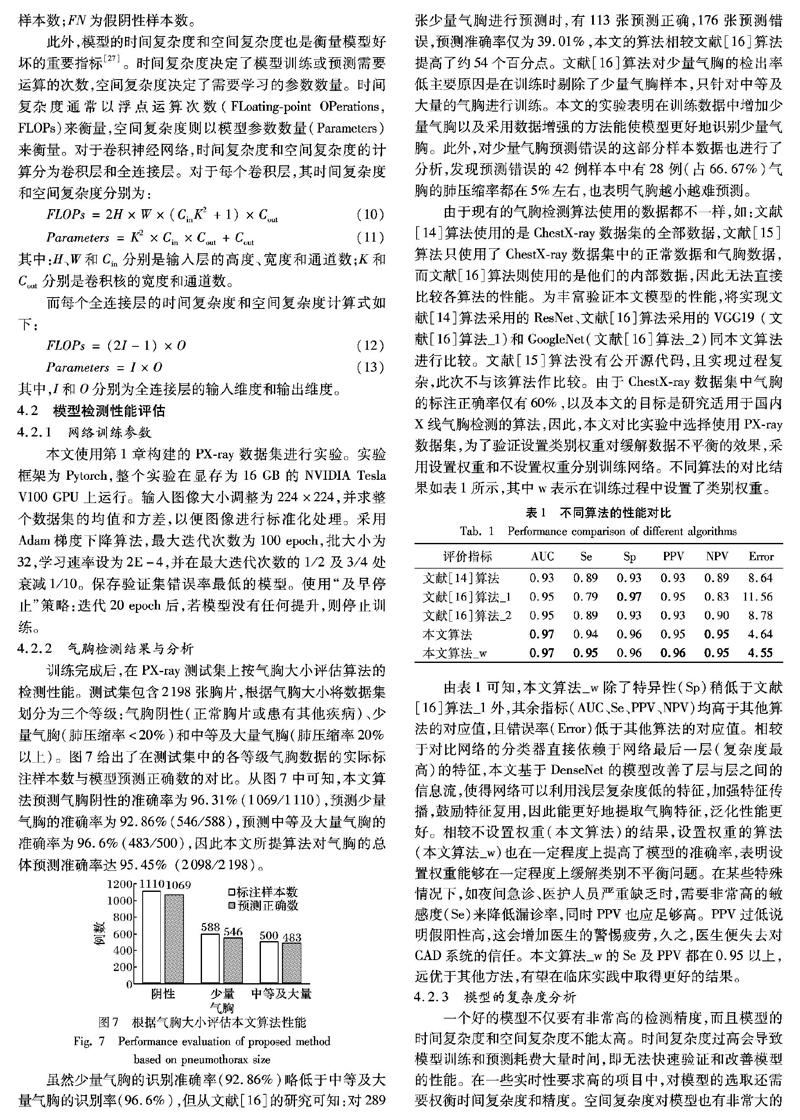

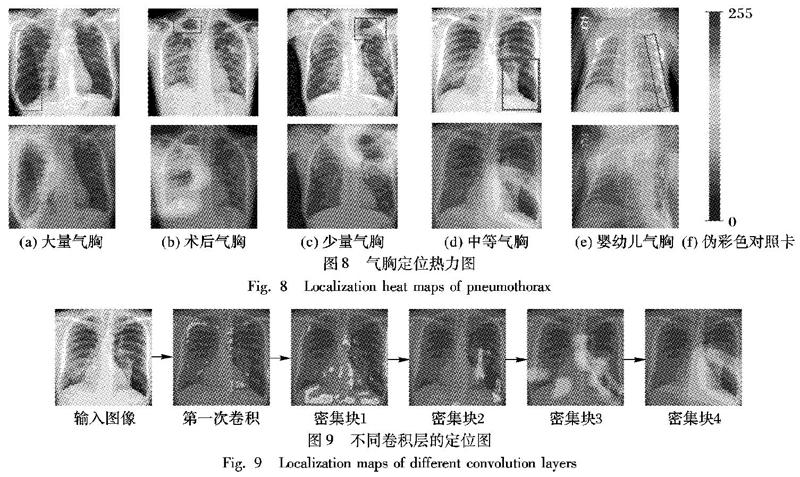

从表2中可以看出:雖然文献[14]模型基于ResNet的模型空间复杂度最低,但对内存的消耗却是最大的。文献[16]的基于VGG19(文献[16]模型_1)和GoogLeNet(文献[16]模型_2)的两个模型,在较少的卷积层数下,时间复杂度和空间复杂度都非常高。由于气胸是胸部的危急症,本文算法希望能在X线检查中实时监控,因此对模型的时间复杂度和精确度的要求较高,而本文基于DenseNet的模型在确保高准确度的同时,时间复杂度也是所有模型中最低的;此外,空间复杂度以及内存消耗也取得了较好的折中效果。综合来讲,本文模型可以满足临床的高需求。

4.3 气胸定位性能评估

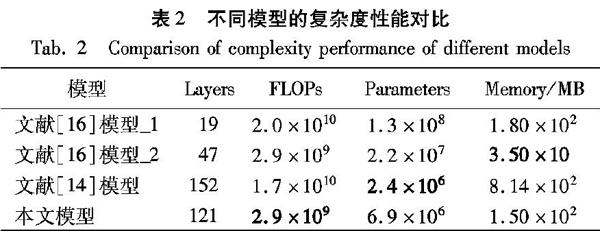

对于DenseNet判定为气胸的图像,本文不仅给出气胸的概率值,同时应用Grad-CAM方法对可疑气胸区域粗略定位,缩小医生查找病灶的范围。图8给出了本文模型在部分测试集的定位结果,图中矩形框是由医生标注的气胸区域。由图8可以看出:图8(a)为右侧大面积气胸,模型很好地检测到气胸区域;图8(b)虽然没有直接检测到右侧少量气胸,但识别出了术后气胸的典型特征(胸管);图8(c)左侧少量气胸被模型准确识别;图8(d)是左侧中等量气胸;图8(e)为婴幼儿气胸;图8(f)是热力图伪彩色转换对照卡,越靠近255的区域表示对气胸检测越重要。从可视化定位图中可以看出,本文模型确实很好地拟合了气胸的特征,比如:大面积的无纹理暗区、胸管以及位置信息(均位于肺的四周)等。

图9显示的是不同卷积层对气胸区域定位的重要性。从图9中可以发现,网络前面的卷积层主要提取空间信息,而最深的卷积层提取的语义信息最丰富,可视化效果也最好。

5 结语

本文充分利用DenseNet在特征提取方面的优势以及Grad-CAM可视化方法,提出了一个121层的深度CNN模型,实现了X线气胸(包括少量气胸)的自动检测及定位。本文所提模型准确率更高,不仅避免了人工提取特征的复杂性和局限性,同时增加了深度学习算法的可解释性,并且采用了数据扩充的方法使模型能更好地拟合少量气胸。通过给少数样本较大的损失权重,在一定程度上缓解了数据不平衡问题,提高了模型的性能。实验结果表明,本文方法具有非常高的灵敏度及特异性,可辅助医生提高气胸诊断效率,减少漏诊误诊。

尽管本文有意将尽可能多的不同临床环境(包括体检、门诊、急诊及重症监护室)和不同年龄段人群(婴幼儿、成人及老人)的胸片纳入其中,但上述训练及测试的数据都是来自同一个机构,如何使本文方法适用于更广泛的临床环境是下一步的研究方向。

参考文献 (References)

[1]王朝,邹卫.原发性自发性气胸病因研究进展[J].临床肺科杂志,2015,20(6):1120-1122,1126.(WANG C, ZOU W. Progress in study of primary spontaneous pneumothorax [J]. Journal of Clinical Pulmonary Medicine, 2015, 20(6): 1120-1122, 1126.)

[2]THOMSEN L, NATHO O, FEIGEN U, et al. Value of digital radiography in expiration in detection of pneumothorax [J]. RoFo: Fortschritte auf dem Gebiete der Rontgenstrahlen und der Nuklearmedizin, 2014, 186(3): 267-273.

[3]BINTCLIFFE O, MASKELL N. Spontaneous pneumothorax [J]. British Medical Journal, 2014, 348: g2928.

[4]SUTHAR M, MAHJOUBFAR A, SEALS K, et al. Diagnostic tool for pneumothorax [C]// Proceedings of the 2016 IEEE Photonics Society Summer Topical Meeting Series. Piscataway: IEEE, 2016: 218-219.

[5]MACDUFF A, ARNOLD A, HARVEY J. Management of spontaneous pneumothorax: British thoracic society pleural disease guideline 2010 [J]. Thorax, 2010, 65(S2): ii18-ii31.

[6]OCONNOR A R, MORGAN W E. Radiological review of pneumothrax [J]. British Medical Journal, 2005, 330(7506): 1493-1497.

[7]SEOW A, KAZEROONI E A, PERNICANO P G, et al. Comparison of upright inspiratory and expiratory chest radiographs for detecting pneumothoraces [J]. American Journal of Roentgenology, 1996, 166(2): 313-316.

[8]穆魁津.谈谈气胸的诊断方法[J].中国实用内科杂志,1995,15(4):205-206.(MU K J. Discussion on the diagnosis of pneumothorax [J]. Chinese Journal of Practical Internal Medicine, 1995, 15(4): 205-206).

[9]SANADA S, DOI K, MACMAHON H. Image feature analysis and computer-aided diagnosis in digital radiography: automated detection of pneumothorax in chest images [J]. Medical Physics, 1992, 19(5): 1153-1160.

[10]GEVA O, ZIMMERMAN-MORENO G, LIEBERMAN S, et al. Pneumothorax detection in chest radiographs using local and global texture signatures [C]// Proceedings of the Medical Imaging 2015: Computer-Aided Diagnosis, SPIE 9414. Bellingham: SPIE, 2015: Article No. 94141P.

[11]CHAN Y H, ZENG Y Z, WU H C, et al. Effective pneumothorax detection for chest X-ray images using local binary pattern and support vector machine [J]. Journal of Healthcare Engineering, 2018, 2018: Article No. 2908517.

[12]LECUN Y, BOSER B, DENKER J S, et al. Handwritten digit recognition with a back-propagation network [C]// Proceedings of the 1989 International Conference on Neural Information Processing Systems. San Francisco: Morgan Kaufmann Publishers Inc., 1989: 396-404.

[13]何雪英,韓忠义,魏本征.基于深度卷积神经网络的色素性皮肤病识别分类[J].计算机应用,2018,38(11):3236-3240.(HE X Y, HAN Z Y, WEI B Z. Pigmented skin lesion classification based dermoscopic images using deep convolutional neural network [J]. Journal of Computer Applications, 2018, 38(11): 3236-3240).

[14]WANG X, PENG Y, LU L, et al. Chestx-ray8: hospital-scale chest X-ray database and benchmarks on weakly-supervised classification and localization of common thorax diseases [C]// Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2017: 3462-3471.

[15]JUN T J, KIM D, KIM D. Automated diagnosis of pneumothorax using an ensemble of convolutional neural networks with multi-sized chest radiography images [EB/OL]. [2019-03-22]. https://arxiv.org/ftp/arxiv/papers/1804/1804.06821.pdf.

[16]TAYLOR A G, MIELKE C, MONGAN J. Automated detection of moderate and large pneumothorax on frontal chest X-rays using deep convolutional neural networks: a retrospective study [J]. PLOS Medicine, 2018, 15(11): e1002697.

[17]SZEGEDY C, LIU W, JIA Y, et al. Going deeper with convolutions [C]// Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2015: 1-9.

[18]SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition [EB/OL]. [2019-03-22]. https://arxiv.org/pdf/1409.1556.pdf.

[19]PINHEIRO P O, COLLOBERT R. From image-level to pixel-level labeling with convolutional networks [C]// Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2015: 1713-1721.

[20]RIBEIRO M T, SINGH S, GUESTRIN C. “Why Should I Trust You?”: explaining the predictions of any classifier [EB/OL]. [2019-03-22]. https://arxiv.org/pdf/1602.04938.pdf.

[21]FANG H, GUPTA S, IANDOLA F, et al. From captions to visual concepts and back [C]// Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2015: 1473-1482.

[22]ZHOU B, KHOSLA A, LAPEDRIZA A, et al. Learning deep features for discriminative localization [C]// Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2016: 2921-2929.

[23]SELVARAJU R R, COGSWELL M, DAS A, et al. Grad-CAM: visual explanations from deep networks via gradient-based localization [C]// Proceedings of the 2017 IEEE International Conference on Computer Vision. Piscataway: IEEE, 2017: 618-626.

[24]HUANG G, LIU Z, VAN DER MAATEN L, et al. Densely connected convolutional networks [C]// Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2017: 2261-2269.

[25]BENGIO Y, COURVILLE A, VINCENT P. Representation learning: a review and new perspectives [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2013, 35(8): 1798-1828.

[26]MAHENDRAN A, VEDALDI A. Visualizing deep convolutional neural networks using natural pre-images [J]. International Journal of Computer Vision, 2016, 120(3): 233-255.

[27]楊真真,匡楠,范露,等.基于卷积神经网络的图像分类算法综述[J].信号处理,2018,34(12):1474-1489.(YANG Z Z, KUANG N, FAN L, et al. Review of image classification algorithms based on convolutional neural networks [J]. Journal of Signal Processing, 2018, 34(12): 1474-1489.)

This work is partially supported by the Science and Technology Program of Sichuan Province (2019JDRC0119).

LUO Guoting, born in 1995, M. S. candidate. Her research interests include medical image analysis, deep learning.

LIU Zhiqin, born in 1962, M. S., professor. Her research interests include medical image analysis, high performance computing.

ZHOU Ying, born in 1984, Ph. D., attending physician. Her research interests include tumor image analysis, deep learning.

WANG Qingfeng, born in 1988, Ph. D, lecturer. Her research interests include medical image analysis, computer-aided diagnosis.

CHENG Jiezhi, born in 1980, Ph. D. His research interests include medical image analysis, pattern recognition.

LIU Qiyu, born in 1963, M. S., chief physician. His research interests include medical image analysis, interventional radiology.

收稿日期:2019-05-27;修回日期:2019-07-23;录用日期:2019-07-24。基金项目:四川省科技计划项目(2019JDRC0119)。

作者简介:罗国婷(1995—),女,四川绵阳人,硕士研究生,CCF会员(88023G),主要研究方向:医学图像分析、深度学习; 刘志勤(1962—),女,四川绵阳人,教授,硕士,CCF会员,主要研究方向:医学图像分析、高性能计算; 周莹(1984—),女,四川绵阳人,主治医师,博士,主要研究方向:肿瘤图像分析、深度学习; 王庆凤(1988—),女,四川安岳人,讲师,博士,CCF会员,主要研究方向:医学图像分析、计算机辅助诊断;郑介志(1980—),男,中国台湾人,博士,主要研究方向:医学图像分析、模式识别; 刘启榆 (1963—),男,四川广元人,主任医师,硕士,主要研究方向:医学图像分析、介入放射学。

文章编号:1001-9081(2019)12-3541-07DOI:10.11772/j.issn.1001-9081.2019050884