基于LSTM长短期记忆网络的情感分析

2018-09-14张原溥

张原溥

1 引言

随着网络媒体的飞速发展,大量用户已经习惯用视频通话来与亲朋好友交流,从而产生了庞大的数据量和各种各样的微表情。这些微表情不仅表达了用户本人的思想感情,还带有极高的社会价值。为此,分析这些微表情中蕴藏的情感已经成为当下研究热点之一。

人工神经网络[1]是对人脑神经元网络进行信息处理以达到抽象的目的,由大量的节点(或称神经元)相互联接构成。前馈神经网络FNN[2]就是最简单的人工神经网络之一,它由输入层、输出层及隐含层三种层构成。它可以接受输入并进行输出,但由于各层之间没有反馈,FNN没有记忆功能,处理数据时只能使用当前时刻信息,这样便不能将捕获到的微表情保留下来供以后使用。为了改进这一缺点,Jordan和Elman率先提出了循环反馈的神经网络RNN[3]。1997年Hochreiter&Schmidhuber提出了用长短期记忆单元LSTM[5]来改进传统的RNN模式,才有效解决了梯度消失与梯度爆炸的问题。针对以上神经网络的优劣势,本文提出基于LSTM的微表情分析模型——双门LSTM模型,以提高对微表情的情感分析能力。

本文具体章节安排如下:第二节介绍了FNN、RNN与LSTM的运作机制,寻找差异并比对了各自的优缺点;第三节阐述了自己的双门LSTM模型,并介绍其工作原理;第四节将双门LSTM模型运用到情感分析当中,实现长短时记忆网络模型在一段微表情片段中的应用,针对微表情小视频对人进行情感分析;第五节进行实验,进一步改进双门LSTM模型;第六节总结归纳实验结果,并在人工神经网络知识的基础下整理模型,得出情感分析的最终优化方法,同时说明自己的局限性,指出后续的工作方向。

2 相关工作

FNN是传统的人工神经网络,又叫前馈神经网络,FNN在输入层处接收前一层的输出,并在输出层处输出给下一层。但由于FNN每个神经元只与前一层的神经元相连[2],导致了各层间没有反馈。针对FNN的无法记忆的问题,Jordan和Elman率先提出了循环反馈的神经网络RNN[3]。隐含层能够保存并利用历史信息来辅助处理当前数据,可以将信息持久化,这也导致了梯度的不断减小甚至于消失[6],这种现象也被称为梯度爆炸。

Hochreiter & Schimidhuber提出了用长短期记忆单元LSTM改进传统的RNN模式,普通的RNN的重复模块结构非常简单,只有一个tanh层[7]。调节门由一个Sigmoid神经网络层和一个元素级相乘操作组成[8]。虽然LSTM有很好的利用长距离历史信息的能力,但是它毕竟只能够利用一种数据。针对这一缺陷,本文提出了双门LSTM模型。

图1 双门LSTM示意图

3 双门LSTM模型

与普通LSTM单元类似,双门LSTM单元也同样由输入门、输出门、遗忘门以及记忆单元组成。但是双门LSTM门的个数却要多一些:双门LSTM模型拥有2个输入门、2个遗忘门,但它的输出门也只有1个。

由图1我们可以观察到双门LSTM模型也是由输入层、输出层及隐含层构成。

(1)首先我们根据传统RNN公式1计算出当前记忆单元候选值,与当前时刻输入值和上一时刻输出值有关:

(2)第二步我们计算输入门的值it。输入门用于控制我们要更新哪些信息,控制当前信息对记忆单元造成的影响。需要注意的是,输入门的计算还与上一时刻记忆单元的值有关:

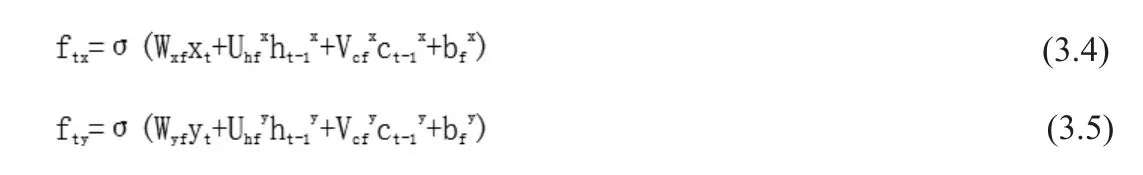

(3)第三步计算遗忘门的值ft。遗忘门决定我们要从当前历史信息中扔掉哪些信息,控制历史信息对当前记忆单元状态值的影响:

(4)第四步计算当前记忆单元状态值ct,当前时刻记忆单元状态值取决于上一时刻的记忆单元状态值ct-1与候选记忆单元状态值,并受遗忘门与输入门两部分进行调节:

(5)第五步计算输出门ot,用于控制记忆单元状态值的输出:

(6)最后计算当前时刻LSTM单元的输出:

其中xt、yt分别对应这一时刻x、y方向上的输入,ht-1对应上一时刻的输ht-1x、

4 基于LSTM的模型的应用

长短期记忆网络LSTM在许多方面都取得了不错的效果,例如翻译语言、制机器人以及语音识别等。然而普通的LSTM由于只有一个输入门,只能固定的获得一种信息,并不能很好的分析情感,尤其是微表情这种人们可能刻意掩的信息。此模型优势在于遗忘门在不断遗忘一些已失去效用的微表情,从而控制历史信息对当前时刻分析的影响,既充分利用了历史信息又不至于失去效用的历史信息积累过多。再结合输入门每一刻输入的微表情数据信息,LSTM便可分析出人的情感。因为结合生活经验与对微表情的观察,我们可以知道人的面部在产生微表情时,他的身体可能会同时产生一些不由自主的动作,例如抖肩、揉鼻子、眼睛向两侧看等等。这样的肢体语言为我们多提供了一种信息,恰好可以辅助我们分析情感。基于上述思路,本文提出了双门LSTM模型运用于情感分析,该双门LSTM模型的优势便在于此。它通过对微表情与肢体语言两种信息的分析处理,并将其综合起来,得出了更为准确的情感数据。改进了普通LSTM模型只能运用一种信息的不足。

表1 隐含层数目与误差的关系

5 实验

为了验证基于LSTM模型的双门LSTM的有效性并进一步改进该模型,本文使用The Extended Cohn-Kanade Dataset(CK+)数据库[9],并采用监督学习的方式(因为双门LSTM模型的样本类别是已知的,即微表情和肢体语言两类),将双门LSTM模型做了不同的改变并进行了对比。显而易见的是,最优的双门LSTM模型便是实际图像能够与目标图像(即理论上误差最小的图像)收敛。双门LSTM模型的图像扔难以收敛,且误差一直在上下振荡。随着隐含层数的增多,双门LSTM模型最初的误差逐渐降低,并且收敛所需的训练次数也越来越少,即越来越容易收敛,最后将在目标图像附近波动。实验数据整理如表1:

结合表1可知,隐含层数较少时,图像难以收敛,误差较大且不断振荡;隐含层数增多时,图像收敛所需的训练次数越来越少,误差减小;隐含层数目多到一定值时,即使再增加隐含层,误差也不能再次下降,而是在一定范围内波动。因此选择隐含层数较多的双门LSTM模型将更有利于分析情感。

6 总结与展望

本文将普通的LSTM延伸到双门的LSTM模型上,从而得以同时运用微表情与肢体语言两种信息,以便更好地分析人的情感,同时进行了实验对比,得出了隐含层数与误差之间的关系,明白选择隐含层数较多的双门LSTM模型将更有利于分析情感,进一步优化了双门LSTM模型。

由于时间与技术的原因,本文并没有实际做实验去比对普通LSTM与双门LSTM模型的误差曲线,仅仅是从理论分析上比较了一下,认为同时运用两种数据的双门LSTM模型的分析将更加准确。同时,双门LSTM模型的具体实现也亟待解决。下一步的工作也将从这两个角度展开,以便更好地处理有关微表情片段的情感分析问题。