基于运动行为的复杂监控事件探测

2012-07-30梁浩哲王振华徐树奎李国辉

梁浩哲,王振华,徐树奎,李国辉

(1.国防科技大学 系统工程系,湖南 长沙410073;2.上海海洋大学 信息学院,上海201306)

面向监控视频的语义事件探测技术是目前的研究热 点[1-2].Hamid[3]使 用n-gram 模 型 表 示 事 件 序列,利用图聚类序列集而得到潜在事件结构;Nevatia提出了监控视频领域的本体模型[4];Lavee等[4]将本体语义转译为Petri网模型,完成事件识别与推理.目前研究多采用手动标注形成场景事件训练集,通过事件的低层特征描述探测场景中的简单事件.与新闻视频与体育视频不同,监控视频事件不具备明显的单元结构性,很难做到精细的事件标注,因此需要一种主动事件学习模型.

监控场景中,运动目标的行为状态是描述语义事件的重要信息线索,通过分析状态特征间的关联可实现对事件要素的自学习.Xiang等[5-6]使用 Pixel Change History模板描述行为,基于Gaussian混合模型聚类得到场景中的基本事件集;Cedric等[7]使用决策树对轮廓特征量进行聚合分析,实现场景事件识别.在上述研究中,通过特征挖掘事件属于一种低层数据驱动的方式,对噪声影响具有较强的鲁棒性,但是相应的“自下向上”的方式在事件时空语义描述方面存在较差的伸缩性,而透过“专家”的领域知识灵活建立事件描述模型可以弥补以上缺陷.

针对以上问题,本文提出一种监控视频的复杂事件探测模型,通过聚类学习得到场景的行为模式,以其作为语义事件的组成要素;其后使用Petri网构建基于运动行为的语义事件时序关系模型.在实验中,给出了测试视频中的基本行为模式及其语义表达,并通过“停留”与“偷车”两个具体的事件案例演示了探测过程的建模有效性与可扩展性,探测结果表明了模型的有效性.

1 复杂监控事件探测模型

针对监控上下文,可使用三个层次刻画其潜在语义结构(图1):运动行为集a={ai};行为模式A={Ai};复杂语义事件E={Ei}.

图1 事件探测模型Fig.1 Events detection model

本文通过blob特征描述行为矢量[7]:

其中:xc,yc为blob质心坐标;sh,sw为检测框尺寸;V为速率;u,v为方向.在环境约束条件下,行为按一定规则运动,因此ai间存在较强的特征关联.基于此假设,事件探测模型由双层语义关系构成(图1).

对行为样本集a聚类:

式中:ai∈a,Ai∈A,构成行为模式集A= {Ai},回答监控场景中“有什么”的问题.

以A为组成要素,按照特定时序关系构成语义事件集E={Ei},存在模式间的时序约束:

式中:A'⊂A,为模式子集;Ei∈E,解决模式间“关联”问题.对应式(1),(2),事件探测过程分为两步:①使用DBSCAN聚类模型学习行为样本集a={ai}的潜在结构,形成行为模式表;② 使用Petri构建模式间的连续、并行等时序关系,构成语义事件集E={Ei},并完成事件探测.

2 基于DBSCAN聚类的行为模式学习

2.1 行为特征提取

对于视频序列,使用平均背景建模加光流场运动估计[8]完成行为特征提取.目标矢量为

步骤1:blob位置与尺寸提取.前景对象条件:

其中:t为当前时刻;B为累积背景均值;f为当前帧;σ为背景累积方差.经过形态学运算并四连通域分析,得blob集:bt={bt1,bt2,…btn}(如图2,第2列所示).针对bti,尺寸框为

式(3)~(6)中,∀x,y∈bti.图2,第3列为尺寸检测框;图2,第4列为绿色质心点.

步骤2:速度估计.使用h帧平均速度:

式中,centriod(·,t)为t时刻 blob质心矢量,‖·‖为欧氏范数,实验中使用h=8.

步骤3:方向估计.对bti,计算其光流值:

flow 为 Lukas-kanade算子,[u,v]jti为光流集,平均方向角为

得归一化平均光流方向(如图2,第5列):

图2 基于blob状态矢量提取运动行为特征Fig.2 Extraction of foreground blob

使用式(3)~(9),计算视频序列F得行为样本集a={ai}.

2.2 运动行为DBSCAN聚类

DBSCAN是一种基于密度的特征矢量聚类模型[9],可以解决行为样本集a聚类中存在的以下问题:① 模式集A={Ai}内部结构无先验知识,类数n难以提前确定,DBSCAN仅需定义样本间距离;②行为特征的时空分布并不规则,DBSCAN聚类可形成任意形状分布,而K-means,Gaussian混合等聚类法的类圆型聚类形状存在局限性;③DBSCAN的孤立点识别具有较强的抗噪能力.

使用DBSCAN聚类模型给出行为样本学习模型如下[9]:

(1)定义行为ai的状态值ε邻接域:

其中,dist(·)为行为矢量间距离.

(2)行为ai到aj的直接密度可达(本文称为直接状态可达):

如果aj∈Nε(ai)∀|Nε(ai)|≥MinPts

MinPts为孤立点阈值,与样本点密集程度相关.

(3)通过ai到aj的状态直接可达的传递性定义状态可达.

(4)ai到aj的密度联通(称为状态联通):如果存在ak,使得ai与aj到ak都状态可达.

(5)A={Ai}模式集定义:

Ai:∀ai,aj如果ai∈Ai满足aiaj的直接可达,则aj∈Ai.

Ai:∀ai,aj∈Ai满足,ai到aj是状态联通.

由于特征分量间存在量纲差异,模型使用层次性DBSCAN聚类:

步 骤 1:对 分 量xc,yc,sh,sw,V,使 用Mahalanobis距离:

其中,Σ为协方差阵.

步骤2:对u,v分量,使用矢量距离,<,>为内积运算:

使用式(10),(11)为距离度量,聚类形成行为模式集A={Ai}.

3 基于Petri网的复杂监控事件探测模型

模式集A={Ai}形成场景基本语义单元,描述了行为样本集的潜在结构,以此为基础,通过定义Ai间的时序关系可形成语义事件模型E= {Ei}.

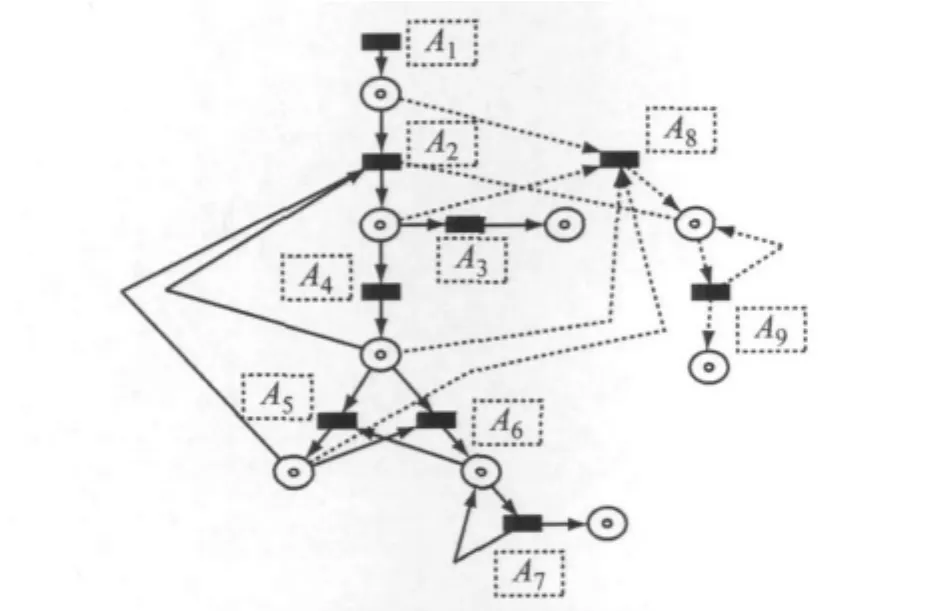

Petri网是一种数学建模语言[10],文献[11]提出7种事件时序关系.如图3所示,本文提出一种面向监控视频的Petri事件探测模型(surveillance Petri detection model,SDM-Petri),建立模式间的时序关系.

图3 SDM-Petri模型结构Fig.3 Structure of SDM-Petri model

构建一张SDM-Petri网描述场景中存在的多个语义事件Ei.基本要素包括模式节点集A={Ai},状态位置S,以及模式转移弧:定义为有向对(Ai,S).在模型构成中,S代表了当前运动目标集O={Oi}的状态值,Oi等价于Petri令牌,如图3中黑点表示.A代表模型随Oi状态值而产生的变迁.SDM-Petri的演化规则[11]简单定义为:

当匹配映射fullfill(attribute(Oi),Aj)→true,则enable(Ai)→true.其中,函数attribute(Oi)为目标的瞬时状态矢量,fullfill(a,b)定义为匹配关系,即a满足于b;处于enable状态后Ai可fire(点火),Oi由Ai的前置状态转移至后置状态.

SDM-Petri模型在表示串行模式的同时,也可以刻画非对称时序关系.如图3所示,模式A1,A2为顺序关系,A1可理解为A2的发生条件;A1,A3存在竞争关系,当仅为单一目标时,A1,A3表现为非对称式的条件互斥,而多目标的不同变迁使A1,A3刻画模式并行;A2,A4实现模式同步;A5为终点模式,表示语义事件Ei发生或Oi消失.在实验中将结合具体实例演示SDM-Petri的构造过程.

4 事件探测模型测试实验

本文实验环境为户外远景视频监控:帧速为15帧·s-1;图像分辨率为320×240;实验的硬件环境是Pentium(R)4CPU 2.40GHz,内存1GB;使用平均背景模型收集行为样本集a={ai},时长为5 h[12](图2).

4.1 行为模式学习

针对行为样本a={ai},图4为DBSCAN聚类结果.将数据点映射到(xc,yc)分量空间进行可视化显示,行为模式具有明显的区域性,存在5个区域,其边缘间存在相互重叠,为直观显示,使用5条分离的闭合曲线显示(图4a).表1中为区域性模式集A={Ai}的简要语义.图4b为各模式的关键帧.

表1 模式语义说明Tab.1 Semantic description of activity patterns

图4 模式区域标注及模式关键帧Fig.4 Patterns labeling and key-frame of patterns

图4 a左为式(10)聚类结果.对xc,yc,sh,sw分量,由于目标运动的连续性,以及远景监控下行人的近似刚体运动,样本集a={ai}的xc,yc,sh,sw分量相互状态联通或状态可达;速度V的强分离性将场景划分为两部分.其中,A,B,C为停留区;黑色闭合曲线F覆盖了运动区.

图4a右使用式(11)进一步分割模式集,u,v分量将黑色闭合曲线F分裂为E,D区域(图4a右),各包含两个运动主方向(图4a右中直线运动域所示),近似代表了场景中的运动路径.

4.2 SDM-Petri事件探测

4.1表明模式集A={Ai}代表了监控场景运动区域语义信息.针对测试场景(图4),基于SDMPetri模型定义目标从道路D进入场景发生“偷车”事件(图5所示,以下简称SDM-Petri 1.1).SDMPetri模型规范化模式集A={Ai},包括添加起始运动模式,以及终点运动模式,见表2.

图5 SDM-Petri实例1.1Fig.5 SDM-Petri 1.1for complex event dectection

表2 模式集规范化表示Tab.2 Regularized semantic descriptions of motion patterns

针对每一视频帧:① 定义运动目标集O={Oi}的属性值,见表3;② 以及各模式的使能条件,Oi.代表各运动对象的状态值,见表4.

表3 SDM-Petri目标属性描述Tab.3 Descriptions of attributes in SDM-Petri

表4 SDM-Petri 1.1使能条件Tab.4 Description of enabling rules in SDM-Petri 1.1

对于模型SDM-Petri 1.1的描述:当目标Oi出现在道路D中,定义属性IDNew为true,触发初始化模式A1;模型1.1同时定义了偷车终点模式A7.通过检测跟踪计算xc,yc分量,更新ParkZone及IDNew;若IDNew为假,触发模式A3,目标进入建筑物;ParkZone为真,则触发A4,目标进入停车场区,此时预警开始,提示目标越界;当目标进入区域P后,存在3种状态变迁:① 停留对应模式A6;②沿停车区与路径D重叠边缘区运动,对应模式A5;③ 沿路径D运动,对应模式A2;通过对ParkZone值与Velocity值的循环更新;三模式相互可为发生条件.而模式A6触发后,A7进入自循环触发,与其他模式不同,A7会延迟触发,延迟时长t>T2时,触发代表“偷车”事件发生,否则触发A5;同时注意到A7具有自反性质,触发后的目标数量代表事件的严重程度;终点模式A3与A7,触发A3后的状态目标数量可进行人流统计,A7预警“偷车”模式.

SDM-Petri模型可扩展多语义事件,SDM-Petri 1.2增加了“运动区停留”事件探测,如图6所示,添加A8、A9模式,其语义与使能条件见表5.A9与A7类似,同样为延迟触发,以自循环触发表示事件重要程度.

图6 扩展SDM-Petri实例1.2Fig.6 Extended SDM-Petri 1.2

4.3 实时监控事件探测结果

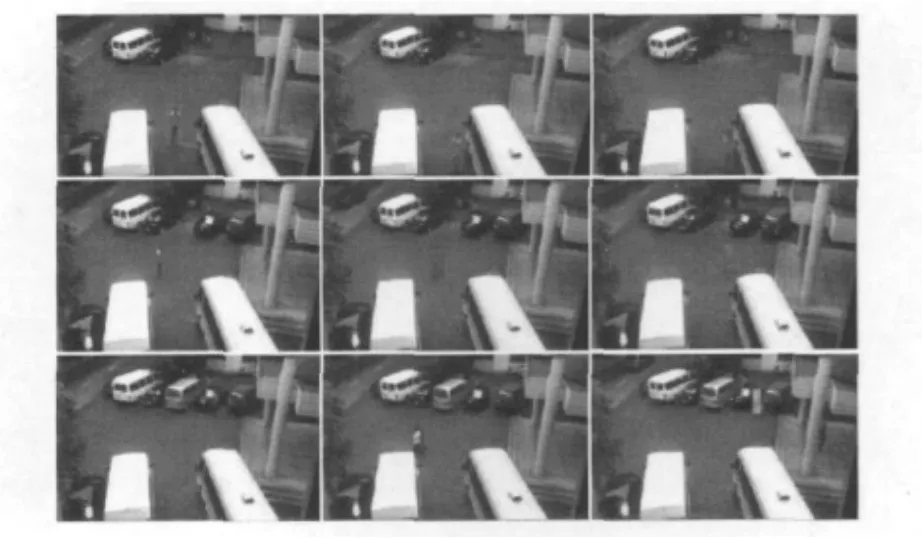

使用SDM-Petri 1.2,图7为“运动区停留”事件与“偷车”事件的探测结果.

表5 模式A8与A9描述与使能条件Tab.5 Enabling rules of A8and A9in SDM-Petri 1.2

图7 事件探测结果Fig.7 Expetriment result for event detection of SDM-Petri 1.2

图7 第2行,为“停留”事件探测,左图提示目标运动速度低于阈值,检测框的颜色从左至右逐渐变深,指示停留时间增长,可自动探测到运动区的静止目标.图7第1,3行为两个停车区的“偷车”事件探测,左图提示目标进入停车区,相似的,检测框的颜色渐变指示停留.图7第3行右图表示目标速度大于阈值,停止触发A7同时转向模式A5,结束预警.

在表6中,给出了“偷车”事件模型的实时探测结果.为了验证性能,首先将停留阈值设定为2s,模型预警了全部进入停车区的运动对象,正确率接近95%;其次,将阈值设为5s,在实验过程中加入异常停留行为,模型预警到全部异常行为;SDM-Petri模型可满足实时监控预警需要.

表6 “偷车事件”探测结果Tab.6 Detection result of semantic event‘stealing’

5 结语

本文研究了一种监控场景中的高层语义事件探测技术,针对运动行为样本,给出一种Dbscan行为模式自动学习方法;以此为基础,使用SDM-Petri建模其时序关系,完成事件探测.通过实时监控视频演示了模型的探测结果.

强鲁棒性的SDM-Petri建模已经成为目前的研究热点,例如表6中停留阈值的分布学习、模型组件的自适应构建.从行为模式学习结果可看出模式与上下文间存在较强依赖性,因此,面向复杂场景上下文的先验信息融合[13]也是未来的重要研究方向.

[1]徐光佑,曹媛媛.动作识别与行为理解综述[J].中国图象图形学报,2009,14(2):189.XU Guangyou,CAO Yuanyuan.Action recognition and activity understanding:a review[J].Journal of Image and Graphics,2009,14(2):189.

[2]王素玉,沈兰荪.智能视觉监控技术研究进展[J],中国图象图形学报,2009,12(9):1505.WANG Suyu,SHEN Lansun.Intelligent visual surveillance technology:a survey[J].Journal of Image and Graphics,2009,12(9):1505.

[3]Hamid R,Maddi S,Bobick A,et al.Unsupervised analysis of activity sequences uisng event-motifs[C]//Proceeding of 4th Acm International Workshop on Video Surveillance and Sensor Networks.California:ACM Press,2006:71-78.

[4]Lavee G,Rudzsky M,Rivlin E,et al.Video event modeling and recognition in generalized stochastic petri nets[J].IEEE Transactions on Circuits and Systems for Video Technology,2010,20(1):102.

[5]XIANG Tao,GONG Shaogang.Incremental and adaptive abnormal behaviour detection[J].Computer Vision and Image Understanding,2008,111(1):59.

[6]XIANG Tao,GONG Shaogang.Beyond tracking:modeling activity and understanding behavior[J].International journal of Computer Vision,2006,67(1):21.

[7]Cedric S,Jerome M,De Christophe.Using decision trees to recognize visual events[C]//Proceeding of 1st Acm Workshop on Analysis and Retrieval of Events/Actions and Workflows in Video Streams.Vancouver:ACM Press,2008:41-48.

[8]于起峰,尚洋.摄像测量学原理与应用研究[M].北京:科学出版社.2009.YU Qifeng,SHANG Yang.Video metrics:principles and research[M].Beijing:Science Press,2009.

[9]Ester M,Kriegel H,Xu X W,et al.A density-based algorithm for discovering clusters in large spatial databases with noise[C ]//Proceeding of 2nd International Conference on Knowledge Discovery and Data Mining.Oregon:AAAI Press,1996:226-231.

[10]Borzin A,Rivlin E,Rudzsky M.Surveillance interpretation using generalized stochastic petri nets[C]//8th International Workshop on Image Analysis for Multimedia Interactive Services.Santorini:IET,2007:102-118.

[11]Lavee G,Borzin A,Rivlin E.Building petri nets from video event ontology [C ]//Proceeding of 3rd International Conference on Advances in Visual Computing.Nevada:Springer-Verlag,2007:442-451.

[12]焦波.面向智能视频监控的运动目标检测与跟踪方法研究[D].长沙:国防科学技术大学系统工程系,2009.JIAO Bo.Research on moving object detection and tracking method for intelligent video surveillance[D].Changsha:National University of Defense Technology.Department of Engneering System,2009.

[13]Wang Xiaogang,Ma Xiaoxu,Grimson Eric.Unsupervised activity perception in crowded and complicated scenes using hierarchical bayesian models[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2009,31(3):539.