基于深度学习LDAMP 网络的量子状态估计

2023-01-16林文瑞

林文瑞 丛 爽

在量子力学中,量子状态密度矩阵包含了量子系统的全部信息,是量子信息处理和量子控制研究的基础.根据海森堡不确定性原理[1],对量子系统的每一次测量都会破坏其原有的状态,这使得人们无法通过直接对一个量子系统进行测量来获得量子系统的状态,只能测量到量子系统的状态在某个投影方向上的投影(坍缩)结果,再通过多次测量的统计结果,计算出各投影分量的概率对真实量子状态进行估计[2].为了解决量子态的估计问题,1957 年Fano[3]提出了量子层析的方法,它是通过对一个量子状态进行多次投影测量,根据测量值与量子态直接的关系式,联立方程求解出量子状态.该方法需要制备量子状态的大量全同副本,并进行重复地测量来进行量子态估计.随着量子理论的逐步完善,1969 年Cahill和Glauber[2]提出利用重复测量获取的量子概率统计数据重构出量子态的密度矩阵来恢复量子状态信息,奠定了量子态层析的基础.一个n比特量子系统状态的密度矩阵ρ∈Cd×d的维数为d×d,并同时具有半正定,单位迹和共轭对称的性质,其中d=2n.由于待估计的ρ的未知元素数目为d×d=4n个,所以该系统的完备测量次数为 4n,是随着量子维数呈指数增加[4].为了解决测量次数随量子位指数增长的问题,人们根据压缩感知(Compressive sensing,CS)理论[5]将量子态密度矩阵通过高维测量矩阵投影到维数很低的压缩矩阵上,只要测量矩阵满足限制等距特性(Restricted isometry property,RIP)[6],就可以利用压缩后的低维压缩矩阵通过求解一个优化问题精确重构出待估计的密度矩阵[7-9].

在实际量子测量过程中,测量噪声的存在是不可避免的,并且可以被假定为高斯噪声.在量子状态估计算法研究中,Smith 等[10]基于最小二乘法从含有噪声的数据中实现了4 比特量子状态估计.Li等[11]基于压缩感知将交替方向乘子法(Alternating direction multiplier method,ADMM)运用到量子态估计中[12],给出了算法迭代优化形式,并在5 比特的量子状态密度矩阵估计中获得了较高的估计精度.ADMM 算法是一种求解分布式凸优化问题的计算框架,在图像处理及恢复、统计学习和量子态估计等领域有着广泛应用.Smolin 等[13]提出了一种从加性高斯噪声测量中计算最大似然量子态的有效方法,其最坏时间复杂度为O(d4).但是这些优化算法在量子态重建过程中都会需要较多的计算内存和计算时间.对于高维量子系统,重建过程中需要测量和处理的数据会很多,这样会导致所需的计算资源和计算时间增长很快.Metzler 等[14]提出DAMP 算法,它是一种基于压缩感知的迭代稀疏信号恢复算法,通过在算法中添加Onsager 校正项[14-15],修正每次迭代时有效噪声的偏差,改进了基于去噪的迭代阈值(Denoising-based iterative threshold,DIT)算法收敛速度慢的问题.Liu 等[16]采用卷积神经网络的降噪自动编码器,从带有噪声的密度矩阵中重建出高精度的密度矩阵.

本文基于压缩感知理论,结合深度学习网络,提出一种采用深度学习网络来估计量子状态密度矩阵的方法.将密度矩阵视为二维自然图像信号,采用基于学习降噪的近似消息传递(Learned denoising-based approximate message passing,LDAMP)神经网络[17],将去噪卷积神经网络(Denoising convolutional neural network,DnCNN)的图像降噪器[18]融合到基于去噪的近似消息传递(Denoisingbased approximate message passing,DAMP)算法[19]中.此外,还提供一个关于LDAMP 在量子状态估计中的渐近收敛性能的分析框架—状态演化(State evolution,SE)方程[17]来预测LDAMP 网络每一层的均方误差(Mean square error,MSE)性能[20].在数值仿真实验中,在固定DnCNN 神经网络和LDAMP 网络的层数,选择高斯测量矩阵,在无和有外部测量噪声两种情况下,分别对4 个量子位的量子本征态、叠加态、对角混合态和一般混合态的密度矩阵参数估计进行结果和性能分析,并与其他典型的重建算法对密度矩阵参数估计的性能进行了对比研究.

本文结构安排如下:第1 节概述了基于压缩感知的量子状态估计作为一个信号恢复问题,第2 节介绍了应用于量子状态估计的DAMP 信号恢复算法,第3 节具体描述了LDAMP 网络的实现和DnCNN 神经网络的结构及其训练过程,第4 节给出了对DnCNN 训练后模型的测试结果和量子态估计数值模拟实验结果及分析,第5 节是结论.

1 基于压缩感知的量子态密度矩阵估计

压缩感知是近10 多年来在信号处理领域诞生的一种新的信号恢复理论.它主要是利用信号s∈CN的M(远远小于完备测量需要的N)个随机线性测量值y,建立欠定线性方程组y=As(y∈CM),并通过优化算法来高精度重构求解出原始信号s,其中A∈CM×N,M<N为测量矩阵.在量子态估计中,原始信号为密度矩阵ρ∈Cd×d,它与量子系统波函数之间的关系为:

式中,|ψi〉为系统的波函数,pi表示波函数的概率,d为密度矩阵的维数.将密度矩阵写成向量表达的形式是ρ=ψ·ψ*,其中ψ=当量子系统的量子位数为n时,密度矩阵的维数d=2n.由于神经网络无法直接处理复数信号的去噪,在本文中仅对实数密度矩阵进行估计.在基于压缩感知的量子态估计中,测量矩阵A需要满足限制等距特性才可以唯一确定d2个待估计的密度矩阵元素,人们通常采用的是泡利测量矩阵[21].由于随机高斯矩阵参数均为实数并且具有较好的重构效果[22],本文中在RIP 条件下采用随机高斯矩阵来构造测量矩阵,其设计方法为:构造一个M ×N大小的矩阵A,使A中的每一个元素独立的服从均值为0,方差为 1 /M的高斯分布,即:

式中,A的行数与列数的比值定义为采样率η=M/N,并且有N=d2.

考虑从有外部测量干扰的线性度量中恢复密度矩阵ρ∈Rd×d的问题:

式中,vec(·) 表示将一个矩阵按列的方向组合成一个列向量,w∈Rm为测量噪声并且通常被假设为独立且同分布的高斯噪声.定义测量噪声w~N(0)为加性高斯白噪声(Additive white Gaussian noise,AWGN),其中γw为噪声标准差.在本文的模拟实验中,采用含测量噪声信号y和理想测量信号y0=A·vec(ρ) 之间的信噪比(Signal noise ratio,SNR)作为噪声强度,计算公式为:

式中,y(i,j)和y0(i,j) 分别为含测量噪声信号和理想测量信号在向量中 (i,j) 点处的值.

利用正则化二次损失最小化方法解决该线性逆问题,可以通过求解一个凸优化问题计算得到vec(ρ)的估计值[23-24]:

式中,λ>0 为正则化参数.然而这个极小化问题是一个凸优化问题,在大规模问题中,由于数据维度较大,常规求解算法中,如内点法等的算法复杂度较大,求解起来非常耗时.这使得众多研究人员通过简单的基于梯度的方法来求解式(5).

2 DIT和DAMP 算法

在众多基于梯度的算法中,最受关注的一类方法是迭代阈值(Iterative threshold,IT)算法.为了方便表示,定义s=vec(ρ).当待估计的密度矩阵为ρ0时,称s0=vec(ρ0) 为待估计的信号.从s0=0和z0=0开始,迭代公式为:

式中,sl是l次迭代密度矩阵的估计值.zl是l次迭代的残差,如果密度矩阵恢复过程是无噪声的,并且算法性能执行得很好,它将收敛于0.η(·) 称为阈值函数,它是一个被应用到矢量的分量元素上的标量非线性函数.λl是l次迭代阈值函数使用的参数.

在信号恢复中,阈值函数的选择非常重要,常见的有软阈值函数(7)等.其中符号 (w)+表示w ≥0时结果为w,否则结果为0.另外一种实现阈值函数的方法是使用降噪器Dσˆl,此时阈值参数λl的含义为输入降噪器的信号的所含高斯噪声的标准差估计,并且计算公式为它随着迭代次数的变化而变化.利用降噪器实现阈值函数的迭代阈值算法称为基于去噪的迭代阈值(Denoisingbased iterative threshold,DIT)算法[17],迭代公式为:

基于不同的降噪器,DAMP 包含许多算法[27],包括高斯-AMP (Gauss-AMP)、双边-AMP (Bilateral-AMP)、非局部平均-AMP (Non-local means AMP,NLM-AMP)和三维块匹配-AMP (Block matching 3D AMP,BM3D-AMP)[28]等.本文采用的降噪器和散度计算都是通过设计并训练一个深度卷积神经网络DnCNN 来实现.同时通过设计一个学习的基于去噪的近似消息传递LDAMP 网络,来实现算法1 的DAMP 算法,并通过多个相同结构的的级联,来获得高精度的信号s0即vec(ρ0) 的估计,得到密度矩阵ρ0的估计.

本文通过LDAMP 网络,使用量子系统输出的测量值,来实现对量子态密度矩阵估计,具体流程如下:

步骤1.根据生成DnCNN 神经网络的训练集,验证集和测试集,具体过程在第3.3 节;

步骤2.在9 个不同噪声标准差范围下,训练出相应的DnCNN 神经网络,训练完成后利用测试集对网络进行测试;

步骤3.对于待估计的密度矩阵ρ0,在不同采样率下利用高斯测量算符获取的输出测量值y0.对于含噪声情况下测量值,通过y=awgn(y0,SNR) 添加固定SNR数值的高斯噪声获得好噪声测量值y;

步骤4.设计一个包含训练好的DnCNN 网络和实现DAMP 算法的10 层LDAMP 网络,网络各层中的DnCNN 是根据当前层的噪声标准差估计σˆ落入的9 个范围来选定.LDAMP 网络的输入为测量值y0或y;

步骤5.LDAMP 网络最后的输出为根据输入测量值y0或y得到的估计的密度矩阵.

3 LDAMP和DnCNN 网络的结构设计及其训练

第3.1 节对LDAMP 网络的结构进行设计;第3.2 节进行DnCNN 降噪器及其中的卷积神经网络的结构设计;第3.3 节进行DnCNN 降噪器中神经网络的训练过程.

3.1 LDAMP 网络的结构设计

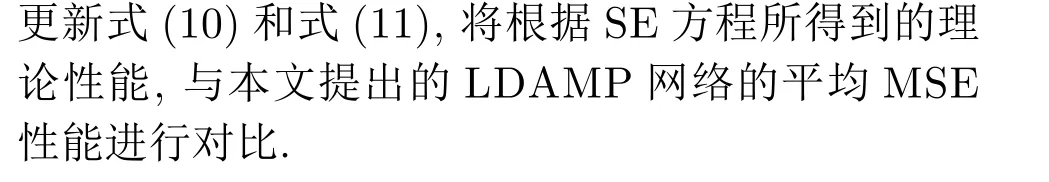

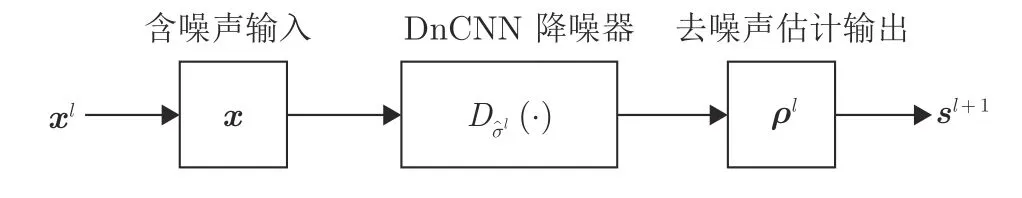

LDAMP 网络由L层相同的AMP 网络结构级联而成,其中,LDAMP 网络单层的结构图如图1所示.每层网络包含两个在固定噪声标准差区间下训练好的DnCNN 降噪器,一个用于计算每层AMP网络的输出sl+1,另一个用于实现散度图1中的xl=sl+AHzl为LDA MP网络的第(l+1) 层中DnCNN 降噪器的输入信号,vˆl为降噪器中DnCNN 卷积神经网络的输出,它表示对有效噪声vl的估计.

图1 LDAMP 中第 l 级网络结构图Fig.1 Structure of the l-level network in the LDAMP

需要指出的是,LDAMP 网络中只有DnCNN降噪器是由神经网络设计而成,而网络的其他部分只是对DAMP 算法的实现.

对于L层的LDAMP 网络,可以使用不同的方法来训练,包括端到端训练,逐层训练和逐降噪器训练,其中,端到端训练是指将L层的LDAMP网络视作一个整体,同时训练网络的所有权值.这是训练神经网络的标准方法.逐层训练是指每次训练LDAMP 网络中的一层AMP 网络来恢复信号,固定这些权值,然后添加一层AMP 网络,训练产生的2 层网络的第2 层来恢复信号,再固定这些权值,重复操作直到已经训练一个L层LDAMP 网络.逐降噪器训练是指将DnCNN 降噪器从网络中单独出来,并在不同噪声标准差范围区间下训练每个降噪器的AWGN 去噪问题,从而得到多个不同去噪水平的降噪器,以供LDAMP 网络中的各层选择,即每层AMP 网络,根据当前层的噪声标准差的估计,来选择使用哪一个降噪器.

本文采用的逐降噪器训练方法是最小均方误差(Minimum mean squared error,MMSE)[17]最优的.具体训练过程为:首先,对噪声水平的预期范围进行离散化,将噪声标准差[0,2]范围内的噪声分成多个小范围;然后,在这些小范围噪声水平下训练DnCNN 降噪器,得到多个训练好的降噪器模型;最后,LDAMP 网络实现时,每层网络根据本层的噪声标准差估计落在某个区间内,来选择在该噪声标准差区间下训练好的降噪器模型.LDAMP网络易于训练,可以应用于各种不同的测量矩阵,并带有一个可以准确预测其性能的状态演化框架.

状态演化(State evolution,SE)是一个可以预测LDAMP 网络各级的输出与真实信号之间MSE性能的分析框架.它由一系列SE 方程组成:

3.2 DnCNN 降噪器的结构设计

在DnCNN 神经网络结构设计上,DnCNN 网络源于对VGG 网络的改进,去除了池化层和全连接层,在卷积层(Convolution,Conv)和修正线性单元(Rectified linear unit,ReLU)[29]之间加入了批归一化(Batch normalization,BN)[30].这种改变可以减轻内部协变量移位[18]带来的影响,从而提高网络的学习收敛速度.在模型学习中,DnCNN 借鉴了ResNet 的残差学习方法[31-33],来提高训练速度和去噪性能.

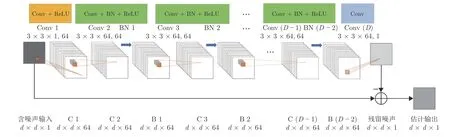

图2 为DnCNN 降噪器的网络结构图,图3 是DnCNN 降噪器输入变量的尺寸变换过程图.输入矢量的维数为d×d,其中d=2n,n为量子态的位数.深度为D的DnCNN 神经网络,在本文应用中,D取值为20.本文设计的DnCNN 有三种不同的网络层,具体排列顺序为:第1 层为卷积层+修正线性单元(Conv+ReLU):使用64 个大小为3×3×1的卷积核(或称为滤波器),生成64 个特征图.然后,使用修正线性单元进行非线性处理.第2~(D-1)层为卷积层+批归一化+修正线性单元(Conv+BN+ReLU),使用64 个大小为 3×3×64 的卷积核,在卷积层和ReLU 层之间加入BN 层.最后一层为卷积层(Conv),使用1 个大小为 3×3×64 的卷积核重构输出.

图2 DnCNN 降噪器的网络结构图Fig.2 Network structure of the DnCNN denoiser

DnCNN 神经网络的输入是有噪声的信号矩阵x∈Rd×d,所以LDAMP 网络各层把数据输入到DnCNN 神经网络之前,需要将列向量变成原始信号大小的矩阵形式,变换过程如图3 所示.含噪声输入的矩阵x和向量xl分别为:

图3 DnCNN 降噪器输入变量的尺寸变换过程Fig.3 Size transformation process of input variable of the DnCNN denoiser

它是估计噪声信号R(x;Θ) 与真实噪声信号v=x-s0之间的均方误差.其中,Q是批大小(Batch Size),Θ 是DnCNN 神经网络中可以调整的参数,包括网络的权值和偏置,训练次数和目标误差等.

在许多信号恢复算法中,通常要求输出信号的尺寸与输入信号的尺寸一致,这可能会导致恢复的矩阵信号中边界元素值受到较大影响,也就是产生边界伪影.为了保证隐含层的每个特征信号与输入信号的尺寸大小相同,在DnCNN 神经网络的每个卷积层中进行卷积运算之前,对输入卷积层的信号采用简单的零填充策略,不过这种零填充策略不会产生任何边界伪影[18].

3.3 DnCNN 神经网络训练过程

在对DnCNN 神经网络进行训练时,采用的样本数据的尺寸大小为 24×24=16×16,也就是4个量子位的密度矩阵.对样本数据加入不同标准差范围下的高斯噪声作为训练输入,原始样本数据作为训练输出目标,在未知高斯噪声水平下训练DnCNN 神经网络.为了训练更小噪声范围下的DnCNN 网络,将噪声标准差范围[0,2]划分成9个小范围,具体分段结点为0、0.005、0.01、0.03、0.05、0.1、0.3、0.5、1和2,并在这9 个小范围噪声水平下分别训练了DnCNN 网络.然后LDAMP 网络根据各级的噪声标准差估计σˆ 的大小选择对应的DnCNN 模型.训练和测试过程中,样本数据包含满足和近似满足量子态密度矩阵性质的矩阵,其中满足性质的两种量子态的密度矩阵生成公式为:

式中,φr为d×r的Wishart 矩阵,并且矩阵内各元素满足高斯分布[35].r=1 时,为叠加态密度矩阵,r >1时为一般混合态密度矩阵.

本文研究的另外两种量子态还包括本征态和对角混合态,其中本征态密度矩阵为仅有对角线某一位置有元素为1,其他位置元素均为0 的矩阵,对角混合态密度矩阵为仅在对角线上所有位置有非0 元素,且对角线所有元素之和为1,其他位置元素均为0 的矩阵.样本数据中近似满足性质的矩阵是指在构造样本数据时,改变部分满足性质的密度矩阵中的元素,加入一些噪声干扰,使矩阵的迹在[0,1]之间且近似共轭对称的半正定矩阵.在构造过程中,采用[0,1]之间的随机数乘以原始密度矩阵或在原始矩阵生成过程中给矩阵φr的共轭转置矩阵添加噪声干扰.值得注意的是,训练集和测试集中近似满足性质的密度矩阵所占的比例在30%~50%可以取得较好的估计效果,另外[0,0.5]之间的随机数应多于(0.5,1]之间的随机数.这种构造方法的原因是因为LDAMP 网络具有数层相同的结构,网络的初始输入s0=vec(ρ0) 为零向量,网络的最终输出为估计的密度矩阵,所以网络进行密度矩阵估计是各层网络渐近逼近真实密度矩阵的过程,因此需要大量的中间估计结果和少量的零矩阵包含在训练样本集中.

在训练DnCNN 时,本文使用了9 900×128=1 267 200 个样本用于训练,1 100×128=140 800 个样本用于验证和11 × 128=1 408 个样本矩阵用于测试.训练集、验证集及测试集中4 种量子态密度矩阵的比例为本征态:对角混合态:叠加态:一般混合态=1:2:4:4.所有的样本矩阵在生成时都是无噪声样本,而在训练、验证和测试时,会在对应的噪声水平范围内加入噪声.为了获取足够的空间信息进行去噪,将DnCNN 神经网络的深度设置为20 层.采用了一种鲁棒的初始化方法MSRA[36]来初始化DnCNN 神经网络权值,并采用权值衰减为0.0001、动量为0.9、小批量尺寸为128 的带动量的随机梯度下降法(Stochastic gradient descent with momentum,SGDM)训练网络.为每个小范围噪声水平下的神经网络设置的最大训练次数为50,最大允许无用训练次数(Max bad epochs,MBE)为2,初始无用训练次数(Bad epochs,BE)为0.在训练过程中,初始最小验证误差采用验证集验证未训练的网络得到,后续过程中,网络训练一次就验证一次得到新的验证误差,并将新的验证误差与上一次的验证误差相比,如果小于上一次的验证误差就将此次验证误差设置为最小验证误差并将BE 清零,否则最小验证误差不变并将BE 加1.当BE 大于等于MBE 时,网络就减小学习速率,并将BE 清零.学习速率变化过程为初始值0.001 衰减为0.0001,最后衰减至0.00001.当学习速率衰减为0.00001且BE 大于等于MBE 时,DnCNN 神经网络的训练结束.在实验中,使用Matlab 中的MatCov-Net 工具箱[37]来实现DnCNN 神经网络.所有实验均在Intel(R) Core(TM) i7-8700K CPU 3.70 GHz、NVIDIA GeForce GTX 1 080 GPU 的PC 上运行的Matlab (R2018b)环境下进行.所有9 个小范围噪声水平下的20 层DnCNN 网络的GPU 训练时间需要59 小时左右.

4 量子态估计仿真实验及其结果分析

本节对本文提出的LDAMP 网络的量子态估计性能,在不同参数下,进行了数值性能对比实验,进行3 个实验:

1)不同噪声标准差区间下,对所设计训练出的20 层DnCNN 神经网络降噪器去噪性能的测试实验;

2)本文的LDAMP 网络与其他5 种不同方法对量子态密度矩阵估计的性能对比实验;

3)不同测量噪声以及不同采样率分别对LDAMP网络估计量子态密度矩阵性能的影响实验.

实验中,量子状态测量值y是根据式(3)计算:y=A·vec(ρ0)+w,其中A为随机高斯测量矩阵,w~N(0)表示测量过程中产生的高斯噪声,ρ0为真实密度矩阵,可以从本征态、叠加态、对角混合态和一般混合态密度矩阵中选取.定义了三个性能指标来衡量实验结果:

当MSE 以dB 作为单位时,定义为:

3)估计的密度矩阵与真实密度矩阵之间的保真度(Fidelity)[38]:

式中,保真度的范围是[0,1],并且当2 个矩阵完全相同时,保真度为1[39].

4.1 DnCNN 去噪性能的测试实验

图4 为使用11 × 128=1408 个随机样本矩阵,分别测试噪声水平分别从[0,0.005],(0.005,0.03],···,(1,2]共9 个范围情况下,对训练后得到的20 层DnCNN 进行去噪性能的测试实验的误差曲线图,其中方形实线表示网络输入样本与对应的无噪声样本之间的平均均方误差MSE (dB);圆圈虚线为网络输出样本与对应的无噪声样本之间的平均均方误差MSE (dB);三角形实线是输出误差与输入误差之间的MSE 比值变化曲线.由图4 可以看出,网络输出误差始终小于输入误差,并且随着噪声标准差的增加,输出误差与输入误差之间的比值逐渐减小:从[0,0.005]区间的0.5956 减小至(1,2]区间的0.0311.这说明,当输入噪声很小时,输出误差仍然能够滤掉接近一半噪声,随着噪声的增加,去噪效果越明显.表明经过训练后的DnCNN 降噪器拥有良好的去噪效果.

图4 DnCNN 降噪器的MSE 性能Fig.4 MSE performance of the DnCNN denoiser

4.2 LDAMP 网络与其他方法的对比实验

本节中将本文的LDAMP 网络与ADMM 算法,以及其他4 种DAMP 算法(BM3D-AMP、NLMAMP、Gauss-AMP和Bilateral-AMP)对量子态估计的性能,进行对比实验.实验中采用的样本为对角混合态密度矩阵.分别在采样率从0.05 每隔0.05增加到0.5,测量噪声强度固定为SNR=40 dB 情况下,不同量子态估计方法的归一化距离随采样率变化情况,实验结果如图5 所示.固定采样率η=0.1,不同量子态估计方法的MSE (dB)性能随SNR 变化情况如表1 所示.由图5 可以看出,在每一个采样率下,LDAMP 网络的性能是所有算法中最好的,并且在采样率为0.15 时,就能够达到10-3的性能.由表1 可以看出,在所有不同噪声等级干扰和无噪声情况下,LDAMP 网络的估计性能均优于其他方法,并且在无噪声干扰下的MSE (dB)为-41.0905 dB,估计误差达到 1 0-4量级.

表1 当 η=0.1 时,LDAMP 网络和其他方法的MSE (dB)性能比较Table 1 Comparison of MSE (dB) performance between LDAMP network and other methods with η=0.1

图5 当SNR=40 dB 时,LDAMP 网络和其他方法的归一化距离性能对比Fig.5 Comparison of normalized distance performance between LDAMP network and other methods with SNR=40 dB

4.3 LDAMP 网络的量子态估计实验

本节采用本文设计出的具有20 层DnCNN 以及10 层算法迭代的LDAMP 网络,在无和有噪声的2 种情况下,分别对本征态、叠加态、对角混合态和一般混合态的估计进行了性能对比实验.影响状态估计性能的因素有采样率的多少和噪声的大小,共进行了4 个实验.

1)不同采样率下无和含固定测量噪声的量子状态估计实验

在采样率从0.05 每隔0.05 增加到0.5,分别在无和含固定测量噪声SNR=40 dB 两种情况下,对4 种不同算法的量子状态进行了网络训练设计,网络的估计结果与真实状态之间的归一化距离变化过程如图6 所示.从图6 可以看出,随着采样率的增加,所有状态估计的归一化距离呈下降趋势,估计效果逐渐变好.由于测量噪声的存在,所有状态的估计结果均略差于无噪声情况下的状态估计.其中,本征态的估计最为准确,归一化距离均可以在最低采样率0.05 时达到 1 0-4量级,其在无噪声情况下的保真度为0.999993,有噪声情况下的保真度为0.989028.对角混合态的估计次之,其在0.15 采样率时无噪声情况下的归一化距离(保真度)才达到0.0017 (0.999898).这2 种量子状态具有较为简单的密度矩阵结构,因此在估计时也达到了较好的估计效果.在无噪声情况下,叠加态在采样率0.3 时的归一化距离(保真度)达到0.0037 (0.980570);一般混合态在采样率0.5 时的归一化距离(保真度),达到0.0198 (0.992958).在采样率小于0.3 时,对角混合态的估计效果不如一般混合态;当采样率大于0.3 时,对角混合态效果优于一般混合态.对于这种现象,经过采用多个不同密度矩阵的验证,可以得出以下原因:在采样率较小时,两种状态的估计效果均不理想,但是由于叠加态密度矩阵中元素数值相对一般混合态中的元素数值较大一些,所以计算出的归一化距离的值会更大,而采样率变大后,两种状态的估计效果均逐渐变好,由于叠加态相对于一般混合态的密度矩阵结构更为简单,此时叠加态的估计效果明显优于一般混合态,其归一化距离更低.

图6 LDAMP 网络对不同量子态密度矩阵估计的归一化距离性能对比Fig.6 Comparison of normalized distance performance of LDAMP network for estimation of density matrices of different quantum states

2)三种采样率及噪声固定下不同层数的LDAMP 网络的性能实验

图7 为固定噪声SNR=40 dB,采样率分别取0.05、0.1和0.2 三种情况下,不同层数的LDAMP 网络估计效果与式(10)和式(11)所示的SE方程的MSE (dB)性能对比的实验结果,其中虚线为SE 方程在三个不同采样率下的性能,实线为本文设计的LDAMP 网络所对应的性能Sim.由图7可以看出,在采样率低于0.2 时,LDAMP 网络在10 层内收敛;而采样率大于0.2 时,对于混合态和叠加态,LDAMP网络则需要更多的层数达到收敛,这也与密度矩阵的复杂度相关,同时表明本文设计的LDAMP 网络的高效性.

图7 当SNR=40 dB 时,不同采样率下LDAMP 网络的仿真(Sim)状态演化方程的MSE (dB)性能对比Fig.7 Comparison of MSE (dB) performance between simulation (Sim) and SE analysis of LDAMP network for different sampling ratios with SNR=40 dB

3)固定采样率在无和有噪声下对角混合态的估计性能对比实验

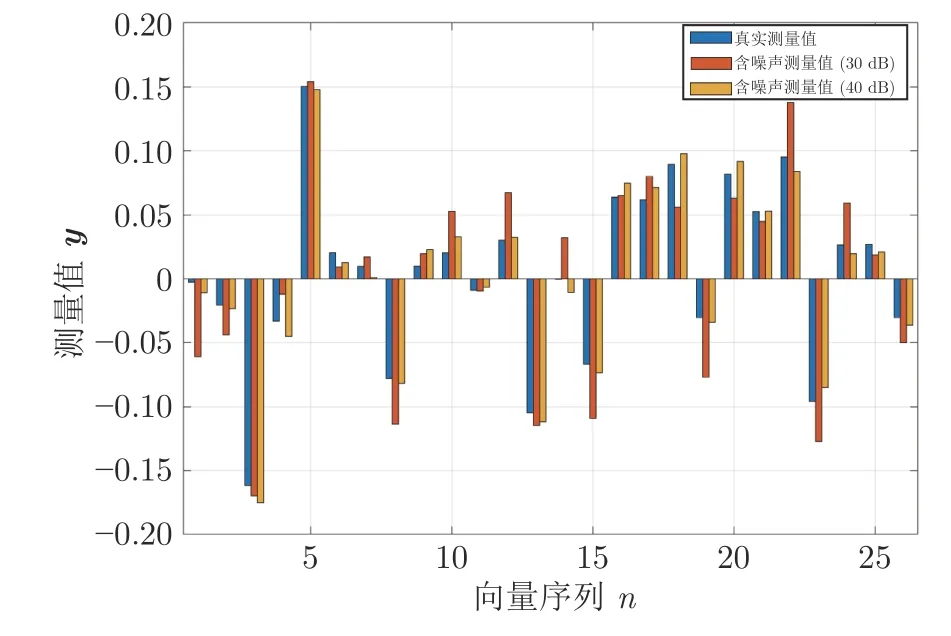

图8 为固定采样率0.1,在无和分别含SNR=30 dB和SNR=40 dB 测量噪声的情况下,对角混合态真实密度矩阵ρ3测量值的柱状图.图8 中3 个测量值之间的对比表现出不同大小测量噪声对真实测量值的影响效果.由图8 可以看出,30 dB 明显比40 dB 等级的噪声影响更大,这种影响持续体现在对真实量子态的估计上.

图8 当 η=0.1 时,对角混合态密度矩阵 ρ3 的真实测量值与含噪声测量值对比Fig.8 Comparison between the real measured values of diagonal mixed state density matrix ρ3 and the measured values with noise inη=0.1

图9 为相同情况下,对角混合态真实密度矩阵ρ3与密度矩阵估计、(w=30 dB)和(w=40 dB)的模值元素分布图.估计出来的3 个密度矩阵与ρ3之间的归一化距离分别为0.1492、0.3197和0.1614.

图9 当 η=0.1 时,对角混合态密度矩阵 ρ3 及其在无和含测量噪声下估计矩阵的模值分布Fig.9 Diagonal mixed state density matrix ρ3 and its modulus distribution of estimation matrix without and including measurement noise with η=0.1

4) 3 种采样率下4 种不同量子态在不同噪声的估计性能实验

为了研究测量噪声和采样率对量子态估计的具体影响,还进行了采样率分别为0.05、0.1和0.2 时,4 种不同量子态估计后的MSE (dB)随测量噪声大小的变化的实验,实验结果如图10 所示.由图10可以看出,在采样率和噪声水平分别固定时,所有量子态估计的MSE 均随另一个未固定量的增加而减小,其中SNR 增加时表示噪声水平降低.LDAMP 网络的性能可以随着采样率的增加而提高.不同量子态的表现也有差异,对于本征态,LDAMP网络在采样率η=0.1 的情况下,就能够获得优良的性能.而对于其他3 种量子态,则需要增加采样率来达到期望的估计效果.

图10 不同采样率下LDAMP 网络对4 种量子态密度矩阵估计时的MSE 性能Fig.10 MSE performance of the LDAMP network for the estimation of four quantum state density matrices with different sampling ratios

5 结束语

本文训练出一个具有20 层的降噪卷积神经网络(DnCNN),与基于去噪的近似消息传递(DAMP)算法相结合,设计出一个10 层的基于学习去噪的近似消息传递(LDAMP)网络,并将其应用于量子状态估计中.本文提出的LDAMP 网络在量子态估计中的性能,优于基于压缩感知理论最先进的三维块匹配近似消息传递BM3D-AMP 信号恢复算法和ADMM 算法,为采用深度学习网络进行量子态估计开辟了一条新的路径.更加深入的研究是带有虚部的深度学习网络的量子态估计,以及实现在线量子态估计[40]的深度学习网络的实现.