基于多层次特征融合的图像超分辨率重建

2023-01-16李金新黄志勇李文斌周登文

李金新 黄志勇 李文斌 周登文

单图像超分辨率(Single image super-resolution,SISR)技术旨在将一幅低分辨率(Low-resolution,LR)图像重建其对应的高分辨率(High-resolution,HR) 图像.SISR 被广泛应用于医学成像[1]、遥感[2]和安防[3]等领域.超分辨率重建是一个病态的逆问题:一个LR 图像可与多个(High-resolution,HR)图像对应,恢复细节逼真、丰富的HR 图像非常困难.超分辨率成像是计算机视觉领域的热点问题之一,深度学习技术已主导了当前SISR 方法的研究[4-13].

基于深度学习的SISR 方法直接端到端地学习LR 图像与HR 图像之间的映射关系.Dong 等[7]第一个提出基于卷积神经网络[14]的SISR 方法,称为SRCNN.SRCNN 仅使用了三个卷积层,以端到端的形式直接学习LR和HR 图像间的非线性映射.Kim 等[15]基于残差学习[16],提出网络更深的SISR方法(Very deep convolutional networks for superresolution,VDSR),改进了性能.为了能够增加网络深度,又限制网络参数的增加,Kim 等[8]采用共享参数的递归结构,提出了Deeply-recursive convolu-tional Network (DRCN)方法.Tai 等[9]提出的Deep recursive residual network (DRRN),同时利用了局部残差结构、全局残差结构和递归结构.残差单元之间参数共享,改进了VDSR和DRCN的性能.Li 等[17]提出的Super-resolution feedback network (SRFBN-S)方法,使用循环神经网络结构,共享隐藏层参数,降低参数量的同时提升了重建图像质量.Hui 等[18]提出Information multi-distillation network (IMDN)方法,在残差块内逐步提取特征信息,利用通道注意力机制进行特征选择,进一步提高了重建图像质量.Ahn 等[10]提出了基于级联残差网络的SISR 方法(Cascading residual network,CARN),结合级联结构与残差学习,取得了更好的参数量和性能之间的平衡.Zhu 等[19]提出Compact back-projection network (CBPN)方法,通过级联上/下采样层,在LR和HR 空间中提取特征信息,增强了重建能力.Li 等[11]提出的Multiscale residual network (MSRN)方法,残差块内运用不同感受野的卷积层,提取不同尺度的特征信息,进一步改进了性能.Lai 等[20]提出了拉普拉斯金字塔网络结构的SISR 方法(Laplacian pyramid super-resolution network,LapSRN),逐步上采样与预测残差,可同时完成多个尺寸的HR图像重建.

以上方法使用了轻量级网络,但网络深度和参数量是影响SISR 性能的重要因素[12].Lim 等[12]提出了一个重量级的Enhanced deep super-resolution network (EDSR)方法,去除了规范化层,叠加残差块,超过65 个卷积层,获得了2017 年超分辨率比赛冠军[21].Zhang 等[13]提出的Residual dense network (RDN)方法,结合残差结构和稠密结构,并充分利用LR 图像的层次特征信息,能够恢复出高质量的HR 图像.Liu 等[22]提出Residual feature aggregation net work (RFANet)方法,在残差块中使用感受野更大,参数量更小的空间注意力模块,筛选特征信息,并将每个残差块的残差支路提取的特征进行融合,提高了图像重建质量.EDSR、RDN和RFANet 等方法是当前有代表性的重量级网络SISR 方法,性能好,参数量也都较大(分别为43 MB、22 MB和11 MB).

在资源受限的情况下,重量级SISR 模型难以满足应用需求,本文考虑轻量级SISR 模型,提供潜在的解决方法.

本文提出一个新的、轻量级多层次特征融合网络的SISR 方法(Multi-hierarchical features fusion network,MHFN).当放大因子为4 倍时,MHFN 参数量仅为1.47 MB,是当前尖端方法EDSR 的1/29,RDN 的1/14,RFANet 的1/7.对比同类轻量级SISR 模型,本文的MHFN 方法,在性能和模型规模上取得了更好的平衡.以最有代表性的MSRN 方法为例,本文的MHFN 参数减少了3/4,在测试集上2 倍、3 倍和4 倍放大,客观性能相当,而8 倍放大,一致优于MSRN 方法.对于4 倍和8倍放大,主观性能也一致优于MSRN 方法.实验结果表明,MHFN 方法重建条纹的能力显著优于其他轻量级方法,对于8 倍大尺度放大因子,重建图像结果优势更明显.本文贡献包括:1)提出了一种对称结构的双层嵌套残差块(Dual residual block,DRB).残差块内先两次扩张,然后两次压缩特征通道,并使用两层残差连接以有效地提取特征信息;2)提出了一种自相关权重单元(Autocorrelation weight unit,ACW).ACW 可根据特征信息计算权值,自适应地加权不同的特征通道,以有效地传递特征信息;3)设计了一种浅层特征映射单元(Shallow feature mapping unit,SFMU).SFMU 通过每条支路上的不同感受野的卷积层,提取不同层次的浅层特征信息;4)设计了一种多路重建单元(Multipath reconstruction unit,MPRU).MPRU 可获取多条支路的特征信息,以充分地利用不同层次的特征信息重建图像不同方面.

1 本文方法

目前,大多数SISR 模型利用残差结构[12,23].残差块结构一般是卷积层–激活层–卷积层(Conv-ReLU-Conv)1该结构是将特征信息 x 经过卷积处理再激活操作,随后再次卷积处理得到 ,结构最终输出为 x + ..这类模型的一个问题是:模型性能严重依赖于网络规模(可训练的网络层数和通道数),如何减小网络规模,又提高或不降低模型性能,是极具挑战性的问题.本文设计了轻量级的多层次特征融合网络,特征通道先扩张后压缩的双层嵌套残差块,可以显著降低参数量,自相关权重单元自适应融合特征信息,也改进了特征利用效果.本文的MHFN 网络结构如图1(a)所示,主要包含浅层特征提取单元(Shallow feature extraction unit,SFEU)、浅层特征映射单元(Shallow feature mapping unit,SFMU)、深层特征映射单元(Deep feature mapping unit,DFMU)和多路重建单元(Multi-path reconstruction unit,MPRU)四个部分.

图1 本文多层次特征融合网络结构与残差组结构((a) 多层次特征融合网络结构图;(b) 残差组结构图)Fig.1 Our multi-hierarchical feature fusion network structure and the residual group structure ((a) The architecture of multi hierarchical feature fusion network;(b) The structure of residual group)

令ILR与ISR为输入与输出图像.浅层特征提取单元(SFEU)仅包含一个3×3 卷积层,实现浅层特征信息提取和特征维度转换的功能:

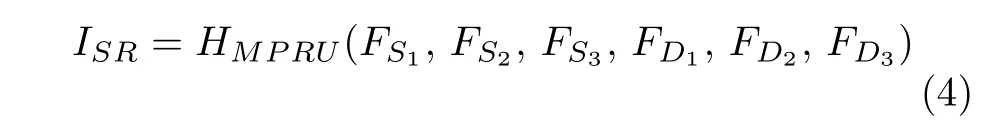

式中,HSF EU是浅层特征提取单元,将输入图像ILR生成符合浅层/深层特征映射单元维度要求的浅层特征信息F0. 浅层特征映射单元(SFEU)从F0中进一步提取浅层特征信息,并将浅层特征信息传递到多路重建单元(MPRU):

式中,HMP RU是多路重建单元,利用所有特征信息重建图像,生成最终结果ISR.

1.1 浅层特征映射单元(SFMU)

当前SISR 模型通常使用1 或2 个卷积层提取浅层特征,本文的SFMU 使用了不同感受野的卷积核,分层次提取浅层特征信息,实现多尺度、多层次浅层特征信息的获取.丰富的浅层特征信息,可以帮助重建单元重建更高质量的SR 图像.

SFMU 首先通过1×1 卷积层对输入信息进行维度转换,以降低后续操作的参数量.然后,使用三种不同感受野的卷积层,实现多尺度浅层特征信息提取.将三个卷积层分为三条支路,逐步加权叠加浅层特征信息.实现多尺度、多层次浅层特征信息的提取.

1.2 深层特征映射单元(DFMU)

为了获取深层次特征信息,本文设计了DFMU,如图1(a)所示.DFMU 包含3 个残差组(Residual group,RG),每个RG 又包含多个DRB.简单地堆叠残差块,不利于特征信息的传递.本文在每个RG中添加局部跳跃连接,促进特征信息的有效传递.并且通过RG 获取深层次特征信息:

1.2.1 双层嵌套残差块(DRB)

在SISR 模型中,常用的残差结构如图2(a)所示,每个卷积层具有相同的通道数目.这个结构的一个主要问题是:增加特征通道数目,会导致参数量快速增加.本文提出了如图2(b)所示的DRB,由内单元(Inner unit,IU)和外单元(External unit,EU)嵌套组成,并且使用先扩张后压缩的策略[24].该策略可以降低通道数目,进而减少参数量.EU第1 个卷积层提取特征信息同时,扩张特征通道,以获取更丰富的图像特征信息.第2 个卷积层压缩特征通道,筛选特征信息,促使有效特征信息传递.本文在EU 内部增加了包含2 个1×1 卷积的IU,增加通道数目,不会造成参数量的急剧增加.

图2 不同的残差块结构图Fig.2 The structure of different residual block

IU 采用了Conv-ReLU-Conv 结构,并加入跳跃连接.

1.2.2 自相关权重单元(ACW)

基于深度残差结构的SISR 模型,仍然存在梯度消失或爆炸问题,为了稳定训练,通常引入一个残差尺度参数[25].这个超参数通常经验设置,难以优化.本文的ACW 可学习最优的残差尺度参数.

如图3 所示.ACW 由全局平均池化层和Sigmoid 激活函数两部分组成,没有附加的参数.全局平均池化层将所有输入特征信息编码为初始化权重,随后利用Sigmoid 激活函数将其调整至[0,1].由于特征信息之间存在差异,生成不同的权重,增强了对重建图像有效的特征信息.

图3 自相关权重单元结构图Fig.3 The structure of autocorrelation weight unit

令X=[x1,x2,···,xC] 为输入特征信息,尺寸为H×W×C.初始化权值Z=[z1,z2,···,zC] 是通过全局平均池化层HGAP对输入特征信息X进行计算得出.第c个输入特征信息的初始权值为:

使用Sigmoid 激活函数f(·) 调整初始化权值Z,生成最终的权重参数W:

对输入特征信息进行加权处理:

1.3 多路重建单元(MPRU)

当前的SISR 模型网络末端,大多采用转置卷积或亚像素的卷积进行上采样.与转置卷积相比,亚像素的卷积重建的图像质量更好[26],但需要配合使用多个3×3 卷积层[11-13],放大因子增加,参数量会显著增加.为了在不降低图像重建质量的同时减少参数量,设计了MPRU.见图1(a),MPRU 有三条重建支路,每条重建支路由1 个1×1 卷积层与1个亚像素卷积层组成.每条支路重建结果与HR 图像尺寸相同,最终的SR 图像是三条支路重建结果的和.MPRU 使用1×1 卷积层,可极大地减少参数,放大因子增加,也不会显著提高参数量.同时,MPRU 获取各支路的特征信息,也可以改进重建效果.

下面将计算MPRU 参数量并与EDSR2https://github.com/thstkdgus35/EDSR-PyTorch方法的重建单元参数量作对比分析.假设两者用于重建的特征信息通道均为C,图像放大因子为S,重建后图像为3 通道.经1×1 卷积层处理后的特征信息通道数目为S×S×3.亚像素卷积层没有参数量,不参与计算.MPRU 的重建支路参数为3×((1×1×C+1)×S×S×3).

EDSR 重建单元在放大因子S=[2,3] 时,包含2 个 3×3 卷积层和1 个亚像素卷积层.第1 个卷积层将输入的特征信息通道由C扩张至S×S×C,再经过亚像素卷积层将特征信息高度与宽度扩张为原来的S倍,通道压缩为C,再经过另一个卷积层将通道压缩至3,生成最终结果.参数量为((3×3×C+1)×S×S×C+(3×3×C+1)×3).在放大因子S=4 时包含3 个卷积层和2 个亚像素卷积层.同理于上述过程,先将图像放大2 倍,再放大2 倍.其参数量为(2×((3×3×C+1)×2×2×C)+(3×3×C+1)×3).

当S=[2,3] 时,MPRU 参数量与EDSR重建单元参数量之比为:

当S=4 时,MPRU 参数量与EDSR 重建单元参数量之比为:

在本文模型中,重建的特征信息通道为48,即C=48. 由式(15)和式(16)可知,放大因子S=2,3 时,EDSR 重建单元参数量是MPRU 参数量的47 倍,而S=4 时,EDSR 重建单元参数量是MPRU 参数量的23 倍.

2 实验细节

2.1 实验设置

本文使用DIV2K[21]数据集中第1~800 个图像作为训练数据集,并对训练集进行 9 0°旋转和随机的水平翻转,进行数据增强.训练中每个批次处理16 个尺寸为48×48 像素的图像块,使用β1=0.9,β2=0.999,ϵ=10-8的ADAM 优化器[27].本文在训练模型中使用权值归一化处理[28],初始学习率设置为 1 0-3,共训练1 000 个迭代周期,并且每200 个迭代周期学习率衰减为原先的一半.使用L1损失函数.为了验证本文方法性能,使用Set5[29]标准测试数据集以及DIV2K 数据集中第801~810张高质量图像(标记为DIV2K-10)进行对比实验,Set14[30]、B100[31]、Urban100[32]和Manga109[33]共4个标准测试数据集进行测试,并使用平均峰值信噪比(Peak signal-to-noise ratio,PSNR)[34]与结构相似性(Structural similarity index,SSIM)[34]指标评价实验结果.模型使用PyTorch 实现,并在NVIDIA GeForce RTX 2080Ti GPU 上训练.

2.2 实验分析

2.2.1 残差组实验分析

本文提出模型包含3 个残差组,并且每组内包含相同数目的双层嵌套残差块.为了验证残差组内不同数目的双层嵌套残差块对模型的影响,本文在Set5 标准测试数据集以及DIV2K-10 数据集上进行4 倍超分辨率实验,对组内数目分别为5、6、7 的残差组作对比实验.如表1 所示,组内数目为6 时性能最佳.对比组内数目为5 时,虽然参数量提高0.24 MB,但是PSNR 指标分别在Set5 与DIV-2K-10 数据集上提高0.03 dB和0.04 dB,而当组内数目为7 时,PSNR 指标提升不明显,参数量却提高0.24 MB.本文模型残差块个数为6,是一个合理的选择.

表1 Set5和DIV2K-10 数据集上,放大4 倍,运行200 个迭代周期,残差组中不同双层嵌套残差块数模型的平均PSNR 及参数量Table 1 Average PSNRs and number of parameter with different numbers of DRBs in the residual group with a factor of × 4 on Set5 and DIV2K-10 datasets under 200 epochs

2.2.2 SFMU 单元实验分析

为了验证浅层特征映射单元不同支路上卷积核大小,以及未使用浅层特征映射单元等情形对模型的影响,本文在Set5 标准测试数据集与DIV2K-10 数据集上,进行4 倍超分辨率对比实验.如表2所示,未使用浅层特征映射单元导致模型无法使用浅层特征信息,致使重建效果较差.而当每条支路使用相同大小的卷积核,且卷积核大小不断增加时,重建效果提升,然而参数量也随之增加.当支路卷积核均为1 时,PSNR 指标低于未使用浅层特征映射单元的模型,这是由于提取的特征信息较少,存在冗余信息,导致效果较差.本文发现当三条支路卷积核分别设置1、3、5 时效果最佳.这是由于每一条支路可以提取不同层次的浅层特征信息,可以有效地与深层层次特征信息进行组合使用.因而本文使用支路卷积核大小分别为1、3、5 的浅层特征映射单元.

表2 Set5 与DIV2K-10 数据集上,放大4 倍,运行200 迭代周期,浅层特征映射单元支路不同卷积核设置的平均PSNRTable 2 Average PSNRs of the models with different convolutional kernel settings for SFMU branches for× 4 on Set5 and DIV2K-10 datasets under 200 epochs

2.2.3 DRB 对比实验分析

相比于流行的残差块结构,如图2(a)所示,本文的DRB 在性能和参数量上均有优势.本文在Set5 与DIV2K-10 数据集上进行4 倍超分辨率对比实验.本文构建了两个测试模型,分别称为模型I和模型II.模型I 是EDSR 架构,但是,卷积层输入输出通道数从256 缩减为64,残差块数从32 缩减为18.模型II 是把模型I 中残差块替换为DRB.在DRB 扩张阶段,EU 输入输出特征通道数分别设置为32 与64,IU 输入输出特征通道数分别设置为64 与128;在压缩阶段,EU 输入输出特征通道数分别设置为64 与32,IU 输入输出特征通道数分别设置为128 与64.模型I和模型II 中其他参数都是相同的:残差尺度参数为0.1,运行200 个迭代周期.结果如表3 所示,在Set5 与DIV2K-10 数据集上,模型II 的PSNR 分别高于模型I0.01 dB和0.05 dB,而本文的DRB 比ERSR 残差块的参数量少20.3 KB.

表3 Set5 与DIV2K-10 数据集上,放大4 倍,运行200 个迭代周期,不同模型的平均PSNRTable 3 Average PSNRs of different models for × 4 super-resolution on Set5 and DIV2K-10 datasets under 200 epochs

2.2.4 ACW 对比实验分析

为了验证ACW 的有效性,考虑第2.2.3 节中模型I 包含和不包含ACW 两种情形,结果如表4所示.使用ACW 后,Set5 与DIV2K-10数据集上PSNR 分别提高0.02 dB和0.03 dB.实验结果表明,ACW 自动学习最优的残差尺度参数是有效的.

表4 Set5和DIV2K-10 数据集上,放大4 倍,运行200 个迭代周期,包含/不包含ACW 模型的平均PSNRTable 4 Average PSNRs of the models with/without the ACW for × 4 super-resolution on the Set5 and DIV2K-10 datasets under 200 epochs

2.2.5 MPRU 对比实验分析

为了验证本文的MPRU 重建性能,本文把第2.2.3 节模型I 中的EDSR 重建单元替换为MPRU后,与模型I 进行比较,两个模型的结果分别对应于表5 中EDSR 重建单元和MPRU.MPRU参数量仅为9.36 KB,大约只有EDSR 重建单元参数量的1/32 (297.16 KB).在Set5 与DIV2K-10 数据集上,本文MPRU 使PSNR 分别提高了0.02 dB和0.05 dB.

表5 Set5和DIV2K-10 数据集上,放大4 倍,运行200 个迭代周期,不同重建单元模型的平均PSNRTable 5 Average PSNRs of the models with different reconstruction modules for × 4 super-resolution on Set5 and DIV2K-10 datasets under 200 epochs

2.3 模型分析

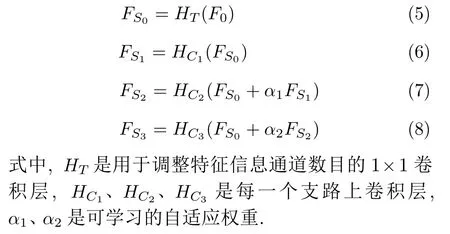

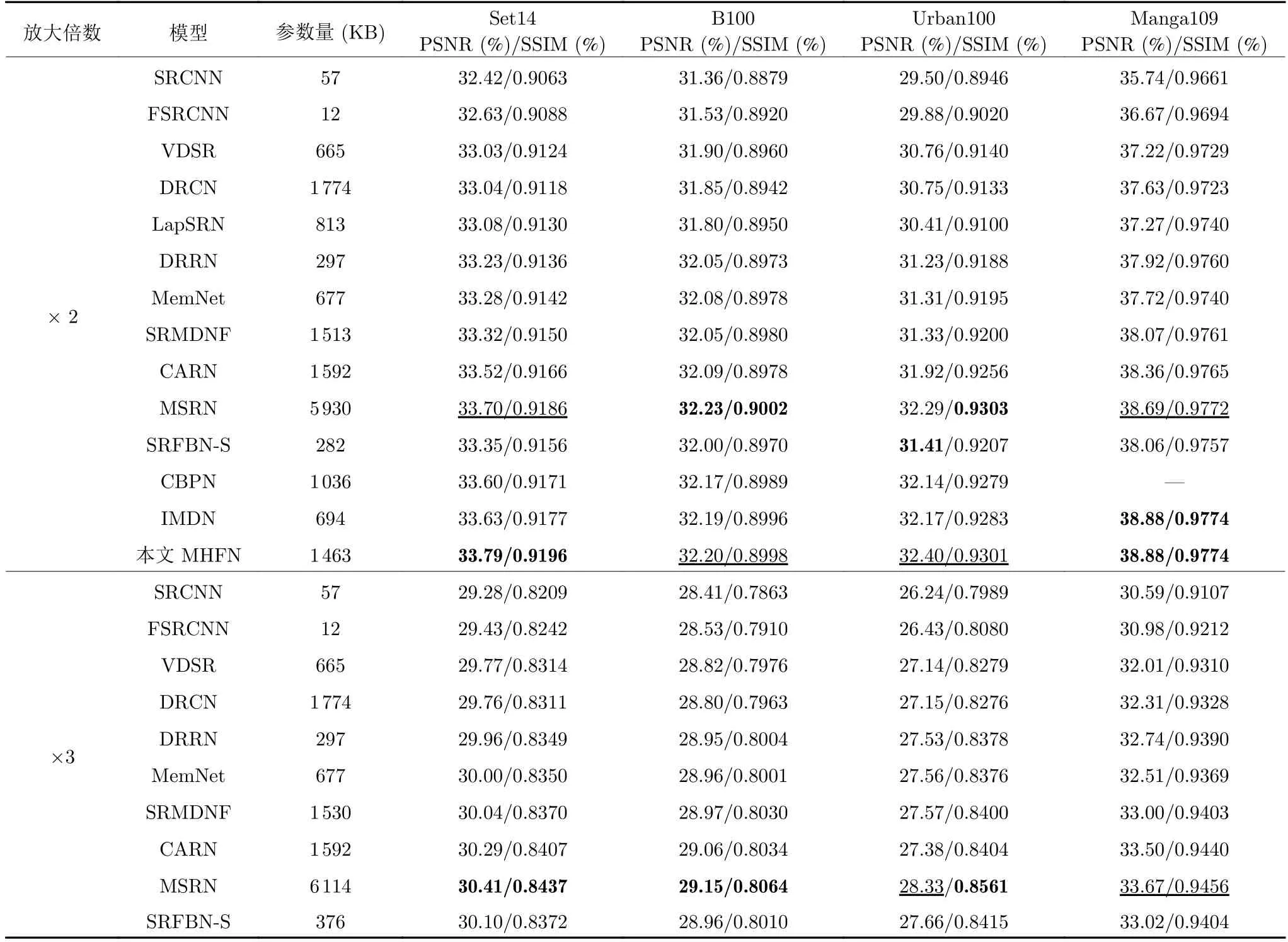

本文提出的模型在Set14、B100、Urban100和Manga109 标准测试集验证2 倍、3 倍、4 倍和8 倍超分辨率性能.并与轻量级的SRCNN[7]、FSRCNN[35]、VDSR[15]、DRCN[8]、DRRN[9]、LapSRN[20]、CARN[10]、SRFBN-S[17]、IMDN[18]、CBPN[19]、MSRN[11]、MemNet[36]和SRMDNF[37]进行性能对比.

1)客观指标如表6 所示,最好的结果与次好结果分别以粗体和下划线形式标出.在Set14 数据集上,放大因子为2 倍时,本文的MHFN 模型比CARN模型PSNR 高出0.27 dB,在其他放大因子的情况下类似,并且MHFN 模型参数量比CARN 更少(大约减少了120 KB).在所有测试数据集上,放大因子为4 倍时,MHFN 模型比CBPN 模型和IMDN 模型PSNR 平均高出0.06 dB 与0.16 dB.虽然在部分数据集上,MSRN 性能略好,但本文的MHFN综合性能更好,MSRN 的4 倍模型参数量是本文MHFN 的4 倍.

表6 各个SISR 方法的平均PSNR和SSIMTable 6 The average PSNRs/SSIMs of different SISR methods

表6 各个SISR 方法的平均PSNR和SSIM (续表)Table 6 The average PSNRs/SSIMs of different SISR methods (continued table)

2)主观视觉如图4 所示,本文对比Urban100标准测试数据集中img012、img024 与img046 图像以及Manga109 标准测试数据集中的Highschool-Kimengumi_vol20 (HK_vol20)图像.在图像img-012 中,IMDN 与MSRN 重建结果与原图像条纹方向相反,本文的模型正确重建了条纹的方向,可能是浅层特征提取单元获取了更丰富的浅层特征信息,帮助重建单元重建出更精确的结果.在img046图像中,Bicubic 插值、SRCNN 模型和VDSR 模型重建图像非常模糊,LapSRN 模型、CARN 模型、SRFBN-S 模型、IMDN 模型与MSRN 模型重建结果严重失真,本文结果显著更好.类似地,在img-024 图像中,本文模型与其他方法均存在恢复的条纹数目与原图像不一致的问题.其他方法均严重模糊和失真,本文的重建结果也显著更好.在HK_-vol20 图像中,其他方法眼睛部位重建模糊和走样,本文重建结果显著优于其他方法,是清晰可视的.

图4 标准测试集放大4 倍视觉效果比较Fig.4 Visual qualitative comparison of × 4 super-resolution on the standard test datasets

如图5 所示,当放大因子为8 倍时,本文的模型重建效果显著优于其他模型.在img092 图像中,LapSRN 模型与MSRN 模型重建图像条纹方向与原图像相反,本文的重建结果很接近于原图像.在ppt3 图像中,本文重建结果比其他模型显著更清晰.对于规则形状和结构的重建,本文模型性能提升显著.如何进一步提高不规则形状和结构的重建质量,是本文未来的研究工作.

图5 标准测试集下放大8 倍视觉效果比较Fig.5 Visual qualitative comparison of × 8 superresolution on the standard test datasets

3 结束语

本文提出一种轻量级的多层次特征融合网络(MHFN),用于重建高质量的超分辨图像.本文设计了双层嵌套残差块(DRB)用于提取图像特征信息,其特征通道数目先扩张后压缩,并且使用不同感受野的卷积层,降低参数量.为了使双层嵌套残差块有效传递特征信息,本文设计了自相关权重单元(ACW),通过计算特征信息生成权重信息,再利用权重信息对特征信息进行加权处理,保证高权重的特征信息被有效传递.本文将双层嵌套残差块组成残差组,用于提取深层的层次特征信息,并构建浅层特征映射单元(SFMU)提取多尺度、多层次的浅层特征信息.多路重建单元(MPRU)将深层的层次特征信息与浅层特征信息融合重建为高质量超分辨率图像.实验结果表明,上述模块设计有助于重建高质量图像,并且本文的模型可以有效增强图像条纹,重建高质量超分辨图像.与其他轻量级模型相比,本文模型在性能与模型规模方面上获得了更好的平衡.