区别性知识利用的迁移分类学习*

2017-03-16王士同杭文龙

程 旸,王士同,杭文龙

江南大学 数字媒体学院,江苏 无锡 214122

区别性知识利用的迁移分类学习*

程 旸+,王士同,杭文龙

江南大学 数字媒体学院,江苏 无锡 214122

目前的迁移学习模型旨在利用事先准备好的源域数据为目标域学习提供辅助知识,即从源域抽象出与目标域共享的知识结构时,使用所有的源域数据。然而,由于人力资源的限制,收集真实场景下整体与目标域相关的源域数据并不现实。提出了一种泛化的经验风险最小化选择性知识利用模型,并给出了该模型的理论风险上界。所提模型能够自动筛选出与目标域相关的源域数据子集,解决了源域只有部分知识可用的问题,进而避免了在真实场景下使用整个源域数据集带来的负迁移效应。在模拟数据集和真实数据集上进行了仿真实验,结果显示所提算法较之传统迁移学习算法性能更佳。

迁移学习;经验风险最小化(ERM);泛化的经验风险最小化(GERM);区别性知识利用;负迁移

1 引言

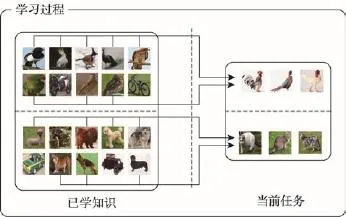

美国心理学家Anderson提出了自适应思维控制理论(adaptive control of thought,ACT)[1],把人类认知分为过程性认知和陈述性认知,并把认知过程分为两个阶段:首先是过程性认知上升为陈述性认知,然后陈述性认知在任务间迁移,并在新任务中产生新的过程性认知。由于过程性认知的不足,对于某些新任务,即使人们只学习到其某些特征,陈述性认知会选择性地利用大脑中的旧任务知识对该新任务进行识别、学习并转化为过程性认知的新任务。在陈述性认知过程中,大脑会根据新任务的某些特征检索与其相关的旧任务,以便推理得到更多、更具体的认知[1]。如图1所示的例子,若在过程性认知中已掌握了源域中的任务,当接触到识别鸡的新任务时,会根据鸡的外形等特征迅速检索到同属鸟纲类的鸟类动物。同样的情形也适用于猫科类动物的识别。

Fig.1 Two examples of using related knowledge on birds and dogs while learning target objects chicken and cats图1 使用相关鸟类和狗类知识帮助目标域鸡类和猫类对象学习示例

机器学习自从诞生起,一直在模仿人类的认知学习过程。毫无疑问,认知心理学的发展促进了机器学习的发展。然而,区别性知识利用是人类所特有的,传统的机器学习并无此认知能力,即传统的机器学习算法在辅助学习时没有考虑如何检索仅与当前任务相关的经验知识。目前,模仿人类的学习方式,利用先前知识辅助当前任务学习的迁移学习[2-3]吸引了越来越多人的关注,但绝大多数迁移学习算法都是在事先准备好的源域数据上获得较高的识别度。考虑到人工成本的攀升,在现实场景中筛选出同一分布的源域数据并不现实。并且由于常规迁移学习模型并没有考虑如何从源域中抽选出与目标域相关的源域子集,使得在常规场景下的迁移学习知识利用并不可靠,极有可能出现负迁移的情况。本文给出一种泛化的经验风险最小化模型,在此基础上提出了区别性迁移学习框架,并给出了风险上界。与当前迁移学习算法相比,本文所提算法具有以下特性:

(1)提出了一种基于泛化的经验风险最小化区别性知识利用迁移学习模型,更有效地利用了源域知识,其中心思想是利用与目标域相关的源域子集数据辅助目标域学习。

(2)提出了一种源域相关数据选择算法,通过保持源域与目标域数据分布一致的原则,筛选出部分相关数据,进而避免了负迁移。

2 相关工作

美国国防部DARPA机器人大赛文档系列在2005年给出了迁移学习的基本定义:利用事先学习的知识和技能来识别新任务的学习能力。根据此定义,迁移学习旨在抽取有用的历史知识,并用此类知识来帮助新任务的学习。根据所抽取的知识,迁移学习方法所使用的技术大概可分为三大类:

(1)实例迁移方法。实例迁移的主要思想是假设源域中有部分数据可以直接用来辅助目标域的学习[3-4],通过诸如聚类等方法,挑选出一些最具代表性的源域数据用于帮助目标域建模。其中,比较著名的是Liao等人在文献[4]中展示了一种利用自主学习推断出目标域数据标签的方法;Dai等人提出了基于Adaptive Boosting(AdaBoost)[5]算法的迁移学习算法;Wu等人在文献[6]中提出了一种基于支持向量机的框架,通过整合源域数据提高分类精度。

(2)特征迁移方法。特征迁移学习方法旨在获得一个理想的特征表示,并通过将该特征表示嵌入到某个知识共享框架中来降低源域和目标域的差异,以此提高目标域的学习效果[7-8]。典型的有Bart和Ullman[8]提出用新类别中的单个实例特征来自适应目标域的特征,以达到提高精度的效果。

(3)参数模型迁移方法。大部分基于参数模型迁移的方法都基于一个假设,即源域和目标域共享某些参数或者先验分布[9-11]。Tommasi等人在文献[9]中提出了一种基于最小二乘支持向量机的有区别的迁移学习策略,通过留一法自适应源域和目标域的学习程度。Li等人在文献[10]中提出了一种基于贝叶斯先验模型的参数迁移方法,使用源域获得的参数模型知识辅助目标域的学习。

从以上分析可以看出,目前大多数迁移学习建模方法旨在一系列事先准备好的源域数据集上取得最优的知识迁移效果。但实际情况下,筛选出来自同一领域的数据涉及大量的人力物力,已不现实。在这种情况下,如何高效地选出仅和目标域相关的源域数据来辅助目标域学习是关系迁移学习成败的关键。目前,这方面的相关工作较少,较著名的有ASVM(adaptive support vector machine)[12]和CD-SVM(cross-domain support vector machine)[13]。在文献[12]中,提出了自适应支持向量机A-SVM,即在SVM(support vector machine)的目标函数中引入一个新的规则化项,旨在同时最小化源域数据和目标域有标签数据的分类误差以及目标和原始分类器之间差异。但是由于其样本选择策略是基于最小化期望误差,这需要在上一次迭代更新得到的样本集上重新训练并更新,这种策略某种程度上会导致A-SVM效率较低且精度受限。文献[13]中提出了一种基于源域支撑向量的方法,其旨在约束目标域数据与源域数据支撑向量保持流型一致,即目标域数据落在源域支撑向量近邻范围内的应当保持标签一致。CDSVM的缺点在于其在选择源域支撑向量时,没有充分考虑领域间的差异性。其选择的源域支撑向量对源域数据具有较低的实际风险,却不能够较好地自适应目标域数据学习,极端情况下,甚至会降低目标域的学习效率和精度。

不同于A-SVM和CD-SVM的样本选择策略,本文提出了一种新的方法,通过一般化的经验风险最小化验证了仅仅和目标域相关的源域数据才能保证知识迁移的风险上界,并提出了一种选择方法,用于筛选出源域与目标域分布一致的数据。

3 基于一般化经验风险最小化模型的区别性知识利用迁移学习方法框架

3.1 经验风险最小化

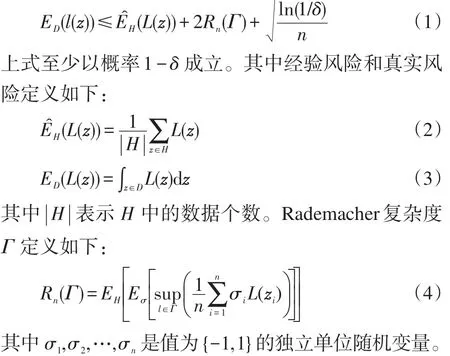

在传统的半监督学习框架中,经验风险最小化(empirical risk minization,ERM)准则被成功地应用于解决许多机器学习和数据挖掘问题[14]。给定一个数据集H服从分布p(z),从中随机选取n个独立同分布的数据。若使用Rademacher复杂度指标测量目标函数的复杂性,真实风险和经验风险之间满足如下不等式:

3.2 一般化经验风险最小化

ERM准则的主要问题在于其要求H中的数据独立同分布且符合同一分布p(z),也就是说测试数据必须与训练数据分布一致,这极大限制了在真实环境中的应用。在迁移学习中,如何选出与目标域分布最接近的源域数据,即去除干扰数据是保证正迁移的首要条件。

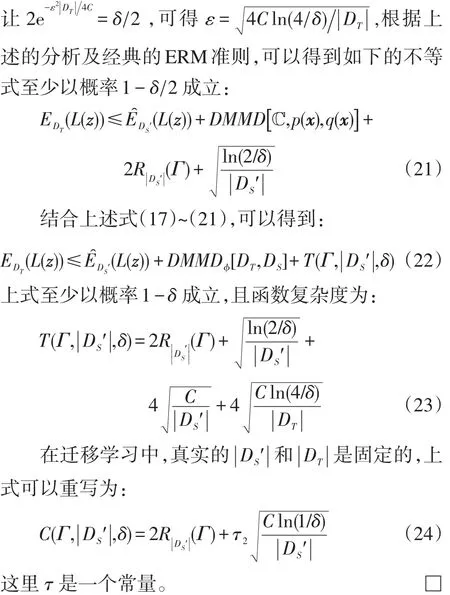

在迁移学习中,源域数据分布q(z)通常与目标域不同,即p(z)≠q(z)。则一般化的经验风险最小化(generalized empirical risk minimization,GERM)准则上界可以表示为:

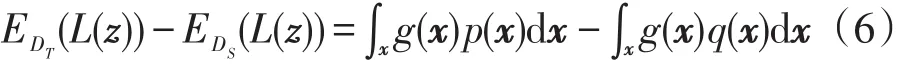

在迁移学习中,若源域和目标域数据分布不一致,但有着相同的条件分布[2],即p(x,y)=p(x)p(y|x),q(x,y)=q(x)p(y|x),可以得到:

式(6)中,g(x)=∫yL(f(x),y)p(y|x)dy。函数g有界并且可测,可以得到一个实际的有界且连续的函数。最终,通过函数和不等式的性质,可以得到:

这里是关于变量x且属于有界连续函数类ℂ(x)。

3.3 基于一般化经验风险最小化模型的区别性知识利用迁移学习方法

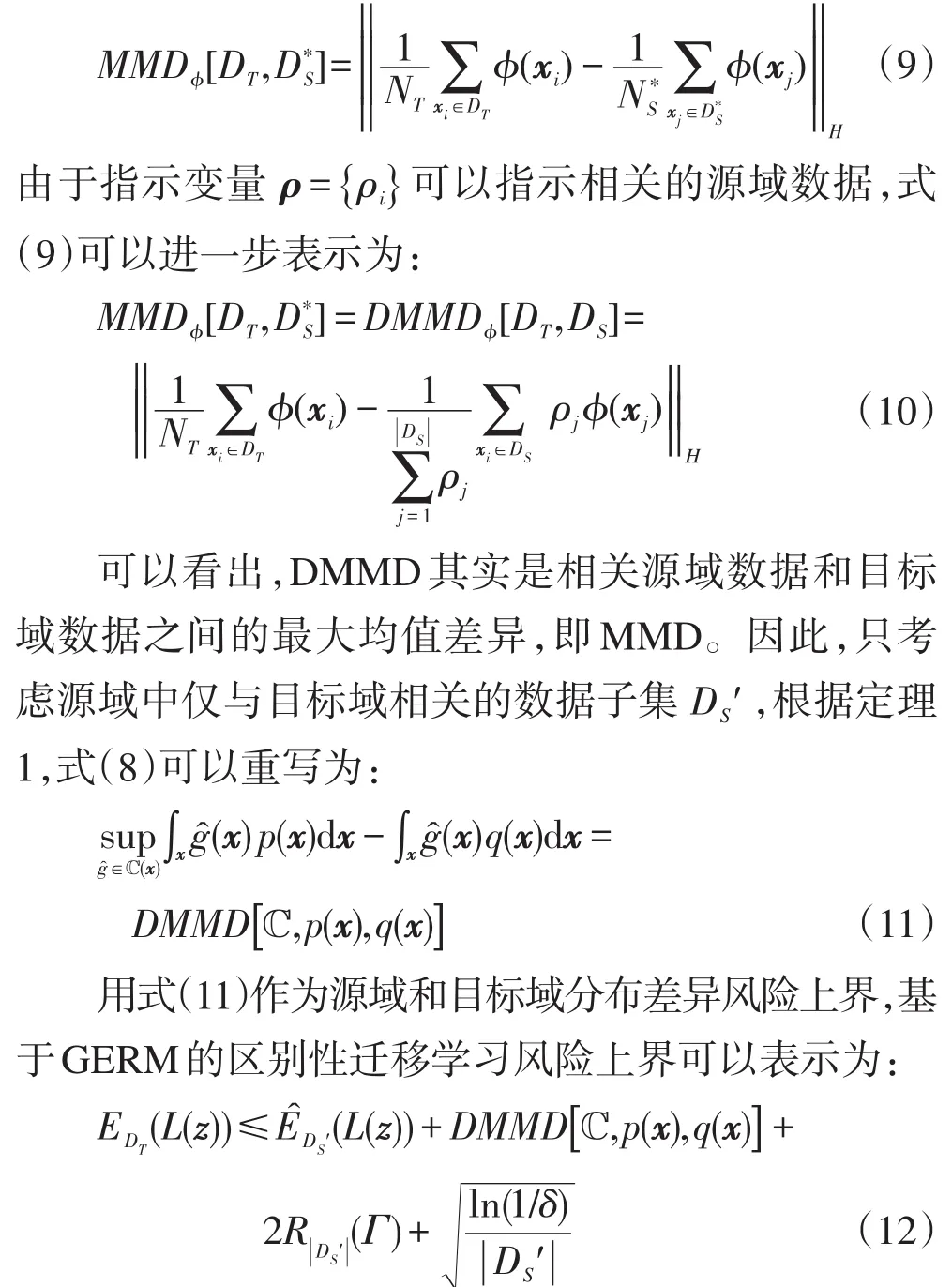

由于真实场景下收集的历史数据不可能完全和目标域相关,仅筛选出部分相关的数据来辅助目标域的学习是关系知识迁移成功的关键。因此如何筛选出这些数据,最小化源域和目标域之间的分布差异是保证正迁移的关键。首先定义区别性最大均值差异(discriminativemaximum meandiscrepancy,DMMD)。

定义1(区别性最大均值差异)用NS个变量ρ=表示源域的每一个数据指示器。ρi=1表示该数据可以被用来辅助目标域学习,则DMMD可以定义如下:

定理1考虑一组确定的变量ρ={ρi},指示相关的源域数据,则仅对于相关的源域数据和目标域数据而言,式(8)等价于最大均值差异(maximum mean discrepancy,MMD)[16]。

证明假设表示源域中与目标域相关的数据的个数,则这些相关源域数据构成的子集和目标域DT之间的MMD可以表示为:

用Kij=K(xi,xj)=ϕ(xi)Tϕ(xj)表示核矩阵,可以把DMMD拓展到再生核希尔伯特空间(reproducing kernel Hilbert space,RKHS)。则基于GERM的迁移学习的风险上界可以用下面的定理描述,即式(12)同样至少以概率1-δ成立。由于在绝大多数实际情况中,源域数据较充足,本文仅仅考虑源域数据量大于目标域数据的情况。 □定理2令zi=(xi,yi),这里xi∈ℝd并且yi∈{- 1,+1}。假设核函数有上界C,即0≤Kij≤C,∀xi,xj。在迁移学习的框架内,如下的GERM不等式至少以概率1-δ成立。

这里DMMD和函数复杂度项表示如下:

这里,τ为一个常量;为相关的源域数据子集。

证明文献[17]给出了真实MMD和经验MMD间的关系,由定理1可知,真实DMMD和经验DMMD之间同样满足:

3.4 区别性源域样本选择

本文用NS个指示器表示源域中的每个数据点。如果ρi=1,对应的源域数据点被认为是可以安全使用的。通过最小化如下DMMD可以得到ρ:

这里1为|DN|维单位向量。上述最优化问题是一个凸二次规划问题,有全局最有解。得到的不为0的α所对应的源域数据即为源域和目标域相关的源域数据子集。

3.5 问题求解

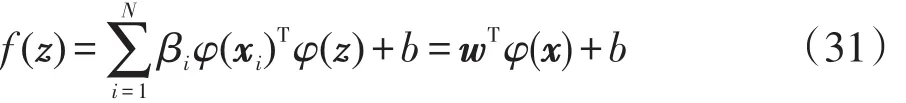

根据上一节源域相关数据求解,可以得到和目标域分布最接近的数据,此部分数据可以被用来进行知识迁移。此节,结合最小二次支持向量机和源域相关数据,提出区别性知识利用的迁移学习目标表达式:

在核理论的基础上,通过表示定理,可以得到最终的决策函数如下:

算法的时间复杂度分析如下:式(29)和式(31)的时间复杂度均为n3,因此总的时间复杂度为2n3。此外本文算法仅仅选出与目标域相关的源域数据,因此其在目标域的决策函数中可能会包含更少的支持向量。实验表明本文算法的实际时间对比传统的迁移学习算法具有明显优势。

4 实验与分析

此部分,在人造数据集和真实图像、文本数据集上验证所提算法的有效性。

在人造数据集部分,使用双月数据集,其中目标域由300个数据样本构成(正、负类各150个)。源域数据集构造如下:将目标域数据集逆时针旋转10°、20°、30°和40°,并对每个数据点增加均值为0,方差为2的高斯噪声。由于旋转和噪声,目标域数据已和源域数据产生了分布差异,且一些随机噪声导致了源域部分数据无法用来辅助目标域学习。表1给出了人工数据集更详细的说明。

Table 1 Synthetic dataset表1 人造数据集

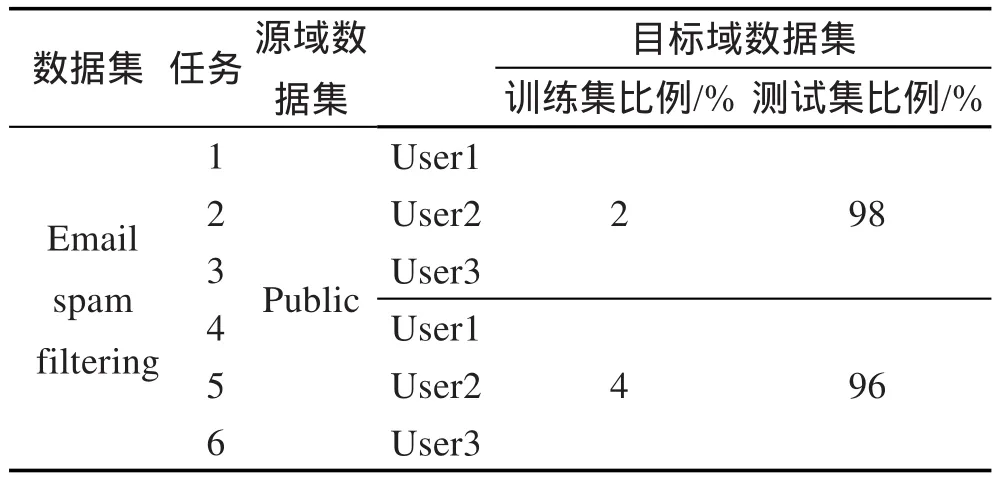

在真实数据集部分,使用了图像公共数据集Caltech-256[18]。Caltech-256包含了30 607张图片,共有256类。使用其中的车辆数据集,包含5个子类:fire-truck、school-bus、car-side、moto-bike和snow-mobile。本文使用了PHOG(pyramid histogram of oriented gradients)特征描述方法对图片进行特征提取,并构造moto-bike和snow-mobile为负类,其他均为正类。表2给出了数据集设置的更多细节。

在文本数据集方面,使用了公共垃圾邮件数据集email spam filtering[19],包括一个公共邮件集(Public)和3个用户邮件集(User1、User2和User3)。其中,每个用户邮件集有2 500份邮件,公共邮件集有4 000份邮件。每一份邮件都是一个字符集合,共有206 908维。按文献[20]中所提方法对所有邮件进行降维。具体关于源域和目标域的设置如表3。

本文采用如下对比算法:

(1)最小二乘SVM(LS-SVM)。

(2)归纳式最小二乘SVM(ILS-SVM)。

(3)自适应SVM(A-SVM)[12]。

(4)交叉SVM(CD-SVM)[13]。

Table 2 Image dataset表2 图像数据集

Table 3 Text dataset表3 文本数据集

Table 4 Classification accuracy obtained by different inductive transfer learning algorithms on synthetic dataset表4 不同的归纳式迁移学习算法在人造数据集上的分类精度对比

(5)本文算法DLS-SVM。

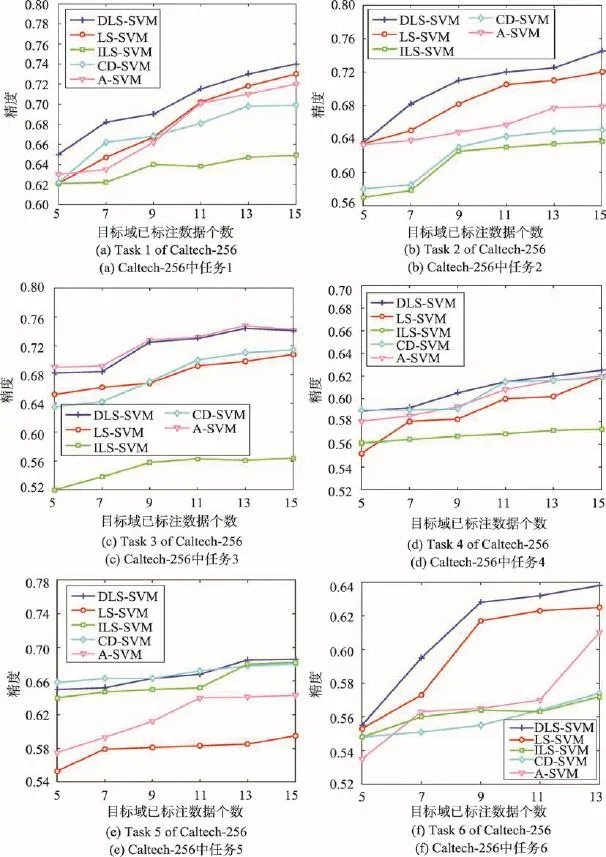

从目标域中随机抽出一些数据点,用作目标域的标注数据。所有实验均运行10次,给出均值和方差。表4给出了在人造数据集上5种方法的运行效果。由表4中可以看出,DLS-SVM明显优于直接利用源域数据集的对比算法,进一步说明了所提算法的有效性。接下来将进一步对比所提算法与传统算法在真实图像和文本数据集上的效果。图2给出了各个对比算法在图像数据集上的对比效果,表5和表6给出了在文本数据集上的分类效果。随着已标注目标域数据的增加,各个分类算法的效果趋于平稳。可以看出,相对于其他对比算法,所提算法具有明显的优势。另外,还能得到如下观察结论:

Fig.2 Classification accuracy obtained by 5 algorithms on image dataset图2 5种对比算法在图片数据集上的分类精度

(1)根据数据集Caltech-256[18]中源域和目标域数据集的产生方式以及表2中的设置,并非所有的源域图片都适合用于知识迁移。因此,本文算法理论上比其他归纳式迁移学习算法更适用于此类真实场景。从图2(a)~(f)可以看出,DLS-SVM算法可以有效地检索出和目标域相关的源域数据子集来提高目标域的分类效果。

(2)在人造数据集上对本文实验的中间过程做了进一步的观察,得到如下结论:表4中,对源域1、源域2、源域3和源域4进行分布一致性求解时,分别得到了152、128、89和52个源域数据子集,进一步验证了本文所提分布一致性策略的有效性。仅仅参考部分相关源域数据子集,对目标域数据的学习,无论在精度还是时间上都将得到提升。

(3)从表4和图2可以看出,本文算法在人造数据集和图片数据集中的大多数情况下都取得了显著的结果。由于CD-SVM和ILS-SVM算法最主要的局限性在于它们虽然考虑了所有源域数据,但是并没有考虑与目标域不相关的数据对目标分类器造成的干扰,因此这些算法所生成的目标模型并不完善。对于A-SVM而言,在部分情况下取得了较好的结果,如图2(c),但是其样本选择策略是基于最小化期望误差,这需要在上一次迭代更新得到的样本集上重新训练并更新,这种策略导致了大部分情况下ASVM的精度受到影响。

(4)表5和表6展示了各种对比算法在文本数据集上的分类对比效果。随机抽取了目标域2%和4%的数据作为目标域有标注数据。与传统归纳式迁移学习算法对比可以发现,本文算法在目标域已标注数据匮乏的情况下明显优于传统方法。随着目标域已标注数据的增多,传统半监督方法LS-SVM同样得到了很好的分类效果,这与实际相吻合。

(5)图3显示的是5种对比算法在图片数据集中的平均总运行时间,即训练时间与测试时间之和。从图3中可以看出,LS-SVM算法的运行时间相对于其他算法较短,这是因为其训练样本较少。相对于ILS-SVM、A-SVM和CD-SVM,本文算法的运行时间具有明显优势。由于A-SVM需要不断迭代选择与目标域数据分布一致的源域数据子集,且在迭代过程中得到目标域分类精度,花费较多时间在迭代计算过程且不能保证收敛于全局最优值。对于CD-SVM而言,其增加流型约束项增加了核函数计算成本,导致目标域分类器的学习效率降低。且流型约束项中的近邻个数的选择对目标域分类器的学习影响较大。也就是说,尽管DLS-SVM需要使用额外的时间计算源域的相关数据,但是仅有部分源域相关数据被用于知识的迁移,因此通常决策函数包含了较少的支撑向量,从而使得本文算法具有更短的测试时间,总运行时间具有优势,如图3所示。

Table 5 Classification accuracy obtained by different inductive transfer learning algorithms on email dataset with 2%training samples and 98%testing samples表5 不同的归纳式迁移学习算法在已标注2%的垃圾邮件数据集上的分类精度对比

Table 6 Classification accuracy obtained by different inductive transfer learning algorithms on email dataset with 4%training samples and 96%testing samples表6 不同的归纳式迁移学习算法在已标注4%的垃圾邮件数据集上的分类精度对比

Fig.3 Total running time obtained by 5 algorithms on image dataset图3 5种对比算法在图片数据集上的总运行时间对比

(6)综合在图片数据集和文本数据集上的实验结果可以发现,本文算法明显优于传统的归纳式迁移学习算法,即本文算法是一种有效的数据选择、合理利用历史数据的方法。这表明应该筛选出仅和目标域相关的源域数据子集并加以利用,可以更好地避免负迁移。

5 结束语

本文针对现实情况中源域存在干扰样本导致传统数据分析任务失效的问题,拓展了经典的ERM,使其适用于迁移学习机制,利用部分相关源域知识辅助目标域学习,提出了一种新的基于泛化的经验风险最小化区别性知识利用迁移学习算法。本文算法是一种基于数据分布一致性的知识迁移聚类算法,其只利用了源域数据的部分相关数据子集,得到了更具指导意义的有效知识,进而确保了利用的源域知识不会对源域造成负迁移。最后,结合最小二乘支持向量机,进一步提出了DLS-SVM算法。在人工数据集和真实数据集上的实验结果反映了DLSSVM算法对于领域间知识迁移学习的有效性。

[1]Anderson J R.Cognitive psychology and its applications [M].7th ed.New York:Freeman,2010.

[2]Mao Fagui,Li Biwen,Shen Beijun.Cross-project software defect prediction based on instance transfer[J].Journal of Frontiers of Computer Science and Technology,2016,10 (1):43-55.

[3]Hang Wenlong,Jiang Yizhang,Qian Pengjiang,et al.Transfer affinity propagation clustering algorithm[J/OL].Journal of Software(2015-11-26)[2015-12-05].doi:10.13328/j. cnki.jos.004921.

[4]Liao Xuejun,Xue Ya,Carin L.Logistic regression with an auxiliary data source[C]//Proceedings of the 22nd International Conference on Machine Learning,Bonn,Germany, Aug 7-11,2005.New York:ACM,2005:505-512.

[5]Dai Wenyuan,Xue Guirong,Yang Qiang,et al.Transferring naive Bayes classifiers for text classification[C]//Proceedings of the 22nd National Conference on Artificial Intelligence, Vancouver,Canada,Jul 22-26,2007.Menlo Park,USA: AAAI Press,2007:540-545.

[6]Wu Pengcheng,Dietterich T G.Improving SVM accuracy by training on auxiliary data sources[C]//Proceedings of the 21st International Conference on Machine Learning,Banff, Canada,2004.New York:ACM,2004:110.

[7]Daume III H,Marcu D.Domain adaptation for statistical classifiers[J].Journal of Artificial Intelligence Research, 2006,26(1):101-126.

[8]Bart E,Ullman S.Cross-generalization:learning novel classes from a single example by feature replacement[C]//Proceedings of the 2005 IEEE Computer Society Conference on Computer Vision and Pattern Recognition,San Diego,USA, Jun 20-25,2005.Washington:IEEE Computer Society,2005: 672-679.

[9]Tommasi T,Orabona F,Caputo B.Learning categories from few examples with multi model knowledge transfer[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2014,36(5):928-941.

[10]Li Feifei,Fergus R,Perona P.One-shot learning of object categories[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2006,28(4):594-611.

[11]Yang Changjiang,Deng Zhaohong,Jiang Yizhang,et al. Adaptive recognition of epileptic EEG signals based on transfer learning[J].Journal of Frontiers of Computer Science and Technology,2014,8(3):329-337.

[12]Jun Yang,Rong Yan,Hauptmann A G.Adapting SVM classifiers to data with shifted distributions[C]//Proceedings of the 7th IEEE International Conference on Data Mining Workshops,Omaha,USA,Oct 28-31,2007.Washington: IEEE Computer Society,2007:69-76.

[13]Jiang Wei,Zavesky E,Chang S F,et al.Cross-domain learning methods for high-level visual concept classification[C]// Proceedings of the 15th IEEE International Conference on Image Processing,San Diego,USA.Oct 12-15,2008.Piscataway,USA:IEEE,2008:161-164.

[14]Burges C J C.A tutorial on support vector machines for pattern recognition[J].Data Mining and Knowledge Discovery, 1998,2(2):121-167.

[15]Dudley R M.Real analysis and probability[M].Cambridge, UK:Cambridge University Press,2002.

[16]Borgwardt K M,Gretton A,Rasch M J,et al.Integrating structured biological data by kernel maximum mean discrepancy[J].Bioinformatics,2006,22(14):e49-e57.

[17]Gretton A,Borgwardt K M,Rasch M J,et al.A kernel twosample test[J].The Journal of Machine Learning Research, 2012,13(1):723-773.

[18]Gehler P,Nowozin S.On feature combination for multiclass object classification[C]//Proceedings of the 2009 IEEE 12th International Conference on Computer Vision,Kyoto, Sep 29-Oct 2,2009.Piscataway,USA:IEEE,2009:221-228.

[19]Bickel S.ECML-PKDD discovery challenge 2006 overview [C]//ECML-PKDD Discovery Challenge Workshop,Antwerp,Belgium.Piscataway,USA:IEEE,2006:1-9.

[20]Deng Zhaohong,Choi K S,Jiang Yizhang,et al.Generalized hidden-mapping ridge regression,knowledge-leveraged inductive transfer learning for neural networks,fuzzy systems and kernel methods[J].IEEE Transactions on Cybernetics, 2014,44(12):2585-2599.

附中文参考文献:

[2]毛发贵,李碧雯,沈备军.基于实例迁移的跨项目软件缺陷预测[J].计算机科学与探索,2016,10(1):43-55.

[3]杭文龙,蒋亦樟,刘解放,等.迁移近邻传播聚类算法[J/OL].软件学报(2015-11-26)[2015-12-05].doi:10.13328/j. cnki.jos.004921.

[11]杨昌健,邓赵红,蒋亦樟,等.基于迁移学习的癫痫EEG信号自适应识别[J].计算机科学与探索,2014,8(3):329-337.

CHENG Yang was born in 1991.He is an M.S.candidate at Jiangnan University,and the student member of CCF. His research interests include artificial intelligence and pattern recognition,etc.

程旸(1991—),男,江苏苏州人,江南大学硕士研究生,CCF学生会员,主要研究领域为人工智能,模式识别等。

WANG Shitong was born in 1964.He received the M.S.degree in computer science from Nanjing University of Aeronautics and Astronautics in 1987.Now he is a professor and Ph.D.supervisor at School of Digital Media,Jiangnan University.His research interests include artificial intelligence,pattern recognition and image processing,etc.

王士同(1964—),男,江苏扬州人,1987年于南京航空航天大学获得硕士学位,现为江南大学数字媒体学院教授、博士生导师,主要研究领域为人工智能,模式识别,图像处理等。在国内外重要核心期刊上发表论文近百篇,其中SCI、EI收录50余篇,主持或参加过6项国家自然科学基金项目,1项国家教委优秀青年教师基金项目,其他省部级科研项目10多项,先后获国家教委、中船总公司和江苏省省部级科技进步奖5项。

HANG Wenlong was born in 1988.He is a Ph.D.candidate at Jiangnan University,and the student member of CCF.His research interests include artificial intelligence and pattern recognition,etc.

杭文龙(1988—),男,江苏南通人,江南大学博士研究生,CCF学生会员,主要研究领域为人工智能,模式识别等。

Discriminative Knowledge-Leverage-Based Transfer Classification Learning*

CHENG Yang+,WANG Shitong,HANG Wenlong

School of Digital Media,Jiangnan University,Wuxi,Jiangsu 214122,China

+Corresponding author:E-mail:szhchengyang@163.com

Current transfer learning model studies the source data for future target inferences within a major view that the whole source data should be used to explore the shared knowledge structure.However,due to the limited availability of human ranked source domain,this assumption may not hold due to the fact that not all prior knowledge in the source domain is correlative to the target domain in most real-world applications.This paper proposes a general framework referred to discriminative knowledge-leverage(KL)based on generalized empirical risk minimization(GERM) transfer learning,where the empirical risk minimization(ERM)principle is generalized to the transfer learning setting. Additionally,this paper theoretically shows the upper bound of generalized ERM(GERM)for the practical discriminative transfer learning.The proposed method can alleviate negative transfer by automatically discovering useful objects from source domain.Extensive experiments verify that the proposed method can significantly outperform the state-ofthe-art transfer learning methods on several artificial/public datasets.

transfer learning;empirical risk minimization(ERM);generalized empirical risk minimization(GERM); discriminative knowledge-leverage;negative transfer

10.3778/j.issn.1673-9418.1512014

A

:TP181

*The National Natural Science Foundation of China under Grant No.61272210(国家自然科学基金).

Received 2015-12,Accepted 2016-04.

CNKI网络优先出版:2016-04-08,http://www.cnki.net/kcms/detail/11.5602.TP.20160408.1642.002.html

CHENG Yang,WANG Shitong,HANG Wenlong.Discriminative knowledge-leverage-based transfer classification learning.Journal of Frontiers of Computer Science and Technology,2017,11(3):427-437.