基于双重SE注意力机制下的CNN-BiLSTM混合石墨电极位移预测模型

2023-12-25张渊硕王子涵

张渊硕 王子涵

摘要:石墨化是石墨电极生产核心环节,石墨电极位移预测的准确性和有效性对电极的生产质量具有重大意义。文章针对内串石墨化工艺参数与位移数据之间的关系进行建模,提出了一种引入注意力机制下的卷积神经网络(CNN)和双向长短期记忆网络(BiLSTM)混合石墨电极位移预测模型。为有效解决时间序列重要程度差异性问题,在传统SE注意力机制中增加了双重SE注意力并行模块,并用BiLSTM通过两个方向来发掘时间序列信息,有效提高模型预测度。实验结果表明,文章提出的混合网络模型能够对石墨电极位移进行有效预测,且相比于传统的SE-CNN-BiLSTM方法和主流预测方法预测准确度更高。

关键词: 内串石墨化;石墨电极位移;卷积神经网络;双向长短期记忆;注意力机制

中图分类号:TP391.41 文献标识码:A

文章编号:1009-3044(2023)31-0051-04

开放科学(资源服务)标识码(OSID) :<G:\飞翔打包文件一\电脑2023年第三十一期打包文件\9.01xs202331\Image\image256.jpeg>

0 引言

石墨化工艺的作用是使焙烧品的六角碳原子平面网络从二维空间的无序重叠转变为三维空间的有序重叠并具有石墨结构的高温热处理过程[1],要达到这个目的,大多数碳素企业通过电流加热的方式使制品温度最终达到2300~3000℃。由于其利用电极本体发热,通过电极的电流密度分布比较均匀[2],可有效地降低能耗。在内串石墨化生产过程中,随着温度的不断升高,制品会產生膨胀,为保证在石墨化送电过程中制品不因加热过快而出现裂纹等次品,整个串接柱的膨胀量是工艺师傅重点参考的数值,膨胀量主要通过外接的位移传感器来实现数据监测。

石墨化炉阻、炉温等工艺参数都呈现出很强的非线性和不确定性,用数学回归方法很难得到精确模型[3]。将深度学习技术应用到石墨化时序数据的石墨电极位移预测中,可以更好地发掘出石墨化工艺参数与石墨电极位移之间的关系,对于石墨电极的生产质量有显著提高。文献[4-5]采用BP神经网络预测技术对焙烧控制进行改进,但其对长期依赖问题表现不佳。文献[6]采用LSTM模型对铝用阳极质量进行预测,对焙烧成品率有显著提高,但采用单一模型进行预测存在精度差和训练时间较长的问题。文献[7]基于CNN-LSTM模型对NOX浓度进行预测,利用CNN对机组运行相关参数的时间序列数据进行特征提取,使各参数的序列特征更加明显。但LSTM仅在一个方向上传递信息,无法同时获取过去和未来的上下文信息。文献[8]基于CNN-BiLSTM混合模型对短期风电功率进行预测,虽然采用BiLSTM同时挖掘未来和过去的时间序列信息来提高预测精度,但CNN在进行特征提取时,对于每个通道的特征图采用相同的权重和处理方式,没有明确地考虑通道间的相关性和重要性差异。

根据上述情况,本文提出了一种在双重SE注意力机制下的CNN-BiLSTM混合预测模型。首先应用CNN对输入数据进行卷积处理,增强输入与输出之间的相关性;然后SE模块对卷积得到的特征图进行操作,从而增强重要通道的表达;最后通过BiLSTM网络对时序数据进行预测。实验结果表明,本文所提出的方法可以有效地提高预测精度。

1 模型建立

1.1 卷积神经网络

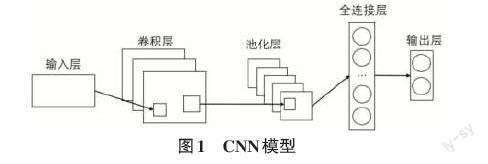

CNN(Convolutional Neural Networks,卷积神经网络)[9]是一种常用于图像处理、模式识别等领域的深度学习网络。

CNN的核心思想是利用卷积运算提取局部特征,其结构图如图1所示,通过堆叠多层卷积层和池化层来逐渐抽象出更高层次的特征表示,并最终完成分类或回归任务。在卷积层中,通常由多个特征平面组成,每个特征平面均由一组矩形排列的神经元构成,这些神经元共享同一组权重参数,即卷积核。在网络前向传播过程中,卷积核会与前一层的局部区域连接并进行卷积运算,以提取前一层特征的关键信息。计算公式如式(1)所示:

[XLj=f(i∈MjXL-1i*KLj+bLj)] (1)

式中:[Mj]为输入特征图;[KLj]为特征对应的卷积核;[KLj],[XL-1i]分别为第L层、第L[-]1层的特征图;*为卷积运算;[bLj]为第L层的偏置单元;[fx]为激活函数。

而在池化层中,则会对特征图进行下采样,减小特征图大小,同时保留最显著的特征。除了卷积和池化层之外,CNN还包括全连接层、激活函数、损失函数等一系列组件,可以通过反向传播算法来更新权重和偏置参数,优化网络性能。综上所述,CNN具有局部感知性、权值共享、平移不变性等特点,使其在处理数据方面表现出色。

1.2 SE注意力机制

SE(Squeeze-and-Excitation)注意力机制[10]是一种用于提升神经网络性能的自适应机制,它可以自适应地学习每个通道的重要性,并赋予网络更强的区分能力。SE注意力模型由2个主要部分组成:挤压(Squeeze)操作和激励(Excitation)操作。其中,Squeeze操作是对输入特征图进行全局平均池化,将每个通道的特征压缩成一个标量,以获得全局的上下文信息。Excitation操作则是对Squeeze操作的输出进行激活,通过多层感知机(MLP)模型来对每个通道赋予不同的权重,从而达到增强关键通道、压缩无用通道的目的。

SE注意力模型的主要优点是可迁移性好,可以方便地嵌入各种结构中,例如卷积神经网络、全连接层等。同时,由于可以精准地选择需要关注的信息,因此大幅减少了模型的参数量,提高了网络运行效率。图2为SE模块模型图,[X']为原始输入数据,[H']为原始输入的空间高度,[W']为原始输入的空间宽度,[C']为原始输入的通道数,[X]为卷积操作后的特征图,[H]为卷积操作后的高度,[W]为卷积操作后的空间宽度,[C]为卷积操作后特征的通道。

首先,Ftr这一步是转换操作,是对输入特征进行一次卷积,对于任何给定的变换Ftr映射输入[X]到特征映射[U],定义如公式(2)所示:

[Ftr:X→U,X∈RH'×W'×C',U∈RH×W×C] (2)

接下来就是Squeeze操作通过采用全局平均池化,将输入特征图在空间维度上进行降维,提取全局信息。这有助于捕捉输入特征图的整体上下文信息,不仅局限于局部区域,具体计算公式如式(3)所示:

[z=Fsq(x)=1H×Wi=1Hj=1Wuc(i,j)] (3)

其中,[z]表示全局特征,[Fsq]表示擠压操作,[x]表示输入特征图,[H]为特征图的高度,[W]为特征图的宽度,[uc(i,j)]为第[i]行第j列像素的特征向量。因此公式就将U[H×W×C]的输入转换成Z[1×1×C]的输出,C为输入特征图的通道数。Excitation操作主要目的是激活学习到的通道相关性,通过使用Sigmoid函数将学习到的通道相关性转化为0~1的概率值,表示每个通道重要性得分。这些得分用于加权每个通道的特征响应,使得重要的通道特征得到加强,而不重要的通道特征得到抑制,其公式如式(4)所示:

[s=fex(z,W)=σ(W2δ(W1z))] (4)

其中,[s]表示激励得分向量,[fex]表示为激励操作,[W1∈RCr×C]表示[Cr]行[C]列的权重矩阵,[W2∈RC×Cr]表示[C]行[Cr]列的权重矩阵,[r]代表缩放比例,[σ]为Sigmoid函数,[δ]为ReLU激活函数。

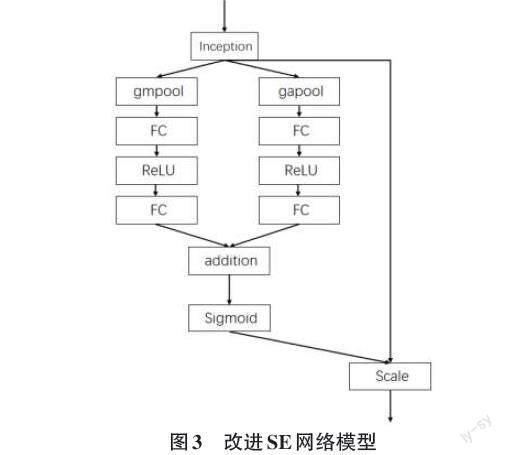

考虑到传统SE注意力机制仅采用全局平均池化操作来压缩特征图信息,容易产生信息丢失问题。因此为了弥补SE注意力机制的这一缺陷,本文提出了一种双重注意力机制[11]。即在传统的SE注意力机制上,另设一条SE注意力机制,其中采用最大池化来提取整张特征图的空间像素信息。进而将两条SE注意力机制的初步加权结果相加,进而输入至Sigmoid函数中,为各通道赋予0~1的权重,改进网络模型图如图3所示。

其中,Inception表示Ftr转化;gmpool、gapool分别表示最大池化和全局平均池化;FC表示全连接层,ReLU为激活函数;addition表示权重相加;Sigmoid表示激活函数。

1.3 BiLSTM模型

长短期记忆网络[12]是循环神经网络(Recurrent Neural Network,RNN)的一种,用于时序数据预测等。与传统RNN相比,LSTM添加了更多的结构,通过设计门限结构解决了传统RNN存在的缺陷,并且具有较长的短期记忆,效果更好。

LSTM是一种特殊的循环神经网络,主要是通过精心设计的“门”结构来实现去除或增加信息到细胞状态的功能。

其计算如公式(5)~公式(10)所示:

[it=σ(Wi⋅[ht-1,xt]+bi)] (5)

[ft=σ(Wf⋅[ht-1,xt]+bf)] (6)

[ot=σ(Wo⋅[ht-1,xt]+bo)] (7)

[ct=tanh(Wc⋅[ht-1,xt]+bc)] (8)

[ct=it×ct+ct-1×ft] (9)

[ht=ot×tanh(ct)] (10)

其中,s 为 sigmoid 激活函数,[ft]、[ct]、[ot]分别表示遗忘门、输入门和输出门的输出,[W]为神经元的权重,[b]为神经元的偏差。

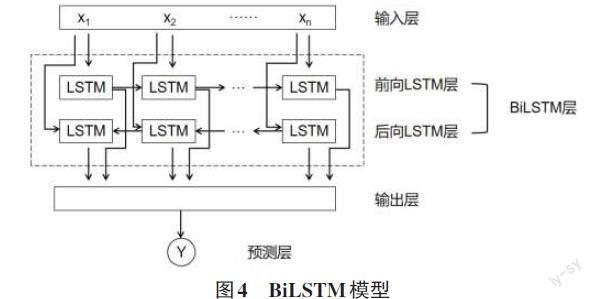

BiLSTM[13]由2个方向的LSTM组成,其中一个LSTM按时间顺序处理序列,另一个LSTM按时间逆序处理序列,其结构图4如所示,每个LSTM层都由多个LSTM神经元组成,每个神经元可以保留一个内部状态,以便于捕捉序列中潜在的长期依赖关系。LSTM层还包括输入门、遗忘门和输出门,这些门控制着神经元如何处理输入数据以及维护其内部状态。

在正向和反向LSTM处理完输入序列之后,它们的输出会被拼接在一起作为BiLSTM的最终输出结果,以提供更全面和丰富的特征信息。

2 模型设计

2.1 数据预处理

1) 数据采集

本文采用邯郸市成安县某炭素厂2022年4月27日—2023年6月20日的15分钟数据,通过边缘计算网关进行实时采集,在后端通过API接口获取数据库中的数据。由于获取的数据较完整,只对数据中出现的个别空值采用向上赋值法进行赋值。

2) 数据处理

为了确保模型训练的有效性,对于包含不同特征值且存在量纲差异和数值差异较大的数据集,采用输入数据归一化方法以降低其对模型训练产生的消极影响。其计算公式如式(11)所示:

[x∗=x-xmax+xmin2xmax-xmin2] (11)

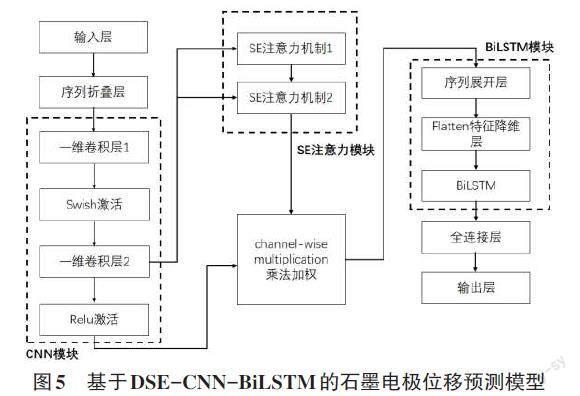

2.2 石墨电极位移预测模型设计

本文采用双重SE注意力机制下的CNN-BiLSTM混合预测模型进行石墨电极位移预测,模型结构如图5所示。首先,将经过预处理的数据输入网络,通过第一层卷积对数据进行特征提取,通过激活层到第二层卷积更加细致地对特征进行提取。本文的模型结构采用了两层卷积作为特征提取层,考虑到池化层的加入会产生信息丢失的问题,因此不再引入池化操作。然后用SE注意力机制建立特征之间的相互依赖性,双重SE注意力机制被放置在CNN最后一层卷积层与BiLSTM层之间的连接处。随后通过Flatten降维层将SE注意力模块与BiLSTM模块相连接,最终通过全连接层输出结果。

<G:\飞翔打包文件一\电脑2023年第三十一期打包文件\9.01xs202331\Image\image298.png>

图5 基于DSE-CNN-BiLSTM的石墨电极位移预测模型

2.3 模型评价指标

为了更进一步对所提出的DSE-CNN-BiLSTM混合网络预测模型进行评估,本文采用RMSE和MAE作为误差评价指标。上述指标值越小则代表预测准确性越高。具体计算公式如式(12)~式(13)所示:

[ERMSE=1Ni=1N(yi-y)2] (12)

[EMAE=1Ni=1Nyi-y] (13)

式中:[yi]为样本[i]的真实值;[y]为真实值序列的均值;[y]为样本[i]的模型预测值。

3 实验分析

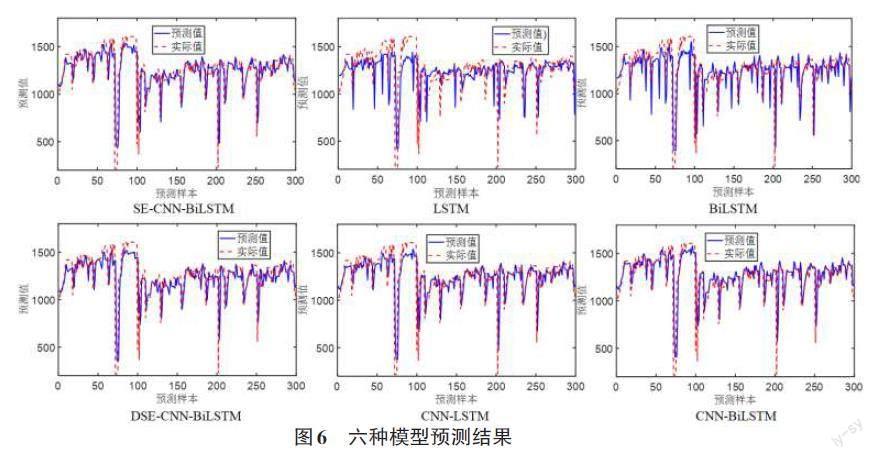

本文对采集到的数据集分为训练集和测试集,前80%作为训练集,总计4 800条;后20%作为测试集,总计1 200条。模型采用adam优化器和mini-batch梯度下降法,训练批次设为256,迭代次数为100,进行15分钟的石墨电极位移预测,图6为6种模型的预测结果,分别为LSTM、GRU[13]、CNN-LSTM[14]、CNN-BiLSTM、SE-CNN-BiLSTM、DSE-CNN-BiLSTM模型。图6中横轴为预测样本数,纵轴为石墨电极位移预测值。

为进一步验证本文所提出模型的预测优势,采用上述6种模型在相同数据和环境下进行对比,图7为预测对比图,图中横轴为预测样本数,纵轴为石墨电极位移预测值。可以看出DSE-CNN-BiLSTM预测值与实际值更接近,优于其他5种模型。

其中,模型1~5分别为SE-CNN-BiLSTM、LSTM、GRU、CNN-LSTM、CNN-BiLSTM模型,主模型为DSE-CNN-BiLSTM模型[15]。

表1为6种模型对15min尺度的石墨电极位移预测评价指标值。从表1中可以看出,本文所提出的模型误差低于其他5种模型误差,对石墨电极位移可以更好地预测。

4 结束语

本文提出了一种引进注意力机制下的CNN和BiLSTM混合石墨电极位移预测模型。在传统SE注意力机制中加入了并行模块,通过加入最大池化操作来更好地挖掘重要的输入信息。通过大量实验和研究表明,基于DSE-CNN-BiLSTM模型相比传统SE-CNN-BiLSTM和市面上主流的4种预测模型有着更高的预测精度,更小的误差,对于石墨电极位移的预测有着更有效的预警意义。

参考文献:

[1] 顾鹏,冯俊杰,张胜恩.内串石墨化炉炉体的优化与改进[J].炭素技术,2019,38(5):64-67.

[2] 刘炳强,赵修富,马广禧.浅谈内串石墨化送电曲线的制定与调整[J].炭素技术,2010,29(5):41-43.

[3] 曲丽萍,曲永印,薛海波.石墨化炉人工神经网络预测控制的研究[J].控制工程,2006,13(5):466-468.

[4] 姜潮阳,文克,刘予湘,等.BP神经网络在预焙阳极生产中的应用[J].炭素技术,2001,20(1):38-41.

[5] 苏志同,吴佳龙.预焙阳极配方焙烧块质量预测模型研究[J].计算机与数字工程,2019,47(8):2066-2069.

[6] 苏志同,王春雷.基于LSTM的焙烧时序数据的质量预测模型[J].软件,2020,41(5):105-107,197.

[7] 王永林,白永峰,孔祥山,等.基于CNN-LSTM算法的脱硝优化控制模型研究[J].综合智慧能源,2023,45(6):25-33.

[8] 杨子民,彭小圣,熊予涵,等.计及邻近风电场信息与CNN-BiLSTM的短期风电功率预测[J].南方电网技术,2023,17(2):47-56.

[9] JIN K H,MCCANN M T,Froustey E,et al.Deep convolutional neural network for inverse problems in imaging[J].IEEE Transactions on Image Processing:a Publication of the IEEE Signal Processing Society,2017,26(9):4509-4522.

[10] 肖鹏程,徐文广,张妍,等.基于SE注意力机制的废钢分类评级方法[J].工程科学学报,2023,45(8):1342-1352.

[11] 苏向敬,周汶鑫,李超杰,等.基于双重注意力LSTM神经网络的可解释海上风电出力预测[J].电力系统自动化,2022,46(7):141-151.

[12] YU Y,SI X S,HU C H,et al.A review of recurrent neural networks:LSTM cells and network architectures[J].Neural Computation,2019,31(7):1235-1270.

[13] MOHARM K,ELTAHAN M,Elsaadany E.Wind speed forecast using LSTM and Bi-LSTM algorithms over gabal el-zayt wind farm[C]//2020 International Conference on Smart Grids and Energy Systems (SGES).IEEE,2021:922-927.

[14] 李静茹,姚方.引入注意力機制的CNN和LSTM复合风电预测模型[J].电气自动化,2022,44(6):4-6.

[15] SHIRI F M,PERUMAL T,Mustapha N,et al.A comprehensive overview and comparative analysis on deep learning models:CNN,RNN,LSTM,GRU[EB/OL].[2023-06-01].2023:arXiv:2305.17473.https://arxiv.org/abs/2305.17473.pdf.

【通联编辑:唐一东】