耦合深度神经网络的动力电池联合状态估计

2023-12-21王军洁

王军洁

(淮安生物工程高等职业学校 计算机系,江苏 淮安 223200)

在节能减排、绿色环保的大背景下,发展新能源汽车对解决能源和环境问题以及提高国家的综合实力都具有非常重要的意义[1-3]。 目前,新能源汽车已经成为全球汽车产业的重要战略方向。 2020 年国务院印发《新能源汽车产业发展规划(2021—2035 年) 》[4],要求深入实施发展新能源汽车国家战略,推动中国新能源汽车产业高质量可持续发展,加快建设汽车强国。 在政策的激励下,中国新能源汽车产业迅速发展,保有量占全球份额超过50%[5]。 随着我国新能源汽车产销量的不断攀升,作为新能源汽车核心部件的动力电池获得广泛关注[6-7]。 动力电池对新能源汽车的性能具有决定性作用,实现对动力电池精确的状态估计,包括荷电状态(state-of-charge,SoC) 估计和健康状态(state-of-health,SoH) 估计,是确保电池管理系统(battery management system,BMS) 对电池包实现安全管理的关键所在,因此电池状态估计研究已成为近年来交通电气化研究的热点[8-10]。

1 研究概述

大多数现有研究可实现SoC 或SoH 的独立估计。 例如,刘素贞等[11]融合高相关性超声特征和低复杂性回归模型提出了一种磷酸铁锂电池平台期SoC 估计方法,实现了不同动态工况下SoC 估计的均方根误差和平均绝对误差分别低于1.9%和1.6%。 黄玉莎等[12]基于二阶RC 等效电路建立了一种受控自回归滑动平均模型,在此基础上实现了开路电压(open circuit voltage,OCV) 参数的高精度在线辨识,并通过预先建立的分段OCV-SoC 曲线逆向查表,实现了SoC 的实时估计。 Zhou 等[13]提出了一种基于信息能量理论和奇异值分解(singular value decomposition,SVD) 的电池SoH 估计方法,首先计算电压和电流的谱熵,并按照时间顺序排列谱熵,构建信息能量矩阵,然后对信息能量矩阵进行奇异值分解以获得与SoH 具有高度相关性的特征值,最后通过构建的SoH 与特征值间的线性回归关系实现SoH 的准确估计,结果表明SoH 的平均绝对误差估计可以控制在2%以内。 上述方法虽然可以实现较为精确的SoC 或SoH 估计,但是却无法实现SoC 和SoH 的联合估计,不能为BMS 控制决策提供充分的状态信息。 若简单采用两套不同算法分别实现SoC 和SoH 的估计,一方面两套算法相较于一套算法而言,将加重BMS 计算的负担;另一方面,两套算法的独立运行也忽视了SoC 和SoH 之间的耦合关系。 因此,将SoC 和SoH 算法进行简单叠加无法满足新能源汽车BMS的实际需要。

为解决上述问题,本研究结合深度神经网络理论,提出了一种可实现SoC 和SoH 联合估计的计算框架,通过卷积神经网络(convolutional neural network,CNN) 和长短期记忆网络(long short term memory,LSTM) 挖掘输入特征量电压到SoC 和SoH 的耦合映射关系,该方法具有运算量小、精度高等优点。

2 状态联合估计方法

2.1 问题描述

本研究需要解决的问题是在给定固定长度的动力电池充电测试数据片段后,根据数据片段信息实现对动力电池SoC 和SoH 的同步估计。 其中,SoC 指的是数据片段末端动力电池的荷电状态,SoH 定义为动力电池当前状态下的可用容量。 充电测试的数据片段在本研究中特指电池的端电压数据,因为目前动力电池组大多采用恒流充电模式,且由于现代BMS 温控性能较好,充电过程中温度不会发生明显变化,对于可测数据电压、电流、温度而言,仅电压数据会在充电过程中发生明显变化,故输入数据片段仅采用电压数据即可。需要说明的是,模型实际使用时的充电倍率和环境温度必须与训练时的条件相近,即如果训练时动力电池的充电倍率为1C,恒温控制为23 ℃,那么实际应用时也应和上述条件相近。

2.2 估计方法

联合状态估计的深度神经网络架构(图1) 主要包括1 个输入层、10 个卷积层、1 个全局平均池化(global averaging pooling,GAP) 、1 个LSTM 层、1 个全连接层(FC) 等,其中卷积层进一步由卷积操作、最大池化以及截断线性(rectified linear unit,ReLU) 激活函数组成。

图1 联合状态估计的深度神经网络架构Fig.1 Deep neural network architecture for state co-estimation

图1 中,输入层即数据片段的输入接口,输入层长度需要与数据片段长度保持一致。 在本研究中数据片段长度为500,因此输入层长度也为500。

卷积操作可以有效提取局部数据中的特征信息[14],非常适用于提取电压数据中隐含的与SoC 和SoH 高度相关的特征细节。 假设Wm表示第m个卷积核(卷积核的长度和高度分别为h和w) 的权重,bm表示对应的偏置项,那么对于数据片段输入D,卷积操作的输出ym可以表示为

上述卷积操作通过一定的步长在输入数据片段上逐一扫过,从而构成完整的卷积输出。

最大池化层可以缩减模型的大小,提高计算速度,同时提高所提取特征的鲁棒性。 前向传播时,最大池化层输出特征图Y中某一位置的值的输入特征图X对应池化窗口的最大值,即

式中:n是特征图号;c是通道号;h是行号;w是列号;kh,kw∈[1,K],K是池化窗口的边长。

ReLU 是人工神经网络中常用的激活函数,其数学定义如下:

即:当输入大于0 时,ReLU 被激活,可以直接输出;当输入小于0 时,ReLU 将被抑制,输出为0。 ReLU 函数相比于tanh、sigmoid 等其他激活函数,具有梯度下降及反向传播效率更高、梯度爆炸和梯度消失问题不易出现、整体计算成本较低等显著优势。

GAP 本质上也是一种平均池化操作,旨在取代经典卷积层中的部分全连接层。 GAP 意味着每个输入特征图的区域被当作相应特征图的输出[15]。 假设输入特征图为n,每个特征图的大小为m×m,如果使用全连接层,则应将原始图展平为n×m2的向量。 然而,如果使用GAP 代替全连接层,输出长度可以减少到n。 从以上分析可以看出,当特征图较大时,GAP 可以大大减轻计算负担。 此外,与全连接层相比,GAP 层没有额外的参数和复杂的乘法,进一步降低了计算成本。 同时,GAP 层直接规范了网络结构,从而缓解了过度拟合问题。

LSTM 是最常用的循环神经网络结构之一,其关键是内部状态sc。 内部状态可被视为信息已被添加或已被删除的载体,这种信息流通过“门”结构进行调节。 “门”结构是LSTM 的一个独特特征,能够选择性地对信息进行传递。 LSTM 主要包括遗忘门、输入门和输出门[16],其结构如图2 所示。

图2 长短期记忆神经网络架构Fig.2 Network architecture of the LSTM

遗忘门:LSTM 的第一步是决定丢弃哪些信息,这个决定由遗忘门的sigmoid 层决定,它接受t时刻的输入x(t)和t-1 时刻的隐藏状态h(t-1),并为sc中的每个状态输出一个0 ~1 的数字。 1 表示完全保留状态值,而0 表示完全丢弃值。 例如,对于电池SoC 和SoH 状态的估计,丢弃的信息可以是相邻循环之间劣化数据的异常值、噪声和冗余信息等。 遗忘门的计算如下:

式中:WfX和Wfh分别表示遗忘门中的输入权重和状态权重;bf表示遗忘门偏置,为sigmoid 函数。

输入门:LSTM 的第二步是决定在内部状态中存储哪些新信息,该步骤的核心是sigmoid 函数和tanh 函数,其中sigmoid 函数决定要更新哪些值,tanh 函数将创建一个可增加到隐藏状态的新候选状态向量。 输入门的计算如下:

式中:WiX和Wih分别表示输入门中的输入权重和状态权重;bi表示输入门偏置;WgX和gih分别表示tanh 层中的输入权重和状态权重;bg表示tanh 层偏置。

根据式(4) 至式(6) 更新内部状态值:

输出门:LSTM 的最后一步是决定输出哪些信息。 在内部状态sc通过tanh 层后,将其乘以sigmoid 函数的输出以获得剩余状态值,即

式中:WoX和Woh分别表示输出门中的输入权重和状态权重;bo表示输出门偏置。

全连接层是神经网络中最常见的层,其作用是将输入空间线性加权后,经过ReLU 函数去线性化,映射到输出空间。 由于神经网络需要实现SoC 和SoH 的联合估计,因而全连接层(即输出层) 的神经元数量为2,分别代表SoC 和SoH 的估计值。

3 电池数据集

本研究使用的电池数据集由牛津大学于2017 年发布[17]。 数据集包含Kokam 公司生产的8 个小型锂离子电池,型号为SLPB533459H4,编号为1#至8#,电池外形及性能参数分别如图3 和表1 所示。 电池的负极材料是石墨,正极材料是锂钴氧化物和锂镍钴氧化物的混合物。

表1 电池性能参数Tab.1 Configuration parameters of the battery

图3 电池外形参数(单位:mm) Fig.3 Size of the battery(unit: mm)

电池均在40 ℃恒温箱中进行测试。 所有电池首先进行恒流-恒压(constant current-constant voltage,CCCV) 充电,然后进行城市工况Artemis 曲线的循环放电,每100 个循环进行一次特性测试,包括1C(电流为740 mA) 和pseudo-OCV(电流为40 mA) 循环测试。 测试过程中以1 Hz 的频率记录数据,包括电压、温度和电量。 图4 给出了第100 次循环时1#电池的记录数据[18]。

图4 第100 次循环时1#电池的记录数据Fig.4 Data record of battery 1#at 100th cycle

pseudo-OCV 测试最重要的作用是提供校准容量。 pseudo-OCV 测试时的激励电流非常小,在这种情况下仅约为1/18C,充电和放电测试时的平均累积电量可以定义为实际容量。 因此,根据图4 所示的结果,第100 次循环时1#电池的实际容量可以校准为(739.2+734.8) mA·h/2=737 mA·h。

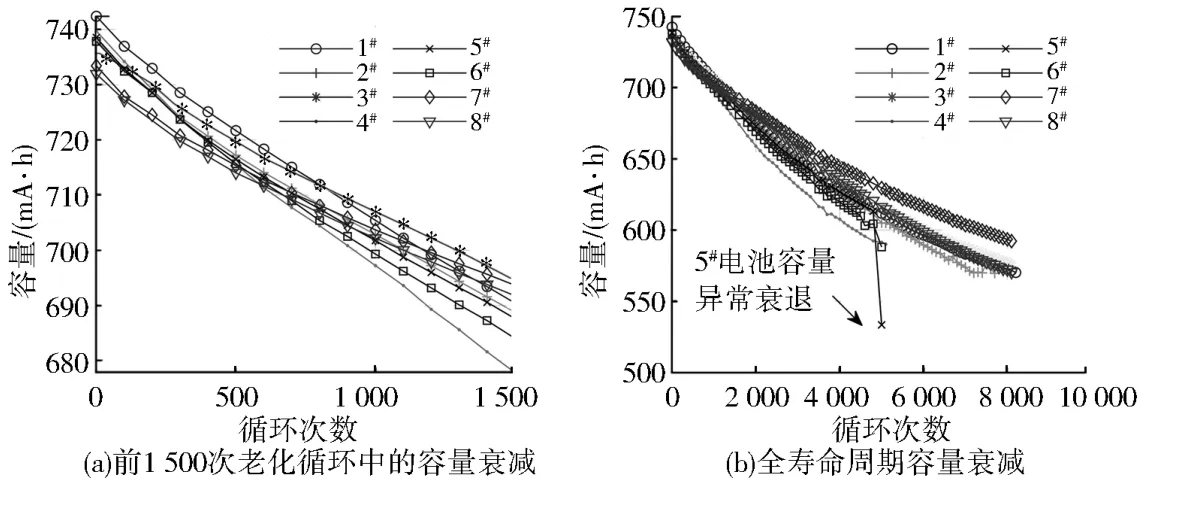

图5 显示了基于pseudo-OCV 测试计算的8 个锂离子电池的容量衰减情况。 从图5(a) 可以看出:前1 500 次循环,8 节电池的容量衰退基本一致,说明电池在使用早期时一致性相对较好。 然而,随着电池的老化,容量差异逐渐扩大,如图5(b) 所示。 特别地,由于未知原因,5#电池在末期出现异常退化,容量突然下降表明5#电池内部可能出现某些故障。 为避免此处可能引入的误导性结果,后续训练或测试数据集中不包括5#电池末期的数据。

图5 实验中8 个锂离子电池的容量衰减情况Fig.5 Degradation of the eight Li-ion batteries

对于SoC,可以用图4 中的电量来表示,如图4(b) 所示。 由于实验中采用恒流充电,电量线性增加,也反映出SoC 在线性增加。

4 算法验证

表2 给出了网络各层的详细结构参数。 对于最大平均池化层、ReLU 层和GAP 层,没有特殊的超参数;对于LSTM 层,设置了4 个隐藏层单元数;对于全连接输出层,如前所述采用ReLU 激活函数且输出维度为2。

表2 卷积神经网络各层的详细参数Tab.2 Detailed information about convolutional layers in the proposed mothod

模型验证流程如图6 所示,训练数据集为1#至6#电池,测试数据集为与训练集不同的7#和8#电池,以验证模型的泛化能力。 首先用1#至6#电池训练深度神经网络,获得网络参数,然后将7#和8#电池的电压数据输入神经网络,获得估计的电池容量,再与数据集中电池的标定容量进行对比,以获得模型的估计误差。

图6 模型验证流程Fig.6 Flowchart of model verification procedure

采用Adam 算法来训练网络,学习率最初设置为0.2,并且以指数形式随着训练的进行而逐渐减少,每训练10 轮,将学习率乘以0.99,以获得更好的网络收敛性能[19]。 训练时最大训练轮数为5 000,每次训练的样本个数设置为2 048。 训练用的电脑CPU 为Intel 酷睿i7-12700F@ 4. 9 GHz,GPU 为NVIDIA GeForce RTX3060,训练时间持续约148 h。 需要说明的是,尽管训练持续时间很长,但在网络训练完成时,用于预测的时间非常短。 给定长度为500 的输入数据段,执行一次联合估计只需要约0.69 ms。 因此,该方法有望应用于计算能力有限的车载BMS。

为进一步说明本方法在精度方面的优势,将本方法与5 种先进的机器学习算法进行比较,包括将本方法中LSTM 层删除的纯CNN、支持向量回归(support vector regression,SVR)[20]、集成学习(ensembling learning,EL)[18]、多层感知器(multilayer perceptron,MLP)[21]和决策回归树(regression tree,RT)[22]。 5 种方法效果评估流程均类似图6,对比时采用和本方法相同的训练集和测试集。 另外,由于SVR 和RT 方法无法同时给出2 个输出,即无法实现SoC 和SoH 的联合估计,所以SoC 和SoH 的估计是采用两套模型完成的。 6 种方法在测试集上的平均误差如表3 所示。 实验结果表明,本方法可以实现较为精确的SoC 和SoH 联合估计,SoC 和SoH 的估计均方根误差分别是12.09 mA·h 和10.89 mA·h,仅为标称容量的1.63%和1.47%。

表3 不同方法在测试集上的SoC 和SoH 联合估计误差Tab.3 Joint SoC and SoH estimation error of different approaches on testing dataset

从表3 可以看出:无论是SoC 还是SoH,本方法均表现出6 种方法中最高的估计精度。 对比CNN 方法可以看出,引入LSTM 层有效地捕捉了电池动态特性数据中的时域关联,因而精度有一定程度的提升,其他方法无论是估计误差的平均值还是方差,均不如本方法,说明本方法在估计精度方面具有显著优势。

5 结语

本研究针对车用动力电池SoC 和SoH 的联合状态估计需求,提出了一种融合CNN 和LSTM 的联合状态估计方法,克服了传统方法无法解析SoC 和SoH 耦合关系的不足。 利用深度神经网络特征自提取功能,构建了从可观测电压数据片段输入到SoC 和SoH 的映射模型,实现了SoC 和SoH 的快速、高精度联合估计。 对所提方法在电池测试数据集的1C充电数据上进行了验证,结果表明SoC 和SoH 的估计均方根误差分别是12.09 mA·h 和10.89 mA·h,分别仅为标称容量的1.63%和1.47%,优于CNN、SVR、EL、MLP、RT 等机器学习算法。