基于深度学习的隧道掌子面节理智能检测与分割

2023-10-24彭磊,周春,胡锋,田晓阳,王海波

彭 磊,周 春,胡 锋,田 晓 阳,王 海 波

(1.中铁七局集团广州工程有限公司,广东 广州 510760; 2.中山大学 航空航天学院,广东 深圳 518107)

0 引 言

隧道(隧洞)作为一种隐蔽式的建筑,具有复杂的建设环境,如围岩构造、温度变化以及地下水的影响,大量隧道建设面临进度慢、安全性低等问题。在进行隧道开挖时,需要按照设计要求将隧道内的土石方挖掉,形成一个断面,该断面即为隧道掌子面。隧道掌子面素描是一项重要且复杂的任务,通过掌子面素描可以判定隧道围岩级别,为隧道开挖支护等提供作业依据。准确高效的掌子面素描工作可以有效解决隧道建设进度慢以及安全性低等问题。因此,实现隧道掌子面节理的科学检测对隧道建设具有重要意义。

目前,传统的隧道掌子面节理检测方式以人工观察描绘为主。该方法不仅效率低且主观影响显著,在实际工作过程中经常出现与实际情况不相符的现象。随着科学技术的快速发展,计算机图像处理方法率先应用在露天岩体地质信息的识别当中。范留明[1]、胡刚[2]等采用数字图像处理方法(边缘检测、阈值分割、hough变换等)识别岩体表观裂隙,并封装为软件供检测人员使用,缺点是处理过程复杂,需要人工调教,智能化程度并不高。此外数字图像处理方法在隧道掌子面节理识别方面的应用也涌现出来[3],如叶英[4]、冷彪[5]、罗佳[6]等基于此处理隧道掌子面图像,提取出节理目标,达到替换地质素描图的目的。李术才[7]、李鹏云[8]等直接借助结构面处理软件SIR6.0、OpenCV平台对隧道掌子面图片节理信息进行提取。考虑到隧道环境条件比较恶劣,拍摄掌子面图像质量容易受到粉尘的影响,周春霖等[9]借助红外摄影技术获取清晰的隧道掌子面照片,接着利用数字图像处理技术对图片进行去噪、均衡化以及阈值分割处理,以直线段标识节理目标。以上基于数字图像处理技术的隧道掌子面节理提取方法虽然借助计算机技术实现了节理的识别与分割,但适用条件较为苛刻,显著依赖应用场景的简单性,即现场光照均匀充足且节理目标较为明显。此外,数字图像处理技术存在多种阈值分割算法,往往需要切换调整不同算法对比挑选出最佳的分割结果,增加了该方法现场应用的难度。同时该技术分割的节理目标是一个整体,不能直接使用,还需进行复杂的后处理工作。故亟需开发一种环境适应性更强、鲁棒性更好的技术手段,能够适应隧道内复杂的光线环境,实现节理目标的像素级分割。随着人工智能的快速发展,传统的土木工程行业引入了众多智能识别算法[10-11],实现了工程任务的智能化发展。

计算机视觉领域主要包含4种图像处理任务,即图像分类(Image Classification)、语义分割(Semantic Segmentation)、目标检测(Object Detection)以及实例分割(Instance Segmentation)。图像分类仅能表示图片的类别,无法确定掌子面图片中具体的节理信息;语义分割可以实现图片中所有节理的分割,但是无法区分个体,被分割的节理属于一个整体;目标检测能够检测出不同个体的节理,但无法实现分割;实例分割则在目标检测的基础之上,可实现对不同节理目标的分割。在隧道现场实际应用过程中,检测结果将用于计算节理组数以及节理间距等参数,即隧道掌子面节理智能检测任务需要将每一条节理目标单独检测出来并实现分割,故本文将采用实例分割算法而非语义分割算法检测并分割隧道掌子面节理目标。

现有识别掌子面节理的数字图像处理方法存在调教复杂的问题,虽然避免了人工描绘的主观影响,但是仍需人工处理调教,导致识别检测过程并不智能,存在一定的局限性。本文针对传统数字图像方法存在的局限,提出一种实例分割算法——Mask R-CNN,实现掌子面节理的智能检测与分割,避免了人工描绘的主观性以及现有数字图像处理方法的局限性。

1 基于Mask R-CNN的掌子面智能识别方法

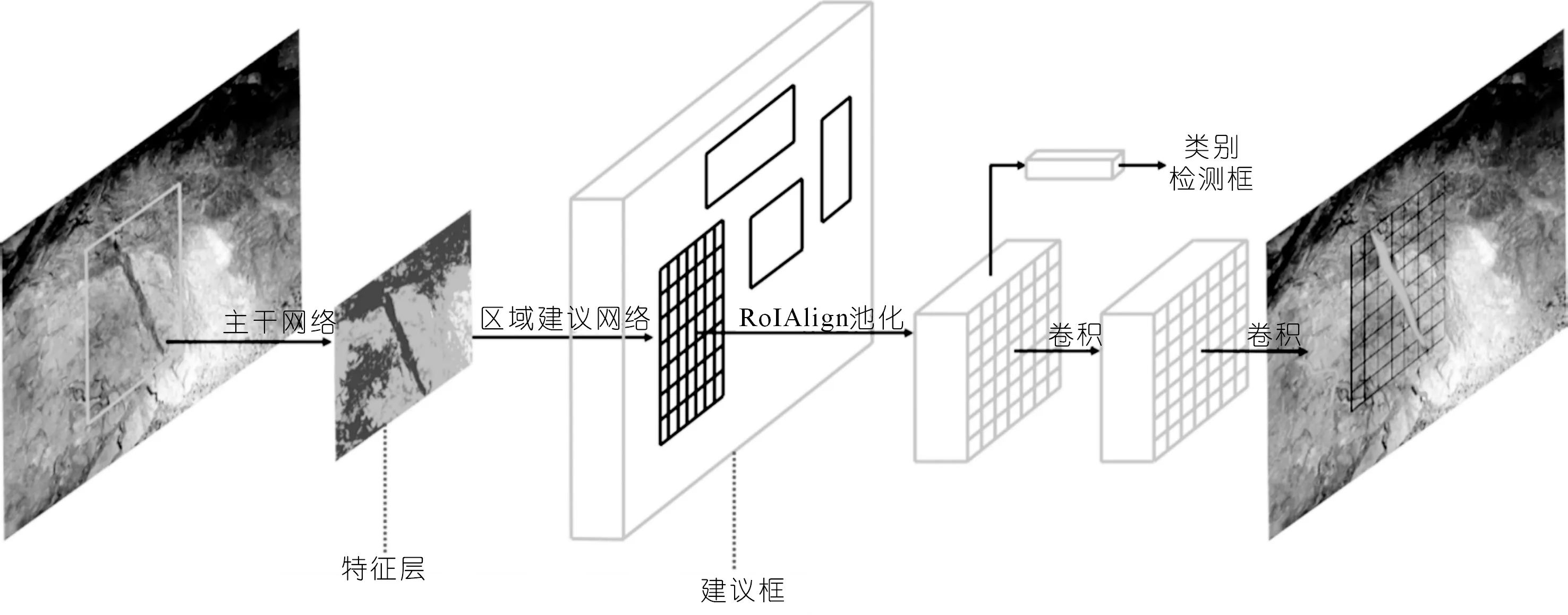

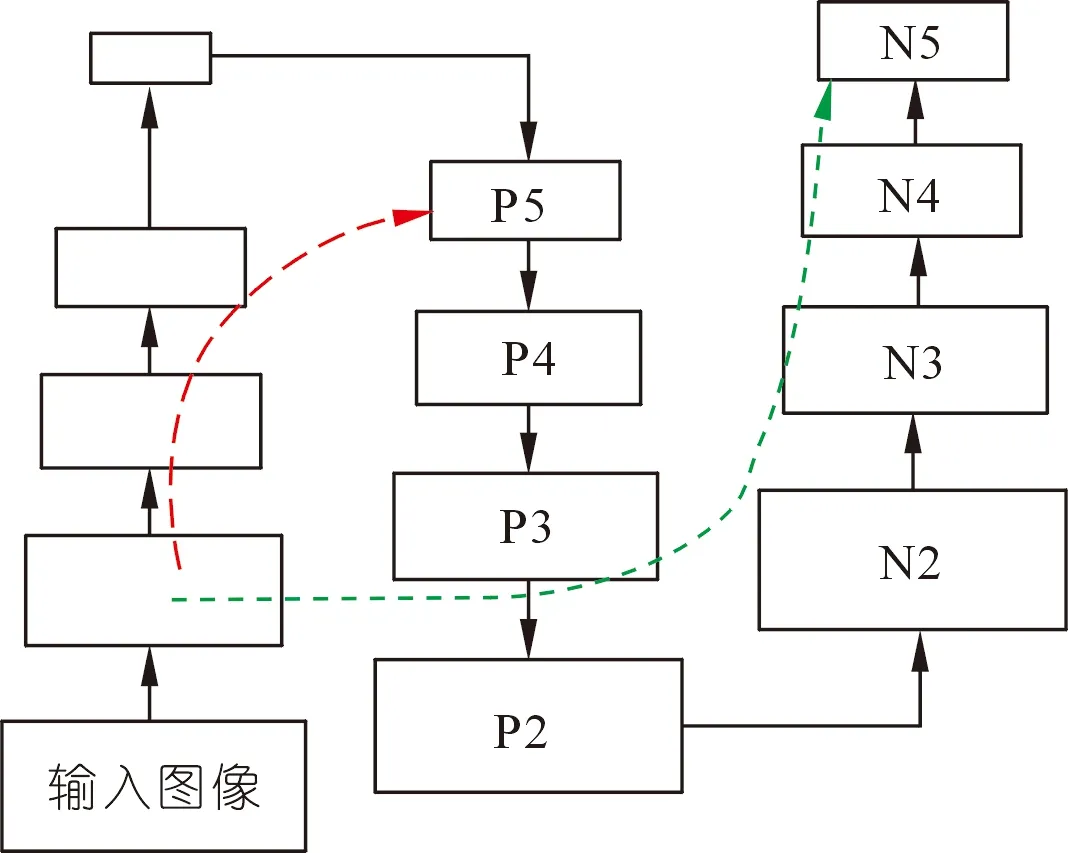

本文采用实例分割算法(Mask R-CNN)对隧道掌子面节理进行智能识别与分割,Mask R-CNN算法网络框架如图1所示[12]。包含主干网络、区域建议网络(RPN:Region Proposal Network)、RoIAlign调节、结果预测等部分。

图1 Mask R-CNN算法网络框架

1.1 主干网络

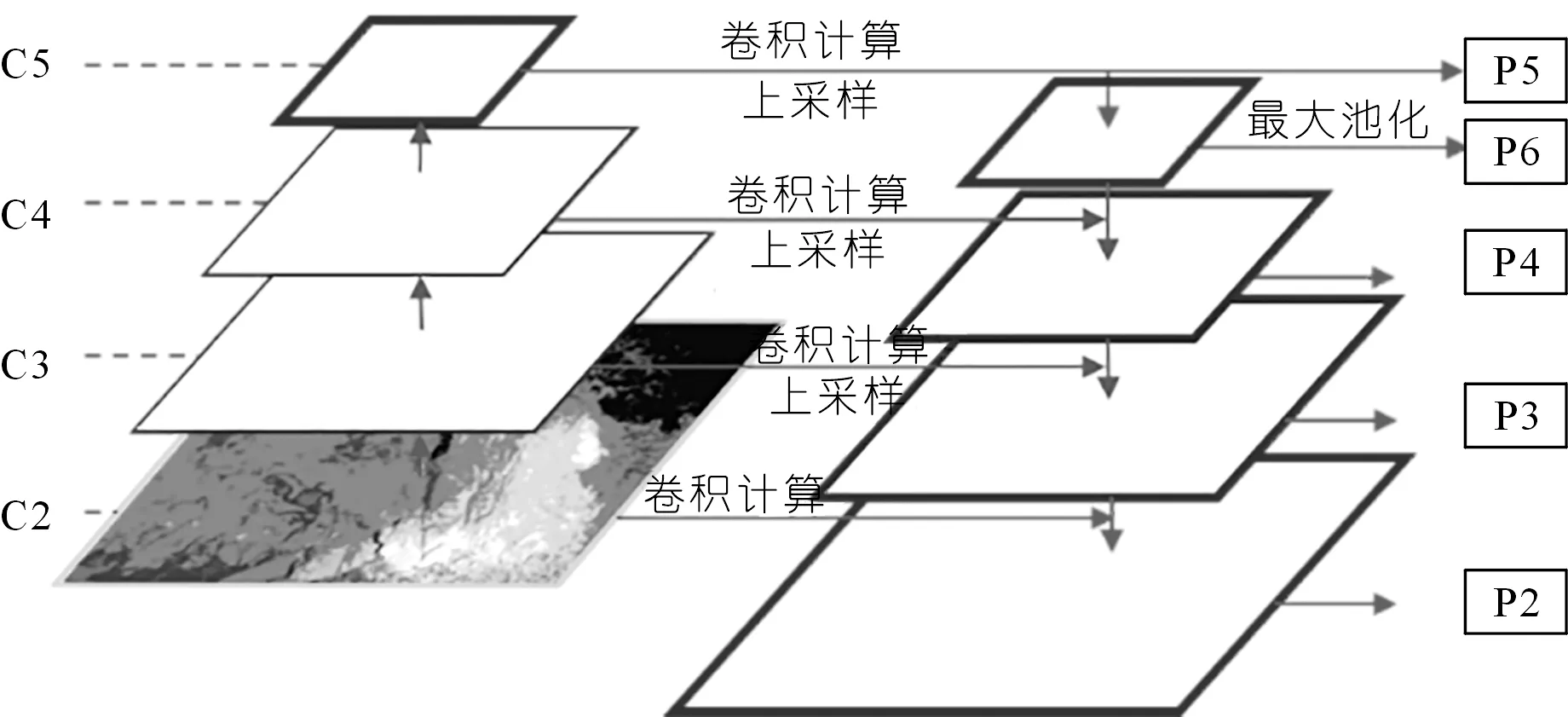

ResNet101与FPN(特征金字塔网络)是主干网络的主要组成部分。其中,ResNet101主要由Conv block与Identity block两个模块组成,分别负责卷积运算与加深网络的任务,用于提取掌子面图片的特征信息。基于图片的像素数据,运算输出多个不同大小的特征图,这些特征图像素点可理解为用于表征原始图片像素特征的次级像素,包含了原始图像的特征信息,表示为C2~C5(因C1特征图感受野较小,语义信息较少,无法很好地捕捉图像中的物体结构和特征,故将其舍弃,不进一步处理),便于检测不同大小的目标物。本文结合掌子面图像的尺寸大小,对特征图的尺寸设计做了针对性改进,以适应掌子面图像节理识别任务。

FPN可以将不同层级的特征信息融合成多尺度、多语义级别的特征金字塔(见图2)。通过“latlayer”操作,从高分辨率的特征图上采样,使其与较低分辨率的特征图具有相同的空间尺度,然后将它们相加,从而得到融合后的特征图。在Mask R-CNN中,FPN的输出特征图为P2、P3、P4、P5和P6有效特征层,用于检测不同尺度的物体。

图2 FPN网络框架

1.2 区域建议网络

RPN是一种轻量级的神经网络,它以滑动窗口的方式扫描输入图像并找到含有目标的区域,这些扫描的区域称为anchors,为大小不同的方框[13]。本文针对隧道掌子面节理识别这一特殊任务,通过掌子面标注文件统计现有掌子面图像中的节理尺寸信息,分析节理标注框的大小以及长宽比,对anchors的大小及长宽比例设计进行了针对性的改进,以适应掌子面节理的形状。

计算每个anchor与标注框之间的交并比(两框交集面积与并集面积之比),即IOU(Intersection Over Union)。通过IOU与设定阈值的大小关系确定该anchor的类别,当IOU>阈值时,anchor为正类,反之则为负类。在训练算法时RPN阶段存在两个训练任务,即anchors的分类训练与框位置回归训练,其训练误差LR表示为

LR=LRc+LRr

(1)

式中:LRc表示anchors的分类训练误差函数,LRr表示anchors框回归训练误差函数,用式(2)~(3)表示:

(2)

(3)

式中:i表示anchors的序号;pi表示序号为i的anchor被预测为正类的概率;pi*表示序号为i的anchor真实标签值,anchor为正样本时,pi*=1,anchor为负样本时,pi*=0;si为一向量,含序号为i的anchor框中心坐标、宽和高等4个元素;si*表示含有标注框相应元素的四维向量;NRc、NRr表示RPN阶段分类与回归训练的批次数据量;λ为超参数;lRc为交叉熵损失函数,回归损失函数lRr的表达式为

(4)

式中,R表达式为

(5)

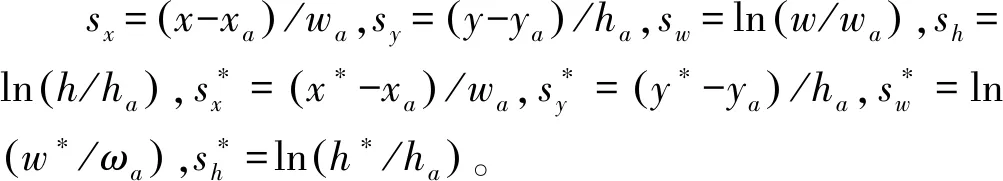

(6)

式中:x,y,w,h分别表示方框的中心坐标、宽和高;x,xa,x*分别对应于预测框、anchor框与真实框(y,w,h同理)。

训练完成之后,RPN可以预测anchor的类别(正类或负类)并对框的位置进行初步调整。改进后的区域建议网络(RPN)实现了掌子面特征图像中可能包含节理区域的提取,生成建议框,作为下一阶段的输入。

1.3 RoIAlign调节

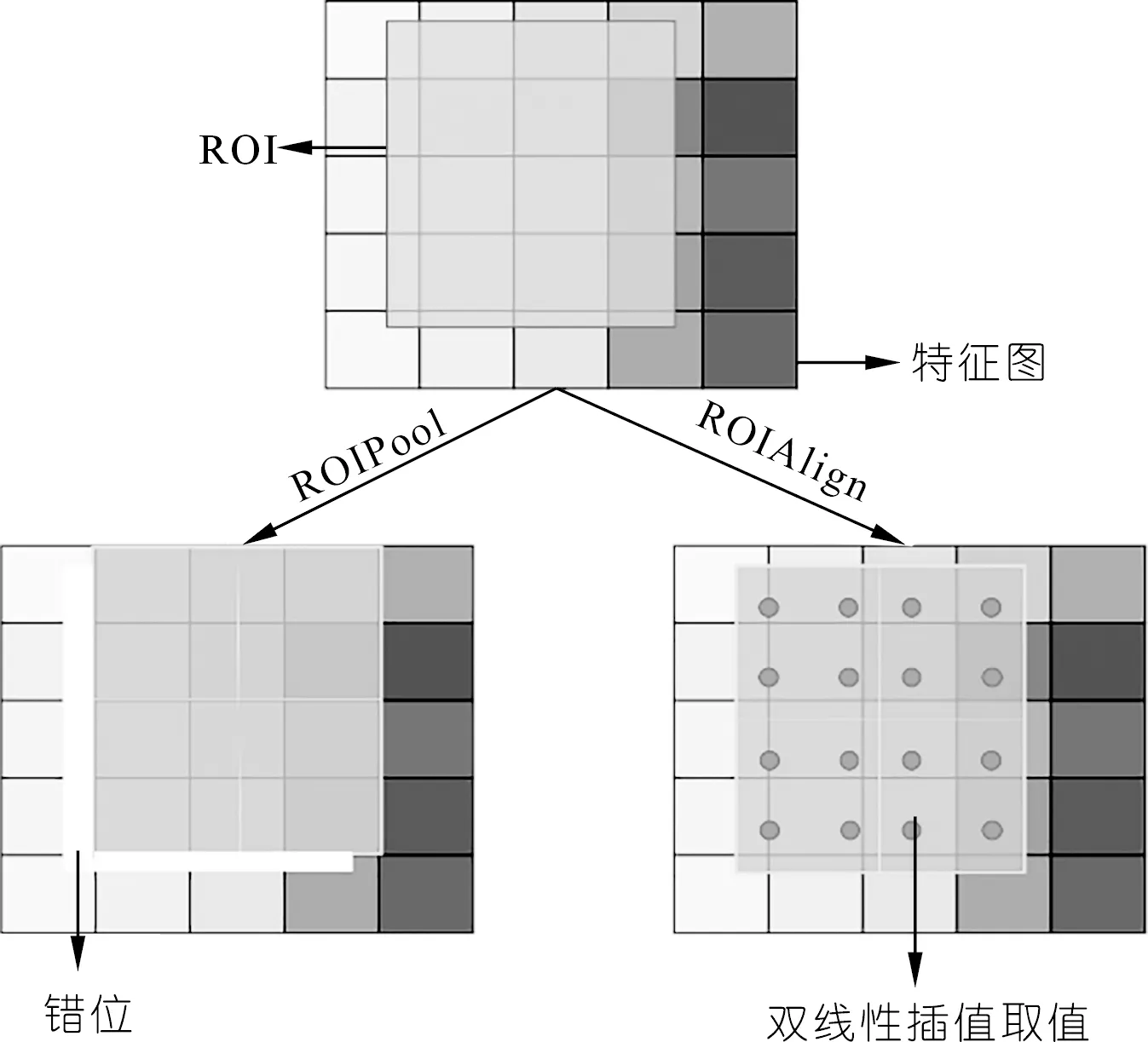

RoI(Region of interest),即RPN阶段输出的建议框。由于RPN阶段生成的anchor框大小不一,且通过位置调整模型进行了微调,需采用RoIAlign统一RoI的尺寸,便于分类。相比于Faster R-CNN算法中采用的RoIPool模块[14],本文算法所采用的RoIAlign基于双线性插值取值解决了像素错位的问题,优化了建议框尺寸调节,保留了更多原始信息(见图3)。

图3 RoIAlign与RoIPool对比

以上采用了RoIAlign模块对RoI的尺寸调节进行改进,有效防止了特征信息的丢失,有助于实现隧道掌子面节理目标的精细化识别分割。

1.4 结果预测

Mask R-CNN网络最后会对调整后的RoI进行以下处理:① 具体分类,针对掌子面数据集,就会给出RoI的具体标签,即“节理”,不同于RPN阶段的二分类(正类、负类);② 预测框位置精调,在RPN阶段微调的基础之上,进一步对预测框的位置和长宽进行调整,使得预测框和目标更加贴合;③ 生成掩码,识别出预测框内属于目标物体的像素,并标记形成掩码。

该阶段训练过程设置误差函数LRoI为

LRoI=LRoIc+LRoIr+Lmask

(7)

式中:mask掩码损失函数为平均二元交叉熵损失函数,LRoIc分类损失函数lRoIc表示为

lRoIc=-ln(pu)

(8)

式中:pu表示预测为u类别的概率。

式(7)中LRoIr分类损失函数lRoIr表示为

lRoIr=λ[μ≥1]lRr

(9)

式中:[u≥1]表示u≥1时,值为1,否则为0。

综上所述,RPN阶段与结果预测阶段共设置5个误差函数,合计为

L=LRc+LRr+(LRoIc+LRoIr+Lmask)

(10)

1.5 基于改进Mask R-CNN的掌子面智能识别方法

上文所述特征金字塔网络(FPN)虽然实现了特征融合,增强了主干网络提取特征的能力,但从下到上的计算路径过长(整体包含101层网络),不利于特征信息传导,尤其是复杂隧道环境下多样的节理目标特征的传输。为此本文引入PANet(Path Aggregation,路径聚合网络)解决特征信息路径传输问题[15]。

图4展示了路径聚合网络结构。红色虚线表示原FPN的传输路径,自下而上传输特征需要经过多层网络结构。而改进的聚合路径方法(绿色虚线)则在较低的层次上使用精确的定位信号来增强整个特征层次结构,缩短了较低层次与最上层特征之间的信息路径,减少了信息损失。

图4 Path Aggregation网络结构

鉴于上述PANet的优势,本文将其引入FPN之中设计出了PA-FPN网络,以此改进Mask R-CNN网络,以增强隧道掌子面节理智能识别模型的识别分割性能。

2 隧道掌子面数据集

2.1 数据集创建

掌子面数据集是一种包含大量隧道施工现场掌子面图片的集合。掌子面图片来源于国内数座公路矿山法施工的隧道,经过挑选剩余共计400张原始图像,统一调整像素为2 048×2 048 pixel,部分图像见图5。从图中可以见到本文所搜集的掌子面图像数据具有丰富的环境条件(不同角度、不同照明、台车干扰以及阴影等),提高了隧道掌子面智能识别算法的鲁棒性。

对于一个基于深度学习的实例分割模型,400张图像数据还不能满足需求,因此本文采用翻转、裁剪以及亮度调整等方式对原始图像进行了数据增强(见图6),扩大数据量至800张,按照一般数据集划分准则[13],掌子面数据集中的训练集、验证集以及测试集分别包含560,160和80张图片。

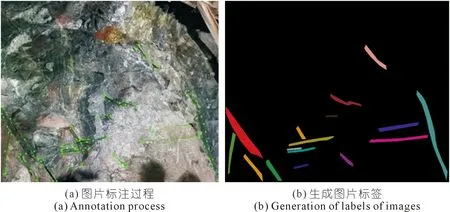

2.2 数据集标签

掌子面图像识别任务不同于传统的图像分类,实例分割算法需要在每张图片中标记目标物体制作标签,因此完成单张图片的标注工作需要约10 min,保证了掌子面节理数据集的质量。本文采用Labelme标注软件对掌子面节理进行标注。图7(a)中的点线为人工标注节理的多边形轮廓。每张图片标注完成之后生成包含节理位置和名称信息的JSON文件,这些文件经过内置代码转换为coco数据集格式,生成可训练的二值化标签图像(见图7(b))。

图7 图片标注方法

3 隧道掌子面图像实例分割实验

本文提出的隧道掌子面节理智能识别分割方法分为两个步骤:首先通过训练集、验证集数据训练掌子面节理智能识别分割模型;接着用测试集数据检验评估模型的性能,并与原Mask R-CNN算法以及其他实例分割算法进行对比。

智能识别分割算法采用python编程语言编写完成,在Windows系统Pytorch1.8.0平台下实现,运行内存为32G,GPU显存24G。

3.1 评估指标

机器学习任务的评估指标多种多样,针对实例分割任务,通常采用混淆矩阵、准确率等指标评估其性能。

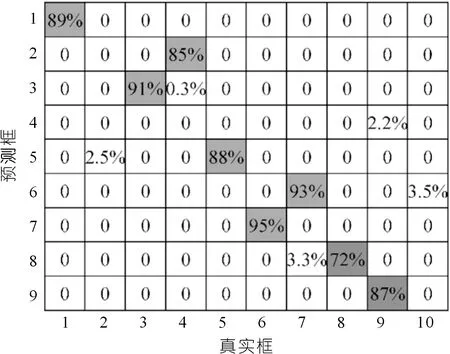

3.1.1混淆矩阵

在深度学习实例分割任务中,混淆矩阵针对单张测试图片,计算智能分割模型给出的预测框与所有真实框的IOU(与1.2节RPN阶段的计算相似),以列方向为预测框、行方向为真实框形成矩阵[13]。通常情况下,设置的IOU阈值为50%,当IOU>50%时,认为预测框检测出了目标,若预测框给出的类别与真实框一致,表示分类正确;若预测框给出的类别与真实框不同,则分类错误。混淆矩阵可以直观感受智能分割模型的检测效果。

3.1.2准确率、召回率、平均准确率

准确率(P)、召回率(R)以及平均准确率(AP)是分类任务中经常使用的评估指标,表达式为

(11)

(12)

(13)

式中:TP表示检测测试集图像的预测框为正类、真实框也为正类的预测框数量,即检测正确的数量;FP表示检测测试集图像的预测框为正类而真实框为负类的数量,即检测错误的数量;FN表示检测测试集图像的真实框未被检测出的数量,即漏检的数量。f(R)表示R与P之间的关系函数,通过检测数据获得。

针对本文所建立的智能识别分割模型,首先取单张测试图片计算IOU得出混淆矩阵,混淆矩阵的列方向预测框按其分类置信度大小从高到低排列[13],依次设置各分类置信度为分类阈值计算对应的准确率P与召回率R,绘制P-R折线图,即可计算AP值。

此外,单张测试图像的AP值并不能准确反映智能识别分割模型的性能,故计算整个测试集图片的AP值的均值作为整体的评估指标,即mAP。

3.2 超参数设置

深度学习算法的参数分为两种:① 模型内部的权重参数,可以随着训练进度不断改进;② 超参数,它并非训练得出,而是预先设定好的参数,用来调整训练效果。所以得到一套优秀的智能识别分割模型需要反复调整超参数。

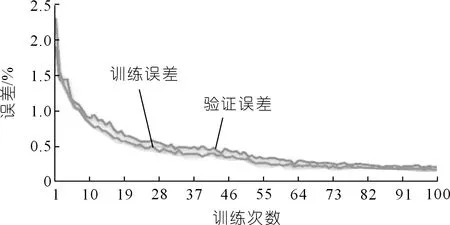

本文最终设置的学习率(指在训练神经网络时,用于控制权重更新步长的一个超参数)为0.001;图片尺寸超参数指深度学习网络中设定的训练尺寸,它会影响模型的性能和训练速度,为了保证网络的质量,训练尺寸设定为1 024×1 024,共训练100个epoch(一个epoch表示训练数据集中所有样本被训练完一次的过程)。

4 实验结果与分析

4.1 模型训练结果

智能识别分割算法的训练过程会生成训练日志文件,包含训练误差与验证误差数据,如图8所示。在训练100次之后,训练误差与验证误差都趋于平缓,表示训练模型达到了收敛。最后训练误差与验证误差分别为0.17%与0.21%,相差不大,表示智能识别分割模型未出现过拟合现象,具有较强的鲁棒性。

图8 训练误差与验证误差曲线

4.2 模型测试结果及评估

利用测试集图片对智能识别分割模型的性能进行评估,部分检测图像如图9所示。在不同的环境条件下,掌子面节理智能识别与分割模型仍然能够检测出大部分节理目标,且无需人工调整干预,实现了真正意义上的智能化,从检测结果来看,图片的拍摄光照越充足、环境越简单(不存在台架等干扰)则识别效果越好。

由此可见基于深度学习算法Mask R-CNN的掌子面节理智能识别分割模型表现非常优异,检测图片中的检测框对节理进行了准确定位,并且用掩码分割出属于节理的像素区域,实现了高效精细化的隧道掌子面智能识别。

不可否认的是,就图9所展示的典型的检测结果而言,本文算法还有很多需要改进的地方:① 存在部分肉眼可见的节理目标没有被模型检测出来的现象;② 分割节理目标的掩码普遍宽于节理本身;③ 对面状节理目标的识别准确率不高,较为粗糙。对此,进一步扩充数据集、优化标注质量将是解决以上问题的关键。

此外,为准确判定智能识别分割模型的性能,随机选择测试集中的图片进行精细化评估。首先通过智能识别分割模型检测测试集中的一张图片,接着计算预测框与真实框之间的IOU值,生成混淆矩阵(见图10)。第4个预测框与所有真实框之间的IOU均小于50%,存在误检情况,此外第2、10个真实框与所有预测框之间的IOU均小于50%,存在漏检情况。总体而言,本文算法检测出了大部分的节理目标,足以满足工程需求。但仍需针对图片中节理的检测细节问题,在进一步的研究工作中完善隧道掌子面节理检测与分割数据集的质量。

图10 检测测试集图片的混淆矩阵

根据3.1.2节内容计算准确率和召回率,得到P-R折线图,如图11所示。计算得到AP值为75.0%。接着设置迭代算法依次计算测试集内80张图片的测试AP值,取均值得到检测框mAP值为58.0%。分割mAP值的计算与检测框mAP计算规则相似,将像素IOU替换检测框IOU即可。经计算,分割mAP值为49.2%。

4.3 对比试验结果

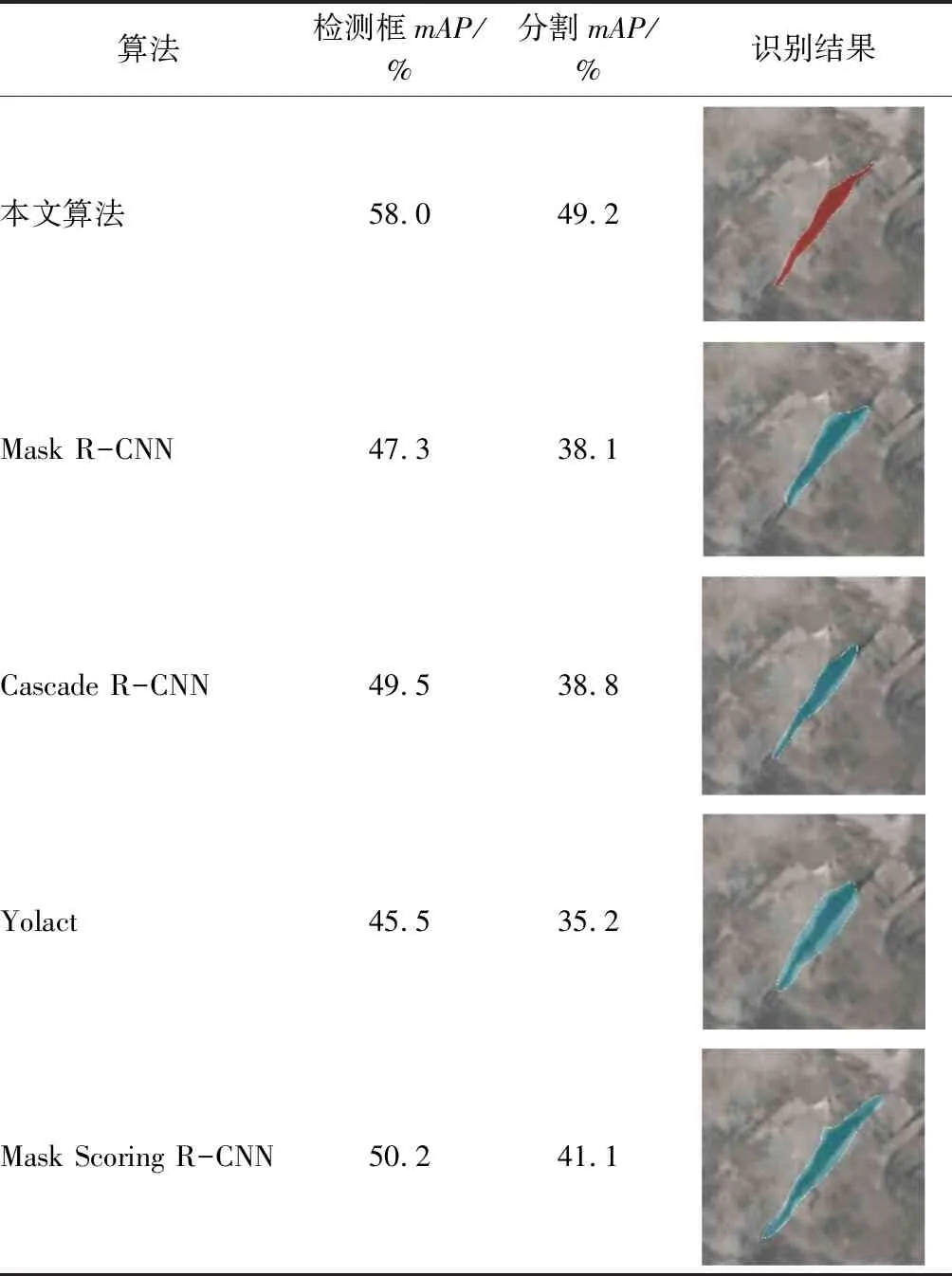

为使本文改进算法的有效性更加有说服力,开展了本文算法、原Mask R-CNN算法以及其他流行的实例分割算法的对比试验,表1展示了各算法的mAP值及其代表性识别结果。

表1 不同算法的mAP值及其代表性识别结果

由表1可知,本文算法相较于传统的Mask R-CNN算法在识别结果中表现更优。本文算法对节理分割精确,而Mask R-CNN算法出现了分割不彻底、掩码过宽的问题。此外,检测框与分割mAP值(58.0%,49.2%)均较高,表明本文引入的PANet改进了原算法的性能,能更加胜任隧道掌子面的节理检测与分割任务。

此外,本文引入了Cascade R-CNN[16]、Yolact[17]和Mask Scoring R-CNN[18]3种较为流行的实例分割算法与本文算法进行对比,其检测结果见表1。其中Cascade R-CNN与Mask Scoring R-CNN的检测框与分割mAP值分别为(49.5%,38.8%)与(50.2%,41.1%),较传统的Mask R-CNN算法均有所提升。且两种算法的识别分割结果更加精确,但相对于本文算法存在过度分割和分割不足的问题。而Yolact算法检测框与分割mAP值均最低,在隧道掌子面节理检测中性能最差(见表1中的识别结果),难以胜任复杂环境下的智能检测任务。但值得一提的是,该算法检测速率很快,在相对简单的应用场景及简单的目标检测任务中有广阔的应用前景。综上,本文算法性能优于传统的Mask R-CNN算法与多种当前流行的实例分割算法,验证了本文算法在隧道掌子面节理检测分割任务中的有效性与优越性。

5 结 论

本文以Mask R-CNN智能识别算法为基础,采用ResNet101作为提取特征的主干网络,引入路径聚合网络改进FPN对特征信息的融合能力,提出了一种基于深度学习的隧道掌子面节理智能识别分割算法,实现了复杂现场环境下多类型隧道掌子面节理的智能、快速、高精度检测,主要结论如下:

(1) 在数据集方面,本文建立了基于800张隧道掌子面图像的数据集,采用多边形方式对节理目标进行标注,包含了丰富的图像信息、多边形轮廓信息以及标签信息。

(2) 根据掌子面节理识别分割任务的特殊性对算法做出了针对性改进,引入路径聚合网络改进了FPN对特征信息的融合能力。该算法能够检测出隧道掌子面照片中的节理信息,通过检测框定位节理的位置,通过掩码分割属于节理的像素。同时该算法抗干扰能力强,能够适用于复杂隧道环境下的掌子面节理智能检测分割。

(3) 基于测试集中80张样本图片,采用混淆矩阵、准确率和召回率等指标对智能识别分割模型各项性能进行了评估,计算得出检测框与分割mAP值分别为58.0%,49.2%,相较于Mask R-CNN算法与多种当前流行的实例分割算法表现非常优异,表明本文算法在隧道掌子面节理检测分割任务中的有效性与优越性。

(4) 数据驱动的机器学习方法依赖有效、丰富的现场数据。尽管本文建立的隧道掌子面节理检测方法对隧道掌子面节理目标的检测效果良好,但仍然存在部分分割掩码较宽的现象,这些问题有待通过提升数据集的质与量来解决。

此外,本文提出的智能识别分割模型可直接用于复杂环境下的铁路、公路隧道掌子面节理检测任务中。结合硬件开发,可形成无人机、机器人等智能识别设备,解决传统素描方法存在的主观性、时效低等问题,为隧道建设的智能化发展提供技术和理论支持。