面向异构场景的智能运维联邦学习算法

2023-08-31宁宝玲谭思行苏新渺李文博刘成瑞刘文静

于 佳, 宁宝玲*, 谭思行, 苏新渺, 李文博, 刘成瑞, 刘文静

1. 黑龙江大学数据科学与技术学院, 哈尔滨 150001

2. 哈尔滨工业大学计算机科学与技术学院, 哈尔滨 150001

3. 北京控制工程研究所, 北京 100094

4. 空间智能控制技术全国重点实验室, 北京 100094

0 引 言

由于工作环境极端恶劣、系统设备性能退化等原因,航天器等核心设备发生故障的可能性较大,随之引发的系统异常、任务中断甚至装备失效等后果也非常严重.为航天器等设备设计智能运维算法是当前设备自主智能运维和健康管理研究领域的热点问题,行之有效的智能运维算法是提升系统自主性以及安全可靠运行能力的有效手段[1].

基于设备监测的相关信息,设计数据驱动的智能运维算法,可以充分利用数据优势,尽早发现系统运行中产生的异常情况,识别潜在发生的故障,并支持故障预警、故障诊断等运维任务.传统的系统运维方法大都依赖人工干预[2],存在响应速度慢、运维能力弱等缺点.很多现有的自动化运维方法依赖于专家知识[3]或预设的系统模型[4],对实际工作场景中不同情况的应变能力较弱,检测能力不足.与上述方法不同,智能运维是指以大数据为驱动,基于智能算法的运维方法[5,16],利用成熟的机器学习算法自动获取运维大数据中的知识,支持对不同应用场景下的精准决策判断,为航天器等关键设备提供快速有效的系统运维能力、发现系统潜在故障风险的能力以及设备寿命的精准预测能力,进而保障系统的可靠长期自主运行.

近年来,航天器设备逐渐呈现集群化趋势,现有研究工作中的航天器智能运维方法面临分布式运维和隐私保护2个挑战.一方面,需要面向航天器集群构建分布式智能运维方法.随着航天器设备制造和部署能力的不断提升,在轨运行的航天器数量越来越多、能力越来越强.利用航天器的无线通信能力,构建航天器集群系统成为主流趋势.然而,在新的集群场景下,由于各系统节点之间距离远近各不相同,计算和通信等资源极为受限,传统的集中式运维方法并不适用.因此,需要面向航天器集群构建安全、可靠的分布式智能运维方法,同时支持系统终端的实时运维能力以及融合多终端的综合运维能力.另一方面,需要为航天器设备提供智能运维过程中的隐私保护支持.很多航天器的工作环境和任务具有特殊性,保护系统中个体隐私信息的需求非常高.例如,通常来说,执行重要任务的航天器个体的位置、轨迹和负载等信息是非常敏感的,需要严格保护.然而,为了提供支持融合能力的分布式智能运维,不可避免地需要系统的各节点分享信息,因此,需要为分布式智能运维系统设计支持隐私保护的智能运维方法.

联邦学习[6]是解决上述挑战的有效方法.联邦学习本质上是一类特殊的分布式机器学习方法,其主要思想是协同融合多个数据源进行模型训练,可以支持对各自数据的隐私保护.联邦学习可以构建本地训练和模型融合相结合的智能运维方法,有力支持安全和隐私保护,完成分布式智能运维任务.文献[7]首次正式提出联邦学习的概念,并且设计了基于本地训练和模型聚合的联邦学习框架,后续很多研究工作针对实际应用中的不同挑战不断完善和改进该框架.在模型聚合方面,YUROCHKIN等[8]为神经网络的联邦学习提出一个贝叶斯非参数框架,它通过匹配本地模型的神经元建立一个全局模型.在隐私保护方面,BHOWMICK等[9]在总隐私保护的有效性被限制的情况下,设计了一个极小极大最优私有化机制,它可以模拟用户的本地私有保护策略,限制潜在攻击者的能力,并达到比严格本地隐私更好的模型表现.在通信压缩方面,KONECNY等[10]通过量化、随机旋转和二次采样的方法对模型数据进行压缩,以解决模型更新的通信代价大这一重要问题,降低中央服务器与所有用户之间的通信压力.WANG等[11]提出一个叫做局部补偿拉减(PRLC)的局部模型更新方案,使得不参与全局更新的设备通过PRLC在本地更新以减少与全局模型之间的差距.YU等[12]提出一个只使用正类标签的基于几何正则化器的半监督联邦学习分类框架,服务器在每次迭代后加入一个几何正则化因子,以促进类在嵌入空间中的投影性能.

在航天器等关键设备的运维应用中,由于设备的计算和通信资源受限,常规的联邦学习算法并不能达到很好的训练效果,无法很好解决运维模型训练的问题.一个最典型的问题是,由于不同航天器设备以及不同系统组件间具有不同的物理特性和任务负载,不同训练节点的数据分布往往是异构的,训练速度也不同,甚至不同任务的训练目标也有区别.面对上述情况,基本的模型聚合算法无法保障联邦学习的训练速度和模型性能.为了解决这些问题,现有研究工作已经开始尝试各种联邦学习的改进方法.例如,文献[13]基于受限的局部更新进行研究,通过将全局模型拆分为多个仅更新自己部分的参数的局部模型以实现降低通信和计算成本的目标.文献[14]基于设备分组的方式将参与联邦学习的设备划分为不同的组进行本地模型训练和参数交换以降低通信需求.同时,目前已经有一些研究尝试在数据分布异构的情况下开发有效的联邦学习算法,包括FedProx[13]、FedNova[18]和SCAFFOLD[19]等.FedProx通过限制客户端本地更新的程度以及在局部目标函数中引入L2正则化的方式来控制局部模型与全局模型的差异.FedNova允许不同的客户端组别在每轮聚合过程进行不同轮次的本地训练以降低训练时间差异,同时将具有大量本地训练的客户端赋予更大的权重以减小模型偏差.SCAFFOLD基于各参与客户端之间数据分布异构的程度为模型引入方差,通过方差减少技术[20-21]和增加控制变量的方式来提升模型性能.另外,也有部分研究工作利用模型相似性、数据分布度量和类失衡度量等方法来处理联邦学习中的异构问题[22-25].

然而,上述这些方法很少考虑或者仅考虑单一因素的异构性,缺乏对多种异构因素的统一表述和处理方法,并不适用于多异构因素同时存在的情况.并且,不同异构因素可能从不同角度影响联邦学习方法,可能同时造成训练效率和模型性能的下降,需要设计同时支持效率和性能改进的新型联邦学习方法,而现有研究工作并未关注这一点.

针对航天器智能运维所面临的异构联邦学习场景,为了应对数据分布、计算性能等不同异构因素带来的训练效率和模型性能下降问题,本文提出了一种基于模型分组的联邦学习算法,综合考虑计算性能不同导致的更新延迟以及数据分布异构导致的模型异构问题,将各客户端本地训练的时延信息和模型特征信息结合,利用聚簇方法将客户端进行分组,进而实现基于模型分组的联邦学习方法,支持异构场景下的智能运维模型构建.通过基于时延信息的联邦学习节点分组,可以实现更加高效的局部模型获取和通信交互,提升联邦学习的训练效率.通过基于客户端特征的模型分组,将客户端分组到合适的子联邦中,以实现更加高效的模型更新,提升联邦学习运维模型的性能.基于标准数据集和实际运维应用数据集,通过多组对比实验评测所提出方法的性能,验证了提出的异构场景的联邦学习算法的有效性.

1 面向航天器智能运维的联邦学习问题

1.1 智能运维方法的联邦学习表示

数据驱动的智能运维方法需要构建运维模型完成各类不同的运维任务,以有监督学习情况为例,面向具体的任务构建运维模型可以抽象表示为如下优化问题:

(1)

其中,w表示运维模型的参数(参数的总数为d),f(w;xi;yi)表示参数w对应的运维模型在数据样本(xi;yi)上的损失.传统的集中式运维模型构建问题可以抽象为以式(1)为目标的最优化问题,即寻找最优解对应的参数w取值.

在航天器集群的场景下,样本数据是由不同的航天器设备采集的,利用上述传统的方法构建智能运维模型需要极大的通信和计算代价,在资源受限的集群场景下难以适用.为该类场景设计智能运维模型的联邦学习算法可以解决上述问题.在联邦学习框架中,数据样本不是集中存储,而是分布在不同的客户端上.

设S为客户端集合,Dj为客户端j的数据样本集合,运维模型构建的联邦学习问题可以表示为如下形式:

(2)

这里,优化目标也可以表述为如下等价形式:

(3)

其中,Loss(j)为第j个客户端的损失均值,各客户端的权重与数据样本量成正比.

1.2 经典联邦学习算法

联邦学习算法的关键在于设计高效的本地模型训练和全局模型融合算法,以提升分布式模型构建的性能.FedAvg[7]是最经典的联邦学习算法,该方法每一轮随机选择m个客户端进行训练并上传本地模型,并且依据训练数据量将模型参数加权平均来更新全局模型,从而实现高效的联邦学习模型训练.FedAvg算法的主要流程如算法1所示.

可以发现,联邦学习算法并不需要在各计算节点之间传输数据,仅需要将本地训练和全局聚合获得模型参数在各计算节点之间传输.一方面,训练过程的通信代价仅依赖于模型,不随数据量的增加而变大;另一方面,联邦学习方法仅传输模型参数,不传输数据,可以在很多应用场景中实现隐私保护.

算法1:FedAvg算法输入:客户端集合S,初始模型w0,服务器通信容量m输出:训练后的模型参数w1 函数FedAvg(S,w0,m)2 服务器初始化全局模型w=w03 迭代 round t=1,2,…执行4 St←在客户端集合S中随机选取m个客户端5 服务器发送全局模型w给St中的客户端6 迭代每个客户端 i∈St执行∥并行7 客户端i接收服务器发来的全局模型w8 客户端i完成本地训练得到模型wti9 客户端i发送wti和训练数据量Di给服务器10 迭代结束11 服务器接收各客户端的模型并存入列表wt12 服务器聚合全局模型w=∑i∈StDi∑j∈StDjwti13 迭代结束14 返回w15 函数结束

1.3 异构场景下的联邦学习

航天器的工作场景具有计算资源受限、环境恶劣等特点,利用联邦学习构建智能运维模型面临如下异构问题,需要设计相应的高效联邦学习算法.

一方面,联邦学习的异构体现在不同的航天器节点的训练数据分布不同,即当参与联邦学习的客户端所拥有的数据分布存在显著差异,本地训练得到的模型彼此差异很大.由于传统的聚合算法倾向于将不同的模型进行均匀混合,这使得通过混合方式聚合得到的模型可能出现在某些节点上的性能提高损失减少,而在另一些客户端上预测损失大幅增加,这会使得聚合后的模型在各设备上应用时性能进一步下降,依轮次进行聚合获取的全局模型收敛速度变慢.此外,当简单以客户端数据量作为加权依据进行模型聚合时(如FedAvg),可能会出现算法公平性缺失、联邦学习性能下降的问题.例如,当某些客户端训练所用的样本数据量较小时,聚合过程为这些客户端赋予的权重也很小,会忽视它们对应的模型,使得聚合后的模型在该类客户端上性能无法得到保障.针对上述经典联邦学习算法性能受损的问题,需要设计新的聚合策略来处理数据异构情况,提高联邦学习的性能和效率.

图1 航天器运维场景中的异构示意图Fig.1 An Illustration of Heterogeneous Scenario for Operating Spacecrafts

2 面向异构场景的联邦学习算法

2.1 利用模型分组提升算法性能

为了解决异构场景对经典联邦学习算法所提出的挑战,提升联邦学习框架下异构场景运维模型构建的性能,本文采用模型分组的想法,设计异构场景下的联邦学习算法.模型分组是指将各参与训练的计算节点所获得模型划分为不同的分组,进而在联邦框架下将同一分组的本地模型聚合,将同一分组的计算节点同步聚合.

针对异构对训练效率的影响,不难发现,模型分组可以将训练效率相近的计算节点划分到相同的分组,调整节点训练的同步节奏,提升异构场景下的联邦学习效率.针对异构对模型性能的影响,如下面的分析所示,模型分组可以将数据分布相类似的本地模型划分到同一分组,提升分组聚合模型在相关节点上的性能,同时,调整不同类型模型间的聚合权重,提升全局模型对参与训练节点的适应性,提升全局模型的性能.

假设参与联邦学习的客户端能够根据其所拥有的数据分布划分到不同的分组中,这种分组带来的好处是每个分组客户端的样本数据分布相似,这样可以保证聚合后模型与本地模型的一致性,同时,这种分组方式还可以减少模型在不同客户端上的拟合效率差异,避免聚合模型在不同客户端表现差异过大的问题.令Sk表示某组相似数据分布所代表的计算节点集合,称其为一个子联邦,进而令wk代表第k个子联邦的模型参数,则原始的运维模型构建对应的优化目标可以转换成如下形式:

(4)

由上文的假设知,各个子集合Sk中的数据分布较为接近,故认为采用相同的聚合策略的情况下,模型的预测损失与模型训练时的数据分布接近程度成反比.因此,可推知有如下关系:

(5)

进而,可以得到

(6)

可以将式(6)进一步改写为如下形式:

(7)

根据上述分析,不难验证,如果能够找到一种恰当的模型分组方法,根据数据分布将联邦内的所有客户端分组到合适的子联邦中,然后在每个子联邦内部使用基于联邦全体模型更新的聚合策略(例如FedAvg),有机会在一定程度上提升模型的表现,改进联邦学习的性能.该方法直观上可以更好地解决数据分布异构的问题,减少模型在不同客户端上的拟合速度差异.

2.2 基于模型分组的联邦学习算法

受启发于经典的K-means聚簇算法[15],设计基于模型分组的联邦学习算法.

1)在每一轮联邦学习的模型更新中,服务器首先将当前运维模型下发到各个客户端,然后运行一轮收集客户端分组所需的各项信息,包括训练数据量、数据分布情况和训练耗时等.其中,训练数据量用来实现模型均匀聚合,可以用样本数目等基本信息表示;数据分布情况用来实现相似模型的聚合,可以用样本数据的抽样、直方图等分布描述信息表示;训练耗时用来实现客户端训练节奏的调节,可以用实际训练的时间代价表示.

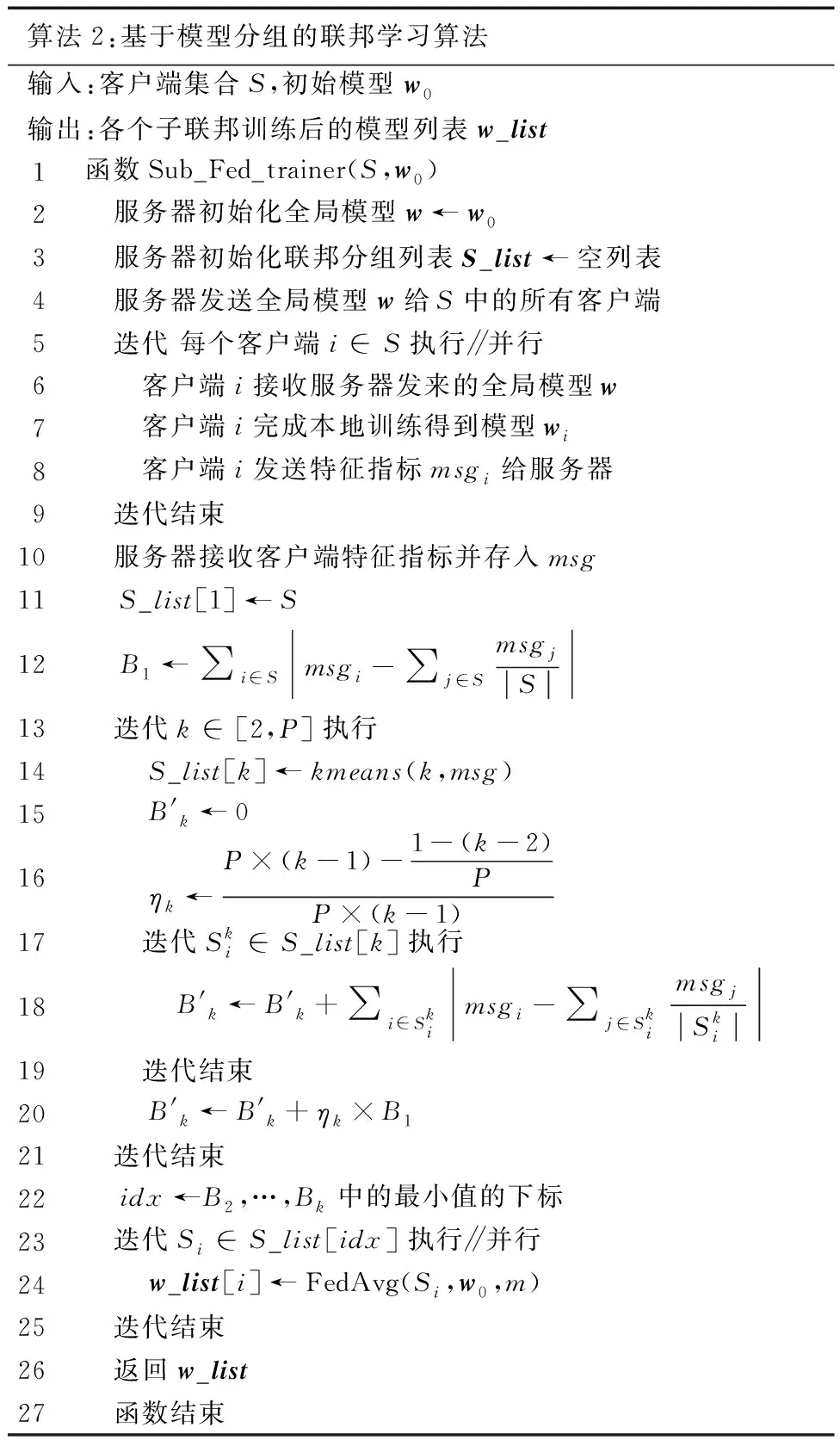

算法2:基于模型分组的联邦学习算法输入:客户端集合S,初始模型w0输出:各个子联邦训练后的模型列表w_list1函数 Sub_Fed_trainer(S,w0)2 服务器初始化全局模型w←w03 服务器初始化联邦分组列表S_list←空列表4 服务器发送全局模型w给S中的所有客户端5 迭代 每个客户端i∈S 执行∥并行6 客户端i接收服务器发来的全局模型w7 客户端i完成本地训练得到模型wi8 客户端i发送特征指标msgi给服务器9 迭代结束10 服务器接收客户端特征指标并存入msg11 S_list[1]←S12 B1←∑i∈Smsgi-∑j∈SmsgjS13 迭代 k∈[2,P]执行14 S_list[k]←kmeans(k,msg)15 B'k←016 ηk←P×(k-1)-1-(k-2)PP×(k-1)17 迭代 Ski∈S_list[k]执行18 B'k←B'k+∑i∈Skimsgi-∑j∈SkimsgjSki19 迭代结束20 B'k←B'k+ηk×B121 迭代结束22 idx←B2,…,Bk中的最小值的下标23 迭代 Si∈S_list[idx] 执行∥并行24 w_list[i]←FedAvg(Si,w0,m)25 迭代结束26 返回 w_list27 函数结束

(8)

进而,算法所需要计算的分组代价可以定义为如下形式:

(9)

经过多次遍历不同的子联邦数后,服务器选取分组代价最小的分组方式作为最佳分组方式,并根据分组的结果将客户端分配到各个子联邦中.接下来,在各个子联邦内部,系统将采用现有的基于联邦全体模型更新的聚合策略,对本地数据进行联邦学习训练.假定子联邦内采用的联邦聚合策略为FedAvg,则基于上述描述的基于模型分组的联邦学习算法的伪代码如算法2所示.

上述伪代码中的客户端训练特征指标msg可以是训练数据量、数据分布情况和训练耗时等.从直观上,通过基于模型分组的联邦学习算法,可以利用客户端的数据特征(如数据分布和数量)以及训练特征(如训练速率)将相似的客户端归为同一组,并将它们分组到同一个子联邦中.这种方法可以在一定程度上减少数据分布异构所引起的负面影响,同时避免不同训练阶段(欠拟合、拟合和过拟合)的各个客户端的模型效果互相干扰,可以改善异构场景下传统联邦学习算法(例如FedAvg)的学习效果不佳的问题.

3 实验结果

在这一部分实验中,分别基于标准的测试数据集以及面向设备运维的时序数据集构建联邦学习方法,完成对应数据上的智能模型构建,进而利用所获得模型验证所提出方法的有效性.

3.1 标准测试数据集实验

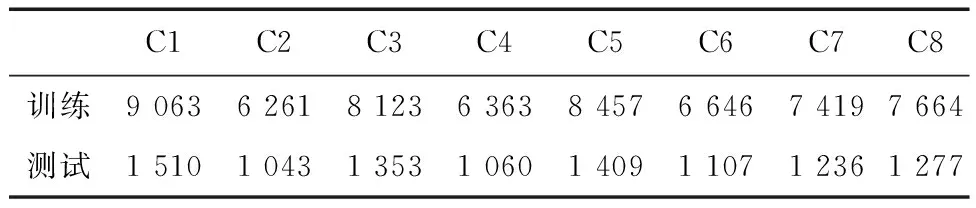

这部分实验利用Mnist数据集构造了2个不同的客户端数据分布情况,比较基于模型分组的联邦学习算法与无分组算法的效果.实验使用联邦学习仿真平台TensorFlow-Federated作为实验平台.实验采用的数据总量为60 000,测试集总量为10 000.进而,设计了一个客户端数据分布构造算法,该算法用于将集中式数据集Mnist按照合适的数据比例生成8个客户端的训练和测试数据数量分布,以作为测试实验的分布.2个不同分布分别代表同构分布以及异构分布,实验中所采用的数据集分布情况如表1和表2所示.

表1 同构Mnist数据集的分布情况Tab.1 The statistical characteristics of Mnist under homogenous setting

表2 异构Mnist数据集的分布情况Tab.2 The statistical characteristics of Mnist under heterogeneous setting

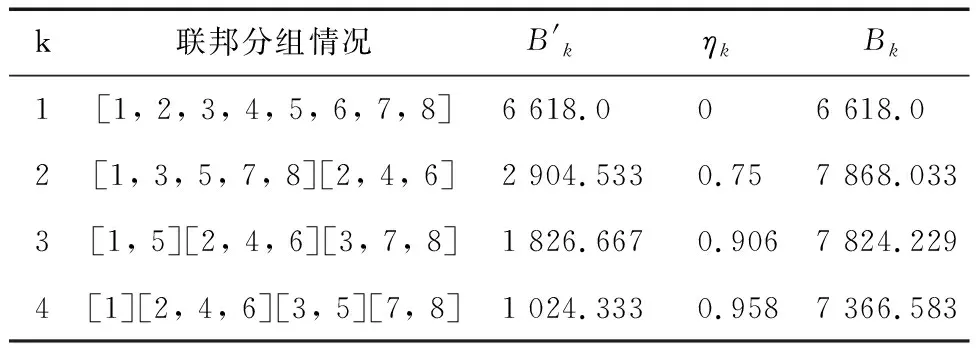

表3 同构情况下模型分组情况Tab.3 The statistical characteristics of groups under homogenous setting

由表3可见,在表1的客户端数据分布的情形下,当子联邦总数为1时的分组代价Bk最小,这也与直觉上相符,即此时无需客户端分组.为了更客观地评估效果,下面给出Mnist数据集在表1的数据分布下训练过程的模型效果,采用的联邦聚合策略是FedAvg变种方法,即将每一轮异步训练时本地处理的样本量作为额外的指标加权平均,评价指标为准确率,模型效果如图2所示.

图2 在表1数据分布下的联邦学习模型效果Fig.2 The performance of federated learning under data distributions shown in Tab.1

表4 异构情况下模型分组情况Tab.4 The statistical characteristics of groups under heterogeneous setting

表5 数据集的统计信息Tab.5 The statistical characteristics of the read datasets

由表4可见,在表2的客户端数据分布的情形下,当子联邦总数为3时的分组代价Bk最小,这也与直觉上相符,即应当将训练数据较多的前2个客户端、训练数据适中的中间3个客户端以及训练数据较少的后3个客户端分开,即需要分组为3个子联邦.为了更客观地评估效果,下文给出由Mnist数据集基于表2的数据分布情形下模型分组前后的训练过程的模型效果,见图3~6,采用的联邦聚合策略是FedAvg,评价指标为准确率,图中的Round为联邦聚合轮数.不进行模型分组的情形的模型效果如图3所示;模型分组后的第1个子联邦的模型效果如图4所示;模型分组后的第2个子联邦的模型效果如图5所示;模型分组后的第3个子联邦的模型效果如图6所示.

图3 异构情况下无模型分组的模型效果Fig.3 The performance of the model obtained via only 1 group

图4 异构情况下第1个子联邦模型效果Fig.4 The performance of the model of the first group

图5 异构情况下第2个子联邦模型效果Fig.5 The performance of the model of the second group

图6 异构情况下第3个子联邦模型效果Fig.6 The performance of the model of the third group

为了比较模型分组前后各个客户端的模型曲线,将各个客户端使用基于模型分组的联邦学习算法前后的准确率按照模型分组情况在图7~9中展示出来.其中,准确率图表的绿色线代表模型分组之前的结果,蓝色线代表模型分组之后的结果,图中的Round指的是联邦聚合的轮数.

图7 模型分组的第1个子联邦准确率对比图Fig.7 The performance of the clients in the first group

图8 模型分组的第2个子联邦准确率对比图Fig.8 The performance of the clients in the second group

图9 模型分组的第3个子联邦准确率对比图Fig.9 The performance of the clients in the third group

从上图展示的各客户端准确率的对比图可以看出如下几点:

1)对于数据量较多的第1个子联邦,模型分组后各个客户端的模型训练速度和模型性能都要显著高于未进行模型分组前的情形,体现在客户端1和客户端2的对比图中蓝色曲线全程位于绿色曲线之上,猜测是由于模型分组消除了数据量较多的客户端在模型聚合时受到数据量较小的子联邦的客户端模型训练步调较慢带来的影响,从而提高模型性能.

2)对于数据量适中的第2个子联邦,模型分组后各个客户端的模型训练速度减缓,体现在客户端3~5的对比图在前80轮聚合时蓝色曲线全程位于绿色曲线之下.然而随着聚合轮数增加到一定程度后,各个客户端的模型效果逐渐逼近甚至超过未进行模型分组之前的情形,体现在客户端3在80轮聚合附近,客户端4在90轮聚合附近,客户端5在100轮聚合附近出现蓝色曲线反超绿色曲线的情形.这是因为,模型分组带来的聚合模型收益比分组导致的数据量降低带来的负面影响要大,最终导致分组后在训练时间较长时获得了更好的模型效果.

3)对于各客户端数据量较少的第3个子联邦,模型分组后各个客户端的模型训练速度大幅减缓且模型效果较差,具体体现在客户端6~8的对比图,训练过程蓝色曲线全程位于绿色曲线之下.甚至在训练过程中有部分客户端出现了过拟合的情况,体现在聚合轮数大于80时客户端6和客户端7的蓝色曲线开始下降.出现这样的情形猜测是由于各客户端的数据量太少导致数据特征不足,使得模型分组消除掉的在聚合轮数较多时受到数据量较大的子联邦的客户端聚合时模型权重较高带来的负面影响远不及分组后导致训练数据量降低带来的负面影响显著,最终导致模型效果整体大幅低于分组前的情况.

总体来看,模型分组之后,对于数据量较多的客户端,其训练速度和模型效果均有一定提升;对于数据量较少的客户端,其训练速度略有下降但训练时间较长后的模型效果依旧超过未进行模型分组之前的情况;对于数据量较少的客户端,模型分组导致训练速度和模型效果全都降低.考虑到数据量较多的客户端在全体客户端中的权重占比较高,在客户端数据数量3级分布的情况下使用基于模型分组的联邦学习算法改进传统的联邦学习算法对于全体的模型效果有一定提升.并且,在实际应用中可以采取全局模型和多个分组模型相结合的策略,充分发挥学习侧重点不同模型的优势,可以显著提升所构建模型的整体性能.

新生儿的体温调节功能尚不完善,因此要使婴儿处于中性温度,在此温度中婴儿的代谢率和耗氧量最低。新生儿的中性环境温度随着体重及天数大小而异:出生24小时内,新生儿的中性温度为32℃~33℃,早产的未成熟儿为33℃~36℃;生后4~7天,足月儿的中性温度降至31℃~32℃,未成熟儿降至32℃~34℃;胎龄越小、体重越小的婴儿所需要的中性温度也越高。外界环境温度最低限度也不应低于25℃。

3.2 实际运维测试数据集实验

这部分实验选择经典的时序数据集SWaT[17]作为测试数据,该数据集是检验航天器等设备运维方法的常用数据集.SWaT数据集的数据量较大(共946722条数据),同时异常数据的占比较少(异常数据占比为5.7%).

与3.1节相同,利用随机选择的方法构造不同分布的数据划分,其中异构情况的信息如表6所示.

表6 SWaT数据集异构情况的数据分布Tab.6 The statistical characteristics of SWaT under heterogeneous setting

这部分选取异常检测作为典型的设备运维任务验证方法的有效性.因此,实验选择了自动编码器作为异常检测模型.采用的自动编码器[45]是一个全连接自动编码器,该编码器用一个模型覆盖所有的通道,输入样本是一个展平的时序数据子序列,即一个长度为lw×m的矢量,其中输入的时间序列的长度为lw,每个数据的维度为m, 激活函数使用的是tanh.自动编码器的左半部分是编码器部分,右半部分是解码器部分,呈现对称结构,编码器的输入与解码器的输出维度相同.编码器本身是一个多层全连接感知器,输入维度为lw×m,隐藏层中每2层的维数按2的幂减少并四舍五入获得,编码器输出的维度为lw×(m/8+1).编码器各层维度的示意图如表7所示.

表7 自动编码器的结构信息Tab.7 The structure information of the auto-encoder utilized

在划分构造的数据集上,同构分布情况下利用传统联邦学习算法基于自动编码器构造的异常检测模型的实际性能如图10所示.图11是数据异构情况下传统算法构造的异常检测模型性能,可以看出异构情况会极大影响传统算法的性能,算法性能变得不稳定,即随着训练轮数的增加算法性能收敛性变弱,并且在大多数客户端上所展示的3个指标上此种情况模型的性能明显落后于同构场景.

图10 数据同构情况下异常检测模型的性能Fig.10 The performance of the anomaly detection model under the homogenous setting

图11 数据异构情况下传统算法构建的异常检测模型的性能Fig.11 The performance of the anomaly detection model obtained by traditional methods under the heterogeneous setting

如图12所示,利用本文提出的异构联邦算法构建的异常检测模型性能与同构场景接近,图12中只列举了第2组模型分组的性能,其余分组性能类似,具体对比信息如表8所示.可以看到,所提出的算法可以改善获取的异常检测模型的性能,同时,模型的性能也更稳定.

表8 不同计算节点上的性能对比Tab.8 The performance comparison on different clients

4 结 论

面向构建基于联邦学习的智能运维模型,针对航天器等关键设备运维所面临的异构特点,本文利用模型分组的思想提出一种数据分布和训练能力异构情况下的联邦学习算法,该算法利用模型特征进行分组,提升了全局模型的性能,减小了不同训练效率设备间的延迟等待时间,标准测试数据和实际应用数据上的实验结果表明所提出的方法是有效的,可以提升分布式异构场景下的关键设备智能运维的能力.