低资源少样本连续语音识别最新进展

2023-07-10杨绪魁闫红刚陈雅淇

屈 丹, 杨绪魁, 闫红刚, 陈雅淇, 牛 铜

(战略支援部队信息工程大学 信息系统工程学院,河南 郑州 450001)

自动语音识别技术(automatic speech recognition, ASR)是人工智能领域非常活跃的一个领域。传统的语音识别框架通过DNN或GMM与HMM联合实现混合结构的声学模型,并需要语言模型和发音词典的配合才能完成语音识别任务,该框架的缺点在于模型结构复杂、训练步骤烦琐和专家知识依赖性强。为了解决这些问题,研究人员逐渐开始研究下一代语音识别框架——端到端(end-to-end)的语音识别技术。

2006年,Graves等[1]首次提出端到端连接时序分类(connectionist temporal classification, CTC)算法,并用其训练了一个由RNN编码器和线性分类器构成的深度网络,实现了端到端语音识别。2013年,Graves等[2]又提出了RNN转换器(RNN transducer, RNN-T)语音识别模型。Chan等[3]提出了“listen, attend, and spell (LAS)”模型,LAS模型的listen、attend和spell分别表示编码器、注意力机制和解码器,通过注意力机制在编码器输出的特征序列上构造上下文相关矢量,并与前一时刻的解码器的输出一并用于生成当前时刻的输出,该模型超过之前的模型,达到了当时最好的性能。2017年,谷歌公司在文本处理领域首先提出了基于全注意力的变换器(Transformer)模型[4],研究者将其扩展到语音识别领域,在训练效率和识别性能上达到了新的最佳性能,逐渐成为端到端语音识别领域的基本模型。随后很多针对Transformer的改进模型陆续被提出[5]。

当代最新语音识别技术在某些特定数据集上已突破了人类的能力极限,超过了人类听抄的最高水平。但这种突破基于两个特定条件:一是信道环境较为理想,即通常话音质量非常好、采集场地相对单一、噪声起伏变化不大;二是训练语料非常充足,尤其是对于汉语、英语等大样本语言,其工业级实用系统训练所需的标注数据常常超过数千小时甚至是数万小时。但在大多数特定行业应用领域,所面临的实际条件对少样本机器学习提出了更为迫切的需求,主要表现在以下两个方面。一是现实环境极其复杂且难以预测,信道条件往往多种多样,噪声也起伏变化差异较大,如既有录播室环境的高保真信号,也有经过电信网络或者其他带噪通道传输的窄带信号,这种复杂的条件为语音处理与识别处理带来诸多难题。二是标注数据匮乏使得传统机器学习难以形成有效认知。无论是哪种语言的语音识别系统都需要有大量标注数据。世界上有超过7 000 种语言,而其中仅有为数很少的几种语言(如汉语普通话、英语等)具有充足的标注数据,除此之外的绝大部分语言或方言都面临“资源匮乏”或“少样本”困境。而往往这些“少样本”语言如马来语、印尼语、印地语、土耳其语等在国家战略交流中也非常重要。很多行业应用的现实环境就不具备大规模采集标注数据的条件,使得语音识别行业应用面临的迫切需求是突破少样本机器学习的性能极限、探讨更先进的技术方法、从理论和技术上攻克难题。

1 低资源连续语音识别框架技术

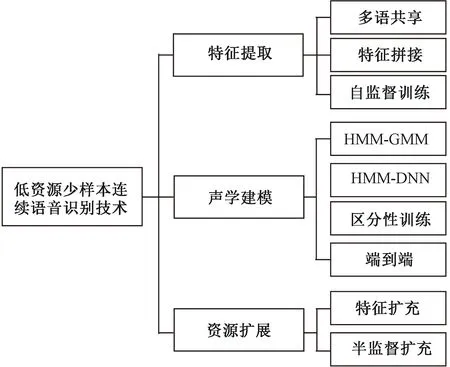

近年来,国内外针对低资源少样本下的语音识别问题进行了大量研究。其中以2011年美国情报先进研究计划署(Intelligence Advanced Research Projects Activity,IARPA)的Babel计划[6],荷兰代尔夫特理工大学、爱尔兰都柏林城市大学等组织发起的每年一次的多媒体评测(MediaEval)为代表。低资源小语种语音识别指缺乏用于训练的相关数据资源,包括标注语音、发音字典和文本等,其中尤其以发音字典和标注语音影响最大。小语种语音数据难以获取不仅表现在语音上,更表现在语料、发音词典和标注资源上。与传统语音识别相比,低资源少样本连续语音识别有许多针对性的技术,主要体现在如下3个方面,总体框架如图1所示。

图1 低资源少样本连续语音识别技术Figure 1 Low-resource few-shot continuous speech recognition

1.1 低资源少样本特征提取技术

深层特征具有较强的鲁棒性,在环境、说话人发生变动的情况下不确定性更小,因此目前广泛采用深度神经网络(deep neural network, DNN)提取更加稳健的高层语义表示特征[7]。2011年前后,在深度学习引入语音识别领域不久,许多研究关注于利用DNN提取深层特征,典型的研究成果有tandem特征和瓶颈(bottleneck, BN)特征。目前关于低资源条件下的特征提取技术研究主要集中在3个方面:一是利用多语数据通过共享神经网络权值的方法实现相关特征的提取,从而提高在其基础上建立的语音识别系统的性能;二是采用不同声学特征参数拼接融合的方法增强特征的区分性和稳健性[8];三是借助一些无监督或者自监督方法训练编码器,可以将编码器的输出作为特征映射函数,将信号或特征经过编码器后的输出作为特征,或者将编码器借助特定领域数据进行迁移后作为特征提取模型来完成特征映射,该部分内容将在2.2节的自监督表示学习部分中重点阐述。

1.2 低资源声学建模技术

语音识别中的声学建模技术发展可以分成4个阶段:一是传统隐马尔可夫模型-高斯混合模型(hidden Markov model Gaussian mixture model, HMM-GMM);二是DNN混合声学模型建模技术;三是目标函数的区分性训练准则;四是打破传统框架的端到端建模技术。

在HMM-GMM框架模型方面,2011年Povey等[9]提出子空间高斯混合模型(subspace Gaussian mixture model, SGMM)来对HMM发射概率进行建模;Imseng等[10]进一步利用Kullback-Leibler距离对传统GMM进行正则化。在DNN混合声学模型建模技术方面,Mohamed等[11]提出使用DNN代替HMM-GMM声学模型中的GMM,用于对发射概率进行建模,大大减少了对标注数据的依赖性。后续的工作对DNN的结构进行了进一步的探索,典型的如时间延迟神经网络(factorized time-delay neural network, TDNN-F)[12-13]等。此外,为了进一步提升模型表现力,深度学习的区分性训练准则如最大互信息(maximal mutual information, MMI)、提升最大互信息(boosted maximal mutual information, BMMI)、最小音素/词错误(minimum phone/word error, MPE/MWE)、状态级最小贝叶斯风险(state-level minimum Bayes risk, sMBR)、词格无关最大互信息(lattice-free maximum mutual information, LF-MMI)[14]等,也被引入到模型训练中,以进一步提升识别率。鉴于混合模型需要多个模型分别训练,优化难度大,且对专业知识需求高,研究者越来越关注端到端的结构,目前已成为主流的学习范式。但是这也并不意味着丢弃之前的研究,类似于区分性训练准则也被广泛整合到端到端模型的训练过程中。

1.3 低资源语音识别资源扩展技术

标注数据匮乏是低资源的一个显著特点,因此需要研究者考虑扩展数据集。目前由于语音标注资源比较受限于高成本,因此主要考虑标注语音样本扩展技术。训练数据扩展有两种策略。一种是不改变文本标注,只对音频或声学特征进行扩展。最简单的做法是针对现有训练数据,在保证基本语义不变的情况下通过改变语速等方法获得额外的训练数据。因此噪声添加、声道长度扰动技术[15]、语速扰动(speed perturbation, SP)方法[16]作为经典数据拓展方法常常被用于低资源语音识别中。后期更多的数据增强策略被采用,包括SpecAugment[17]、Wav-Aug[18]、MixSpeech等。目前这些方法已经成为语音识别模型中的默认配置,在各种场景、语种下展现出较强的鲁棒性,可以使识别效果得到持续的提升。

另外一种重要的方法是基于半监督的数据扩充。首先,利用训练数据训练一个初始的语音识别模型。其次,对无标注的单语数据进行识别,将识别结果作为这些单语数据的标注,一般称之为伪标注数据。最后,根据一定的策略对这些伪标注数据进行筛选,将筛选后的伪标注数据和原始训练数据混合,重新训练整个模型。比较典型的有噪声学生训练(noisy student training,NST)[19]。但是该方法一方面需要多轮重新训练,会耗费大量训练资源;另一方面其性能依赖于好的标签选择策略。

2 少样本语音识别中的高级深度学习技术

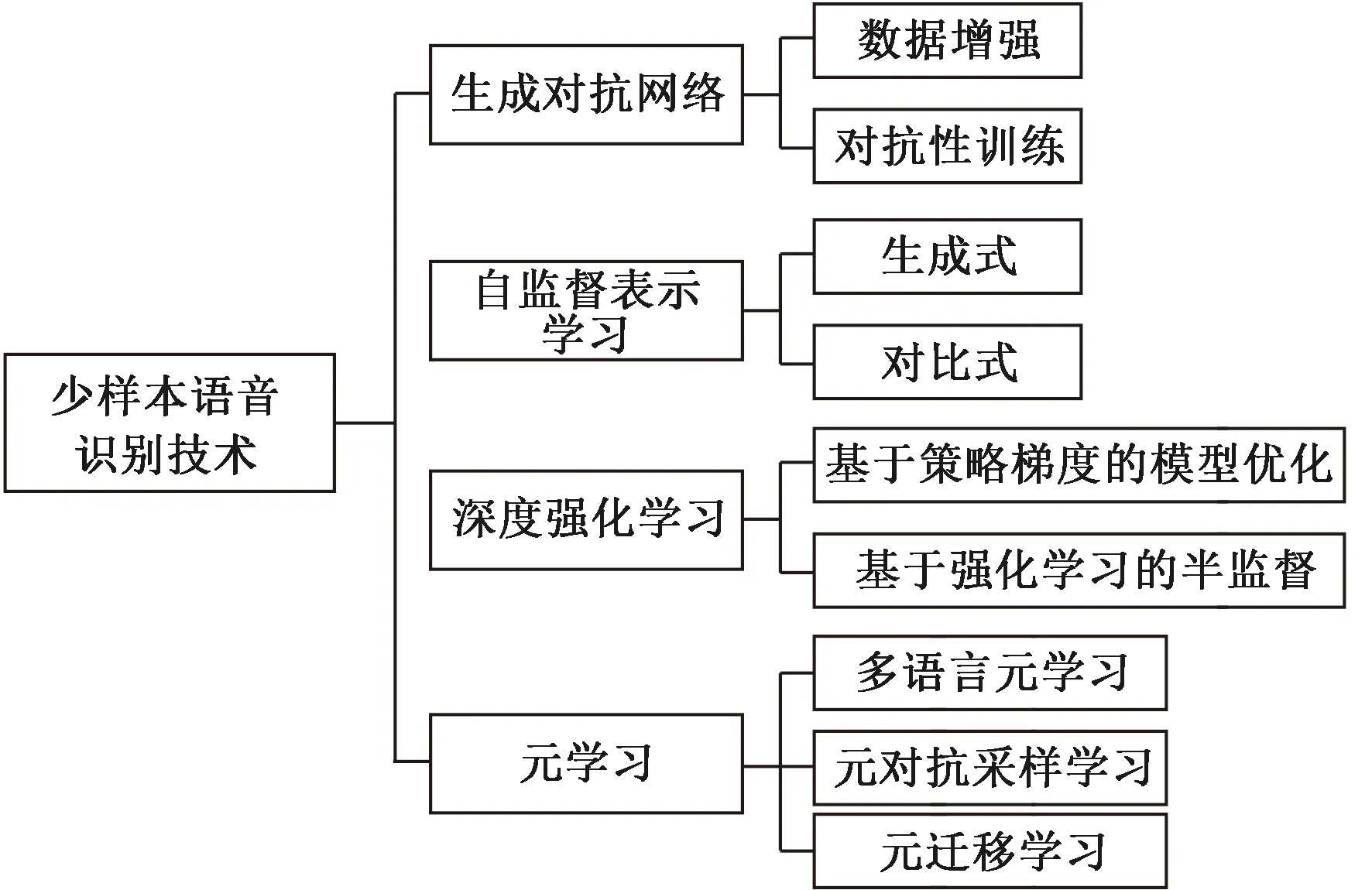

为了能够在受限标注样本情况下获得更好的性能,近年来深度学习中的高级建模技术也为低资源语音识别技术带来了新的活力,主要技术包括生成对抗网络、深度强化学习、迁移学习、元学习、自监督表示学习等,其核心目标在于从几个方面克服低资源恶劣环境的影响:一是数据层面的拓展,例如生成对抗网络和深度强化学习都可以进行数据增强;二是利用已有数据获得更有泛化力和表征性更强的特征提取算法,如自编码和自监督表示学习技术;三是已有相关知识的借鉴和利用,如迁移学习和元学习技术;四是寻找一些更好的学习机制,例如元学习、对抗学习和深度强化学习机制等。总体框架如图2所示。

图2 少样本语音识别中的高级深度学习技术框架Figure 2 Advanced deep learning framework in few-shot speech recognition

2.1 生成对抗网络

生成对抗网络(generative adversarial networks, GAN) 是蒙特利尔大学Goodfellow等[20]在2014年提出的一种生成式模型。GAN的基本思想来源于博弈论中的二人零和博弈[21],通过从训练库中获取多个真实训练样本,利用博弈对抗思想学习这些样本的生成概率分布。GAN模型中的两个博弈方分别由生成器G和判别器D构成。其优化目标为

Ez~pz(z)[log(1-D(G(z)))]。

(1)

生成器在噪声先验分布pz中采样生成样本以捕捉样本数据的分布,判别器用于最大化式(1)的训练样本来自于训练数据pdata(而非生成数据)的概率,二者都可以采用结构多样的模型来完成。生成对抗网络在低资源语音识别中的应用主要体现在两个方面:一是利用对抗网络来产生训练数据等实现数据增强和拓展;二是利用对抗网络进行对抗性训练以减少训练环境和测试环境失配。

在数据增强方面,2019年,Qian等[22]利用GAN进行数据生成以改善噪声条件下的语音识别,一方面利用生成对抗网络构建无监督学习框架进行声学建模,另外一方面利用条件GAN生成带标签信息的真实语音用于声学模型建模。实验证明了这种数据增强可以降低噪声环境下语音识别系统的词错误率。2018年,Sun等[23]采用快速梯度符号法(fast gradient sign method, FGSM)生成对抗样本进行数据增强,与一些静态转换数据增强方法不同,样本可以基于当前声学模型参数动态产生。该方法在噪声和变化信道条件下获得了较好的性能。

在对抗性训练方面,2016年,Shinohara[24]提出对抗多任务训练(adversarial multi-task learning, AMT)方法。该方法最早将GAN用于语音识别,其基本思想是基于DNN高层特征对噪声具有鲁棒性的特点,将语音经DNN编码器处理后的高层次特征送入到GAN网络中进行对抗性训练来实现对音子建模。生成器目标在于最大化分类概率,判别器目标在于最大化信号域分类概率,而编码器目标在于上述两种目标和。实验结果表明该方法可提升噪声条件下语音识别系统性能。2018年,Liu等[25]提出了一种直接增强声学模型噪声鲁棒性的对抗性训练方法。该方法中生成器用来从噪声特征中产生干净的特征表示,判别器用于区分干净信号和生成信号。2021年,Li等[26]提出了一种多鉴别器CycleGAN语音增强方法来提升语音识别性能,该方法不需要任何并行数据,通过设置能够比对不同频率区域的判别器和多个类似数据子集的生成器来优化噪声增强性能,从而提高自动语音识别的性能。

尽管效果提升显著,但生成对抗网络较难训练,通常利用频谱正则化等方法稳定优化过程,并且随着其他训练方法如自监督表示学习在低资源语言识别上展现出极其优异的性能,目前对其直接的使用逐渐减少,更多的是利用其进行领域自适应或者作为一种正则化手段结合其他方法一起使用。

2.2 自监督表示学习

自监督表示学习是无监督学习的一个分支,其本质是一种具有监督形式的非监督学习方法,即不借助任何标注数据,直接利用数据本身信息通过构造某种形式的辅助训练任务来学习对下游任务有价值信息的表示方法。由于其非常适合解决少样本环境下的模型冷启动问题,已经成为人工智能领域最热点的方向之一。自监督学习广义上可以分为生成式、对比式两类[27],而语音信号的自监督表示学习主要包括信号重建和对比预测两种,在语音识别、增强和处理等多个任务中获得显著效果。

基于信号重建的自监督学习方法属于生成式方法,即根据重建损失对语音信号的帧级基本单元信号进行重建。信号重建方法又可以细分为回归预测和掩蔽重建两个子类。比较典型的模型有自回归预测编码(autoregressive predictive coding, APC)[28]、矢量量化自回归预测编码(vector-quantized autoregressive predictive coding, VQAPC)[29]、重构变换器表示模型(transformer encoder representations from alteration, TERA)[30]、HuBERT[31]等。

语音处理中第二类自监督表示学习是对比式方法,其基本思想是通过自动构造相似实例(正例)和不相似实例(负例)训练一个表示模型,使得正例在编码器对应的投影空间中比较接近,反之负例距离较远,因此可以认为在编码器投影空间中学习到样本的本质特征,或者说找到了数据内在流形。而通常编码器训练准则为最小化噪声对比估计(noice-contrastive estimation,NCE)[32]或InfoNCE[33]。典型对比式自监督学习包括对比预测编码(contrastive predictive coding, CPC)、wav2vec[34]系列、XLST等。以wav2vec2.0为例,其对比损失Lm定义为

(2)

虽然自监督模型在多个下游任务上取得了优异的性能,但是由于其在训练过程中采用的是无监督的范式,因此学习到的表示是通用的表示。对于少样本语音识别任务来说,这种表示存在相当大的容量冗余,在少样本的条件下模型难以有效去除掉这些冗余,并且模型的参数量巨大,在少样本条件下微调容易过拟合。因此对少样本语音识别任务来说,后续的研究主要集中在模型的轻量化调整、压缩学习到的表示中的无关容量等方面。

2.3 深度强化学习

强化学习是智能体(agent)与环境不断交互获得环境反馈进行学习的方法,本质上是一种“试错”学习,即在与环境的不断交互中寻找最优策略。其理论基础是马尔可夫决策过程(Markov decision process, MDP)。近几年来,强化学习与深度学习结合获得了巨大的发展,尤其是在AlphaGo凭借深度强化学习技术先后打败人类顶级围棋选手后,深度强化学习的应用越来越广泛。当前,深度强化学习技术在语音识别中应用较少,主要集中在两个方面[35]:一是利用策略梯度来进行模型优化提升,同时在目标函数不可导时可利用策略梯度算法无须计算回报函数导数的特点进行解决;二是利用强化学习无须数据标注的特点进行半监督训练解决少样本条件问题。

现有基于注意力机制编解码器结构的语音识别系统在训练时采用交叉熵训练准则和教师强制(teacher-forcing)训练方法,即解码器每一时刻输入强制约束为正确标注,而在测试时利用自回归方式进行解码后计算词错误率,即解码器每一时刻输入为上一时刻输出,使得训练和测试时解码器行为不一致。换而言之,解码器新预测单词在训练和测试时是从不同分布中推断,存在训练和测试失配问题。因此Tjandra等[35]提出采用强化学习训练方法,以输出序列与正确标注的编辑距离作为回报函数,采用策略梯度下降进行模型训练,在最大似然准则下错误率有明显下降。随后Tjandra等[36]进一步优化训练方法,探讨了两种不同单步符号级和序列级回报函数的性能,指出单步符号级回报函数可以获得更优结果。此外,为进行在线实时语音识别,Luo等[37]提出一种类似于混合自回归变换器(hybrid autoregressive transducer, HAT)结构[38]的在线式序列到序列语音识别模型。

强化学习方法不需要监督信号,因此理论上也不需要标注数据,利用无标注数据就可以进行学习,但关键问题在于回报函数设定和识别结果的评价机制。由于强化学习本质是人机交互式学习,因此利用强化学习算法对语音识别系统进行半监督或非监督训练也成为一个重要发展方向。如Kala等[39]提出一种利用无标注数据、以人机交互式学习提升语音识别系统性能的方法;Chung等[40]提出一种强化学习半监督训练方法,即对标注数据采用交叉熵准则进行训练;Radzikowski等[41]提出将对偶学习和强化学习相结合的方法进行非母语说话人语音识别系统的半监督训练。最近由于ChatGPT的优异表现,基于人类反馈的强化学习引起了前所未有的关注,后期如何将相关的研究引入到语音识别中,并根据领域特点进行调整是可期望的一个研究方向。

2.4 元学习

由于深度学习方法性能极其受标注数据规模的影响,因此迫切需要一种新型学习方式来实现少样本甚至是零样本的学习。神经网络元学习作为推动当代深度学习行业前沿的潜在强大驱动力,导致了近期研究的爆炸式增长。业界期望通过元学习来解决当代深度学习中的许多瓶颈问题。

(3)

(4)

(5)

(6)

王璐等[42]在TIMIT和自建佤语语料库上利用经典MAML算法和Reptile算法,探讨并验证了元学习方法有助于解决小规模孤立词语音识别。后期侯俊龙等[43]将元度量学习也用于低资源孤立词识别,但其孤立词应用场景设定过于简单缺乏实用性。2018年Klejch等[44]提出采用元学习方法来进行说话人自适应来解决训练和测试条件失配问题,研究结果表明元学习者可以学习执行有监督和无监督说话者适应,并且在适应具有1.5 M个参数的DNN 声学模型时,优于当前性能比较好的隐含单元贡献度学习(learning hidden unit contribution, LHUC)深层网络自适应方法。Hsu等[45]提出端到端框架的元语音识别(MetaASR)方法,即将不同语言的ASR认为是不同的任务,并且利用MAML算法进行模型初始化训练,使用6种语言作为预训练任务,4种语言作为目标任务。结果表明,MetaASR显著优于最先进的多任务预训练方法。2020年,Xiao等[46]借鉴MetaASR方法构造多语言元学习语音识别(multilingual meta-learning ASR, MML-ASR)方法,将每个源语言ASR问题分解成许多小的ASR识别任务,然后利用元学习对不同源语言所有任务的模型初始化,以快速适应未知目标语言。但由于不同语言的数据规模和其发音系统建模难度差异性很大,导致了元学习子任务数量和任务难度不平衡问题,从而导致了多语言元学习方法的失败,为此该团队又提出元对抗采样学习方法(adversarial meta sampling, AMS)来改善不同语言子任务的非均衡问题[46]。口音的较大可变性和复杂性为语音识别系统带来重大挑战,2020年,Winata等[47]在MAML算法基础上提出口音无关元学习方法来快速适应未知英语口音,在混合区域和跨区域口音任务中该方法均优于联合训练方法。同年,Winata等[48]又提出基于MAML的元迁移学习方法对混合语种的连续语音进行识别,结果优于同等情况下的其他方法。

元学习本质上是一种更通用的模式,其核心在于元知识(meta-knowledge)的表征和获取。通过在任务上学习,具有非常强大的表征能力,因此对新任务的泛化能力更强。目前在连续语音识别上应用的元学习算法主要是基于梯度的MAML、Reptile、ANIL等算法,这些算法都是与模型无关的、只改变模型的训练方式。元学习将语言作为任务,通过“先适应再学习”的学习范式,能够获得对新任务快速适应的能力。

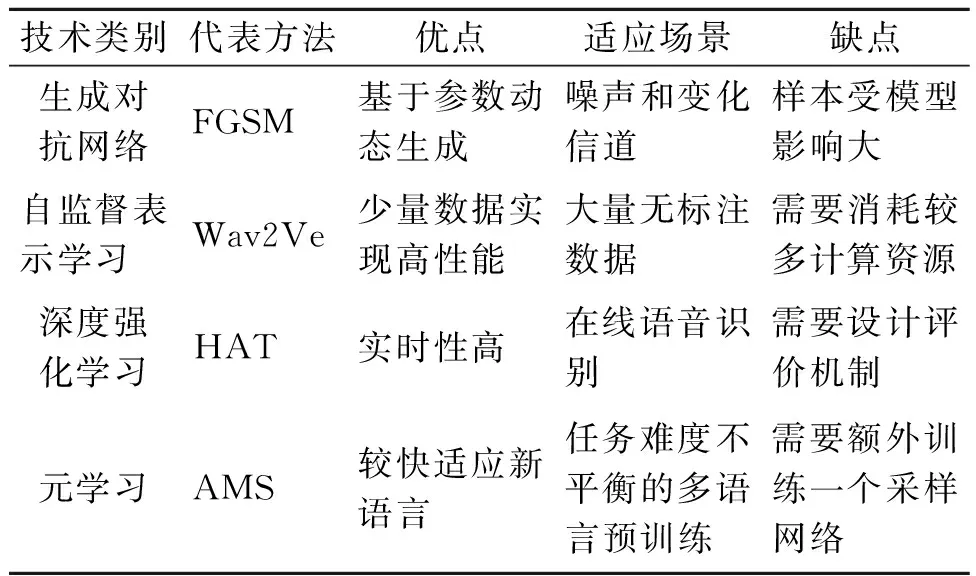

以上4类高级深度学习技术各有特点,每类技术的代表方法、优缺点以及适用场景如表1所示。

表1 高级深度学习技术方法特点对比Table 1 Comparison of advanced deep learning techniques and methods

3 存在的问题和挑战

尽管研究人员在低资源语音识别方面有一定进展,但从认知角度来看,采用的方法与人的快速学习能力相差甚远;而且在训练数据规模方面,没有考虑到更小的规模,因此需要对语音识别采用更先进的理论、对低资源标注数据获取条件更为受限的情况开展研究。目前面临的主要问题包括以下几点。

3.1 不同学习范式的组合互补有限

3.2 多语言联合学习对数据和任务均衡问题考虑不足

由于很多语言的单一语种数据都很匮乏,而借鉴不同语言之间的共性信息进行多语言联合学习已经成为提升少样本语言识别性能的一种有效方式。无论是自监督表示学习、元学习或者生成对抗网络,在进行多语言联合处理时都对不同语言没有区别对待。但实际过程中,即使是相同方法处理不同语言的数据时性能都会有一定差异,或者说每种语言都有不同的难度系数。以元学习模型构建为例,初始化元学习方法由于上述不均衡性会导致其初始化模型离大规模、易训练收敛语言比较近,离目标语言最优模型较远,会导致后期优化进程缓慢且容易陷入局部最优。因此在采用不同方法进行模型建模时,面临多种“不均衡”问题,如何克服这种不均衡性、减少不均衡性对系统性能的影响是值得思考的问题。

3.3 模型轻量化部署需更深入研究

深度学习由于其强大的复杂模式表示能力使得其在语音识别等诸多领域获得了突飞猛进的发展,但由于其模型参数规模大、计算复杂度和空间复杂度高,无法有效应用于轻量级资源受限的便携设备中。而语音识别是人机交互的重要一环,人机交互场景更需要小型化、微型化设备的应用,因此如何在低资源少样本条件下进行模型部署也成为一个重要问题。

深度学习技术正朝着两极发展:一是深度学习领域研究人员致力于研发更深、更大的模型,达到更高的精度和准确度,如speech-transformer模型层数和参数规模都很大,且这种大模型也开始向微观世界发展,如深度学习用于蛋白质合成、分子发现等领域;二是深度学习自身朝着小型化发展,很多智能化应用场景的搭载平台受体积、功耗等因素影响,因此一些研究学者致力于对深度学习模型进行压缩以便部署在小型平台。而作为深度学习应用的重要领域,语音识别也同样遵循上述两极化发展的脉络。目前模型压缩技术主要包括浅层压缩和深层压缩两大类,浅层压缩主要通过裁剪和知识整流来实现,而深层压缩通过量化、轻量级网络和结构搜索来实现。但当模型压缩与低资源少样本同时出现时,其性能更难以保证,因此未来需要对模型轻量化技术进行更加深入的研究,以便在低资源少样本条件下,轻量化模型可取得期望的性能。

4 结语

事实上,众多研究证实:虽然低资源少样本语音识别在标注数据获取、高层次语义表征、紧致模型的有效表征训练等方面存在诸多困难,但从少样本学习误差理论分析可知,少样本训练识别仍然可以通过先验信息引入、假设空间约束条件设定等方式优化提升。现有的自监督表示学习、元学习等高级深度学习技术都在低资源少样本语音识别领域展现了优越的性能。未来这些高级深度学习技术的体系化的组合互补策略、克服语言之间的不均衡性以及对深度模型的压缩与轻量化部署等方面都是值得进一步研究的方向。