基于二值网络的自动驾驶目标检测方法

2023-04-29吴岳敏孙圣鑫王小龙马彬程香平

吴岳敏 孙圣鑫 王小龙 马彬 程香平

摘要:针对现有全精度自动驾驶目标检测方法难以在车载计算资源受限平台实时部署等问题,提出了一种基于二值网络的目标检测方法.该方法通过重构残差网络单元和加宽每阶段通道数改进Faster R-CNN主干网络,以增强主干网络特征提取的能力.此外,该方法通过修改卷积核改进特征金字塔网络和区域提议网络,增强表征和预测能力.通过在两种常用目标检测数据集上进行的大量实验表明,该方法能够大幅度减小模型内存,提高检测速度,并取得与全精度模型相近的检测精度.该方法相比于其他先进的二值化目标检测算法,取得了最优秀的检测性能;相比全精度模型,平均参数量减少1.89倍,平均推理速度提高了6.10倍,而检测精度mAP在两数据集上分别仅下降0.2%和2.4%.

关键词:自动驾驶; 目标检测; 二值化; 特征金字塔网络

中图分类号:U461.91文献标志码: A

Automatic driving object detection method based on binary network

WU Yue-min SUN Sheng-xin WANG Xiao-long MA Bin CHENG Xiang-ping(1.School of Electrical and Information Engineering, Hubei University of Automotive Technology, Shiyan 442002, China; 2.Haoteng (Hubei) Intelligent Technology Co., Ltd., Shiyan 442000, China; 3.School of Electronic Information Engineering, Beihang University, Beijing 100191, China; 4.Institute of Applied Physics, Jiangxi Academy of Sciences, Nanchang 330029, China)

Abstract:Aiming at the problem that the existing full precision automatic driving detection methods are difficult to deploy in real time on the platform with limited computing resources,an object detection method based on binary network is proposed.This method improves the backbone network of Faster R-CNN by reconstructing residual network units and widening the number of channels in each stage,so as to enhance the capability of backbone network feature extraction.In addition,this method improves FPN and RPN by modifying the convolution kernel to enhance the representation and prediction capability.Extensive experiments on two target detection datasets show that this method can greatly reduce the model memory,improve the detection speed,and achieve the accuracy similar to the full accuracy model.Compared with other advanced binary target detection algorithms,this method has achieved the best detection performance; Compared with the full accuracy model,the average parameter quantity is reduced by 1.89 times,and the average reasoning speed is increased by 6.10 times,while mAP is only reduced by 0.2% and 2.4% on the two datasets,respectively.

Key words:automatic driving; object detection; binarization; feature pyramid network

0引言

自動驾驶目标检测是当今汽车领域的研究重点之一,主要处理来自车载雷达和视觉检测传感器的观测数据.目前基于车载雷达的检测技术已经相对成熟,但基于视觉检测的检测技术还需进一步研究.随着深度卷积网络的发展,在视觉目标检测领域,已经出现了众多高精度的检测网络,例如一阶段检测算法SSD[1]、YOLO[2]、RetinaNet[3]等,二阶段检测算法Fast R-CNN[4]、Faster R-CNN[5]等.Lin等[6]提出了一个具有自上而下架构、可以实现多维度特征提取的特征金字塔网络(Feature Pyramid Networks,FPN),结合现有检测网络能够显著增强检测网络检测性能.但目前来看,这些检测网络通常拥有数百万的参数,要求数以亿计的浮点数运算,难以有效的在资源受限设备中进行实时应用.

为了实现检测网络有效嵌入资源受限设备的同时保证目标检测网络的推理速度和检测精度,工业界和学术界提出了轻量化网络设计[7]、网络剪枝[8]、低秩分解[9]、量化[10]和知识蒸馏[11]等多种方法.李彦辰等[12]提出一种基于Efficientdet的单阶段目标检测框架来应对自动驾驶计算资源受限和小目标检测精度问题;黄鸿胜[13]研究了基于融合的感兴趣区域特征的蒸馏学习机制,加快了用于自动驾驶的轻量级模型的训练与推理速度;白士磊[14]对改进的YOLOv3网络进行模型剪枝,模型精度下降可接受的情况下,减少模型对硬件资源的消耗,进而保证实时性.量化凭借减少网络参数和激活值的比特宽度,能够实现高效的推理和模型压缩.二值网络是一种极端的量化形式.它将卷积神经网络的权重和激活值压缩到1比特,并使用XNOR位运算和位计数操作代替32比特浮点数的乘法来实现卷积操作,从而节省了大量的内存和计算资源.Rastegar等[15]将激活和权重量化至1比特,取得了较好的性能;Lin等[16]通过增加权重参数来增强检测器的性能.但由于二值化网络的表达能力有限,其模型精度一直远低于全精度模型.

為了降低自动驾驶场景下计算资源的同时满足检测精度的要求,本文选取当前主流的二阶段目标检测方法Faster R-CNN为基准模型,改进了作为主干网络的深度残差网络[17](Deep residual network,ResNet)以及特征金字塔网络FPN与区域提议网络(Region Proposal Network,RPN).本文提出的二值化模型可通过更少的参数实现接近32比特全精度模型的检测精度,并优于其他先进的二值化检测方法,在自动驾驶目标检测领域中具有重要的应用价值.

1算法原理

1.1Faster R-CNN网络框架

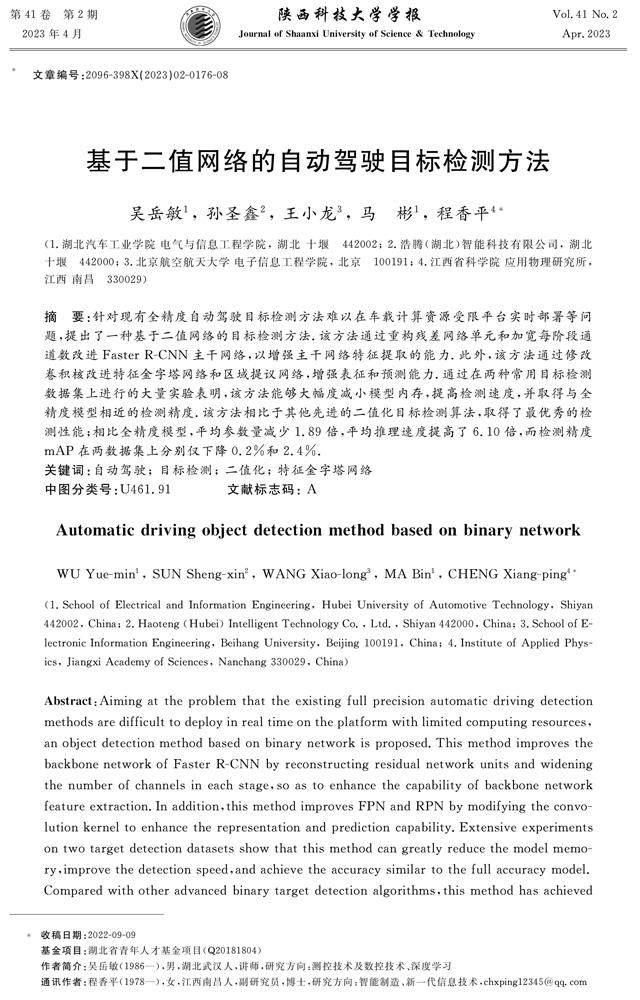

Faster R-CNN的网络结构图如图1所示,可分为特征提取、区域提议网络和Fast-RCNN检测网络三个部分.

1.1.1算法流程

Faster R-CNN摒弃了以往二阶段检测模型[5]中带来巨大的时间成本滑动窗口和selective Search方法,而是通过RPN网络来生成目标区域候选框,极大程度上缩减了待检测目标区域的生成成本,使得二阶段算法时间复杂度大大降低.如图1所示,待检测图像经过预处理后,输入卷积神经网络中进行特征提取,RPN与Fast R-CNN部分共享该特征.本研究将特征图对应的尺寸映射到原图可以得到锚点坐标,再以锚点为中心在原图上设定不同尺寸和比例的候选框,并根据候选框与真实图像的目标边框的交并比(Intersection over Union,IOU)设定正负标签.

RPN网络部分使用3×3卷积对特征进行进一步提取,再将卷积结果分别使用两个1×1卷积分成两条支路,每条支路用通道数对应每个锚点对应候选框的分类概率值与位置坐标数目.然后,Fast R-CNN网络部分滤除不符合要求的候选框,将剩下的候选框按存在目标的概率进行排序,提取前N个提议区域并进行非极大值抑制(Non-Maximum Suppression,NMS),最终筛选出M个感兴趣区域(Regions of interest,ROIs)与共享特征一起输入到ROI池化层.其中,ROI池化层根据特征提取部分的下采样倍数在共享特征上摘取每个ROI所对应的大小不一的特征转换为长度相等的特征向量送入到全连接层.最后利用Softmax函数来计算特征向量对应候选框所包含目标类别,以及利用回归函数精确回归最终检测框的坐标.

Faster R-CNN可以总结为特征提取、目标区域候选框生成和目标位置坐标与种类的概率的计算三个步骤,从而实现端到端训练.

1.1.2损失函数

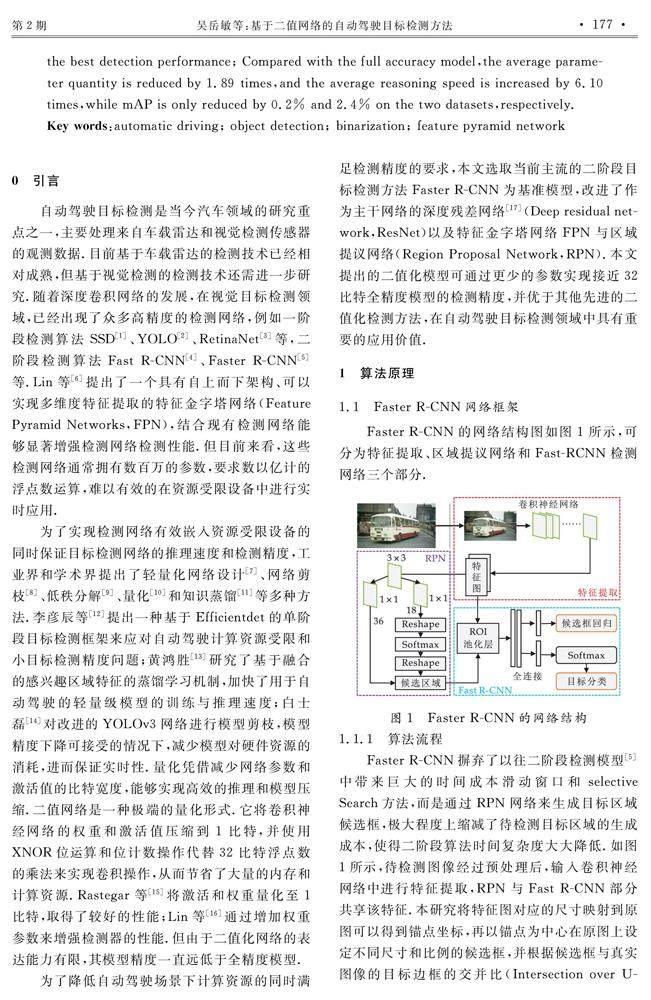

1.2标准1比特卷积神经网络

2二值化目标检测

2.1更宽的主干卷积神经网络

本文选取Faster R-CNN为基准模型,提出了一种二值化自动驾驶目标检测方法.其中,本研究选用了ResNet18作为主干卷积神经网络,其采用了残差网络单元结构,如图3(a)所示.该结构有效的解决了深度网络的深度增加导致模型准确度出现饱和甚至下降的情况,即深度网络的退化问题.

为了提高主干网络提取语义特征的能力,本研究首先将其通道数加宽了一倍,结构对比如表1所示.此外,本研究对残差单元内部的卷积及批归一化操作前后使用了跳跃连接,以降低过拟合的风险,如图3(b)所示的全精度残差网络单元.

为了将设计的全精度残差网络单元进行二值化,本研究首先引入了一种归纳偏置来微调输入特征,然后利用二值化激活函数将全精度激活值输入进行1比特量化.本研究还设计了二值化卷积操作替代传统卷积操作,实现了网络参数的二值化,并利用批归一化操作使训练过程更快更稳定,具体过程如公式(5)所示.然后,本研究再次引入了归纳偏置优化卷积操作的输出,并用非线性激活函数PRelu增强二值神经网络的非线性表征能力.此外,本研究在二值化残差网络单元中额外引入了跳跃连接,与输入的全精度激活值进行累加,增强网络训练的稳定性.本文二值化网络残差单元整体结构如图3(c)所示.

2.21比特FPN 网络

在FPN网络结构出现前,传统目标检测网络在多尺度目标检测任务上依然表现不佳.这是因为以往大多数的目标检测网络只采用了卷积神经网络的顶层特征做预测,尽管高层的特征所包含的语义信息较为丰富,但是定位位置会比较粗略,相反底层特征包含语义信息较少,但定位位置准确.FPN充分利用了不同分辨率层的特征图所含有的多尺度语义信息,使得模型能够检测较大尺度差异的不同目标,大大提升了小目标检测水平.

2.2.1FPN算法流程

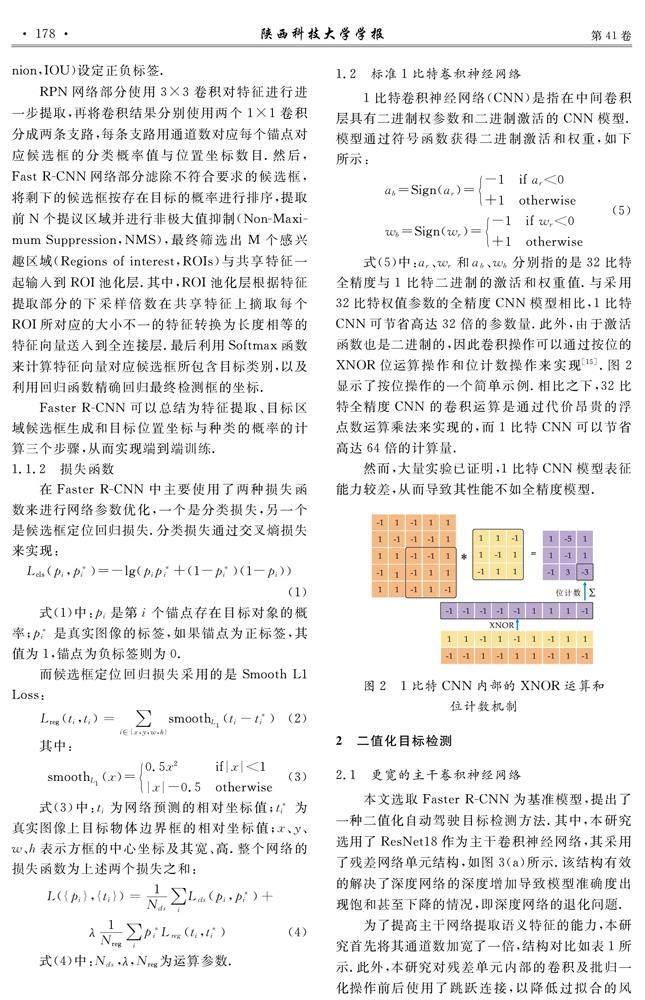

如图4所示,FPN网络结构包含2个部分,分别是一个自底向上的路径,一个自顶向下和横向连接的路径.

自底向上路径对应图4左侧部分,也代表图1中的特征提取部分.对于FPN,本研究定义每个网络阶段为一个金字塔级别,并抽取每个阶段的最后一层来搭建特征金字塔.因为每个阶段的最后一层包含该阶段最丰富的语义信息.自顶向下的路径如图4右侧所示,通过从更高层的金字塔特征进行空间上采样得到语义更强的特征图,从而产生更高分辨率的特征.

简单来说,当给定任意尺寸大小的单张图片作为输入,通过FPN网络,本研究可以得到不同层级上不同大小比例的具有更丰富语义信息的特征图.

2.2.2结合1比特FPN网络的Faster R-CNN

为了增加1比特特征金字塔所包含的语义信息和增强其表征能力,本研究做了两点改进.其一是将自顶向下过程中特征图的通道数加宽一倍,由256调整为512;其二是将横向连接过程中的1×1卷积调整为3×3卷积.

本研究将改进FPN网络分别用在Faster R-CNN的RPN阶段来生成提议框和Fast R-CNN阶段来检测目标,整体框架如图5所示.针对RPN,结合FPN的Faster R-CNN使用FPN代替单尺度顶层特征图来改进RPN.与Faster R-CNN相同,它使用一个相同的头部网络(由3×3卷积和两个1×1卷积支路组成)附加到特征金字塔的每一层.这样本研究就可以得到多尺度特征所对应的特征区域.

此外,传统Faster R-CNN使用ROI池化层将不同尺度的特征区域转换为相同尺度的特征向量,以进行分类预测和边界框回归.但是,ROI池化层中的取整操作会加大特征图的转化偏差.本文使用ROI Align替换ROI池化来减轻其导致的误差.ROI Align是一种区域特征聚集算法,其使用双线性插值算法来确定候选框坐标,而不是简单的取整操作,从而有效提升检测模型的检测性能.

2.3二值化的目标检测网络

本研究将结合改进FPN网络的Faster R-CNN作为最终的目标检测模型.根据前文描述,本研究将其二值化过程分为3个部分,分别是更宽的ResNet18主干神经网络量化、改进FPN网络量化和RPN网络量化.

更宽的ResNet18网络主要由通道数加宽的全精度残差网络单元组成,如图3(b)所示.本研究将其进行二值化,如图3(c)所示.对于网络残差层,输入为32比特全精度x,随后按照公式(5)对x和32比特全精度的卷积神经网络的权重wr进行1比特量化得到1比特激活ab和1比特权重wb.

对于改进FPN网络的量化,同样可分为自底向上和自顶向下与横向连接两条路径.自底向上的过程也就是主干网络的量化过程,详见2.3节.自顶向下的过程中,本研究对来自更高层的二值化特征进行上采样.同时,本研究将横向连接过程中用到的32比特全精度3×3卷积按照公式(5)量化为1比特3×3卷积来调整本层金字塔特征通道数.之后再将其与来自更高层上采样后的二值化特征合并,最终得到不同比例大小的特征映射.

RPN网络的作用是对FPN网络得到的候选框进行初步筛选和坐标微调,这里本研究将RPN网络用到的32比特全精度3×3卷积和两路1×1卷积都调整并量化为1比特3×3卷积.随后的Reshape操作与Softmax函数遵循32比特全精度网络模型的做法.

Fast R-CNN预测分类类别和边界框坐标回归所用到的全连接层保留全精度模型的权重和激活.

2.4训练及推理过程

本研究的目标监测网络在训练时的前向传播与梯度反传过程依旧保持32比特全精度的权重与激活,并使用连续优化方式即随机梯度下降法(Stochastic Gradient Descent,SGD)来训练网络.其中主干卷积神经网络使用的是在ImageNet大型数据集上预训练好的ResNet18网络模型,激活函数使用的是PRelu非线性函数.损失函数与32比特全精度模型一致,按照公式(4)计算.推理过程中,本研究按照2.1及2.2节所描述流程对32比特全精度Faster R-CNN+FPN网络进行二值化,利用该1比特二值化模型进行推理.

3实验与分析

本文在公开数据集PASCAL VOC[18]和COCO[19]上进行了全面且充足的实验,来验证本文提出的基于二值网络的自动驾驶目标检测方法的性能.此外,本研究在自动驾驶场景数据集KITTI[20]上进行了检测结果的可视化,进一步验证了本文方法在自动驾驶场景的有效性.

3.1数据集介绍

PASCAL VOC数据集共有20个类别的目标,包含行人、自行车、摩托车、公交车、轿车等自动驾驶场景下常见的目标类型.遵循其他检测算法的做法,本研究在PASCAL VOC2007 trainval和PASCAL VOC2012 trainval上训练模型,在VOC test2007进行测试.训练集大概含有16 k张图片,测试集含有4 952张图片.

COCO数据集共有80个种类的目標,包含行人、自行车、摩托车、轿车、卡车、公交车、交通信号灯、停车标志、停车计时器等自动驾驶场景下常见的目标类型.本研究的训练集由80 k张COCO train2014的图像与35 k张从COCO val采样的图像(即COCO trainval35 k)组成,测试集为COCO minival里的5 k张图片.

KITTI数据集包含市区、乡村和高速公路等真实的交通场景采集的图像数据,是目前国际上最通用的自动驾驶场景算法评测数据集之一.

3.2实验结果

遵循LWS-Det[21]检测算法的做法,本研究使用均值平均精度(mean Average Precision,mAP)作为目标检测性能评测指标,使用参数量(Parameters)和浮点运算次数FLOPs(Floating Point of Operations)作为基于二值网络的检测算法内存量和计算量的评测指标.

3.2.1檢测性能分析

本研究首先在通用数据集PASCAL VOC验证本文方法的有效性,并与其他先进的基于二值网络的目标检测算法进行比较,实验结果如表2所示,其中所有方法都以Faster-RCNN模型为基础模型,其主干网络均为ResNet-18,W/A(bit)表示权重和激活函数的比特位数.结果表明,与其他先进的二值化目标检测算法相比,本文方法取得了十分显著的检测性能提升,在mAP指标上比第二名的LWS-Det方法提升了3.0%.实验表明了本文方法能够在减小计算量和参数量的同时,取得更好的检测性能.即便与全精度目标检测网络相比,本文方法几乎没有检测性能上的损失,在mAP指标上仅降低了0.2%.

本研究还在含有大量自动驾驶相关场景的COCO数据集上做了充足的实验以进一步验证本文方法的有效性,并与其他先进的基于二值网络的目标检测算法进行比较,实验结果如表3所示,其中所有方法都以ResNet-18为主干网络.与PASCAL VOC数据集上的结果类似,本文方法取得了优于其他先进的二值检测算法的表现,在mAP指标上比第二名的LWS-Det方法提升了2.9%,同时超越了4比特FQN检测方法1.7%的mAP.

总的来说,相比于其他先进的二值目标检测算法,本文方法在基于二值网络的目标检测任务上取得了最优的性能.本文方法还达到了接近于全精度目标检测算法的性能,充分证明了本文方法的有效性.

3.2.2参数量与计算量分析

参数量对比结果如表4所示,本研究对目标检测网络的每个部分都进行了单独统计.表4表明了本文方法相比于全精度的目标检测算法,参数量节省了1.89倍.值得注意的是,因为检测头部多为全连接部分,而全连接层并没有进行二值化,仅量化了其中的卷积部分,所以该部分参数量相对于全精度网络并没有明显的减少.

类似地,在计算量方面,本研究同样分别对比了网络的各个模块的计算量,结果如表5所示.表5表明了本研究的方法相比于全精度的目标检测算法,计算量大大减少,速度提升了6.10倍.值得注意的是,检测头部虽然参数量降低程度不大,但由于卷积网络的参数共享的特性,其能够用更少的参数完成更多的计算量,所以量化后头部网络的计算量有了十分明显的下降.

综上所述,相比于全精度网络,本文方法很大程度上降低了检测算法的参数量与计算量,同时保证了优秀的检测性能.

3.2.3自动驾驶场景目标检测可视化

目前,基于COCO数据训练的全精度Faster-RCNN模型已能满足实际目标检测需求,而本研究提出的二值化检测模型在大大提高模型效率的基础上,仅有极小的性能损失,因此同样满足于自动驾驶场景下的目标检测要求.为了更直白地表明本算法的实用性,本研究在KITTI测试集上进行测试并可视化,结果如图6所示.从图6中可以看出,在自动驾驶场景中,很多场景包含密集目标,且存在着大量的小目标,例如远处的车辆、行人和自行车等,这对目标检测算法是一个极大的挑战.

图6中的检测结果表明,本文方法在自动驾驶场景目标检测中,对密集场景以及多尺度目标,都取得了优秀的检测效果.因此,本文提出的基于二值网络的目标检测算法能够在大大减小现有目标检测算法参数量和计算量的基础上,同时保证在自动驾驶场景下有着优秀的目标检测性能.

4结论

为了实现高效且准确的自动驾驶目标检测,本文提出了一种基于二值网络的目标检测方法.具体地,本研究基于现有Faster-RCNN目标检测框架,二值化改进更宽的ResNet18主干网络,并设计了一种二值化的FPN特征金字塔网络.相比于全精度模型,本文提出的检测模型平均参数量减少1.89倍,平均推理速度提高了6.10倍,并且同时保持了接近全精度模型的检测性能,这对目标检测算法在自动驾驶场景下的应用有着十分重要的意义.此外,通过大量的实验表明,相比于其他先进的基于二值网络的目标检测方法,本文提出的1比特方法取得了最优秀的目标检测性能,甚至优于4比特的目标检测算法.因此,本文方法对自动驾驶目标检测算法的部署有着极为重要的实用价值及研究意义.

参考文献

[1] Yi J,Wu P,Metaxas D N .ASSD:Attentive single shot multibox detector[J].Computer Vision and Image Understanding,2019,189(1):102 827.

[2] Sun Z,Leng X,Lei Y,et al.BiFA-YOLO:A novel YOLO-based method for arbitrary-oriented ship detection in high-resolution SAR images[J].Remote Sensing,2021,13(21):4 209.

[3] 刘洁瑜,赵彤,刘敏.基于RetinaNet的SAR图像舰船目标检测[J].湖南大学学报(自然科学版),2020,47(2):85-91.

[4] Arora N,Kumar Y,Karkra R,et al.Automatic vehicle detection system in different environment conditions using fast R-CNN[J].Multimedia Tools and Applications,2022,81(13):18 715-18 735.

[5] Rens Q,He K,Girshick R,et al.Faster R-CNN:Towards real-time object detection with region proposal networks[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2017,39(6):1 137-1 149.

[6] Lin T,Dollar P,Girshick R,et al.Feature pyramid networks for object detection[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.Hawaii:IEEE,2017:2 117-2 125.

[7] 丁瑞敏,田軍委,刘雪松,等.轻量化卷积神经网络目标检测算法研究[J].西安工业大学学报,2022,42(2):188-194.

[8] 孙文宇,曹健,李普,等.基于全局信息的卷积神经网络模型剪枝微调优化方法[J].北京大学学报(自然科学版),2021,57(4):790-794.

[9] Lin S,Ji R,Chen C,et al.Holistic CNN compression via low-rank decomposition with knowledge transfer[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2019,41(12):2 889-2 905.

[10] 冯鹏程,禹龙,田生伟,等.基于均方误差的8位深度神经网络量化[J].计算机工程与设计,2022,43(5):1 258-1 264.

[11] 褚晶辉,史李栋,井佩光,等.适用于目标检测的上下文感知知识蒸馏网络[J].浙江大学学报(工学版),2022,56(3):503-509.

[12] 李彦辰,张小俊,张明路,等.基于改进Efficientdet的自动驾驶场景目标检测[J].计算机工程与应用,2022,58(6):183-191.

[13] 黄鸿胜.自动驾驶场景下的车辆检测技术研究[D].广州:广东工业大学,2018.

[14] 白士磊.基于深度学习的交通标志检测与识别算法研究[D].长春:长春工业大学,2020.

[15] Rastegari M,Ordonez V,Redmon J,et al.Xnor-net:Imagenet classification using binary convolutional neural networks[C]//European Conference on Computer Vision.Amsterdam:Springer,2016:525-542.

[16] Lin X,Zhao C,Pan W.Towards accurate binary convolutional neural net work[C]//Proceedings of the 31st International Conference on Neural Information Processing Systems.Long Beach:NeurIPS,2017:344-352.

[17] 王海燕,张渺,刘虎林,等.基于改进的ResNet网络的中餐图像识别方法[J].陕西科技大学学报,2022,40(1):154-160.

[18] Everingham M,Eslami S M,Van Gool L,et al.The pascal visual object classes challenge:A retrospective[J].International Journal of Computer Vision,2015,111(1):98-136.

[19] Lin T Y,Maire M,Belongie S,et al.Microsoft coco:Common objects in context[C]//European Conference on Computer Vision.Zurich:Springer,2014:740-755.

[20] Wang X,Zhang H.Deep monocular visual odometry for ground vehicle[J].IEEE Access,2020,8:175 220-175 229.

[21] Xu S,Zhao J,Lu J,et al.Layer-wise searching for 1-bit detectors[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition.Virtual:IEEE,2021:5 682-5 691.

[22] Liu Z,Luo W,Wu B,et al.Bi-real net:Binarizing deep network towards real-network performance[J].International Journal of Computer Vision,2020,128(1):202-219.

[23] Wang Z,Wu Z,Lu J,et al.Bidet:An efficient binarized object detector[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition.Seattle:IEEE,2020:2 046-2 055.

[24] Liu Z,Shen Z,Savvides M,et al.ReActNet:Towards precise binary neural network with generalized activation functions[C]//European Conference on Computer Vision.Glasgow:Springer,2020:143-159.

[25] Li R,Wang Y,Liang F,et al.Fully quantized network for object detection[C]//Computer Vision and Pattern Recognition.Long Beach:IEEE,2019:2 810-2 819.

【责任编辑:陈佳】