基于Q学习的多无人机协同航迹规划方法

2023-03-21尹依伊王晓芳周健

尹依伊, 王晓芳, 周健

(1.北京理工大学 宇航学院, 北京 100081; 2.北京电子工程总体研究所, 北京 100854;3.西安现代控制技术研究所, 陕西 西安 710065)

0 引言

多飞行器协同作战是未来空战的重要发展趋势,与单飞行器相比,多飞行器具有更高的作战效能以及更强的作战能力[1]。在多飞行器协同飞行过程中,航迹规划技术可为飞行器提供航迹指引,是实现飞行器协同作战的关键技术之一[2-4]。协同航迹规划可得到满足飞行器性能约束及时间协同约束的最优航迹,是多飞行器实现自主飞行的重要保障[5]。好的航迹不仅能节省飞行器运行的成本,也增加了完成攻击任务的成功率[6]。

针对协同航迹规划问题,国内外学者进行了较多研究。文献[7]提出了一种在混合卫星导航覆盖场景中的多无人机路径规划方法,使各无人机能够在同一空间内共存且彼此不发生碰撞,仿真结果表明无人机数量增多对计算负担几乎无影响。文献[8]提出了带距离因子的改进势场法,此算法能够在三维环境下控制多无人机避开障碍物,到达期望位置。文献[9]建立了一种基于无向图搜索方法的覆盖路径优化模型,并通过混合整数线性规划方法求解各无人机的最优飞行路径。文献[10]提出飞行无人机能量因子概念,并基于遗传算法设计了一种用于多无人机的能量平衡路径规划算法,以使多无人机协同完成搜索和救援任务。文献[11]针对现有路径规划方法忽略侦察区域优先级的问题,将侦察区域、人机能耗和飞行风险值加权作为多目标效能函数,基于粒子群优化算法求解多无人机的最优协同侦察路径。但上述文献均未对时间协同问题进行考虑。文献[12]利用羊群算法求解满足时间协同与空间协同的航迹组,但此算法仅适用于环境模型已知的路径规划问题,当环境发生突变时需要重新进行求解。文献[13]考虑到固定和移动目标、外部干扰等情况,使用粒子群优化算法求解得到避免碰撞的最佳路径。

随着人工智能领域的发展,强化学习技术也被应用于多智能体协同航迹规划中。文献[14]针对追捕问题,提出了一种基于共享经验的Q学习航迹规划算法,此算法具有收敛速度快的优点。文献[15]考虑了飞行时间和碰撞避免约束,基于深度强化学习理论设计了在没有密集无线信道特性先验知识情况下的协同航迹规划方法,但此算法所需求解时间较长,不适用于在线应用的场景。文献[16]提出了一种联合动作- 状态法,与环境交互时各智能体采取联合状态与联合动作,此方法有效减少了探索次数,但存在维度爆炸的问题。文献[17]提出了一种基于多智能体深度确定性策略梯度算法,通过同步目标分配和路径规划,避免重分配带来的重规划问题,提高了路径规划效率,但此算法所需训练时间较长。文献[18]基于改进的深度Q学习(DQN)算法解决多机器人路径规划问题,与传统DQN算法相比具有更快的收敛速率,但此方法也存在求解时间较长的问题。

本文首先建立了航迹规划问题的马尔可夫模型,基于Q学习理论设计了单飞行器的航迹规划算法,针对多飞行器航迹规划的时间协同问题,根据Q学习理论的特点,将单飞行器航迹规划的经验矩阵拓展到多飞行器围捕目标的协同航迹规划中,设计了满足时间协同约束的多飞行器航迹规划方法。然后针对飞行器间碰撞避免问题,通过设计后退参数并基于深度强化学习法设计了碰撞段局部航迹重规划方法,实现了多飞行器间的避碰目标。考虑航迹规划问题的在线应用问题,针对环境中存在先前未探明障碍物的情况,设计障碍物Q矩阵,通过将障碍物矩阵与原经验矩阵叠加的方法,使飞行器能够在线躲避新探测到的障碍物。最后进行了多飞行器协同航迹规划的仿真,证明了所述算法的正确性与有效性。

1 基于Q学习的单无人机航迹规划方法

1.1 航迹规划问题马尔可夫建模

将无人机航迹规划的Q学习问题建模为马尔可夫决策过程,依次对环境、状态S、动作A、回报R及策略进行如下定义。

1.1.1 环境模型描述

采用栅格法对环境进行离散化处理,假设无人机匀速飞行,且飞行速度为v,法向加速度幅值为azmax,则其最小转弯半径Rm为

(1)

为了使规划的航迹具有可飞性,即无人机能够在相邻栅格内实现连续转弯运动,因此需满足栅格边长l大于最小转弯半径的4倍(l≥4Rm)。在考虑无人机机动能力的前提下,考虑到环境建模的精确性,取l=4Rm。假设作战空间长度为L、宽度为W,则离散化处理后栅格子空间个数N为

N=L4Rm∗W4Rm

(2)

式中:「⎤表示向上取整。因此,离散化处理后的战场区域可能略大于实际作战区域。

无人机从初始位置向位于期望位置的目标飞行,环境建模示意图如图1所示。图1中,红色区域为期望位置,黑色区域为障碍禁行区域,蓝色区域为无人机的初始位置,局部放大区域为栅格边长与最小转弯半径的关系示意图。

图1 战场模型示意图Fig.1 Diagram of battlefield model

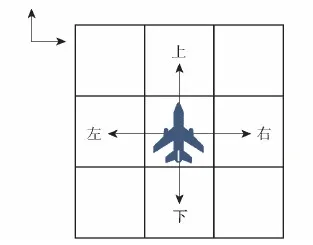

1.1.2 状态空间、动作空间设计

针对航迹规划问题,将状态S与无人机位置建立联系,当环境模型如图1所示时,作战空间被划分为144个栅格,依次对栅格进行标号,将无人机视为质点,无人机所处栅格作为无人机状态。如图2所示,无人机离散化后的动作空间选取为向上、向下、向左和向右4个飞行方向。

图2 动作空间示意图Fig.2 Diagram of action space

当无人机执行所选动作后,其状态转移到对应相邻状态,实现动作状态的转移,因此,Q学习满足马尔可夫性质,即下一时刻状态只与当前状态有关,与之前状态无关。

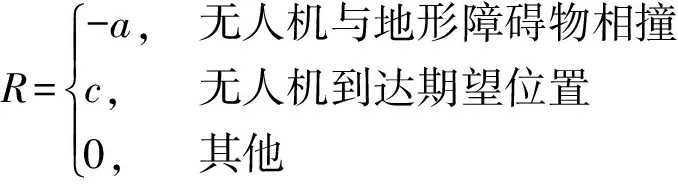

1.1.3 回报函数设计

针对单无人机的航迹规划问题,本文设计回报函数为

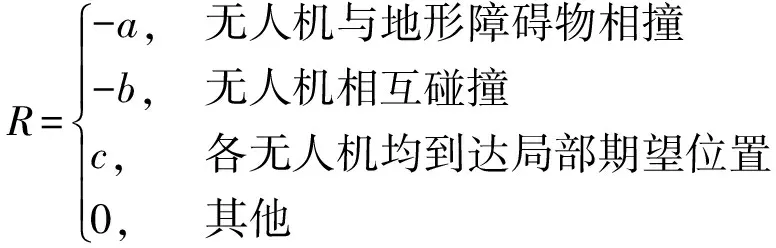

(3)

式中:a、c为大于0的常数。回报函数体现了对无人机向期望位置飞行的牵引作用和对障碍的回避作用。

1.1.4 动作选择策略设计

训练过程中,本文采用ε-贪婪策略进行动作选择,通过引入随机变量ε∈(0,1),每次以概率ε进行探索,以概率1-ε进行利用,即每次在选择动作时都生成随机数randt,动作的选择策略满足

(4)

式中:St、At分别为t时刻智能体所处位置与所执行动作;A为动作空间;Qt(·)为t时刻执行动作后转移到新状态的Q值;A(R>0)表示执行动作后即时回报大于0的动作集合。

1.1.5Q值更新方式定义

根据Q学习算法的定义,经验矩阵中Q值更新规则满足

(5)

式中:α∈(0,1)为学习效率,影响学习收敛的快慢;γ∈(0,1)为衰减值,某两个状态相隔的时间越长,则后一状态对前一状态的影响越小。

1.2 基于Q学习的航迹规划方法

基于Q学习的单无人机航迹规划方法按照以下步骤进行。

步骤1初始化环境、无人机的初始位置与期望位置,初始化经验矩阵Qtable、学习效率α,衰减值γ,最大迭代步数tmax,最大幕数episodemax,ε-贪婪策略参数ε。

步骤2初始化无人机的初始位置为当前状态。

步骤3生成随机数randt,判断randt是否大于ε,是则选择当前状态下Q值最大的动作执行,否则随机选择动作执行。

步骤4执行动作后无人机转移到新的状态,根据式(3)计算即时回报,根据式(5)对经验矩阵Qtable进行更新。

步骤5判断无人机是否到达期望位置或达到最大迭代步数tmax,若未到达且当前步数小于最大迭代步数,则令新的状态为当前状态并返回步骤3,否则执行步骤6。

步骤6判断是否到达最大幕数episodemax,若未到达则返回步骤2,否则终止计算并输出Qtable。

当已训练得到完备的经验矩阵Qtable后,此Qtable表示了在每个状态下无人机采用4个动作的优劣性,Q值越大的动作越快趋向目标。因此,可直接基于此Q-table获得无人机从任一起始点出发到达目标位置的最优航迹。为保证航迹的最优性,在基于训练后的Q-table选择动作时采用贪婪策略。

2 基于Q学习的多无人机协同航迹规划方法

2.1 考虑时间协同的协同航迹规划算法

基于1.2节可得到能够避免障碍物且航迹最短的单无人机航迹。对于实现围捕目标目的的多无人机协同航迹规划问题,其在单无人机航迹规划的基础上,增加了各无人机飞行时间相等的约束。

假设对N架无人机进行协同航迹规划,由于本文中无人机的速度为常值且相等,飞行时间相同问题就转化为多无人机航迹长度相等的问题。根据第1节内容,可分别获得各无人机到期望位置的最优航迹长度P1,P2,…,PN,考虑协同航程Pc的最优性与可行性,选择最长的航迹长度作为协同航程,即

Pc=max (P1,P2,…,PN)

(6)

对于航迹长度小于Pc的无人机,需要对其航迹进行扩展,即无人机需要绕飞。对于无人机i,在飞行过程中的动作选取策略调整为

(7)

Pi=Pi0t+Pite,i=1,2,…,N

(8)

式中:Pi0t为无人机飞到当前位置经过的航迹;Pite为从t+1步起,在当前状态下根据经验矩阵Qtable选择最优航迹到达目标所需航迹长度。由于每个状态Q值最大的动作对应的航迹是长度最短的航迹,需要绕飞时就不能选取Q值最大的动作,而是在其他可行动作中随机选取。

假设针对同一环境下单无人机的航迹规划经验矩阵已训练完毕,则满足时间协同的多无人机航迹规划求解步骤如下:

步骤1初始化各无人机的初始位置、期望位置、当前状态,根据当前状态,按照式(6)选择航迹长度最长的作为协同航迹Pc。

步骤2根据当前状态,按照已训练好的经验矩阵Qtable,计算各无人机到达期望位置的航迹长度Pi(i=1,2,…,N)。

步骤3判断各无人机航迹长度Pi是否与Pc相等,若相等则执行步骤4,否则各无人机按照式(7)进行动作选择,返回步骤2,重新计算各无人机到达期望位置的航迹长度。

步骤4各无人机根据贪婪算法选择动作执行,并进行状态转移,执行步骤5。

步骤5判断各无人机是否到达期望位置,若未到达则返回步骤4,否则终止计算,并输出各无人机的协同航迹。

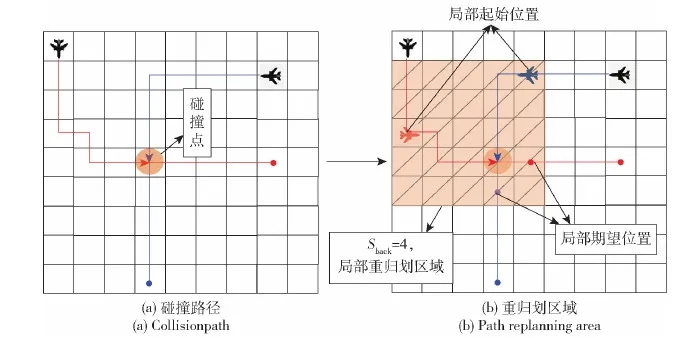

2.2 碰撞避免策略设计

多无人机按照2.1节规划的航迹飞行时可能发生碰撞,因此需要在2.1节算法中加入碰撞检测模块,并针对发生碰撞的航迹进行局部重规划,其余未发生碰撞的航迹保持不变。本文设置从发生碰撞时刻的前Sback步开始进行局部重规划,并将该时刻所处状态作为局部重规划的初始位置,将原航迹组中碰撞结束后的下一时刻状态作为无人机局部重规划的期望位置。局部环境的选取如图3所示。

图3 多无人机局部航迹重规划Fig.3 Partial path replanning for multiple UAVs

图3中,两无人机基于2.1节算法得到的航迹存在碰撞点(见图3(a)),因此需要对局部航迹进行重规划。若令后退参数Sback=4,则图3右图中红色无人机和蓝色无人机分别为红色航迹和蓝色航迹无人机从碰撞点后退4步后的位置。作为两个无人机局部重规划的初始位置,红色圆点和蓝色圆点分别为发生碰撞后两个无人机的下一个非碰撞状态,作为两无人机的期望位置,将包含上述初始位置、期望位置的矩形区域作为局部重规划区域。需要注意的是,在局部规划时,通常在某个状态会有大于1个的最优动作,为了不改变重规划前航迹的长度,应选择重规划路径长度为4的动作。若没有这种动作,则重规划后的航迹长度变化,可增大后退参数取值,在更大范围内寻找协同路径。

定义局部重规划区域的回报函数为

(9)

式中:a、b、c为大于0的常数,-a引导无人机避开障碍物,-b引导无人机避免相互碰撞,c引导无人机向期望位置飞行。

为避免随着无人机个数增多导致状态、动作空间指数级上升,本文使用DQN方法对局部碰撞区域进行重规划,通过构建神经网络模拟Q-table输出,从而解决Q-table维数过高、收敛难度大的问题。DQN算法以神经网络作为载体,通过神经网络的输出值模拟Q-table输出的Q值,可表示为

f(S,A,w)=Q*(S,A)

(10)

式中:S为无人机状态;A为所选动作;w为神经网络的权重参数;Q*(S,A)为S状态下执行A动作的Q值。

由于采用多无人机进行协同航迹规划,输入项为多架无人机的动作与状态,输出为各无人机执行相应动作的联合Q值。若局部空间有Na架无人机发生碰撞,每架无人机有上、下、左、右4个可选动作,则神经网络模型如图4所示。

图4 局部重规划的神经网络模型Fig.4 Neural network model of partial path replanning

图4中,神经网络有3Na个输入,分别为Na架无人机的x轴坐标(栅格编号)、y轴坐标及所选动作,输出为神经网络模拟经验矩阵的Q值。

为使神经网络应用在Q学习算法中保持稳定,建立双层网络结构,包括训练网络Qnet(St+1,a,w)与目标网络Qtarget(St+1,a,w-),两个网络的结构相同、参数不同,w-为Qnet中网络参数w的延迟更新值。其中,训练网络Qnet用于选择动作,更新模型参数,目标网络Qtarget用于计算目标Q值。Q值计算公式为

(11)

式中:R为式(9)所示联合动作的即时回报;γ∈(0,1)为衰减值;Q为训练网络Qnet(St+1,a,w)的期望输出。

为实现神经网络对Q-table的拟合,根据期望输出与实际输出求解损失函数值,进而对网络Qnet进行更新,损失函数[19]的求解公式为

(12)

每间隔一段时间,拷贝Qnet到Qtarget,进而降低目标Q值和当前的Q值相关性。

当训练达到局部重规划的最大训练幕数时,网络训练终止。各飞行器从局部初始位置开始,采用Qnet计算不同状态、动作下的Q值,选择Q值最大的动作执行,直至各飞行器到达期望位置,即可获得局部重规划的路径。需要说明的是,如果局部调整范围选得大,则需要重新规划的航迹长度较长,求解速度就会比较低;如果局部范围选得小,则可调整的范围较小,可能无法找到成功避免碰撞的航迹组,因此需根据战场情况合理设置局部区域的大小。

2.3 存在突然发现的障碍物的规划方法设计

无人机实际作战时的战场情况与离线训练时的战场情况存在差异,可能实际战场中的某些障碍物事先并未被探明,但无人机在实际飞行时必须要躲避此未知障碍物。实际作战时,无人机的探测范围是有限的,不妨设障碍物位于Lob×Lob的栅格区域中心,当无人机进入此区域时,可探测到位于区域中心的障碍物,障碍物区域如图5所示(见图中Lob=5)。

图5 未探明障碍物区域Fig.5 Unexplored obstacle area

参考人工势场理论思想,当无人机距离障碍物越近时其所受斥力越大,无人机趋于远离障碍物的方向飞行。在Q学习理论中,经验矩阵Qtable也反映了无人机趋向目标的快慢程度,在同一状态下Q值越大的动作到达目标所需步数越少。因此,当目标位于栅格区域的中心时,Q值越大则“引力”越大,越快趋向目标,当障碍物位于栅格区域的中心时,可在原有“引力”基础上取负值,表示无人机所受“斥力”,Q值越小则需越快远离目标。

针对图5的障碍物区域,将障碍物位置设为目标,由于Q-table具有全局性,随机选取区域内一点作为无人机初始位置,并采用第1节方法得到障碍物区域内已收敛的经验矩阵Q1。当区域中心位置为障碍物时,障碍物区域产生斥力,因此令障碍物模型的Q-table求解公式为

Qobstacle=-kobQ1

(13)

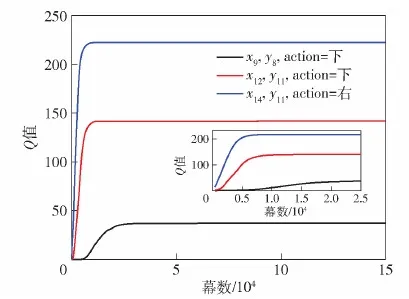

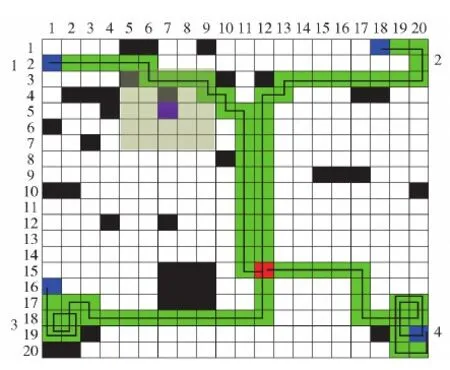

式中:kob为缩放系数,0 当无人机飞行过程中发现未探明障碍物时,在原有环境模型中叠加障碍物后的模型,如图6所示。 图6 叠加未探明障碍物后的战场模型Fig.6 Battlefield model with unexplored obstacle 图6中,浅绿色区域为未探明障碍物区域,区域中间紫色方格为障碍物所在位置,当无人机飞入浅绿色区域内时,即可探测到障碍物,此时经验矩阵将在原有Q-table中的对应状态及动作上叠加障碍物矩阵Qobstacle中的Q值,即 Qnew(S,A)=Q(S,A)+Qobstacle(S′,A) (14) 式中:Qnew(S,A)为叠加障碍物矩阵后的Q值;S′为状态S在局部区域内相对应的状态。 综合考虑时间协同、避撞、存在未探明障碍物的情况,多无人机协同航迹规划步骤如下。 步骤1初始化各无人机的初始位置、期望位置、环境,根据当前状态按照式(6)选择航迹长度最长的作为协同航迹Pc,执行步骤2。 步骤2根据Qtable计算各无人机到达期望位置的航迹长度Pi(i=1,2,…,N)。 步骤3判断各无人机航迹长度Pi是否与Pc相等,若相等则按照贪婪策略选择动作,否则各无人机按照式(7)进行动作选择,转移到新的状态,执行步骤4。 步骤4判断各无人机是否到达期望位置,若到达则执行步骤6,否则执行步骤5。 步骤5判断各无人机是否发现先前未探明的障碍物,若是则在Q-table基础上叠加未探明障碍物矩阵并返回步骤2,否则直接返回步骤2。 步骤6判断各无人机是否存在碰撞,若是则对局部区域进行重规划,否则执行步骤7。 步骤7输出满足时间协同与碰撞避免的协同航迹组。 假设有4架性能相同的无人机,无人机速度v=100 m/s,最大法向加速度azmax=20 m/s2,则最小转弯半径Rm=500 m。战场环境为L×W=40 000 m×40 000 m的正方形区域,根据式(2)可得N=400,因此本文仿真算例将战场离散化为20×20的栅格区域,行和列的编号从上至下、从左至右依次是1~20,(x,y)表示所在的行和列。为了使战场栅格位置与经验矩阵Qtable的状态对应,将400个战场栅格从左至右、从上至下依次编号为状态1~400。单无人机的初始位置为(2,2),期望位置为(15,12)。Q学习算法模型的参数设计为学习效率α=0.01,衰减值γ=0.8,最大迭代步数tmax=800,最大幕数episodemax=150 000,ε-贪婪策略参数ε=0.2。回报函数的设置为 进一步设置障碍物,得到战场示意图如图7所示。 图7 仿真算例战场模型Fig.7 A simulation example of battlefield model 按照1.2节训练步骤对此模型进行训练,训练后得到完备的经验矩阵Qtable。以位置坐标分别为(8,9)、(12,11)动作为“下”的对应Q值Q168,2、Q231,2,以及位置坐标为(14,11)动作为“右”的对应Q值Q271,4为例,图8显示了3个Q值随幕数增大的取值变化曲线。 图8 部分Q值变化曲线Fig.8 Part of Q value variation curves 由图8中可见,3个状态、动作对应的Q值均收敛到稳定值,但不同位置Q值收敛速度不同,Q271,4在7 250幕收敛,Q231,2在13 321幕收敛,Q168,2在39 623幕收敛。根据Q值迭代公式(式(11))可知,通常离期望位置近的状态收敛得快,因为Q值的更新依赖于下一时刻的状态,下一时刻状态收敛后当前状态才可收敛,而离期望位置远的状态由于前期探索次数较少,往往收敛得较慢。因此,Q271,4收敛最快,Q168,2收敛最慢,而Q231,2介于二者之间。通过对多个局部Q值进行验证可知,经过50 000幕训练后Q-table已全局收敛,即已得到完备的经验矩阵,可用于求解协同航迹,所需训练时间为1 283.442 s。 假设各无人机初始位置和期望位置所对应的栅格编号如表1所示。为实现各无人机对目标的围捕,期望位置设为(15,12)。 表1 无人机相关参数Table 1 Parameters of UAVs 禁飞区定义与图7一致。根据2.1节满足时间协同的协同航迹解算方法,得到步数相等的协同航迹如图9、图10所示。需要说明的是,根据训练得到的Q-table得到无人机1、2、3、4的最优航迹步数分别为24、20、14和12,因此选择24为协同航程;由于存在Q值相同的最优动作,在选取动作时从最优动作中随机选取,会出现满足最短协同航程的多组最优航迹,本文算例仅列出两种满足时间协同的协同航迹。 图9 满足时间协同的协同航迹1Fig.9 Time-coordinated path 1 图10 满足时间协同的协同航迹2Fig.10 Time-coordinated path 2 图9和图10中各无人机都能以最短协同航程24步到达期望位置。由于无人机2、3、4到达目标所需的最短航迹小于24步,通过绕行的方式实现时间协同,其中无人机3、4离目标距离较近,因此需要进行较长时间的绕行后再向目标飞行。但由于在动作选择策略中设定了选取非最优动作时尽量和上一步的动作相同,图9和图10中的绕行轨迹在一定程度上相对平直。从图9和图10中可见,虽然各无人机能够以相同的协同航程到达目标,但是由于未考虑无人机的碰撞避免问题,无人机1、2发生碰撞。 A*算法是一种典型的启发式搜索算法,可在有效时间内搜索到满足要求的可行航迹,近年来也被应用于协同航迹规划问题,此处给出采用文献[20]中的A*算法对本仿真算例进行时间协同航迹规划问题求解的结果,如图11所示。 图11 基于A*算法的协同航迹Fig.11 Time-coordinated paths based on A* algorithm 由图11中可见,A*算法虽然实现了时间协同,但是与Q学习算法相比,局部碰撞区域增大,处理难度增加,这是因为在Q学习算法中,步数少的无人机在开始飞行的动作选择初期选择非最优动作实现绕行直至期望步数与协同航程相同,因此无人机在初始位置附近盘旋,当满足协同航程约束时朝目标飞行,而A*算法需要综合考虑代价函数中趋于目标与趋于时间协同的两方面因素,无法对绕行时刻进行约束,导致无人机在接近目标时仍处在绕行阶段,由于各无人机的期望位置相同,碰撞概率增大。 基于A*算法和基于本文Q学习算法的协同航迹规划方法在计算耗时上有较大的差别。基于A*的方法由于在过程中要进行不断的搜索,而且搜索空间随搜索维度呈指数级增长,耗时较长。相比而言,本文基于Q学习的方法仅需根据离线训练好的Q-table按照预设的策略寻找轨迹即可,因此求解速率较快。分别进行5次仿真,A*算法与Q学习算法协同航迹规划所需时间如表2所示。仿真结果表明,Q学习算法在求解协同航迹规划问题时耗时较短,求解效率更高,平均提高63.8%。 表2 Q学习算法与A*算法性能对比Table 2 Performance comparison between the Q-learning and A* algorithms 当飞行器间存在碰撞或考虑战场环境中事先未探明障碍物时,A*算法都需要根据当前场景进行重新规划,例如战场中有未探明障碍物时,需要在新的战场环境下从目前点到终点重新进行规划计算,相对本文中叠加Q表的方法,将花费更多的时间。因此,以下不再进行两种算法的对比。 对图9中无人机3、4进行局部重规划,局部区域有两架无人机发生碰撞,令Sback=5,Na=2。从碰撞点后退5步后的位置,作为两个无人机局部重规划的初始位置,由于两无人机的期望位置相同,设到达期望位置前一时刻的非碰撞位置作为局部期望位置,得到6×3的局部重规划区域如图12所示。 图12 局部重规划区域Fig.12 Partial path replanning area 图12中蓝色区域为两个无人机的初始位置,红色区域为期望位置,根据局部区域的新编号,得到局部区域内的无人机初始位置、终点期望位置如表3所示。 表3 局部区域无人机3、4的初始位置、期望位置Table 3 Starting position and expected position of UAV 3 and 4 in the partial area 奖励函数设置为 设局部重规划的神经网络含有两个隐藏层,每层80个神经元,输入为两架无人机的x轴坐标、y轴坐标以及各无人机的动作,输出为拟合的Q值,记忆矩阵最大容纳量为8 000,定义平均回报Rave为1 000个回合内总回报的平均值,平均回报曲线如图13所示。 图13 平均回报函数曲线Fig.13 Average reward curve 由图13可见,观察期的回报波动较大,探索期随着训练次数增加算法的平均回报曲线呈现波动上升趋势,当经过50 000幕时平均回报逐渐趋于稳定,此时网络已训练得较充分,可用于求解最优航迹。根据训练网络选择Q值最大的动作进行状态转移,得到局部重规划航迹如图14所示。 图14 局部重规划示意图Fig.14 Diagram of partial path replanning 由图14可见,采用DQN算法可有效对局部航迹进行重规划,将局部航迹替换到全局航迹中,即可获得满足时间协同与多无人机碰撞避免的最优航迹组。全局航迹图如图15所示。 图15 协同航迹图Fig.15 Diagram of cooperative path 设置未探明的障碍物位置为(5,7),得到战场示意图如图16所示。 图16 存在未探明障碍物战场的仿真算例Fig.16 Battlefield model with unexplored obstacle for simulation 图16中,紫色栅格为未探明障碍物位置,假设无人机飞入浅绿色区域内,则可探测到位于中心的障碍物。根据2.3节算法进行未探明障碍物的躲避,若无人机进入浅绿色区域,则在原有Q-table中叠加一个障碍物矩阵。取kob=1/|Qob(S,A)|max=0.003 6,则叠加障碍物矩阵与未叠加障碍物矩阵的局部Q-table如表4、表5所示。 对比表4、表5可知,仅对障碍物区域内(state48、state69)的数值进行了叠加变换,而障碍物区域外(state1、state70)的数值未改变。 采用表4中的未叠加障碍矩阵的Q-table直接进行航迹规划时,得到的一种最优航迹组如图17所示。 表4 叠加前局部经验矩阵取值Table 4 Partial Q-table before superposition 表5 叠加后局部经验矩阵取值Table 5 Partial Q-table after superposition 图17 存在未探明障碍物的协同航迹1Fig.17 Cooperative path 1 with unexplored obstacle 图17中各架无人机满足时间协同,但是由于存在位于(5,7)的先前未探明障碍物,无人机1将会与障碍物发生碰撞,进而导致围捕任务失败。 采用表5中叠加了障碍矩阵后的Q-table,假设探测到障碍物前各无人机的航迹与图17所示航迹相同,则得到仿真结果如图18所示。 图18 存在未探明障碍物的协同航迹2Fig.18 Cooperative path 2 with unexplored obstacle 从图18中可见,无人机1成功躲避了先前未探明的障碍物。根据表5所示,当无人机1位于State48(坐标(3,8))时,由于叠加了障碍物矩阵,动作“右”对应的Q值9.363 8大于动作“下”对应的Q值9.133 4,这是因为位置(4,8)比位置(3,9)更接近障碍物,按照最大Q值选取动作时无人机会转移到State49,按此Q-table进行状态转移,直至转移到障碍物区域边缘,如表5所示state69(位置(4,9))的最大Q值对应动作为“右”,执行动作后无人机转至state70(位置(4,10)),此状态下叠加与未叠加障碍物矩阵的各个动作所对应的Q值相同,即障碍物区域外的Q-table数值未发生改变。因此,无人机1进入未探明障碍物区域后,在未探明障碍物的“斥力”以及期望位置的“引力”的双重作用下,躲避障碍物的同时趋向目标飞行。经检验,所规划的航迹中各飞行器未发生碰撞,因此无需对局部区域进行重规划。 本文设计了一种基于Q学习算法的协同航迹规划方法,可以实现多无人机对目标的同时打击。得出主要结论如下: 1)基于已有Q-table的多无人机满足时间协同的航迹规划方法,充分应用Q学习理论不依赖于初始状态的特点,显著提升了在线应用的求解效率。 2)基于DQN算法的局部航迹重规划方法,避免了Q-table维度爆炸问题,有效降低了多无人机碰撞避免问题的求解难度。 3)通过与人工势场法原理类比设计的针对未探明障碍物的临时避碰策略,能够应对在线应用过程中战场环境与训练模型存在差异的情况,显著增加网络的实用性。

2.4 多无人机协同航迹规划算法流程

3 仿真试验

3.1 飞行时间协同航迹规划方法仿真分析

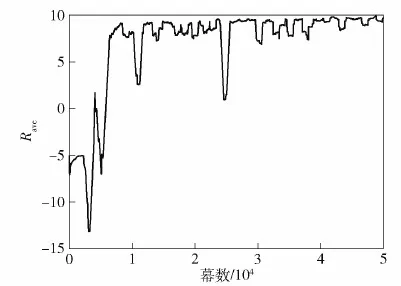

3.2 碰撞避免策略仿真分析

3.3 存在未知障碍物的规划方法仿真分析

4 结论