基于轻量级模型共享的联合半监督学习

2022-11-17王世辉莫锦华

王世辉,朱 晓,莫锦华

(1.广西大学信息网络中心,广西 南宁 530004;2.广西工业职业技术学院电子信息学院,广西 南宁 530001;3 .广西科技信息网络中心,广西 南宁 530015)

0 引言

在传统的以云为中心的方法中,移动设备收集的数据在基于云的服务器或数据中心集中上传和处理。具体来说,物联网设备和智能手机收集的数据,例如测量、照片、视频和位置信息在数据中心被聚集。此后,这些数据被用来提供见解或产生有效的推理模型。然而,这种方法不再可持续,原因如下。首先,数据所有者对隐私越来越敏感。随着大数据时代消费者对隐私的担忧,政策制定者的回应是实施了数据隐私立法,如欧盟的《通用数据保护条例》和美国的《消费者隐私权利法案》。其次,以云为中心的方法涉及很长的传播延迟,并且对必须做出实时决策的应用(例如自动驾驶汽车系统)会产生不可接受的延迟。最后,将数据传输到云进行处理会给主干网络带来负担,特别是在涉及非结构化数据的任务中,例如视频分析。因此,这可能会阻碍新技术的发展。

为了保证训练数据保留在个人设备上,并促进分布式设备之间复杂模型的协作机器学习,引入了一种称为联合学习(FL)的去中心化机器学习(Machine Learning,ML)方法[1]。在FL中,移动设备使用它们的本地数据协同训练FL服务器所需的ML模型。然后,它们将模型更新(模型的权重)发送到FL服务器以进行聚合。这些步骤在多个回合中重复,直到达到所需的精度。这意味着FL可以成为移动边缘网络中ML模型训练的使能技术。与传统的以云为中心的训练方法相比,在移动边缘网络上实现FL的模型训练具有以下优势。

联合学习是近年来研究比较活跃的一种机器学习框架。FL利用客户的计算能力,在没有数据共享的情况下实现本地模型培训,帮助解决隐私问题。主流方法如FedAvg或FedProx,要求客户端将本地训练的模型发送到服务器,而服务器使用某种聚合方法更新全局模型。一旦全球模型被更新,全局权重被广播回客户,完成一轮训练。一轮又一轮地重复,直到达到收敛。

然而,在大规模实施FL之前,还有几个问题需要解决。首先,尽管不再需要将原始数据发送到云服务器,但是模型更新的高度维度和参与的移动设备的通信带宽有限,通信成本仍然是一个问题。特别是,最先进的DNN模型训练可以涉及用于聚合的数百万个参数的通信。其次,在大型复杂的移动边缘网络中,参与设备在数据质量、计算能力和参与意愿方面的异构性必须从资源分配的角度得到很好的管理。最后,FL不保证恶意参与者或服务器在场时的隐私。

现有的FL方法大多集中在监督学习(Supervise Learning)设置上[2],客户端的数据被完整地标记。然而,考虑到已标记数据的获取成本很高,假设客户端数据大多是未标记的是可行的。客户端上的标签数据不是一个实际的设置,因为在现实世界中,边缘设备上的数据通常没有完全标签。例如,一些用户可能会在手机中标记图像,但由于标记数据需要时间和人力,不能指望用户标记设备中的所有数据。如果数据被采集到服务器,可以聘请一些专家进行标记,但边缘设备上的数据被用户标记的可能性较小,可能因为不专业而被错误标记。因此,研究联合半监督学习具有重要意义。联合半监督学习(FSSL)是为了从未标记的客户端数据中获取价值。虽然已经提出了许多半监督学习(SSL)方法,如FixMatch和UDA[3],但是简单地将本地模型训练替换为SSL方法的半监督学习应用不太成功。这是因为客户的数据量有限且异构性(非I.I.D.)数据分布,造成局部模型之间的高度梯度差异。

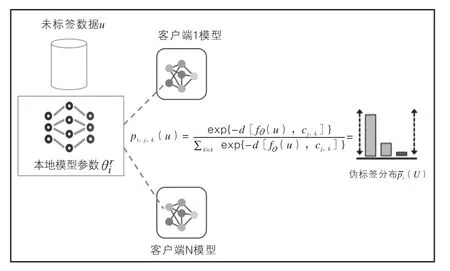

FedMatch被提出来解决上述问题,使客户端能够在使用未标记数据时利用来自其他客户端的知识,从而防止本地模型发散。然而,它以模型权重的形式进行客户间知识共享的方法增加了客户的通信和计算开销,并且开销与模型大小呈线性关系。考虑到客户端比服务器更受资源限制,增加客户端负担在FSSL中是不可取的。此外,研究表明,它提供的准确率明显低于其他不在客户之间共享知识的FSSL方法,这表明知识共享的想法可能是无效的,因此在客户端进行模型共享是一个值得研究的问题。FSSL的总体训练流程图如图1所示。

图1 FSSL的总体训练流程图

本文重新审视了客户之间的知识共享,并开发了一种定制方法,在客户之间共享知识,而不使用模型权重,以实现有效的客户间一致性规则;提出了采用轻量级模型共享的方案,引用了最初为基于度量的元学习实现FSSL。在提出的方案中,客户之间的知识以比模型参数轻得多的文本形式共享。每个客户利用共享的原型对其未标记数据进行一致性正则化,从而提高了伪标记的质量,减少了非I.I.D中的局部模型发散。考虑到原型的通信成本较低,FSSL允许更多的客户频繁地共享知识,以更好地收敛模型。本文的主要贡献如下:①研究了FSSL,这是FL在客户上的一个实际应用,具有部分标记的数据。具体地说,我们提出了一种新的方法,将原型、客户之间的知识共享和一致性正则化与FL相结合,以实现高效和准确的模型训练。②设计了两个轻量级组件来利用未标记的数据:模型参数共享和客户间基于模型参数的伪标注。即使在轻量级ResNet9中,这些组件实现的通信为FedMatch的25%,与FedMatch和其他基于数据增强的一致性正则化方法相比,客户端计算量减少了75%。此外,它们通过更频繁地在更多客户端之间共享知识来提高准确性。

1 基于模型共享的半监督联合机器学习

本章节描述了FSSL的细节,旨在通过使用轻量级原型作为客户端间的知识的一种形式,为FSSL提供高效的客户端间一致性规则化。图 1说明了FSSL架构。

1.1 有监督的联合学习

联合学习已经成为在边缘网络中分发机器学习模型的一种有吸引力的范例。虽然在机器学习的背景下有大量关于分布式优化的工作,但是联合学习与传统的分布式优化之间存在两个关键挑战——高度的系统和统计异构性。为了处理异质性和解决高通信成本,允许本地更新和低参与度的优化方法是联合学习的流行方法[4]。

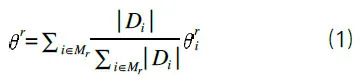

FedAvg 是一种典型的FL方法[5],该方法操作如下:每轮培训r包括广播、本地培训和聚合。在广播步骤中,服务器选择一组m客户端Mr,并将全局模型r-1发送到Mr中的客户端。每个客户端I(∈Mr)使用自己的数据和多个历元E的基本事实标签DI将r-1本地更新为。客户端将本地模型发送回服务器,服务器将全局模型更新如下:

重要的是,假定客户端数据集具有异构数据(非I.I.D.)分布。

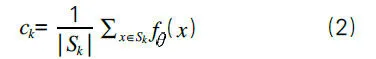

FSSL对本地模型进行训练,为嵌入空间中的每一类提供良好的嵌入空间和原型。该网络将数据样本转换为嵌入向量,并使用与每个原型的距离对该向量进行分类。将k定义为类的集合,将Dk定义为类k(∈K)的训练数据集。训练集DK分为两个部分:①支持集(SK),它是DK的随机子集;②剩余的文本集(K)(DK减去 SK)。然后从支持集计算类k的原型:

其中,d是欧几里得距离函数。对模型进行训练,使得同一类的嵌入向量靠近,而不同类的嵌入向量远离。该算法结合了原型学习和联合半监督学习的思想。

1.2 半监督FSSL系统分析

虽然联合学习可以保护用户隐私,但是现有的大多数方法都依赖于高度标注的数据。然而,边缘用户和设备具有不可预测的可变特性,在边缘获得标记数据使得当前的解决方案不切实际[5]。为了解决这些不足,人们提出了介于监督学习和非监督学习之间的半监督学习解决标签数据不足的问题。半监督学习是机器学习的一个分支,介于监督学习和非监督学习之间,其中有几个已标记的实例和大量的未标记的实例,并且已标记的数据点的数量不足以训练期望的监督模型。监督学习框架中的一个主要挑战是标签实例的可用性。数据标注通常既耗时又昂贵,而且在每个边界点都无法访问。解决半监督学习的一种流行方法是通过在未标记的实例上训练自动编码器提取特征。自动编码器是一种人工神经网络,它从未标记的数据中学习数据表示。它的目标是将原始数据转换为其压缩表示,并在不丢失有价值的信息的情况下将其重建回其原始形式。

在半监督学习中,我们有少量的已标记数据和大量的未标记数据。已经有多次尝试将联合学习与半监督学习统一。考虑到用户有大量的标签数据,而服务器有一组标签数据,Saeed等开发了一种自我监督的方法,从用户的未标记数据中学习有价值的表示[6]。

然而,这些工作都没有研究解决数据异构性问题的方法。我们考虑一个FSSL问题,其中服务器没有数据,但每个客户端I都有一个私有的非I.I.D.数据集,其中是已标记的数据集,而是未标记的数据集。K被定义为类别标签的集合。对于所有客户端,假定未标记的数据集比已标记的数据集大得多,即。有了数据设置,这项工作的目标是以联合方式训练一个由参数化的轻量级模型共享。在每个通信循环r,对于E局部历元,每个参与的客户端i使用其标记和未标记的数据集将全局参数r-1在客户端本地更新为,并为每个k(∈K)更新其本地原型c。在每个局部i,k历元中,客户端I从中随机抽样一个带标签的支持集,并从中随机抽样一个带标签的查询集,从中随机抽样一个未标记的查询集。

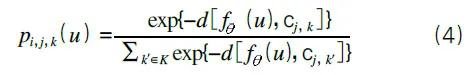

如图2所示,对于每个训练历元中关于未标记数据的本地训练,Mr中的客户端I使用来自Hr中的助手客户端的外部原型标记其未标记的查询数据。假设是客户端在本地历元e中的当前权重,客户端i首先使用本地权重为未标记的数据点u计算嵌入向量。然后计算嵌入向量与每个类(k∈K)和辅助客户端j(∈Hr)的原型cj,k之间的欧几里得距离。对于帮助客户端的原型,使用每个类别的距离的负数的Softmax计算未标记数据u成为类别k的概率,表示为pi,j,k(U)。

图2 客户端共享模型参数流程图

在计算每个帮助客户端的原型的类概率后,u的平均类概率计算如下:

2 实验结果

为了进行比较,我们遵循了FSSL中的设置。总共有100个客户端,每轮随机选择5个活跃客户端(m=5)参加训练。我们在3个数据集(CIFAR-10、SVHN 和STL-10)进行了评估。我们将CIFAR-10数据分成54 000个训练集、3 000个验证集和3 000个测试集,将SVHN数据分成54 000个训练集、2 000个验证集和2 000个测试集。将训练数据点分发给100个客户端(即每个客户端有540个数据),其中每个类标记5个实例,其余490个实例未标记。对于未标记的数据,我们使用I.I.D设置,其中每个客户端每个类具有相同数量的数据,以及非I.I.D设置,每个客户端具有不平衡的类分布。对于STL-10,每个客户端有1 080个数据点,其中100个数据点已标记,其余980个未标记。由于STL-10最初是为SSL构建的,它不提供未标记数据的类别信息,因此我们将其未标记数据随机分布到每个客户端。由于STL-10未完全标记,因此无法在数据集中评估FedAVGSL和FedProx-SL。

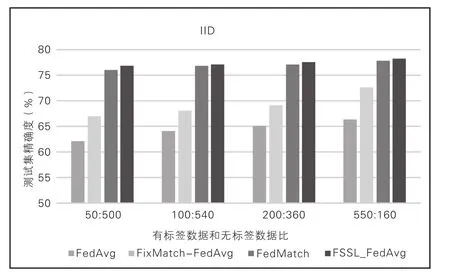

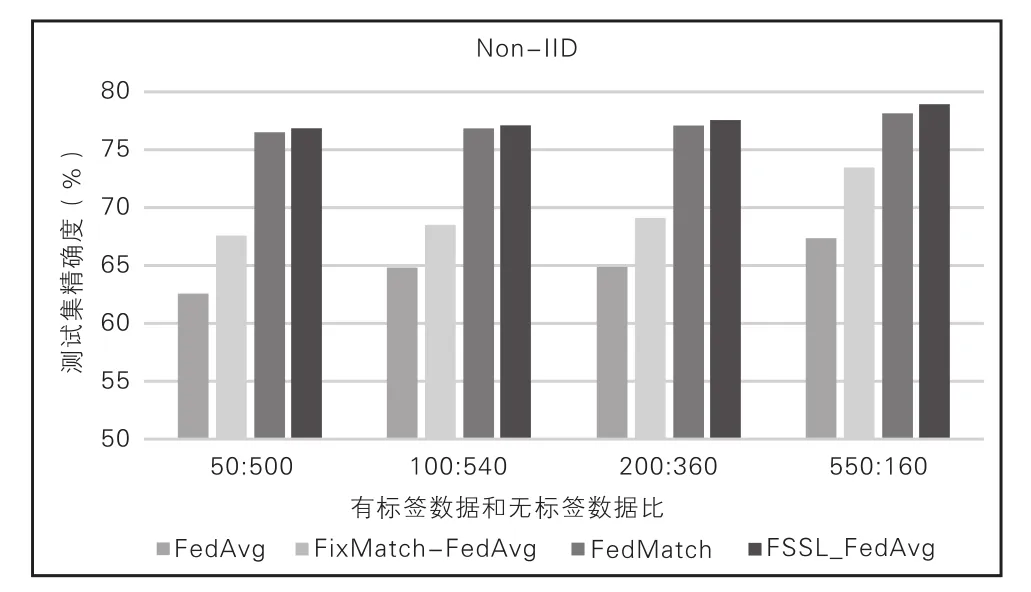

本文比较了FSSL和基线的测试精度,将FedMatch参数设置为|Hr|=2。考虑到FSSL很容易扩展,本文将客户端helper参数设置为|Hr|=5。经观察发现,FSSL显著优于FedAvg和FedProx基线,后者不使用未标记的数据。这表明FSSL能够通过客户端之间的原型交换伪标记从未标记的数据中提取知识。FSSL的性能也优于FL和SSL的简 单 组 合(即FixMatch-FedAvg/FedProx) 和FedMatch,表明基于原型的知识共享优于无共享和基于模型的共享。值得注意的是,它在非I.I.D.环境中的性能下降是微乎其微的,这意味着客户之间的原型有效地防止了客户的偏见学习。在SVHN中,FSSL甚至可以与完全监督的学习案例相媲美。相比之下,FedMatch的精确度最低,甚至低于FedAvg和FedProx。这表明基于模型的知识共享的脆弱性。值得注意的是,在FedMatch的原始论文中,CIFAR-10上报告的测试下界精度更差(如图3、图4所示)。

图3 CIFAR-10测试集精度(I.I.D分布)

图4 CIFAR-10测试集精度(Non-I.I.D分布)

3 结语

本文研究了异质数据分布下的联合半监督学习,重点是在不增加资源受限客户端的计算/通信负担的情况下提高模型的收敛速度;提出了通过在客户端之间交换轻量级模型参数来强制客户端间一致性的建议;在实验中,从训练准确率方面对该方案进行了评估。作为将轻量级模型应用于FSSL的第一次尝试,所提出的方案比现有的FSSL方法更有效。本文研究结果为未来基于轻量级模型的FSSL框架研究提供了新的思路。