基于深度监督的TransUNet可见光卫星图像分割

2022-11-15侯作勋鲁泓言武伟超周家乐屈晓磊

侯作勋 鲁泓言 武伟超 周家乐 屈晓磊,*

基于深度监督的TransUNet可见光卫星图像分割

侯作勋1鲁泓言2武伟超3周家乐2屈晓磊2,*

(1 北京空间机电研究所,北京 100094)(2 北京航空航天大学仪器科学与光电工程学院,北京 100191)(3 北京理工大学光电学院,北京 100081)

卫星部件 图像分割 深度学习 遥感应用

0 引言

卫星技术的持续发展,为人类日常生活和探索未知世界带来了诸多便利,但是近年来,随着卫星数量的不断增加,尤其是商业航天领域的蓬勃发展[1],出现了很多新的问题。其中最突出的问题是轨道变得越来越拥挤,也越来越不安全。例如马斯克的星链计划包括42 000颗卫星,其卫星失效率很高,寿命初期已达到3%。这些卫星未来都将成为太空垃圾,将严重威胁人类进一步发射卫星的安全性。因此,亟需发展空间目标探测与识别技术解决这一问题。而在空间目标探测与识别技术中,通过空间视觉相机精确定位卫星的重要部件是对故障卫星和太空垃圾进行准确抓捕和维修的前提条件[2]。卫星的部件主要包括卫星星体、太阳翼、卫星天线、星箭对接环、发动机和有效载荷等,而天线、星箭对接环、发动机、有效载荷均位于卫星星体上,因此,星体和太阳翼的识别、定位对于卫星抓捕具有重要意义。

空间目标识别,尤其是星上载荷构成识别是开展在轨服务与维护的基础,核心是对目标图像进行分割,实现不同区域对应不同的物体载荷。2001年,英国的Cropp等人通过单目可见光相机来估计已知目标卫星的相对位置和方向[3]。2002年,日本的Terui等人基于Cropp的研究,提出了使用单目可见光相机来识别空间碎片和失效卫星等在轨大型物体的相对位置和姿态的方法[4]。由于单目视觉方式获取信息量少,导致载荷构成识别非常困难[5]。为了提升目标识别正确率,目前的研究方向是不断提升可以测量的信息量,手段包括双目视觉、飞行时间技术、结构光等[6-10]。2006年,日本的Terui等人借助双目可见光相机获取目标的图像信息,设计了立体视觉和3D模型匹配相结合的算法,提高了空间目标卫星识别的精度[6];2015年,德国的Tzschichholz提出了一种使用3D飞行时间相机与高分辨率灰度相机相结合的测距信息进行空间目标卫星的姿态和位置的估计,提高了姿态估计的速度[7];2017年,德国的 Klionovska提出了使用光子混合器设备传感器对空间目标卫星部件进行初始姿态和位置的估计识别算法,进一步降低了评估的误差。国内也有不少研究集中在空间目标卫星检测、识别和位姿估计上[8]。2012年,哈尔滨工业大学徐文福等人利用双目可见光相机,实现目标卫星的快速识别和位姿估计[9];2016年,清华大学的梁斌设计了单目相机与结构光系统,通过圆形与矩形投影时的几何约束关系测量空间非合作目标的位姿[10]。但是卫星对载荷的质量非常敏感,期望负载轻小,以上方法增加了系统的复杂度,在实际应用中代价很大。只采用单目相机就可以实现有效分割,这是目前最经济的方式。此外,传统的卫星检测、识别和分割方法,往往需要手动设计特征,对于不同卫星检测、识别和分割的鲁棒性较差。近年来,深度学习算法的蓬勃发展为单目相机的有效分割提供了可能,核心是基于学习充分发掘图像内部的固有特征,实现鲁棒的分割。

随着深度学习技术的发展,其已被广泛应用于自然图像、医学图像等的检测、识别和分割上。LeNet[11]网络结构的诞生,标志着卷积神经网络的出现。但由于当时条件限制,深度学习一直没得到进一步发展。直到AlexNet[12]出现,深度学习才在图像处理领域引起了广泛的研究。深度神经网络是非线性的,具有很强的特征表示能力,在图像分类等领域有较好的性能,但是其在像素级的语义分割任务上的效果一直较差。2014年,全卷积神经网络(Fully Convolutional Networks,FCN)[13]的提出,使得像素级的图像分割效果明显提升,是图像语义分割里程碑式的进展。2015年,Ronneberger等人提出的U-Net模型在医学图像分割领域的应用,取得了较好的效果[14]。深度神经网络的高级特征往往具有丰富的语义特征,但是在空间目标定位任务中表现较差。U-Net 的网络结构在同分辨率的特征图上实现跨层连接,多尺度上实现编码和解码的同分辨率特征的融合。此后,多种模块被融入U-Net用以改进网络,提升分割性能。与卷积神经网络相比,基于自注意力机制的模型结构Transformer具有较强的学习能力,可以建模图片所有位置之间的依赖关系,能够提升神经网络的分割性能。Jieneng Chen等人将基于自注意力机制的模型视觉Transformer(ViT)融入U-Net提出了TransUNet,在语义分割任务上取得了较好的结果[15-16]。2017年,Zhengxin Zhang等人将残差网络(ResNet)[17]的残差连接结构加入了U-Net进行道路提取任务,提出了残差学习“U”型卷积神经网络Residual U-Net(ResU-Net)[18]。残差结构能够优化U-Net深层网络的训练,提高了模型的特征学习能力,优化了模型性能。Attention U-Net在U-Net基础上,引入了注意力机制,将注意力模块(Attention)引入了U-Net的解码器模块中,通过学习图像中不同区域的重要程度,训练过程中神经网络抑制图像无关区域,提高重要区域的权重,更关注目标区域,网络性能提升[19]。除了对U-Net的改进之外,其他网络如全分辨率残差网络(Full Resolution Residual Network,FRRN)和Dual Attention Network(DANet)等也在图像分割任务上取得了较好的效果。FRRN在网络结构中设计了一条携带边界信息的全分辨率流和一条携带语义信息传递的残差流,在每层网络中全分辨率流特征输入残差流网络进行特征融合,融合后的特征输出更新全分辨率流,实现了高精度分割[20]。DANet在传统FCN上设计了位置自注意力模块和通道自注意力模块,分别模拟空间维度上不同位置之间的语义依赖性和不同通道间的语义依赖性。模型融合了两种自注意力模块的输出特征,分割精度得到提升[21]。

针对空间目标图像分割这一难题,本文采用基于深度监督的TransUNet(Deep Supervised TransUNet,DSTransUNet)网络,其创新性在于在Jieneng Chen等人提出的TransUNet网络的基础上,通过引入深度监督机制,实现从不同的深度学习卫星图像各部件内部的语义特征,增强中间特征图的品质,同时缓解随着网络规模增加带来的梯度消失等问题,显著提高了对卫星目标、星体和太阳翼的分割精度。同时在卫星部件图像和对应标签不好获取的情况下,利用仿真方法制作得到数据集。

1 深度神经网络及结构

1.1 U-Net与TransUNet

U-Net具有卷积神经网络的特点,即距离较近的像素间相关性强,对局部信息的学习性能较好,但是距离较远相关性比较弱。与卷积神经网络相比,基于自注意力机制的模型(如Transformer)在计算两位置之间的关联所需的操作次数不随距离增长,可以较好建模长距离位置之间的依赖关系。TransUNet将Transformer引入U-Net,在编码器部分加入Transformer对图像的全局信息进行建模,大幅提高了分割精度。

1.2 深度监督机制

不同于标准神经网络仅靠输出层逐步反向传播来降低模型预测和标签的损失,深度监督机制在不同深度隐藏层中添加额外的目标函数来对其特征图品质进行监督。Chen-Yu Lee等人在深度神经网络的隐藏层中加入了监督信息来判断隐藏层特征图的好坏,提出了Deeply-Supervised Nets(DSN)结构,在图像分类任务上取得了较好的结果[22]。通过隐藏层额外的深度反馈影响权重更新过程,提高隐藏层的特征图品质,进一步提高最终的分类结果。而对于图像分割任务来说,较深的隐藏层可以对分割品质好坏起到较大的影响,只在原分辨率的输出上添加监督信息可能会忽略隐藏层图像品质的好坏。对于我们的卫星部件分割来说,不同卫星图像的星体、太阳翼的大小不是固定的,如果在较浅的隐藏层添加额外的深度反馈,将网络权重约束到目标区域,可以进一步优化深层输出特征图品质,进而优化最终分割结果。另一方面,仅靠输出层在图像原分辨率下进行监督会使网络侧重细节纹理信息的学习,而对较深隐藏层进行监督可以使网络直接学习卫星部件的语义特征,这种学习方式可以提高对卫星部件识别的鲁棒性,使得神经网络在面对不同纹理的卫星时也能有较好的分割效果。为了监督不同深度模型的输出,可以在不同深度的层添加深度监督机制,这些辅助的监督信息有助于神经网络的训练,提高图像分割网络的性能。

1.3 DSTransUNet总体结构

DSTransUNet总体模型结构如图1所示,输入图像在编码器部分进行4次下采样,每次下采样特征张量分辨率变为原来的一半,通道数逐渐增加,第4次下采样输入Transformer模块对全局信息进行建模。在解码器部分对特征张量进行上采样,每次上采样分辨率变为原来的2倍,特征通道数逐渐减少,且与编码器部分同分辨率的特征张量对应的通道数相同,和编码器的同分辨率张量进行跨层连接。每一个深度的特征张量上采样到原分辨率后进行深度监督,模型共5个损失函数均为交叉熵损失函数。本文中我们与已有分割模型进行了大量的对比实验,最终得到相比于对比方法最优的分割精度,验证了模型改进的有效性。

图1 DSTransUNet网络结构图

2 卫星部件图像分割实验

2.1 数据集

本文构建了仿真数据集来进行训练和验证。为了仿真空间卫星目标的可见光图像,我们构建9个三维卫星模型,并对其进行纹理贴图和渲染。在仿真光照环境上,同时设置了太阳光源和环境光源,其中太阳光使用平行光进行模拟,由于其他星体造成的环境光则使用强度较弱的环境光源来模拟。通过随机选取追踪相机的角度和距离,仿真渲染不同角度和距离的可见光卫星图像。最终,在每个三维模型下,以不同的角度、距离仿真渲染200幅图像,图像尺寸为224像素×224像素,整个数据集包含卫星仿真图像共1 800张,同时每张图片有对应的标签,将可见光卫星图像分割为宇宙背景、星体和太阳翼。在训练和验证过程中,我们将每个卫星模型的200张图像作为一份,全部数据集分为9等份,然后进行9折交叉验证。9折交叉验证就是将数据集平均分成九等份,每次选用其中的一份作为验证集,其余的八份作为训练集进行训练和测试,一共进行九次。最后得到模型平均的评估结果作为最终的分割结果。图2给出了部分卫星仿真图像以及其对应的标签,上半部分是经过渲染仿真后得到的卫星图像,下半部分是每个卫星图像对应的标签。

图2 卫星仿真图像及标签

2.2 实验虚拟环境及细节

我们的训练和测试环境为Ubuntu 16.04操作系统,基于Pytorch 深度学习框架[23],使用4块GeForce RTX 2080Ti显卡,实验中所有模型训练批次设置为4,以此获得较优的训练速度和收敛精度,选择 Adam 优化器训练,学习率设置为2×10–5,损失函数选取加入类别权重的交叉熵,公式如下

2.3 评价指标

本文使用卫星分割的准确率和雅卡尔指数定量地评价和对比分割方法。本文中的卫星分类问题,可以看作对每个像素进行多类别的分类,所以可以通过真阳性(TP)、假阳性(FP)、假阴性(FN)、真阴性(TN)的像素集合来计算各个类别对应的准确率和雅卡尔指数。其中准确率ACC的定义如下

式中表示对应部件的标签区域像素;表示对应部件区域的预测结果;与相交的区域表示预测结果中为正确区域的像素,即TP。各卫星部件雅卡尔指数JSC可以通过下式计算

雅卡尔指数也称交并比(Intersection of Union,IOU),被定义为真实区域和预测区域交集和并集像素数的比值。

3 实验结果及分析

3.1 分割结果对比

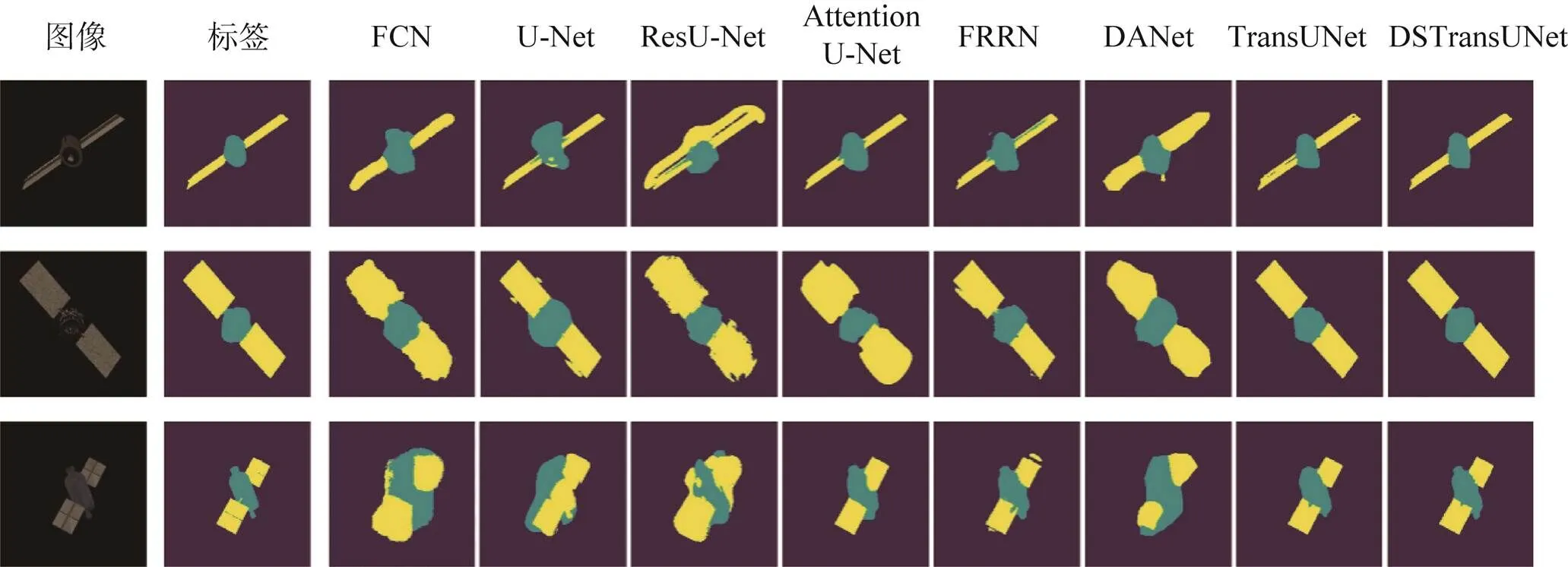

图3给出了3个分割的示例和不同分割方法分割结果的对比。在所有对比模型中,ResU-Net对于星体的分割存在明显的错误分割,对第一行图像中太阳翼的过分割比较明显,将星体附近的背景区域也预测为了太阳翼;对第二行图像中太阳翼的分割较为模糊;而第三行图像中星体和太阳翼的分割不规则,且交融在一起,分割效果较差。FCN和DANet网络模型在视觉上分割效果较为相似,存在将背景区域预测为卫星星体和太阳翼的问题,存在明显的分割错误。U-Net对第一行和第二行图像的预测结果尚可,但在第三行图像中将卫星星体识别为太阳翼区域,产生了非常明显的分割错误。Attention U-Net网络模型分割结果较前面几种网络模型更好,但分割结果与标签相比仍有较大差距。FRRN网络模型在所有卷积模型中视觉效果较好,但分割边缘比较粗糙,丢失了大量细节。TransUNet对于细节的处理明显好于所有卷积神经网络,但边缘细节的错误分割仍多于DSTransUNet。本文提出的DSTransUNet在三个分割示例中均展现出了较好的分割精度,给出了最接近标签的分割结果。

图3 各网络模型分割结果可视化对比

3.2 DSTransUNet特征图分析

图4给出了DSTransUNet解码过程中不同深度上特征图。特征图的亮度越高代表对应区域权重越高。第一行是不同深度网络中对宇宙背景进行分割的特征权重;第二行是对星体进行分割的特征权重;而第三行是对太阳翼进行分割的特征权重。可以看出随着解码层数从左侧的低分辨率上升到右侧的高分辨率过程中,特征权重越来越集中在待分割区域上。

图4 DSTransUNet深监督特征图

3.3 图像分割结果定量评价和对比

表1 不同神经网路模型在数据集上的各指标结果对比

Tab.1 Comparison of the results of different neural network models on the dataset 单位:%

4 结束语

本文将深度监督引入TransUNet,提出了DSTransUNet用于可见光空间卫星目标的图像分割,可以高精度地将可见光卫星图像分割为宇宙背景、卫星星体和太阳翼,为空间抓取提供重要信息。同时本文构建仿真图像数据集,对DSTransUNet进行了定量评价,并与现有方法进行对比,结果显示DSTransUNet的分割精度高于现有方法,能够有效地对空间可见光卫星图像进行分割。

[1] 罗格, 卫征. 航天遥感与中国空间信息产业发展[J]. 航天返回与遥感, 2018, 39(4): 10-17.

LUO Ge, WEI Zheng. China Aerospace Remote Sensing and Spacial Information Industry Development[J]. Spacecraft Recovery & Remote Sensing, 2018, 39(4): 10-17. (in Chinese)

[2] 陈磊, 高升, 袁宝峰, 等. 基于多相机的空间机械臂视觉系统[J]. 航天返回与遥感, 2014, 35(3): 35-42.

CHEN Lei, GAO Sheng, YUAN Baofeng, et al. Multi-camera Based Space Manipulator Vision System[J]. Spacecraft Recovery & Remote Sensing, 2014, 35(3): 35-42. (in Chinese)

[3] CROPP A, PALMER P. Pose Estimation and Relative Orbit Determination of a Nearby Target Microsatellite Using Passive Imagery[C]//Dynamics and Control of Systems and Structures in Space 2002, July 14-18, 2002, Cambridge. Bedfordshire: Cranfield University Press, 2002: 389-395.

[4] TERUI F, KAMIMURA H, NISHIDA S. Motion Estimation of Large Space Debris Objects Using Imaging[J]. The Proceedings of the JSME Annual Meeting, 2002, 1: 289-290.

[5] 韩璐瑶, 谭婵, 刘云猛, 等. 在轨实时空间目标检测算法研究[J]. 航天返回与遥感, 2021, 42(6): 122-131.

HAN Luyao, TAN Chan, LIU Yunmeng, et al. Research on the On-orbit Real-time Space Target Detection Algorithm[J]. Spacecraft Recovery & Remote Sensing, 2021, 42(6): 122-131. (in Chinese)

[6] TERUI F, KAMIMURA H, NISHIDA S I, et al. Motion Estimation to a Failed Satellite on Orbit using Stereo Vision and 3D Model Matching[C]//9th International Conference on Control, Automation, Robotics and Vision, December 5-8, 2006, Singapore. IEEE, 2007.

[7] TZSCHICHHOLZ T, BOGE T, SCHILLING K, et al. Relative Pose Estimation of Satellites Using PMD-/CCD-Sensor Data Fusion[J]. Acta Astronautica, 2015, 109: 25-33.

[8] KLIONOVSKA K, BENNINGHOFF H. Initial Pose Estimation Using PMD Sensor during the Rendezvous Phase in On-orbit Servicing Missions[C]//27th AAS/AIAA Space Flight Mechanics Meeting, February 5-9, 2017, San Antonio Texas, USA. Univelt Inc, 2017: 919-934.

[9] XU W F, XUE Q, LIU H D, et al. A Pose Measurement Method of a Non-cooperative GEO Spacecraft Based on Stereo Vision[C]//12th International Conference on Control, Automation, Robotics and Vision, December 5-7, 2012, Guangzhou, China. IEEE, 2013: 966-971.

[10] GAO X H, LIANG B, PAN L, et al. A Monocular Structured Light Vision Method for Pose Determination of Large Non-cooperative Satellites[J]. International Journal of Control Automation and Systems, 2016, 14(6): 1535-1549.

[11] LECUN Y, BOTTOU L. Gradient-based Learning Applied to Document Recognition[J]. Proceedings of the IEEE, 1998, 86(11): 2278-2324.

[12] KRIZHEVSKY A, SUTSKEVER I, HINTON G E. ImageNet Classification with Deep Convolutional Neural Networks[J]. Advances in Neural Information Processing Systems, 2012, 60(2): 1097-1105.

[13] LONG J, SHELHAMER E, DARRELL T. Fully Convolutional Networks for Semantic Segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 39(4): 640-651.

[14] RONNEBERGER O, FISCHER P, BROX T, et al. U-Net: Convolutional Networks for Biomedical Image Segmentation[J]. IEEE Access, 2021(9): 16591-16603.

[15] CHEN J, LU Y, YU Q, et al. Transunet: Transformers Make Strong Encoders for Medical Image Segmentation[EB/OL]. [2022-01-05]. https://arxiv.org/abs/2102.04306, 2021.

[16] DOSOVITSKIY A, BEYER L, KOLESNIKOV A, et al. An Image is Worth 16x16 Words: Transformers for Image Recognition at Scale[EB/OL]. [2022-01-05]. https://arxiv.org/abs/2010.11929, 2020.

[17] HE K M, ZHANG X Y, REN S Q, et al. Deep Residual Learning for Image Recognition[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition: CVPR 2016, June 27-30, 2016, Las Vegas, USA. Piscataway: IEEE, 2016: 770-778.

[18] ZHANG Z, LIU Q, WANG Y H. Road Extraction By Deep Residual U-Net[J]. IEEE Geoscience and Remote Sensing Letters, 2018, 15(5): 749-753.

[19] OKTAY O, SCHLEMPER J, FOLGOC L L, et al. Attention U-Net: Learning Where to Look for the Pancreas[EB/OL]. [2022-01-05]. https://arxiv.org/abs/1804.03999, 2018.

[20] POHLEN T, HERMANS A, MATHIAS M, et al. Full-resolution Residual Networks for Semantic Segmentation in Street Scenes[EB/OL]. [2022-01-05]. https://arxiv.org/abs/1611.08323v1.

[21] FU J, LIU J, TIAN H J, et al. Dual Attention Network for Scene Segmentation[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 15-20, 2019, Long Beach, CA, USA. IEEE, 2019: 3141-3149.

[22] LEE C Y, XIE S, GALLAGHER P, et al. Deeply-supervised Nets[EB/OL]. [2022-01-05]. https://arxiv.org/abs/1409.5185v2.

[23] PASZKE A, GROSS S, MASSA F, et al. PyTorch: An Imperative Style, High-Performance Deep Learning Library[EB/OL]. [2022-01-05]. https://arxiv.org/abs/1912.01703v1.

A Deep Supervised TransUNet for the Segmentation of Visible Satellite Image

HOU Zuoxun1LU Hongyan2WU Weichao3ZHOU Jiale2QU Xiaolei2,*

(1 Beijing Institute of Mechanics & Electricity, Beijing 100094, China)(2 School of Instrumentation and Optoelectronics Engineering, Beihang University, Beijing 100191, China)(3 School of Optics and Photonics, Beijing Institute of Technology, Beijing 100081, China)

satellite component; image segmentation; deep learning; remote sensing application

TP753

A

1009-8518(2022)05-0142-08

10.3969/j.issn.1009-8518.2022.05.014

2022-04-02

侯作勋, 鲁泓言, 武伟超, 等. 基于深度监督的TransUNet可见光卫星图像分割[J]. 航天返回与遥感, 2022, 43(5): 142-149.

HOU Zuoxun, LU Hongyan, WU Weichao, et al. A Deep Supervised TransUNet for the Segmentation of Visible Satellite Image[J]. Spacecraft Recovery & Remote Sensing, 2022, 43(5): 142-149. (in Chinese)

侯作勋,男,1986年生,2008年获西安交通大学电子科学与技术专业学士学位,2015年获西安交通大学控制科学与技术专业博士学位,高级工程师。主要研究方向为遥感器设计、智能图像处理。E-mail:hzx_007xjtu@163.com。

屈晓磊,男,1984年生,2007年获西安交通大学软件工程专业学士学位,2009年获华中科技大学模式识别专业硕士学位,2012年获日本东京大学生物工程专业博士学位,副教授。主要研究方向为医学超声成像、图像处理与识别。E-mail:quxiaolei@buaa.edu.cn。

(编辑:庞冰)