基于关键面纹理特征提取的自动人脸微表情识别

2022-08-31朱原雨润王艳霞张领王晶仪

朱原雨润 王艳霞 张领 王晶仪

摘要:微表情是一种短暂且微弱的面部表情,它揭露了一个人试图隐藏的真实情感,在公安、心理治疗等各个领域都有很好的应用前景。目前多数微表情的识别研究是对整个面部区域的运动特征进行提取,实际上,微表情表现最丰富的部分位于人脸眉毛和嘴巴附近,针对此问题,提出了一种基于12分块组合特征的降维LBP-TOP微表情识别方法,从微表情发生的关键部位选取分块,通过级联分块特征及特征降维处理实现微表情的特征提取。为验证方法的有效性,进行了两类实验,第一类是与基线的比较,第二类是与其他经典微表情分类方法的比较,等价模式下SAMM数据集的3分类准确率达到72.93%,F1分数达到0.66,优于现有方法。

关键词:微表情识别;三正交平面动态纹理特征;分块特征级联;感兴趣区域;支持向量机

中图分类号:TP3 文献标识码:B

文章编号:1009-3044(2022)18-0067-04

开放科学(资源服务)标识码(OSID):

微表情是一种自发式的表情,它发生在人类试图压抑或隐藏真实情感时,其特点是发生迅速、表情强度低且不能自主控制,持续时间在1/25~1/5秒以内[1],单靠人眼捕捉十分困难。并且在非语言交流形式中如面部表情、语调和身体姿势,微表情最有可能揭示一个人最深层的情感[2]。目前针对微表情研究在现实生活中的应用越来越广泛如安全领域、临床医学等,而且近几年来微表情识别在计算机视觉领域引起了研究者们的极大兴趣。

采用计算机视觉方式的微表情相关研究方面,郑亚男[3]提出使用Mo-SIFT算法进行特征点定位,取代手工设定ROI(region of interest),利用尺度不变特征变换(Scale-invariant feature transform,SIFT)[4]定位空间特征点,再用光流阈值对这些点进行过滤,得到既有大的运动幅度,又有尺度不变和旋转不变性的微表情特征点。Liong 等[5]利用光流应变对各区域的特征进行加权,突出微表情,削减无关量。Huang等[6]提出了结合积分投影和LBP(Local Binary Pattern)的特征提取算法,将图像序列中的各帧减去第一帧以突出微表情消去脸部无关信息,再向水平和垂直方向进行累加投影,用LBP提取投影特征。基于同样的思路,Huang等用低秩分解[7]提取图像序列中的微表情,再进行Radon变换提取LBP特征[8]。这种做法会比简单地将各帧减去第一帧得到的微表情信息更加准确。Wang等[9]提出的LBP-SIP(LBP with six points)只用了六点计算响应值,比LBP-TOP少了两点,在一定程度上减少了特征提取的时间。

目前多数微表情识别研究没有充分利用产生微表情局部区域的信息特征,而是对整个面部区域的运动特征进行提取。整个面部区域特征地提取容易受到位置、光照、眨眼等不利因素的干扰,且高分辨率微表情视频的特征提取计算资源耗费巨大。为了降低LBP-TOP的信息冗余和计算复杂度,提出了一种基于12分块组合特征的降维LBP-TOP微表情识别方法,选出眉毛、鼻子和嘴巴处对于微表情识别特征权重最高的感兴趣区域,提取该局部区域的时空纹理三维度特征,级联12个视频纹理信息进行特征拼接和降维处理。该方法仅在特定的面部区域内提取特征来描述纹理变化,在消除不必要的时空冗余信息的基础上保证了微表情识别的准确率,大大缩短计算时间,获得了更高的识别效率。

1 相关工作

1.1 局部二值模式

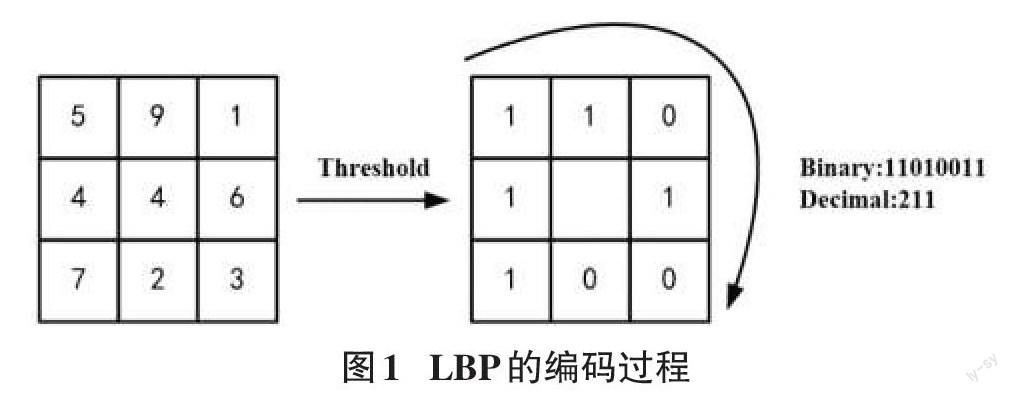

局部二值模式(LBP)[10]是一种常见的特征提取算法。LBP可以很好地处理光照变化图像,主要解决纹理分析与识别问题。LBP算法主要被应用于表情识别和人脸识别领域。该算法的原理是以一张灰度图像中某一像素点c为中心,选取以R为半径的P个邻域点。如图1所示,中心点c的LBP编码LBPPR能够通过与其邻域像素点的灰度值比较得到。灰度值大的邻域赋值为1,反之,赋值为0。从左上角将邻域值展开得到一个Binary,将Binary转换为一个十进制数。

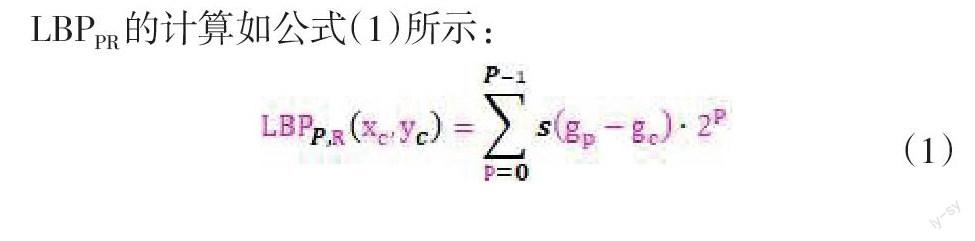

LBPPR的计算如公式(1)所示:

其中xc和yc为中心点c位置的横纵坐标,gc和gp分别为中心点c和邻域点p的灰度值,s为阈值函数。

根据公式(1)可提取二维图像的空间特征,但微表情视频图像是动态序列,具有时域的信息特征。为了能够提取微表情视频的时空信息特征,赵国英等人[11]提出了一种运动与外观特征结合的动态纹理特征算子(Local Binary Pattern From Three Orthogonal Planes,LBP-TOP)。方向X,Y表示空间坐标,方向T表示时间序列,三个方向轴形成了XY、XT、XY三个正交平面,LBP-TOP的本质就是从以上三个正交平面中分别获取特征后再进行组合。

1.2 感兴趣区域划分

面部微表情最富有表现力的部分实际上是位于眉毛和嘴巴附近,所以在寻找感兴趣区域或掩蔽的过程中,通常会围绕这两个区域的特定坐标点作参考。这样既可以消除不希望有的面部动作引起的噪声,又可以防止排除太多有意义的信息。表1是对CASME2微表情数据集中各个区域和动作单元出现频率的统计。从表中可以看出“眉毛+眼睛”和“嘴巴”区域是出现频率最高的,也进一步说明了这些区域是微表情最丰富的区域。

因此,相较于直接构建人脸微表情特征结合分类器进行微表情识别工作,提取人脸关键区域的联合特征作为分类器的输入更能凸显出加强信息有效性和减少计算资源的优势。

2 基于12分块组合特征的降维LBP-TOP微表情识别方法

2.1 基于12分块组合特征的降维LBP-TOP微表情识别方法思想

为充分利用产生微表情的局部区域的信息特征,在眉毛和嘴角处选取了12个包含大量关键微表情特征的面部区域,进行图像序列纹理特征的提取、拼接和降维,获得联合的高权重特征。基于12分块组合特征的降维LBP-TOP人脸微表情特征提取流程如图2所示。以一个微表情视频为例,以该视频的第一帧图像作为模型脸,对第一帧图像进行人脸检测与人脸特征点定位,以左右眼中心水平夹角计算出旋转变换矩阵,对微表情视频所有帧应用变换矩阵,将人脸姿态放水平。根据眼角与嘴角的特征点确定12分块,在时间序列上的每一帧图像进行同样的分塊定位,形成12个视频序列,如图2虚框(1)内所示。每一个视频序列可以得到三个维度的直方图特征,如图2虚框(2)内所示。最后级联12个直方图特征进行分类,如图2虚框(3)内所示。

2.2 关键面纹理特征提取

微表情变化强度低并且通常只涉及局部运动,从整个面部提取特征将会引入许多无关信息,比如无论表情是否发生,眨眼动作都可能出现,所以眼睛区域的信息并不完全可靠。而且由于微表情的变化强度低,很容易受到局部信息的干扰。因此,需要排除无关区域的冗余信息,消除不符合预期面部动作的部分。眉毛、嘴巴是微表情发生最相关的区域,含有微表情的关键特征,提供更多有效的表情变化信息;鼻子刚性的运动可以反映头部动作,选取少量的鼻子关键区域可以反映出头部整体的运动变化,比如害怕情绪带来的头部微微后仰。特定区域提取特征可以排除弱相关或不相关信息的干扰,也减少特征提取的时间及准确性。

眉毛、鼻子、嘴巴关键区域的选取如图3所示,一共有12个区域分块。其中每一个分块的边长等于被试左右内眼角之间距离的1/5。以视频第一帧图像作为模型脸,对其进行人脸检测与人脸特征点定位,确定出分块区域坐标,用该坐标对第一帧以及后续帧进行相同的关键面截取,得到12个微表情关键序列。然后提取这12个关键序列的三维度特征并拼接,得到12个频次为3×256的直方图,将其级联得到12×3×256维的特征向量作为后续微表情分类器的输入。

由于微表情样本量少,其特征量的长度过长,会导致分类器泛化能力差,因此采用等价模式(Uniform Pattern)实现LBP算子的模式种类降维。对于3×3邻域内8个采样点,二进制模式由原始统一模式(Basic Pattern)的256种减少为58种,再加上混合模式的1种,这样直方图从原来的256维变成59维,二进制模式的种类大大减少,模式数量由原来的2P种减少为P(P-1)+2种,其中P表示邻域集内的采样点数。统计性的降维方式可以在不丢失微表情运动关键信息的前提下,减少参数且不影响分类器的分类能力。

3 实验与评估

3.1 数据集

有效的人脸微表情识别模型依赖于高质量微表情数据集的支撑,SMIC[12]、CASME2[13]和SAMM[14]微表情数据集在相关研究中被广泛使用。CASME2数据集中所含微表情样本数最多,包含249个微表情视频样本,所有的实验参与者均为中国人。SMIC的参与者来自3个不同种族,SAMM则克服了微表情数据集种族分布不广泛的局限,拥有来自13个不同种族的参与者。CASME2和SAMM拥有高帧率数据,视频帧率达到200fps。三个微表情数据集的参与者数、样本数以及帧率信息对比见表2。

其中,各数据集分类标准各不相同,CASME2分为了厌恶、高兴、压抑、惊讶和其他,SAMM分为了生气、高兴、轻蔑、惊讶和其他。通过将5分类的情绪类别映射积极、消极和惊讶3个通用的情绪类别,实验还将三个数据集合并为了一个混合数据集,将数据量扩充到了426之多,混合数据集的3分类数目如下表3所示。

3.2 实验与分析

使用Dlib开源机器学习工具包进行特征点定位,基于10代i5处理器16G内存的实验环境,所有实验采用RBF核SVM分类器,留一法交叉验证。

3.2.1 与基线方法的比较

LBP-TOP通常作为微表情自动识别领域的基线方法。文章实现了统一模式(降维前)和等价模式(降维后)下基于12分块组合特征的降维LBP-TOP微表情识方法与基线方法LBP-TOP在不同数据集上的比较。

表4列出了统一模式和等价模式下所提方法与基线方法的对比实验结果,从表中可以看出所提方法在各个数据集上都比基线方法分类效果好。统一模式3分类下,SMIC数据集的分类准确率提高了约22个百分点,CASME2和SAMM数据集提高了约10个百分点,SAMM数据集的分类F1分数提高突出,上升了0.29,在混合数据集上的分类准确率达到66.67%。

等价模式下每个微表情的特征向量维数由9216减少到2124,与统一模式相比,CASME2数据集的5分类成绩提高了2个百分点,SMIC和CASME2数据集的3分类效果保持一致。虽然混合数据集上的分类成绩有略微降低,但换来的是维数减少带来的计算资源的释放和分类效率的提高。

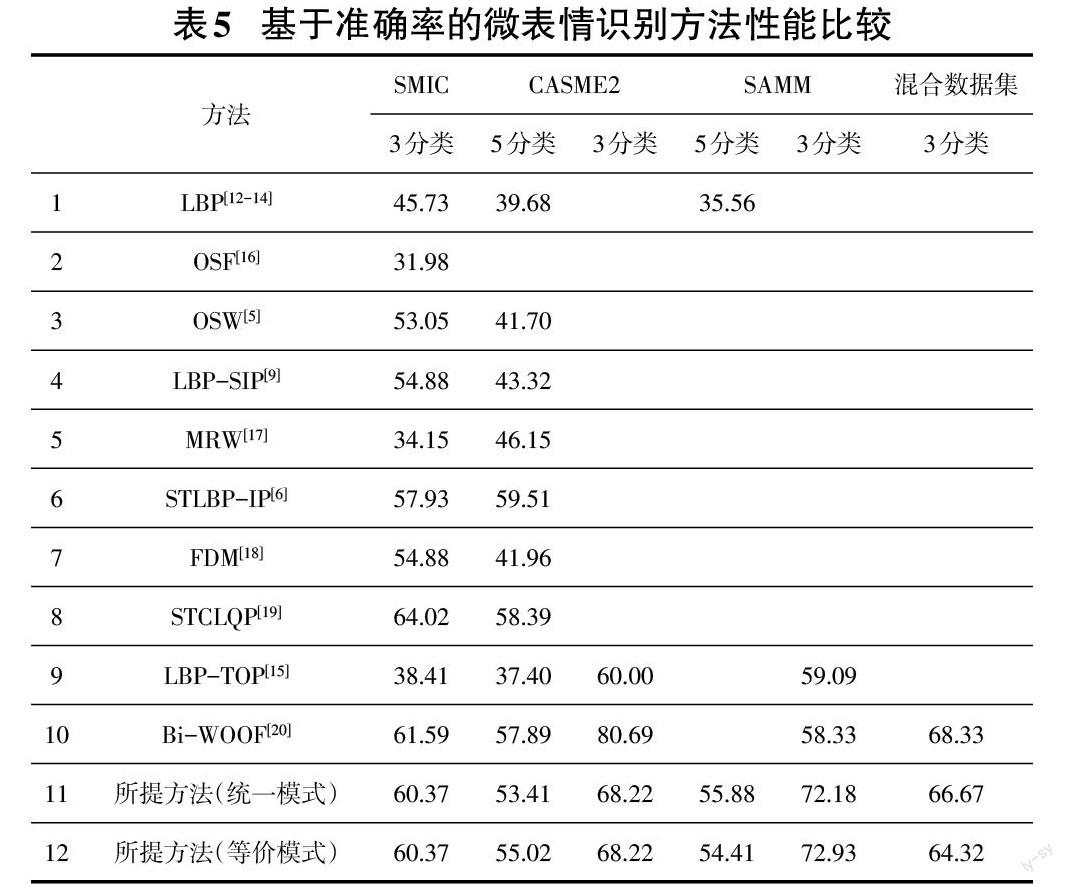

3.2.2 与其他微表情识别方法的比较

表5给出了不同数据集上基于准确率的不同方法的比较,在SMIC数据集上,所提方法的分类效果优于方法1至8,但低于方法9和12,与表现最好的方法9 STCLQP相差约4个百分点;在CASME2数据集上,所提方法5分类识别效果优于8种方法,落后于表现最优的STLBP-IP方法约4.5个百分点,3分类识别效果落后Bi-WOOF方法较大,落后12.5个百分点左右;由于SAMM数据集是最新发布的,在该数据集上实现的方法只有LBP、LBP-TOP和 Bi-WOOF,在SAMM数据集上,所提方法5分類识别效果优于LBP方法20个百分点以上,3分类识别效果优于Bi-WOOF方法近15个百分点;在混合数据集上,所提方法稍落后于Bi-WOOF方法。

所提方法在最新的SAMM数据集上的分类表现有着明显的优势,但在CASME2的3分类上落后较多。经过分析数据集,发现CASME2是三个数据集SMIC、CASME2和SAMM中戴眼镜样本数最多的数据集,戴眼镜样本数占总样本的58%,SAMM数据集中只占了17%,而关键面的选取包含了鼻梁区域,鼻梁上的框架眼镜与皮肤分割明显,对微表情纹理特征提取影响较大。因此,所提方法更适用于佩戴框架眼镜样本较少或者戴眼镜占比较小的微表情数据集,例如在眼镜占比较小的混合数据集上,所提方法的有效性得到证实。

4 总结

在微表情识别中,眉毛与嘴巴部分的运动贡献了大量的特征信息,因此文章选取眉毛、鼻子和嘴巴处对于微表情识别特征权重最高的感兴趣区域,提取该局部区域的时空纹理特征,并做关键面特征级联和统计性降维处理。在三个开放数据集和一个混合数据集上进行了验证实验,实验表明所提出的方法比较适合SAMM这种戴眼镜被试占比较小的数据集的识别。在今后的工作中,着重改进方法的普适性,例如降低鼻梁分块的权值或绕过镜框分块的位置,以减小眼镜刚性运动带来的影响;使用关键特征与神经网络相结合的方式对微表情进行分类,进一步提高自动人脸微表情的识别能力。

參考文献:

[1] Yan W J,Wu Q,Liang J,et al.How fast are the leaked facial expressions:the duration of micro-expressions[J].Journal of Nonverbal Behavior,2013,37(4):217-230.

[2] Ekman P.Telling lies: clues to deceit in the marketplace, politics, and marriage[M].New York: WW Norton & Company, 2009:16-18.

[3] 郑亚男.微表情检测与定位关键技术研究[D].北京:北京交通大学,2016.

[4] Lowe D G.Distinctive image features from scale-invariant keypoints[J].International Journal of Computer Vision,2004,60(2):91-110.

[5] Liong S T, See J, Phan R C W, et al. Subtle expression recognition using optical strain weighted features[C]//Asian conference on computer vision. Springer, Cham,2014:644-657.

[6] Huang X H,Wang S J,Zhao G Y,et al.Facial micro-expression recognition using spatiotemporal local binary pattern with integral projection[C]//2015 IEEE International Conference on Computer Vision Workshop.December 7-13,2015,Santiago,Chile.IEEE,2015:1-9.

[7] Wright J, Ganesh A, Rao S, et al. Robust principal component analysis: Exact recovery of corrupted low-rank matrices via convex optimization[C]//Advances in neural information processing systems. 2009:2080-2088.

[8] Huang X H,Zhao G Y.Spontaneous facial micro-expression analysis using spatiotemporal local radon-based binary pattern[C]//2017 International Conference on the Frontiers and Advances in Data Science (FADS).October 23-25,2017,Xi'an,China.IEEE,2017:159-164.

[9] Wang Y,See J,Phan R C W,et al.Lbp with six intersection points: Reducing redundant information in lbp-top for micro-expression recognition[C]//Asian conference on computer vision. Springer, Cham,2014:525-537.

[10] Ojala T,Pietikainen M,Harwood D.Performance evaluation of texture measures with classification based on Kullback discrimination of distributions[C]//Proceedings of 12th International Conference on Pattern Recognition.October 9-13,1994,Jerusalem,Israel.IEEE,1994:582-585.

[11] Zhao G Y,Pietik?inen M.Dynamic texture recognition using local binary patterns with an application to facial expressions[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2007,29(6):915-928.

[12] Li X B,Pfister T,Huang X H,et al.A Spontaneous Micro-expression Database:Inducement,collection and baseline[C]//2013 10th IEEE International Conference and Workshops on Automatic Face and Gesture Recognition.April 22-26,2013,Shanghai,China.IEEE,2013:1-6.

[13] Yan W J,Li X B,Wang S J,et al.CASME II:an improved spontaneous micro-expression database and the baseline evaluation[J].PLoS One,2014,9(1):e86041.

[14] Davison A K,Lansley C,Costen N,et al.SAMM:a spontaneous micro-facial movement dataset[J].IEEE Transactions on Affective Computing,2018,9(1):116-129.

[15] Gan Y S,Liong S T,Yau W C,et al.OFF-ApexNet on micro-expression recognition system[J].Signal Processing:Image Communication,2019,74:129-139.

[16] Liong S T,Phan R C W,See J,et al.Optical strain based recognition of subtle emotions[C]//2014 International Symposium on Intelligent Signal Processing and Communication Systems (ISPACS).December 1-4,2014,Kuching,Malaysia.IEEE,2014:180-184.

[17] Oh Y H,le Ngo A C,See J,et al.Monogenic Riesz wavelet representation for micro-expression recognition[C]//2015 IEEE International Conference on Digital Signal Processing.July 21-24,2015,Singapore.IEEE,2015:1237-1241.

[18] Xu F,Zhang J P,Wang J Z.Microexpression identification and categorization using a facial dynamics map[J].IEEE Transactions on Affective Computing,2017,8(2):254-267.

[19] Huang X H,Zhao G Y,Hong X P,et al.Spontaneous facial micro-expression analysis using Spatiotemporal Completed Local Quantized Patterns[J].Neurocomputing,2016,175:564-578.

[20] Liong S T,See J,Wong K,et al.Less is more:micro-expression recognition from video using apex frame[J].Signal Processing:Image Communication,2018,62:82-92.

【通聯编辑:梁书】