面向云环境的对抗样本攻防仿真验证平台

2022-08-02郎大鹏李子豫陈德运陈庆钰

郎大鹏,李子豫,陈德运,陈庆钰

(哈尔滨理工大学 计算机科学与技术学院,黑龙江 哈尔滨 150001)

0 引言

云计算技术是计算机领域广泛关注的技术热点之一,其发展应用给社会生活的各个方面带来了显著的影响和变化。借助于云计算平台,用户可以实现在线数据的存储和计算,并进行迅速的分享和分布式部署。随着大数据的发展和云计算的快速普及,大量基于人工智能和深度学习的应用软件不断云化,如智能矿山、智能监控和智能安防等典型的云应用都迅速地实现云平台部署。这些应用中大量集成了基于深度学习的人工智能模块,如文本处理、安防监控、图像分割、动作识别和语音识别等典型应用。这些深度模型促进了云应用的智能化程度不断提升,但是也引入了许多更隐蔽、更难以防范的安全隐患。

Szegedy等[1]首先发现并提出对抗样本的概念,通过在数据中添加肉眼难以察觉的扰动形成对抗样本,使模型以高置信度给出一个错误的分类结果[2]。研究发现,包括卷积神经网络在内的深度学习模型对于对抗样本具有极高的脆弱性,并且针对某一模型生成的对抗样本能够对不同训练集上训练的不同结构的模型产生影响。目前大量的理论和实践证明,传统的逻辑回归模型等线性模型面对对抗样本的攻击是无法抵御的。对对抗样本进行研究的同时也大大促进了对深度模型鲁棒性的研究。

与传统攻击方法不同,围绕对抗样本而产生的对抗攻击并不是由程序漏洞、代码Bug造成的,而是由深度模型自身脆弱性造成的。攻击者不需要物理接触云平台或云化应用,只通过对输入数据进行修改和试探,如图片、图像、视频甚至音频等信息,就能展开对云平台和应用程序的攻击,使正常运行的系统产生错误的结果。这种攻击手段更加隐蔽更加难以防御,增加了用户对云平台计算应用的数据安全、应用安全潜在风险的顾虑,限制了深度学习模型的推广和应用。

1 本文工作

近年来,学者们围绕对抗样本的原理、网络模型和应用场景等方面展开了深入研究。由于对抗样本的生成逻辑、防守策略和主干网络,甚至验证数据集的选择往往会对攻击效果有较大影响。而在对攻击和防御手段进行评测的过程中,往往无法建立统一的标准。

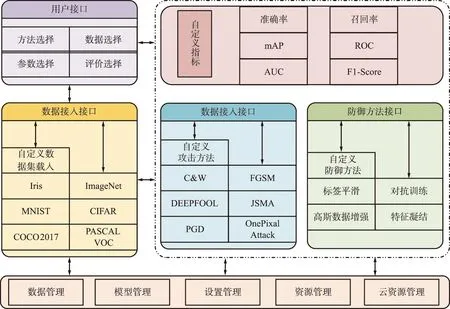

对抗样本仿真测试平台架构如图1所示。

图1 对抗样本仿真测试平台架构Fig.1 Structure of the adversarial example simulation and test platform

测试平台提供了多种对抗样本生成算法,并围绕这些攻击方法实现了有效的防御策略;为了保证云环境的安全,本系统基于微隔离技术对每一个接入的攻防测试模块都进行了纵向隔离,有效地避免了攻击溢出以及恶意代码在平台内的跨域流动等安全隐患;平台基于Token等多重认证方式提供了对自定义攻击和防御方法的接口调用功能,安全人员可以对自定义的攻击方法和防御手段进行测试。最后,通过集成标准的公共数据集,为基于对抗样本的攻防测试提供基准数据,供研究者进行测试和改进。

2 对抗样本生成与防御关键技术

2.1 对抗样本生成技术

深度学习技术以强大的适配特性可以对各种复杂的模型、网络和数据分布进行拟合,在传统的机器学习领域(如计算机视觉、动态规划和自然语言等)带来了新的突破。另一方面,深度模型自身也带来了新的安全威胁,本文从对抗攻击和对抗防御2个方面来阐述相关进展。对抗样本攻击如图2所示。

图2(a)是一张航空母舰图片,分类器将其以高概率识别为Carrier;图2(b)为加入的对抗噪声;图2(c)为将对抗噪声叠加到纯净图片中形成的对抗样本,分类器将其识别为Totem pole。

(a) Carrier:99.98

(a) 亮度

(a) AlexNet

深度学习在传统人工智能的基础上叠加多层隐含网络并包含大量超参数,使得由于可解释性问题造成的安全隐患始终是一个待研究问题。研究发现,深度模型框架中存在固有的安全隐患。Szegedy等[1]于2013年提出卷积神经网络的分类结果可以通过在其输入样本上添加难以被人类发现的小扰动来操纵输出结果;同时,提出了L-BFGS算法利用迭代优化扰动,成功地以高成功率对深度模型进行了攻击。但是,该算法由于需要通过多次迭代获得最优攻击扰动,因此计算速度较慢。随后,Goodfellow等[3]提出了快速梯度符号攻击方法(Fast Gradient Sign Method,FGSM)。算法计算反向传播梯度来计算最大化损失,即调整输入数据最大化损失。由于只需要一次参数更新,因此计算速度很快,此后基于梯度的攻击都利用了类似的原理。Kurakin等[4]在此基础上,提出了迭代的FGSM,即基础迭代法(Basic Iterative Method,BIM),由于FGSM追求计算速度,仅在梯度方向上进行一步扰动,因此攻击的效果常常不稳定。而BIM通过迭代FGSM,在每一步攻击后再次计算梯度,从而获得更加精准的攻击效果。文献[5]证明了对抗样本具有迁移特性,能够跨模型攻击。对于某一模型的攻击往往对其他模型也有效,并提出黑盒攻击的概念。生成攻击的模型也可以是多个模型,生成的扰动能够产生通用性更强的攻击扰动。

2.2 对抗样本防御技术

Dong等[6]将对抗样本的防御归类为鲁棒训练、输入变换、随机化、模型集成和认证防御。鲁棒训练的基本原理是使分类器适应对抗样本产生的噪声,主要分为2类。第1类防御训练是基于梯度掩蔽效应[7],通过正则化或平滑标签使模型更加稳定,减少对抗扰动在梯度上的影响。第2类基于对抗训练的防御方法研究最为深入,防御效果相较其他方法效果更好。研究发现,对抗训练带来的鲁棒性同样具有可迁移性。对抗训练需要在模型训练阶段加入对抗样本,提高深度模型在对抗样本上的分类精度[3]。各种对抗训练方法在同攻击方法下的不同扰动以及不同迭代次数影响下的表现不同,因此很难评价各种防御方法的优劣。其缺点是对抗训练相比常规训练更加耗时,尤其对于ImageNet这种大图像、多分类的网络,训练过程中网络需要更多次迭代来拟合对抗样本[8],分类准确率会显著下降。

基于输入变换的防御主要是在样本输入模型之前进行一个预处理操作,先去除对抗噪声,再将其输入模型。Gu等[9]首先提出使用去噪自动编码器作为防御手段,可以有效降低对抗样本的影响。Osadchy等[10]应用一组过滤器以删除对抗性噪声,如中值滤波、平均滤波和高斯低通滤波。Das等[11]使用JPEG压缩对图像进行预处理,以减少对抗性噪声的影响。基于输入变换的防御能够显著提高对白盒攻击的鲁棒性,且对于基于分数和决策的黑盒攻击同样有较高的准确性。鉴于输入变换的实现相对简单,且成本较低,可以与其他方法结合构成更加强大的防御网络。

3 对抗样本生成算法

为了有效分类评估对抗样本生成方法,本平台引用Tsauro等[12]提出的7个特征对对抗样本生成方法进行分类,分别是对抗性伪造(分为假正例以及假反例攻击)、对手的知识(分为白盒和黑盒攻击)、对抗特异性(分为有目标攻击和无目标攻击)、扰动范围(分为个体、全体攻击)、扰动极限(分为优化扰动和普遍攻击)、攻击频率(分为单步及迭代攻击)和微扰测量(分为p范数以及心理测量感知对抗相似度评分(PASS))。本文使用的对抗样本生成方法及分类如表1所示。

表1 平台内置主要攻击方法及分类Tab.1 Major attack methods and classification in the platform

3.1 L-BFGS算法

(1)

3.2 FGSM算法

FGSM是典型的无目标攻击对抗样本生成算法,它基于图像的梯度计算对抗样本,能够对全图中各个像素沿着梯度编号方向进行梯度更新,通过最大化损失函数来误导判别模型。攻击成功的标志是对抗样本经过判别模型判断后,与真实预测结果发生变化。Goodfellow等[3]通过对一个大熊猫照片加入一定的扰动(即噪音点),误导判别模型使结果为长臂猿。该算法对抗样本生成的公式如下:

X′=X+×sign(xL(f(x),y)),

(2)

3.3 BIM

BIM作为FGSM的升级型,能够通过设定步长来迭代运行FGSM,从而生成更加精细的优化效果,因此也称作iter-FGSM。算法在不是重复调用FGSM,而是在每次迭代过程中通过裁剪算法对像素值进行修正,以确保它们与原始图像处于一个邻域内:

(3)

式中,ClipX,∈{}限制了每次迭代中生成的敌对图像的更改;权重α取1,即每次改变每个像素1点;迭代次数N取min(+4,1.25),这样的迭代次数能够在保证效果的同时减少迭代次数。迭代攻击将噪声分配到每一次迭代中进行分配,由于模型的梯度分布不会是均匀的,因此FGSM所产生的对抗样本不会一直向着梯度变化最大的方向,而BIM法通过迭代多次计算梯度,能够在保证扰动幅度较小的情况下最大化扰动效果。

3.4 迭代最小概率类别法

迭代最小概率类别(Iterative Least-Likely Class,ILLC)算法是BIM的升级,可以实现对图像的有目标攻击。FGSM以及BIM的优化目标是降低正确分类的概率,而ILLC算法的优化方向则是引导分类器将目标误判为一个特定的分类,如式(4)所示:

(4)

(5)

由式(5)可以看出,ILLC算法同样是在FGSM的基础上,通过迭代算法实现对图像的有目标攻击。

4 对抗样本防御方法

对抗样本的出现暴露了深度模型的安全隐患,引起了产业界和科研界的极大关注,促进了对深度模型鲁棒性的更进一步研究。实践证明,提升深度模型的安全性主要分为2种思路:第一是通过提升训练数据的多样性来提升模型的健壮性,在模型训练阶段就输入多样化的训练样本,能够有效地提升模型对对抗样本的识别和防御能力;第二是在初始深度模型的基础上增加更深的或更复杂的附加网络,使网络特征提取能力更强,采用多样化的损失函数获得更有效的防御效果。

本文根据实际场景需求,在攻防验证平台中集成了基于输入变换、对抗训练等抵御对抗攻击的防御接口,为研究者提供提升深度模型鲁棒性的防御方法。主要包括鲁棒训练、输入变换、随机化、模型集成和认证防御。研究者可以直接调用数据变换算法实现对自定义数据集的增强。针对深度模型的鲁棒性,本系统提供了基于鲁棒训练、基于输入变换的预训练方法及自定义训练方法接口。

4.1 基于输入变换的数据增强

对抗样本通过混淆识别模型在分类过程中的决策边界,使深度模型在未被更改的情况下生成错误的输出。因此,为了提高深度模型自身的鲁棒性,优化的一个方向是将图像中的决策边界进行拓展。攻击者对拓展后的图像实施攻击时,无法轻易找到目标的决策边界从而难以实现对模型的攻击。

对图像进行模糊处理可以有效地消除对抗噪声。通过采用平滑滤波函数计算卷积核对应的权重,然后进行卷积操作。高斯模糊是一种常用的数据平滑技术,采用高斯分布作为滤波函数,对输入图像中的每个像素值邻域进行加权平均,使处理后的像素趋近于其邻域。处理函数如下:

(6)

式中,高斯核μ表示像素点受邻域影响范围;标准差σ表示当前点受影响的大小。在一维高斯函数的基础上,为了处理图像,需要将其扩展为二维的高斯函数,公式如下:

(7)

式中,dx,dy表示当前像素横坐标和纵坐标到卷积核中心的距离。在此基础上,Kurakin等[4]在实验中将在打印、拍摄和裁剪图像的过程对图像进行多种组合变换,也能获得显著的鲁棒性提升。

在本平台的实现技术中,对图像进行多种变换操作,包括亮度、模糊、JPEG编码以及饱和度的变化等,帮助安全人员测试不同的防御手段,效果如图3所示。

图3 使用高斯模糊、饱和度、亮度处理图像Fig.3 Processing images with Gaussian blur,saturation and brightness

4.2 对抗训练

针对对抗样本带来的安全性问题,Goodfellow 等[3]提出了对抗训练的概念,其核心思想是通过数据增强的方式,将对抗样本作为训练集的一部分,使深度模型在训练过程中改变决策边界,这种方法不但提高了深度模型对对抗样本攻击的防御能力,也提升了对其他原始数据的泛化能力。

2014年Goodfellow等提出在训练模型的过程中加入FGSM生成的样本,用以增强模型的鲁棒性,但是单次构造过程无法生成最优的对抗样本。Madry等[13]提出Min-Max最优化对抗训练模型,将之简化理解为式(8),也就是使模型对于对抗样本的损失函数最小化:

minself.loss(self.attack(x))。

(8)

能够符合式(8)的解决方案是鲁棒的分类器或较弱的攻击,因此理论上只要攻击手段越强,得到的分类器对对抗样本的防御作用越强。

Tramèr等[14]认为Madry等[13]的操作会导致对抗训练模型对于某种攻击过拟合,产生了梯度遮掩[15]效果。即当模型F对于某种攻击A过拟合后,模型F对于A攻击产生的loss只会增大得更缓,而使用其他攻击或迭代攻击B时,模型F对于B攻击产生的loss方向与攻击A不同,模型的鲁棒性只对攻击A有效。对于这种问题,Tramèr等提出集成对抗训练(Ens-AT)方法,通过分离模型F与攻击者A来防止F对于A过拟合。训练使用的对抗样本使用当前模型以及多个预训练的模型生成。

M-PGD:

(9)

ALP:

(10)

本平台提供面向防御的对抗训练模型接口,与平台集成的对抗攻击方法或自定义攻击方法进行测试。通过平台的标准测试环境,衡量深度模型在通过加入对抗样本数据集来限制梯度,加强对模型梯度的可解释性研究,提高了模型的鲁棒性。

5 实验与结果分析

5.1 实验设置

本文实现的平台围绕对抗样本的生成与防御,提供了标准验证测试环境。平台集成了公共数据集供攻防双方调用;提供经典对抗样本生成算法,测试目标深度模型的鲁棒性;提供了标准防御模型测试安全人员自定义攻击方法的攻击效率。下面将从这3个方面介绍本平台的功能和性能。

实验数据集:本平台中运行的对抗样本生成算法和防御模型采用公共的标准数据集。MNIST,CIFAR10以及ImageNet[17]是计算机视觉中常用的数据集,包含的分类和多样性可以满足大多数攻击算法的强度验证。本平台中的算法从ImageNet数据集包含的1 000个分类中随机抽选100个分类,从中再随机选择1 000张图片,用于基线检测数据生成和对抗样本生成。

目标深度模型:本平台集成了AlexNet,GoogLeNet,MobileNet_v2以及ResNet18作为主干网络模型,用户可以基于这些模型实现特征提取等基本功能。AlexNet最早展示了深度学习模型在分类上相对于传统机器学习的优势。该模型虽然简单,但是在CNN中应用了ReLU,Dropout层,采用了归一化等技术,并采用GPU进行了加速。AlexNet具有易用、易配置的特性,测试人员可以迅速进行调用和部署。之后的VGG,GoogLeNet和ResNet被用作深度学习模型的基线,广泛使用于对抗样本的生成与测试。

实验设置:本攻防对抗平台中可以选择不同的超参数来配置对抗样本生成算法。如扰动强度ε,迭代次数T以及优化步长α。对于集成动量等自定义攻击方法,通过集成SDK或API接口的方式供用户调用。

5.2 模型验证及攻击验证

本平台基于数据集ImageNet分别对AlexNet,ResNet18,GoogLeNet,MobileNet_v2四个网络模型进行了预训练,供用户调用测试自定义对抗样本。本节抽取ImageNet验证集中的1 000个验证样本,在4种经典的对抗样本生成算法测试了样本攻击的准确率,计算如下:

(11)

表2中分别针对不同的骨干网络测试4种主流攻击方法,并按照式(11)计算其准确率,可以作为评价攻击成功率的标准评价指标。为了对比多种模型的鲁棒性,本平台还提供对超参数的设置验证功能。如设置扰动幅度(epsilon)超参功能,该参数用于测试攻击强度对对抗样本攻击成功率的影响。

通过平台测试了4种模型在ImageNet数据集下的4种攻击方法,如图4所示。

扰动幅度代表一次更新的攻击强度,随着扰动幅度的增加,对抗样本的攻击成功率不断升高。为降低云环境性能差异和其他因素影响,图中蓝色虚线表示模型检测纯净图像的成功率,曲线下降的越陡说明攻击越有效。在测试的4种攻击方法中,迭代攻击BIM以及ILLC能够在较低扰动幅度下取得较好的攻击效果,符合预期。

5.3 攻击迁移性验证

针对白盒攻击的对抗样本的成功率经过优化和迭代,往往能到达100%的水平。但是黑盒条件下,攻击者往往无法直接访问网络结构,而是利用攻击类似的模型训练得到的对抗样本对目标模型进行攻击。黑盒攻击依赖了对抗样本的可迁移性[18],是未来针对深度模型攻击的一个热点。

本平台提供对于不同模型的对抗样本的迁移性测试功能。对抗样本迁移性验证如表3所示。通过单步FGSM对4种模型分别生成对抗样本,并分别用4组对抗样本放进4个模型中测试攻击的迁移性,并按照式(11)计算其准确率。系统能够自动生成表3中的攻击结果统计,其中深色数据为对抗样本生成模型与被测试模型相同的组作为对照基线。

表3 对抗样本迁移性验证Tab.3 Verification of mobility of adversarial examples 单位:%

FGSM对某一模型的攻击对其他模型也有效果,一定程度地降低了模型对目标的检测成功率,因此可以得出对ImageNet数据集的模型现有方法具有一定的迁移性,但是效果十分有限。用户可以基于现有模型和数据集,测试对抗样本迁移攻击在多个模型下的攻击效果。本平台提供标准的攻击方法和防御方法,同时也可以基于平台提供的API接口调用自定义方法,对具有未知参数和数据集的黑盒攻击进行测试和评价。

5.4 防御方法验证

5.4.1 基于输入变换的防御方法

对抗样本通过计算输入的梯度对原始图像进行修改。根据算法不同,所计算出的梯度和修正不一定是最优的结果,因此Kurakin等[4]研究发现,对原始样本进行初等变换或者进行模糊化处理,会导致无法生成有效的对抗样本。本系统支持对图像进行多种变换方式,如高斯模糊、饱和度和亮度调整等,并进一步测试这些变换在面向对抗样本攻击时的表现。

本文基于5.3实验中的1 000个基于FGSM生成的对抗样本,对每种内置防御方法进行了测试。测试结果如图5和图6所示,其中横坐标为采用的变换使用方法的参数,纵坐标为正确分类类别的置信率均值。

如图5所示,随着高斯模糊的增大,准确率在持续下降,模糊本身造成检测器无法正确分类图片。卷积核为2时,实验显示网络模型的准确率都存在小幅波动,采用GoogLeNet和ResNet18模型时准确率还有提高。当模糊程度继续加深,过大的卷积核也同时影响了人眼对图像的识别,这对对抗样本的隐蔽性和可用性是一个减分项。一般情况下,攻击者希望进行各类变换后的图像对人眼来说是不可见的,或者不影响人眼的识别。

图5 高斯模糊对攻击的准确率影响Fig.5 Influence of Gaussian blur on attack accuracy

本系统针对对抗样本的安全性指标还提供了针对图像的亮度和饱和度等指标的变换操作。通过调整内置参数(自定义参数)测试对抗样本的置信度变化。

如图6所示,特定的亮度以及饱和度在特定条件下可以完全忽视对抗样本造成的影响,模型对对抗样本分类的正确率超过80%。本文利用系统内置方法对数据集中的1 000张图片进行测试,对于不同类别的图像具备一定的防御效果,但是从平台的测试数据上看,需要对特定的图片进行有针对性的优化和调整。

5.4.2 基于对抗训练的防御方法

由于对抗训练对测试环境的软硬件条件要求较高,并且不同的应用数据集有较大差异,本平台仅提供已经完成对抗训练的预训练模型的接口。根据文献[7]的研究,主流的防御方法中采用混淆梯度技术的防御方法很容易通过梯度重建的方法攻破;而基于对抗训练的防御方法则具有较高的安全性和泛化效果。

为验证Tramèr等对Madry等的PGD-AT对抗训练模型对于单一攻击会产生过拟合效果的推测,本系统使用同样的方法测试了该攻击。不同攻击方法对防御效果的影响如表4所示。

表4 不同攻击方法对防御效果的影响Tab.4 Influence of different attack methods on defense effect

由表4可以看出,对训练模型的FGSM进行优化后的Random-FGSM对模型的攻击成功率大幅提升,模型准确率由之前的55%降低到了24%,验证了Tramèr算法的有效性。

本系统提供Ens-AT[14],M-PGD以及ALP[16]三种防御方法,采用FGSM,BIM,ILLC混合的白盒攻击算法对这3种防御模型进行了攻击。各方法在ImageNet的防御效果如表5所示。

表5 对抗训练防御测试Tab.5 Defense test of adversarial training

由表5可以看出,未经对抗训练的原模型在混合攻击下仅有2.12%的准确率,而经过单步攻击训练的集成对抗训练的Ens-AT方法在混合攻击下防御效果提升非常有限,Kannan等提出更强的M-PGD攻击的对抗训练效果相较Tramèr等有小幅提升,几种方法的准确率都远低于10%。实验证明,Kannan等提出的Logit配对损失(ALP)在ImageNet上对抗单步多步混合的白盒攻击达到了较好的防御效果,检测准确率较先前方法有显著提升。安全人员在进行测试过程中,可以选择其中的方法作为基线标准。

6 结束语

云环境自身的安全问题由来已久,大量智能应用的部署使得由于模型自身的脆弱性带来一系列新的安全威胁,这已经成为限制云应用升级的一大瓶颈。本文提出建立一套可用于对抗样本的攻击和防御检测的攻防验证体系。用户可以采用系统内置的多种对抗样本生成算法测试自己的深度学习应用;也可以通过平台的接口调用自定义攻击方法,攻击平台提供的防御模型;通过平台的评估模块,用户可以对自定义的攻击方法进行评估和迭代验证。本文对内置的攻击方法、防御手段以及模型参数设置进行了验证测试,均获得与原始测试准确度接近的稳定的测试性能。安全测试人员基于本系统可以实现对自研攻击方法、防御方法以及神经网络的攻防验证测试,评估对抗样本攻击的有效性以及网络安全性。