多分支主干监督网络下的RGB-D图像显著性检测

2022-05-30王卫兵张晓琢邓强

王卫兵 张晓琢 邓强

摘要:针对现有的RGB-D图像显著性检测技术难以充分挖掘深度图像的有效信息,无法使RGB特征和深度特征有效融合的问题,提出了一种多分支主干监督网络下的RGB-D图像显著性检测方法。基于Resnet50网络获得两种图像的各层特征,利用深度改进模块从通道和空间注意力的角度提取到有用的深度特征信息。利用特征分组监督融合模块,依据卷积神经网络的理论,对RGB和深度特征从高层到底层分组进行多尺度多模态特征融合,每组融合加入上层融合结果和真值图进行监督,最终迭代得到预测显著图。通过4个具有代表性数据集上进行的实验,对比目前先进的RGB-D图像显著性检测,表明此模型平均绝对误差指标最小,在F值、E值和S值指标上均有提高,性能优于其他模型,具有良好的鲁棒性。

关键词:

RGB-D图像显著性检测;多分支主干监督网络;神经网络;注意力机制;多模态融合

DOI:10.15938/j.jhust.2022.04.006

中图分类号: TP391

文献标志码: A

文章编号: 1007-2683(2022)04-0039-07

RGB-D Image Saliency Detection Based on Multi-branch Backbone Supervised Network

WANG Wei-bing ZHANG Xiao-zhuo DENG Qiang

(1.school of computer science and technology, Harbin university of science and technology, Harbin 150080, China;

2.On Line Operation Center of Harbin Power Supply Company, Heilongjiang Electric Power Co., Ltd., Harbin 150036, China)

Abstract:Aiming at the problem that the existing RGB-D image saliency detection technology is difficult to fully explore the effective information of depth image and can not effectively integrate RGB features and deep features, an RGB-D image saliency detection method under multi-branch backbone supervision network is proposed. We obtain the layer features of RGB image and deep image based on Resnet50 network, using the deep improvement module, useful deep feature information is extracted from the perspective of channel and spatial attention. Using the feature grouping supervised fusion module, according to the theory of convolutional neural network, the RGB and deep features are grouped from high level to bottom for multi-scale and multi-modal feature fusion. Each fusion group is supervised by the upper level fusion result and truth map, and finally the predicted saliency map is obtained iteratively. Experiments on four representative data sets show that compared with the current advanced RGB-D image saliency detection model. This model has the smallest average absolute error index, improves in F value, E value and S value, has better performance than other models, and has good robustness.

Keywords:RGB-D image saliency detection; multi-branch backbone supervised network; neural network; attention mechanism; multimodal fusion

0引言

显著性目标检测技术的关键是提取目标场景中最吸引人的重要区域,近年来,许多人在计算机视觉领域探索了显著性目标检测技术,将该项技术应用于语义分割[1],图像分类[2],图像压缩[3]和图像分割[4]等领域。在过去几年里,已经提出了各种基于RGB-D图像的显著性目标检测模型,微软Kinect等深度传感器的出现也提升了对深度图像的捕获。但目前的显著性目标检测方法和技术仍然存在不足。

RGB-D图像中RGB图像与深度图像是成对出现的,RGB图像提供详细的颜色纹理信息,深度图像则提供目标区域的形状,位置等众多空间信息。由于采集设备的限制,在数据集中会出现边缘模糊或遭受噪声干扰的低質量深度图像,如何克服其造成的影响,从中获取有用的特征信息成为提升显著性检测性能的关键之一。JL-DCF[5]网络将深度图像视为彩色图像的特殊情况,使用共享的 CNN 进行特征提取;DPANet[6]网络使用深度感知模块来评估深度图的潜力并减少污染的影响;D3Net[7]网络提出了深度过滤单元,过滤掉影响性能的深度图像。

当从RGB图和深度图中捕获到高质量的多尺度特征时,如何将其有效融合以获得高水平的显著图也是当前探索显著性检测技术的热点问题。CPFP[8]模型提出了流体金字塔积分模块以分层的方式融合跨模态信息;TAN[9]引入了通道式注意机制实现选择性的跨模态跨层次特征融合。这些方法从不同角度探索了如何使特征有效匹配融合,特征融合的效果决定着检测性能的高低。

针对上述问题,本文采用了一种新型的多分支主干监督网络进行RGB-D图像的显著性检测。

本文的主要贡献有:

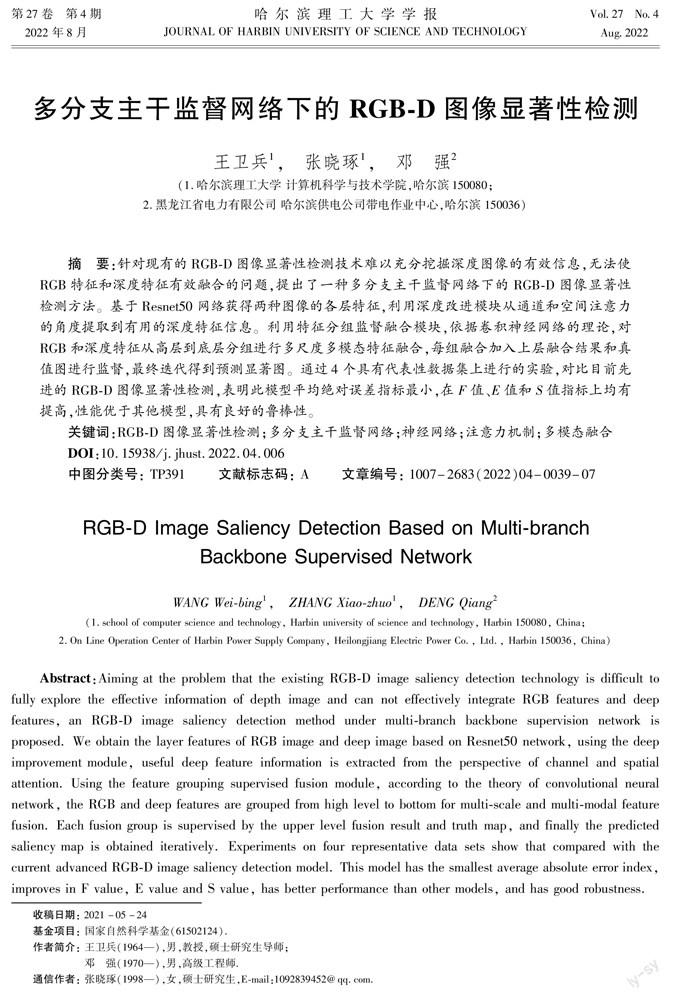

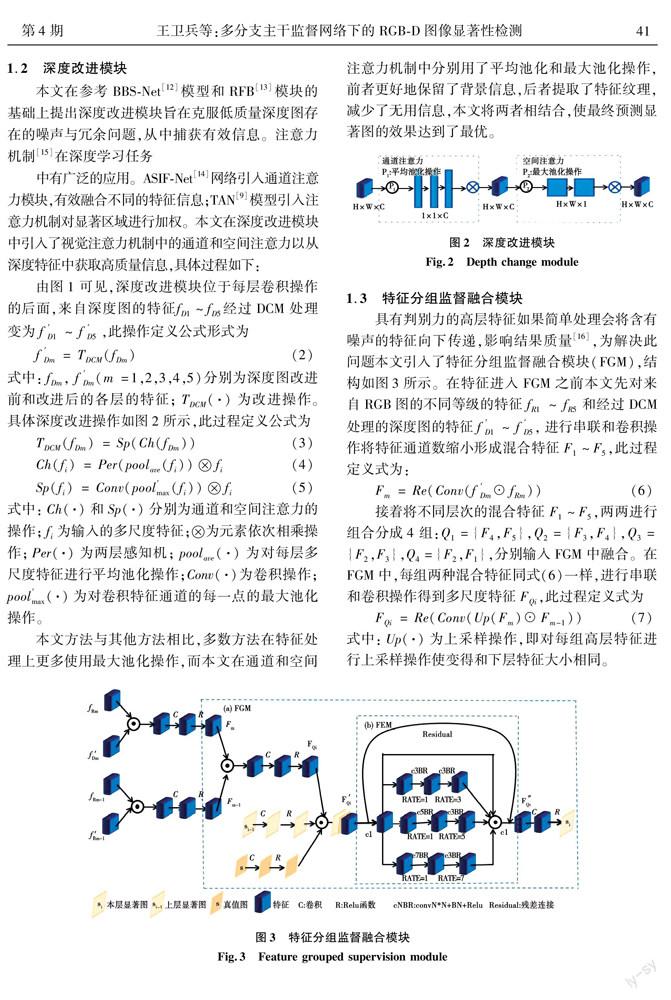

①为了尽可能全面充分融合各级有用特征,本文采用了一种多分支主干监督的网络结构对RGB-D图像进行显著性目标检测,其中,基于卷积神经网络引入特征分层监督融合模块(feature grouped supervision module,FGM),利用高层特征具有指导优化低层细节特征的特点,从高到低分组迭代监督优化结果。

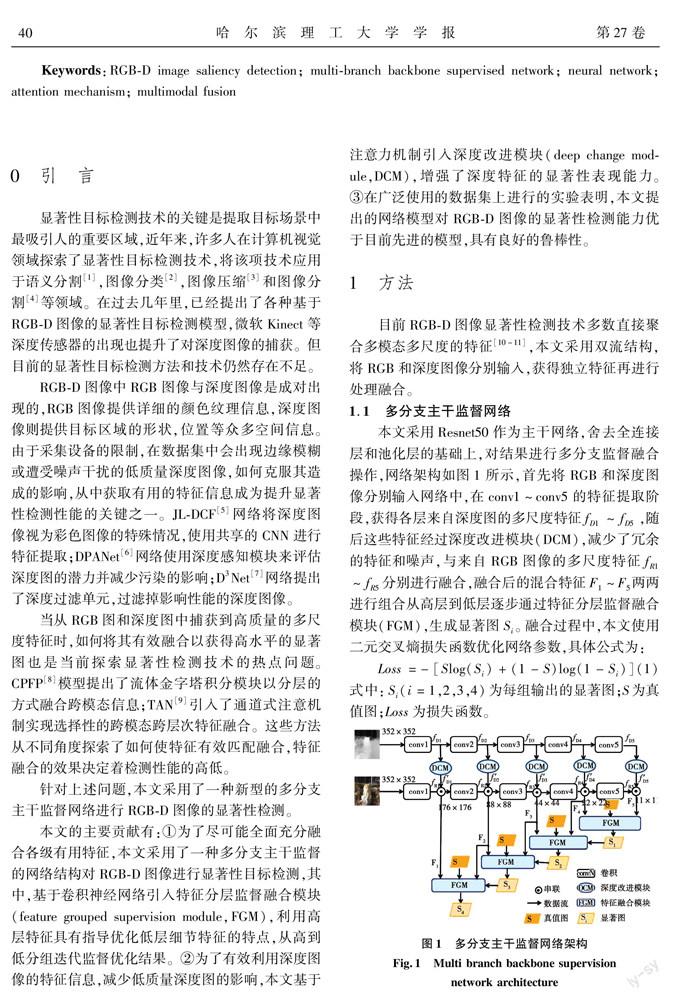

②为了有效利用深度图像的特征信息,减少低质量深度图的影响,本文基于注意力机制引入深度改进模块(deep change module,DCM),增强了深度特征的显著性表现能力。

③在广泛使用的数据集上进行的实验表明,本文提出的网络模型对RGB-D图像的显著性检测能力优于目前先进的模型,具有良好的鲁棒性。

1方法

目前RGB-D图像显著性检测技术多数直接聚合多模态多尺度的特征[10-11],本文采用双流结构,将RGB和深度图像分别输入,获得独立特征再进行处理融合。

1.1多分支主干监督网络

1.2深度改进模块

1.3特征分组监督融合模块

1.4本文模型的代碼描述

2实验

2.1数据集

2.2评价指标

2.3实验细节

本文在windows10操作系统上进行实验,使用CPU型号为英特尔酷睿I7-7700HQ,2.8GHz,GPU型号为 1080ti,应用了深度学习模型框架pytorch[25]。本文使用预训练好的ResNet50模型,同时去掉最后池化层和全连接层,学习率设为10-4,每隔50轮下降10倍,通过对图像进行翻转和边界剪裁进行数据增强操作,当批次大小设为10,模型训练迭代50次时,耗时大约6h。

2.4与先进方法对比

结果对比:本文与4种当前先进的RGB-D图像显著性检测模型CPFP[8],CTMF[26],TAN[9]和BBSNet[12]进行了实验对比,图4和图5分别展示它们在平均绝对误差(MAE)和E值上的比较,其中,MAE越小,E值越大表明模型性能越好,明显看出,本文模型在不同数据集上都取得了最高的E值和最小的MAE。对于F值和S值对比结果如表1所示,本文模型比 CPFP,CTMF,TAN和BBSNet的F值在NJU2000数据集上分别提高了3.34%、6.04%、6.16%和 0.45%,在其他数据集上也有不同程度的提高;对于S值,本文模型也高于其他模型。综合以上数据,可得本文模型显著性检测效果良好,评价指标整体结果优于其他模型,具有一定竞争力。

可视化对比:如图6所示,展示不同影响检测结果情况下各模型输出的显著图。图6中第1行图像是在普通背景下检测单目标物体,可以看出本文模型识别出的物体边缘更清晰;第2行图像是在受光线干扰情况下识别物体,光线反射易造成图像原本颜色或形状改变,本文模型能够有效克服其带来的影响,更好识别目标物体;第3行图像是在复杂场景下对多物体进行识别,本文模型能够清晰地检测出所有物体;第4行图像是在低对比度场景中识别物体,本文模型充分利用深度图像的有用特征,取得了可靠结果。

2.5特征分组监督融合模块实验对比

对特征分组融合监督模块的有效性进行检测,视觉结果如图7所示,其中,图7(a)是仅使用简单卷积操作的NFGM(no feature grouped supervision module,NFGM)算法各层所得,图7(b)是本文模型在FGM融合的各阶段生成的显著图S1~S4,可以明显看到目标物体边缘逐层开始清晰,最后得到了效果良好的结果图;NFGM算法各层输出的显著图与本文模型输出的显著图对应相比,目标物体轮廓模糊,有明显的冗余特征,再结合表2数据,本文模型各项评价指标都远优于NFGM算法。故从视觉和评价标准两方面来看,本文引入的特征分组监督融合模块高质量完成了特征的融合,提升了模型的显著性检测性能。

2.6深度改进模块实验对比

对深度改进模块有效性进行实验对比,实验结果如表3所示,其中,NDCM(no depth change module,NDCM)是未对深度图像做增强处理的算法,可以看出本文算法各性能指标均优于NDCM算法,表明深度信息能够显著提升模型的性能,带来很多增益,为目标检测提供空间信息细节上的指导。

3结语

本文基于卷积神经网络,提出了一种多分支主干监督网络框架,引入深度改进模块和特征分组监督融合模块,以从高到低迭代优化的方式输出显著性预测结果。本文模型在4个具有代表性的数据集上均达到了良好的效果,具有较强的鲁棒性。在未来工作中,可以开发一种端到端的框架,实现深度模块改进与多模态特征融合同步完成,加强关联性研究。

参 考 文 献:

[1]SU W, WANG Z F. Widening Residual Refine Edge Reserved Neural Network for Semantic Segmentation[J]. Multimedia Tools and Applications, 2019, 78(13):18229.

[2]陳宇,周雨佳,丁辉. 一种XNet-CNN糖尿病视网膜图像分类方法[J].哈尔滨理工大学学报,2020,25(1):73.CHEN Yu,ZHOU Yujia,DING Hui. An XNet-CNN Diabetic Retinal Image Classification Method[J].Journal of Harbin University of Science and Technology,2020,25(1):73.

[3]GUO Chenlei , ZHANG Liming. A Novel Multiresolution Spatiotemporal Saliency Detection Model and its Applicationsin Image and Video Compression[J]. IEEE Transaction son Image Processing, 2010, 19(1): 185.

[4]朱素霞,祖宏亮,孙广路. 一种基于空间信息的FSICM图像分割算法[J].哈尔滨理工大学学报,2020,25(4): 101.ZHU Suxia, ZU Hongliang, SUN Guanglu. Image Segmentation Algorithm Named FSICM Based on Spatial Information[J]. Journal of Harbin University of Science and Technology,2020,25(4): 101.

[5]FU K, FAN D P, JI G P , et al. JL-DCF: Joint Learning and Densely-Cooperative Fusion Framework for RGB-D Salient Object Detection [C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).Seattle, WA, USA, 2020,11(3):404.

[6]CHEN Z, CONG R, XU Q, et al. DPANet: Depth Potentiality-Aware Gated Attention Network for RGB-D Salient Object Detection[C]// IEEE Transactions on Image Processing, 2020,24(8):3736.

[7]FAN D P, LIN Z, ZHANG Z, et al. Rethinking RGB-D Salient Object Detection: Models, Data Sets, and Large-Scale Benchmarks[C]//IEEE Transactions on Neural Networks and Learning Systems, 2020,11(36):325.

[8]ZHAN J, CAO Y, FAN D, et al. Contrast Prior and Fluid Pyramid Integration for RGBD Salient Object Detection[C]// 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Long Beach, CA, USA, 2019,29(3):2925.

[9]CHEN H, LI Y. Three-Stream Attention-Aware Network for RGB-D Salient Object Detection[J]. IEEE Transactions on Image Processing, 2019, 28(6): 2825.

[10]ZHU C, CAI X, HUANG K, et al. PDNet: Prior-Model Guided Depth-Enhanced Network for Salient Object Detection[C]//2019 IEEE International Conference on Multimedia and Expo (ICME). Shanghai China, 2019,36(7):199.

[11]CHEN S, TAN X, WANG B, et al.Reverse Attention-Based Residual Network for Salient Object Detection[J]. IEEE Transactions on Image Processing, 2020, 29 (1): 3763.

[12]FAN D P, ZHAI Y J, BORJI A, et al. BBS-Net: RGB-D Salient Object Detection with a Bifurcated Backbone Strategy Network[J]. Computer Vision-ECCV,2020, 12357(1): 275.

[13]LIU S, HUANG D, WANG Y. Receptive Field Block Net for Accurate and Fast Object Detection[C]//ECCV. 2018,33(1):404.

[14]LI C. ASIF-Net: Attention Steered Interweave Fusion Network for RGB-D Salient Object Detection[J]. IEEE Transactions on Cybernetics, 2021, 51(1): 88.

[15]孙广路,吴猛,邱景,等.针对长视频问答的深度记忆融合模型[J].哈尔滨理工大学学报,2021,26(1):1.SUN Guanglu,WU Meng,QIU Jing, et al.Deep Memory Fusion Model for Long Video Question Answering[J].Journal of Harbin University of Science and Technology,2021,26(1):1.

[16]刘政怡,段群涛,石松,等.基于多模态特征融合监督的RGB-D图像显著性检测[J].电子与信息学报,2020,42(4):997.LIU Zhengyi, DUAN Quntao,SHI Song, et al. RGB-D Image Saliency Detection Based on Multi-modal Feature-fused Supervision[J].Journal of Electronics and Information Technology, 2020,42(4):997.

[17]JU R, GE L, GENG W, et al.Depth Saliency Based on Anisotropic Center-surround Difference[C]// 2014 IEEE International Conference on Image Processing (ICIP). Paris, France, 2014,7025(22):1115.

[18]PENG H W, LI B, XIONG W H, et al. RGB-D Salient Object Detection: A Benchmark and Algorithms[C]// Computer Vision-ECCV,2014,45(33):92.

[19]LI G, ZHU C. A Three-Pathway Psychobiological Framework of Salient Object Detection Using Stereoscopic Technology[C]// 2017 IEEE International Conference on Computer Vision Workshops (ICCVW). Venice, Italy, 2017,18(9):783.

[20]LI N, YE J, JI Y, et al. Saliency Detection on Light Field[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 8(39):1605.

[21]KRAHEN P. Saliency Filters: Contrast Based Filtering for Salient Region Detection[C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2012,3(46):733.

[22]ACHANTA R, HEMAMI,S, Estrada F, et al. Frequency-tuned Salient Region Detection[C]//Proceedings of the IEEE conference on Computer Vision and Pattern Recognition,2009,4(13):1597.

[23]BORJI A, CHENG M, JIANG H, et al. Salient Object Detection: A Benchmark[J]. IEEE Transactions on Image Processing, 2015, 12(24): 5706.

[24]FAN D, CHENG M, LIU Y, et al. Structure-Measure: A New Way to Evaluate Foreground Maps[C]//2017 IEEE International Conference on Computer Vision (ICCV). Venice, Italy, 2017,34(6):4598.

[25]STEINER B, DeEVITO Z, CHINTALA S, et al. PyTorch: An Imperative Style, Highperformance Deep Learning Library[C]// NIPS, 2019,48(3):8024.

[26]HAN J, CHEN H, LIU N, et al.CNNs-Based RGB-D Saliency Detection via Cross-View Transfer and Multiview Fusion[J]. IEEE Transactions on Cybernetics, 2018, 11 (48): 3171.

(編辑:温泽宇)