改进YOLOv4算法的袋料香菇检测方法

2022-05-30黄英来李大明吕鑫杨柳松

黄英来 李大明 吕鑫 杨柳松

摘要:为探索对袋料栽培香菇的机械式采摘,提出一种基于改进YOLOv4的识别算法。主要改进方法为:在PANet(Path Aggregation Network)结构中,增加一条具有残差注意力机制的特征图路径,提高对小目标的识别精度,并用深度可分离卷积结构替换PANet网络中卷积层,降低了参数量。使用Focal loss损失函数改进原置信度损失函数。在数据预处理方面,采用gamma变换方法对数据进行增强扩充。在训练过程中利用迁移学习的思想,对主干网络载入VOC数据集的预训练权重。相比原YOLOv4算法,mAP值增加了4.82个百分点,达到94.39%,算法参数量降为原来的58.13%,算法更加高效和轻量化,为机械采摘提供视觉算法支持。

关键词:YOLOv4;目标检测;gamma变换;迁移学习;香菇采摘

DOI:10.15938/j.jhust.2022.04.004

中图分类号: TP391.4

文献标志码: A

文章编号: 1007-2683(2022)04-0023-09

A Detection Method of Lentinus Edodes Based

on Improved YOLOv4 Algorithm

HUANG Ying-lai,LI Da-ming,L? Xin,YANG Liu-song

(Collegeof Information and Computer Engineering, Northeast Forestry University, Harbin 150040, China)

Abstract:In order to explore the picking of Lentinus edodes which are cultivated in bags, a recognition algorithm based on improved YOLOv4 is proposed. The main improvement measures are: in the structure of PANet (Path Aggregation Network), we add a feature map path with residual attention mechanism to improve the recognition accuracy of small targets, and replace the convolution layer in PANet network with deep separable convolution structure to reduce the amount of parameters. Focal loss is selected to improve the original confidence loss function. In the aspect of data preprocessing, gamma transform method is used to enhance and expand the data. In the training process, the idea of transfer learning is used to load the pre training weight of VOC data set on the backbone network. Compared with the original YOLOv4 algorithm, the mAP value is increased by 4.82 percentage points to 94.39%, and the amount of algorithm parameters is reduced by 58.13%. The algorithm is more efficient and lightweight, providing visual algorithm support for mechanical picking.

Keywords:YOLOv4; target detection; gamma transform; transfer learning; lentinus edodes picking

0引言

香菇是一種普遍的食用菌,袋料培育技术[1]是目前木屑栽培技术的主要方法之一。通过实地调查,香菇的采摘主要依靠人力,采摘过程繁琐且劳动强度大,且香菇在生长条件适宜时,出菇量猛增,若不及时采摘会使香菇过大,而香菇生长过大会降低香菇自身品质。过大的香菇的收购价格也远低于标准级香菇,对种植户造成一定经济损失,机械式采摘[2]不但可以节省人力,降低种植户的生产成本,提高香菇出菇峰值期的采摘效率,而且可以扩大香菇种植业,并使其向智能农业、现代农业方向发展,具有很好的实际应用价值。

为探索对食用菌的开发利用,近几年来利用计算机视觉对于食用菌的辨识研究从未中断。2014年Chen等[3]提出基于纹理特征和聚类方法的香菇品质分选方法,香菇类型分选模型的分选正确率可达到 93.57%。2015年Xu等[4]提出基于显著性分割算法实现对食用菌杂质的自动提取,算法在光照不均匀条件下的识别率仍达到99.6%。2016年Liu等[5]提出基于红外光谱技术和支持向量机的野生蘑菇近红外识别模型,正确识别率为95.3%。2020年Lin等[6]利用图像处理技术,提取融合野生菌菇的颜色和形态特征,实现食用菌种类的识别,识别率达到90.87%。上述研究方法利用传统的机器视觉处理方法,人工设计提取特征,部分方法虽取得较高检测精度,但方法并不具有通用性和复杂环境下的鲁棒性。

基于卷积神经网络的机器视觉辨识研究,通过神经网络进行监督训练,自动学习分类特征,取得了较高的准确率[7-8]。而基于卷积神经网络的目标检测算法(如SSD[9],Efficientdet[10] ,Faster RCNN[11],Centernet,YOLO系列等),也为目标检测提供较高的精度。Liu等[12]提出改进SSD的田间行人检测模型,使用MobileNetV2[13]作为基础网络,以反向残差结构结合空洞卷积作为基础结构进行位置预测,准确率达到了97. 46%。Xiang等[14]提出改进Faster RCNN的铝材表面缺陷检测方法,在主干网络加入特征金字塔网络(FPN)结构以加强对小缺陷的特征提取能力,使用区域校准(ROI Pooling)算法来代替区域池化算法,获得更准确的缺陷定位信息,实验表明,改进后的网络对铝材表面缺陷检测的平均精度均值为91.20%。Zhu等[15]提出基于改进Efficientdet的端子线芯检测算法,利用K-means多维度聚类算法对线芯边界框聚类,生成锚框,利用梯度均衡机制重构损失函数,精度均值达96.2%。Deng等[16]提出改进YOLOv3[17]的交通标志检测方法,引入改进的空间金字塔池化结构,优化多尺度预测网络,选取CIoU作为损失函数,平均精度可达94.8%。上述目标检测算法的改进也为食用菌的机器视觉辨识提供了新的方法。YOLOv4算法[18]在相近的参数量下,表现较高的准确率。本文提出基于YOLOv4的香菇机器视觉识别算法,为香菇的机械采摘提供视觉算法支持。

1YOLOv4算法介绍

1.1网络结构方面

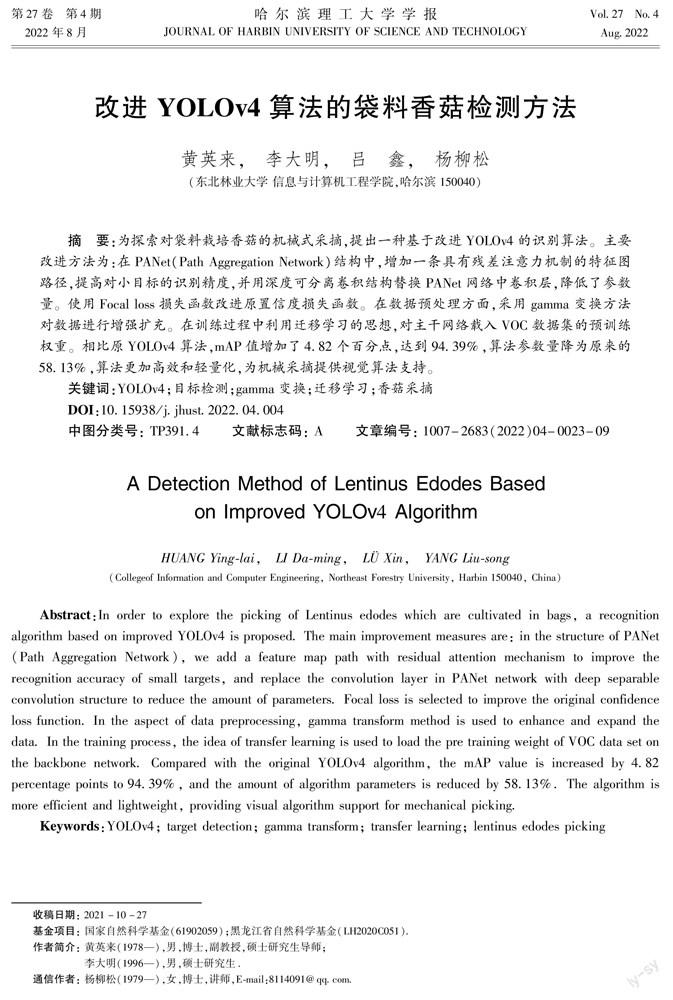

首先在主干网络嵌入表征能力更强CSP(Cross Stage Paritial Network)结构进行特征图提取,如图1所示。其中,每个CSP结构是以CBM结构为基本单元组合构成的残差结构,而每个CBM结构由1个卷积层,1个归一化层和1个Mish函数激活层堆叠而成:

其次,使用SPP结构(spatial pyramid pooling layer)将特征图通过并列的3个不同池化层进行池化,最后通过残差边进行拼接。接着,将所得到的三组不同尺寸的特征图送入PANet结构,输出拥有全局语义信息的特征图。

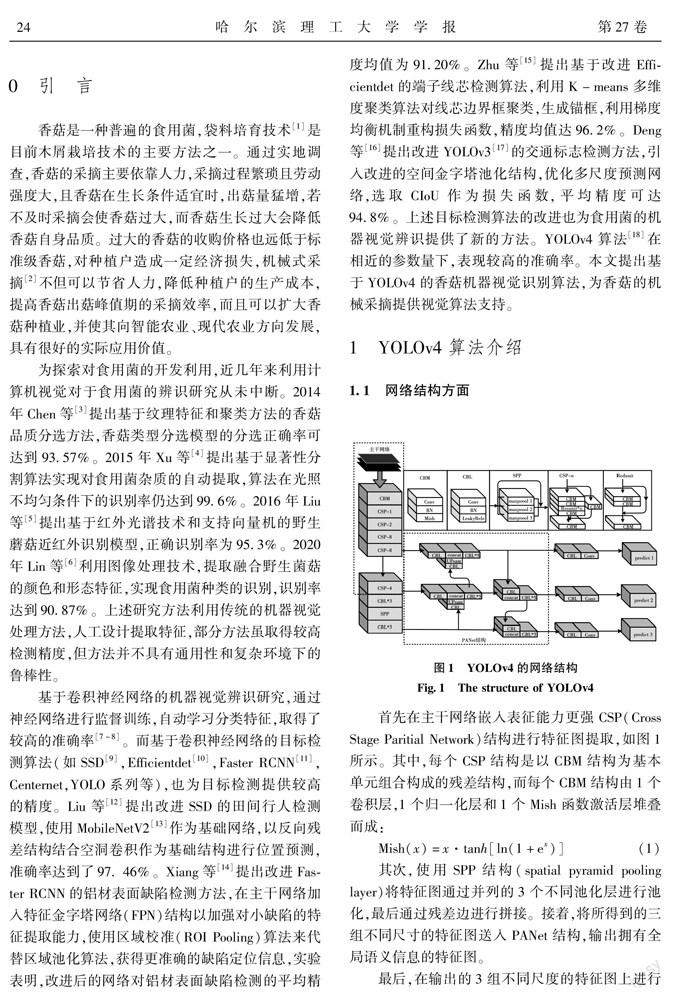

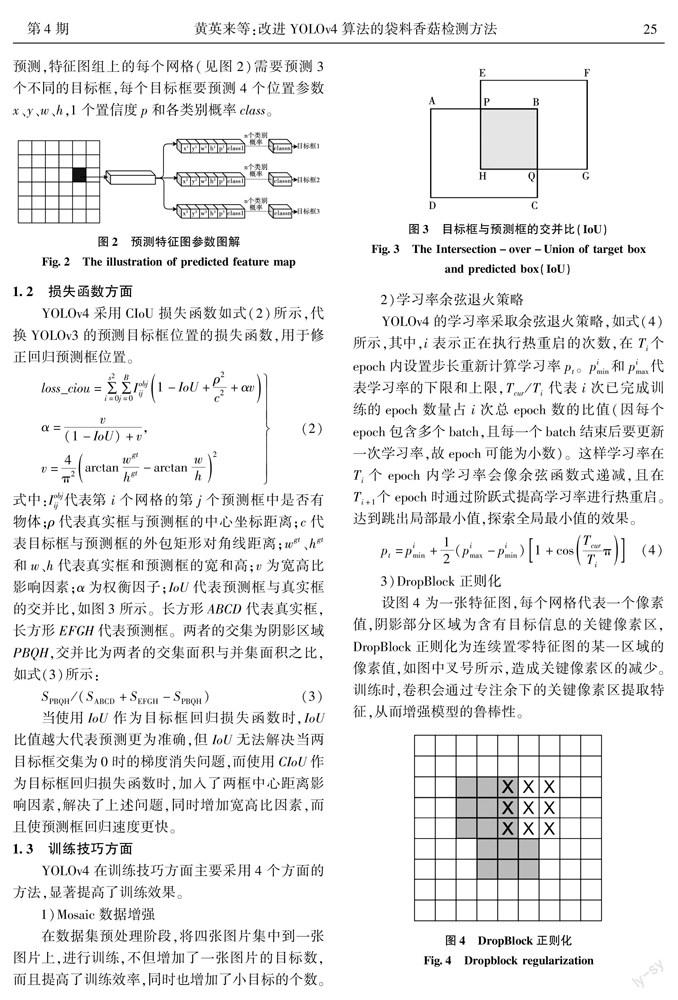

最后,在输出的3组不同尺度的特征图上进行预测,特征图组上的每个网格(见图2)需要预測3个不同的目标框,每个目标框要预测4个位置参数x、y、w、h,1个置信度p和各类别概率class。

1.2损失函数方面

1.3训练技巧方面

2YOLOv4算法改进

2.1深度可分离卷积网络轻量化

2.2残差注意力机制与PANet特征融合

2.3单目标损失函数

3进行实验与结果分析

3.1实验环境

实验所用硬件环境为Intel(R) Core(TM) i5-10300H CPU,NVIDIA Geforce GTX 1660Ti GPU,内存大小为16g。软件环境为Windows 10操作系统,使用pytorch 1.2框架,cuda 10.1,cudnn 7.6.4,python版本3.7.1。

3.2研究方法

3.3结果对比与分析

4结论

本文提出一种改进YOLOv4算法的香菇机器视觉检测方法,通过增加一条具有残差注意力机制的特征图路径,使用Focal loss损失函数改进损失函数,以及使用迁移学习的训练方法,提高了网络的检测精度。其次,在部分非主干网络中,利用深度可分离卷积层替换原卷积层,减少了算法参数量。上述方法在对比实验中被证明有效,且与当前主流的几种目标检测方法的相比,检测精度较高,但检测速度还是有进一步提升的空间,这依赖于方法的改良与网络结构的改进,后续的研究将注重在算法的检测精度值不下降的基础上,进一步减小参数规模和提高检测速度,以方便嵌入式设备的部署。

参 考 文 献:

[1]肖德清, 史向阳. 大棚层架式袋料香菇栽培技术[J].现代农业科技,2013(7):109.XIAO Deqing, SHI Xiangyang. Cultivation Techniques of Lentinus Edodes in Greenhouse with Bagged Materials[J]. Modern Agricultural Science and Technology, 2013(7):109.

[2]高文硕, 宋卫东, 王教领, 等. 果蔬菌采摘机械研究综述[J].中国农机化学报,2020,41(10):9.GAO Wenshuo, SONG Weidong, WANG Jiaoling, et al. Review of Fruit and Vegetable Fungus Picking Machinery[J]. China Journal of Agricultural Machinery Chemistry, 2020,41 (10): 9.

[3]陈红, 夏青, 左婷, 等. 基于纹理分析的香菇品质分选方法[J].农业工程学报,2014,30(3):285.CHEN Hong, XIA Qing, ZUO Ting, et al. Quality Sorting Method of Lentinus Edodes Based on Texture Analysis[J]. Journal of Agricultural Engineering, 2014,30(3): 285.

[4]徐振驰, 纪磊, 刘晓荣, 等. 基于显著性特征的食用菌中杂质检测[J].计算机科学,2015,42(S2):203.XU Zhenchi, JI Lei, LIU Xiaorong, et al. Detection of Impurities in Edible Fungi Based on Significance Characteristics[J]. Computer Science, 2015,42(S2):203.

[5]刘洋, 王涛, 左月明. 基于支持向量机的野生蘑菇近红外识别模型[J].食品与机械,2016,32(4): 92.LIU Yang, WANG Tao, ZUO Yueming. Near Infraredrecognition Model of Wild Mushrooms Based on Support Vector Machine[J]. Food and Machinery, 2016,32(4):92.

[6]林楠, 王娜, 李卓识, 等. 基于机器视觉的野生食用菌特征提取识别研究[J].中国农机化学报,2020,41(5):111.LIN Nan, WANG Na, LI ZhuoZhi, et al.Research on Feature Extraction and Recognition of Wild Edible Fungi Based on Machine Vision[J]. China Journal of Agricultural Machinery Chemistry, 2020,41(5):111.

[7]王卫兵, 王卓, 徐倩, 等. 基于三维卷积神经网络的肺结节分类[J].哈尔滨理工大学学报,2021,26(4): 87.WANG Weibing, WANG Zhuo, XU Qing, et al. Classification of Pulmonary Nodules Based on Three Dimensional Convolutional Neural Network[J]. Journal of Harbin University of Science and Technology, 2021,26(4):87.

[8]毕蓉蓉, 王进科. CT图像下结合RCNN与U-Net的肺实质自动分割方法[J].哈尔滨理工大学学报,2021,26(3):74.BI Rongrong, WANG Jinke. Lung Consolidation Combined with RCNN and U-net under CT Images Automatic Mass Segmentation Method[J]. Journal of Harbin University of Science and Technology, 2021,26(3):74.

[9]LIU W, ANGUELOV D, ERHAN D, et al. SSD:Single Shot MultiBox Detector[C]//Computer Vision-ECCV 2016. Cham, 2016: 21.

[10]TAN M, PANG R, LE Q V. EfficientDet: Scalableand Efficient Object Detection[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). IEEE, 2020:10781.

[11]REN S Q, HE K M, GIRSHICK R, et al. Faster R-CNN:Towards Real-time Object Detection with Region Proposal Networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2017,39(6):1137.

[12]劉慧, 张礼帅, 沈跃, 等. 基于改进SSD的果园行人实时检测方法[J].农业机械学报,2019,50(4):29.LIU Hui, ZHANG Lishuai, SHEN Yue, et al. Real Time Detection Method of Orchard Pedestrian Based on Improved SSD[J]. Journal of Agricultural Machinery,2019,50(4):29.

[13]SANDLER M, HOWARD A, ZHU M , et al. MobileNetV2:Inverted Residuals and Linear Bottlenecks[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). IEEE, 2018.

[14]向宽, 李松松, 栾明慧, 等. 基于改进Faster RCNN的铝材表面缺陷检测方法[J]. 仪器仪表学报,2021,42(1):191.XIANG Kuan, LI Songsong, LUAN Minghui, et al. Based on Improved Faster RCNN′s Aluminum Surface Defect Detection Method[J]. Journal of Instrumentation,2021,42(1):191.

[15]朱世松, 孙秀帅. 基于改进EfficientDet的线束端子线芯检测算法[J/OL].激光与光电子学进展:116[2022-01-18].http://kns.cnki.net/kcms/detail/31.1690.TN.20210806.1548.017.html.ZHU Shisong, SUN Xiushuai. Based on Improved Efficient Det′s Wire Harness Terminal Core Detection Algorithm[J/OL].Laser and Optoelectronics Scientific Progress:1[2022-01-18].http://kns.cnki.net/kcms/detail/31.1690.TN.20210806.1548.017.html.

[16]邓天民, 周臻浩, 方芳, 等. 改进YOLOv3的交通标志检测方法研究[J]. 计算机工程与应用,2020,56(20):28.DENG Tianmin, ZHOU Zhenhao, FANG Fang, et al. Improve the Traffic Sign Inspection of YOLOv3 Study on Measurement Methods[J]. Computer Engineering and Application, 2020,56(20):28.

[17]REDMON J, FARHADI A. YOLO v3:an Incrementalimprovement[R]. arXiv:1804. 02767v1,2018.

[18]BOCHKOVSKIY A, WANG C Y. YOLOv4: Optimal Speed and Accuracy of Object Detection[J/OL]. arXiv:109342020.http://arxiv.org/abs/2004.10934.

[19]HE K, ZHANG X, REN S, et al. Deep Residual Learning for Lmage Recognition[C]//CVPR 2016, Las Vegas, 2016: 770.

[20]CHOLLET F. Xception: Deep Learning with Depthwise Separable Convolutions[J]. arXiv preprint arXiv:1610.02357, 2016.

[21]WOO S, PARK J, LEE J Y, et al. CBAM: Convolutional Block Attention Module[C]// Proceedings of the 2018 European Conference on Computer Vision .2018:3.

[22]LIN T Y, GOYAL P, GIRSHICK R, et al. Focal Loss for Dense Object Detection[C]// IEEE Transactions on Pattern Analysis & Machine Intelligence. IEEE, 2017:2999.

(編辑:温泽宇)