基于多模态特征融合的无人驾驶系统车辆检测

2022-03-25薛其威伍锡如

薛其威,伍锡如

(1. 桂林电子科技大学 电子工程与自动化学院, 广西 桂林 541004; 2. 广西高校非线性电路与光通信重点实验室(广西师范大学), 广西 桂林 541004)

随着人工智能和机器人技术的不断发展与深入,无人驾驶系统作为人工智能领域的一个重要分支已经成为国内外的研究热点[1-3]。无人驾驶系统通过三维车辆检测对主体实现路径规划与决策控制,其中雷达、摄像机、GPS等传感器的多模态特征融合是三维车辆检测中的重要内容[4-6]。

毫米波雷达和摄像机的多模态特征融合因其检测分辨率和精度高、抗干扰性强、感知范围广、不受光照和阴影遮挡的特性,有利于实现复杂交通环境下的无人驾驶[7-9]。因此基于多模态特征融合的车辆检测算法在过去几年里发展得较为迅速,大量优秀算法广泛应用[10-12]。

Nie等[13]利用多模态融合深度神经网络对不同模态的特征进行多通道分层,并在隐藏层提取多通道特征张量实现特征融合以预测车辆位姿、转向角以及速度。Zhang等[14]根据归一化像素距离加权平均值对点云插值处理并与像素点融合,通过注意力机制分配特征通道权重,抑制干扰通道并增强车辆特征通道信息。王肖等[15]通过随机样本一致性算法定位校准稀疏点云,提取点云结构并与像素直接对齐,避免多坐标转换以及校准的误差累积,根据图像中目标角点与点云位置匹配确定车辆位置。李明磊等[16]先将点云实时栅格化筛选路面信息,再根据道路粗粒度特性将特征拓展到扇形检测单元格减少路面纹理的干扰,最后通过八叉树的三维占用栅格融合障碍物检测结果。吴毅华等[17]采用定向包围体来描述目标障碍物并用RANSAC算法找出点云分布与方向航向角。上述算法为无人驾驶系统的障碍物检测提供了重要的参考依据,但存在精度低、多尺度车辆检测困难、遮挡车辆检测框合并等状况,因此针对多模态特征融合的车辆检测精度低与时间长的问题亟需解决[18-23]。

本文采用基于多模态特征融合的方法,通过摄像头和毫米波雷达的多模态特征融合完成车辆检测。对传感器联合标定实现时空间配准减小采样误差,加入统计滤波算法剔除点云离群点降低干扰;预处理后传入车辆检测模块,通过多模态特征融合模块结合特征金字塔对采集到的特征进行融合并提取,提升多尺度对车辆的检测精度;最后,融合特征传入检测框生成模块筛选车辆位置,使用非极大值抑制去除冗余的三维检测框,将检测框与车辆位置匹配输出三维车辆检测结果。

1 数据采集

1.1 算法框架及数据采集平台

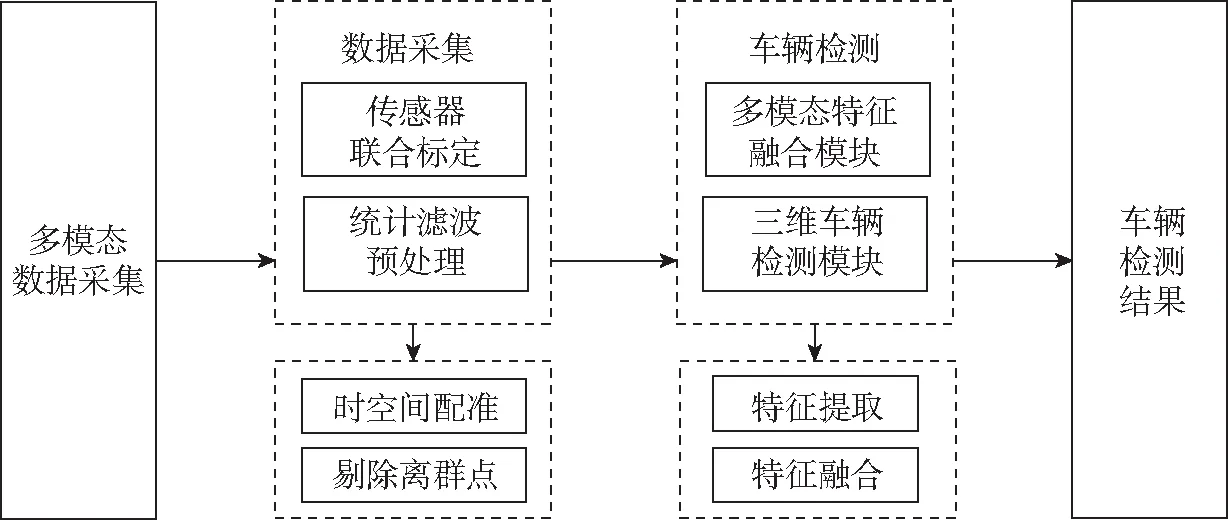

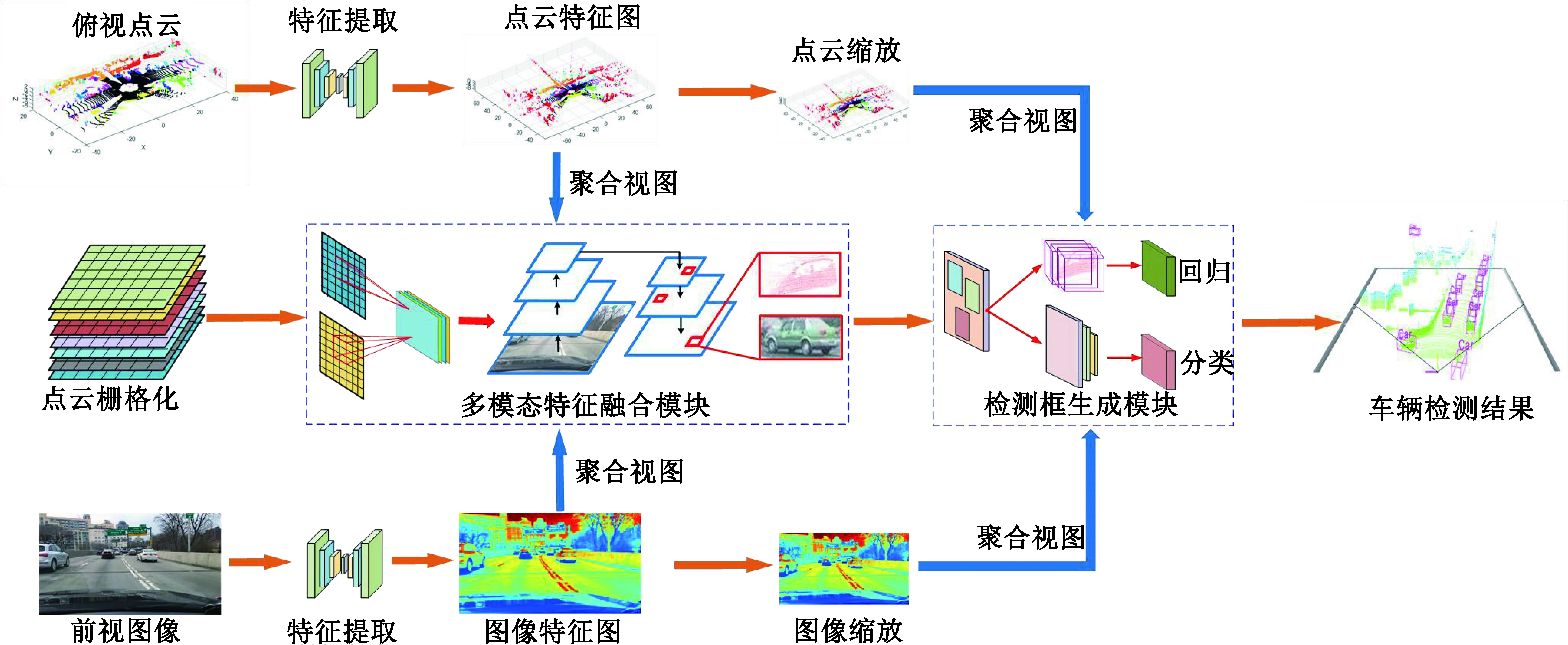

本文算法框架如图1所示,毫米波雷达与摄像机联合标定后对道路环境采集,收集点云及图像信息,将多模态数据输入车辆检测模块,融合后进行车辆检测并输出结果。

图1 车辆检测算法总体框架Fig. 1 Overall framework of vehicle detection algorithm

采用海康威视摄像机和24 GHz毫米波雷达联合对车辆进行检测。毫米波雷达通过可调螺栓固定于车辆前保险杠中央,摄像机固定于后视镜下方,如图2所示。NRA24毫米波雷达采样频率为20 Hz,每帧数据的采集时间间隔为50 ms,每秒采集20帧雷达数据;摄像机采样频率是50 Hz,每帧数据采集间隔为20 ms。

图2 传感器装配位置Fig. 2 Diagram of sensor installation

1.2 毫米波雷达和摄像机联合标定

联合标定是多模态融合的准备条件,毫米波雷达与摄像机存在不同采样频率及坐标系,因此要把传感器坐标转换到相同坐标系并时间配准才可融合。毫米波雷达和摄像机的空间标定需要找到同一时刻点云和图像中对应的像素点。

假设车体坐标系中物点P为(xl,yl,zl),对应图像坐标系中像点Q为(x,y),其像素级融合方程为

zc(x,y,1)T=K(Rc(xl,yl,zl)T+Tc)。

(1)

式中:zc为物点P在摄像机坐标系中Z轴方向的坐标;K为摄像机内部参数矩阵;Rc和Tc为摄像机外部参数,分别代表旋转矩阵和平移向量。

毫米波雷达将三维信息呈现为极坐标系的二维信息。毫米波雷达与目标径向距离为R,与中心所成角度为α,坐标系所在的平面与环境坐标系平行,且两者之间的距离为H0,则环境坐标系中的物点P的坐标(xn,yn,zn)与毫米波雷达坐标系中物点P的坐标(R,α)的相互转化关系为

(2)

联立式(1)与式(2)可得毫米波雷达坐标系与图像像素坐标系的转化关系为

(3)

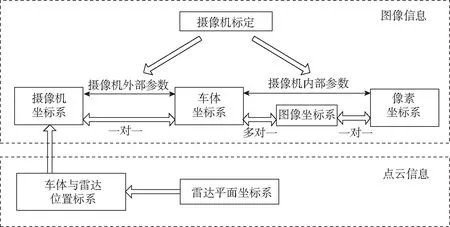

空间标定的车体坐标系和像素坐标系之间转换关系如图3所示。

图3 坐标系转换关系Fig. 3 Coordinate system conversion diagram

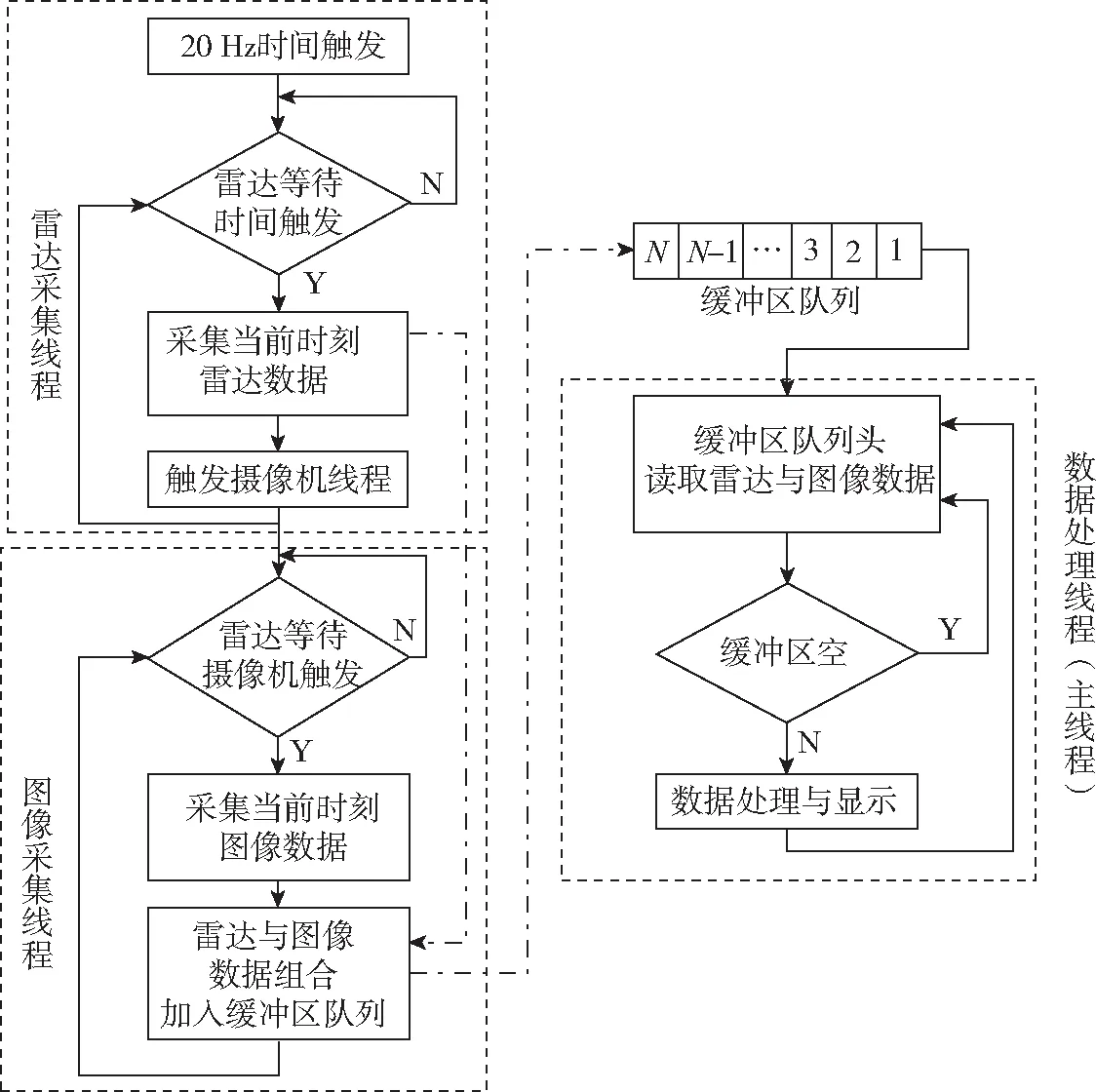

时间配准包含总数据采集、毫米波雷达数据采集和图像采集,对每一帧数据给定一个以系统时间为准的标签,将数据传输到缓冲区队列。在总数据采集中启动毫米波雷达数据采集和图像采集,以采样频率低的毫米波雷达数据为基准,每采集到1帧毫米波雷达数据则触发图像采集,从缓冲区队列中选取相同时间标签的图像数据,以实现数据的同步采集和存储,流程如图4所示。

图4 时间配准流程Fig. 4 Time registration flowchart

1.3 统计滤波预处理

毫米波雷达对目标物体扫描时,软硬件的误差使得某个点集区域内点的三维坐标产生偏移,会出现离群点,产生多余的特征信息,使算法模型训练达不到全局最优。

通过最小二乘迭代方法来估计曲率张量,并在迭代的时候根据点云周围的邻域为样本分配权重,细化每个点周围的每一个邻域。利用计算获得的曲率以及统计权重来重新校正正态分布[24]。求得全局量的最小化,并计算出曲率和法线把离群点剔除,从而较好地保持车辆点云的纹理特征。

在笛卡尔坐标系下,点云的每个点以x、y、z三维坐标形式存在。假设某个点云样本为

D={pi∈R3}i=1,2,…,n,

(4)

式中:n表示采样点云点的总个数;pi表示采样样本D中的无序点,只取每个无序点的x、y、z三维坐标。计算点的距离阈值dmax:

(5)

(6)

(7)

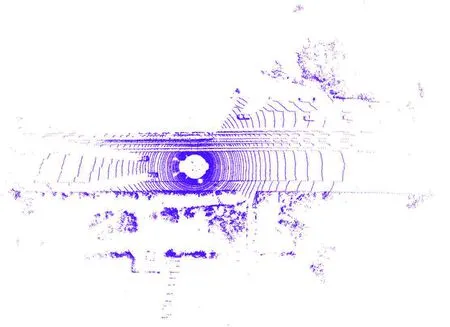

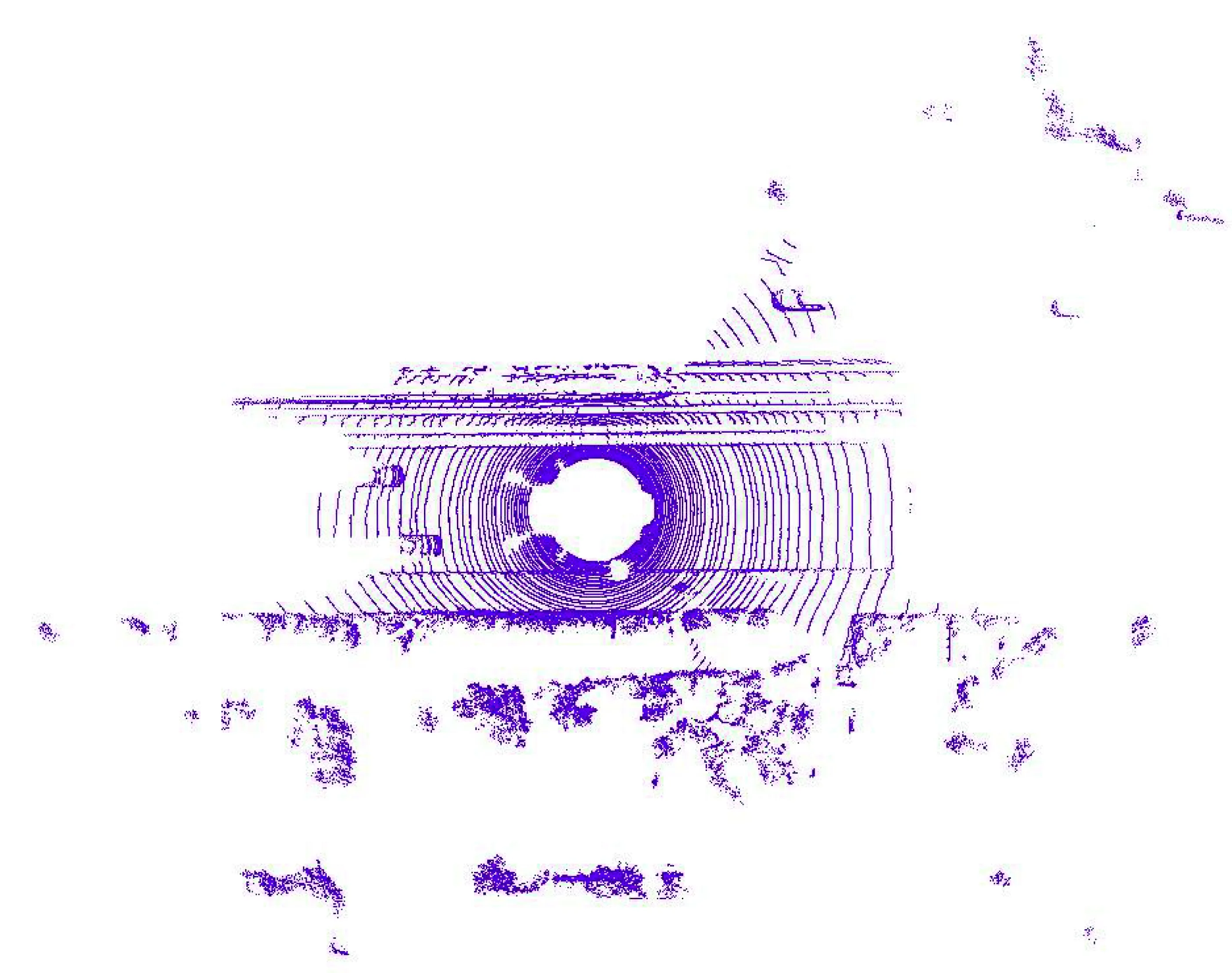

图5为点云样本的初始视图,近端点云分布分散,地面点云不清晰,远端点云在障碍物周边存在较为杂乱的离群点且分布不均,给车辆检测增加检测难度;图6为数据预处理后的视图,局部区域的点分布较为均匀,近端地面点云平整,易于后续的地面分割实现,远端点仅保留车辆及墙面点云信息,分布均匀。

图5 点云数据过滤前Fig. 5 Point cloud data before filtering

图6 点云数据过滤后Fig. 6 Point cloud data after filtering

2 三维车辆检测算法

2.1 算法总体思路

针对车辆特征的多样性和复杂性,引入深度神经网络以实现车辆检测,算法框架如图7所示。首先,将预处理后的点云与图像信息使用ResNet[25]进行特征提取;通过缩放点云和图像特征图大小,实现多视图具有相同长宽比进行特征匹配;然后,传入多模态特征融合模块对多模态特征进行逐像素平均操作,实现多模态特征融合并加入特征金字塔[26]提取高阶特征;最后,将高阶特征输入检测框生成模块,与剪裁后视图聚合生成三维车辆检测框。

图7 算法框架Fig. 7 Algorithm framework

2.2 多模态特征融合模块

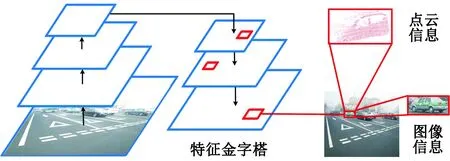

多模态特征融合模块由特征融合、特征金字塔、1×1卷积组成。将特征提取后的稀疏点云与图片匹配,同步输入特征金字塔中,实现目标特征的提取,最后通过1×1卷积降维处理。

本文采用多模态特征融合模块对输入的特征值进行剪裁实现区域选取并调整大小,将统一分辨率的多视图特征图做逐像素平均,融合点云信息与图像信息高级特征。融合图像传入特征金字塔中并进行上采样,采用横向结构将其连接至前一层特征,使特征增强,结构如图8所示。

图8 特征金字塔Fig. 8 Feature pyramid Network

P1~P5每一层输出所用特征图融合不同分辨率、不同语义强度的特征,实现对不同分辨率车辆进行检测,保证每一层都有合适的分辨率以及强语义特征,以解决车辆检测中的多尺度问题。如图9所示,由于特征金字塔在256维的特征地图上会提取10万个7×7的特征,大大增加计算量,因此在特征金字塔后方加入1×1卷积降维处理。通过1×1的卷积减少卷积核的个数,用于在不改变特征图尺寸大小的前提下减少特征数量实现降维。

2.3 检测框生成模块

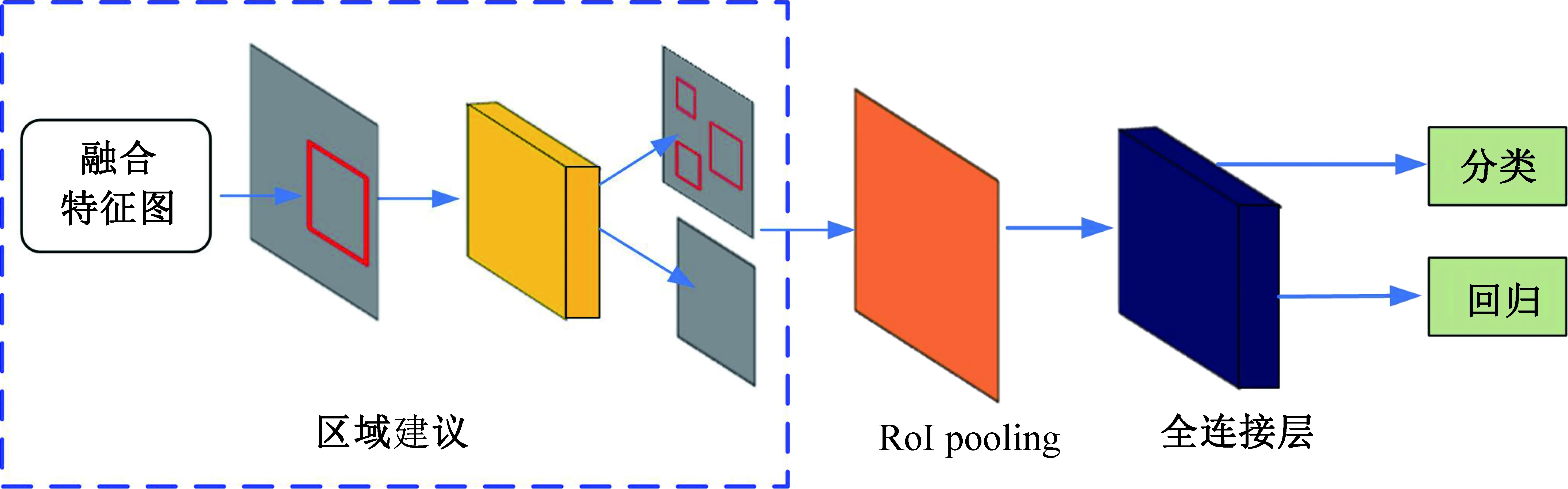

融合后的特征信息传入车辆检测模块完成回归与分类。车辆检测模块由区域建议、RoI pooling和全连接层构成。

本文提出特征融合区域建议结构,如图10所示。通过投影到栅格的俯视图与主视图融合传入区域建议生成建议特征图,RoI pooling将建议特征图缩放至7×7传入全连接层,以输出每个车辆检测框回归、方向估计和类别分类,最后使用非极大值抑制去除冗余的三维检测框。

图9 高级特征提取Fig. 9 Advanced feature extraction

图10 特征融合区域建议模块Fig. 10 Feature pyramid Network

本文采用了一个多任务损失,设计为

(8)

式中Nc与Np分别为点云点的个数和下采样后点云个数。

分类损失Lc为交叉熵损失,其中si为预测分类得分,ui为中心点i的标签。

(9)

回归损失Lr包括距离回归损失Ldist、大小回归损失Lsize。Ldist和Lsize使用SmoothL1函数使得损失函数对离群点鲁棒性更强,其中

(10)

角度损失Ls包括角损失Lcorner和角度回归损失Langle,表示如下:

(11)

(12)

为了消除重叠的检测,使用阈值为0.7的非极大值抑制删除车辆附近重叠较大的边界框。最终采用检测框顶点匹配的方式对齐减少计算参数,并利用车辆相对于地平面的偏移,得到更精确的三维矩形框定位。

2.3.2 水提工艺正交试验结果及统计分析 按照处方比例称取药材适量,根据L9(34)设计表进行9组试验,将水提液浓缩后置于已恒重的蒸发皿中,水浴浓缩蒸干,移入105℃烘箱中,干燥至恒重,取出,置干燥器中冷却30 min后,取出称重,计算浸膏得率。精密称取L9(34)试验项下1~9号浸膏样品适量,按“2.2.1”供试品溶液制备方法,进行测定,计算样品中葛根素的含量。以葛根素含量和浸膏得率为指标,将葛根素含量的权重系数设为0.8,浸膏得率设为0.2,进行统计分析。见表5~6。

3 实验结果与分析

3.1 平台及参数

本实验在TensorFlow框架下进行,计算机处理器为Intel Core i7-6700,内存32 GiB,同时使用NVIDIA GeForce RTX 2080Ti来实现GPU加速训练。学习率为0.001,在KITTI数据集[27]上训练120个周期,每个周期为1 000,衰减系数为0.8。

3.2 实验结果

为了验证改进网络模型在不同交通场景下的多目标检测能力,选择训练周期数为120的网络模型进行测试,在10%测试样本集中分类选取样本开展多组对比实验,结果如图11~14所示。

图11为自然交通场景下车辆检测结果。从检测结果可知,三维车辆检测算法能够有效实现车辆检测,检测结果与实际判定结果相符合,且目标的标定框范围较精准。

图11 自然场景实验结果Fig. 11 Natural scene experiment results

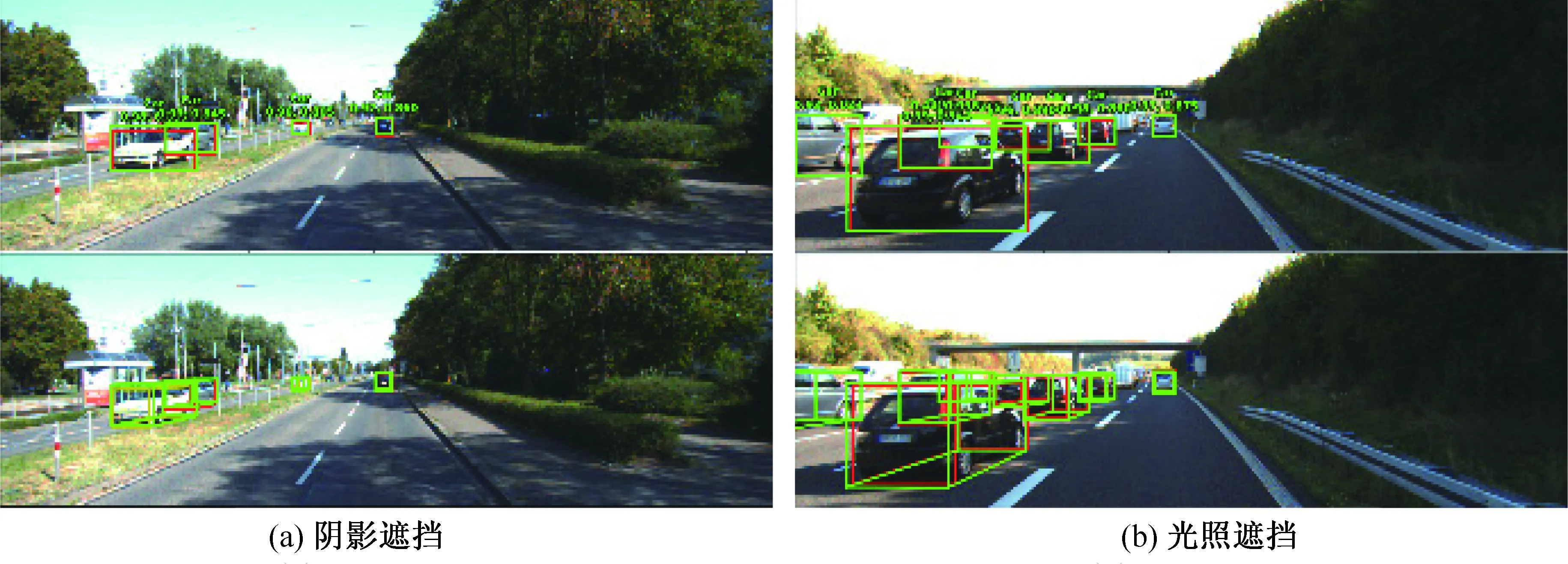

图12为光照交通场景下实验结果,图12(a)为阴影遮挡情况,图12(b)为光照遮挡情况。从图中可以看出,即使图像中车辆的摄像机受光照影响变化较大,颜色以及纹理受到干扰,但由于加入多模态特征融合使点云弥补了图像信息的缺失,本文提出的方法可以很好地完成车辆检测任务。

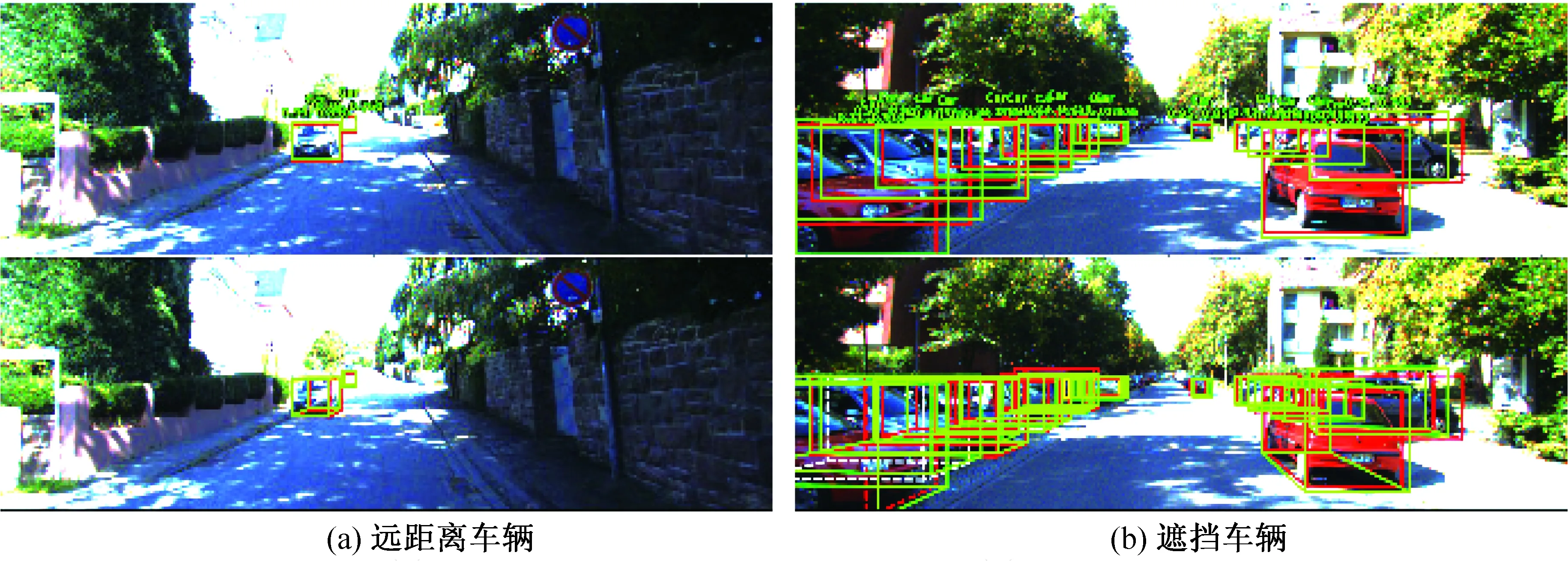

图13为复杂场景下的实验结果,针对图12(a)远距离车辆、图12(b)遮挡车辆,本文方法对于多目标也能够有效检测,在应对多目标的复杂状况下,具有较好的鲁棒性。

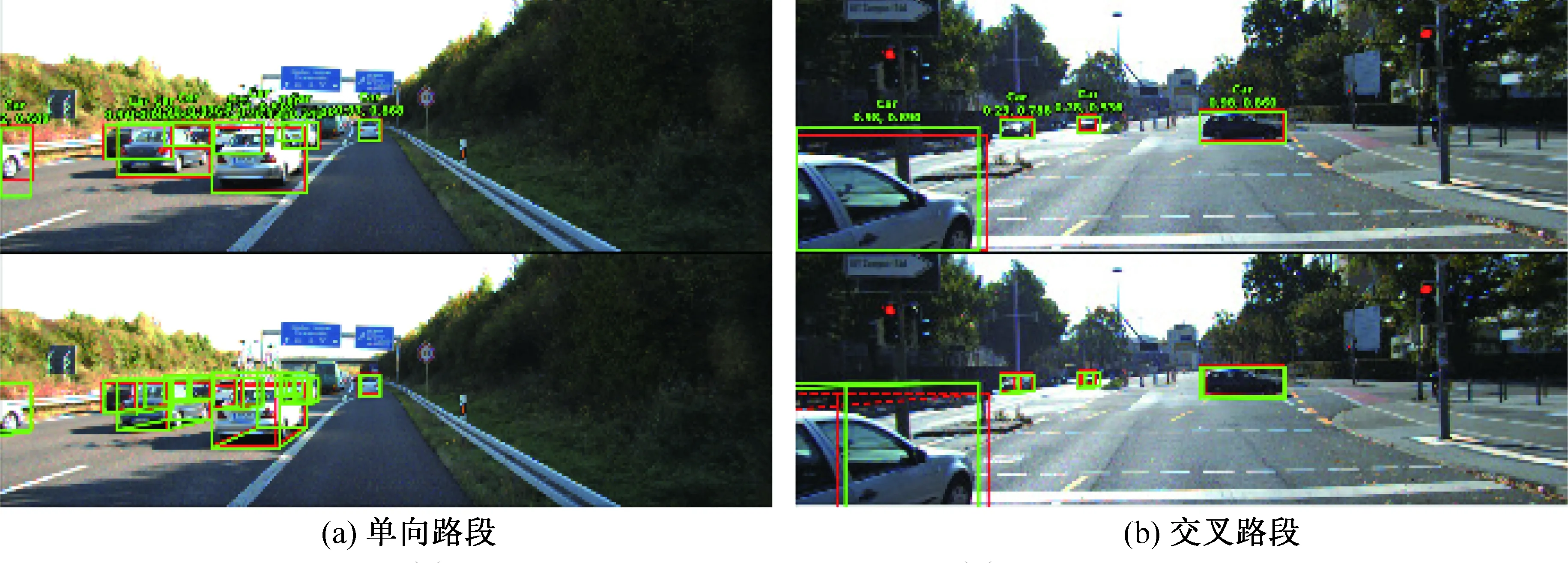

图14给出了复杂路段场景检测结果,图14(a)为单向路段,图14(b)为交叉路段。由于道路环境错综复杂,同时存在来向车辆、去向车辆以及侧向来车,车辆方向各不相同且存在车辆遮挡,导致车辆点云特征不明显。由实验结果可知,通过摄像机对车辆二维信息的采集以及毫米波雷达对车辆在三维环境的位姿匹配,车辆检测能够保证复杂环境下的车辆检测精度。

图12 光照场景实验结果Fig. 12 Illumination scene experiment results

图13 多目标场景实验结果Fig. 13 Multi-target scene experiment results

图14 复杂路段场景检测结果Fig. 14 Complex road section scene detection results

实验结果表明,对于自然道路环境以及复杂道路环境,本文算法通过多模态融合弥补摄像机与毫米波雷达不足,对遮挡车辆、光照车辆以及多尺度多目标车辆能够有效检测。

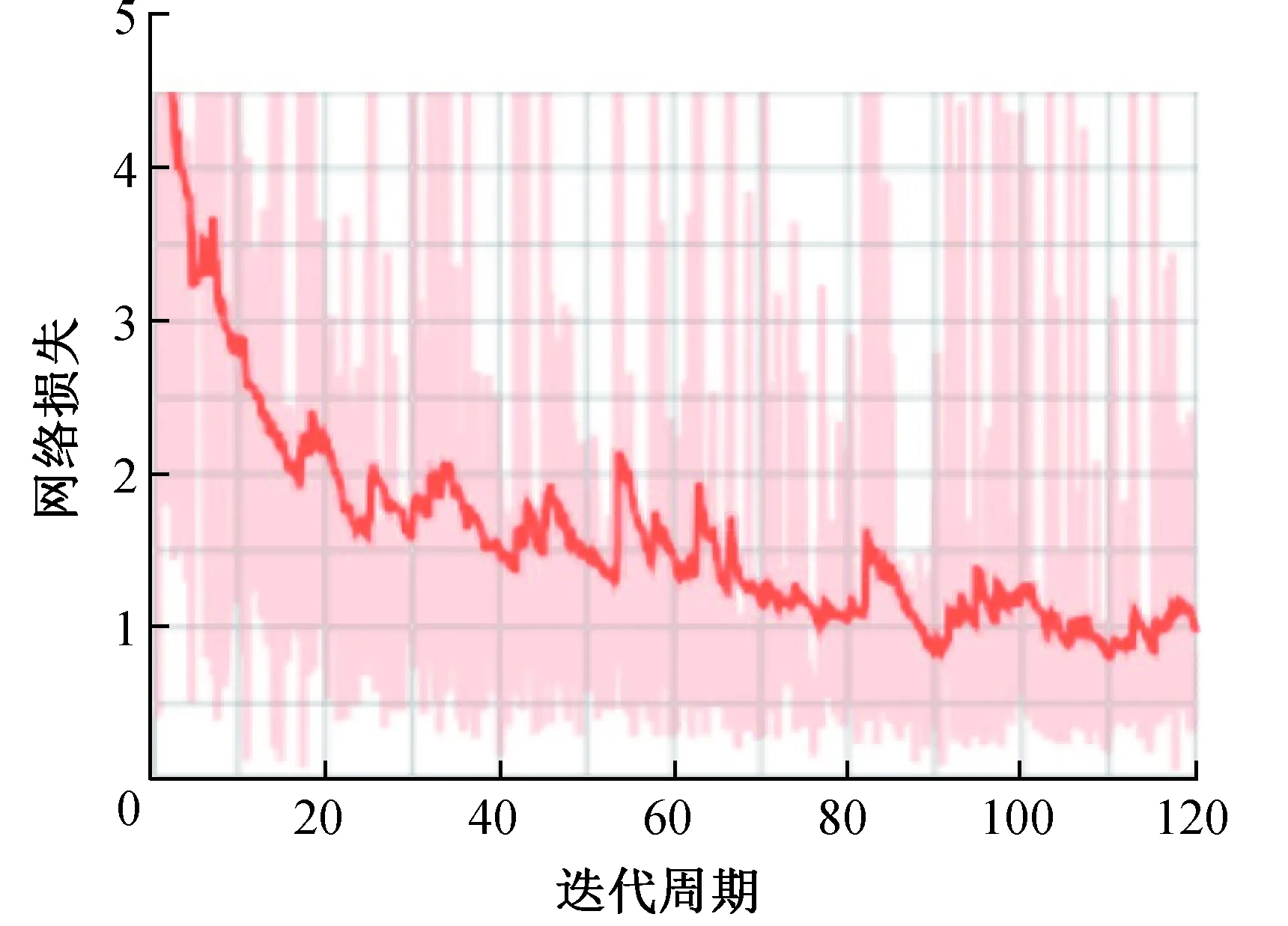

网络训练时,分别选取迭代周期为60、80、100以及120的模型进行评估,网络训练损失与检测精度如图15所示。随着网络训练周期的增加以及学习率的改变,网络损失能够有效下降且趋于收敛,这表明改进网络模型检测精度是不断提升的(如表1)。

图15 训练损失图Fig. 15 Training loss chart

表1 网络训练损失与检测精度

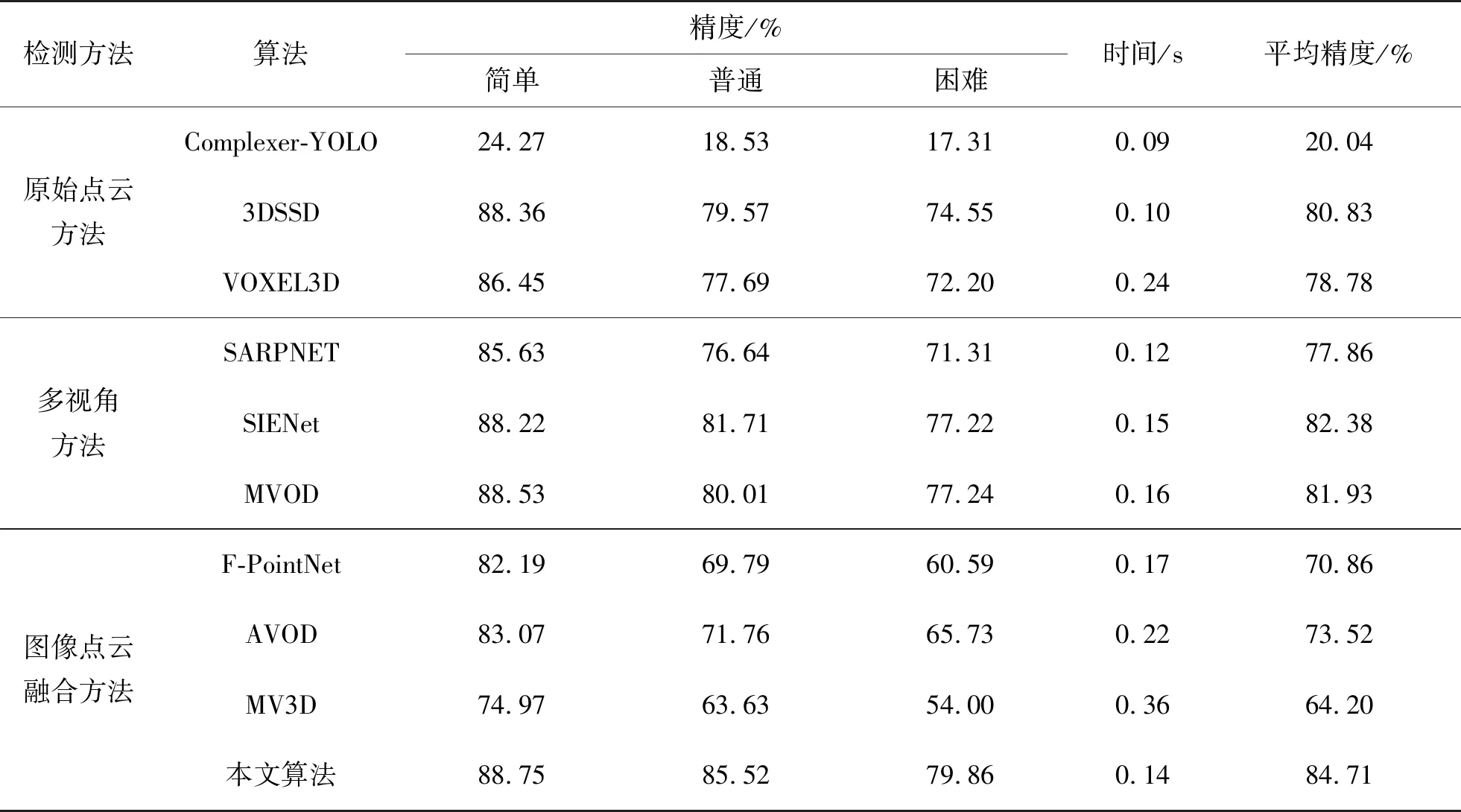

本文算法在同数据集同环境下与目前主流算法进行对比,测试结果如表2所示。对比实验根据三维检测方法分为原始点云方法、多视角方法、图像点云融合方法。选择不同方法中主流算法在本文实验平台上用KITTI数据集进行测试。本文算法检测平均精度为84.71%,毫米波雷达数据信息相比于图像信息,冗余数据量小、分类特征维度低的特点使本文算法精确度高于其他方法。由于加入特征金字塔导致检测时间略有上升,检测时间略高于基于原始点云方法的Complexer-YOLO与3DSSD算法,但仍优于其他主流算法。

表2 主流算法时间及精度对比

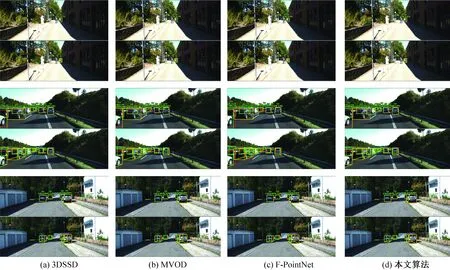

在原始点云方法、多视角方法、图像点云融合方法中各选择一种算法与本文算法进行结果对比,如图16所示。在阴影遮挡、车辆遮挡以及远距离车辆的情况下,本文算法的误检率及漏检率均低于其他算法,对车辆的三维检测框匹配准确度也高于其他算法。实验结果表明,本文算法能够快速准确地完成自然场景以及复杂场景的车辆三维检测,该方法有效可行。

图16 算法效果对比Fig. 16 Algorithm effect comparison diagram

4 结论

本文采用基于多模态特征融合的方法,通过摄像头和毫米波雷达的多模态特征融合完成车辆检测。该算法采用统计滤波算法预处理剔除点云冗余信息;通过多模态特征融合并结合特征金字塔提取高层特征,提高复杂道路场景下车辆检测精度;最终使用区域建议与三维检测框匹配生成车辆检测框。该算法的车辆识别准确率为84.71%,对自然道路以及复杂道路场景表现出良好的稳定性。单帧融合数据的平均总处理时间为0.14 s,具有较好的实时性。本文算法使无人驾驶系统能在复杂道路场景下实现三维车辆检测。