一种用于沙盘推演的规划识别方法*

2022-01-06刘成龙胡广朋

刘成龙 胡广朋

(江苏科技大学计算机学院 镇江 212100)

1 引言

随着人工智能的发展,从贝叶斯估计到近阶段的深度学习,军事智能的指挥决策研究者们在将深度学习应用于自主决策上也展开了许多研究。就目前来说,国内外关于自主决策的方法探讨是处于起步阶段,绝大部分研究工作采用半监督或监督的深度学习方法,但是数据的缺乏限制了方法后续的发展。虽然之后也有人利用深度学习方法对自主决策进行进一步的研究,但是相关方面的研究也还在理论探索,要想有具体的实际应用,还是要有比较长的路要走。

传统典型的方法是胡桐清、陈亮等在军事智能决策的理论与实践中提出的军事专家支持系统[1],该系统建立了多条规则和一个定量与定性相融合的有效推演机制,可以自动生成作战决策的方案,根据方案,能够帮助指挥员进行决策,但方案需要一定的专业知识,存在一些局限性。朱丰等在对战场态势评估的研究讨论中[2]利用一系列技术对目的识别、决策推演等多方面展开了研究。李耀宇等曾在国防科技大学学报上发表文章[3],利用逆向强化学习的方法,优化方案,前提条件是不确定条件策略、地形的战场火力分布。陈希亮、张永亮在基于深度强化学习的陆军分队战术决策问题研究[4]中提出了一种决策框架,利用逆向强化学习在战场行为决策上收获颇丰。乔永杰,王欣九,孙亮等提出利用陆军指挥所模型自主生成作战计划时间参数的方法[5],建立服务框架,进而有了自动生成作战计划的方案。中科院研制的“SASIA-先知V1.0”在全国兵棋推演大赛上取得了较好的成绩,先知V1.0所采用的模型是由知识和数据共同建立的,同时也证明了深度学习在军事对抗领域大有可为。

文章针对对手行为分析构建预测模型,进而采用基于自适应增强的规划识别方法,利用此算法能够将可观察到的对手行为作为唯一已知条件,实现对目标的预测。该方法对可观察行为不断训练弱预测器,最终组成强预测器。并以aerial bombing operations数据集为例设计实验,验证方法可行性。

2 沙盘推演分析模型

2.1 模型框架

实现沙盘推演分析的模型如图1所示。首先策略规划器将对手的动作或状态的改变作为观察对象,推理出对手规划和所有的目标,不仅如此,策略规划器会依据预测的对手规划做出应对动作,然后策略规划器向动作规划器下达指令,动作规划器会依照指令,进行有效的信息决策,接着模型要依据决策进行行为模拟,同时将收集到的有效信息发给动作处理器,动作处理器后续就会将收到的有效信息传回最初的策略规划器,达到破坏对手规划和防御的目的。

规划识别方法是整个沙盘推演的核心,规划识别方法是整个行为分析网络的核心,整个分析过程以特征抽象处理后的数据特征作为输入,通过识别算法分析寻找异常的操作行为,分析各行为之间相互转换的概率。在对对手规划的分析时间,不断完善规划应对,达到应对对手规划的预测识别。

图1 沙盘推演分析框架

2.2 自适应增强算法

策略规划器根据对手行为进行的分析会影响规划识别算法对最终结果的预测,常见的策略规划器方法主要有隐马尔可夫、随机快速搜索树(RRT)以及Adaptive boosting等。

Adaptive boosting又被称为自适应增强,其基础的想法就是利用相同的训练集去训练各不相同的弱分类器,接着将这些集合起来,构成一个新的分类器,也称为强分类器,记为H(x)。定义一个样本(xi,yi),则训练样xi为样本类别观测值,yi是xi的样本类别标识,满足yi=f(xi),f是要学习的目标概念的集合。各个样本的权值为D(1),…D(n),D(i)>0,1≤i≤n。

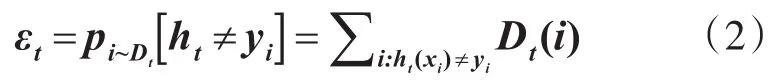

基本过程分为以下几步:第一,对初始的训练数据进行赋值,假设存在M个训练数据,那么每一个样本的初始权值相同,都为1/M。第二,进行训练。在过程中,如果样本被错误分类,那么它的权重增加;如果被正确分类,权重减少。权重重新赋值后就会应用于下次训练,如此迭代下去,第三,将每次迭代得到的分类器融合起来,作为最终的决策分类器,也称为强训练器。融合的规则是损失函数(loss function)最小化原则,按照此函数的负梯度方向不断地循环。定义在第t轮迭代时,第i个训练样本(xi,yi)的权重分布为Dt(i)。弱学习算法的任务就是根据训练样本的分布及权重Dt完成一个弱分类器ht:X→R的学习,最简单情况下ht是二值的,好坏由误判率εt进行衡量。

经过T次训练学习后,得到一系列弱分类器h1,h2,h3,…,hT。可以用累加模型来定义强分类器:

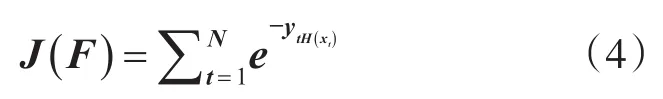

其中,x是特征向量;ht(x)是第t次迭代得到的弱分类器;αt是ht(x)的权重。AdaBoost的核心思想就是按照损失函数的负梯度方向不断地循环,融合迭代所得到的分类器,指数损失函数为

其中,t,y分别为循环更新次数和种别标记,通过不断地更新权值,求得最终强分类器的最优解。

2.3 基于自适应增强的规划识别算法

针对于复杂的沙盘推演环境,文章提出基于自适应增强的的规划识别方法(Adaptive Boosting Planning Recognition,ABPR)。自适应增强算法的核心思想是重视误差大的学习样本,改变其分配权重并再次进行训练,得到多个误差较小的弱预测器,再组成一个强预测器。根据自适应增强算法的原理,将规划识别方法看作弱预测器。首先用规划识别算法对样本不断的训练,如果得到的预测误差不在范围之内,那么对该样本重新赋值,并计算第t个规划识别弱预测器的权重,得到T个规划识别弱预测器、权重,将得到的权重进一步融合,得到一个强预测器,利用最终预测器,输出规划预测。

ABPR方法在沙盘推演中的应用主要由数据预处理过程、分析模型建立并调整模型参数、识别判断当前的对手规划和对敌意规划的预测四个部分组成。在本文提出的方法中,首先对选用的数据集进行数据预处理,包括对冗余信息的删减和不规范数据的规范化;然后将数据集作为Agent的行为进行观察并对分析模型进行优化;接着输入一组对手行为数据,提取领域中的(近期、中期或者远期)目标,将这些目标分解以降低其抽象层,并将其扩展进规划中,重复这样的动作确定具体动作,直至规划中只存在原始动作。最后预测层对概率值最大的数据序列做状态信息的预测,获取对行为的预测值。如在沙盘推演中,占领对手领地这个目标是明确的,因为占领阵地明确指出,但是何时占领、如何占领等问题没有具体描述,假设给定以下前提条件:有足够的兵力,并且已经在对手阵地,那么利用兵力占领阵地就可以直接执行,这是一个具体操作。

根据以上分析,自适应增强改进的规划识别算法预测具体步骤如下。

1)导入数据样本,初始化样本权重。

其中,Di是初始权重;m是样本个数。

2)设置要训练的规划识别弱预测器个数T和模型结构,用规划识别算法对样本不断的训练。

3)计算规划识别弱预测器预测训练样本的预测误差ec。

4)将预测误差ec与预设误e进行比较,调整训练样本权重Di。

5)计算第t个规划识别弱预测器的预测误差:

6)计算第t个规划识别弱预测器的权重:

其中,Ct是第t个规划识别预测器权重;et是第t个规划识别预测器的预测误差。

7)计算下一轮迭代时训练样本的权重:

其中,Bt是归一化因子。

若未达到迭代次数,返回第2)步,进行下一次迭代,直到迭代T次后,停止训练。

8)输出强预测器。经过T次训练后,生成T组弱预测函数ft(x)根据权重分布组合生成强预测函数:

其中,F(x)是强预测函数,ft(x)是弱预测函数。

3 实验验证

3.1 实验说明

本次实验主要针对空军任务中飞机状态进行分析。主要的样本来自于aerial bombing operations数据集。该数据集由二战的数字化纸质任务报告组成。每条记录都包含了date(日期)、conflict(冲突)、geographic location(地理位置)和飞机的状态数据。并从数据集中随机抽取50条数据定义为对手进攻性行为,以此模拟进攻行为。并且该数据集的数据被按块分割,在进行验证实验时,将数据块中的三分之一作为训练集,剩余的数据块作为测试集,最后分析本文算法在对飞机不同状态下的行为目的预测的效果。

3.2 实验结果分析

用规划识别方法训练测试,误差大于0.005的样本视为强化训练样本,不断地更新权值,计算预测误差。通过不断的训练,得到10个弱预测器和相应的权值,最后通过加权,输出一个规划识别最终预测器。

由图2、图3的均方误差曲线可以看出,Ada-Boost改进的规划识别在第5次之后开始收敛,最佳验证性能为0.00057352;规划识别在训练7次之后开始收敛,最佳性能为0.00075864;由图可得,经由AdaBoost改进后的规划识别算法比过去简单的的规划识别算法收敛速度更快,拥有更良好的预测效果。

图2 规划识别预测模型均方误差曲线

图3 AdaBoost改进的规划识别预测模型均方误差曲线

4 结语

为了提高在沙盘演练中敌意规划的预测效率和准确度,本文提出基于AdaBoost改进的规划识别方法。将每个规划识别预测模型看做一个弱预测器,利用AdaBoost算法的核心思想,将得到多个经过多次训练的、误差较小的弱预测器组合成一个强预测器。利用得到的强预测器,识别预测军事对抗中的敌意规划。通过实验证明,改进后的规划识别方法可以提高预测模型的收敛速度以及预测效果,因此,改进后的规划识别预测模型用于沙盘演练中敌意规划的预测效果相对更好,所以该模型可以用于敌意规划的识别与应对之中,为演练中的敌意规划预测提供了一种新的方法,结论为决策者做出科学决策提供帮助。

文章提出的方法主要考虑对手规划中的复杂性和误导性,虽然抽象后的数据特征能够提高模型的识别精度,但是有些初始信息的处理较为繁琐,会增加模型对数据信息处理工作量。所以下一步的研究重点是提高处理行为信息的效率,并且虽然本文提出的算法一定程度上提高了识别的精度,但在实际应用场景中还需要能够适应多场景的识别方法,接下来的研究学习将尽可能地提高算法的精度,从而能够在实际环境下实现应用。