基于手部姿态运动特征的暴力行为检测

2021-12-30周晴

周晴

摘要:姿态在行为识别与分析领域是一种具有良好语义性、高度结构化且对光照及场景变化具有鲁棒性的信息。基于人体骨架的动作识别方法由于能提取个体的关节点构成人体的关节点形成的骨架图,在近几年逐渐成为了异常行为识别领域的重要研究方向之一。本文设计了一种基于手部姿态运动特征的暴力打斗行为检HandPose-network姿态估计网络模型,通过对手部运动情况建立运动模型,完成暴力行为检测。本模型在目前最大暴力行为监控视频数据集RWF 2000和常用暴力行为检测Hockey数据集进行了实验,其准确率分别达到92.10%和97.80%,说明了该方法在暴力行为场景的有效性。

关键词:异常行为;暴力行为;动作识别;姿态序列;轨迹聚类

1 引言

对于我国社会治安的防控体系当中,公共安全防范方面属于其极为重要的一部分,影响着社会的稳定与繁荣。商场、步行街道、火车站、办事厅等人群密集的公共场所,一旦出现损害人民生命财产安全与社会稳定的公共事件特别是打架斗殴这类群体暴力行为,将产生恶劣的社会影响。视频监控不仅可以强化公共区域(或场所)的监管力量,而且可以对潜在犯罪者产生威慑作用,借助日趋成熟的计算机视觉技术实现智能化、自动化的视频监控与分析,对保障公共场所安全具有重要的意义。目前针对基于视频的暴力打斗行为检测问题,国内外已有大量的学术研究成果,但普遍存在着算法模型可解释性差、针对场景变化鲁棒性差等缺点,难以应用到实际场景。

针对暴力打斗行为检测,主要有两类方法:提取手工特征分类和端到端深度学习方法。这两类方法容易受到杂乱背景以及目标表观变化的干扰,使得模型难以迁移到其他场景下,局限于训练数据集所在的场景。同时由于暴力行为没有一种简单、固定的行为模式,并且通常涉及多个主体目标,通用异常行为检测难以取得较好的效果。因此需要针对暴力打斗行为展开特定的研究。

本文研究了基于姿态运动特征的暴力打斗行为检测算法,提出了手部危险区域位置特征和轨迹簇运动效率特征,并根据当前场景的情况对是否发生暴力行为做出判断。基于姿态的特征可以直观地描述行人的动作状态,可以克服行人外貌、相机运动等对行为识别的干扰。

本文提出了一种基于手部危险区域位置特征以及聚类轨迹运动有效性特征的暴力行为检测算法,并在RWF 2000和Hockey两个常用数据集中进行了实验结果的验证和分析。

2 相关工作

公共场所中,暴力行为一般指有威胁性地行为动作,比如目标攻击其他行人、目标蹲下放置危险物品等[1]。暴力行为的识别方法主要基于表观特征和运动特征,通常在网格化后的图像块中[2],或者在视频时空立方体中[3],或者在预先定义的识别区域[4]进行特征提取。但是,基于像素的特征是对噪声敏感的高维非结构化信号,一些无关的特征维度可能会掩盖蕴含重要信息的特征维度[5]。此外,高维特征中存在的冗余信息增加了模型区分信号和噪声的负担。

人体关节点可以直观地描述行人的动作状态,相比于图像和光流信息,关节点信息可以克服行人外貌、相机运动等对行为识别的干扰。因此可以利用人体姿态提取人类行为的重要信息。Li[6]等为了处理人体骨架的 3D 坐标值信息,提出了一种平移尺度不变的映射方法,该方法在关节点信息在比例不发生变化的同时将范围映射到 0~255 的区间内,再训练 CNN 网络提取其中存在的空间、运动信息。刘凯[7]使用了基于非负矩阵分解和隐马尔科夫模型的方法,取得了更快的识别速率,以便在实际场景中应用。

虽然姿态信息在动作识别领域已经受到重视,但在暴力行为检测领域,目前研究人员较少利用姿态信息研究魯棒性更好的检测算法。使用传统手工设计的特征以及深度特征进行暴力行为检测的方法,面对场景变化鲁棒性差,对噪声敏感,同时方法模型不具有良好的可解释性。因此针对实际场景,如何结合对光照变化及场景变化鲁棒性更好的姿态信息取得更好的暴力行为检测效果值得深入研究。

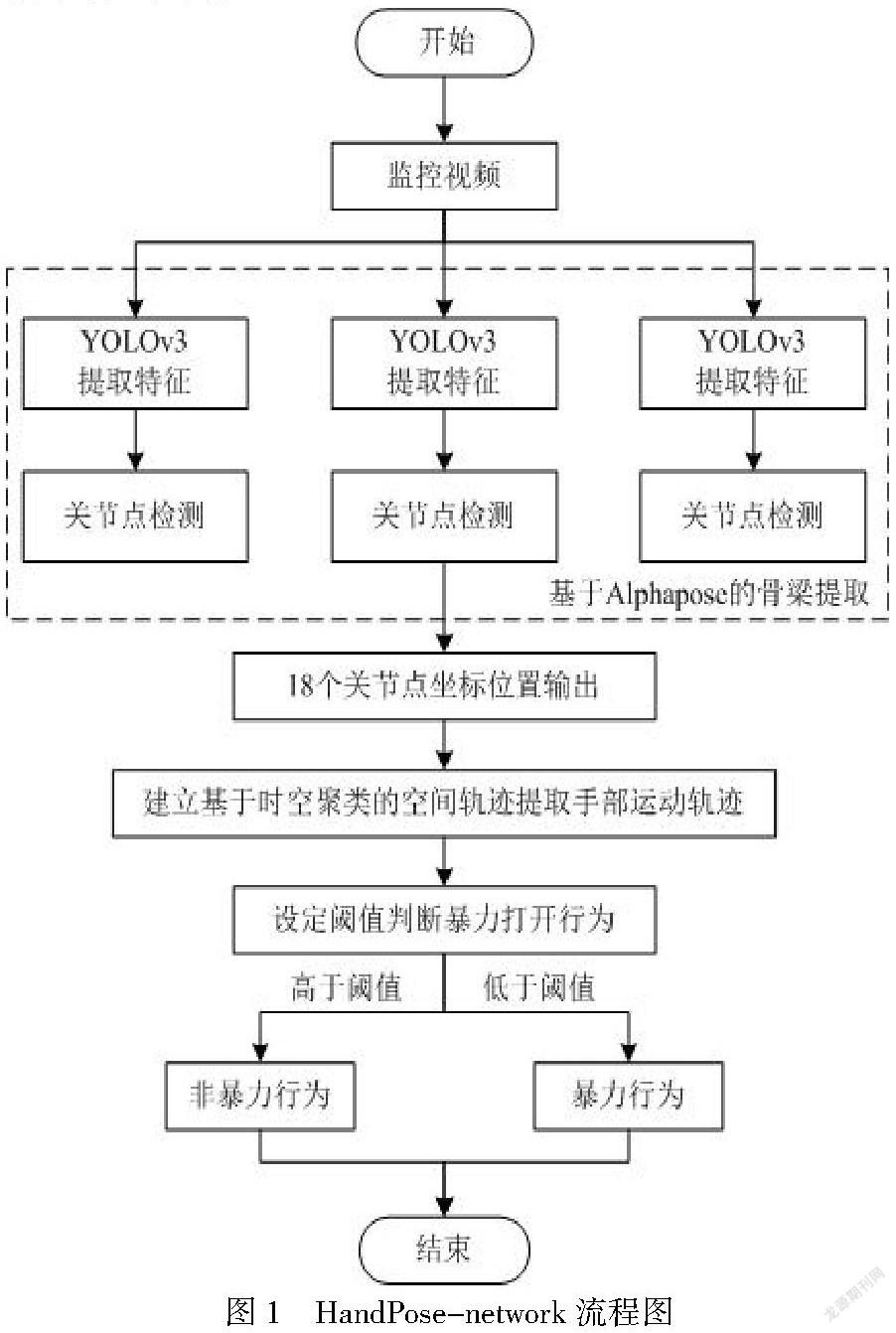

3 HandPose-network模型及实现

针对打架斗殴这类暴力行为,有效获取及利用人体手部姿态信息是进行准确检测暴力行为的保障。基于此,本文设计了一种基于手部姿态运动特征的暴力打斗行为检测方法HandtPose-network,模型整体实现流程如图1,本文沿用Alphapose[8]算法提取人体姿态特征,先将监控视频转化为 t 个关键帧,对每一帧使用yolov3网络模型提取特征。然后检测图像中的人体骨架关节点,得到了手部关键点集合后,根据手部危险区域位置特征,采用基于时空密度聚类的空间轨迹提取的方法获取每个人在视频中的手部运动轨迹,将提取的动作特征输入暴力打斗行为检测模块进行行为判定,旨在针对实际场景中的复杂打斗行为进行准确地检测。

3.1Alphapose采用的算法原理

Alphapose可以明确的分为两部分,即目标检测阶段和人体姿态提议阶段。首先通过目标检测YOLOv3[9]网络,直接将图片输入到网络中利用 CNN 来提取整个图片的特征,最后再对整张图片进行回归操作来检测目标。YOLOv3 使用 Darknet-53 作为主干网络,并且借鉴了金字塔特征图的思想,使用 FPN 对输出进行预测,Residual 指带残差结构的卷积模块。

通过YOLOv3网络从原图片中根据人的提议框裁剪出人的区域后依次将单人图片输入区域多人姿态检测(Regionalmulti-person pose estimation,PMPE)框架中,检测出人体姿态,再通过 p-Pose NMS 比较姿态相似性,去除重复目标。

3.2手部特征提取

3.2.1手部危险区域位置特征

暴力打斗行为的具体行为模式不易定义,在现实生活中以多种形式呈现,具体包括推搡、缠斗等多种情况。打架斗殴这类暴力行为,四肢的运动通常具有更强的语义性,能更准确地表征暴力行为,打架行为手部的运动情况与正常行为有较大的区别。因此本文从手部运动模式进行建模分析,由此区分暴力行为与非暴力行为。

3.2.2手部危险动作区域分析

在大多数暴力行为中,手部动作发挥了至关重要的作用。建立手部的运动模型,有助于理解个体的行为状态。因此本文从手部的运动模式着手,建立相应的运动特征。首先将人体从头至脚等比例划分为k部分。k通常设置为10,编号分别为0~9。个体处于正常站立状态,手部位置通常处于3~5号区域位置。进一步结合现实生活中人体的实际暴力行为的相关动作,当手部位置落入到3~5号区域是安全动作的手部位置,通常难以对他人产生威胁性的姿势;当手部位置落入到0~2号区域是危险动作手部位置,该位置的手部姿态将满足大部分可产生伤害性动作姿势的必要条件。

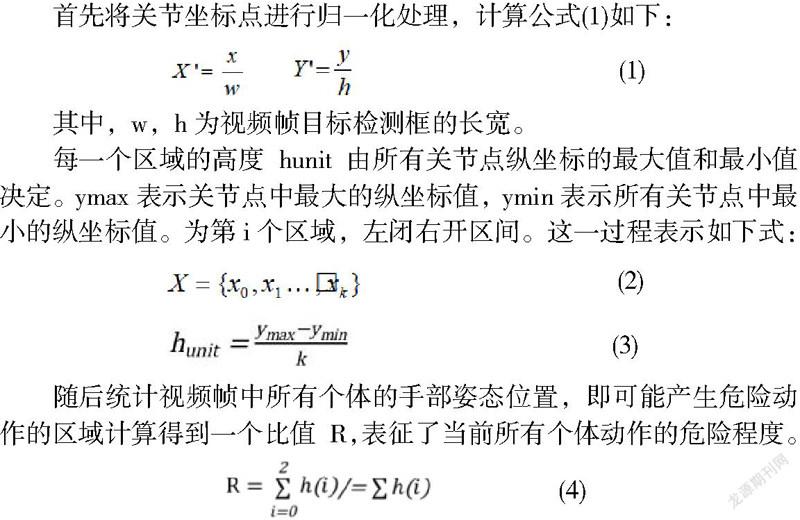

首先将关节坐标点进行归一化处理,计算公式(1)如下:

其中,w,h为视频帧目标检测框的长宽。

每一个区域的高度hunit由所有关节点纵坐标的最大值和最小值决定。ymax表示关节点中最大的纵坐标值,ymin表示所有关节点中最小的纵坐标值。为第i个区域,左闭右开区间。这一过程表示如下式:

随后统计视频帧中所有个体的手部姿态位置,即可能产生危险动作的区域计算得到一个比值 R,表征了当前所有个体动作的危险程度。

3.2.3 时空密度聚类轨迹运动有效性特征

手部的运动轨迹有丰富的肢体信息,在人类行为识别任务中起到主要作用。因此如何有效利用手部轨迹中蕴含的丰富信息,将决定暴力行为的检测效果。

目标处于正常行走状态,手部随着身体的移动,近似呈现一条直线;而发生打斗时,个体组成的群体的手部轨迹将呈现团状。这两种情况的手部轨迹有明显的区别。在观察到该现象的基础上,综合考虑手部关节点的运动的时空信息,提出基于时空密度聚类轨迹运动有效性特征。首先将连续若干帧个体的手部位置堆叠为关节点图谱,根据时空密度将位置点分为若干轨迹簇,轨迹簇表示了个体手部运动的轨迹。

3.2.4 基于时空密度聚类的空间轨迹提取

为了得到相关性较高的手部轨迹数据,本文提出了基于时空域密度聚类的手部轨迹提取方法。DBSCAN (Density-Based Spatial Clustering of Applications with Noise) 是一种经典的基于密度的聚类算法,一般假定类别可以通过样本分布的紧密程度决定,同一类别的样本之间的紧密相连的。手部轨迹空间点很符合这类特点,即同一个体的手部运动轨迹在时空上是连续的,两点之间距离较近,不同个体正常行走会避免碰撞,短时间内不会出现重叠现象。

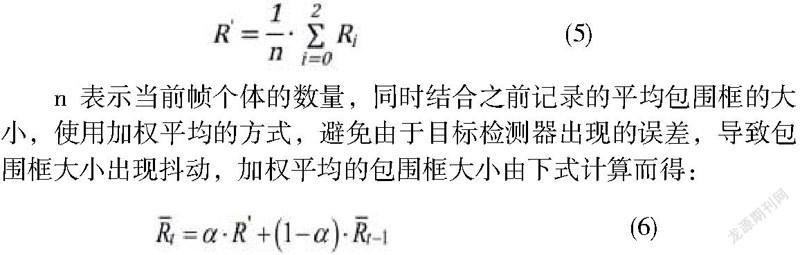

利用場景中个体的平均包围框对聚类算法的领域进行自适应估计。首先通过移动加权平均的方式,计算当前帧的平均包围框大小。使用来表示个体的包围框,当前帧的平均包围框大小计算如下式:

n表示当前帧个体的数量,同时结合之前记录的平均包围框的大小,使用加权平均的方式,避免由于目标检测器出现的误差,导致包围框大小出现抖动,加权平均的包围框大小由下式计算而得:

t表示当前时刻的个体平均包围框的大小,对应表示为。使用与关节点坐标同样的方式对t做尺度归一化后,得到归一化后的包围框Rn=(wn,hn)。结合手部连续运动范围相对于个体包围框的比例,拟合得到空间邻域阈值的大小εs,具体计算入下式:

带有时间信息的关节点由向量p=(x,y,t)表示,其中x,y分别是空间上的坐标值,t为关节点所在的帧数。将时间信息融合到关节点的表示向量中,充分利用时间域中的信息,获取在时间和空间上关联性更紧密的点,构成相应轨迹。

时空距离由空间坐标差的二范数进行表示,见下式:

时域上的距离将由点所属的帧差dists的一范数进行计算。

时空邻域是将空间邻域和时间邻域相结合确定的时空范围,先从空间和时间的物理意义入手,分别确定各自的邻域范围,再将二者有机结合,这样能够有效分离前后分别出现在同一位置的两条无关轨迹。

空间邻域与时间邻域共同构建时空邻域之后,基于时空密度的DBSCAN算法从关节点集中的任一点出发,计算与其他所有点之间的时空距离,统计满足时空阈值的关节点个数,若数目大于给定的最小样本数时,该样本即为核心对象,形成一个聚类,邻域内其他直接密度可达的点重复进行此步骤,得到最终的聚类结果。

3.3 暴力打斗行为检测

在正常情况下,普通人手部行为包括以下情况:提东西、玩手机、牵手、或自然垂手等,个体手部轨迹会跟随移动路径进行改变,可能伴随小幅度的摆动。在发生暴力行为的场景中,个体为了完成各种暴力行为,手部会发生剧烈地挥动。同时由于暴力行为通常有多个参与个体,在一定的时空中,手部关节点位置高度随机分布,与正常行走状态下的手部小幅度挥动的轨迹完全不同。为了量化手部运动剧烈程度,引入了手部轨迹运动有效性特征。

对聚类后的每一段手部轨迹分别计算移动效率,使用经验性阈值进行异常判定。

在某一时刻t,通过时空聚类获得了m条轨迹,表示由空间点集构成的一条轨迹。针对空间簇内的点集,两两计算成对距离,每个点选择其最小成对距离di作为运动距离,计算公式如下:

将所有点的最小运动距离进行累加,得到整个空间簇点集的运动距离:

运动距离可以有效轨迹空间簇轨迹的运动路径的长度。使用空间轨迹簇中两点最大距离dist作为整段轨迹的有效距离:

对每个轨迹簇使用其点数作为权重,加权求得当前时刻的轨迹簇运动有效性:

表示当前轨迹簇中点的数量。当前帧整体运动有效性低于某一阈值时,判定当前帧发生暴力打斗行为。

4 实验结果及分析

4.1暴力打斗行为检测数据集

本文在RWF 2000[10]数据集和Hockey[11]数据集上测试HandPose-network的性能。RWF2000数据集是从YouTube上收集的一个新的真实世界战斗数据集,包含2000个由监控摄像头在真实场景中捕获的视频,一半视频属于暴力行为视频,另一半视频属于正常行为视频。Hockey数据集视频画面取自于美国曲棍球比赛,该数据集由500段暴力行为视频和500段正常行为视频组成。两个暴力检测公用数据集中的视频环境各异,其中发生的打斗行为各式各样,这给暴力行为检测带来一定的挑战。

4.2评价方法

检测图像中暴力打斗行为个体是本文算法的研究目的,因此以暴力行为个体作为正样本,以非暴力行为个体作为负样本,将图像中的每一个人类个体作为一个样本,本文采用了精确率(Precision)作为评价指标。

其中,TP為真阳性样本数(被正确识别为暴力行为的样本数),FP为假阳性样本数(被错误识别为暴力行为的样本数)。

4.3实验细节

本文实验环境如下:Intel(R) Core(TM)i9 CPU处理器,32.00GB安装内存,Windows10 64位操作系统,显卡为NVIDIA GTX 1080Ti。本文先对RWF2000数据集和Hockey数据集中所有视频进行了人工筛选,将模糊不清、界限不明确的视频删除。

4.4实验结果分析

首先,在目前最大的暴力行为监控视频数据集RWF 2000上与当前最有效的算法进行准确率的比较(表1)。

为了比较算法的高效性,表2列举了本文提出的算法与其他算法在Hockey数据集上的识别精度。

4.轨迹聚类可视化

为了进一步验证手部姿势运动特征对暴力打斗行为检测的有效性,对基于时空密度的轨迹聚类结果进行解释说明,展示了部分发生暴力打斗行为的异常场景轨迹聚类结果(如图2),不同类别的簇使用不同的颜色进行了标注。从异常场景中的聚类结果可以发现,场景中存在个体的打斗行为时,个体手部轨迹在空间中存在高度重叠,呈现混乱的团状,与正常场景中手部随身体移动呈现的线状明显不同,具有比较易于区分的特征。

5.结束语

异常行为检测技术,在公共安全领域具有广泛的应用前景。然而人类行为模式复杂多样,真实场景中存在大量干扰信息,现有方法在实际应用场景取得较好的检测效果。本文针对实际场景中的暴力打斗行为,研究一种基于手部姿态的运动模型的暴力行为检测方法,旨在进行准确地检测判断。

本文围绕暴力行为检测这一课题展开了研究工作,本文的算法针对手部活动剧烈的一些暴力行为,这当然不足以描述现实生活中可能发生的各种打斗行为。在面对目标倒地、腿部 踢踹、持有枪支等更多种类的暴力行为时,本文算法难以进行有效检测。因此如何进一步拓展可识别的暴力行为种类,将是今后研究的一个方向。

参考文献

[1]Sodemann A A,Ross M P,Borghetti B J.A review of anomaly detection in automated surveillance[J].IEEE Transactions on Systems,Man,and Cybernetics,Part C (Applications and Reviews),2012,42(6):1257-1272

[2]Edison A,Jiji C V.Optical acceleration for motion description in videos[C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition Workshops,2017:39-47.

[3]胡学敏,余进,邓重阳,等.基于时空立方体的人群异常行为检测与定位[J].武汉大学学报(信息科学版),2019,44(10):1530-1537.

[4]Coşar S,Donatiello G,Bogorny V,et al.Toward abnormal trajectory and event detection in video surveillance[J].IEEE Transactions on Circuits and Systems for Video Technology,2016,27(3):683-695.

[5][Kim T S,Reiter A.Interpretable 3d human action analysis with temporal convolutional networks[C].2017 IEEE Conference on Computer Vision and Pattern Recognition Workshops (CVPRW).IEEE,2017:1623-1631.

[6]Li C,Zhong Q,Xie D,et al.Skeleton-based action recognition with convolutional neural networks[C].2017 IEEE International Conference on Multimedia & Expo Workshops (ICMEW).IEEE,2017:597-600.

[7]刘凯.高校校园视频监控系统中异常行为 检测的设计与实现[D].西安科技大学,2019.

[8]Fang H S,Xie S,Tai Y W,et al.Rmpe:Regional multi-person poses estimation[C]//Proceedings of the IEEE International Conference on Computer Vision.2017:2334-2343.

[9]REDMON J,FARHADI A.Yolov3:anincremental improvement[J]. arXiv:1804.02767,2018.

[10]Cheng M,Cai K,Li M.RWF-2000:an open large scale video database for violence detection[J].arXiv preprint arXiv:1911.05913,2019.

[11]Nievas E B,Suarez O D,García G B,et al.Violence Detection in Video Using Computer Vision Techniques[C]// International Conference on Computer Analysis of Images and Patterns.Springer-Verlag,2011:332-339.

[12]Sudhakaran S,Lanz O.Learning to detect violent videos using convolutional long short-term memory[C]//2017 14th IEEE International Conference on Advanced Video and Signal Based Surveillance (AVSS).IEEE,2017:1-6.

[12]Tran D,Bourdev L,Fergus R,et al.Learning spatiotemporal features with 3d convolutional networks[C]//Proceedings of the IEEE international conference on computer vision.2015:4489-4497.

[13]Carreira J,Zisserman A.Quo vadis,action recognition a new model and the kinetics dataset[C]//proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.2017:6299-6308.

[14]Hassner T,ItcherY,Kliper-Gross O.Violent flows:Real-time detection of violent crowd behavior[C]// 2012 IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshops (CVPR Workshops).IEEE Computer Society,2012.

[15]Nievas E B,Suarez O D,García G B,et al.Violence Detection in Video Using Computer Vision Techniques[C]//International Conference on Computer Analysis of Images and Patterns.Springer-Verlag,2011:332-339.

[16]Serrano I,Deniz O,Bueno G,et al.Spatio-temporal elastic cuboid trajectories for efficient fight recognition using Hough forests[J].Machine Vision and Applications,2017,29(6):207-217.

[17]丁春輝.基于深度学习的暴力检测及人脸识别方法研究[D].中国科学技术大学,2017.

[18]Zhang T,Jia W,He X,et al.Discriminative Dictionary Learning with Motion Weber Local Descriptor for Violence Detection[J].IEEE Transactions on Circuits & Systems for Video Technology,2017(99):1-1.