关于点击率大数据的高阶深度分解机预测仿真

2021-11-17张换梅董云云

张换梅,董云云,2

(1.晋中学院计算机科学与技术学院,山西 晋中 030619;2.太原理工大学信息与计算机学院,山西 太原 030024)

1 引言

互联网与云计算在提供丰富业务功能的同时,产生海量中间数据,网络应用通过数据收集、提取和分析,从中获取所需信息,对用户进行画像,从而完成业务的精准投放。尤其对于电子商务、移动、搜索引擎等互联网场景,大量收集用户数据,处理过载信息,并完成用户模型预测,是其业务优化与收益增长的重要手段。其中,点击率(Click-through Rate,)是目前互联网应用中主要的数据过滤方式[1-2],但是在多源异构的海量数据分析中,预测模型和方案需要具有良好的动态时变特性,从而满足推荐业务要求。对于大数据的预测,就是根据数据集的学习,得到一种映射关系。在点击率预测时,其映射输出分为点击与不点击,即输出具有离散性[3]。当系统较为线性时,通常可以采用逻辑回归[4]方案对数据进行预测,并在逻辑回归基础上,采取似然估计或其它方式对预测模型进行计算。这种方案虽然简便高效,但是不能分辨数据间的非线性关联和高阶特征。于是,在非线性系统中,通常引入多项式回归方案[5]。利用映射关系来描述多阶系统,基于这种映射关系,可以对数据特征的耦合关联进行深入学习,但是可能引发特征数量与维度的泛滥,难以处理高阶和稀疏情况。由于分解机[6]能够避免大量特征耦合关联权重的学习计算,同时具有良好的稀疏数据处理性能,因此,本文设计一种高阶深度分解机点击率数据预测方法。在分解机设计时,利用特征耦合性替代传统的权重关系,提高对交互特征和稀疏特征的描述精度;同时采取映射二次项转换来降低特征映射复杂度,从而使分解机能够向高维扩展。基于高阶分解机,将与结合构造了深度学习网络,并引入对比散度和对学习网络的样本训练性能做进一步优化。

2 高阶分解机特征映射模型

针对数据特征耦合情况,在分解机算法中引入隐向量,取代权重计算,利用其长度来改变系统变量。对于只有两特征耦合的情况,分解机的映射关系描述如下

(1)

(2)

当隐向量的大小是k,分解机的特征映射复杂度表示为O(kn2)。为了降低复杂度,改善其多阶性能,把映射二次项采取如下转换

(3)

转换后的特征映射复杂度是O(kn)。优化之前,当数据量增加时,复杂度呈指数增长;优化之后,当数据量增加时,复杂度呈线性增长,显然更有利于大数据的处理。

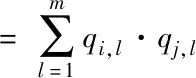

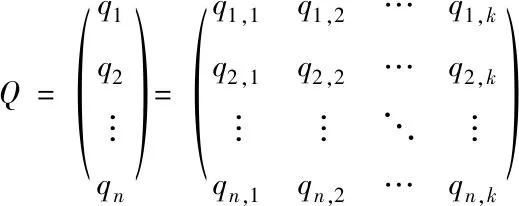

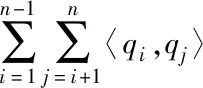

两特征耦合符合稀疏数据场景,即耦合变量不充足,通过隐向量与系数矩阵能够有效描述特征交互关联,有利于提高预测效果。根据二阶分解机,很容易将其应用于高阶场景。于是,三阶分解机的映射关系如下

(4)

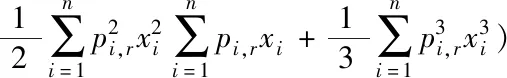

式中,qi,k、qj,k构成系数矩阵Q;pi,k、pj,k、pl,k构成系数矩阵P。此时,为保持线性复杂度,对其映射三次项采取如下转换

(5)

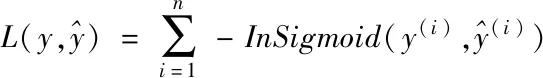

在进行模型学习时,考虑到点击率的二分类特性,在特征预测的过程中设计损失函数如下

(6)

式中Sigmoid(·)函数用于把输入数据映射至输出结果二值类上,它的计算方式为Sigmoid(x)=(1+e-x)-1。

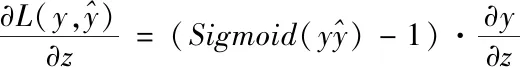

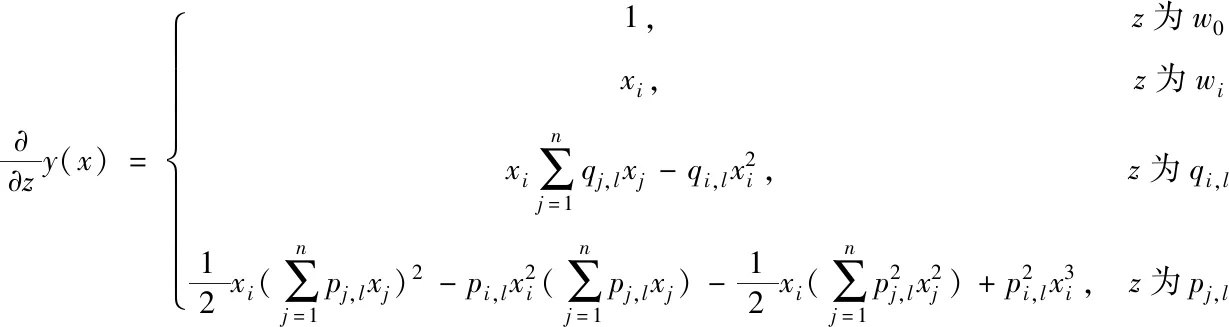

分解机特征映射模型的计算变量为w0、wi、系数矩阵Q。在经过映射模型转换后,对其采取SGD方法训练,通过损失函数求偏导得到变量梯度更新方式

(7)

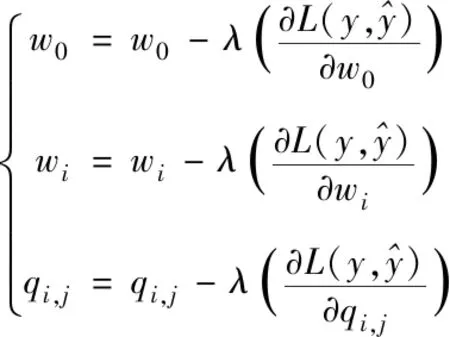

式中的λ代表学习率。在点击率二分类情况下,损失函数的偏导计算方式如下

(8)

于是,二阶特征预测变量的梯度描述为

(9)

对于三阶映射模型,偏导计算后其特征预测变量的梯度描述为

(10)

由梯度计算可知,特征预测复杂度也是O(kn)。从模型映射到特征预测都具有线性复杂度,有利于大数据处理效率。预测模型的阶数并不是越高越好,二阶处理适用于数据属性为非线性的情况,三阶处理适用于属性耦合较强的情况。另外,由于本文将分解机与深度学习结合,阶数过高不利于学习,所以三阶以上的分析意义不大。

3 深度网络学习

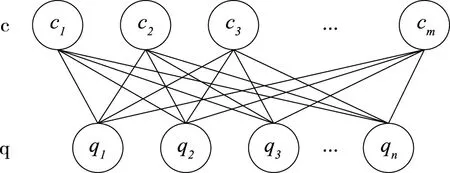

本文采用BP神经网络与RBM构造深度学习网络,RBM是一种无向图,图1描述了它的拓扑。其中,q代表显式层,c代表隐式层,W代表q与c的耦合权值。系统输入数据由q层进入,在c层完成特征处理。

图1 RBM拓扑结构

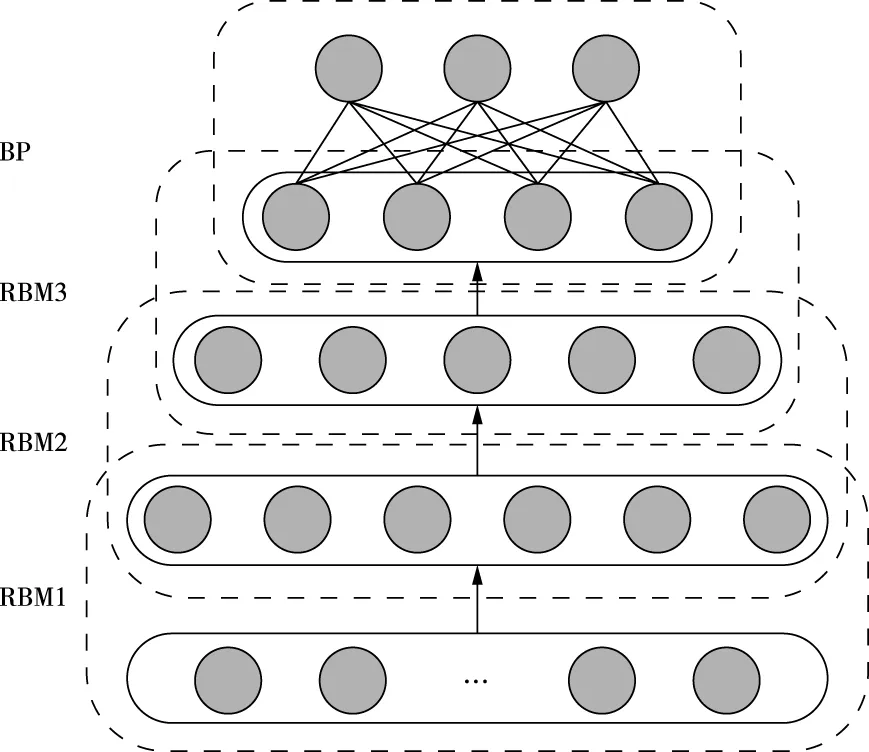

考虑到RBM缺乏监督学习,为了弥补RBM的此缺陷,深度学习网络设计为若干层RBM与单层BP网络,图2为深度学习网络模型。利用RBM实现数据特征识别操作,利用BP神经网络实现特征分类操作。输入数据首先经过多层RBM训练,将特征识别结果送至BP神经网络层做最后的分类处理,BP神经网络层还会对网络参数采取适当调整,从而优化网络参数。

图2 深度学习网络模型

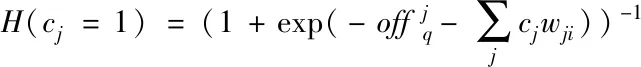

在RBM网络中,将隐式层的偏置记作offq,显式层的偏置记作offc,则根据显式层能够推导出隐式层,公式如下

(11)

因为RBM网络具有对称性,所以根据隐式层也能够推导出显式层,公式如下

(12)

输入集合q在经过RBM网络处理后输出集合c,RBM网络利用集合c与式(11)推导出隐式层集合q′,并与输入集合q比较得到偏置。网络训练过程就是搜索出最优的输入输出联合概率p(q,c)。为了得到p(q,c),这里首先计算输入输出的能量,公式如下

(13)

根据RBM输入输出能量,得到其联合概率如下

p(q,c)∝exp(E(q,c))

(14)

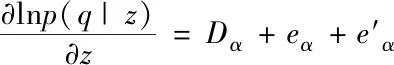

然后计算RBM网络的梯度,公式如下:

(15)

(16)

在进行点击率深度网络学习时,为避免发生过拟合,在BP神经网络层采用Dropout机制,该机制神经网络原理如图3所示。Dropout机制就是在学习阶段将所有神经元都赋予对应的活跃概率pa,其中任何神经元可能处于活跃状态或者失活状态,定义其理想输出是pax。当神经元处于活跃状态时,采用活跃概率作为它在网络中的权值。同时,Dropout机制还会利用随机方式选取神经元,与其它神经元进行协作,降低彼此共适能力,最终防止过拟合情况的发生。

图3 Dropout机制神经网络

4 仿真与结果分析

4.1 仿真数据集与实验指标

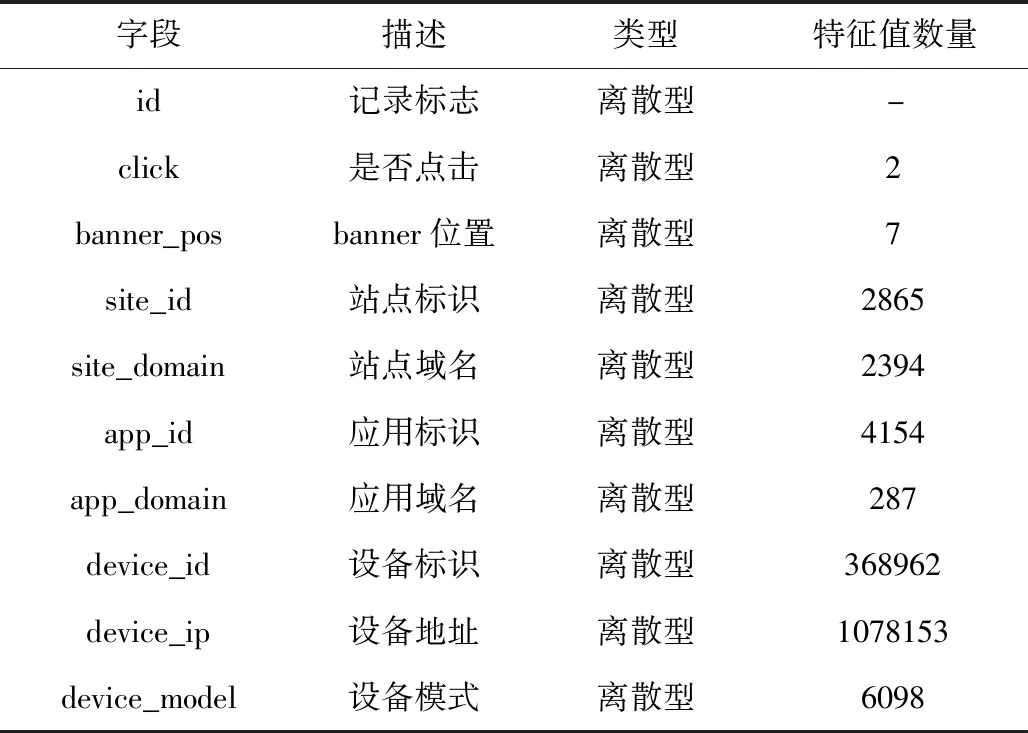

本文采用Kaggle作为仿真数据集,并在Tensorflow平台实现预测模型,模拟点击率预测方法的实际效果。Kaggle是一个竞赛数据集,表1对其中主要字段进行了具体描述。实验过程中从Kaggle随机抽取定量带有标签的数据,并以5:1的比例分为学习集与测试集。实验设定学习速度是,Dropout的失活概率是。

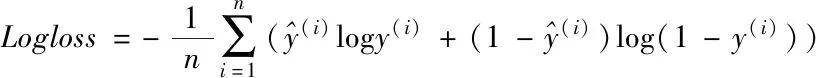

采用损失函数Logloss和AUC作为点击率预测性能的衡量指标。为了能够适应不同方法,这里将Logloss函数衡量定义如下

(17)

(18)

式中f表示假阳率。因为特征类别差异会形成f的差异,所以通过f曲线围成的面积得到AUC。

表1 实验数据集描述

4.2 结果与性能分析

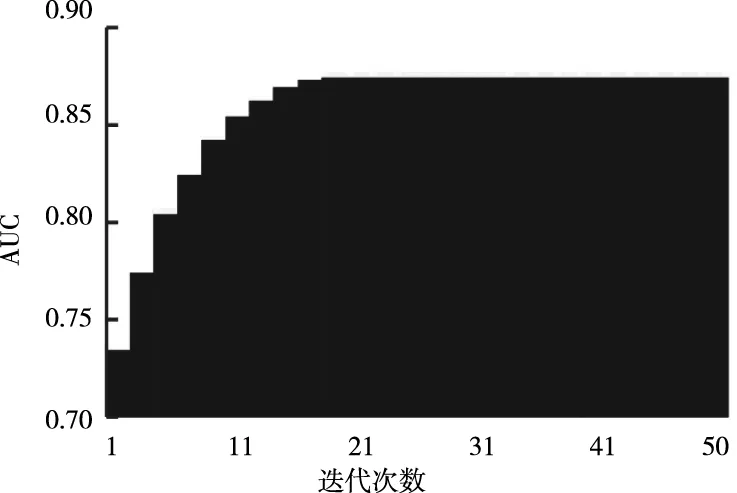

在深度网络对学习样本集进行迭代学习时,得到测试样本集的Logloss与预测准确度的敛散变化情况,结果如图4所示。可以看出,在深度网络学习的过程中,迭代至20代时Logloss就已经达到最优解收敛,此时预测准确度达到最佳,损失函数Logloss值对应0.422,预测准确度对应0.907。在迭代次数增加时,原本应该受到过度拟合的影响,使Logloss回升,准确度减小,但是由于引入了Dropout机制,避免局部最优解间的竞争,有效改善了神经元的共适能力。同样在学习样本集迭代过程中,得到测试样本集的AUC指标变化情况,结果如图5所示。可以看出,在迭代至20代时AUC也收敛至最优解,此时AUC对应0.874。从上述实验结果可以得到,分解机特征映射模型能够有效应对高阶高维特征,降低处理的复杂度,使得本文提出的点击率预测方法具有良好的预测速度。

图4 Logloss预测准确度曲线

图5 随迭代次数变化曲线

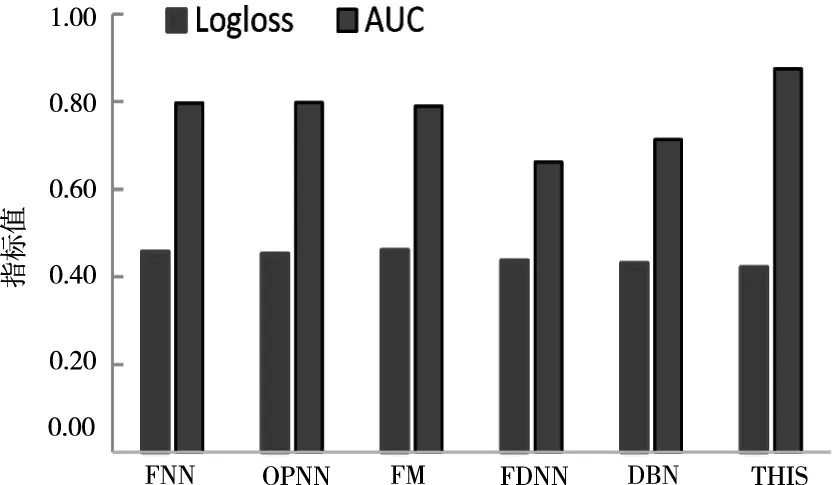

将本文(THIS)提出的点击率预测方法与FNN[7]、OPNN[8]、FM[9]、FDNN[10]、DBN[10]进行性能比较,基于Kaggle数据集分别得到各方法对应的Logloss和AUC指标,结果如图6所示。通过对比可以得出,本文方法对于点击率大数据预测具有更好的Logloss和AUC值。这种性能的提升是由于模型学习时,考虑到点击率的二分类特性,在特征预测的过程中优化了损失函数,结合深度网络学习,输入数据经过RBM训练提取出数据特征,再经由BP神经网络实现特征分类操作,同时,BP对网络参数采取优化更新,当预测模型性能出现下降或者梯度减弱时,深度分解机能够提高对高阶交互特征的提取分类。

图6 不同方法的预测性能对比

5 结束语

针对逻辑回归与多项式回归等模型在具有高维、高阶,以及非线性关联等特征的点击率数据预测模型中表现出的缺陷,本文设计了一种高阶分解机模型。为达到良好的解耦效果,完成数据特征的准确高效提取,研究工作主要做了如下改进创新:

1)采用隐向量代替权重计算,通过映射关系转换降低复杂度,同时利用损失函数求偏导得到变量梯度更新。

2)在高阶分解机模型基础上,引入了深度网络学习,利用RBM实现数据特征识别操作,利用神经网络实现特征分类操作。

基于Kaggle数据集的仿真,通过Logloss和AUC指标数据验证了高阶深度分解机能够有效处理高阶稀疏点击率大数据的预测,且具有良好的预测速度与预测准确度,在样本训练至约20代便可达到最佳预测效果,最优准确率达到0.907。