基于改进CenterNet的机械臂抓取检测

2021-10-18王勇陈荟西冯雨齐

王勇,陈荟西,冯雨齐

(1.重庆理工大学两江人工智能学院,重庆,400054;2.重庆理工大学计算机科学与工程学院,重庆,400054)

抓取检测是机器人抓取任务中一个具有挑战性的问题,它与目标检测的相同之处在于它们都需要从当前视觉传感器获取的信息,快速、准确地检测出理想位置。在目标检测算法中,基于Anchor-based 的方法使得one-stage[1−3]算法性能与two-stage[4−6]的性能相当;同样在抓取检测中,Anchor-based方法能借助预先设置的先验信息提升检测效果,GUO等[7]受Faster-RCNN的启发,在抓取检测中采用Anchor box 的先验机制,降低了直接进行回归计算的难度;CHU等[8]在多目标的抓取检测中运用了Anchor box 的机制;ZHOU等[9]提出了一种定向Anchor box先验机制,合理引入了抓取检测中旋转角度参数的先验信息,提高了检测的正确率。但Anchor-based方法严重增加了超参数的数量以及网络的复杂度,从而降低了训练的效率。

传统的目标检测方法大多先穷举出候选的目标位置,而后对位置进行分类,这些方法效率较低,且需要后续处理。目前最新研究中提出将目标看作1 个点,从而转换为基于关键点检测的方法。LAW等[10]提出CornerNet模型,采用检测出的1对左上角和右下角代替锚框(anchor box),同时引入corner pooling 提高检测能力;DUAN 等[11]在CornerNet 的基础上进行改进,提出Triplets CenterNet 模型,通过3 个关键点(中心点、左上角和右下角)确定目标边界框;ZHOU 等[12]则提出结构简化的CenterNet 模型,只预测边界框的中心点这1 个关键点,它是真正意义上的Anchor-free;ZHOU等[13]提出了ExtremeNet这个自底而上的目标检测框架,将预测的4 个极点(最上、最左、最底和最右)和目标中心点组成5个关键点,若这5个点满足几何对齐关系,则可将其组合成一个边界框。

由于抓取框的中心位置是抓取检测中最关键的问题,本文将关键点检测的思想引入机械臂的抓取检测中,并基于CenterNet[12]网络模型进行改进,提升获取的中心位置的准确度;为了更准确地检测到抓取感兴趣的区域,本文在特征提取阶段之后设计一种视觉注意力机制。

1 相关介绍

1.1 CenterNet模型

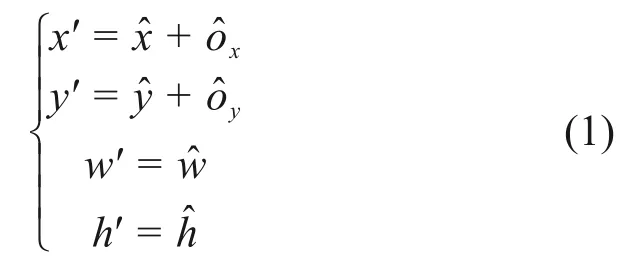

CenterNet[12]使用边界框的中心点来表示物体,如图1所示。

图1 CenterNet模型的边界框表示Fig.1 Bounding box representation in CenterNet model

首先,将图像送入全卷积网络得到1个关键点的热力图,取热力图的峰值点为目标的中心点

预测得到目标边界框(x′,y′,w′,h′),其计算方式为

1.2 注意力机制

为了提高视觉信息处理的效率和准确率,注意力机制被广泛引入计算机视觉相关算法中。在神经网络中,注意力机制[15]能够应用于卷积神经网络,增强对图像中的显著性区域的提取,而忽略无关信息。注意力机制通常通过一个额外的神经网络模块来实现,能够针对性选择处理输入的某些部分,或者给输入的不同部分给予不同权重。孙文赟[16]在进行人脸表情识别时将视觉注意力模型融入全连接网络中,WANG等[17]利用ResNet[18]中的残差模块来构造多个注意力网络分支,从而提出了一种残差注意力学习的方法。

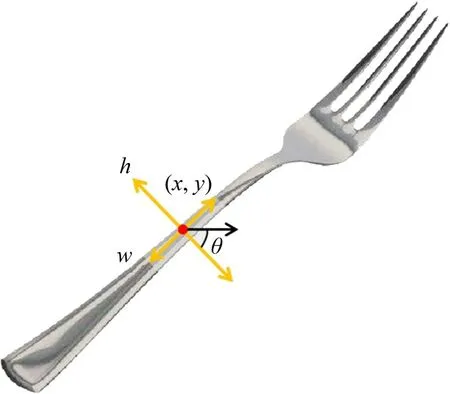

1.3 抓取位置表示

与目标检测不同的是抓取检测具有方向性,JIANG 等[14]提出了由五维参数(x,y,w,h,θ)构成的抓取矩形来表示目标的待抓取位置,它仅仅在目标检测边界框的基础上加入旋转角度参数,如图2所示。图2中,(x,y)为矩形的中心,w和h分别为矩形的宽和高,并且w为夹持器张开的距离,h为夹持器的物理高度,θ(0°~180°)表示相对于水平轴方向的矩形顺时针旋转角度。

图2 抓取位置表示Fig.2 Grasping position representation

2 基于改进CenterNet 的机械臂抓取检测模型

2.1 改进的CenterNet

与其他基于关键点的目标检测模型相比,CenterNet 模型主要检测目标的中心位置。这种Anchor-free 方法不需要预先设置一些超参数,从而检测更加简单。在用于机械臂抓取检测时,准确获得抓取矩形的中心位置对有效预测抓取矩形至关重要。本文将中心位置预测作为关键点估计问题进行重点研究,改进CenterNet 模型能够用于抓取检测。设计一种视觉注意力机制,以提高检测的准确性。

图3所示为改进后的CenterNet 的抓取位置。这里的目标是生成关键点的热力图其中W为宽,H为高,尺寸缩放比例R为4,关键点类型数C为1。可以把抓取位置检测看作是一个排序问题,需要寻找到一个最优的抓取位置;通过对热力图的峰值点排序可以确定最大抓取矩形的中心位置,同时也输出用于修正中心位置的偏移量以及矩形的宽、高和旋转角度

图3 改进CenterNet中抓取位置表示Fig.3 Grasping position representation in improved CenterNet

最终预测的抓取位置(x′,y′,w′,h′,θ′)计算方式如式(2)所示,其中x′,y′,w′和h′的预测方式与CenterNet[12]的相同。大量实验证明,抓取检测中的旋转角度θ′比宽和高更难准确预测,若直接使用回归方法计算该参数,则可能带来较大误差。因此,本文先使用激活函数σ将网络输出值θ′归一化,然后再转换至[0,180]的取值范围内。

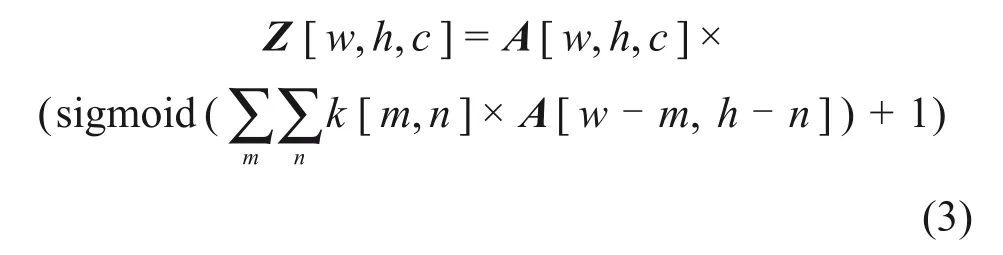

2.2 一种视觉注意力机制

与文献[16−17]相比,本文设计了一种新的视觉注意力机制,用于特征提取和回归预测。该机制结构更简单,参数更少,更容易训练。在网络中新增分支来计算注意力的权重,使网络能够更加关注图像中的关键信息,更好地进行关键点的检测和回归计算,从而提升预测能力。设通过特征提取得到的特征图为A∈Rw×h×c,经过视觉注意力模块处理后得到的特征图为Z∈Rw×h×c,则A→Z的计算如式(3)所示,

式中:k为一个1×1 的卷积核,而A′ ∈Rw×h,为通过k后输出的特征图。使用激活函数Sigmoid 直接获取A′的权重图I∈[0,1]W×H,每个像素点的权重代表其注意力的强度,最后权重I与原特征图A进行点乘运算,并加上原特征图A的值,从而得到处理后的特征图Z。该注意力机制在计算过程中使用的参数量仅为c。

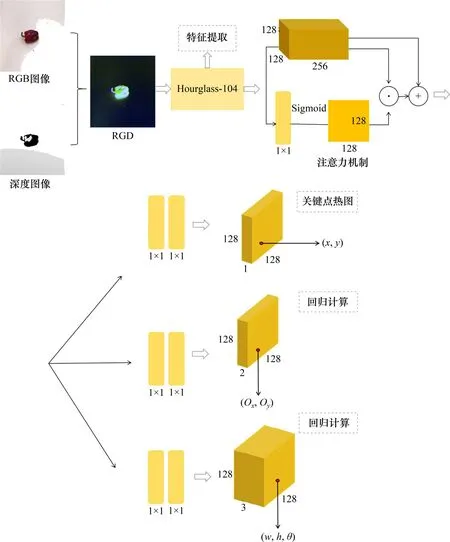

2.3 网络结构

通常来说,层次越深、越复杂的神经网络能够提取到抽象程度更高的特征。本文采用了具有较强特征提取能力的Hourglass-104[19]作为主干网络,整体结构由Hourglass-104 模块、注意力模块和3个预测网络组成,如图4所示。

图4 改进CenterNet的机械臂抓取检测模型Fig.4 Grasp detection model based on improved CenterNet

在网络输入阶段,将RGB 图像和深度图像通过前期特征融合的方式变为RGD 图像,经特征提取后形成128×128×256的特征图。在注意力机制阶段,通过一层卷积神经网络将原通道数降维为1,然后对应生成为128×128×1的权重图,将权重图与原特征图按像素点相乘再加上原特征图,最后输出128×128×256 的特征图。预测网络包括3 个部分,各自采用不同的2层卷积神经网络进行计算。

第1部分进行关键点预测,输出128×128的热力图,每个值代表该点权重,其范围为[0,1]。当某个权重超过预设的阈值时,对应的像素点被作为检测出的关键点,最后从关键点中排序选出最大权重对应的点作为最终的抓取预测矩形中心点。

第2部分进行关键点偏移量预测,代表关键点在x和y方向上的偏移量,输出为128×128×2 的向量;

第3部分为以每个关键点为中心其他3个参数预测,包括抓取矩形的宽、高和旋转角度,输出为128×128×3的向量。

3 实验及结果

康奈尔抓取数据集中有240个不同的物体,共计885幅图像,对于每1幅图像都包括RGB图像和对应的原始点云数据。数据集中还有每幅图像中给定目标的多个正矩形和负矩形标签。本文忽略负矩形标签,仅使用正矩形标签进行实验,图5所示为数据集中部分正标签进行可视化呈现的例子。

图5 数据集中部分正矩形标签Fig.5 Some rectangle labels in dataset

3.1 训练过程

为了达到更好检测效果,并加速训练过程,本文对网络ourglass-104 在目标检测COCO 数据集上进行预训练,在此基础上进行整个模型的端到端训练。

在计算网络误差时,首先对抓取矩形的标签值进行预处理。对于每个真实的中心位置p,进行采样获得对应的关键点

式中:λ为康奈尔抓取数据集评估中的IOU 阈值,取0.25。

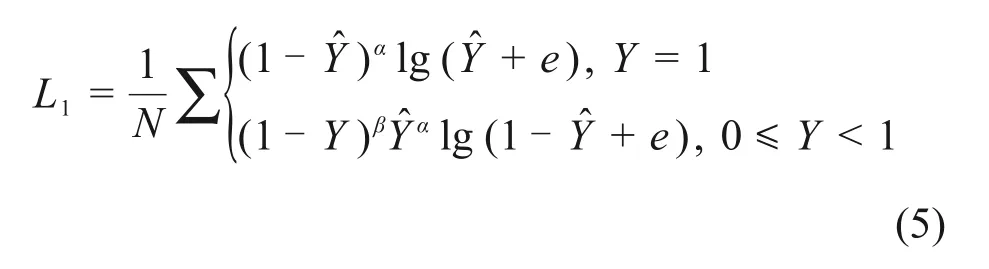

本文采用的损失函数L包含L1和L2这2 个部分,其中,L1为关键点热力图的损失函数,采用Focal Loss[20]解决热力图上关键点与非关键点在数量上不均衡的问题,其计算方式如式(5)所示;L2为其他参数的损失函数,直接采用均方误差函数。

式中:N为关键点个数;α和β为超参数,取值分别为2 和4。为了避免损失出现NAN 或INF 的情况,本文加入参数e,取10-6。

3.2 实验结果

与同类研究一致,本文也采用五折交叉验证方法来评估预测结果。采用图像分割和对象分割2种方式来进行训练集和测试集的划分。

1)图像分割方式。图像分割方式是指将数据集中按图像本身进行五折随机分割,这有助于评估评估模型检测不同位置和姿态物体的性能。

2)对象分割方式。对象分割是指将数据集中数据按其中的对象实例进行五折随机分割。这将有助于提高看不见的对象评估模型性能。

按照康奈尔抓取数据集上的矩形度量标准对结果进行评估:如果预测出的抓取矩形G与任意一个正矩形标签G′能同时满足如下2 个条件,则认为该矩形代表一个合理的抓取位置。

其中,式(6)表示预测矩形与正矩形标签的角度相差小于30°,式(7)表示预测的矩形与正矩形标签的Jaccard相似系数大于25%。

表1所示为本文模型与其他模型使用图像分割和对象分割2 种方式进行实验的抓取检测结果对比。由表1可见:

表1 抓取检测对比结果Table 1 Grasping detection contrast results %

1)无注意力机制的图像分割和对象分割上的正确率分别为97.7%和94.8%;而加入注意力机制的正确率分别达到98.3%和96.7%。

2)文献[21−25]提出的模型均采用Anchor-free的方法,可以看出最终改进的CenterNet模型(有注意力机制)性能超过了先前算法性能,并且模型满足端到端的训练,结构更加简单。

3)文献[7−9]采用的是基于Anchor-based 的方法,可以看出本文提出的方法比有更高的正确率。

本文将在测试集上进行检测的部分结果进行可视化,如图6所示。其中,紫色边框的矩形是待抓取目标的正矩形标签,橙色矩形的边框是关键点检测中得出的最可能中心点以及其对应的其他参数组成的抓取矩形。由图6可见模型的检测结果与标签重合度比较高。

图6 部分实验结果Fig.6 Part of experimental results

4 结论

1)本文基于关键点的抓取检测方法不需要设置任何先验信息,大幅度降低了网络结构的复杂性,提升了网络的高效性和灵活性。

2)在网络中引入的注意力机制提高了检测的视觉显著性,从而提高了检测的准确性。

3)通过在康奈尔抓取数据集上进行实验验证,本文方法具有较高准确率。